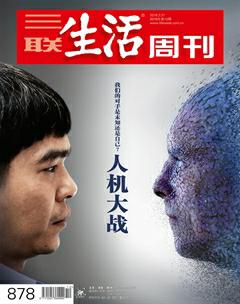

AlphaGo背后:深度学习的胜利

曹玲

近日的围棋人机大战,很多人折服于AlphaGo的精准、聪明和大局意识。人们问AlphaGo为什么如此厉害,工程师给出的答案是它有“两个大脑”:一个输入了3000万盘人类顶级棋手对弈数据,通过“自我对战”来进行增强学习,改善此前的决策网络;另一个通过价值网络来进行整体局面判断,决策网络与价值网络协作决定落子位置。

AlphaGo的技术架构采用的是模仿人类大脑神经的模式,通过深度学习把人工神经网络的层级大大增加,提升了计算能力。AlphaGo的胜利,让如今已经很火的深度学习益发成为人工智能领域的焦点。

人工神经网络起伏

2011年,谷歌X实验室的研究人员从YouTube视频中抽取了1000万张静态图片,把它“喂”给谷歌大脑,在这些图片中寻找重复出现的模式。谷歌大脑就是一个采用了深度学习技术的大型神经网络模型,由1000台电脑组成。三天后,谷歌大脑在没有人类帮助的情况下,从这些图片中发现了“猫”。这件事在人工智能界引起了很大轰动,被认为是深度学习复兴的里程碑。

简单地说,人工神经网络是一种从信息处理角度对人脑神经元网络进行抽象,按不同的连接方式组成不同网络的算法数学模型。它由一层一层的神经元构成,层数越多就越深。而所谓深度学习就是用多层神经元构成的神经网络,以达到机器学习的功能。这些多层的电脑网络像人类大脑一样,可以收集信息,并基于收集到的信息产生相应的行为,也就是“认识”事物,并做出行动。

人工智能的发展和人们对大脑的认知水平相辅相成。1943年,神经生理学家沃伦·麦卡洛克(Warren McCulloch)与精通数学的学生沃尔特·皮茨(Walter Pitts)合作,一起提出了神经元网络模型,沿着图灵关于通用计算机的论述,他们认为人类神经元具有计算机1和0那样的逻辑功能,指出了神经元的数学描述和网络结构。数学概念的介入,为人类理解并创造智能提供了途径,开启了人工神经网络时代。

在上世纪四五十年代,计算机还是一个新鲜产物,第一代人工智能研究者急切地幻想成熟的人工智能技术近在眼前。但当研究者发现实际的知识里蕴含着巨大复杂度时,他们渐渐不再乐观,尤其是遇到一个感知问题,比如说人脸与面具或猴子脸的区别到底在哪里。许多研究者与学者花了几十年时间对计算机识别物体所必备的不同特征的规则进行手动编程。但是找出特征是件难事,耗费很多时间,并且需要专业知识,急需研究者找到更好的解决方法。

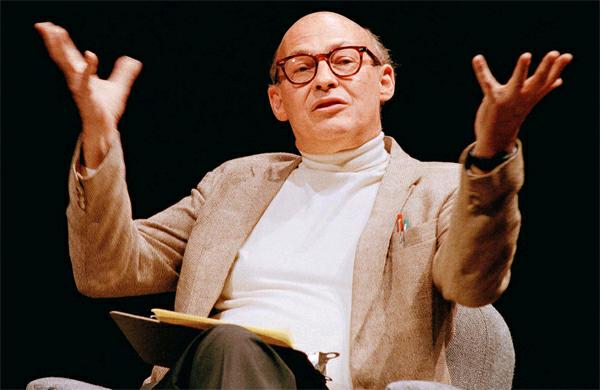

当时有位叫马文·明斯基(Marvin Minsky)的科学家,在1951年建造了第一台神经网络机SNARC。他是麦卡洛克和皮茨的学生,后来被誉“人工智能之父”,今年1月24日刚刚去世,人工智能界写了大量文章进行悼念。

1957年,康奈尔大学的实验心理学家弗兰克·罗森布拉特(Frank Rosenblatt)在一台IBM-704计算机上模拟实现了一种他发明的叫“感知器”的神经网络模型,依据的原理是当时人们理解的学习机制:当一个神经元反复激活另一个神经元,细胞就提高了它们的连接效率。

感知器占据了整个实验室,它包括三层结构,运作机制并不复杂。感知器的一端,400个光传感器模拟视网膜;传感器多次连接一组512个电子触发器,当它通过一个特定的可调节的兴奋阀值时就会像神经元一样激发。这些触发器连接到最后一层,当一个物体与感知器受训见过的对象相互匹配时,它就会发出信号。这个模型可以完成一些简单的视觉处理任务。

1958年夏,罗森布拉特和他的赞助方美国海军举行了新闻发布会。《纽约时报》当时报道说:“海军透露了一种电子计算机的雏形,它将能够走路、说话、看、写、自我复制并感知到自己的存在……据预测,不久以后,感知器将能够识别出人并叫出他们的名字,立即把演讲内容翻译成另一种语言并写下来。”

美国科学家马文·明斯基在1951年建造了第一台神经网络机SNARC

明斯基于1969年出版了《感知器》一书,暗示了感知器具有重大局限,不能解决人工智能的问题。这本书的杀伤力是巨大的,随即神经网络研究便因为联结主义的式微被打入冷宫,所有原来的政府资助机构也逐渐停止对神经网络的研究。1971年,罗森布拉特43岁生日那天因游船事故去世,有传言他是自杀。

后来神经网络得势后,当时受压迫的科学家认为明斯基不可原谅,纷纷对其口诛笔伐。美国电气电子工程师协会(IEEE)于2004年设立了罗森布拉特奖,以奖励在神经网络领域的杰出研究。

上世纪80年代初,加州理工生物物理教授霍普菲尔德(Hopfield)提出了一种新的神经网络,可以解决一大类模式识别问题,还可以给出一类组合优化问题的近似解。一帮早期神经网络研究的幸存者,在DNA双螺旋结构发现者弗朗西斯·克里克(Francis Crick)和认知科学家唐·诺曼(Don Norman)的鼓励下,以加州大学圣地亚哥分校为基地开始了“联结主义”运动,领导者是两位心理学家外加一位计算机科学家杰夫·辛顿(Geoffrey Hinton)。

在学术上,人工智能有三种学派:符号主义、联结主义和行为主义。符号主义认为人工智能源于数理逻辑,行为主义认为人工智能源于控制论,而联结主义认为人工智能源于仿生学,特别是对人脑模型的研究,人工神经网络是这一理论的杀手锏。

人类大脑的思维分为抽象(逻辑)思维、形象(直观)思维和灵感(顿悟)思维三种方式。20世纪80年代,在符号主义学派影响下,许多人工智能的专家系统被制造出来。它们的抽象思维异常强大,在解决逻辑性强的专业问题上,速度比人类快很多,比如医疗诊断、矿产勘探等问题。但是这类人工智能欠缺人类最基本的感知能力,连猫和狗都区别不开,人工神经网络有机会展示出它解决机器形象思维的能力。

起初,辛顿等人的研究并不顺利,但是他们相信,计算能力的增强以及数字数据爆炸将会再次推动人工神经网络的发展,自己的算法将给世界带来惊奇。

2006年,辛顿在《科学》杂志上发表了有关深度学习的论文,重新审视深度学习方法,将深度学习的性能提升到了一个新的台阶。

2009年,辛顿小组获得了意外的成功,他们的深度学习神经网络在语音识别应用中取得了重大突破,转换精度突破世界纪录,错误率比以前少了25%。有评论说,辛顿小组的研究让语音识别领域缩短了至少10年的时间。他们的突破吸引了各大公司的注意,苹果公司把研究成果应用到了Siri语音识别系统上。从此,深度学习的流行便一发不可收拾。

2010年,美国国防部DARPA计划首次资助深度学习项目,参与方有斯坦福大学、纽约大学和NEC美国研究院。2012年,深度学习技术在图像识别领域取得惊人的成果,在ImageNet评测上将错误率从26%降低到15%。同年,制药公司将深度神经网络应用于药物活性预测问题取得世界范围内最好结果。2013年4月,麻省理工学院《技术评论》杂志将深度学习列为2013年十大突破性技术之首。

研究人员认为,深度学习是个很好的解决方案。它能从抓取的数据中生成自己的规则,提供一种采用受大脑启发机制的对称性来完成类大脑功能。这种策略需要模拟神经元并将之组织成多个层次。拿人脸识别来说,当系统面对一张图片时,学习系统的第一层仅能简单区分其中的明暗像素点。下一层就能意识到某些像素点构成了边界,再往下一层就能区别水平和垂直线条。最后一层能识别出眼睛,并且认识到人脸中通常有的两只眼睛。

如今,神经网络研究如日中天。由于擅长处理语音、视觉以及其他复杂人机交互,神经网路已经被谷歌、Facebook、微软、百度等技术先驱欣然采纳。在这些公司里,神经网络已经证明了一种有效的可以吸收大量数据并从中进行有价值预测的处理方式,比如怎样让你的数据中心更高效节能、此用户之后有买车的意愿吗?科技公司对每一位擅长神经网络的程序员展开了激烈角逐,重金聘用人才,不惜到研究机构去挖角。

后来,辛顿和两个学生开创了一家专注深度学习的公司DNNresearch。公司成立没多久,谷歌和微软就对这家公司动了收购的念头,后来百度也加入竞标,最终2013年谷歌出了几千万美元收购了这家只有三名员工的公司。此次收购不如说是收编更准确,谷歌把包括辛顿在内的三位人才收归麾下。

有人问,人工神经网络起起伏伏,为何会复兴于这个时代?

神经网络需要学习大量实例,就像小孩收集现实世界的信息一样。上世纪80年代到90年代,由于没有太多的数字信息可用,计算机要花费很长的时间去确定有些什么信息。因此,这一时期的技术应用非常少,其中一个是由深度学习的大佬之一燕乐存(Yann LeCun)开发的技术,现在被银行用于手写支票识别。

当我们将超大规模的训练数据喂给深度学习模型的时候,这些具备深层次结构的神经网络就摇身一变,成为拥有感知和学习能力的大脑,表现出了远远好于传统神经网络的学习能力。

业内人士描述深度学习和大数据的关系,就像火箭和燃料一样:火箭虽然厉害,但是没有大数据这个燃料也只是一堆废铁。而且这个模型对原始数据来者不拒,无论属于图像识别、语言识别、NLP、生物医药等哪个领域,都可以“喂”给神经网络学习处理。而且,喂给它的数据越多,它就变得能力越强、越聪明,并且只会吃不饱,不会消化不良。这和大脑的工作原理很相似,大脑用同一套算法解决视觉、听觉、嗅觉等感知问题。因为大数据的必不可少,我们也看到深度学习做得最好的地方是我们熟知的那些拥有大量数据的IT巨头。

如今,深度学习似乎无孔不入:深度学习识别出患有自闭症风险的基因;深度学习为图片和视频自动添加标题;深度学习识别大型强子对撞机中的粒子;使用深度学习来制造无人驾驶汽车和机器人。

即便如此,深度学习也不是万能的。人工智能包括三个方面。第一是感知,就是知道周围环境是什么,知道和对方交互的时候对方在说什么,要表达什么意思,感知不是感觉但包含感觉。第二是认知,在感知的基础上去理解。比如机器已经能识别人类的语言,但是它能不能听懂其中的意思、理解人类的话?第三是决策,依据理解做出行动。

目前,感知和决策智能已取得巨大的进步,甚至在某些方面已经超越人类,但是在认知方面还有很大的差距,机器依然听不懂人的意思。机器学习不是万能的模型,将来还会出现更好的解决方式。

模拟人脑

既然深度学习模型成功的秘诀之一就在于它模仿了人类大脑的深层体系结构,那么我们为什么不直接模拟人类的大脑呢?事实上,科学家们已经行动起来了。

例如,德国海德堡大学的FACETS计划就是一个利用硬件来模拟大脑部分功能的项目。他们采用数以千计的芯片,创造出一个包含10亿神经元和1013突触的回路的人工脑,复杂程度相当于人类大脑的十分之一。与此对应,由瑞士洛桑理工学院和IBM公司联合发起的“蓝脑计划”则是通过软件来模拟人脑的实践。他们计划2020年左右制造出科学史上第一台会“思考”的机器,将可能拥有感觉、痛苦、愿望甚至恐惧感。

然而,这类研究计划也有很大的局限性。其中最大的问题就在于,迄今为止,我们对大脑的结构以及动力学的认识还相当初级,尤其是神经元活动与生物体行为之间的关系还远远没有建立。尽管科学家早在30年前就已经弄清楚了秀丽隐杆线虫302个神经元之间的连接方式,但到现在仍然不清楚这种低等生物的生存方式,比如进食和交配是如何产生的。尽管科学家已经做过诸多尝试,但是还不足以解释不断变化的电信号是如何产生特定认知过程的。

于是,为了进一步深入了解大脑的运行机制,一些大科学项目先后启动。2013年1月,美国奥巴马政府宣布“脑计划”的启动,该计划在2014年的启动资金为1亿多美元,致力于开发能记录大群神经元甚至是整片脑区电活动的新技术。

同年4月,欧盟也发起了“人类大脑计划”,这一计划为期10年,耗资16亿美元,致力于构建能真正模拟人脑的超级计算机。2014年10月,日本发起了本国的大脑研究计划,主要是通过对狨猴大脑的研究来加快人类大脑疾病,如老年性痴呆和精神分裂症的研究。

中国不甘落后,“十三五”规划纲要草案已经把脑科学和类脑研究列入国家重大科技项目,主要有两个研究方向:以探索大脑秘密、攻克大脑疾病为导向的脑科学研究,以及以建立和发展人工智能技术为导向的类脑研究。

这似乎让人们想到了第二次世界大战后的情景,各国争相发展大科学项目:核武器、太空探索、计算机等等。脑科学的时代已经来临,人工智能能否借助脑科学的发展,获得下一步的飞跃?