AlphaGo到底有多聪明?

陈赛

AlphaGo的胜利昭示了未来几年人工智能很可能会以超出我们想象的速度发展。我们对李世石的感同身受,恐怕就是因为多少嗅到了其中危险与刺激的气息。

关于这场万众瞩目的世纪大战,赛前最大的悬念,也是构成比赛最大的魅力之一就是,赛前没有人、连谷歌DeepMind的工程师都不知道AlphaGo的棋力到了什么水平。即使比赛之后,人们仍然搞不清楚AlphaGo的棋力到底到了什么水平,以及它能够达到什么水平。

当棋盘上的局面越来越让人困惑时,媒体观战室里的很多记者都放弃了,开始掏出手机,互相传看各种段子。我的手机上就收到这么一个段子:“赛后,李世石恼羞成怒,不顾管理人员的阻拦,疯狂地拆开了AlphaGo以泄愤,一看,卧槽,柯洁藏在里面。”

其实,这个段子有个典故。18世纪欧洲一位发明家号称发明了一种具有人类智能的机器人,能够跟人下国际象棋,并且真的带着这个机器人横扫欧洲的各位象棋大师。一位不信邪的国王下令拆掉这台机器,结果发现里头真的藏着一个土耳其象棋大师。于是这台机器,或者说这位土耳其人Turk,就被称为Mechanical Turk。

这个段子击中了我们这些观战者最大的困惑,机器到底聪明到了什么程度?

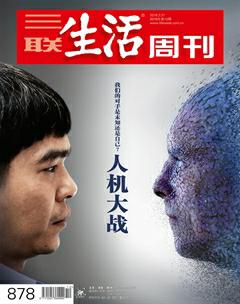

人工智能公司DeepMind联合创始人德米斯·哈萨比斯

两年前,一个叫Eugene Goostman的聊天机器人号称成功骗过了图灵测试三分之一的评委。但Eugene Goostman之所以能通过图灵测试,并非它真的会“思考”,而是借助于一些聪明的花招和诡计——它假装自己是一个13岁的男孩,诡称英语是自己的第二语言,以此解释语言中的不一致;当无法给出直接答案时,就通过虚张声势或装疯卖傻来转换话题。事实上,这在图灵测试的历史上已经成了某种惯例:图灵测试所测的与其说是机器思考的能力,不如说是扯谎的能力。

作为自然语言处理领域达到最高水平的机器,IBM的沃森在2011年的Jeopardy游戏(Jeopardy是美国出名的电视问答游戏,问的问题涉及大量比喻、笑话、谜语)中击败了所有的人类对手,而且它的知识不是工程师手动编程灌输给它,而是自己通过阅读获得的。沃森每秒可以处理500GB的数据,相当于1秒阅读100万本书,但很可惜的是,沃森并不理解它所阅读的内容的任何含义。

2012年,“谷歌大脑”——一个由1.6万台计算机组成的网络系统,在随机分析了1000万条YouTube视频之后,终于“认识”了猫是什么样的动物。这个机器被认为是当下人工智能领域(“深度学习”)一个里程碑式的进步,因为它是凭借自己的力量发现了猫的概念,没人告诉它猫是什么。据称他们是在控制论层面模拟了人类大脑视觉皮层的运作方式——神经学家认为,可能存在一种名为“祖母神经元”的细胞,当人被反复“训练”去识别某一张人脸时,这种细胞便会被激活。但这个网络与人类的视觉皮层相比仍然很渺小,后者的神经元和突触数量比该网络多100万倍。更重要的是,谷歌的这个“猫侦察机”虽然号称识别准确率达到81%,但“一旦将样本量扩大到2万个类别,得分瞬间会跌至15.8%”。

与图灵测试、自然语言一样,棋类游戏也是测试人工智能进展水平的小白鼠。事实上,人类历史上第一个下棋程序就是阿兰·图灵写的。图灵是“人工智能”概念的发明者。60年前,他写了一段程序,可以让机器下棋,因为当时计算机还没有被发明出来,所以他亲自充当人肉CPU来执行这段程序,每下一步都要花掉30分钟。只有一局棋被记录下来,图灵的“纸机器”输给了他的同事。

那么,谷歌这次如此大张旗鼓地召开人机大战,要展示的到底是一种什么样的智慧?

“神之一手”:机器的直觉?

在首尔最豪华的四季酒店里,一墙之隔的两个会议室同时播放比赛的现场投影,一个以英文解说,一个以韩文解说——韩国来了200多家媒体,韩国一共5000万人口,围棋爱好者就有800万人。

每个记者眼前都有一台笔记本,手里卧着一个手机,房间的正前方是一张大屏幕,棋盘上的黑棋与白棋正在激烈地交锋……

被包围在机器之中的人类啊。

空气很热,我喝了太多的咖啡,手有点发抖,心跳得厉害。

来韩国之前,我跟一位围棋业余五段的朋友请教,他教我说:“你把棋子看成是两军对战就是了。”整个围棋都是关于控制、关于势力范围。

他一直耐心地在微信上跟我直播解释:

“现在白棋要求战了,要分断黑棋。”

“太乱了,现在到底是谁包围谁?”

“形式会转化的,包围别人的,也会被别人包围。随着局部向更大的范围演化,整个棋盘的别的看似无关的棋子都会参与到战斗中来。”

“现在战火已经烧到了全盘。”

……

但是,我的注意力不断地被一些不相干的细节牵走,比如整场比赛中,两位解说员都称AlphaGo为“他”,而不是“它”。李世石刚出场的时候向那个看不见摸不着的对手——不知疲倦亦无忧惧的AlphaGo君鞠了一个躬,表情有点怪;他抿了一口水,落下了第一颗黑棋;不对,他有5分钟没有落棋了;他以手捂嘴,有时候你觉得他几乎要睡着了;他的座位空了,估计是上厕所去了;他看上去似乎松了一口气;他开始表现出明显的挫折感,把手举到脑后……

记忆中最为意味深远的一幕是在第二局,AlphaGo在下第37手棋时,突然从右下角的战役中离开,跑到右上侧开阔的疆域作战。当时现场解说员迈克·雷蒙(西方唯一的围棋九段职业棋手)吃了一惊,说:“这一招很怪。”另一个显然水平比较差的解说员附和着笑了一下,不经意地说:“也许是机器又犯傻了。”

但李世石看到此棋一落,突然一言不发,面无表情地出去了,回来以后喝了一口咖啡,陷入了漫长的15分钟的沉思。

1997年,当时IBM的“深蓝”打败国际象棋大师卡斯帕罗夫的时候,也有过这么一个类似的瞬间。卡斯帕罗夫在漫长的20分钟沉思之后,他相信自己正在面对一个具有直觉力的机器。“机器拒绝走向一个具有决定性短期优势的位置。”在他的一篇回忆文章里,他这样写道,“它呈现了一种与人类非常相似的对危险的敏感。”对他来说,机器似乎在“体验”这盘棋,而不是在“计算”这盘棋。

与卡斯帕罗夫一样,李世石在赛前宣称自己将以5∶0全胜。他相信下围棋这件事情里面有一些东西是机器不可能模拟的。作为人类代表,他发誓要守护围棋之美。

但事实上,从第二局开始形势已经发生了惊人的逆转。在此之前,是AlphaGo挑战李世石,但在此之后,已经是李世石在挑战AlphaGo了。韩国的报纸上已经开始称AlphaGo为“阿尔法十段”。在韩国,围棋九段与中国古代的一品一样,称为“入神”,十段差不多就是“神”的意思了。

10秒钟后,AlphaGo下的那一颗看似与之前的棋子毫无关联的黑棋,奇迹般地以燕尾之势与它之前的18颗黑子相联合。在围棋职业棋手们事后的不断回味中,AlphaGo的这步棋(黑37)被人叹为“神之一手”,其中似乎包含了无穷无尽的计算、判断与预谋,现场解说员甚至称其有“吴清源”之风。

“没有任何一个人类棋手会那样下棋,它打破了所有的规则。”在赛后的采访中,作为现场裁判的樊麾告诉我,“但那是一步无比美丽的棋。”

除了李世石之外,樊麾是唯一一个曾经与AlphaGo交过手的人类棋手。在去年10月份的一次秘密对决中,他以0∶5败给AlphaGo。而在樊麾之前,AlphaGo以压倒性的优势战胜了两个当时最好的围棋程序——法国的“疯石”(Crazy Stone)和日本的“禅”(Zen)(1负494胜)。

与李世石对决的AlphaGo已经升级到第18个版本。很显然,它的棋艺与5个月前相比已经不可同日而语。九段的人类高手遇到十段的非人类,李世石内心的震动全都写在脸上——眉头紧锁,身体不自觉地来自摆动,手指不停地敲击桌面,一只手抖到几乎难以夹起一枚白棋。

正是这种疯狂的进化速度令人心生惧意。从樊麾到李世石,对人类来说可能是一辈子都无法跨越的鸿沟,而AlphaGo只花了5个月时间。这让人忍不住联想起雷·库兹韦尔那个关于“奇点”的疯狂预言——在不久的将来,我们会制造出比我们更聪明的机器,它们再造出比它们自己更聪明的机器,如此这般,整个世界朝着我们无法预计的巨型超智能的方向狂奔……

就在两天前,当DeepMind的联合创始人德米斯·哈萨比斯在赛前的记者招待会上提到AlphaGo拥有类似于人类棋手的“直觉”时,还没有多少人真正相信。事实上,没有多少人真的关心AlphaGo是个什么东西,哈萨比斯做演讲的时候,前排韩国媒体所有的闪光灯都对着李世石和他的妻女不停狂扫。完全没有大战前剑拔弩张的气氛。绝大部分人都觉得,只是一场好玩的比赛罢了。机器在围棋上战胜像李世石这样的人类高手,至少还有10年时间,因为以围棋的复杂性,绝对不是一种可以靠计算蛮力解决的智力游戏。

当年IBM的“深蓝”打败著名的卡斯帕罗夫,就是完全凭借计算的蛮力。每走一步棋,“深蓝”都能思考对手的棋着、自己的回应及对手的回应……如此达到6个来回甚至更多。运用快速评估函数,它能为每一种可能的棋盘局势计算出分数,然后选择能带来最高分数的棋步。它最多能在一秒钟之内评估3.3亿个棋盘局势,而卡斯帕罗夫在下每一步棋前最多只能评估几十个。

与国际象棋相比,围棋的复杂度又以指数级增长——对于一个19×19的围棋棋盘而言,一共有361个位置,而每个位置可以单独放置黑棋、白棋或者留空,理论上所有的可能组合是3361种,其下法的组合超过170位数。就像DeepMind的创始人哈萨比斯一次次向并不熟悉围棋的西方媒体强调的:“棋盘上排列组合的可能性超过了宇宙中的原子数量。”什么样的机器能承担如此庞大的数据运算量呢?

作为一种令人敬畏的美妙游戏,围棋的魅力之一就在于,千变万化的棋盘空间很多时候没有标准答案,局面的好与坏、厚与薄、领先和落后,连职业高手也常常难以判断。那么,AlphaGo又是如何在无穷无尽的可能性中进行选择,并下出这种完全不按棋理出招,却又妙不可言的招数的呢?

据说人类棋手对弈的时候,胜负之间往往取决于一种类似“直觉”的东西:当被问到为何这样落子的时候,大师们通常的回答是“感觉如此”。也就是说,他们不是靠逻辑判断,而是凭多年的经验和瞬间的感觉,只评估几个到十几个比较有希望的行棋方案。

这是人类演绎与推理的方式。我们并不是单纯理性的动物,情绪、情感和直觉在我们做决策的过程中起到了重要的作用。自然选择在构建我们的大脑时,没有劳神将所有无意识的情绪情感过程转换成为新的明晰的有意识的控制系统。所以,我们的思考过程需要情绪情感,正是情绪情感让我们理解那些不能直接理解的东西。也正因为如此,哪怕是学龄前孩童也都十分擅长于以富有新意的方式,创造出崭新的、打破常规的概念和假设,然后再加以检验。

而当哈萨比斯谈论AlphaGo的“直觉”时,他谈论的其实是一个叫“价值网络”(value net)的算法。正是这个算法在帮助AlphaGo评估落子后的局面与最终胜负的概率关系,判断局面是否处于优势,优势多大。但AlphaGo的厉害之处在于,这个算法并不是程序员事先编写的,而是AlphaGo通过不断的训练和研究自己摸索出来的。可以说,AlphaGo是围棋几千年历史上唯一一个将“直觉”量化的棋手。

在赛前的记者招待会上,哈萨比斯曾经详细介绍了AlphaGo是怎么一步步学围棋的。AlphaGo的设计最独特之处就在于训练了两套深度神经网络——分别用于深度学习与强化学习。

从根本上来说,深度学习模拟的是人的识别模式的能力。它依赖深度神经网络,从原始数据中逐层过滤出有意义的模式(pattern)。比如你给神经网络输入足够多猫的照片,它就能辨认一只猫;你给它输入足够多人类对话,它就能像人类一样交谈;你给它输入10万盘人类围棋高手的棋谱,它就能差不多学会下围棋。哈萨比斯说自己从来没有跟AlphaGo下过围棋,因为没有意义,AlphaGo从一开始就已经超过了他的业余一段水平。

当然,这只是开始。在搭建了一个可以下围棋的神经网络之后,工程师们开始让它自己跟自己对局。AlphaGo每天跟自己(不同的分身)下上几十万盘,在不断的试错中自我完善、自我进化,并累积3000万手的数据库。这个系统叫“强化学习”,灵感源自动物大脑中的神经递质多巴胺奖励系统。在这个算法里,机器得到的唯一的指示就是要赢,就像一只未经训练的小狗,先被编程好去寻找奖励,但并不指点它怎么得到奖励。它的第一步是随机的,对游戏的逻辑一无所知。但通过哪些能得分、哪些不能得分,它逐渐建立起得分的原理。

“强化学习”算法给了AlphaGo一个唯一的强烈动机——赢。所以,它总是在不断地计算胜率,它下的每一步都是在试图最大化胜率——它只在乎自己赢,甚至不在乎赢多少。

正是这两个系统的组合,训练出了一个可以战胜樊麾的AlphaGo。在樊麾之后,AlphaGo继续不断地自己跟自己对决。此时产生的数据不仅质量很高,而且很多都是机器自己琢磨出来的下法,或者说,非人类的下法。正是大量高质量的自学数据,构成了一个强大的价值评判网络,可以预测棋盘上不同的分布会带来什么不同的结果。像不像《黑客帝国》里,尼奥进到一间屋子,看到屏幕上有无数代的尼奥在练武?

就在第一场赛事之前,杰夫·迪恩(Jeff Dean),谷歌深度学习团队的老大专门召开了一次记者见面会,提到深度学习技术已经在谷歌产品中得到大量的应用,从照片搜索、语音搜索、搜索排行以及医疗机器人的研发。

事后回想,这实在是比AlphaGo更大的故事。

我问他从机器学习到机器理解,到底还有多远。

他说:“如果5年前,你告诉我,给一个机器可以输入一张照片,得到这样一句解说,我会觉得不可思议。”

他指的是谷歌的图像搜索,给它一张小女孩抱泰迪熊的照片,它会给出这样的描述:“小孩抱着毛绒玩具的近景照片。”

“虽然不完美,不像人类的理解那么复杂,但它能辨别图像里的内容,也了解上下文的意思,这至少是一定程度的理解。与人类的学习并非没有相似之处——你观察周围的世界,发现小小的细微之处与以往的经验不一样,并且能够总结出来。”

恐怖谷理论

4个多小时里,AlphaGo已经从一个抽象的概念变得越来越具体,每个人都能强烈感觉到它的存在。尤其是随着棋局进入后半盘,李世石的常规时间告罄,进入读秒阶段。媒体观战室里的绝大部分人已经完全看不懂棋盘上的变化,连现场解说员也无法判断局势,但紧张的气氛却渗透到每一个人的骨子里——机器思考的时间越来越长,而李世石可以思考的时间越来越短(每次不能超过60秒),我们看着他的脸由不安转成焦躁,从焦躁到沮丧,从沮丧到愤怒,从愤怒到绝望到几欲崩溃,又以最大的自制力勉强恢复镇静,重新一子一子落下,分分钟都是煎熬,每一分煎熬都让人对机器的“无情”生出不平之意。

当世最伟大的围棋手,那么桀骜不驯的一个人,如今看上去却如此无力和脆弱!

心智运动,比如象棋和围棋,需要高度集中的精神。在人类对弈的棋局上,交战双方彼此的呼吸、表情、汗水、气味……很小的事情会对胜负产生非常微妙的影响。围棋固然是冲突,是厮杀,是人性中潜在的攻击欲,但也是不完美的人类彼此试探、彼此惺惺相惜的心理艺术。甚至有时候,为了给后世留下名局,交战双方不再是对手,而是合作者。

与肉体凡胎不同,机器不知疲倦,没有恐惧,既不骄傲自满,也不会情绪失控,因此能不间断地保持前后一致的优势。5个月前0∶5输给AlphaGo的樊麾在采访时把它形容为一堵“墙”——“就是它不动,你对它施展任何压力它都会反弹给你,你对它施加的所有力量,你对它所有的辱骂也好,对它所有的微笑也好,最后全反馈到你自己身上,这是我对AlphaGo的感觉。”

终于,连现场解说员都看不下去了:“干脆把电源拔了吧。这个家伙是靠网络连着的吧?谁有剪刀就行。”

是的,AlphaGo的确由网络接入谷歌遍布全球的数据中心,但一把剪刀恐怕剪不断它的网线——在比赛之前,谷歌已经在四季酒店接入了自己的光纤网络,以确保不会断网。

但是,我仍然对自己内心受煎熬的程度感到吃惊。为什么一场我看不懂的围棋赛会对我产生如此大的冲击?为什么李世石的情绪会如此感染我?仅仅是不平吗?

在那个瞬息万变的棋盘上,作为过去10年公认的全球最优秀的围棋手,李世石不仅在代表人类与机器进行一场智力上的对决,而且也在代表我们第一次“探访”一个全新的世界——一个机器智慧与人类智慧共存,甚至在某些层面超出人类控制的世界。人类曾经在小说与电影中无数次想象过这个世界,其中有憧憬,也有噩梦,但从没想过它会来得这么快。

在赛前的全球记者发布会上,李世石曾经表示,自己之所以接受AlphaGo的挑战,是因为“好奇心”——唯一满足这种好奇心的方法就是亲自跟它对弈一场。如今,他在棋盘上感受到的所有好奇、焦虑、困惑、不安、沮丧甚至狂喜——如现场评论员迈克·雷蒙所说:“面对千古未见的棋局,在某一瞬间,也许他体会了某种狂喜。”将来我们恐怕也都会一一体会到。

人对于机器,抱着一种多么奇怪的感情啊。我记得《万古》杂志上有一篇文章说,人类之所以要发明人工智能,其实是一种皮格马利翁情结——我们想要创造一个永远不会辜负我们、永不背叛我们、永远忠实于我们的爱人。所以有人开玩笑说,如果AlphaGo真的聪明的话,今天就应该输一场。

但是,AlphaGo没有输。在第三场失利之后,李世石在记者招待会上说:“我想我应该先道歉,我本该取得更好的结果,下出更好的棋,但很抱歉没能满足很多人的期待。输了这些比赛,我觉得很无力。”

他此刻的谦卑令人动容,尤其鉴于他曾经是那么狂傲不羁的一个人。而他的无力感则感染了现场每一个人,沉重的空气如乌云压顶。

在此之前,我们恐怕从来没有把“人工智能”这件事情当真过。是的,机器曾经在很多智力游戏上打败过人类,跳棋、国际象棋、拼字游戏、智力问答(jeopardy)……但一直以来,在一切创造性领域,机器的智慧与人类相比仍然不值一提。给Goolge Translate输入1万亿而不是100亿个双语文本,也不可能达到人类译者的水平。同样,交谈、阅读、写作、设计,或任何一个你宁愿人而不是机器来做的领域都是如此。但是,AlphaGo这一次是在人类最引以为自豪、代表着人类某种最高智慧形式的围棋上打败了人类!想象一下,一个会像巴赫一样作曲的机器人,一个像莎士比亚一样写作的机器人?

计算机科学界有一个“恐怖谷理论”,是一个关于人类对机器人和非人类物体的感觉的假设——当机器人在外表、动作上与人类非常相似,但又没有达到完全相似时,我们会产生一种恐怖甚至恶心的感觉。这一理论在动画、僵尸甚至假肢方面都得到了验证。

对于这种假设有很多理论解释,比如日本科学家伊藤穰一(曾任麻省理工学院媒体实验室主任)认为这与人类对自我特殊性的认知有关,即某种存在性的“自我”(ego)。而我们之所以会进化出这样一套“自我”,多少是一种自我欺骗的方式,是为了让每个人都能在进化动力的系数之内工作和生活。而当机器在这个系统中变得越来越重要时,我们对自我特殊性的认知会进一步显示出荒谬性。

我不断地在脑海里想象,对于李世石来说,AlphaGo到底是一个什么样的存在呢?

首战失利以后,曾经有记者问他这个问题,当时他很不高兴地回避了。但现在,恐怕全世界很多人都在思考同一个问题。AlphaGo到底是什么呢?没有人知道它的段位,没有人知道它的风格,没有人知道它下一步会怎么下,当它下了错棋的时候,它知道自己错了吗?当它知道自己下了一招无比完美的棋时,它知道自己有多完美吗?当它用兵懈怠的时候,是因为悲观,还是认为胜率高?它通过所谓“深度学习”与“强化学习”训练出来的“直觉”到底是一种什么样的“直觉”?日本围棋大师说:“棋道一百,我只知七。”AlphaGo会最终成为围棋的上帝,穷尽无限的可能性吗?

对于这些问题,连创造它的谷歌DeepMind的工程师也无法回答。他们创造了它,但现在只能静静地站在一边,像其他人一样看着它的表现。在三天的观赛期间,德米斯·哈萨比斯不止一次对AlphaGo的精妙棋法表示“惊奇”(surprised)。他的“惊奇”可以从两个方面来解读:

一方面,AlphaGo的学习与决策能力如此之高,意味着它可以为人类所用,帮助人类棋手在围棋上达到更高的境界,开拓出更多的可能性,甚至胜任更多人类智力所不及的任务,如哈萨比斯所说,“一切需要在庞大数据中寻找结构与洞见的任务”,比如气候变化、药物研发、金融系统、疾病诊断……哈萨比斯曾经在欧洲粒子物理研究所(CERN)做过演讲,发现那里的科学家在抱怨大量的数据无法处理,如果AlphaGo的技术可以用来寻找“上帝粒子”,那将是一件多酷的事情?

但另一方面,哈萨比斯的“惊奇”也暗示了AlphaGo在某种程度上不在它的创造者的控制之内。这样的失控在棋盘之上固然无关紧要,但一旦应用到现实世界,必然会引发道德与伦理上的问题。比如,当AlphaGo的未来版本为我们开车、诊断疾病甚至防止犯罪时,我们应该给它们多大的权限?我们应该如何在如此复杂的人工智能里嵌入人类控制?出于失控的风险考虑,是否有一些人工智能从一开始就不应该被发明出来?

AlphaGo知道AlphaGo在下围棋吗?

“AlphaGo知道AlphaGo在下围棋吗?”在赛前针对国际媒体的一次小型专访中,是哈萨比斯自己扔出了这个问题,然后他又笑着回答说:“不,当然不。”

是的,AlphaGo只是一个很会下围棋的强大机器而已。它没有意识,不会思考,也并不真正理解自己下的每一步棋到底意味着什么,更不理解棋局隐喻的哲理。但它的确是一个强大的学习机器。不过,它最强大的地方不在于能在单项的学习任务上击败人类高手,而是它能学会不同的任务,而之前大多数击败了人类的机器都只擅长一种游戏。

“人工智能的梦想是让机器变得聪明。”他说,“今天大部分的所谓人工智能都是预先给一个机器编程。就像‘深蓝,你给它下棋所需的所有的知识和规则,如何开局、如何走子、如何终局,但‘深蓝本身的智力在哪里?相比之下,我们给AlphaGo所编程的,是一种学习如何学习的能力。这是更强大的学习能力,也是生物系统学习的方式。”

事实上,在用于破解围棋之前,DeepMind的幕后团队已经用类似的技术搭建了一个会玩很多种不同经典雅达利视频游戏(比如Pong、Breakout以及Space Invaders)的系统。在有些案例中,这些系统不仅比职业玩家还出色,它们还会以天马行空的方式玩游戏,没有人类玩家会或者可以这么玩。

当然,比起雅达利视频游戏的那套系统,AlphaGo已经有了意义不小的进化——它拥有了“计划”的能力。也就是他之前所说的“直觉”,全局观的能力,而雅达利视频游戏只需要应对当下就好了。

既然我们能在机器的神经网络中注入“直觉”,是否还有别的呢?视觉?

长期记忆?工作记忆?

在不久的将来,AlphaGo的技术还有可能会用来破解《星际争霸》。这也是最近几天媒体观战室里热议的话题。

为什么是《星际争霸》?

在Verge的一篇独家专访里,哈萨比斯是这么说的:“策略游戏需要一种不完全信息世界中的高水平策略能力。相比之下,围棋的一切都显示在棋盘上,对计算机来说反而简单。”

“癌症、气候变迁、能源、基因组学、宏观经济学、金融系统、物理学等,太多我们想掌握的系统知识正变得极其复杂。如此巨大的信息量让最聪明的人穷其一生也无法完全掌握。那么,我们如何才能从如此庞大的数据量中筛选出正确的见解呢?而一种通用人工智能思维的方式则是自动将非结构化信息转换为可使用知识的过程。我们所研究的东西可能是针对任何问题的元解决方法(meta-solution)。”

在这场轰轰烈烈的人机大战中,德米斯·哈萨比斯原本是一个隐形的主角。但随着AlphaGo连胜三局,他的照片开始陆续登上各大媒体的头条,先是韩国,然后是英国、美国、中国……

“我从小就是一个内向、爱思考的孩子。”在其中一篇特写中,他这样说道,“我总是想把事情琢磨清楚。我总是想着我的脑子是怎么想出这一步的、思考到底是怎么回事。”

有人问他:为什么要放弃国际象棋?

他解释说,他对自己的人生有更大的计划和野心。他想要攻克人类的“智力”难题。他认为,学习和通用(general)是人类智力最根本的特征。他想发明一种“通用人工智能”(General AI)——不是一点点教机器如何理解语言、识别人脸,而是利用机器学习与神经学的原理,教机器像人类一样学习,像人类一样做决策,能自然应付一切不可预知的情况。

“在现实世界中,意外总会发生。”他说,“这是为什么我们还没有扫地机器人的原因。因为每次情况都不一样。房子有什么干净、有什么脏乱,机器人需要学习怎么在不同的情况下灵活应变。”

“但是,对机器来说,所有的任务都可以以同样的方式习得吗?”我问他。

“为什么不呢?”他说,“你的大脑作为一个系统,本身就是一个通用学习机器,你学开车、学很多种语言、使用计算机、驾驶宇宙飞船,虽然可能有很多个算法或程序,但使用的是同样一套系统。”

哈萨比斯除了是一位天才的程序员之外,还是一位神经学家。2005年,他在伦敦大学进修神经学博士学位,专攻海马体,这是一块支持记忆和空间导向的大脑部分,且目前所知甚少。“我挑的这些脑领域和脑功能,都是目前对其没有优秀运算法则应对的区域。”

这将是一个长达数十年的,攻克通用人工智能的“阿波罗登月计划”。AlphaGo只是他的“登月计划”的一小步而已。

这个登月计划让我想起人工智能的开创者之一马文·明斯基。1950年他在普林斯顿大学的博士论文中就提出要搭建一个“学习机器”,以模拟大脑的神经网络。他甚至说,只要给他5个优秀的程序员,就能在3~5年的时间里实现这一目标。

近半个世纪以后,他在一本名为《情感机器》(Emotional Machine)的书中再次提出构建一个智能机器的计划,能够在不同的思维方式间切换。

在《情感机器》里,他这样写道:“人类是一种独特的足智多谋的动物,因为他能够用多种方式去处理任何事情。比如:当你在思考某一事物时,你可能以语言表达的方式去思考,也可能以逻辑术语的方式去思考,或者是图表、图像,甚至是某种结构的方式。如果一种方式行不通,你可以迅速转换到其他方式,这就是为什么我们在处理各种情况时都能运用自如的原因。”

与马文·明斯基一样,哈萨比斯也相信,随着时间的推移,这些能自己学习,而且能学习多种任务的机器,解决问题的能力会越来越强,有可能最终通向一个人类思维层面的人工智能。但是,这样的机器对人类来说到底意味着什么?无论我们举杯庆祝AlphaGo,还是李世石所代表的智慧,都应该认真考虑这个问题。