基于ROI内容保留变形算法的三维视频快速稳定

张 鑫,杨棉绒

(1.新乡学院 a.网络管理中心;b.计算机与信息工程学院,河南 新乡 453003;2.解放军信息工程大学,河南 郑州 450052)

基于ROI内容保留变形算法的三维视频快速稳定

张 鑫1a,2,杨棉绒1b

(1.新乡学院 a.网络管理中心;b.计算机与信息工程学院,河南 新乡 453003;2.解放军信息工程大学,河南 郑州 450052)

针对传统的三维视频稳定算法计算量较大的问题,提出了一种基于感兴趣区域内容保护的变形算法。首先,估计每个输入帧特征点的三维信息并确定感兴趣区域;然后,利用基于ROI整帧的图像变形算法和保持显著性的图像变形算法去除输入帧的抖动;最后,利用交叉方法去除ROI边界伪迹。在5个HD视频序列上的仿真实验结果表明,该算法可获得与其他先进算法相同的去抖动性能,且算法执行时间降低了至少14%。

三维视频;数字图像稳定;感兴趣区域;变形算法;特征点

随着图像处理和图像传感技术快速发展,数码设备的使用者也对视觉质量要求越来越高[1]。由于许多数码相机和摄像机足够小并且可以单手操作,它们对人手的抖动很敏感,导致经常得到视觉抖动的视频。因此,找到一种较好的数字图像去抖动(Digital Image Stabilization, DIS)[2]技术对获取高质量视觉效果显得至关重要。

为了降低三维视讯稳定算法的计算量,提出了一种快速视频去抖动算法,从每帧提取足够多的特征点并估计每个特征点的三维运动信息,在三维运动信息的基础上确定感兴趣区域(Regions of Interest, ROI)[3],如果ROI区域的特征点数大于阈值,则利用基于ROI的图像预变形和保持显著性图像变形算法对输入帧进行处理。仿真结果表明,在保持与先进算法相同的去抖动性能的同时,本文算法的计算复杂度降低了14%以上。

1 相关研究

传统的DIS算法首先估计每帧的摄像机运动,接着,被估计的摄像机运动被修正成接近一个预定义的相机运动轨迹,通过低通滤波输入摄像机的运动轨迹来定义并作为自然轨迹[3]。然而,这样的摄像机轨迹存在一个缺点,如果原摄像机轨迹对摄像机运动有重要意义,它将可能引起严重的图像变形。

文献[4-5]提出了一种二维视频去抖动算法通过低通滤波器获取参数并用于消除摄像机抖动的高频信息。虽然二维去抖动算法对许多摄像机抖动很有效,但是,它不能合成一个理想化的三维摄像机轨迹,因为它不知道摄像机输入的是否为三维轨迹 。

为了解决上述二维方法的缺点,学者们提出了许多三维去抖动技术[6-8],例如,文献[6]设计了一种基于可靠特征集合匹配的内容完整的视频稳定算法,为了避免运动前景上的特征点参与运动估计,由经典的KLT算法提取特征点,对于运动补偿造成的无定义区,首先计算当前帧的定义区与相邻帧的光流,从而为向导腐蚀无定义区,利用拼接方法填充仍为无定义区的像素,提高了鲁棒性,并且获得较为稳定的视频序列。为了更好地去除抖动并改善视频效果,文献[7]采用改进的SIFT算法进行特征提取,并根据动态视频相邻帧匹配的实际应用,采用邻域搜索方法进行特征匹配,提高了视频匹配的精度,通过采用Kalman滤波对运动参数平滑后进行视频图像的校正补偿,得到稳定的视频输出。文献[8]提出了一种基于特征块匹配的视频稳定算法,采用均匀分布的方式确定特征块,根据视频图像抖动特性对运动矢量进行预测,并将大钻石与小钻石搜索模板相结合,从而在阈值和搜索空间的约束下完成特征块匹配,通过运动平滑选择有效的运动矢量,有效地稳定了图像序列。文献[9]提出了一种基于保持显著性的图像变形去抖动算法(CPWS),因其优越去抖动性能而广为人知,然而,在第三步最小二乘优化过程需要较大的计算量,例如,针对一个720p的图像帧,它可能花费三小时去变形处理。

2 提出的视频稳定算法

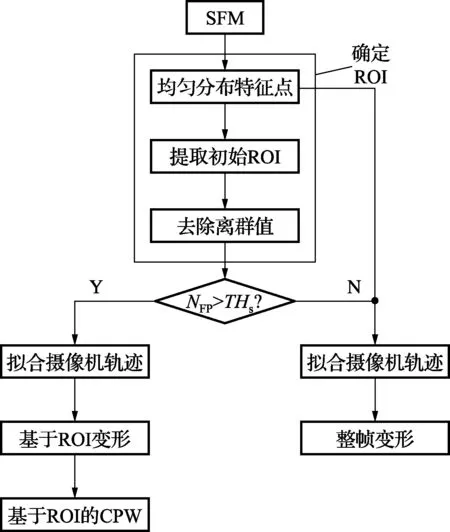

本文算法仅通过在每帧的感兴趣区域运用CPW即可有效降低计算复杂度,图1所示为本文算法的流程图。首先,均匀分布从SFM获取的特征点,然后,使用选择特征点的深度信息提取初始ROI,利用去除极端值进行适当优化。接着,通过分割ROI特征点的数量确定最佳模型,即NFP。如果NFP比设定的阈值大,则运用基于ROI的图像变形,否则,运用传统的整个帧变形。

图1 本文算法的框图

2.1 确定ROI

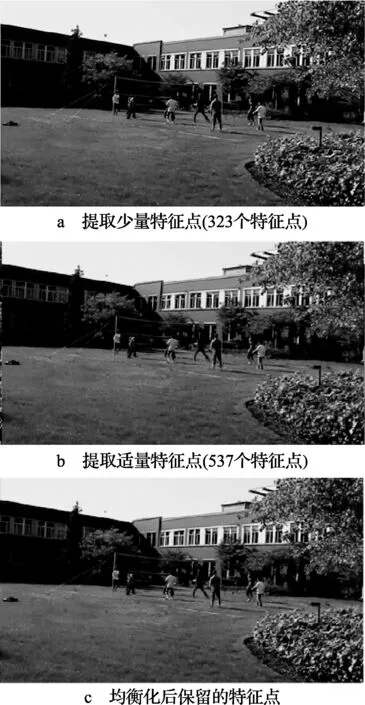

假设使用摄像机跟踪器通过运动恢复结构(Structure from Motion,SFM)[10]处理过程已经提取了特征点,特征点的分布可能影响去抖动算法的性能,图2所示为特征点提取过程,从图2a可以看出,右边比左边存在更多的特征点。由于这种分布类型没有完全反映帧的显著性特点,所以帧的去抖动质量下降了[11]。为了解决该问题,适当地增加提取特征点的数量,如图2b所示,并通过最小化相邻特征点水平和垂直距离选择合适的均匀分布特征点,如图2c所示。本文算法中最小距离设为20个像素,Funi表示近似均匀分布特征点集,图2c的特征点分布比图2a更加均匀,甚至数量更少。

图2 特征点的提取过程

接着,根据特征点的深度信息分割初始ROI,每个特征点的深度表示特征点三维坐标的Z轴值,这个三维坐标从SFM得到,Z轴表示特征点和摄像机的距离。ROI存在于每帧的中间部分,因此,首先确定每帧的中心作为ROI,在该中心区域去除每帧的四分之一边界并提取特征点。Fcen表示中心区域的特征点,Fcen从Funi中选择如下

(1)

(2)

(3)

100是根据经验确定的。若获取δmax,则提取初始ROI,通过特征点满足下列条件

(4)

到深度大于δmax的特征点组成了ROI,这是由于远处对象的运动抖动引起了视觉敏感抖动。

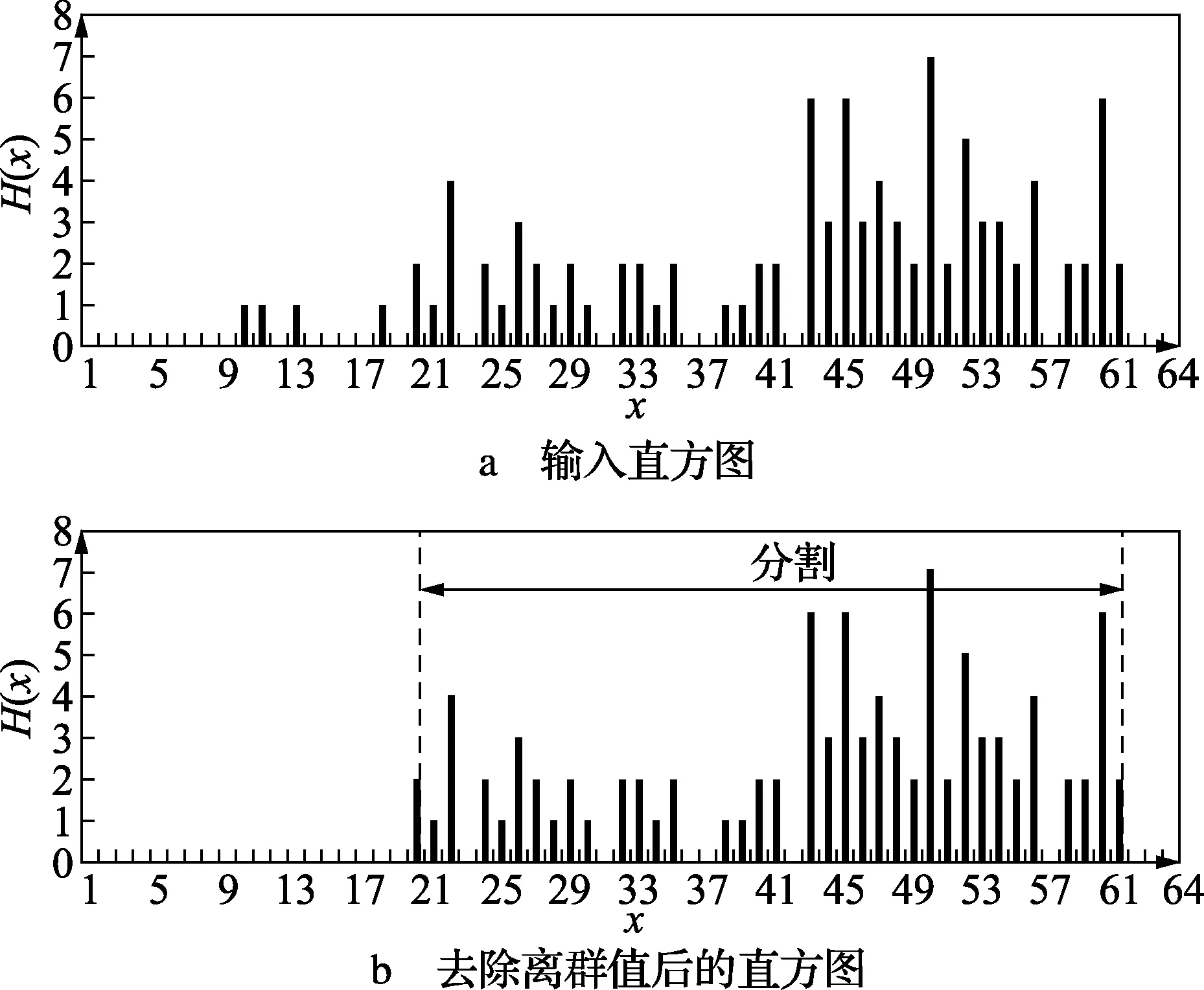

从FROI中去除可能的离群值,通过网格特征点直方图去除离群值,组成特征点水平方向直方图的离群值首先被去除,如图3所示,且保留下来的值随后在垂直直方图执行与水平直方图相同的操作。

图3 基于直方图的区域分割

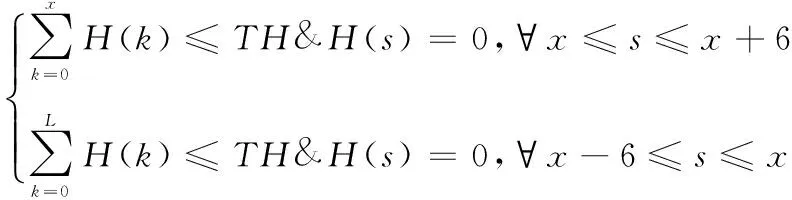

例如,首先通过下列条件去除离群值

(5)

式中:H(X)表示网格位置x的特征点数。如果x周围遮挡频率小于THp,则将相应的特征点作为离群值去除。THp为特征点总数除以100,图3b所示为去除后的结果。特征点满足式(6)的两个条件将被再次优化

(6)

式中:TH为特征点总数除以10,且L表示直方图最后的单元值。从每行第一个网格开始,式(6)的第一个条件从右向左扫描去除左边离群值。此外,从每行的最后一个网格开始,式(6)的第二个条件向左扫描去除右边的离群值。同样,保留下来的值随后从特征点垂直直方图中除去离群值。最终,获取了FROI,图4所示为一个最后优化的ROI示例。

图4 ROI中的特征点分布

2.2 基于ROI整帧的图像变形

传统的整帧变形依靠一个从一帧中获取所有深度运动信息的普通运动模型[12]。然而,如果在图像的前景和背景中存在一个大的深度差值,尽管使用同一个摄像机运动模型,前景和背景可能存在明显不同的运动。因此,因为帧的整体运动很难使用单一的投射模型来描述,传统的整帧变形又常常引起抖动现象,在某些区域像素值发生连续性的突变[13]。为了减缓这种现象,仅仅利用ROI中的特征点FROI代替所有特征点作为整幅图像的变形参数。因为在ROI中的特征点趋于相同的运动,本文提出的基于ROI整帧变形能最大化去抖动性能。

然而,如果特征点NFP的数量太小,整帧变形可能效果不佳,因此,如果NFP的数量小于THs,利用Funi传统整帧变形替代基于ROI的整帧变形。

2.3 基于ROI保持显著性的图像变形

如果NFP的数量大于THs,基于ROI的CPW被应用在基于ROI整帧变形后。在这种情况下,在ROI边界会产生一些伪迹。特别是在区域边界频发出现的伪迹有很少有特征点,因此,本文利用交叉方法[14]减少那些区域的伪迹。首先,如果网格包括至少一个特征点,它的索引Gk就为1,否则为0。接下来,对索引图像应用闭操作,这个交叉方法在网格位置被完成

(7)

式中:dk表示Vk与ROI边界的最小距离,且Dk表示边界与图像中心之间的距离。此外,FVk和CVk分别表示通过整帧变形和CPW更新的网格位置,最后,ROI边界的伪迹明显已被去除。

3 实验

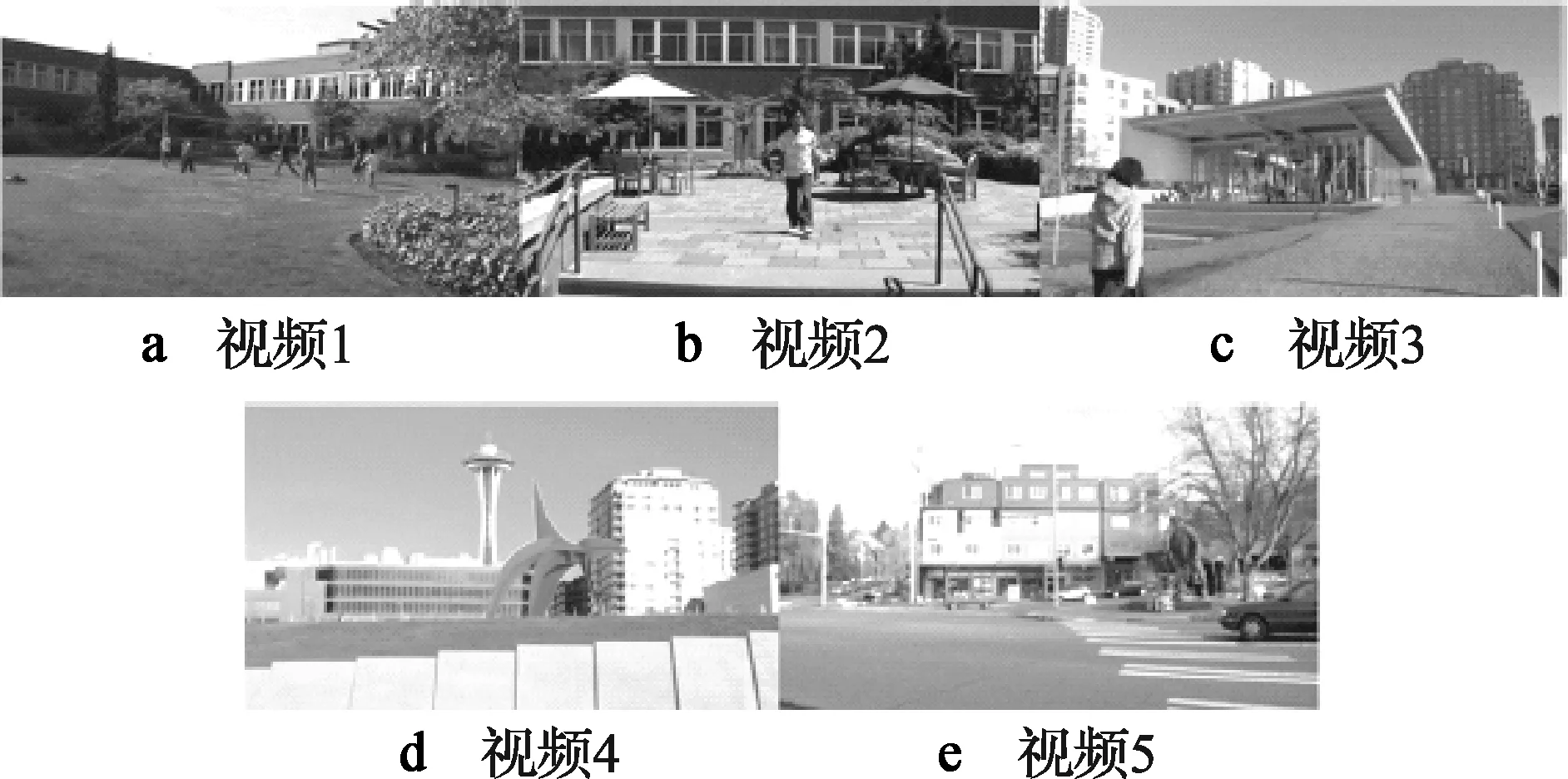

为了评估本文算法的性能,使用5个HD(720p)视频序列[15],如图5所示。实验从每个视频中提取200帧图像,使用默认的平滑权重α=20计算机结果,N,T,THs分别设为20、50、70,所有结果都在大小为64×36的网格上计算,KLT[6]追踪从摄像机跟踪器提供的一些方法中选择。将本文算法与去抖动效果非常好的文献[9]算法进行比较,使用C语言实现,所有实验均在配置为3 Gbyte RAM、2.66 GHz主频、双核英特尔CPU的主机上运行。

图5 测试视频序列

首先,将本文算法的CPU运行时间与其他算法进行比较,其中,SFM部分被排除在模拟结果以外,比较结果如表1所示。

表1 各个算法的CPU运行时间

从表1可以看出,文献[9]提出的算法每帧大约需要 3 min。 针对视频1序列,相比文献[9]提出的算法,本文算法消耗时间降低了至少14%。由于视频4序列的NFP小于THs,其没有包含到该比较结果中。

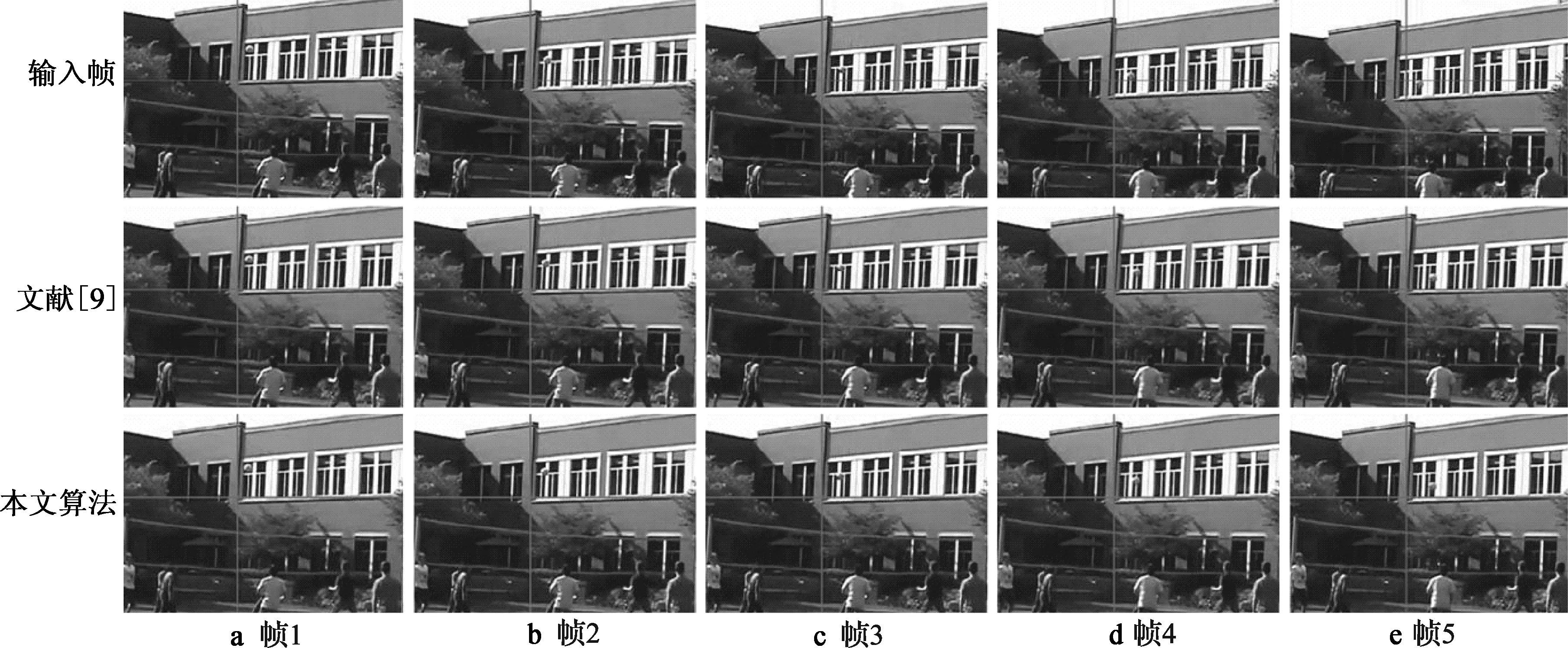

接着,图6和图7所示为在视觉质量上两种算法的实验结果。观察参考线可以发现,相比CPWS算法,本文算法几乎达到了相同的去抖动效果。例如,如图6所示,输入帧的窗口存在一些抖动,但是通过两种算法都达到了几乎相同的效果。从图7可以看出,两种算法均获得了优越的去抖动性能,可见本文算法的去抖动效果几乎与CPWS算法相同。

图6 视频1序列的仿真结果

图7 视频5序列的仿真结果

为了更好地评估本文算法的去抖动性能,使用数字显示所有特征点的统计结果,如表2所示。首先,每个特征点理想的直线轨迹通过线性回归拟合,然后,按照式(8),计算每个序列的理想直线和真实特征点的均方差MSE

(8)

式中:Lk(t)和Fk(t)分别表示第k个特征点线性回归的第k个位置和真实特征点的位置。

为了显示可信的实验结果,仅使用前60帧图像FROI中的特征点。从表2可以看出,相比文献[9]提出的算法,本文算法获得了更小的MSE。

表2 MSE线性定量比较

此外,计算每个序列前60帧每帧的MSE标准差,观察每帧MSE随时间的变化情况,见表2。由于本文算法获得的标准差小于文献[9]提出的算法,可见本文算法具有更加优越的性能。

4 结束语

本文提出了一种快速三维视频去抖动算法,通过估计每个输入帧特征点的三维信息确定感兴趣区域,利用基于ROI整帧的图像变形算法和保持显著性的图像变形算法去除输入帧的抖动,并利用交叉方法去除ROI边界伪迹。仿真结果表明,相比其他的较为先进的视频稳定算法,本文算法获得了相同的去抖动效果,并且降低了至少14%的计算量。

未来会将本文算法应用于其他视频数据库,并结合新颖技术,改变初始参数设置,进行大量实验,在保证去抖动性能的同时,进一步改善算法的执行效率。

[1] 彭艺,叶齐祥,黄钧,等. 一种内容完整的视频稳定算法[J]. 中国图象图形学报,2010,15(9):1384-1390.

[2] KUMAR S, AZARTASH H, BISWAS M, et al. Real-time affine global motion estimation using phase correlation and its application for digital image stabilization[J]. IEEE Trans. Image Processing,2011,20(12):3406-3418.

[3] 张阳, 王宣银. 基于人眼特性的视频稳定方法[J]. 吉林大学学报: 工学版, 2010, 32(2): 529-533.

[4] ZHANG K, XU T F, WANG P, et al. Real-time full-frame digital image stabilization system by SURF[J]. Guangxue Jingmi Gongcheng(Optics and Precision Engineering), 2011, 19(8): 1964-1972.

[5] GOLDSTEIN A, FATTAL R. Video stabilization using epipolar geometry[J]. ACM Trans. Graphics (TOG), 2012, 31(5): 126-132.

[6] LIAO J, CAO J, TANG L. Research on video stabilization algorithm based on SIFT and improved RANSAC[C]//Proc. 2012 Second International Conference on Electric Information and Control Engineering. [S.l.]:IEEE Press, 2012: 755-758.

[7] 林锦梅, 周付根,金挺. 采用SIFT特征的空基动态视频稳定技术[J]. 红外与激光工程,2012,40(12): 2552-2557.

[8] ZHOU Z, JIN H, MA Y. Plane-based content preserving warps for video stabilization[C]//Proc. 2013 IEEE Conference on Computer Vision and Pattern Recognition(CVPR). [S.l.]:IEEE Press,2013: 2299-2306.

[9] ZHOU Z, JIN H, MA Y. Plane-based content preserving warps for video stabilization[C]//Proc. 2013 IEEE Conference on Computer Vision and Pattern Recognition(CVPR). [S.l.]:IEEE Press,2013: 2299-2306.

[10] 张剑. 融合SFM和动态纹理映射的视频流三维表情重建[J]. 计算机辅助设计与图形学学报, 2010, 31(6): 949-958.

[11] KIM S W, YIN S, YUN K, et al. Spatio-temporal weighting in local patches for direct estimation of camera motion in video stabilization[J]. Computer Vision and Image Understanding, 2014, 118(3): 71-83.

[12] TANG C, WANG R. Sparse moving factorization for subspace video stabilization[C]//Proc. 2014 IEEE International Conference on Acoustics,Speech and Signal Processing (ICASSP). [S.l.]:IEEE Press,2014: 4314-4318.

[13] ZHOU Z, JIN H, MA Y. Plane-based content preserving warps for video stabilization[C]//Proc. 2013 IEEE Conference on Computer Vision and Pattern Recognition(CVPR). [S.l.]:IEEE Press,2013: 2299-2306.[14] 张淼.视频稳像技术研究[D]. 上海:上海交通大学, 2011.

[15] ZAHARIA C, BIGIOI P, CORCORAN P M. Hybrid video-frame pre-processing architecture for HD-video[C]//Proc. 2011 IEEE International Conference on Consumer Electronics(ICCE).[S.l.]:IEEE Press,2011:89-90.

张 鑫(1979— ),硕士,讲师,主要研究方向为视频处理、图像处理、人工智能等;

杨棉绒(1979— ),女,硕士,讲师,主要研究方向视频处理、图像处理、人工智能等。

责任编辑:时 雯

Three Dimensional Video Fast Stabilization Based on Warping Algorithm with Content Preserving in Region-of-Nterest

ZHANG Xin1a,2, YANG Mianrong1b

(1a.NetworkManagementCenter;1b.CollegeofComputerandInformationEngineering,XinxiangUniversity,HenanXinxiang453003,China;2.ThePLAInformationEngineeringUniversity,Zhengzhou450052,China)

For the issue that it exists large amount of calculation in traditional 3D video stabilization algorithms, a warping algorithm based on content protection in region-of-interest is proposed. Firstly, the 3D information of each input frame feature points is estimated so as to determine ROI. Then, warping algorithm based on ROI whole frame and keeping the significant is used to remove the jitter of input frame. Finally, intersect method is used to remove the boundary artifact of ROI. Simulation experimental results on five HD video sequences show that proposed algorithm can get same stabilization performance with state-of-the-art algorithm, and it has reduced above 14% executing time.

three dimensional video; digital image stabilization; region-of-interest; warping algorithm; feature point

【本文献信息】张鑫,杨棉绒.基于ROI内容保留变形算法的三维视频快速稳定[J].电视技术,2015,39(11).

河南省科学技术计划发展项目(122400450245)

TP399

A

10.16280/j.videoe.2015.11.010

2014-08-21