基于节奏和韵律调制谱特征的音乐流派分类

庄 严,于凤芹

(江南大学物联网工程学院,江苏无锡214122)

其中,p代表谱图成分的掩膜权重系数,通常p取值1,2。

利用掩膜从混合原复数谱图中分离得到打击与和声成分谱图和:

基于节奏和韵律调制谱特征的音乐流派分类

庄 严,于凤芹

(江南大学物联网工程学院,江苏无锡214122)

音乐主要包括形成节奏的冲击成分和形成韵律的和声成分,直接从音乐信号中提取特征会受到这2种成分相互影响。利用节奏与和声在时频平面具有不同规律的特点,通过对音乐信号进行谱图滤波,分离出音乐中的打击成分与和声成分。对打击与和声谱图分别进行小波调制,得到表现音乐节奏和韵律谱规律的调制谱特征,将其作为音乐流派分类中的长时特征。仿真实验结果表明,分离后的打击与和声成分谱图清晰地表征了音乐节奏和韵律的特点和规律;对8类音乐流派提取打击与和声调制谱特征,经线性鉴别分析降维后利用支持向量机进行分类,分类准确率达到73.54%。

谱图分离;中值滤波;小波调制谱;节奏和韵律;中级特征;音乐流派分类

1 概述

音乐分类检索系统的研究和应用近年来受到广泛关注[1]。音乐风格流派是最主要的分类依据,它取决于音乐的文化背景、演奏乐器、艺术家等诸多因素。目前,多数音乐流派分类的特征都是基于时频谱图的短时特征,如倒谱系数(Mel Frequency Cepstrum Coefficient,MFCC)特征、频谱对比度特征等[2],通常为20 ms~30 ms,忽略了音乐长时特征所包含的语义性,1 s~2 s的中时特征能够反映音符的变化和颤音,更长的音乐片段乃至整个音乐样本的长时特征能够统计节拍快慢、情感变化[3];另一方面,音乐样本由多种音乐元素组成,在特征提取阶段,往往并不考察音乐元素之间的差异,直接对成分混合的整个样本提取特征,不同成分间相互干扰,使特征提取困难,所提取的特征也不能较好反映流派特点,最终导致分类识别率较低。文献[4]提出了调制谱对比度特征来表征音乐信号随时间变化的长时信息,来弥补短时特征的不足,但并没有考虑不同音乐元素时变信息的差异和相互间干扰。文献[5]模拟人类听觉系统对音乐信号的处理,得到音乐的听觉谱图再提取特征,从而得到时变信息,但听觉系统同时也过滤了音乐某些细节信息,对GTZAN库仿真实验取得了74%的平均准确率。文献[6]提取音乐和声序列作为流派分类的长时特征,对9类流派分类达到了68%的准确率,但其忽略了至关重要的节奏信息。文献[7]利用互联网标签、艺术家姓名等语义特征进行流派分类,同时,节拍、主旋律、乐器信息等中级特征模型被不断提出[8-10],为信息检索和分类系统研究提供了新思路。

本文提出基于谱图分离的节奏和韵律调制谱特征的音乐流派分类算法。针对成分混叠引起的相互干扰,利用中值滤波法对音乐原始谱图分离得到打击与和声成分谱图。根据2种成分时频分布特点,对打击成分采用短窗谱图、和声成分采用长窗谱图,再对打击成分谱图进行小波尺度时域调制、和声谱图进行小波尺度时域调制和频域调制,得到打击与和声的长时特征以及和声成分的频率分布特征。联合节奏和韵律调制谱对比度、峰谷值及其均值方差等特征作为音乐流派分类特征,利用线性判别分析(Linear Discriminant Analysis,LDA)降维后再进行支持向量机(Support Vector Machine,SVM)分类,以降低特征维数,提高分类效率[11]。

2 音乐流派分类

2.1 打击与和声谱图分离

打击成分与和声成分在时频谱图中具有不同表现,前者表现为短时连续的频谱分量,后者有典型的谐波性[12],对这2种成分进行谱分离。在给定的时间帧内,能量较大的谐波频率成分代表和声成分,呈现峰值特性,打击成分呈现宽带平滑特点,通过滤除能量较大的峰值频率成分就得到了分离的打击成分;类似地,对于和声成分,由于打击成分持续时间较短,能量集中,在给定的频点上属于峰值部分,通过滤除能量峰值就得到了分离的和声成分。打击与和声成分分离利用中值滤波能够滤除峰值较大的奇异值这一特性,实现了2种成分谱图的分离[13],给定一音乐样本,计算其谱图S:

第i时间帧的谱图为Si,对Si运用中值滤波得到打击成分增强的谱图帧Pi:

其中,lper为打击成分谱图增强的中值滤波器分析窗长;median为中值滤波器。

其中,输入向量x(n)经过窗长为l的中值滤波器输出为y(n),此处l为奇数、l为偶数时,y(n)取按大小排列的中间2个采样点的均值,所有谱图帧Pi构成打击成分增强的谱图P。

同理,对第h频率帧的谱图Sh运用窗长为lhar的中值滤波器得到和声成分增强的谱图帧Hh:

所有谱图帧Hh构成和声增强的谱图H。为了能够分离打击与和声成分,P和H用来生成软阈值掩膜MH和MP:

其中,p代表谱图成分的掩膜权重系数,通常p取值1,2。

利用掩膜从混合原复数谱图中分离得到打击与和声成分谱图和:

其中,⊗代表矩阵对应元素相乘。

2.2 小波调制谱特征

谱图能够表现音乐重要的时频信息,对于节奏,谱图能体现打击乐器的能量强度、节拍的快慢变化、乐器的音色等诸多信息;对于韵律,谱图能体现和声音高,伴奏乐器的基频、谐波分布、音调的高低变化。然而这些长时信息要想直接从谱图中提取出来并不容易,信号的低频时域调制特征通常包含了随时间变化的重要信息[14]。通过对谱图再进行快速傅里叶变换(Fast Fourier Transform,FFT)算法或小波变换,能够进一步得到音乐信息随时间变化的动态特征。

其中,对谱图y(t,Ω)沿时域方向应用小波变换,得到离散调制尺度s、小波时移ζ、频率Ω 3个参数的调制谱图Px(s,ζ,Ω);ψ(t)是小波函数。

为综合时间方向上谱图能量的变化,得到长时动态特征,对Px(s,ζ,Ω)在小波时移ζ方向上作积分,如式(8)所示,得到调制尺度-频率联合表示调制谱,调制尺度s可以按式(9)转换成调制频率Fs,Fc是所采用小波的中心频率,Δ是采样周期,于是得到调制频率与频率联合的调制谱,调制谱特征反映了谱图中各频率分量的能量之和随时间动态变化的情况[15]。

3 算法实现步骤

本文音乐流派分类算法的具体步骤如下:

(1)对音乐样本计算其谱图,运用中值滤波算法分离打击成分与和声成分谱图。

(2)2种成分的谱图参数设置为,打击成分采用短窗,窗函数长度1 024点,帧移256点,和声成分采用宽窗,窗函数长度4 096点,帧移1 024点。

(3)对打击与和声成分谱图进行小波时域调制求调制谱特征:1)按八度频率划分成8个子带,对各子带进行时域小波尺度调制,得到离散尺度与八度频率子带的调制谱表示8×尺度总数维,求取8个子带调制谱的如下特征:子带内调制谱均值、方差(8×2=16维);2)峰值、谷值、对比度(8×3=24维);3)在每个子带内根据尺度再划分尺度子带,求取各尺度子带内调制谱的峰谷值和对比度的均值和方差,能够得到子带内更细致的特征(8×6=48维),共88维特征。

(4)对和声成分谱图进行小波频域调制:对和声成分每帧谱图按频率方向应用小波尺度调制,得到和声成分频域调制谱,对其求各尺度调制谱的均值、方差、峰值、谷值、对比度,并计算它们在时间上的均值和方差,即10维特征。

(5)为了降低特征维数,对步骤(3)中时域调制谱特征集1),2),3)用LDA分别降至7维,即7×3=21维,对步骤(4)中和声频域调制谱特征降至7维;一个样本的特征向量包括:打击成分时域调制谱特征(21维)+和声成分时域调制谱特征(21维)+和声成分频域调制谱特征(7维),共49维。

(6)对音乐库GTZAN 8类音乐流派,按每类100个样本提取特征,构成800×49维分类特征矩阵。

(7)通过10折交叉验证的SVM分类器,得到最终音乐流派分类准确率。

4 仿真实验与结果分析

仿真实验采用GTZAN音乐样本库中蓝调、经典、乡村、迪斯科、嘻哈、爵士、重金属、流行等8种流派音乐片段各100个,共800个音乐样本。每个样本为时长30 s,采样频率22.05 kHz的16 bit单声道数字信号。

打击成分与和声成分分离是特征提取的前提步骤,如图1所示,图1(a)为音乐样本Disco.00055分离前的谱图,图1(b)为分离的打击成分谱图,图1(c)为分离的和声成分谱图,分离谱图的中值滤波器采用长度 17点,打击成分谱图分帧窗长1 024点,帧移 256点,和声成分谱图分帧窗长4 096点,帧移1 024点,对比可以发现,分离后谱图能更清晰地表现打击、和声的音乐特征。

图1 音乐样本Disco.00055成分分离前后的谱图

表1为不同特征集的10折交叉验证分类结果对比,由表中第2行、第3行可以看出,经成分分离后,打击成分的MFCC特征的分类准确率比未分离的高出了5.25%,联合打击与和声成分的MFCC特征分类准确率更是达到了71.82%,对于小波调制谱也得到了同样的结果。由此可见,分离这2种成分有助于提高分类识别结果。同时,小波调制谱特征相比MFCC,在和声成分的分类准确率较高,总体分类准确率相当,经LDA降维后的联合分类准确率较MFCC有所提高,达到了73.54%,且特征维数明显减少,提高了分类效率。

表1 不同特征集分类效果对比

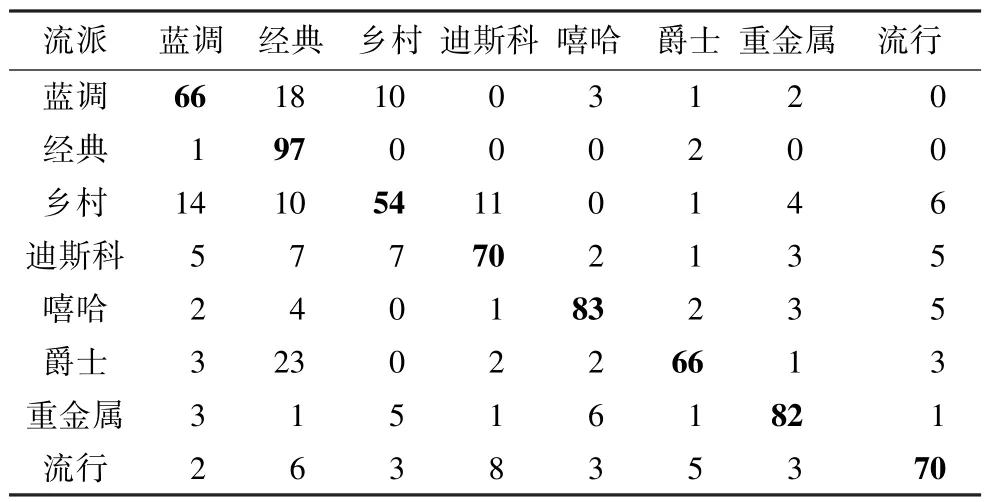

表2列出了8类样本具体正确与错分的情况,加粗数据为正确分类数,其中,经典分类准确率最高,达到了97%,最低为乡村,仅有54%,蓝调、乡村易相互错分,综其原因是两者多数抒情缓和,节奏和韵律的谱图表现较相似,但演唱者歌声、伴奏乐器有明显区别[16],应进一步寻找有效鉴别特征;爵士易错分为经典,主要是因为两者均用到了很多古典乐器,谱分布比较类似,都具有规律的和声谐波特点,导致错分的出现,但爵士多数使用铜管乐器,如萨克斯,而经典常用弦乐器,如小提琴、大提琴等,因此乐器信息将有助于避免这种错分情况[17],提高分类准确率。

表2 本文算法的8类样本分类情况

5 结束语

本文提出基于谱图滤波分离调制谱特征的音乐流派分类算法,通过对谱图滤波分离打击与和声成分,减少两者之间的互相干扰,优化特征提取效果,并且通过提取音乐的长时动态特征,弥补短时特征的不足。对8类音乐流派类别进行仿真实验,与未进行成分分离的调制谱特征以及MFCC特征比较,本文算法的分类准确率有明显提高,达到73.54%,但蓝调与乡村、爵士与经典等类别还存在较多的错分现象,因此需要进一步寻找新的特征以提高分类准确率。

[1] Michael A,Remco V.Content-based Music Information Retrieval:Current Directions and Future Challenges[J]. Proceedings of the IEEE,2008,96(4):668-696.

[2] Lee Chang-Hsing,Shih Jau-Ling.Fusion of Static and Transitional Information of Campestral and Spectral Features for Music Genre Classification[C]// Proceedings of IEEE Asia-Pacific Services Computing Conference.[S.l.]:IEEE Press,2008:751-756.

[3] Anders M,Peter A.Temporal Feature Integration for Music Genre Classification[J].IEEE Transactions on Audio,Speech,and Language Processing,2007,15(5): 1654-1664.

[4] Lee Chang-Hsing,Shih Jau-Ling.Automatic Music Genre Classification Using Modulation Spectral Contrast Feature[C]//Proceedings of IEEE International Conference on Multimedia and Expo.[S.l.]:IEEE Press,2007:204-207.

[5] Yannis P,Constantine K.Non-negative Multilinear Principal Component Analysis of Auditory Temporal Modulations for Music Genre Classification[J].IEEE Transactions on Audio, Speech, and Language Processing,2010,18(3):576-588.

[6] Carlos P S,David R.Genre Classification of Music by Tonal Harmony[J].Intelligent Data Analysis,2010, 14(5):533-545.

[7] 甄 超,郑 涛,许洁萍.基于音乐语义信息的音乐流派分类研究[C]//第五届全国信息检索学术会议论文集.上海:[出版者不详],2009.

[8] Islam M K,Lee H J.Content-based Music Retrieval Using Beat Information[C]//Proceedings of the 4th International Conference on Fuzzy Systems and Knowledge Discovery.[S.l.]:IEEE Computer Society, 2007:317-321.

[9] Poliner G E,Ellis D P W.Melody Transcription from Music Audio:Approaches and Evaluation[J].IEEE Transactions on Audio, Speech, and Language Processing,2007,15(4):1247-1256.

[10] Durrieu J K,David B.A Musically Motivated Mid-level Representation for Estimation and Musical Audio Source Separation[J].IEEE Selected Topics in Signal Processing,2011,5(6):1180-1191.

[11] 徐 星.基于最小一范数的稀疏表示音乐流派与分类器分类算法研究[D].天津:天津大学,2011.

[12] Thoshkahna B,Ramakrishnan K R.A Modified Spectrogram Diffusion Algorithm for Improved Harmonic/Percussion Separation in Music Signals[C]// Proceedings of 2012 International Conference on Signal Processing and Communications.[S.l.]:IEEE Press, 2012:1-5.

[13] Fitzgerald D.Harmonic/Percussive Separation Using Median Filtering[C]//Proceedings of Conference on Digital Audio Effects.[S.l.]:IEEE Press,2010:1-4.

[14] Somsak S,Les E A.Modulation-scale Analysis for Content Identification[J].IEEE Transactions on Signal Processing,2004,52(10):3023-3035.

[15] 谢秀琴,刘若伦.音乐信号的时频分析[J].声学技术, 2008,27(4):543-546.

[16] Ezzaidi H,Bahoura M.Singer and Music Discrimination Based Threshold in Polyphonic Music[C]//Proceedings of 2010 IEEE InternationalSymposium on Signal Processing and Information Technology.Luxor,Egypt: IEEE Press,2011:445-450.

[17] Durrieu J,David B.A Musically Motivated Mid-level Representation for Pitch Estimation and Musical Audio Source Separation[J].IEEE Selected Topics in Signal Processing,2011,5(6):1180-1191.

编辑 陆燕菲

Music Genre Classification Based on Modulation Spectrum Features of Rhythm and Rhyme

ZHUANG Yan,YU Fengqin

(School of Internet of Things Engineering,Jiangnan University,Wuxi 214122,China)

Music is mainly composed of percussive component and harmonic component,and the former forms the rhythm while the latter forms melody and harmony.Extracting features from the music samples directly are affected by the interaction between the two components.As the rhythm and harmony presenting different distributions in the timefrequency plane,the percussive component and the harmonic component can be separated by applying filtering on the spectrogram.It modulates the percussive and harmonic spectrograms with wavelet respectively and then gets the music rhythm and rhyme modulation spectrum features,which describes the long-term mid-level features of music genres. Experimental results show that the music rhythm and rhyme features represent feature and rule of rhythm and rhyme after the percussive and harmonic spectrogram separation.And the classification accuracy is 73.54% for eight music genres classification applying this method with Linear Discriminant Analysis(LDA)and afterward Support Vector Machine(SVM).

spectrogram separation;median filtering;wavelet modulation spectrum;rhythm and rhyme;intermediate feature;music genre classification

1000-3428(2015)01-0186-04

A

TP37

10.3969/j.issn.1000-3428.2015.01.034

国家自然科学基金资助项目(61075008)。

庄 严(1989-),男,硕士,主研方向:模式识别,信号处理;于凤芹,教授、博士。

2014-01-17

2014-03-12 E-mail:yanzhuangzz@126.com

中文引用格式:庄 严,于凤芹.基于节奏和韵律调制谱特征的音乐流派分类[J].计算机工程,2015,41(1):186-189.

英文引用格式:Zhuang Yan,Yu Fengqin.Music Genre Classification Based on Modulation Spectrum Features of Rhythm and Rhyme[J].Computer Engineering,2015,41(1):186-189.