基于稀疏直方图的空间机械臂视觉目标跟踪方法

高 升 袁宝峰 齐 哲 陈 磊 王 康 梁常春

(北京空间飞行器总体设计部空间智能机器人系统技术与应用北京市重点实验室,北京 100094)

基于稀疏直方图的空间机械臂视觉目标跟踪方法

高 升 袁宝峰 齐 哲 陈 磊 王 康 梁常春

(北京空间飞行器总体设计部空间智能机器人系统技术与应用北京市重点实验室,北京 100094)

视觉系统作为空间机械臂的重要组成部分,一项重要功能就是在复杂空间环境下在规定周期内自主、可靠地完成对空间目标的跟踪,即在相机采集的图像序列中定位目标区域。文章面向空间机械臂视觉跟踪的应用需求,提出一种基于稀疏直方图的视觉目标跟踪方法,在目标区域内选取相互重叠的局部图像块,通过组合全部图像块的稀疏系数构造直方图以获取目标表示,采用基于簇比重信息的相似性度量方法计算目标模板与候选目标之间的距离,将此距离作为粒子滤波的观测模型以在图像中确定目标位置。标准测试集测试、室内环境和在轨环境试验的定性和定量分析结果均表明文中方法可以实现对相机视场范围内目标的准确和可靠跟踪。

目标表示 稀疏直方图 相似性度量 空间机械臂 视觉系统

0 引言

空间机械臂是深入开展航天活动必不可少的工具。在中国的载人航天三期工程中,空间机械臂作为支持空间站建设和运营的关键性技术,承担着舱段转位、悬停飞行器捕获和辅助对接、支持航天员出舱活动、舱外货物搬运、舱外状态检查、有效载荷照料等任务。空间机械臂也是空间服务领域的重要基础技术,实现对目标飞行器的接近和捕获,进而完成对航天器故障部件的检测、维修和更换等任务。空间机械臂还是开展月球及深空探测所必须的支撑性技术,当探测器在目标星球着陆后,需要空间机械臂对采样目标进行近距离的观察、分析和选取,进而对采样样本进行清理、抓取、搬运和装载等操作。空间机械臂在轨完成上述任务过程中,不但要能够进行大范围运动,还需要完成一系列精度高、稳定性强的精准操作。为满足这些要求,机械臂必备组成之一就是空间视觉系统,它相当于机械臂的眼睛,机械臂除开环控制外的所有工作模式都不能离开视觉系统的引导和辅助而独立实现,没有视觉系统,空间机械臂将失去其主要的功能。因此,空间视觉技术成为机械臂从研制到应用的整个过程中亟待突破的关键技术之一。面向空间机械臂的应用需求,视觉系统担负着监视与测量两项主要任务,其中一个重要的基本功能就是在规定周期内自主、可靠地完成对空间目标的跟踪,即在相机采集的图像序列中定位目标区域。

国外以国际空间站和航天飞机为平台,现已在轨运行或经过飞行验证了“加拿大 I臂”Canadarm(shuttle remote manipulator system,SRMS)、“加拿大II臂”Canadarm 2(space station remote manipulator system,SSRMS)、“特殊用途灵巧机械臂”(special purpose dexterous manipulator,SPDM)、“日本臂”(Japanese experiment module remote manipulator system,JEMRS)等多个空间机械臂系统。为满足空间机械臂的在轨应用需求,已至少发展了“空间视觉系统”(space vision system,SVS)[1]、“先进空间视觉系统”(advanced space vision system,ASVS)[2]、“加拿大空间视觉系统”(Canadian space vision system,CSVS)[3]等三代空间视觉系统,完成空间目标的识别、位姿测量和跟踪,辅助SRMS、SSRMS、SPDM空间机械臂完成在轨作业任务。

空间目标视觉跟踪方法主要有两类[4]:自底向上(bottom-up)和自顶向下(top-down)。自底向上的方法也称为数据驱动的方法,这类方法不依赖于先验知识,根据图像的底层特征获取目标信息并完成跟踪,具有计算速度快、便于工程实现的优点,目前已经有大量采用这类方法完成目标跟踪的应用系统[5]。自底向上的方法在相机固定、静止的情况下效果较好,但是在相机处于运动的情况下,鲁棒性较差。自顶向下的方法也称为模型驱动的方法,这类方法依赖于所构建的目标模型和有关运动的先验知识,一般采用“预测—匹配—更新”的计算模式,在贝叶斯理论框架下求解后验概率,并选取最大后验概率所对应的状态向量表示目标的当前状态[6]。基于模型的方法可以得到比较精确的跟踪结果,但是存在先验知识难以表达、计算耗时等问题。为了克服上述两类方法的不足,实现优势互补,研究学者提出了二者相结合的方法用于目标跟踪,以提高目标视觉跟踪的鲁棒性、准确性、实时性。为了解决目标表示(即表观模型的建立)这一关键问题,研究学者相继提出基于颜色直方图特征[7]、基于核密度估计[8]、基于混合高斯模型[9]的方法建模目标表观信息,解决目标视觉跟踪问题。近年来,一些研究团队还将目标视觉跟踪视为一个目标区域和非目标区域的二分类问题[10-11],通过构建分类器将目标与非目标区分开来,这一类方法也被称为判别式跟踪方法,如多事例学习检测跟踪方法(multiple instance learning,MIL)、跟踪学习检测算法(tracking learning detection,TLD)。

本文针对空间机械臂对视觉系统的应用需求,提出一种基于稀疏直方图的视觉目标跟踪方法,在粒子滤波目标跟踪框架下,通过组合目标区域内相互重叠的局部图像块的稀疏系数构造直方图以获取目标表示,采用基于簇比重信息的相似性度量方法计算目标模板与候选目标之间的距离,并作为粒子滤波的观测模型,进而在图像序列中实现目标定位。

1 基于稀疏直方图的目标跟踪方法

1.1 目标表示

近年来,稀疏表示作为一种有效的目标表示策略在目标视觉跟踪领域得到了广泛应用[12]。稀疏表示的核心思想是将数据表示为一个字典中若干基元的线性组合,而且只需要较少的几个基元就可以实现数据表示,线性组合权重向量称之为稀疏系数。

本文使用图像的灰度特征表示目标的表观信息,采用重叠滑动窗口的方式在目标区域归一化的图像上提取N个W×H大小的图像块。对于第i个图像块,利用该图像块内全部像素点的灰度特征提取图像块的特征向量

式中 Iij为第i个图像块内第j个像素点的灰度值,其中m W H= × 。

在第一帧图像中,利用 N个图像块,运用 k-means算法聚类得到字典其中Di(i=1,2,3,…,n)表示字典的基元,n表示聚类中心的数量,这n个聚类中心可以很好地体现目标中比较有代表性的模式。每个图像块可以表示成字典基元的稀疏线性组合。每个图像块特征向量稀疏系数)可通过式(1)计算

式中 λ为正则化参数。

组合N个图像块的稀疏系数并做归一化处理,将得到的归一化直方图作为目标表示,其中M表示直方图维度。

1.2 相似性度量

本文采用基于簇比重信息的相似性度量方法[13]计算目标模板与候选目标之间的距离。定义和 q分别为根据上节方法得到的目标模板与候选目标的直方图,p和q的第i簇的距离可定义为

1.3 目标定位

假定相邻两帧间目标的运动是仿射运动,用仿射运动参数表示目标状态,其中 xt和 yt分别表示目标在图像水平方向和垂直方向的位置; μt、 θt、 ωt、 φt分别表示尺度、旋转角、纵横比和倾斜方向,并假定 xt、 yt、μt、θt、ωt、φt彼此之间都是相互独立的。假定运动模型p(stst-1)为高斯模型。观测模型)定义为

采用最大后验估计的策略,在一系列候选目标中选取后验概率最大的作为当前时刻目标跟踪的结果。

2 试验

2.1 标准测试集测试

采用标准测试集对本文所提出的视觉跟踪方法进行了定量测试[14]。为了验证方法的鲁棒性和稳定性,在各次测试过程中,参数的设置完全相同,其中归一化图像大小为32×32,以2个像素为步长采用重叠滑动窗口的方式提取N=169个W×H=8×8的图像块。字典D中基元数量(聚类中心数量)n=50,正

则化参数λ=0.1。粒子数量为400,仿射运动参数 st为

采用平均中心点误差和平均重叠率两个指标作为跟踪结果的评价准则。中心点误差定义为图像中跟踪结果与目标真值的中心点之间的欧氏距离(单位:像素),计算公式为

式中 xR和 yR分别为跟踪结果图像区域中心点在图像水平方向和垂直方向上的像素坐标;xT和 yT分别为目标真值图像区域中心点在图像水平方向和垂直方向上的像素坐标。则平均中心点误差εP定义为

式中 f为图像序列中图像的数量。

重叠率定义为

式中 AR代表跟踪结果的图像区域; AT代表目标真值的图像区域。则平均重叠率定义为

根据式(6)、(8)可知:平均中心点误差εP越小、平均重叠率εo越大,表示目标跟踪性能越好。

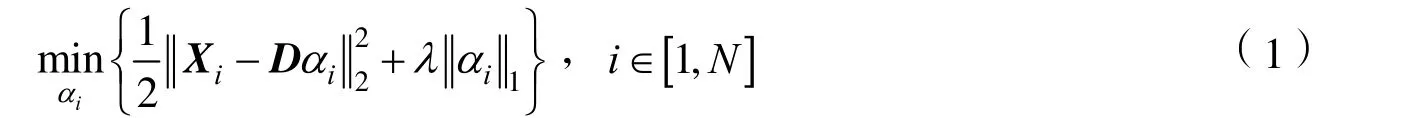

本文方法及MIL、TLD跟踪算法在4个标准测试集上(图像序列首帧如图1所示)的测试结果见表1。可以看出,本文所提方法的目标跟踪性能与MIL及TLD算法相当。

图1 标准测试集图像序列首帧(矩形框代表目标区域)Fig.1 The first frame of each benchmark dataset

表1 标准测试集目标跟踪测试结果Tab.1 Object tracking results on benchmark datasets

2.2 真实环境试验

在室内环境和空间在轨环境下分别进行视觉目标跟踪测试,以定性评估本文所提出方法在实际环境中的性能。

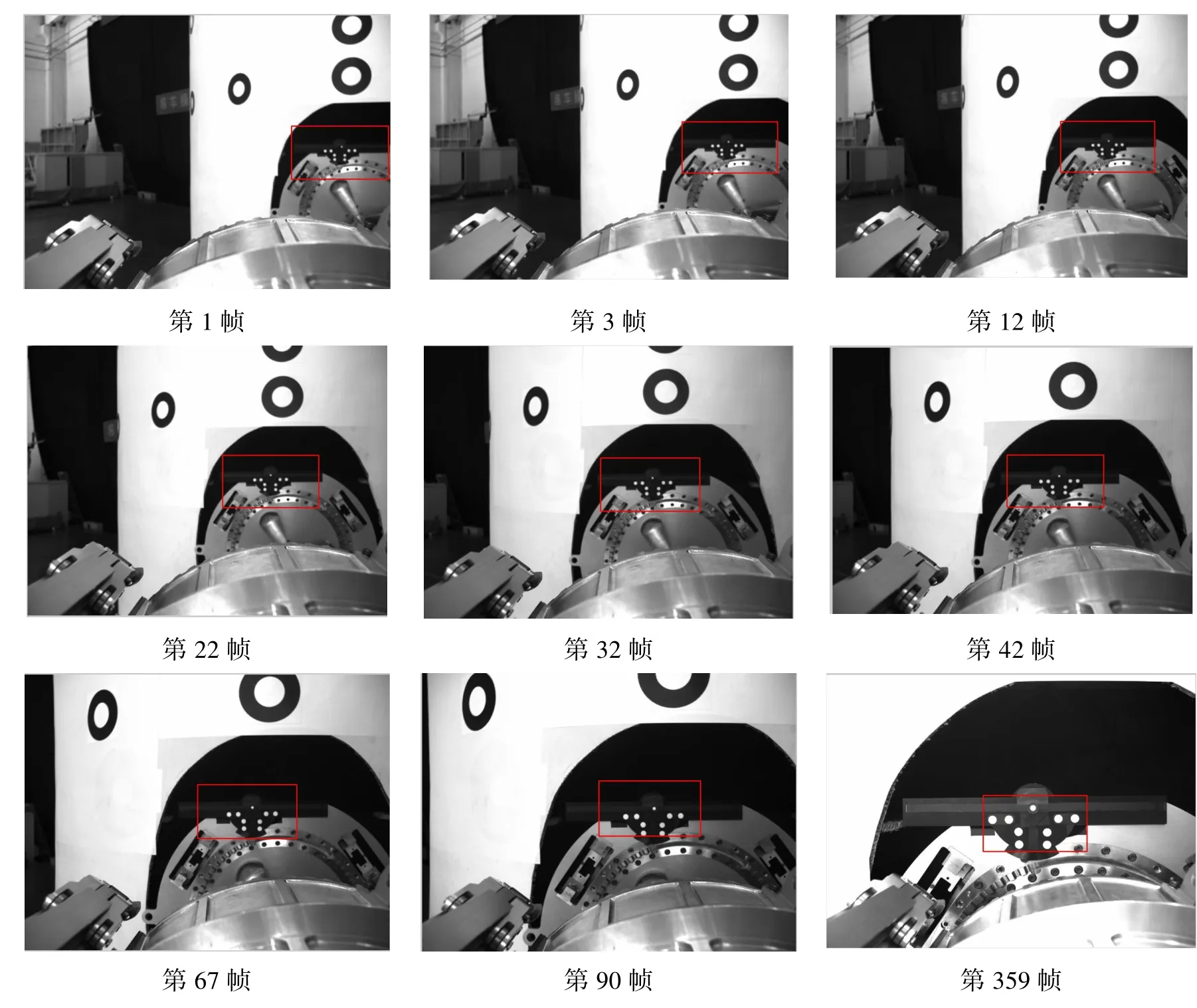

室内环境试验下,在机械臂执行目标捕获任务过程中,自目标进入机械臂视觉系统[15]视场直至机械臂完成对目标的捕获,视觉系统需完成对目标(合作目标上安装的视觉标记)的连续跟踪。在此过程中,从相机采集的图像序列(共359帧图像)中选取9幅代表性图片,目标跟踪结果如图2所示,矩形框代表在图像中定位出的目标区域。结果表明,本文方法可以实现对相机视场范围内目标的准确、可靠跟踪。

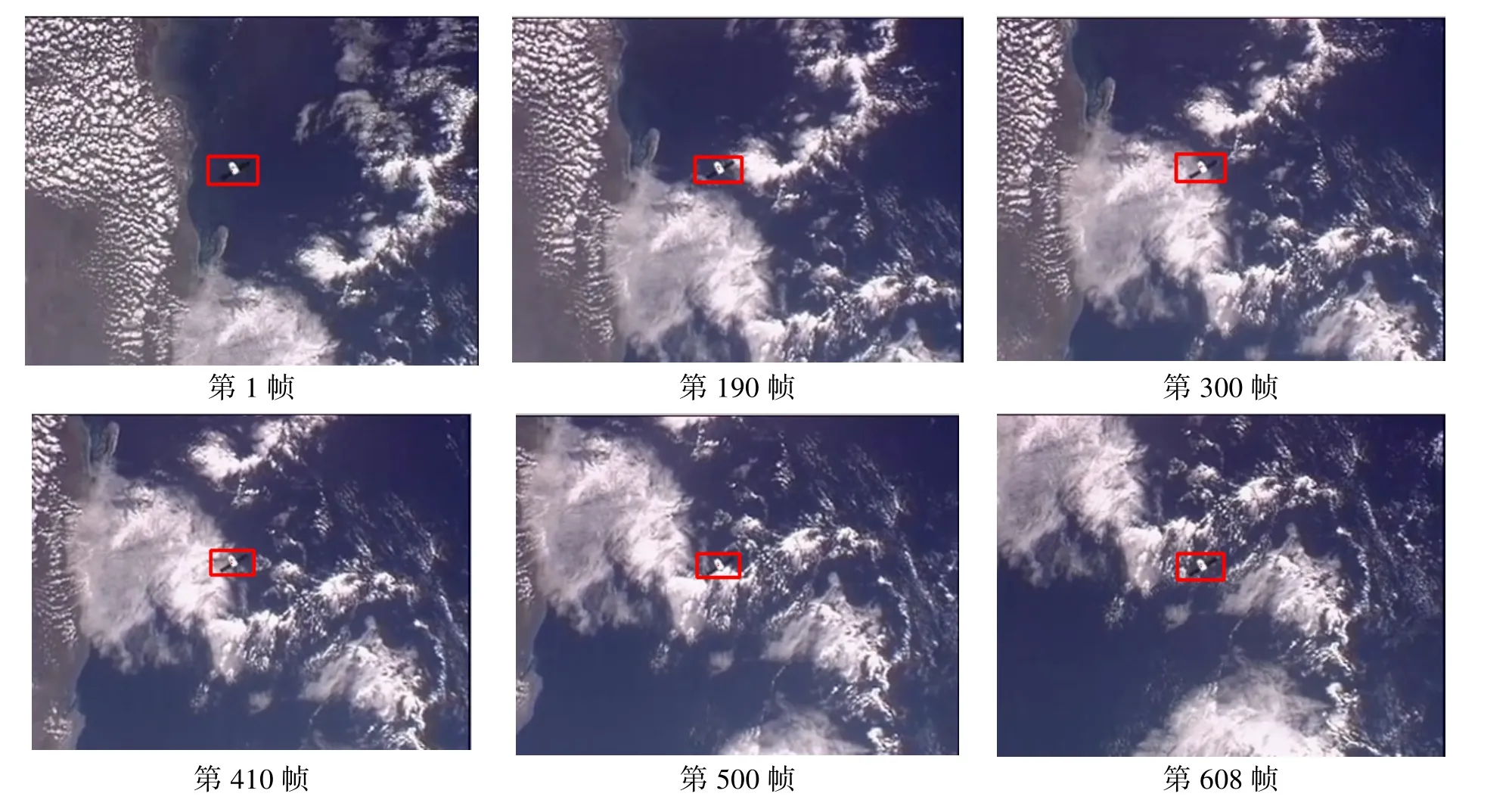

在轨环境试验中,采用NASA公布的国际空间站“加拿大II臂”执行目标(龙飞船)捕获任务视频进行测试。从相机采集的图像序列(共608帧图像)选取6幅代表性图片,目标跟踪结果如图3所示,矩形框代表在图像中定位出的目标区域。跟踪结果表明本文方法可以实现对相机视场范围内目标的准确、可靠跟踪。

图2 室内环境下目标跟踪试验结果(矩形框代表目标区域)Fig.2 Object tracking results in indoor environment(The bounding box depicts the object location)

图3 在轨环境下目标跟踪试验结果(矩形框代表目标区域)Fig.3 Object tracking results in on-orbit environment(The bounding box depicts the object location)

3 结束语

面向空间机械臂的应用需求,视觉系统担负着监视与测量两项主要任务,其中一个重要的基本功能就是在规定周期内自主、可靠地完成对空间目标的跟踪,即在相机采集的图像序列中定位目标区域。本文针对空间机械臂视觉目标跟踪问题,提出一种基于稀疏直方图的视觉目标跟踪方法。在粒子滤波目标跟踪框架下,通过组合目标区域内相互重叠的局部图像块的稀疏系数构造直方图以获取目标表示,采用基于簇比重信息的相似性度量方法计算目标模板与候选目标之间的距离并作为粒子滤波的观测模型,进而在图像序列中实现目标定位。标准测试集测试的定量分析结果以及室内环境和在轨环境试验的定性分析结果均表明:本文方法可以实现对相机视场范围内目标的准确、可靠跟踪,为空间机械臂视觉系统的设计、研制和应用提供借鉴。

References)

[1] Maclean G S, Pinkey H F L. Calibration Procedures for the Space Vision System Experiment[J]. Industrial Vision Metrology, 1991, 1526: 113-122.

[2] Blais F, Couvillon R A, Rioux M, et al. Real-time Tracking of Objects for Space Applications Using a Laser Range Scanner

[R]. Washington D.C. : NASA, 1991.

[3] James C. Utilization of the Space Vision System as an Augmented Reality System for Mission Operations[R]. Washington D.C. : NASA, 2003.

[4] Yilmaz A, Javed O, Shah M. Object Tracking: A Survey[J]. ACM Computing Surveys, 2006, 38(4): Article 13.

[5] Tai J, Tsang S, Lin C, et al. Real-time Image Tracking for Automatictraffic Monitoringand Enforcement Application[J]. Image and Vision Computing, 2004, 22(6): 485-501.

[6] Wu Y, Huang T. Robust Visual Trackingby Integrating Multiple Cues Basedon Co-inference Learning[J]. International Journal of Computer Vision, 2004, 58(1): 55-71.

[7] Nummiaroa K, Koller-Meierb E, Gool L V. An Adaptive Color-based Particle Filter[J]. Image and Vision Computing, 2003, 21(1): 99-110.

[8] Yang C, Duraiswami R, Davis L S. Efficient Mean-shift Tracking via a New Similarity Measure[C]. IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2005: 176-183.

[9] Wang H, Suter D, Schindler K. Effective Appearance Model and Similarity Measure for Particle Filtering and Visual Tracking [C]. European Conference on Computer Vision, 2006: 606-618.

[10] Babenko B, Yang M H, Belongie S. Robust Object Tracking with Online Multiple Instance Learning[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33(8): 1619-1632.

[11] Kalal Z, Mikolajczyk K, Matas J. Tracking-learning-detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(7): 1409-1422.

[12] Zhang S, Yao H, Sun X, et al. Sparse Coding Based Visual Tracking: Review and Experimental Comparison[J]. Pattern Recognition, 2013, 46(7): 1772-1788.

[13] Xie N, Ling H, Hu W, et al. Use Bin-Ratio Information for Category and Scene Classification[C]. IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2010: 2313-2319.

[14] Wu Y, Lim J, Yang M H. Online Object Tracking: a Benchmark[C]. IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2013: 2411-2418.

[15] 陈磊, 高升, 袁宝峰, 等. 基于多相机的空间机械臂视觉系统[J]. 航天返回与遥感, 2014, 35(3): 35-42.

CHEN Lei, GAO Sheng, YUAN Baofeng, et al. Multi-camera Based Space Manipulator Vision System[J]. Spacecraft Recovery & Remote Sensing, 2014, 35(3): 35-42. (in Chinese)

Space Manipulator Visual Object Tracking Method Using Sparsity-based Histogram

GAO Sheng YUAN Baofeng QI Zhe CHEN Lei WANG Kang LIANG Changchun

(Beijing Key Laboratory of Intelligent Space Robotic Systems Technology and Applications, Beijing Institute of Spacecraft System Engineering, Beijing 100094, China)

Vision system is a key part of a space manipulator system. Space object tracking or object localization in image sequences from cameras, which is implemented autonomously and reliably within a given time in complex space environment, is one of the important functions of the vision system. In this paper, we propose a sparsity-based histogram visual object tracking method for a space manipulator system. The object representation is acquired by combining the sparse coefficients of overlapped image patches in the object region, and the distance between the candidate and the template is calculated by using the bin-ratio information based similarity measure. Tracking is carried out within a particle filter framework, in which the distance is used to construct the observation model. Experiments conducted on benchmark set and image sequences captured by manipulator vision systems in indoor environment and on-orbit environment demonstrate qualitatively and quantitatively that the proposed method can perform accurate and reliable tracking of the object in the camera field of view.

object representation; sparsity-based histogram; similarity measure; space manipulator; vision system

V11

A

1009-8518(2015)03-0092-07

10.3969/j.issn.1009-8518.2015.03.013

高升,男,1973年生,2006年获中国空间技术研究院飞行器设计专业硕士学位,高级工程师。研究方向为飞行器供配电系统设计、空间视觉系统信息处理。E-mail: castgaosheng@163.com。

2015-01-15

国家自然科学基金(61231018,61305112)