基于图像法的端铣表面粗糙度研究

闵 莉,王 哲,吴玉厚

MIN Li, WANG Zhe, WU Yu-hou

(沈阳建筑大学 机械工程学院,沈阳 110168)

0 引言

在机械加工过程中工件产生刀痕、切屑分离时的塑性变形、刀具与已加工表面的摩擦及工艺系统产生的高频振动等原因使加工零件的表面产生微小的峰谷,微小峰谷形成的微观几何误差即为表面粗糙度[1]。表面粗糙度(surface roughness)是指加工表面具有的较小间距和微小峰谷的不平度,它对工件的耐磨性、配合性质、疲劳强度、导热性耐腐蚀性、使用寿命和产品外观都会产生一定的影响。随着科技的发展,工业领域中对微小尺寸的测量精度及速度等要求也越来越高,传统的接触式测量精度难以达到要求,非接触式测量迅速发展。机器视觉检测技术为新兴研究领域,通过摄像机与计算机相连接,利用机器视觉进行非接触测量检测零件表面微观特性的方法越来越受到重视[2]。图像法基本上可以归纳为统计法、结构法、模型法和空间/频率域联合分析法等四类。但存在一些方法难以广泛应用,并且对端铣加工方式的研究较少。本文提出了一种基于图像法的非接触式粗糙度检测的方法,来实现表面粗糙度的高精度、快速自动无损检测。通过图像采集系统获取端铣工件表面显微图像,运用统计分析方法对工件表面图像进行纹理分析,提取基于GLCM的8个特征参数,分析参数与表面粗糙度评定值Ra关系,采用BP神经网络,以端铣表面图像纹理特征参数为输入量,对应的表面粗糙度评定值Ra为期望输出,构建了神经网络检测模型检测表面粗糙度。试验证明了该方法的准确性,实现了端铣工件表面粗糙度检测算法分析及表面粗糙度的测量。

1 GLCM算法

1.1 GLCM定义

设图像尺寸为M×N,灰度值为G,灰度共生矩阵(Gray Level Co-occurrence Matrix,GLCM)就是从图像中灰度为i的点(x,y)处的像素出发,统计与其距离为d的点(x+a,y+b)灰度为j的像素同时出现的概率P(i,j|d,θ)[3]。GLCM数学表达式为:

式中:i,j =0,1,…,G-1;x,y为图像中像素的坐标,d表示生成步长,θ表示生成方向。

1.2 纹理特征参数选取

基于GLCM的图像纹理描述有14个纹理特征参数[4]。不相关的8个纹理特征参数定义和计算公式如下[5]:

从实验组和对照组中分别随机选取10株幼苗,用自来水冲洗幼苗,擦干表面水分,测量每株幼苗的根长、苗长,并称取根和苗的鲜重。

1.3 GLCM计算参数确定

GLCM中,图像的灰度级G、生成步长d以及生成方向θ三个参数在不同数值下的不同组合将会生成不同的GLCM,从而得到不同的统计特征参数,对图像纹理的有不同的描述能力。本文依据端铣工件的表面特征分析,选定合适的参数值。

1)G的确定

经验证当灰度级压缩32级时,不同粗糙度等级的纹理特征参数变化明显,离散性较好,且随着粗糙度等级变化,纹理特征参数的线性走向趋势基本相同,能很好的保存了图像的整体性与图像的纹理特征。故取G=32。

2)d的确定

取d=2,能较好的保护图像的细节纹理信息,准确反映图像纹理特性。

3)θ的确定

θ选取4个方向,水平、对角线、垂直、反对角线(0°、45°、90°、135°)。

2 图像纹理特征参数提取与分析

2.1 实验样品及设备

工件表面粗糙度图像采集设备采用由日本基恩士(KEYENCE)公司研发生产的VHX-1000型超景深三维显微系统。被测样本选择哈尔滨量具刃具集团生产的端铣表面粗糙度比较样块。

2.2 图像获取

机械加工过程中都会在工件表面形成区别于其它加工方法的表面纹理,工件表面显微图像差异性很大。但相同加工方式下,工件具有相近的表面纹理特征。因此,通过机器视觉检测技术检测工件表面粗糙度需要从加工方法的不同类别着手。铣削工件表面是一种周期性、方向性和均匀性较明显的纹理图像。本文对端铣工件表面图像的纹理进行研究,针对端铣加工的四个不同粗糙度等级标准比较样块,运用图像采集系统采集图像。采集的原始图像如图1所示。

图1 端铣表面原始图像

2.3 图像预处理

通过图像采集系统获得的图像为1600×1200×3数组,放大倍数100倍的RGB图像,但由于存在日常光照不均匀、噪声污染、温度、振动等不可控因素的影响,造成采集的图像失真,表现在:原本连续均匀的灰度,产生突变,或生成虚假的信息。所以需要对采集的图像经过预处理才能作为实验的图像样本数据,进而获取准确的端铣表面纹理信息以便于对表面纹理的分析处理。

图像采集系统采集到的为彩色图像。彩色图像包含信息量较大,计算过于复杂,而灰度图像能够反应本文所需的纹理特征,因此需要将彩色图像灰度化。同时采用中值滤波等算法对图像进行去噪,结果表明滤噪效果良好,并保护了图像纹理细节。预处理后的图像如图2所示。

图2 端铣表面预处理后的图像

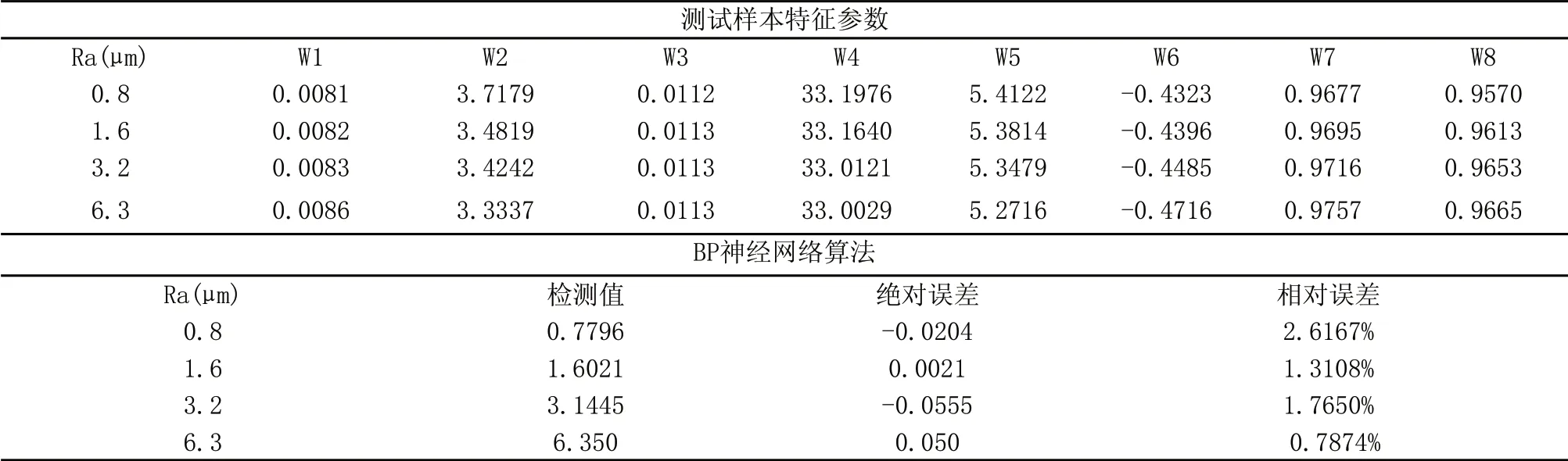

表1 灰度共生矩阵纹理特征参数样本集

2.4 实验数据提取

在G L C M 中,不同的角度会产生较大差异的GLCM,因此不当的生成方向将无法如实反映工件表面纹理特征。为保证纹理信息的完整性,θ选取0°,45°,90°,135°。本文对端铣表面粗糙度样块进行多次的图像采集,提取基于4个方向上GLCM的8个纹理特征参数,并选择特征参数平均值作为最终实验数据。W1~W8依次为角二阶矩、对比度、相关性、和平均、熵、相关信息测度Ⅰ、相关信息测度Ⅱ和最大相关系数。表1为数据库中前6组的端铣显微图像纹理特征参数集。

通过实验组数据,画出端铣加工表面粗糙度比较样块的GLCM的8个特征参数随粗糙度Ra的变化曲线关系图如下。以下列举了角二阶矩、对比度、相关性和熵四个特征参数的曲线图,如图3所示。

图3 纹理特征参数随Ra变化曲线图

由以上实验数据,分析其特征参数随粗糙度的变化规律可以看出,工件表面纹理特征与表面轮廓算术平均偏差(Ra)之间存在确定的变化规律。对比度、和平均、熵、相关信息测度Ⅰ随Ra的增大而成递减趋势。角二阶矩、相关信息测度Ⅱ和最大相关系数随Ra增大而成递增趋势。随粗糙度等级增大,角二阶距增大表示纹理越来越粗,对比度和熵的逐渐减小则表示纹理越复杂且逐渐不清晰。

3 端铣表面粗糙度检测模型

3.1 BP神经网络

BP神经网络,它是一种以误差反向传播为基础的前向网络[6],具有很强的非线性映射能力。其结构包括三部分:输入层、隐含层和输出层。本文选择BP神经网络来完成端铣工件表面粗糙度检测模型的建立。

3.2 BP神经网络设计

根据本文粗糙度建模的实际情况需求,结合上节提取的图像的GLCM的8个特征参数,选择输入层节点数为8,输入量分别为角二阶矩、对比度、相关性、和平均、熵、相关信息测度Ⅰ、相关信息测度Ⅱ和最大相关系数。输出层节点数为1,即表面轮廓算术平均偏差Ra。根据经验公式以及试验法选择最佳隐含层节点数为18。故建立模型结构为8-18-1的BP神经网络模型。

表2 神经网络结构参数

图4 端铣表面粗糙度的BP神经网络检测模型

3.3 BP神经网络检测模型

本文将上述建立的端铣样块表面显微图像纹理特征参数与工件表面粗糙度评定参数Ra的数据库作为BP神经网络的训练样本。数据库的部分训练样本数据如表1所示,显微图像纹理特征参数作为神经网络的训练样本输入数据,同时,以端铣样块表面粗糙度评定值(Ra)作为神经网络算法样本输出目标数据。从而,运用BP神经网络算法建立了显微图像的统计特征参数和对应的表面粗糙度值(Ra)二者间的映射关系模型。将剩余的端铣标准样块作为网络模型的测试样本,其图像纹理特征参数作为输入数据,以此来测试通过BP神经网络算法构建的纹理特征参数与表面粗糙度映射关系模型的可靠性,验证是否可以将其作为检测端铣工件表面粗糙度值的映射关系模型。表3为BP神经网络模型测试结果与误差分析。图4为表面粗糙度评定参数Ra实际值与通过BP神经网络模型获得的Ra检测值的对比线图。

表3 工件表面粗糙度实际值及BP神经网络检测结果对比分析

图5 工件表面粗糙度实际值与检测结果对比图

运用建立的BP神经网络模型对工件端铣表面粗糙度进行检测,与实测值的比较结果如图5所示,检测结果与实测值的绝对误差值不超过0.06,且相对误差值小于3%,表明以上建立的BP神经网络模型对端铣工件表面粗糙度具有较好的检测能力。

4 结论

1)本文以端铣加工为研究对象,基于图像法对工件表面粗糙度进行检测,提出了一种基于机器视觉的非接触式工件表面粗糙度检测方法。

2)通过采集图像求得实验数据,得出基于GLCM的8个纹理特征参数与工件表面粗糙度有较好的映射关系,为粗糙度检测提供了较优的检测参量。

3)建立BP神经网络模型时,用8个纹理特征参数,即角二阶矩、对比度、相关性、和平均、熵、相关信息测度Ⅰ、相关信息测度Ⅱ和最大相关系数为输入量,对应的表面粗糙度评定值Ra为期望输出,构建了神经网络检测模型。实现了端铣工件表面粗糙度的检测,且检测值与实测值误差较小,对快速非接触评定端铣工件表面粗糙度的研究具有借鉴意义。

[1] 陈自新.机器视觉在机械加工表面粗糙度检测中的应用研究[D].东南大学,2010.

[2] 贺秋伟.基于计算机视觉的微小尺寸精密检测理论与技术研究[D].吉林大学,2007.

[3] 薄华,马缚龙,焦李成.图像纹理的灰度共生矩阵计算问题的分析[J].电子学报,2006,34(01):155-158.

[4] HARALICK R M, SHANMUGAM K. Texture Features for Image Classification[J].IEEE Transactions on Systems, Man, and Cybernetics,1973,3(06):6102-6211.

[5] 陈美龙,戴声奎.基于GLCM算法的图像纹理特征分析[J].通信技术,2012,2(45):108-111.

[6] Palanikumar K. Application of Taguchi and response surface methodologies for surface roughness in machining glass fiber reinforced plastics by PCD tooling[J]. The International Journal of Advanced Manufacturing Technology,2008,36(1-2):19-27.