基于轮廓片段匹配和图搜索的红外目标识别方法

苏娟,杨罗,张阳阳

(1.第二炮兵工程大学907 教研室,陕西 西安710025;2.96427 部队 气象室,陕西 宝鸡721006)

0 引言

红外成像制导因其具有灵敏度高、隐蔽性好、全天时工作等优良特性,成为目前精确制导技术的发展主流和研究热点。模板匹配是红外末制导寻的阶段常用的自动目标识别方法,通过对基准图和实时图进行匹配实现目标的识别定位[1]。基准图是根据目标高程、下视可见光图像、成像视角和距离、目标红外特性等信息制作而成的,与红外导引头获取的实时图存在较大的灰度差异、视角差异和尺度差异,传统的外观特征(如灰度和纹理等)不能发挥明显的优势,而在异源图像匹配中得到了广泛应用的轮廓特征[2-5],由于具有较好的鉴别性和鲁棒性,在基准图与实时图的匹配中作用明显。通过提取基准图与实时图中的轮廓特征,在实时图中寻找基准图轮廓对应的最佳匹配区,可以实现目标的匹配识别。然而,在红外成像制导中,当目标处在复杂背景中时,背景区域的边缘线条通常会给轮廓匹配带来较大干扰,并且,目标遮挡、红外干扰和成像质量等因素可能导致目标的重要轮廓难以被完整地检测出来,出现轮廓片段缺失现象。上述复杂背景干扰和目标轮廓片段缺失的情况使得基准图与实时图的轮廓差异扩大,相应增加了轮廓匹配的难度。

在形状轮廓匹配方面,文献[6]根据基准图的尺度和形状信息对实时图进行目标重构处理,提取边缘线条进行匹配,融合轮廓匹配和区域对比度进行目标的识别,该方法需要根据弹目距离制备尺度精确的基准图,要求基准图与实时图的尺度差异较小。文献[7]提出一种不等分坐标空间,提取目标区域的模糊形状特征,采用形状上下文和全局特征加权度量,实现了形状特征差异较大时的红外与可见光图像匹配。文献[8]将模板的轮廓片段分组成片段组合,采用投票的方法衡量模板片段组合与图像中边缘片段集合的相似性,产生候选的边缘片段组合,最后通过边缘片段组合与轮廓模板之间的全局相似性来寻找目标位置,该方法要求轮廓模板包含足够多种类型的形变。文献[9]利用轮廓片段的分布情况形成描述子,从而实现目标检测,该方法需要通过边缘连接使得轮廓的各部分构成一个网络。文献[10]根据训练集得到具有多尺度特性的目标形状片段模型,然后通过计算形状片段间的相似性选取出候选片段,并结合具有全局约束的Hough 变换实现目标检测,该方法计算复杂,受噪声的影响较大。

针对红外成像制导特定的应用背景,本文提出一种基于轮廓片段匹配和图搜索的目标识别方法,利用轮廓分段进行形状匹配。在对基准图和实时图进行轮廓提取与分段的基础上,利用片段的位置和朝向信息计算得到片段匹配矩阵,然后构建匹配图并采用图搜索方法寻找与基准图轮廓最相似的片段组合,最后采用距离变换计算全局相似性测度,确定目标的匹配位置。

1 算法

本文算法流程如图1所示,主要包括4 部分内容:轮廓分段与描述、计算片段匹配矩阵、匹配图构建与图搜索、全局相似性度量。

1.1 轮廓分段与描述

首先对基准图和实时图分别进行轮廓特征提取与分段处理。边缘是基于轮廓的形状描述中所使用的基本特征,前视红外(FLIR)目标识别中所处理的目标大部分为具有稳定结构形式的人造目标,因此本文首先提取图像的结构特征边缘作为轮廓特征,然后提取边缘中的角点,并据此对边缘进行分段处理。具体步骤如下:

1)提取图像的Canny 边缘,并采用基于局部处理的边缘点连接方法提取边缘线段;

2)通过计算边缘线段上每个点的曲率,提取出具有稳定曲率的边缘线段,如直线、弧线、圆等;

3)基于曲率尺度空间提取角点,如果有角点位于边缘线段中,则将该线段在角点处断开;

4)对得到的每条边缘片段进行标记,记录片段上的像素坐标,用于后续处理。

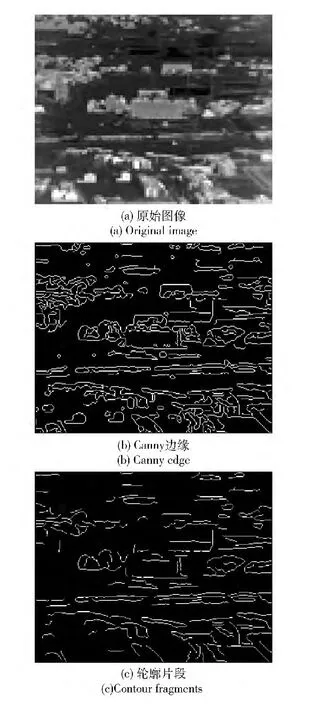

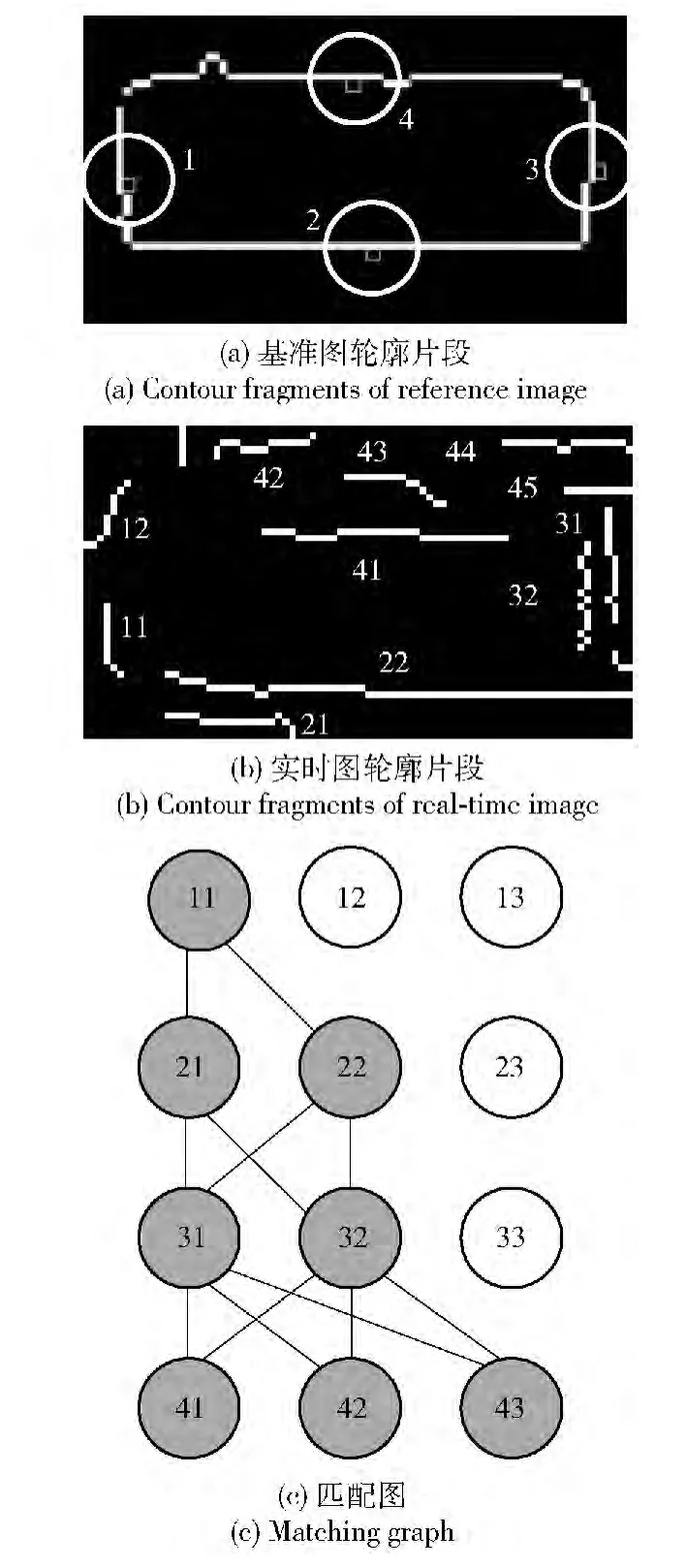

如图2所示给出了一个边缘轮廓片段提取实例。可见,在提取得到的边缘轮廓片段图中,大部分细小杂乱的边缘被滤除,能够基本反映目标的轮廓信息和几何结构。

图2 轮廓片段提取Fig.2 Contour fragment extraction

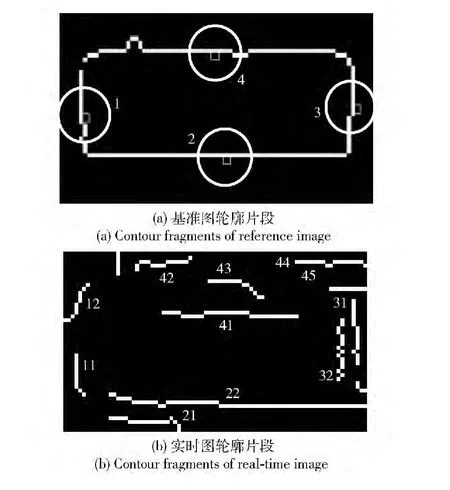

成像质量、遮挡或背景干扰等因素通常会使红外实时图中目标轮廓受到影响,出现某条片段整体缺失或部分缺失的现象。与片段的长度特征相比,片段的方位和朝向特征能更鲁棒地描述片段的属性,因此本文利用片段的方位和朝向进行片段匹配。片段的方位特征提取方法为:首先计算片段的斜率,将其与阈值1(代表斜率为45°的片段)进行比较,斜率大于1 的片段被认为是垂直朝向,反之被认为是水平朝向。在FLIR 目标识别中,以典型建筑物为代表的矩形目标均适用于这种片段区分方法,以图3(a)为例进行介绍。按照以上规则,基准图轮廓中有两条水平朝向和两条垂直朝向的片段,然后根据每条片段的质心相对于图像中心的方位,可给基准图轮廓的片段分别赋以label 进行方位标记,其中label=1(left),2(down),3(right),4(up),分别代表左、下、右、上等粗略方位。图3(b)中12 表示左边第2 条片段,22 表示下边第2 条片段,以此类推。片段的朝向特征用片段的角度表示,设某条片段的斜率为k,则其朝向特征为角度θ=arctan|k|.

1.2 计算片段匹配矩阵

图3 片段描述示意图Fig.3 Illustration of fragment description

经过轮廓提取与分段处理后,采用遍历的方法对基准图和实时图进行模板匹配。在某个匹配位置,基准图和实时图的相应区域分别有m 条和n 条轮廓片段,每条片段均有方位和朝向两个特征。基准图轮廓片段bi(i=1,2,…,m)和实时图轮廓片段rj(j=1,2,…,n)的方位特征分别为labelbi和labelrj,其匹配通过逻辑运算实现。朝向特征分别为θbi和θrj,其匹配通过计算朝向特征的余弦值实现,即以朝向特征匹配值pi=cos(θbi-θrj)作为片段间的相似性测度。根据以下准则计算片段匹配矩阵:

1)实时图片段与基准图片段的方位特征label必须相等;

2)实时图片段与基准图片段的质心间距离dij应满足dij≤r;

3)朝向特征匹配值应满足pi>thresh,即两片段的夹角小于arccos(thresh).

矩阵元素pji表示第i 条基准图片段bi与第j 条实时图片段rj的相似性测度。通过方位和朝向匹配后,如果基准图有两条或两条以上的片段存在对应的实时图匹配片段,则该次匹配有效,可进行后续操作。

表1 片段匹配矩阵Tab.1 Fragment matching matrix

1.3 匹配图构建与图搜索

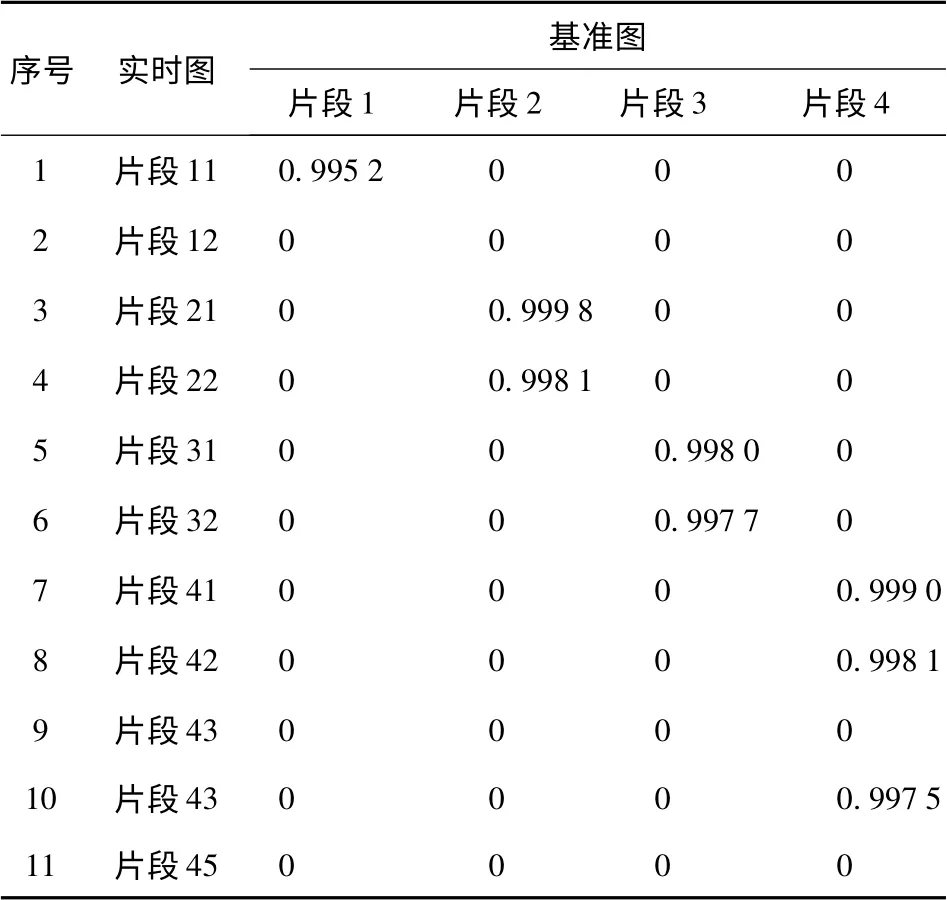

对片段匹配矩阵按由大到小排序,选取每条基准图片段对应的前3 条实时图匹配片段作为节点构建匹配图,该图中每层节点对应1 条基准图轮廓片段,如图4所示。图4(c)中节点n41、n42、n43与基准图片段4 相对应,分别代表候选的实时图片段41、片段42 和片段44. 匹配图中灰色节点为有效节点,从第1 层节点出发到第4 层节点,存在多条路径,每条路径代表了一种可能的轮廓片段组合。

在此基础上,本文根据基准图轮廓相邻片段的空间位置关系定义匹配图相邻层节点间的匹配代价,如图5所示。图5(a)中,连接片段1 和片段2的质心构成向量l12,匹配图中对应的节点为第1 层n1i和第2 层n2i;图5(b)中,对应于基准图片段1 的候选片段为片段11,对应于基准图片段2 的候选片段为片段21 和片段22. 因此,可连接片段11 和片段21 的质心构成向量l112,连接片段11 和片段22 的质心构成向量l212,用两向量的夹角<l12,l1i2>来衡量l12与的相似性,作为节点n11和n2i的匹配代价。越小,说明向量l12与相似性越大,基准图中轮廓片段1 和片段2 的空间关系在对应的实时图中保持得越好。本例中夹角<l12,l212>最小,即节点n11和n22间的匹配代价最小。因此,利用相邻片段之间的空间关系计算节点之间的匹配代价,充分利用基准图轮廓片段的空间信息,遍历搜索匹配图即可得到具有最小匹配代价的路径;图5(c)中,粗实线路径即为搜索得到的最小匹配代价路径,实时图中对应的片段组合(11-22-32-41)即为候选目标。

图4 匹配图构建Fig.4 Matching graph construction

1.4 全局相似性度量

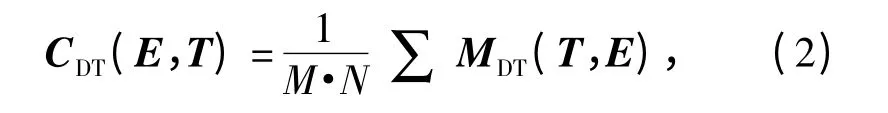

为提高匹配的准确率,本文在获取候选片段组合的基础上,利用目标轮廓的全局特征信息,对候选目标进行进一步确认。由于所处理的轮廓均为二值图像,本文采用距离变换匹配值作为全局相似性度量。距离变换是对二值边缘图像进行的一种运算,变换矩阵中各点的值表示该点到距它最近的一个边缘点的欧氏距离,其计算公式为

式中:E={e}为轮廓片段组合图像上所有边缘点的集合;d 为欧氏距离。

图5 匹配图搜索Fig.5 Matching graph Searching

如图6所示给出了一个轮廓片段组合图像的距离变换结果,其中边缘图像上的白色线条表示边缘点,在距离变换图像中,边缘点的灰度值为0,越暗的点表明和边缘点的距离越近。

因此,基于距离变换的全局相似性度量为

图6 轮廓片段组合的距离变换Fig.6 Distance transform of fragment combination

式中:T 为对应的基准图轮廓片段组合中所有边缘点的集合;M·N 为基准图的尺寸。该测度相当于将基准图轮廓片段组合作为二维滤波器对实时图轮廓片段组合的距离变换矩阵进行滤波,并按照基准图的尺寸求平均值。对于每个候选的轮廓片段组合,利用(2)式计算全局相似性度量,测度值最小的片段组合即为最终确定的目标区域。

2 仿真实验与分析

为了考察本文算法对目标轮廓片段缺失、复杂背景干扰和尺度变化明显等红外成像制导中常见影响因素的适应性,本文采用了两组有代表性的图像序列进行了仿真实验。

2.1 轮廓片段缺失

轮廓片段缺失的一个主要原因是目标被局部遮挡,这在实际应用中是经常出现的。对红外序列中的目标进行遮挡处理,采用梯度矢量法[11]、结构张量法[12]和本文算法分别进行匹配实验,考察算法对目标部分遮挡的适应性,其匹配结果如图7所示。

图7 轮廓片段缺失时的建筑物匹配实验Fig.7 Matching experiment in case of contour fragment missing

由图7可见,当目标被局部遮挡时,目标轮廓片段部分缺失,本文算法仍能实现正确匹配,而另两种方法匹配错误,说明本文算法对目标局部遮挡具有一定的适应性。梯度矢量算法和结构张量算法是在特征提取的基础上进行的模板匹配,局部遮挡使得目标区域特征发生较大变化,从而导致匹配失败。本文算法是针对轮廓片段缺失而设计的,当目标被部分遮挡时,只要能检测出目标的部分轮廓片段,通过片段匹配与组合即可克服遮挡的影响。

2.2 复杂背景干扰

本组实验序列中,目标所处的背景区域存在大量的干扰边缘,并且基准图与实时图中的目标存在视角差异。采用梯度矢量法[11]、结构张量法[12]和本文算法分别进行匹配实验,考察算法在复杂背景干扰情况下的匹配性能,其匹配结果如图8所示。

图8 复杂背景干扰下的建筑物匹配实验Fig.8 Matching experiment in case of complicated background interference

由图8可见,当目标所处背景干扰较大,且基准图与实时图存在视角差异时,本文算法均能实现正确匹配。这是因为该算法根据片段的方位和朝向进行匹配,设定的阈值能容许一定的角度差异,利用了片段之间的空间关系进行片段组合,局部特征与全局特征的组合提高了特征鉴别能力,因此能克服复杂背景干扰与视角差异的影响。

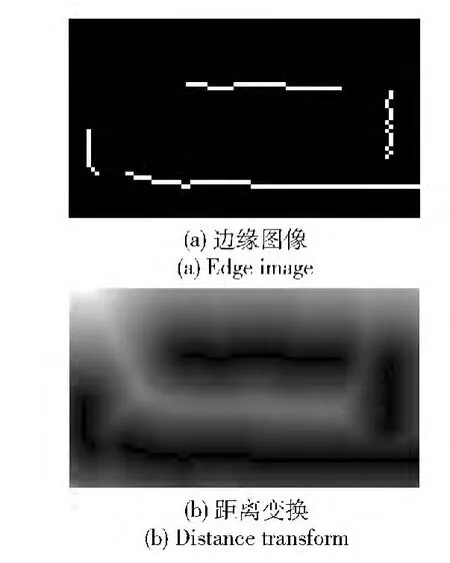

2.3 尺度变化明显

为了考察本文算法对目标尺度变化的鲁棒性和对序列图像的适应性,采用两组分别包含150 帧和300 帧的图像序列进行匹配实验。待匹配目标分别为不同场景下的建筑物目标(如图7和图8所示),随着摄像头与目标距离之间的变化,图像序列由远及近,目标尺度变化明显,匹配实验时均只使用一张基准图。将本文算法与模板匹配的两种常用算法:基于边缘强度的归一化积相关算法(Nprod)和基于Hausdorff 距离的轮廓整体匹配算法进行比较,匹配结果如表2所示。

表2 建筑物序列匹配率Tab.2 Matching ratios for two building sequences

由表2可见,本文算法在这两组形状特征较为明显的图像序列上,均能取得较好匹配性能。对两组序列均利用一张基准图即可实现较好匹配,证明了本文算法对目标尺度变化的鲁棒性。由于基准图缺乏侧面纹理信息,造成基准图和实时图差异较大,因此基于边缘强度的Nprod 算法的匹配性会受到一定影响;而在实时边缘图中,边缘信息较为丰富和复杂,目标区域存在大量边缘片段,造成基准图轮廓与实时图轮廓间存在较大差异,使得基于Hausdorff 距离的轮廓整体匹配算法的适应性不好。本文算法采用轮廓分段匹配的策略,能有效克服轮廓不完整的情况,不要求实时边缘图中具有封闭、完整的轮廓,在片段匹配的基础上采用图搜索方法进行片段组合,对复杂区域具有较好适应性。

从运行速度上来看,在Intel Pentium 2.6 GHz 处理器和2 GB 内存的硬件配置下,采用VC+ +6.0 编程环境,本文算法平均运行时间约2 帧/s,略高于梯度矢量算法(1.2 帧/s)和结构张量算法(1.45 帧/s)。如果采用硬件加速,处理速度还可进一步提高。

3 结论

针对FLIR 目标识别中复杂背景干扰和目标轮廓片段缺失的问题,本文提出了一种基于轮廓片段匹配和图搜索的目标识别方法。该方法对轮廓采用先拆分后组合的思路,充分利用了轮廓片段的局部特征与全局特征。首先将轮廓分段描述与匹配,并构建匹配图,然后根据基准图轮廓片段间的空间关系进行约束,采用图搜索方法进行片段组合,最后采用基于距离变换的全局相似性度量,实现目标的匹配定位。仿真实验结果表明,该方法能够鲁棒准确地识别出复杂背景中的目标,对复杂背景干扰和轮廓片段缺失具有较好适应性,对具有典型形状特征的目标识别具有一定的应用前景。

References)

[1]张义广,丁明跃,周成平. 弹道导弹红外成像制导的关键技术[J]. 制导与引信,2004,25(4):11 -14.ZHANG Yi-guang,DING Ming-yue,ZHOU Cheng-ping. Key technology on ballistic missile infrared imaging guidance[J]. Guidance & Fuze,2004,25(4):11 -14. (in Chinese)

[2]Shotton J,Blake A,Cipoll R. Contour-based learning for object detection[C]∥Tenth IEEE International Conference on Computer Vision. Beijing:IEEE,2005:503 -510.

[3]Tan C Q,Chen Y F,Li F X,et al. A new method for content-based image retrieval via subsets of key contours fragments[J]. Advanced Materials Research,2012,532/533:792 -796.

[4]Yang X W,Liu H R,Latecki L J. Contour-based object detection as dominant set computation [J]. Pattern Recognition,2012,45(5):1927 -1936.

[5]杨效余,张天序. 一种基于复杂地物背景图像的目标识别方法[J]. 系统工程与电子技术,2011,33(1):13 -16.YANG Xiao-yu,ZHANG Tian-xu. Method of target recognition from images based on complex natural scenes[J]. Systems Engineering and Electronics,2011,33(1):13 -16. (in Chinese)

[6]李志军,王卫华,牛照东,等. 基于模板的低信噪比前视红外建筑物识别技术[J]. 信号处理,2012,28(9):1235 -1240.LI Zhi-jun,WANG Wei-hua,NIU Zhao-dong,et al. Method of target recognition from low SNR building FLIR images based on template[J]. Signal Processing,2012,28(9):1235 - 1240. (in Chinese)

[7]曹治国,鄢睿丞,宋拮. 利用模糊形状上下文关系的红外与可见光图像匹配方法[J]. 红外与激光工程,2008,37(6):1095 -1100.CAO Zhi-guo,YAN Rui-cheng,SONG Jie. Approach on fuzzy shape context matching between infrared images and visible images[J]. Infrared and Laser Engineering,2008,37(6):1095 -1100.(in Chinese)

[8]Lu C E,Adluru N,Ling H B,et al. Contour based object detection using part bundles[J]. Computer Vision and Image Understanding,2010,114(7):827 -834.

[9]Ferrari V,Tuytelaars T,Van Gool L. Object detection by contour segment networks[C]∥9th European Conference on Computer Vision. Graz,Austria:Springer Berlin Heidelberg,2006:14 -28.

[10]陈国栋,孙立宁,杜志江,等. 一种利用形状片段的物体检测方法[J]. 自动化学报,2011,37(4):427 -439.CHEN Guo-dong,SUN Li-ning,DU Zhi-jiang,et al. Object detection based on shape fragments[J]. Acta Automatica Sinica,2011,37(4):427 -439.(in Chinese)

[11]明德烈,田金文. 红外前视对一类特殊建筑目标识别技术研究[J]. 宇航学报,2010,31(4):1190 -1194.MING De-lie,TIAN Jin-wen. Automatic infrared condensing tower target recognition using gradient vector features[J]. Journal of Astronautics,2010,31(4):1190 -1194. (in Chinese)

[12]杨兵,于秋则,刘永才,等. 基于新的加权互相关的图像匹配[J]. 弹箭与制导学报,2008,28(4):199 -202.YANG Bing,YU Qiu-ze,LIU Yong-cai,et al. Image matching based on new weighted normalized cross correlation[J]. Journal of Projectiles,Rockets,Missiles and Guidance,2008,28(4):199 -202. (in Chinese)