基于在线目标跟踪算法的研究*

刘 伟,黄勇坚,骆 华,周子力

曲阜师范大学物理工程学院,山东曲阜273165

基于在线目标跟踪算法的研究*

刘 伟,黄勇坚,骆 华,周子力

曲阜师范大学物理工程学院,山东曲阜273165

在线目标跟踪是一个具有挑战性的问题。当运动目标表面发生变化、背景光线剧烈变化、背景物体的遮挡以及运动造成的模糊时,需要建立一个有效的物体外在表示模型。为此,本文利用典型的主成分分析(PCA)与稀疏表示建立了有效的观测模型。将ℓ1最小值引入到PCA重建中,将目标物体表示为主要特征和噪声之和的形式。除此之外,当发生遮挡和运动模糊时,为了减少跟踪漂移现象,该文提出了一种新的更新模型而不是简单的对观测模型直接更新。实验证明,该算法在目标物体发生遮挡以及背景光线发生剧烈变化时,对目标跟踪具有较强的鲁棒性。在评价指标重叠率和中心误差方面,算法跟踪精确度明显提高。

运动目标 观测模型ℓ1最小值 主成分分析 稀疏表示

0 引 言

目标运动跟踪是计算机视觉研究的一个重要课题,它在机器人视觉导航、医疗诊断、交通检测等领域有着重要的应用价值。典型的目标跟踪算法主要包括3部分:观测模型、动态模型、搜寻方法。跟踪算法的关键技术是建立有效的观测模型。文献[1-2]采用基于灰度特征的表示方法,通过计算模板与图像中对应位置像素灰度值的差别来判定它们的相似程度,将目标物体在灰度级的图像上进行匹配和全图搜索。文献[3]采用的是基于颜色的特征表示方法。以上两种算法都是基于区域的表示方法,此类算法用的是目标的全局信息,比如灰度、色彩、纹理等。因此当目标未被遮挡时,跟踪精度非常高、跟踪非常稳定,对于跟踪小目标效果较好。但是在灰度级的图像上进行匹配和全图搜索,计算量较大,非常费时间,所以在实际应用中实用性不强;其次,当发生遮挡时,该类算法缺少对匹配模板的更新。文献[4]提出子空间表示模型,在对目标表面建模时意在寻找使重建误差最小的模板。此算法在可用数据有限时可以获得较高的泛化能力。为了解决目标物体形变所引起的目标跟丢问题,文献[5-7]将在线子空间学习方法应用到目标跟踪中。文献[8]在此基础上提出对低维空间进行在线更新的思想,一些实验表明此模型对物体表面发生变化时具有较好的跟踪效果,但是此算法不具备一个有效的更新机制,因为它仅仅使用新观测学习到的基向量,没有对遮挡部分进行检测并处理这些样本。另外,当目标物体被部分遮挡时,模型中的误差向量不再服从高斯分布,此时会出现跟踪漂移现象。而文献[9]在文献[7]的基础上提出一个潜在的假设,即误差项表示任意稀疏的噪声,此方法可以处理部分遮挡问题,但是计算复杂度限制了其应用。这些跟踪算法各有独到之处,但面对要求不断提高的图像跟踪应用需求,仍有以下几个方面需要提升和改进:①观测模型的建立应适应外观变化,如目标旋转,遮挡;②对跟踪过程中目标物体遮挡部分建立有效的检测机制;③对观测模板的更新方法需要改进。

基于以上分析,提出了基于稀疏表示的在线目标跟踪算法。与文献[1-3]相比,该算法特征提取采用主成分分析法[10-11](PCA),通过降维用少数几个综合变量来代替原始多个变量,这些综合变量集中了原始变量的大部分信息,增加了跟踪的精确度。与文献[8-9]相比,提出将当前帧图像表示为主要特征和次要特征之和的形式,其中次要模板表示任意稀疏噪声。为了避免跟踪中出现的漂移现象,对目标物遮挡部分进行检测,并提出一种新的模型更新方法,而不是简单地对观测模型直接进行更新。

1 算法介绍

该算法利用子空间学习和稀疏表示对目标物体建立观测模型。在跟踪过程中,将目标物体表示为PCA的基向量和次要模板之和的形式。动态模型采用仿射变换[12]实现对运动物体的状态预测。

1.1 动态模型

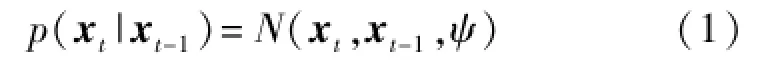

目标跟踪算法中的动态模型主要完成对运动物体状态的预测,其中,预测的基础是前一帧或几帧图像。通过仿射变换中的参数,对当前状态进行预测。设当前状态量为xt。令xt={xt,yt,θt,st,αt,φt},其中xt,yt,θt,st,αt,φt分别表示:第t帧时,x、y方向上的平移,旋转角度,尺度变化,长宽比,倾斜角度。状态转移模型服从高斯分布,如公式(1)所示。

式中,ψ是仿射变换后参数的方差。

图1 跟踪框位置的确定Fig.1 Determination of tracing-box position

1.2 观测模型

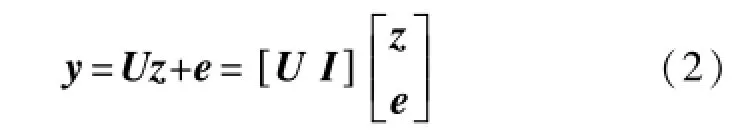

利用了子空间学习模型和稀疏表示模型的优势,建立目标跟踪模型。此模型可以认为是ℓ1的规则化与主成分分析(PCA)的结合。在跟踪过程中,用PCA基向量建立目标特征,同时用次要模板来解决遮挡问题。对每帧图像的观测向量可以表示为:

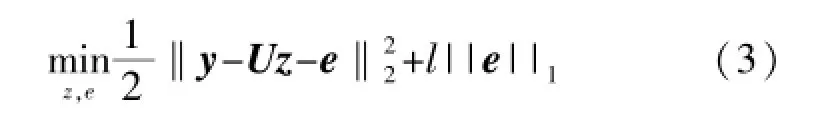

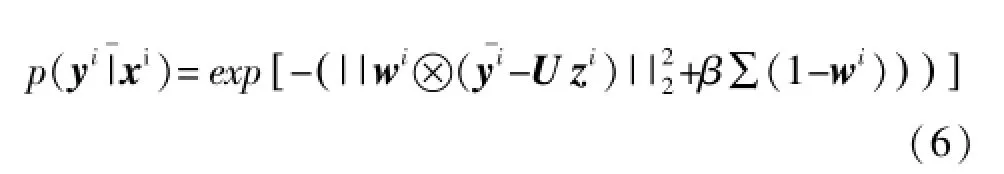

式中,y表示观测向量,U由基向量构成的矩阵,z表示基向量的系数,e表示误差项,也可以认为是次要模板。本模型包括两部分:PCA基向量和次要模板。因此,式(2)可以转换为一个优化问题,即求下式的最值问题。

式(3)中,模板的系数是稀疏的,系数向量正交,l是噪声项系数。

当没有遮挡情况发生时,观测图像yt可以认为是由目标物体的子空间产生。当目标物体被遮挡时,中心观测图像可以表示为由PCA基向量的线性组合和误差项et之和=U zt+et,zt由基向量构成,矩阵zt是稠密的,et表示噪声或是遮挡部分。当没有发生遮挡时,图像块由PCA基向量表示,并且次要模板系数趋向于0。

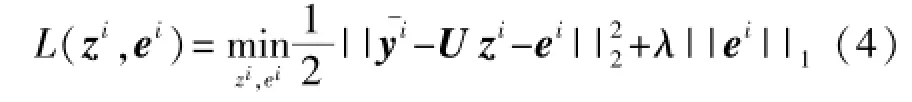

对于每个观察对象相应的预测状态,转化为求解下列函数:

式中,i表示样本状态量x的第i个样本,通过上式求解最值可获得zi、ei。对每个候选图像的观测似然函数可以用最小重建误差来衡量:

加十三香炒制1~2 min即可,锅内温度控制在100~110 ℃。炒制过程中要不断进行翻炒,防止焦锅。

式(5)中没有考虑到遮挡情况。当发生遮挡时,候选图像的观测似然函数可分为非遮挡因子和遮挡因子两部分,用公式(6)表示。

此模型有两个优点:第一,与文献[7]提到的IVT跟踪模型相比,能够有效地解决部分遮挡问题。第二,与文献[8]提到的ℓ1模型相比,此模型通过子空间表示,以较低的计算复杂度处理高分辨率的图像。式(3)算法的实现步骤如下:

输入:观察向量y,正交向量U,常数λ

1:初始化e0=0,i=0

2:迭代

3:计算zi+1,zi+1=UT(y-ei)

4:计算ei+1,ei+1=sλ(y-U zi+1)

6:直到收敛

输出:zop,eop

1.3 模型的更新

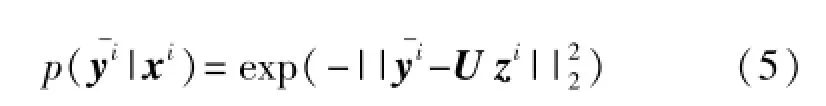

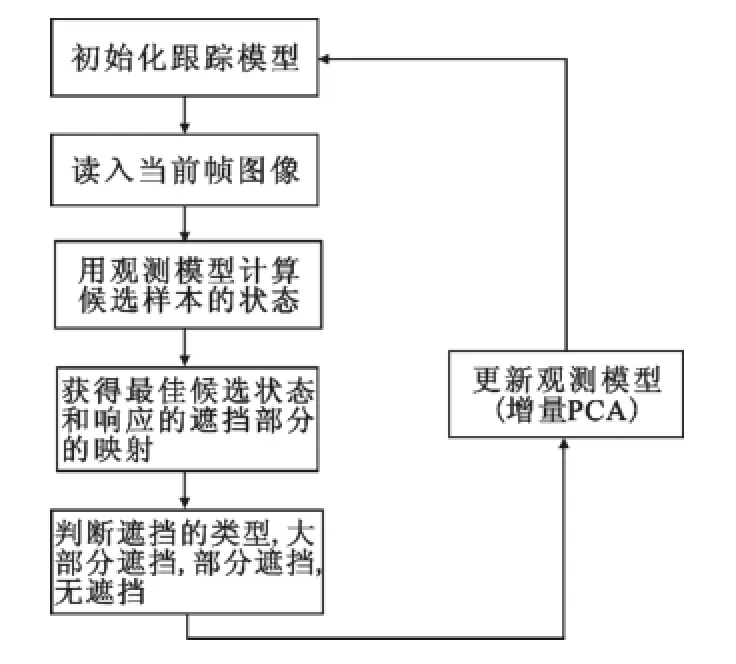

目标跟踪过程中,目标物体表面发生变化时,需要更新观察模型。如果不重要的样本得到更新后,那么会使得跟踪模型的效果减弱,从而产生漂移现象。为此,在处理目标物体发生遮挡时,根据遮挡程度的不同采取不同的处理方式。处理过程为:首先,由于噪声或遮挡是由次要模板来表示,所以用次要模板的系数来检测遮挡,次要模板系数向量对应一个2维映射,当此映射中的元素为非零时,表明有遮挡发生。其次是计算遮挡比例,即遮挡像素和总像素个数的比值,用η表示;其次设定两个阈值tr1=0.1和tr2=0.6。当η<tr1时,直接用这个样本更新模型;当tr1<η<tr2时,表明目标被部分遮挡,用遮挡部分的均值μ代替遮挡部分的像素,然后用替代的样本更新模型;当η>tr2时,这表明目标被大部分遮挡,此时丢弃样本,不对模型进行更新。该算法的算法流程图如图2所示。

图2 算法流程Fig.2 Algorithm flow chart

2 实验结果及分析

为了验证算法的正确性和有效性,在AMD 2. 0GHZ、内存2.0 GB的微机上,利用Matlab编程实现。图像序列中,目标物体在第一幅图像中的位置是通过手动标定。图像序列中的每张图像通过主成分分析(PCA)后,提取的特征图像,观测图像被归一化为32×32像素。重点对算法的鲁棒性进行检验,包括目标旋转,光照的变化,以及遮挡情况。除此之外,将算法与IVT算法[8]、ℓ1算法[9]、Frag Track算法[13]进行了对比说明。

2.1 遮挡实验

在Occlusion1、Occlusion2以及Caviar1序列图像实验中,图像序列包括目标物体被遮挡和动作旋转,实验结果如下图所示。

图3 目标物体动作变化和被遮挡Fig.3 Objects undergo occlusion and pose change

其中,a是Occlusion1序列,b是Occlusion2序列,c是Caviar1序列。实验结果显示,在有遮挡物体的环境下,本文算法能够实现有效地跟踪目标物体。

2.2 光线变化实验

在Singer1图像序列中包括:光线的急剧变化,目标物体的尺度变化和动作变化。尤其实歌手从黑暗的地方移动到光线较亮的地方。除此之外,物体表面的尺度和行为的变化也有可能是因为摄像机的移动或抖动所引起的。

图4 光线变化引起物体表面变化Fig.4 Objects appearance change due to variation of lighting

由实验结果可以看到,在光线的急剧变化的环境下,本文算法能够实现有效地跟踪目标物体。

2.3 算法评估

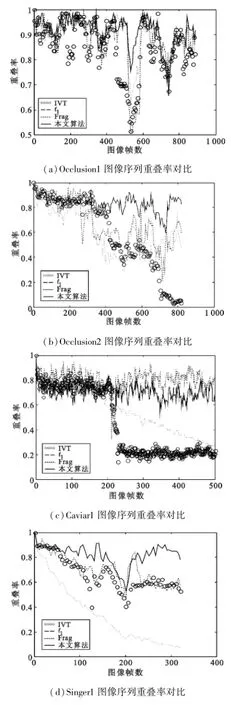

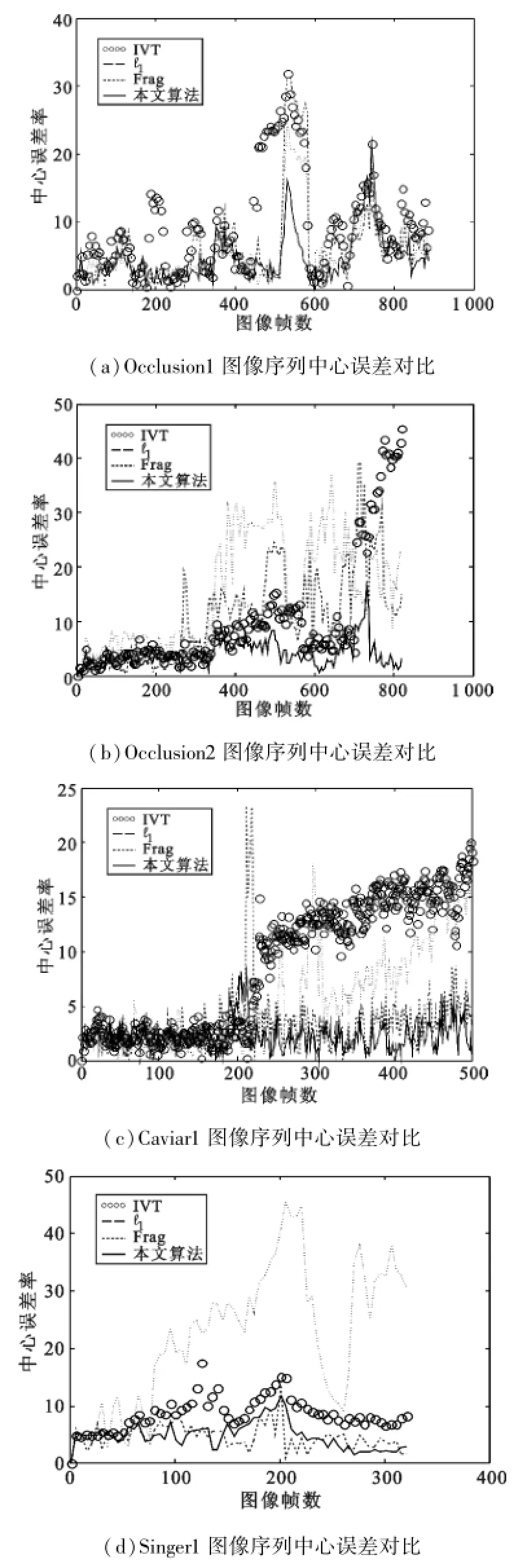

评估跟踪算法的有效性时,需要完整,客观的评价标准。为此将从两个评价标准对跟踪算法进行评估。首先是由PASCAL VOC标准[14]定义的重叠率,其中,RT表示跟踪方框的区域,RG表示实际的目标区域。当score的值大于0.5时便认为跟踪算法是成功的。其次是中心误差(Center Error),中心误差为跟踪方框的中心位置偏离目标物体的中心位置的距离。此值越小说明跟踪效果越好。图5和图6分别是本文算法与其它几种算法在Occlusion1序列、Occlusion2序列、Caviar1序列的中重叠率和中心误差的对比。

图5 重叠率Fig.5 Overlap rate

图5表示本算法与IVT,ℓ1,PN,VTD,MIL, FragTrack算法重叠率对比。a是Occlusion1图像序列的重叠率,b是Occlusion2图像序列的重叠率,c是Caviar1图像序列的重叠率,d是Singer1图像序列的重叠率。

图6 中心误差Fig.6 Center Error

图6表示的是本文算法与IVT,ℓ1,FragTrack算法中心误差对比。其中,a是Occlusion1图像序列中心误差,b是Occlusion2图像序列中心误差,c是Caviar1图像序列中心误差,d是Singer1图像序列中心误差。由图像可知本文算法平均中心误差较低,对跟踪效果具有较强的鲁棒性。

表1 重叠率对比Table 1 Overlap-rate comparison

表1是本文算法与IVT,ℓ1,FragTrack算法重叠率量化对比。由对比结果可以看到,本文算法重叠率的平均值高于其他算法。

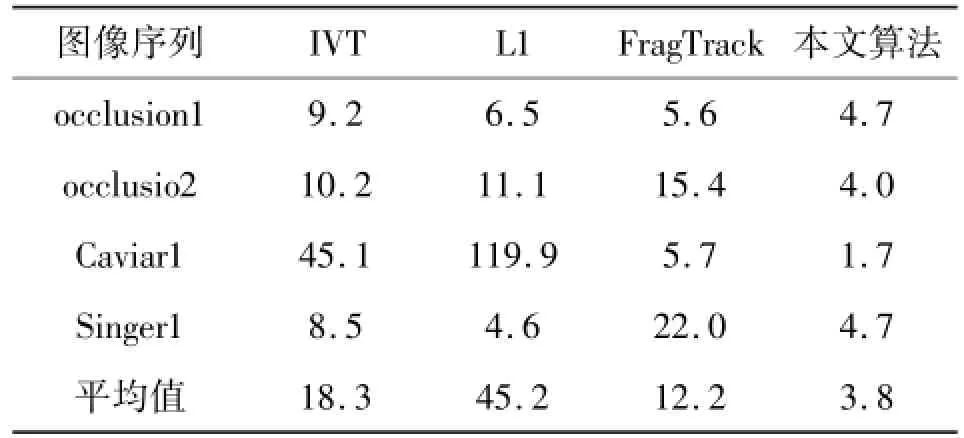

表2 中心误差对比Table 2 Center-error comparison

表2是本文算法与IVT,ℓ1,FragTrack算法中心误差的量化对比。

由表1重叠率和表2中心误差对比结果可以看到,本文算法优于IVT算法、Frag Track算法以及ℓ1算法。上述几种算法中都考虑到了遮挡问题。其中,Frag Track算法通过部分直方图表示来解决了遮挡问题;ℓ1算法是通过将次要模板用稀疏来解决遮挡问题。在Occlusion2序列图像实验中,Frag Track算法表现不尽人意,这是因为此算法中没有对目标物体形变和遮挡的部分进行处理。ℓ1跟踪算法在此序列中跟踪效果并不好,其原因主要是其简单的更新模型,即只是采用新的观测图像更新模型,没有将遮挡部分分离出来。当目标物体被遮挡时,本文算法检测到遮挡物部分,并根据遮挡情况不同对观测模型采取不同的更新方法,所以当目标物体被遮挡以及发生旋转时表现出较强鲁棒性。在Singer1图像序列中,本算法和IVT算法具有较好的跟踪效果。这主要是因为当被跟踪的物体外观改变时可以通过子空间近似表示为固定姿势[15],这样就会产生良好的跟踪效果。

3 结 语

本文的模型充分利用增量主成分分析与ℓ1最小距离算法,在观测模型中建立跟踪模型的稀疏表示。为了解决追踪中出现的漂移问题,算法考虑到了遮挡问题。在相邻两帧之间应用仿射变换估计当前帧中目标物体的位置,从而建立动态目标跟踪模型。当被跟踪的物体发生遮挡时,对观测模型采取了不同的更新方法。最后通过实验证明本文算法是有效的。在下一步工作中,我们尝试在不同的场景中集成多种视觉表示方法来更好的描述对象,结合先验知识与在线学习实现更有效的跟踪效果。

[1] LIM J,ROSS D,YANG M H,et al.Incremental Learning for Robust Visual Tracking[J].International Journal of Computer Vision,2008(77):125-141.

[2] 陈美龙,戴声奎.基于GLCM算法的图像纹理特征分析[J].通信技术,2012(02):108-111.

CHEN Meilong,DAI Shengkui.Analysis on Image Texture Based on Gray-level Co-occurrence Matrix[J]. Communications Technology,2012(2):108-111.

[3] GANGNET M,HUE C,VERMAAK J,et al.Colorbased Probabilistic Tracking[C]//EECV.Denmark: Springer,2002,7:661-675.

[4] HU Weiming,LI Xi,ZHANG Xiaoqin,et al.Incremental Tensor Subspace Learning and Its Applications to Foreground Segmentation and Tracking[J].International Journal of Computer Vision,2011(91):303-327.

[5] WANG Dong,LU Hu-chuan,CHEN Yen-wei.Incremental MPCA for Color Object Tracking[C]//20th International Conference on Pattern Recognition.Istanbul: IEEE,2010:1751-1754.

[6] WANG Tiesheng,IRENE Y H G,SHI Pengfei.Object Track-ing Using Incremental 2-D-PCA Learning and ML Estimation[C]//IEEE International conference.Honolu-lu:IEEE,2007:933-936.

[7] LI Guorong,LIANG Dawei,HUANG Qingming,et al. Object Tracking Using Incremental 2-D-LDA Learning and Bayes Inference[C]//IEEE International Conference.San Diego:IEEE,2008:1568-1571.

[8] ROSS D A,LIM J,LIN R S,et al.Incremental Learning for Robust Visual Tracking[J].International Journal of Computer Vision,2008(77):125-141.

[9] MEI Xue,LING Haibin.Robust Visual Tracking Usingℓ1Minimization[C]//IEEE International Conference on Computer Vision.Maryland:IEEE,2009:1436-1443.

[10] 张铮,王艳平,薛桂香.数字图像处理与机器视觉[M].北京:人民邮电出版社,2010:390-396.

ZHANG Zheng,WANG Yanping,XUE Guixiang.Digital Image Processing and Machine Vision[M].Beijing: Posts&Telecom Press,2010:390-396.

[11] NEDEVSCHI S,PETER I R,DOBOS I A,et al.An Improved PCA Type Algorithm Applied in Face Recognition [C]//IEEE International Conference on Intelligent Computer Communication and Processing.Cluj-Napoca: IEEE.2010:259-262.

[12] DONG Ping,GALATSANOS N P.Affine Transformation Resistant Watermarking Based on Image Normalization [C]//IEEE International Conferenc on Image Processing.Chicago:IEEE.2002:489-492.

[13] MEI Xue,LING Haibin.Robust Visual Tracking and Vehicle Classification via Sparse Representation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2011(33):2259-2272.

[14] MARK Everingham,LUC V G,CHRISTOPHER K I W, et al.The Pascal Visual Object Classes Challenge Results[OL].New York:Springer US,2006[2014-04-08].http://pascallin.ecs.soton.ac.uk/challenges/ VOC/

[15] BELHUMEUR P N,KRIEGMAN David J.What is the Set of Images of an Object under All Possible Illumination Conditions[J].International Journal ofComputer Vision,1998(28):245-260.

LIUWei(1987-),male,graduate student,mainly engaged in image processing.

黄勇坚(1974—),男,硕士,副教授,主要研究方向为图像处理、嵌入式系统设计;

HUANG Yong-jian(1976-),male,M. Sci.,associate professor,mainly engaged in image processing and embedded system design.

骆 华(1989—),男,硕士研究生,主要研究方向为智能信息处理;

LUO Hua(1989-),male,graduate student,mainly engaged in intelligent information processing.

周子力(1973—),男,副教授,主要研究方向为智能通信技术。

ZHOU Zi-li(1973-),male,associate professor,mainly engaged in intelligent communication technology.

Tracking Algorithm based on Online Target

Liu Wei,Huang Yong-jian,Luo Hua Zhou Zi-li

(College of Physics,Qufu Normal University,Qufu Shandong,273165,China)

Online target tracking is a challenging problem.When the surface of moving target changes and the fuzzy caused by background object's shelter and movement appears,it is necessary to establish an effective external representation model of object.Thus,by taking advantage of the typical principal component analysis(PCA)and sparse representation,an effective observation model is established.And by introducing L1 minimum value into the reconstruction of PCA,the target object is expressed as the sum of the major characteristic and the noise.In addition,when the shade and motion blur,in order to reduce the tracking drifting phenomenon,a novel model is proposed instead of simply updating the observation model. Experiments show that when the target object is covered and the background light changes dramatically,the algorithm is of strong robustness in target tracking.In overlap rate of evaluation index and center error,the algorithm is significantly improred in tracking accuracy.

motion target;observation model;ℓ1minimum;principal component analysis;sparse representation

TP391.4

A

1002-0802(2014)11-1285-06

10.3969/j.issn.1002-0802.2014.11.010

刘 伟(1987—),男,硕士研究生,主要研究方向为图像处理;

2014-08-15;

2014-09-15 Received date:2014-08-15;Revised date:2014-09-15

国家自然科学基金资助项目(No.61107030);山东省高校科技计划项目(No.J12LN08)

Foundation Item:The national natural science fund(No.61107030);Shandong university of science and technology plan projects(No.J12LN08)