SIFT匹配算法在视频拼接中的优化应用

丁雄飞,陈 笋,张 宇,张春燕

安徽大学数学科学学院,安徽合肥,230601

在视频拼接的过程中,首先要对选取的视频帧进行匹配。目前,图像匹配方式主要有两种:以灰度为基础的匹配和以特征为基础的匹配。灰度匹配是基于像素的,特征匹配则是基于区域的。后者主要是通过提取图像的显著特征(如边缘和角点)进行匹配。这些方法中的共同之处是寻找具有不变性的特征点,使用大量周围图像数据的显著特征,形成不变的特征描述符,实现匹配。

图像匹配的发展可以追溯到Moravec[1]在1981年提出的对立体匹配的检测,在其之后,Harris和Stephens[2]在1988年对Moravec算子进行了改进,使其在对小图像和其附近边缘的变化更具适用性。随后,Harris[3]在1992年有效地显示了它的运动跟踪和三维结构。而Schmid和Mohr[4]在1997年开创性表明,不变的局部特征匹配可以扩展到一般的图像识别问题,他们还使用了Harris角点选择“兴趣点”,但不是匹配一个相关的窗口,而是使用了图像中具有旋转不变描述符的局部区域,使其在任意方向都有相匹配的功能,在两个图像之间可以进行切换。最终,D.G.Lowe[5]在1999年提出SIFT算法,当时主要用于对象识别。2004年,D.G.Lowe[6]对该算子做了全面的总结及更深入的发展和完善。随后,Y.Ke[7]将SIFT算法中的描述子部分用PCA代替直方图的方式进行改进。本文主要基于优化的SIFT算法进行视频帧的匹配,以求能够更准确地计算偏移量,最终达到更好地进行视频拼接的目的。

1 SIFT算法的简介

SIFT是Scale-invariant feature transform的缩写,中文翻译是尺度不变特征转换,对图像缩放、旋转以及仿射变换保持不变性。本算法主要可以概括为3个步骤。

1.1 尺度空间的建立和关键点检测

尺度空间[8]的建立主要是为了模拟图像的多尺度特征,而一幅图像的尺度空间可以由该图像和高斯卷积而得到。高斯卷积核则是实现尺度变换的唯一线性核[9]。然后再对相邻尺度的两个高斯图像相减得到DOG金字塔。在得到DOG尺金字塔之后,接下来对DOG空间中的局部最大值和最小值进行检测,将DOG尺度空间中每一个取样点与它同一尺度的8个相邻点以及上下相邻尺度空间所对应的9*2个点共26个点做比较,以确保在尺度空间和二维图像空间都检测到关键点。

1.2 关键点方向的确定和描述子生成

在检测到关键点之后,将要为每个关键点指定方向。

(1)

(2)

式(1)、式(2)为关键点(x,y)的模和方向公式[10]。L为每个关键点各自所在的尺度。在视频帧匹配过程中,在以关键点为中心的邻域窗口内取样,并用梯度方向直方图统计邻域像素的梯度方向,以直方图的峰值作为关键点邻域像素的梯度主方向,以大约达到主峰值80%能量的峰值作为辅方向,实验证明,关键点具有多方向可以增强鲁棒性。为保证旋转不变性,将坐标轴旋转到关键点方向,再以关键点为中心,取8*8的窗口,形成2*2个种子数,每个种子数对应一个2*2像素小块,在每个小块中分别计算8个方向的梯度直方图,最终获得64维的关键点描述子。

1.3 图像匹配

2 优化的SIFT算法

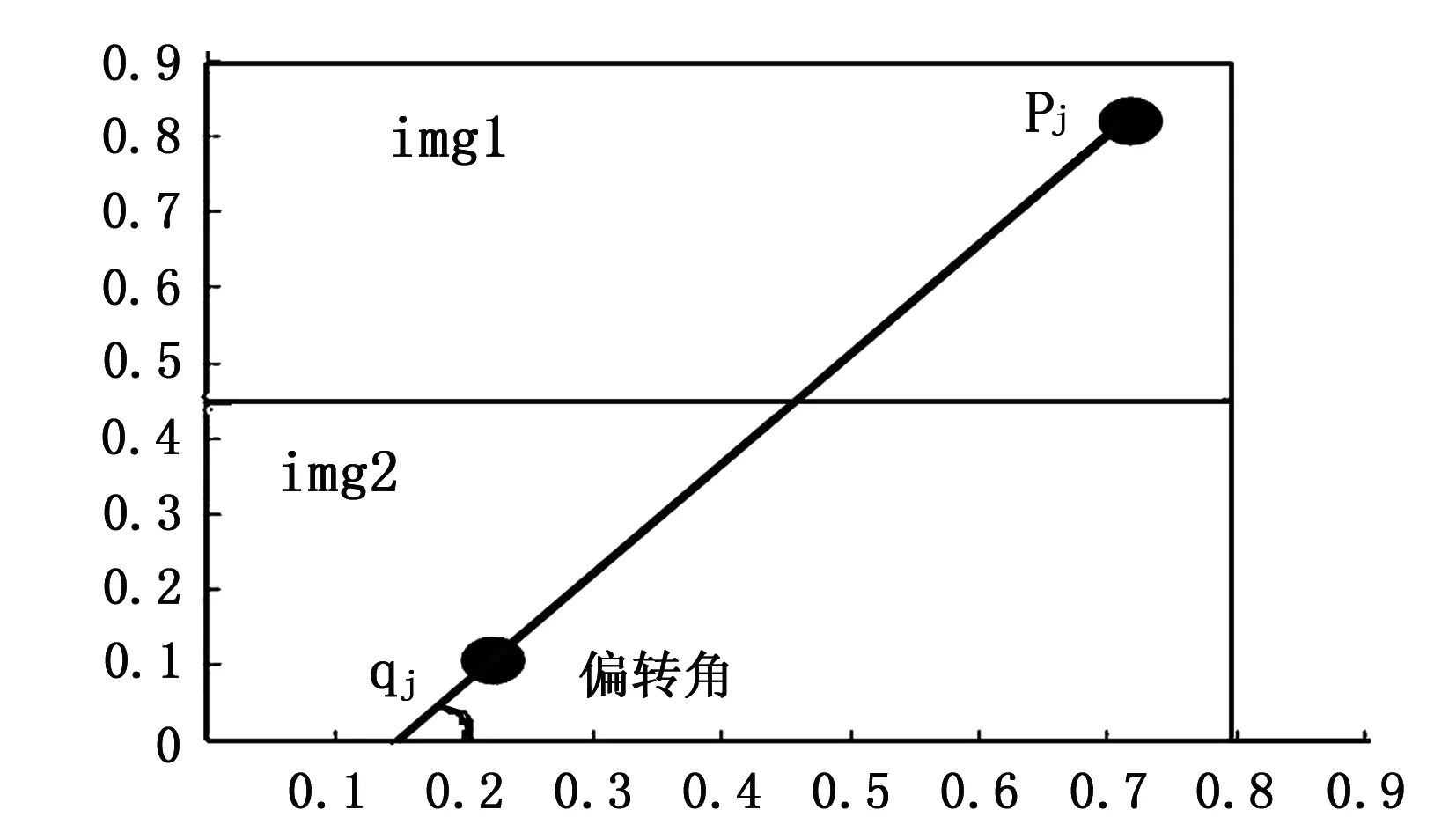

图1

据此,首先建立直角坐标系,如图1所示,将待匹配的左图记为img1,右图记为img2。

3 实验及结果分析

本文的实验环境如下:操作系统为Window XP,平台VS2005+OPNECV2.3.1。所采集的视频帧大小为480*480,均受到不同程度的旋转、缩放、视角变化、亮度和噪声等因素的影响。用优化的SIFT算法和原SIFT算法分别对所采集的视频帧进行匹配实验,将得到的匹配点对数和最后得出的偏移量进行对比。

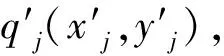

图2 图3

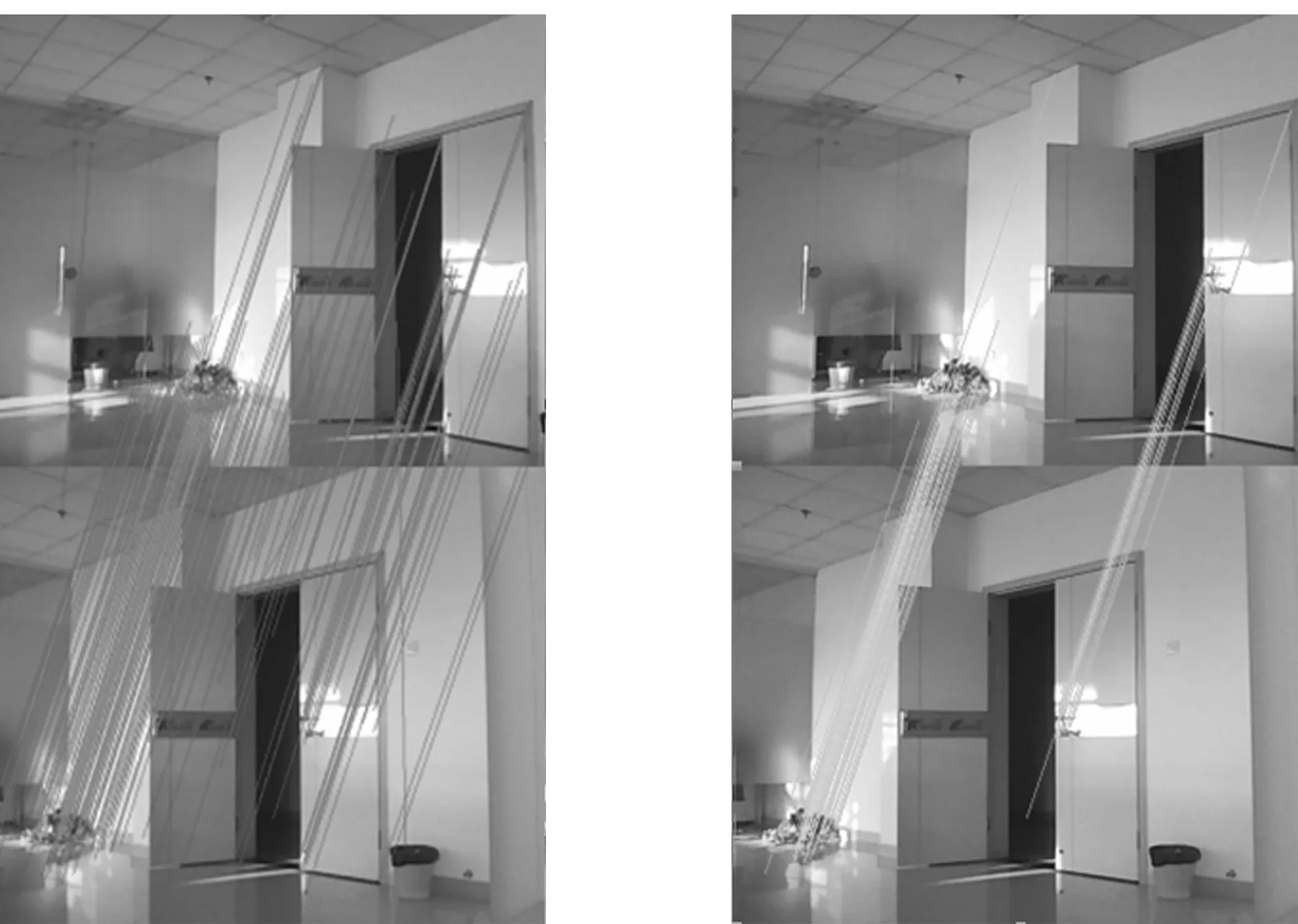

表1

匹配点对偏移量时间SIFT172(142,-412)13.1s优化后的SIFT63(168,-464)10.8s

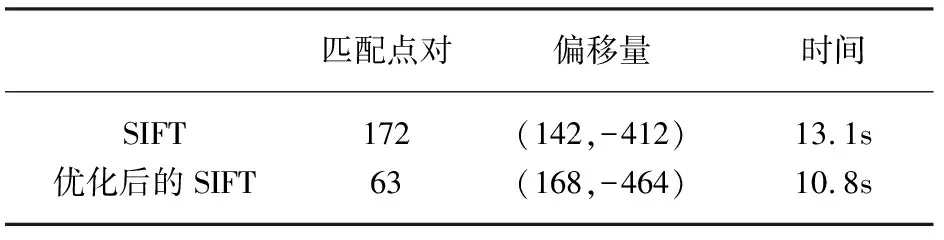

由图2和图3的匹配线对进行直观进行比较,再将优化前后所得到的数据对比,见表1,可以很明显地看出,优化后的SIFT算法对那些错误的匹配点对进行了很好的消除。再根据上面计算出来的偏移量进行拼接,为便于进行对比,将拼接后的图像显示如图4(基于传统SIFT算法的拼接图)和图5(基于优化的SIFT算法的拼接图)。

图4图5

从拼接后的图片可以看出,优化的SIFT算法消除了重复区域拼接的模糊性,在拼接的效果方面优于以前。在实际应用中,优化的SIFT算法提高了视频拼接时所需偏移量计算的准确性。这对于视频拼接所要求的实时性和高效性具有非常重要的意义。

4 结 论

实验结果表明,优化的SIFT算法在视频拼接中能实现准确计算偏移量,对于真正的生产和应用具有很重要的意义。但是存在以下问题:(1)在时间方面应该可以进一步提高;(2)对于无匹配点或者只有一对匹配点的情况无法进行处理。

参考文献:

[1]Moravec H.Rover visual obstacle avoidance[C].International Joint Conference on Artificial Intelligence.Vancouver,Canada,1981:785-790

[2]Harris C,Stephens M.A combined corner and edge detector[C].Alvey vision conference,1988:147-151

[2]Harris S,Dawson-Hughes B.Seasonal mood changes in 250 normal women[J].Psychiatry research,1993,49(1):77-87

[3]Harris M,Freeman T,Hughes J.Retinal speed gradients and the perception of surface slant[J].Vision research,1992,32(3):587-590

[4]Mikolajczyk K,Schmid C.Scale & affine invariant interest point detectors [J].International journal of computer vision,2004,60(1):63-86

[5]Shimkets R A,Lowe D G.Gene expression analysis by transcript profiling coupled to a genedatabase query[J].Nature biotechnology,1999,17(8):798-803

[6]Lowe D G.Distinctive image features from scale-invariant key-points[J].International journal of computer vision,2004,60(2):91-110

[7]Ke Y,Sukthankar R.PCA-SIFT:A More Distinctive Representation for Local Image Descriptors[J].Computer Vision and Pattern Recognition,2004,2(2):506-513

[8]Perona P,Malik J.Scale-space and edge detection using anisotropic diffusion[J].Pattern Analysis and Machine Intelligence,IEEE Transactions,1990,12(7):629-639

[9]Babaud J,Witkin A P,Baudin M,et al.Uniqueness of the Gaussian kernel for scale-space filtering[J].Pattern Analysis and Machine Intelligence,IEEE Transactions,1986(1):26-33

[10]卜凡艳,檀结庆.利用SIFT算子与图像插值实现图像匹配[J].计算机工程与应用,2011,47(16):156-158