基于匹配分布和混合高斯模型的车辆检测算法

戴夏强, 周大可, 鹿 乐

(1. 南京航空航天大学 自动化学院, 南京 210016; 2. 中国兵器北方信息控制集团有限公司, 南京 211153)

0 引 言

随着生活条件的改善, 汽车进入了越来越多的家庭, 智能交通的概念正是在交通状况日益恶化的条件下提出的。其中运动目标检测是智能交通的关键步骤, 准确性高的运动目标检测有利于后续的车辆特征提取、 目标跟踪等步骤。常用的运动目标检测方法主要有光流法、 背景差分法、 帧间差分法和特征检测法等。其中背景差分法广为使用。

背景差分法[1-5]一般分为两种: 自适应方法和非自适应方法。非自适应方法主要有人工选择、 逐像素点投票法和均值搜索算法等。但非自适应方法由于计算复杂和需要人工的初始化等因素逐渐被舍弃。自适应方法主要有隐马尔科夫模型法[5]、 卡曼滤波法[6]、α混合法[7]和高斯混合法[8]等。α混合法最简单、 速度最快, 但检测缓慢运动目标的效果较差, 并且它和卡曼滤波一样不能解决背景多模态的问题。隐马尔科夫模型法虽然能解决背景的多样变化性问题, 如灯光的亮和暗, 但计算量太大, 不适宜用于实时的车辆检测中。而Stauffer等[2]提出的混合高斯模型(GMM: Gaussian Mixture Model)是建立背景较常见和成功的方法之一, 主要由于它能很好地适应背景的多态性和缓慢变化性, 并且计算简单, 特别是Grimson等[1]提出的背景更新方程迭代的方法使背景的学习更加简单高效。它主要对每个像素点、 每帧都建立一个混合高斯方程, 通过学习, 确定点属于前景或背景, 但它也有一些开放性的问题, 如不稳定的背景、 移动缓慢的稳定前景、 光照的突变和阴影等, 这些问题比较典型。目前很多人针对GMM提出了一些改进的方法, 李全民等[9]把背景重构和前景消融世间控制机制整合到传统自适应混合高斯背景模型中, 提高了运动分割的质量; 李伟等[10]提出根据统计每个像素每个模型被匹配的次数, 为每个像素分配一个学习率, 并且在线更新学习率; 马义德等[11]针对模型收敛较慢和检测大而慢的运动物体效果不理想的缺点, 提出对均值和方差的更新采用不同的学习率和引入权值均值的概念。

笔者充分考虑到车辆运动的连续性和空间性以及每帧的检测结果, 提出了一种基于匹配度分布的混合高斯车辆检测算法。该算法兼顾时间性和空间性, 通过实验有效地证明了该算法在不稳定的背景、 移动缓慢的稳定前景、 光照突变的问题上有较高的鲁棒性, 并且复杂度没有太大增加, 很适合用于车辆的实时检测。

1 ROI提取

在车辆检测中, 人们一般使用背景差分法提取ROI(Region of Interest)。因此, 首先要进行背景建模, 常用的背景建模方法是高斯混合模型, 检测动目标的区域, 然后对该区域进行形态学滤波、 连通性分析和阴影消除等后续处理, 最后可以提取车辆区域。

1.1 高斯混合模型

在统计模式识别中, 高斯混合模型可用于对多变量数据进行建模, 得到数据的近似分布。Grimson等[1]提出了高斯混合法对颜色特征建模, 可把每个像素点看作为K个高斯的混合分布, 因此, 要得到每个像素点的混合高斯概率分布, 只需其概率密度函数满足

(1)

(2)

其中μk,Σk分别是第k个高斯模型的均值向量和协方差矩阵, 即θk=[μk,Σk]。

1.2 模型参数估计

在高斯混合模型参数估计中, 由于样本没有类别标记, 为不完全样本, 因此不能采用最大似然估计的方法估计参数, 通常采用期望最大化算法EM(Expectation Maximization)进行参数估计[12]。但对像全天候不断变化的交通道路, 要不断采样变化的样本, 如果使用EM方法不停地估计高斯混合模型的参数, 则会导致计算的重复性, 增加数据处理的负担, 无法满足视频中车辆检测的实时性。因此, Grimson等[1]提出了自适应混合高斯背景模型算法。该算法可进行迭代更新, 计算简便, 成功地解决了背景变化对目标检测的干扰, 能有效地抑制缓慢光照变化, 满足了视频监控的实时性要求。

(3)

其中α和ρ都是学习率,α可初始化为一个常量,ρ=α/ωi,t,Mi,t为匹配标志函数。

(4)

要进行参数更新, 匹配准则必须满足

|Xt-μi,t-1|≤Dσi,t-1

(5)

其中D为参数, 一般取2,μi,t-1和σi,t-1为第i个像素点t-1时刻的第k个单高斯函数的参数。

1.3 车辆目标的分离

按照式(3)~(5)可得到K个高斯分布, 按照从大到小的原则进行排列, 最有可能代表背景的是前B个高斯分布, 取背景高斯分布的准则如下

(6)

其中T为权重阀值,ωk是高斯的权值。

根据式(1)得到背景图像, 根据式(5)比较像素和K个高斯分量之间的关系, 可得到动目标的前景区域[9], 再通过对前景图像的进一步处理, 包括阴影消除、 形态学滤波, 可得到车辆的区域。由于在开始背景学习的过程中, 像素的权值较小, 因此, 模型的学习率较大, 车辆区域像素值很容易被更新到背景的模型中; 当车辆区域较大、 颜色纹理较均匀并且速度较慢时, 车辆区域像素在背景学习的过程中会占据较大的权值, 进而会误认为车辆一部分区域为背景区域, 很容易在检测的过程中导致车辆的断裂, 误认为多辆车, 对于后续的操作产生不良影响。因此, 传统的背景模型的学习有很大的弊端。

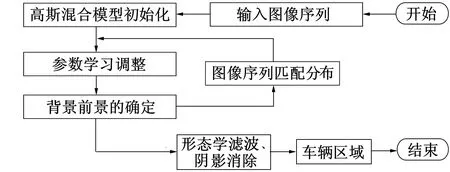

2 模型学习的改进及目标的检测

Stauffer等[2]的方法在背景初始化后通过迭代的方法可收敛到一个估计的背景。在目标检测的过程中, 背景越是稳定和准确, 目标的检测则越好。但对于面积大、 车速较慢、 颜色较均匀的车辆, 用传统的方法很容易把车辆的颜色信息纳入到背景的混合高斯模型中, 这样很容易造成车辆检测的断裂或没有检测出车辆的问题。所以笔者把检测目标的空间信息引入到高斯混合模型的学习中, 充分利用前一帧每个像素邻域的匹配信息, 构建一个匹配分布函数, 改变学习规则, 对模型进行选择性学习, 既提高了背景区域模型的稳定性, 同时又提高了车辆区域背景模型的准确性。车辆区域检测过程如图1所示。

图1 车辆区域检测流程

2.1 含有邻域信息的匹配度分布

为得到含有邻域信息的匹配分布, 必须知道前一帧车辆检测的初步结果, 因为在车辆图像中, 车辆的前景是以块产生的, 一个像素的匹配受到该像素邻域像素点匹配的影响[13]; 在背景区域, 背景像素匹配度明显大于车辆区域或车辆边缘区域, 引入邻域信息加强了匹配度的区域一致性, 同时减少了边缘以及噪声对点匹配度的干扰, 在这里定义一个匹配分布函数

(7)

(8)

2.2 背景更新策略

传统的更新参数的高斯混合模型在背景初始化阶段能产生很好的检测效果, 但在参数更新的过程中使用迭代的方法会使更新很慢。由于自适应混合高斯模型的学习率普遍采用ρ=α/ωi,t(使用β=αη(It(x,y)|μi,t,σi,t) 计算量较大), 随着时间的增长, 权重较大的像素点的学习率很小, 所以保证了背景的稳定性; 权重较小的像素点的学习率较高, 这样可以适应背景像素点的变化, 增加了背景的准确性。但当大而且速度慢的车辆进入时, 就会导致车辆成分融入到背景中, 造成误检。因此, 对车辆图像, 在分析前几帧的检测结果基础上, 计算其匹配度分布, 调整该像素的学习率, 降低不大可能属于背景点的学习率, 同时增加背景像素的学习率, 以便提高复杂情况下车辆的检测。

具体的更新步骤如下。

1) 高斯模型初始化。由于笔者的背景更新中涉及的匹配分布依赖于前几帧的车辆检测结果, 背景初始化的准确性影响到后续的检测效果, 因此笔者采用模糊c均值聚类算法。首先对前面的多帧图像进行聚类, 选定类别数, 有限地判断每个像素的初始均值、 方差。假设图像中每个像素点有M个样本, 再把每个像素点的样本分成c类, 定义一个损失函数

(9)

其中uij代表在第i类的第j个样本xj的友好度,vi是第i类的中心, 参数m是聚类的模糊度, 一般取值为2。

(10)

(11)

模糊c均值聚类可用迭代的方法收敛到一个合适的值, 当属于原本该类的像素点取得高友好度、 而不属于该类的像素点取得低友好度时, 损失函数取得最小值。最后聚类类别数目就是混合高斯成分的数目, 每类的均值和方差对应于每个单高斯的均值和方差, 每个单高斯的权值为每类别样本数目在总数目的权值。

3) 光照突变影响的克服。假定车辆实时现场像素点的变化是连续变化的, 传统的高斯混合模型没有解决常见的光照突变问题。由于车辆移动和背景像素点变化是连续的, 所以图像序列匹配度分布的变化也是连续的。当某帧某个区域光照突然发生变化(例如车灯突然打开)时, 传统混合高斯很容易把照亮区域检测为车辆区域, 并且把照亮区域融入到背景的学习中, 鉴于该区域匹配度变化的连续性, 选用下面的更新策略。

2.3 前景的确定与噪声点去除

对前景的确定笔者选择Stauffer的思想, 循环计算像素点有序高斯分布的权值之和, 按照阈值法生成背景图像。该实验中T=0.8。有了背景图像, 再通过背景差分法得到前景图像, 此时得到的前景中包括运动目标区域和噪声点。检测的目标区域包含阴影部分, 所以要准确提取车辆, 必须去除阴影。目前普遍采用的方法是色彩空间法[15], 基于HSV的色彩空间信息的阴影检测算法属于非模型类, 采用该方法是因为HSV色彩模型非常符合人对颜色的视觉感知的生理特性, 而且能更精确地反映一些灰度信息和色彩信息, 特别对图像中极亮和极暗的物体, 也能反应出相应的信息。背景在被阴影遮挡前后利用两个色彩分量(颜色H(Hue)和饱和度S(Saturation))的变化量之比近似不变的特性进行阴影检测, 检测物体的阴影, 从而达到去阴影的目的。

传统的噪声点分为孤立噪声点和车辆区域内部噪声点。对于孤立噪声点, 这里用连通性分析, 计算其面积。由于车辆区域是以块产生的, 车辆的区域明显大于孤立噪声点的区域, 因此, 可用一个面积阈值消除孤立噪声点。而对于车辆内部噪声点, 这里使用形态学的方法。通过选择合适的结构元进行开闭运算, 开运算可以消除车辆周围点连接的噪声点, 闭运算可以填补车辆内部碎化的小区域, 然后通过车辆内部填充可得到完整的车辆区域。

3 实验结果与分析

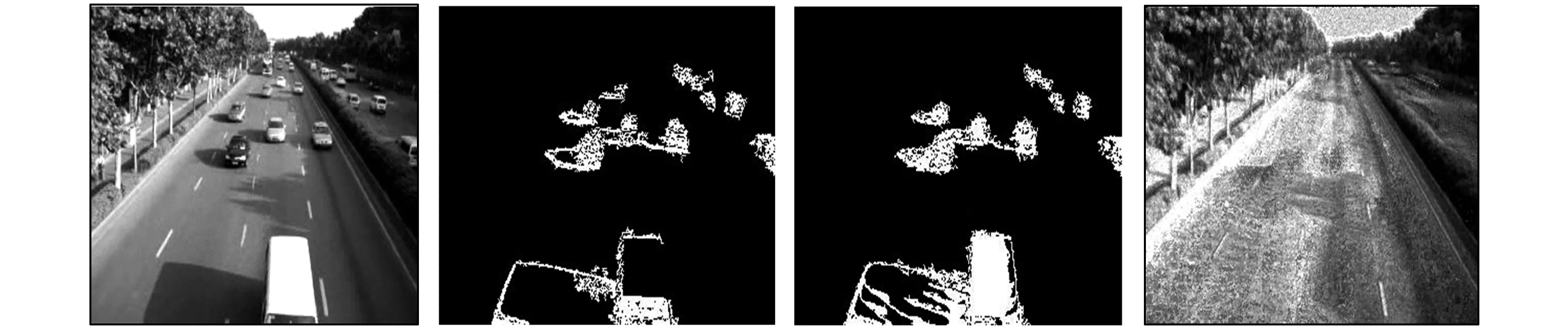

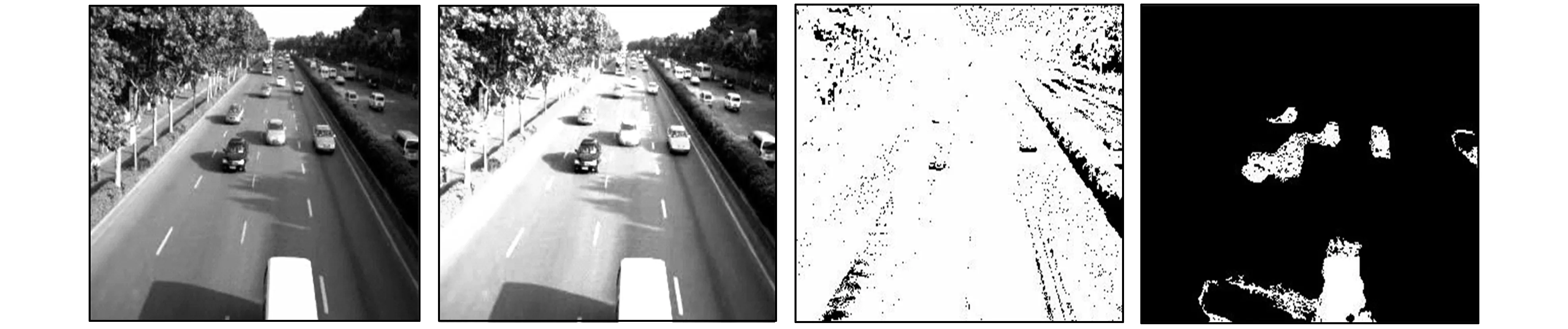

为验证该算法的有效性, 笔者选取一个真实场景序列作为测试对象, 该场景来自真实的交通摄像头拍摄的视频。为证实传统的Grimson自适应高斯混合模型在检测面积大、 车速较慢、 颜色较均匀的车辆的缺陷, 这里选取了有代表性的目标图片。该图片中车辆速度慢, 车长, 而且颜色较均匀。首先用传统的高斯混合模型进行车辆区域(包括阴影部分)的提取, 为了在实时交通视频处理中提高检测的实时性, 提高计算速度, 对每个像素选取3个高斯成分, 每个像素点取1维, 即灰度, 初始方差为36, 参数α=0.01,T=0.8。在改进的混合高斯方法中首先对前90帧用c均值聚类算法求得混合高斯模型的初始参数。为了提高计算的速度, 聚类类别数也选择3, 即初始化混合高斯成分数为3, 方差和均值都可从c均值聚类中得到, 参数T1选择0.7,T2选择0,2,m选择30, 参数α=0.01 ,T=0.8, 匹配分布的窗口半径都选为4。随着背景不停学习, 高斯成分数目将发生变化, 在稳定的背景区域高斯成分数目将变得很小, 而在光照缓慢变化的前景区域将变得很大, 检测效果如图2和图3所示。

a 第78帧 b 第82帧 c 第78帧检测结果 d 第82帧检测结果

a 第91帧 b Grimson GMM检测结果 c 改进GMM检测结果 d 传统GMM生成的背景

e 图2的第100帧 f Grimson GMM检测结果 g 改进GMM检测结果 h 改进GMM生成的背景

从图2可看出, 用传统的高斯模型检测小车辆区域时, 检测的效果很好, 包括了阴影区域。但是, 从图3b和图3f可看出, 大车辆车身检测断裂了, 其他一些小的目标的阴影部分也发生空洞。从图3d可看到车辆的影子(包括一些车辆的涟漪), 表明传统混合高斯模型在提取背景过程中把车辆的成分放到了模型中。从图3c、图3g和图3h可看到, 使用改进的方法, 背景的提取明显比传统方法准确, 包括可看到的右侧的阴影背景, 车辆本身提取很完整, 没有发生断裂。

在图4中, 笔者加入一幅光照突变的图片, 这种状况在一般的情况下很容易发生, 包括车辆车灯突然打开的情况, 造成了局部光照明显加强。在图4b中发生光照突变, 在图4c中可看到, 用传统的自适应高斯混合模型很容易把大部分的区域归入到前景, 所以造成目标的误检, 在图4d中采用改进的方法成功地检测出一些车辆目标。

a 第97帧原图 b 第97帧光照突变图片 c Grimson GMM检测结果 d 改进GMM检测结果

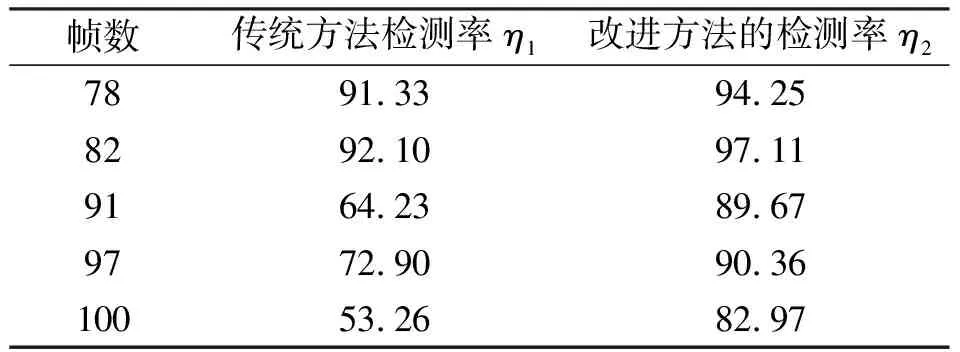

为准确评估两种算法的有效性, 这里引入了前景检测率

(11)

表1 算法检测率结果

在这个实例中, 传统方法每帧的处理时间平均为0.036 879 s, 而改进算法的时间平均为0.078 274 s, 在处理时间上没有大幅增加, 完全可运用到实时的检测中。

这里可得到一些结论: 传统的自适应混合高斯模型没有得到车辆的完整提取, 存在一些缺陷, 改进的方法克服了传统高斯混合模型车辆断裂、 背景学习的不准确性和光照带来的影响, 使检测率平均提高了16%以上, 计算方便, 可在实时交通检测中应用。

4 结 语

笔者针对车辆检测中存在的几种缺陷, 提出了一种改进的混合高斯检测算法。该算法用c均值聚类法求初始值, 使开始的车辆检测更加准确, 有利于后续帧的检测。根据先前几帧检测的匹配度分布, 有效利用了时间图片序列的信息, 并且让每个点的更新都与邻域相关, 改变背景学习的规则。实验结果表明, 该算法比传统的混合高斯检测方法更加优越, 有效地克服了车辆检测的断裂以及光照突变等问题, 提高了车辆区域检测的准确性。对学习率如何准确调整以及一些参数的准确设定, 有待进一步研究。

参考文献:

[1]GRIMSON W E, STAUFFER C, ROMANO R, et al. Using Adaptive Tracking to Classify and Monitor Activities in a Site [C]∥Proceedings of the IEEE Computer Vision and Pattern Recognition. California, USA: IEEE Computer Society Press, 1998: 22-29.

[2]STAUFFER C, GRIMSON W E. Adaptive Background Mixture Models for Real-Time Tracking [C]∥Proceedings of the IEEE Computer Vision and Pattern Recognition. California, USA: IEEE Computer Society Press, 1999: 246-252.

[3]周游, 刘艳滢, 王春民, 等. 几种人体运动检测算法的比较分析 [J]. 吉林大学学报: 信息科学版, 2009, 27(6): 652-657.

ZHOU You, LIU Yan-ying, WANG Chun-min, et al. Contrast Research of Several Human Motion Detection Algorithm [J]. Journal of Jilin University: Information Science Edition, 2009, 27(6): 652-657.

[4]纪腾飞, 王世刚, 周茜, 等. 基于动静背景下的视频对象自适应提取算法 [J]. 吉林大学学报: 信息科学版, 2007, 25(1): 73-77.

JI Teng-fei, WANG Shi-gang, ZHOU Qian, et al. Adaptive Algorithm of Video Object Segmentation under Moving and Static Background [J]. Journal of Jilin University: Information Science Edition, 2007, 25(1): 73-77.

[5]KATO J, WATANABE T, JOGA S, et al. An HMM-Based Segmentation Method for Traffic Monitoring Movies [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2002, 24(9): 1291-1296.

[6]RIDDER C, MUNKELT O, KIRCHNER H. Adaptive Background Estimation and Foreground Detection Using Kalman-Filtering [C]∥Proceedings of the International Conference on Recent Advances in Mechatronics.ICRAM’95. Istanbul, Turkey: [s.n.], 1995: 193-199.

[7]HARITAOGLU I, HARWOOD D, DAVIS L S. W4: Who? When? Where? What?A Real-Time System for Detecting and Tracking People [C]∥Proceedings of the IEEE International Conference on Automatic Face and Gesture Recognition. California, USA: IEEE Computer Society Press, 1998: 222-227.

[8]MOHAND SAI¨D ALLILI, DJEMEL ZIOU. Object Tracking in Videos Using Adaptive Mixture Models and Active Contours [J]. Neurocomputing, 2008, 7(1): 2001-2011.

[9]李全民, 张运楚. 自适应混合高斯背景模型的改进 [J]. 计算机应用, 2007, 27(8): 2014-2017.

LI Quan-min, ZHANG Yun-chu. Improvement on Adaptive Mixture Gaussian Background Model [J]. Computer Applications, 2007, 27(8): 2014-2017.

[10]李伟, 陈临强, 殷伟良. 基于自适应学习率的背景建模方法 [J]. 计算机工程, 2011, 37(15): 187-189.

LI Wei, CHEN Lin-qiang, YIN Wei-liang. Background Modeling Approach Based on Self-Adaptive Learning Rate [J]. Computer Engineering, 2011, 37(15): 187-189.

[11]马义德, 朱望飞, 安世霞, 等. 改进的基于高斯混合模型的运动目标检测方法 [J]. 计算机应用, 2007, 27(10): 2544-2546.

MA Yi-de, ZHU Wang-fei, AN Shi-xia, et al. Improved Moving Objects Detection Method Based on Gaussian Mixture Model [J]. Computer Applications, 2007, 27(10): 2544-2546.

[12]张运楚, 李贻斌, 张建滨. 高斯混合背景模型的方差估计研究 [J]. 计算机工程与应用, 2012, 48(4): 162-166.

ZHANG Yun-chu, LI Yi-bin, ZHANG Jian-bin. Research on Variance Estimation of GMM Background Model [J]. Computer Engineering and Applications, 2012, 48(4): 162-166.

[13]朱峰, 罗立民, 宋余庆, 等. 基于自适应空间邻域信息高斯混合模型的图像分割 [J]. 计算机研究与发展, 2011, 48(11): 2000-20007.

ZHU Feng, LUO Li-min, SONG Yu-qing, et al. Adaptive Spatially Neighborhood Information Gaussian Mixture Model for Image Segmentation [J]. Journal of Computer Research and Development, 2011, 48(11): 2000-2007.

[14]VASILEIOS KARAVASILIS, CHRISTOPHOROS NIKOU, ARISTIDIS LIKAS. Visual Tracking Using the Earth Mover’s Distance between Gaussian Mixtures and Kalman Filtering [J]. Journal of Image and Vision Computing, 2011(29): 295-305.

[15]董蓉, 李勃, 陈启美. 路况视频中HSV彩色不变量阴影检测法研究与改进 [J]. 中国图象图形学报, 2009, 14(12): 2483-2488.

DONG Rong, LI Bo, CHEN Qi-mei. Research and Improvement on Shadow Detection in Expressway Videos Using HSV Color Model [J]. Journal of Image and Graphics, 2009, 14(12): 2483-2488.