手工提取的视觉特征与深度特征的融合模型用于消化性溃疡再出血风险分级

摘要:目的 提出一种基于电子内镜图像的多特征融合模型,结合深度学习与手工特征的优势,用于消化性溃疡再出血风险的分级。方法 根据溃疡的内镜表现,提取颜色特征以区分活动性出血(Forrest I)与非出血溃疡(Forrest II、III),并利用边缘和纹理特征描述不同级别溃疡的形态与外观。通过融合深度学习网络提取的深度特征与手工提取的视觉特征,形成电子内镜图像的多特征表达,最终用于预测消化性溃疡的再出血风险。结果 在包含708例患者、3573张图像的Forrest分级数据集上,提出的多特征融合模型在消化性溃疡再出血风险六分级任务中取得了74.94%的准确率,优于进修医生59.9%的分级准确性(Plt;0.05)。在Ib、IIa和III级溃疡的识别中,F1得分为90.16%、75.44%和77.13%,其中Ib级表现尤为突出。与首个进行溃疡再出血分级研究的模型相比,提出模型的F1得分提升了5.8%。在简化的3类风险分级任务中,模型在高风险、低风险和无需内镜治疗级别上的F1 得分为93.74%、81.30%和73.59%。结论 本文提出的多特征融合模型有效融合卷积神经网络(CNN)提取的深度特征与手工提取的视觉特征,提升了消化性溃疡再出血风险分级的准确性,为临床提供了高效的诊断辅助工具。

关键词:电子内镜图像;多特征融合;消化性溃疡;Forrest 再出血风险分级

出血是消化性溃疡常见的并发症[1],其发病率占急性上消化道出血的40%~60%,且死亡率维持在5%~10%[2-4]。及时准确地评估消化性溃疡的再出血风险并制定最佳治疗方案,以降低再出血率和病死率,是内镜医生面临的重要课题[5]。目前临床中广泛应用的溃疡再出血风险评估标准是Forrest 分级指南[6-9],它根据内镜下溃疡的特征将消化性溃疡分为3个主要类别(活动性出血、近期出血和无近期出血)及6个亚类,分级越高则再出血的风险越大。在临床实践中,内镜医生需要根据Forrest级别制定个性化的治疗方案以应对不同的再出血风险[10-12]。为了辅助医生进行临床决策,有必要构建一个基于电子内镜图像的消化性溃疡再出血风险分级模型,为医生提供客观准确的溃疡风险预测,帮助他们识别需要进一步内镜治疗的高风险患者。

目前,国内外对电子胃镜图像智能分析的研究主要集中在胃溃疡良恶性辅助诊断领域。Klang 等[13]利用CNN将胃溃疡分为良性和恶性。王智杰等[14]也采用CNN构建了用于早期胃癌、良性病变及正常胃黏膜的自动分类模型。黄丽等[15]则分别使用残差神经网络(ResNet)和VGG网络(Visual Geometry Group)构建了3个二元分类模型,用于识别正常胃黏膜、良性溃疡和恶性溃疡。这些研究关注溃疡的良恶性分类,适用于早期胃癌和恶性病变的筛查。然而,对于内镜医生来说,评估消化性溃疡的再出血风险同样至关重要,准确的风险评估是决定患者是否需要进一步内镜治疗的关键。

Yen等[16, 17]针对消化性溃疡再出血分级问题进行了研究,使用4个不同的CNN模型将溃疡分为三级(正常、无需治疗、需要治疗)和四级(正常、无需治疗、高风险、低风险)。这项研究展示了CNN在消化性溃疡风险分级中的潜力,通过提取电子内镜图像中的高层次语义特征分级溃疡的再出血风险[13, 16, 18]。然而,由于CNN的特征提取过程缺乏医学领域知识的指导,所提取的深度特征未能充分表达电子内镜图像中溃疡的颜色、形态外观等关键诊断信息。为了解决这一问题,本文提出了融合手工与深度特征的消化性溃疡再出血风险分级模型(MFFM),通过结合细粒度视觉特征,融合更多具有医学意义的信息。MFFM由深度特征提取模块(DFM)、手工特征提取模块(HFM)以及基于注意力的特征融合模块(FFM)组成。HFM模块通过提取颜色特征区分活动性出血溃疡(Forrest I)和非出血溃疡(Forrest II、III),并利用边缘和纹理特征直接反映溃疡病变的具体性质。FFM模块则有效融合深度特征和手工提取的视觉特征,形成电子内镜溃疡图像的多维度特征。

1 资料和方法

1.1 实验数据

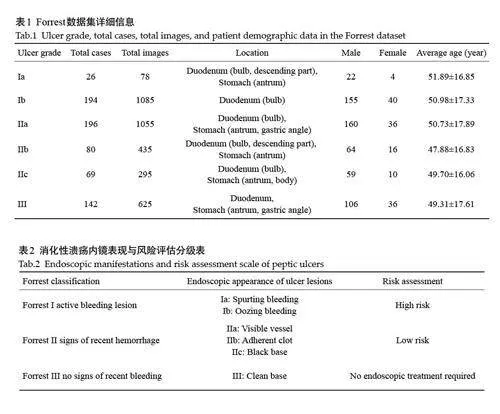

本文回顾性收集了2015 年6 月~2023 年6 月在南方医院消化内镜中心接受电子内镜检查的707例消化性溃疡患者的影像数据,所使用的设备包括Olympus和Fujifilm胃镜。纳入标准:内镜检查明确诊断为消化性溃疡;消化性溃疡引起的出血病例。排除了由静脉曲张出血、肿瘤、血管畸形、息肉切除后出血及原因不明出血所引起的溃疡病例。一共收集到3573张内镜溃疡图像(表1)。由于原始图像尺寸不一致,为了保证模型训练的有效性,所有图像在训练前被统一调整为224×224像素。本研究将所收集的数据定义为Forrest 数据集X Forrest ={xForrest}iNi ,其中包含N张电子内镜图像xForresti ∈ RH×W,H、W分别表示输入图像的高和宽。本研究的数据收集已获得南方医科大学南方医院伦理委员会的审批(NFEC-2024-564),并严格遵循数据隐私保护的相关要求。

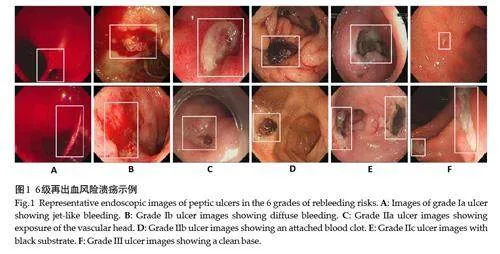

2名具有5年诊断经验的内镜医生根据Forrest临床指南(表2)标注了所有图像,将消化性溃疡分为Forrest 6个等级,并进一步分为高风险、低风险和无需内镜治疗三级,列出6个再出血风险等级下的溃疡图像示例(图1)。

1.2 模型框架

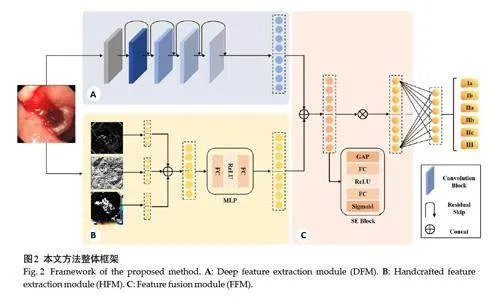

本文提出的分级模型(MFFM)由深度特征提取模块(DFM)、手工特征提取模块(HFM)以及基于注意力的特征融合模块(FFM)组成(图2)。

1.2.1 深度特征提取模块 在深度特征提取模块中,分级模型使用ResNet[19]提取电子内镜图像的复杂高层次语义特征。ResNet的残差连接结构有效缓解了深层网络中的梯度消失问题,确保在处理不同风险级别的溃疡图像时提取到更鲁棒的特征。将电子内镜图像xForresti 输入到深度特征提取模块的特征提取器FD (·),FD (·)输出特征向量Zi ∈ R512,其中512是特征向量的维度,如公式(1)所示。

1.2.2 手工特征提取模块 为了将溃疡再出血风险分级的关键诊断信息融入分级模型,本文添加了手工特征提取模块。该模块通过提取细粒度视觉特征为分级模型提供具有医学意义的信息,并与深度特征融合形成电子内镜溃疡图像的丰富特征表达。

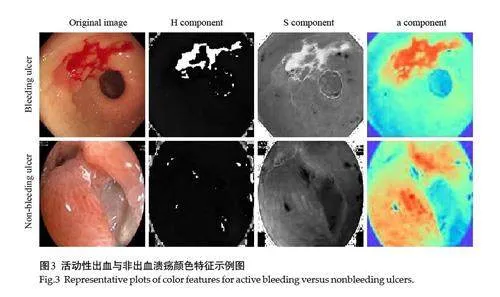

在溃疡再出血风险预测中,首先需要准确判断溃疡的出血状态。根据Forrest 分级指南,消化性溃疡被分为活动性出血(Forrest I)与非出血溃疡(Forrest II、III),其中活动性出血溃疡在内镜图像中呈现红色或暗红色,与非出血溃疡存在显著颜色差异。因此,准确识别这两类溃疡的颜色差异是再出血风险预测的关键。已有研究证实了颜色特征在无线胶囊内窥镜出血检测中的有效性[20-24],本文将颜色特征有效表征出血的能力应用于电子内镜图像分析。考虑到Olympus 和Fujifilm胃镜设备在图像颜色表现上的差异,尤其是在颜色一致性上的问题,本文在手工特征提取模块中选择了HSI和CIELab颜色空间的特征。具体来说,提取了HSI颜色空间中的色调(H)和饱和度(S)分量,以及CIE Lab颜色空间中的a分量,这些分量能够有效区分溃疡的出血与非出血区域(图3),为再出血风险预测提供了重要支持。

在Forrest 分级体系中,不同级别的溃疡在外观与形态上存在显著差异,这为再出血风险分级提供了重要线索。同为出血性溃疡,Ia级溃疡的出血呈喷射状而Ib级表现为弥漫性。在II 级风险溃疡中,IIa 级溃疡表现为平坦溃疡表面的裸露血管,IIb级溃疡则表现为隆起的血凝块,IIc则具有平坦的黑色基底。鉴于这些差异,本文使用边缘和纹理特征描述不同风险级别的溃疡。边缘和纹理特征基于像素之间的差异,这使得在不同设备下提取的特征能够保持一致性。边缘特征通过Sobel算子提取,该算子能有效识别Ia、IIa、IIb、IIc和III级溃疡病灶的清晰边缘,相比之下,由于Ib级溃疡的弥漫性渗血,其边缘信息较为模糊(图4)。此外,纹理特征则通过局部二值模式(LBP)算法提取,以捕捉溃疡表面的细微结构。

为了增强分级模型的视觉特征表示,手工特征提取模块对每个32×32区域计算了颜色分量的平均值、边缘特征以及纹理特征的偏度和峰度统计量[20, 22, 24]。将这些统计量拼接成一个256维的向量,记为Z'H,并通过多层感知机(MLP)进一步优化,生成最终的256维视觉特征向量ZH,如公式(2)所示,

1.2.3 特征融合模块 分级模型融合深度特征与手工提取的视觉特征形成了电子内镜溃疡图像的多维度特征表示,记作ZF。为了提升融合特征的表达能力,在特征融合模块引入了注意力机制[25],通过自适应调整各个特征的权重来优化融合效果。经过注意力机制加权后的融合特征将输入分类器得到各风险分级溃疡的预测概率p(i|I)。

1.3 模型训练设置、评价指标

本文将Forrest数据集按4∶1的比例随机划分为训练集和测试集。为了评估模型在不同训练子集上的表现,训练集进一步采用5折交叉验证。在每个训练周期内,从训练子集中随机抽取32 张图像组成小批量进行训练。输入图像经过数据增强处理,包括随机旋转(90º、180º、270º)以及随机水平和垂直翻转,以提高模型的泛化能力。图像经过标准差归一化处理作为模型输入。模型训练采用随机梯度下降(SGD)优化算法,初始学习率设定为0.01。每折训练过程中,模型在训练子集上进行了100个训练周期,训练结束后在验证子集上评估性能,并保存表现最佳的模型。最终,模型在测试集上进行性能评估。训练过程中使用交叉熵损失函数作为优化目标。实验在 Python 3.9 环境下的 PyTorch 框架中进行,训练和验证在 NVIDIA GeForce GTX 2080Ti GPU 上完成。

分级模型的整体性能评估使用准确率(Accuracy)、精确率(Precision)、召回率(Recall)、F1 得分(F1-score)和受试者工作特性(ROC)曲线。为了综合衡量分级模型在不同风险级别上的精确度和召回率,本文使用 F1得分评估每一级溃疡的预测性能。相关指标的计算公式如公式(4)至(7)所示。

2 结果

2.1 对比实验

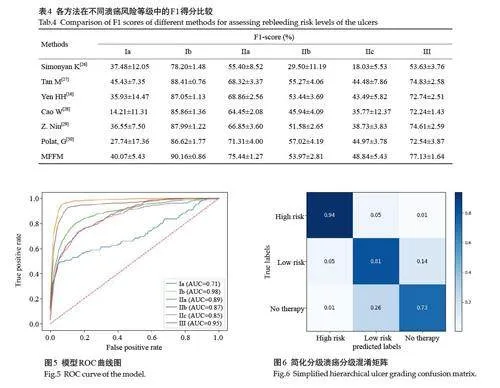

本文系统比较了提出的分级模型与多种先进的分级方法。该模型在准确率(74.94%)、精确率(74.45%)、召回率(74.94%)和F1得分(74.27%)等关键性能指标中表现最优(表3)。与先进的溃疡再出血风险分级的研究相比,提出的模型的准确率提高了5.8%。在六级溃疡的F1 得分中,模型在高风险(Ib、IIa)和无需内镜治疗(III)溃疡的识别能力上具有显著优势。Ib、IIa 和III 级溃疡的F1 得分分别为90.16%、75.44%和77.13%。在Ib 级溃疡的预测中,分级模型取得了90.16%的F1 得分。尽管模型在Ia、IIb和IIc级别的预测性能相对较低,但其F1 得分仍优于其他方法(表4)。ROC曲线(图4)进一步展示了模型在不同风险等级中的表现。

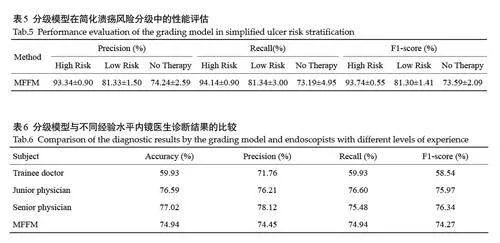

在消化性溃疡的三级风险评估中,分级模型在高风险(Ia、Ib、IIa)、低风险(IIb、IIc)和无需内镜下治疗(III)中的F1得分分别为93.74%、81.30%和73.59%(图5、表5)。模型在高风险溃疡的识别中表现尤为突出,尽管在低风险和无需内镜治疗类别的F1得分略低,但整体分级能力良好。

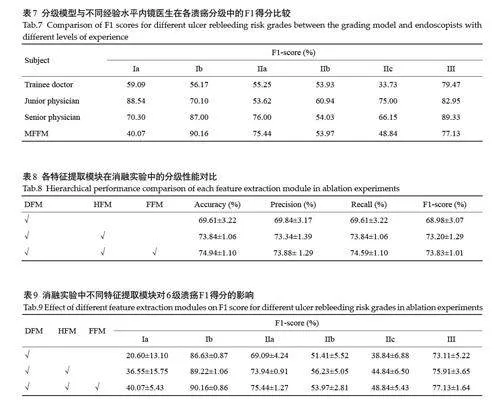

本文将提出的分级模型与3位不同经验水平的内镜医生(进修医生、初级医生和高级医生)的诊断结果进行了对比(表6、7)。高级医生具备5年以上消化内镜实践经验,初级医生具备3年以上经验,进修医生具备约1年的临床实践经验。结果显示,模型的分级性能显著优于进修医生的诊断结果,尤其在高风险溃疡的预测中表现突出(表6)。例如,Ib 的F1 得分从56.17%提升至90.16%,IIa的F1得分提升了20.22%(表7)。此外,模型在整体性能上与初级医生和高级医生的诊断结果相当,在高风险溃疡(Ib、IIa级)的识别中,模型与医生的诊断结果高度一致。

2.2 消融实验

2.2.1 手工特征提取模块的有效性 添加手工特征提取模块后,分级模型在6个溃疡再出血风险级别上的F1得分显著提高。具体而言,Ia级溃疡的F1得分从20.60%提升至40.07%;Ib 级溃疡的F1 得分从86.63%提升至90.16%;IIa级溃疡的F1得分从69.09%提升至75.44%;IIc级溃疡的F1得分从38.84%提升至48.84%。

2.2.2 特征融合模块的有效性 添加特征融合模块后,分级模型的整体准确率从73.84%提升至74.94%(表8),并且在4个溃疡再出血风险级别上均表现出性能提升(表9)。具体而言,Ib级溃疡的F1得分从89.22%提升至90.16%;IIa 级溃疡的F1 得分从73.94%提升至75.44%;IIc级溃疡的F1得分从44.84%提升至48.84%;III级溃疡的F1得分从75.91%提升至77.13%。

3 讨论

出血是消化性溃疡常见的并发症,准确预测溃疡再出血的风险能够帮助医生根据患者的具体情况制定个性化治疗方案,降低再出血的发生率。目前,关于消化性溃疡再出血风险分级的研究[16, 17]主要依赖CNN模型的直接应用。然而,由于CNN在深度特征提取过程中缺乏医学领域知识的指导,得到的特征难以充分表达电子内镜图像中溃疡病变的颜色、外观和形态等关键诊断信息。因此,使用单一深度特征的模型在处理溃疡再出血风险分级时,性能并非最优。针对使用单一深度特征的局限性,现有研究[31, 32]通过结合深度特征与手工提取的视觉特征,形成更具医学语义的特征空间,从而实现更精确的疾病分类。基于这一思路,本文提出了一种融合手工与深度特征的消化性溃疡再出血风险分级模型(MFFM),融合深度特征与手工提取的颜色、纹理和边缘特征。消融实验结果表明,手工特征的引入显著提升了MFFM的特征表达能力,尤其在高风险溃疡的识别上表现出色。

溃疡的颜色变化可以反映其出血状态,活动性出血通常表现为鲜红色或暗红色,而非出血状态则呈现为白色或浅黄色。通过提取颜色特征,MFFM能够有效区分不同的出血状态,这一发现与现有研究一致[20, 22]。在Forrest 数据集上的实验结果表明,融合颜色特征的MFFM在各项性能指标上显著优于经典的溃疡再出血风险分级方法[16, 26, 27],特别是Ib级、IIa级和III级溃疡的F1 得分均显著提升,其中Ib 级溃疡的F1 得分达到了90.16%,高于Yen 等[16]的87.05%,Tan 等[27]的88.41%,Simonyan 等[26]的78.20%。MFFM对高风险溃疡的高精度识别,能够帮助医生迅速识别出血患者,从而及时采取内镜下止血措施,降低再出血风险。

此外,溃疡的表面纹理和边缘特征也是预测溃疡再出血风险的重要因素。活动性出血溃疡通常表现为粗糙、不规则的表面纹理,而愈合中的(II级)和完全愈合的(III级)溃疡则趋于光滑。边缘特征描述了溃疡的轮廓形态,活动性出血溃疡的边缘通常不规则或模糊,而愈合中的溃疡边缘较为清晰。基于多特征融合的设计,MFFM能够在颜色、纹理、边缘3个层面上捕捉更细粒度的溃疡特征,模拟内镜医生的综合判断。在III级溃疡的F1 得分上,MFFM达到了77.13%,显著高于Yen等[16]的72.24%,Tan 等[27]的74.83%,Simonyan 等[26]的53.63%。MFFM的多特征融合方式提升了溃疡风险分级的精准度,符合内镜医生诊断时关注溃疡的颜色变化、表面纹理和边缘形态的经验,为医生理解MFFM的决策过程提供了有力支持。

然而,本文提出的分级模型仍存在一定的局限性。尽管手工特征增强了不同再出血风险级别溃疡的特征表达,然而对于一些相似且复杂的细粒度溃疡,模型仍难以做到精准区分。例如,IIb级溃疡的附着血凝块与IIa级溃疡的裸露血管头在视觉上表现相似,增加了模型的识别难度。而Ia级溃疡的喷射型血柱较细,与Ib级溃疡的弥漫性出血在内镜图像中表现为相似的出血背景,导致模型容易将Ia级溃疡误诊为Ib级溃疡。在面对这些细粒度特征的识别时,未来研究可以通过引入注意力机制来提升模型对关键部位特征的识别能力,从而更好地区分这些难以识别的溃疡等级。此外,数据不平衡问题限制了模型的性能,尤其是在Ia 级、IIb 级和IIc 级溃疡样本数量较少的情况下,这些级别的分级性能表现不够理想。为了缓解此问题,未来可考虑数据增强、重采样方法或使用多中心数据,以增加样本的多样性和数量。

综上所述,本文针对消化性溃疡再出血风险预测任务提出了一种多特征融合模型。实验结果表明,模型实现的各项指标优于现有的先进分级方法,验证了多特征融合在溃疡风险分级中的有效性,该模型不仅能够为进修医生提供重要的诊断支持,还为经验丰富的内镜医生提供有力的辅助诊断参考。

参考文献:

[1] 陈 丽, 常青霞, 陈少銮. 在内镜下治疗消化性溃疡并发上消化道出

血的临床疗效[J]. 中国药物经济学, 2024, 19(6): 67-9, 73.

[2] Wang BL, Yu WT, Zhang ZY, et al. Assessing peptic ulcer risk with

the HAMPROW score in the general Chinese population[J]. Sci

Rep, 2024, 14(1): 4442.

[3] Soldner T, Bakke K, Savage S. Surgical management of upper

gastrointestinal bleeding[J]. Gastrointest Endosc Clin N Am, 2024,

34(2): 301-16.

[4] Vakil N. Endoscopic diagnosis, grading, and treatment of bleeding

peptic ulcer disease[J]. Gastrointest Endosc Clin N Am, 2024, 34

(2): 217-29.

[5] 李兆申. 消化性溃疡出血的Forrest分级与内镜治疗[J]. 中华消化内

镜杂志, 2013, 30(11): 601-3.

[6] 张秀敏, 赵昌东, 李 雪, 等. 基于Forrset分级分层指导内镜下治疗消

化性溃疡出血的临床价值[J]. 中国急救复苏与灾害医学杂志,

2023, 18(3): 362-5.

[7] 付 强. 消化性溃疡出血患者进行内镜下Forrest 分级的临床意义

[J]. 世界最新医学信息文摘, 2017, 17(9): 74.

[8] Chiu PW. Bleeding peptic ulcers: the current management[J]. Dig

Endosc, 2010, 22(Suppl 1): S19-21.

[9] 聂玉强, 李瑜元, 吴惠生, 等. 消化性溃疡出血的FORREST分级及

其与预后关系[J]. 内镜, 1995, 12(1): 3.

[10]Romstad KK, Detlie TE, Søberg T, et al. Treatment and outcome of

gastrointestinal bleeding due to peptic ulcers and erosions - (BLUE

study)[J]. Scand J Gastroenterol, 2022, 57(1): 8-15.

[11]Mackiewicz-Pracka A, Nehring P, Przybyłkowski A. Emergency

endoscopic interventions in acute upper gastrointestinal bleeding: a

cohort study[J]. Diagnostics, 2023, 13(23): 3584.

[12]Yen HH, Wu PY, Wu TL, et al. Forrest classification for bleeding

peptic ulcer: a new look at the old endoscopic classification[J].

Diagnostics, 2022, 12(5): 1066.

[13]Klang E, Barash Y, Levartovsky A, et al. Differentiation between

malignant and benign endoscopic images of gastric ulcers using

deep learning[J]. Clin Exp Gastroenterol, 2021, 14: 155-62.

[14]王智杰, 高 杰, 孟茜茜, 等. 基于深度学习的人工智能技术在早期胃

癌诊断中的应用[J]. 中华消化内镜杂志, 2018, 35(8): 551-6.

[15]黄 丽, 李艳霞, 吴练练, 等. 基于深度学习的良恶性胃溃疡人工智能

辅助诊断系统研究[J]. 中华消化内镜杂志, 2020, 37(7): 476-80.

[16]Yen HH, Wu PY, Su PY, et al. Performance comparison of the deep

learning and the human endoscopist for bleeding peptic ulcer disease

[J]. J. Med. Biol. Eng, 2021, 41(4): 504-13.

[17]Yen HH, Wu PY, Chen MF, et al. Current status and future

perspective of artificial intelligence in the management of peptic

ulcer bleeding: a review of recent literature[J]. J Clin Med, 2021, 10

(16): 3527.

[18]Afonso J, Saraiva MJM, Ferreira JPS, et al. Development of a

convolutional neural network for detection of erosions and ulcers

with distinct bleeding potential in capsule endoscopy[J]. echniques

and Innovations in Gastrointestinal Endoscopy, 2021, 23(4): 291-6.

[19]He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image

recognition[C]//2016 IEEE Conference on Computer Vision and

Pattern Recognition (CVPR). June 27-30, 2016. VegasLas, NV,

USA. IEEE, 2016: 770-8, .

[20]Sunitha S, Sujatha SS. An improved bleeding detection method for

wireless capsule endoscopy (WCE) images based on AlexNet[C]//

2021 3rd International Conference on Signal Processing and

Communication (ICPSC). May 13-14, 2021. Coimbatore, India.

IEEE, 2021: 11-15.

[21]Sainju S, Bui FM, Wahid K. Bleeding detection in wireless capsule

endoscopy based on color features from histogram probability[C]//

2013 26th IEEE Canadian Conference on Electrical and Computer

Engineering (CCECE). May 5-8, 2013. Regina, SK, Canada. IEEE,

2013: 1-4.

[22]Dilna C, Gopi VP. A novel method for bleeding detection in Wireless

Capsule Endoscopic images[C]//2015 International Conference on

Computing and Network Communications (CoCoNet). December

16-19, 2015. Trivandrum, India. IEEE, 2015: 854-8.

[23]Yuan YX, Li BP, Meng MQH. Bleeding frame and region detection

in the wireless capsule endoscopy video[J]. IEEE J Biomed Health

Inform, 2016, 20(2): 624-30.

[24]Tuba E, Tomic S, Beko M, et al. Bleeding detection in wireless

capsule endoscopy images using texture and color features[C]//

2018 26th Telecommunications Forum (TELFOR). November 20-

21, 2018. Belgrade. IEEE, 2018: 1-4.

[25]Chen BZ, Li JX, Lu GM, et al. Lesion location attention guided

network for multi-label thoracic disease classification in chest X-rays

[J]. IEEE J Biomed Health Inform, 2020, 24(7): 2016-27.

[26]Simonyan K, Zisserman A. Very deep convolutional networks for

large-scale image recognition[C]// International Conference on

Learning Representations (ICLR). May 7-9, 2015. San Diego, CA,

USA. ICLR, 2015: 1-14.

[27]Tan M, Le Q. EfficientNet: Rethinking Model Scaling for

Convolutional Neural Networks[C]//Proceedings of the 36th

International Conference on Machine Learning (ICML). Jun 9-15,

2019. Long Beach, CA, USA. Proceedings of Machine Learning

Research, 97: 6105-14.

[28]Cao WZ, Mirjalili V, Raschka S. Rank consistent ordinal regression

for neural networks with application to age estimation[J]. Pattern

Recognition Letters, 2020, 140: 325-31.

[29]Niu ZX, Zhou M, Wang L, et al. Ordinal regression with multiple

output CNN for age estimation[C]//2016 IEEE Conference on

Computer Vision and Pattern Recognition (CVPR). June 27-30,

2016. Las Vegas, NV, USA. IEEE, 2016: 4920-8.

[30]Polat G, Ergenc I, Kani HT, et al. Class distance weighted crossentropy

loss for ulcerative colitis severity estimation[C]//Annual

Conference on Medical Image Understanding and Analysis. Cham:

Springer, 2022: 157-71.

[31]Liu TJ, Xie SN, Yu J, et al. Classification of thyroid nodules in

ultrasound images using deep model based transfer learning and

hybrid features[C]//2017 IEEE International Conference on

Acoustics, Speech and Signal Processing (ICASSP). March 5-9,

2017. New Orleans, LA. IEEE, 2017: 919-23.

[32]Xie JH, Guo LH, Zhao CK, et al. A Hybrid Deep Learning and

Handcrafted Features based Approach for Thyroid Nodule

Classification in Ultrasound Images[J]. J Physics ConSer, 2020,

1693(1): 012160.

(编辑:余诗诗)