基于强化学习的变电站设备自适应维护策略

摘 要:本文针对变电站运维成本高企问题,分析了变电站设备的自适应维护策略。系统收集了变电站设备的故障和异常信息,运用Q-learning算法进行迭代学习,使其能够自动化响应并运行相关动作。制定自适应维护策略,并设置奖励曲线鼓励算法,优化其运维方法。结果显示,系统能够稳定形成应对不同状态的最佳动作,其奖励曲线较稳定,大部分奖励集中,少量极值较高,转换矩阵表明在状态转换中,系统多倾向于对异常和故障状态进行维护,对正常状态的操作较少,基本符合运维的正常工作要求。这一结果表明,本文构建的智能维护系统能够有效提高变电站设备的运维管理效率,并降低风险,可为未来优化算法、改进自适应维护系统提供指导。

关键词:强化学习;变电站设备;自适应维护

中图分类号:TM 76 " " " 文献标志码:A

先行研究普遍关注变电站中的维护策略智能化改进。吴志勇[1]研究了变电站电池组的电压监测与维护。李智威等[2]基于改进GM(1,1)模型预测变电站检修运维费用,优化成本拨付策略,提高了预测精度。刘强等[3]设计了基于三维模型的变电站智能辅助控制系统,提高了设备远程监控和智能化防控能力。彭永磊等[4]设计了基于信息融合技术的变电站智能运维和安防系统。熊一等[5]研究了基于改进BP神经网络的变电站检修运维成本预测,提高了预测精准度。钱宇骋等[6]提出基于多源数据分析的变电站状态维护策略优化方法,提高了供电可靠性和经济性。彭志强等[7]开发了智能变电站自动化设备透明运维系统,提高了运维效率和智能告警性能。

1 算法设计

变电站承担转换和分配电力的重要任务,是供电系统中至关重要的组成部分。然而,在设备复杂性、运行环境多变等因素的影响下,传统固定维护策已经无法充分满足设备实际运行需求,存在资源浪费和效率低下等问题。本文旨在探讨基于强化学习技术的变电站设备自适应维护策略,使用Q学习(Q-learning)算法,在与环境的不断交互中执行智能决策,最大限度地提高运营效率,减少故障风险。

变电站设备的状态和运行情况包括设备正常运行、部分故障或完全损坏等。本文使用Q-learning算法构建自适应维护系统,可以根据当前设备状态选择最佳操作,将累计奖励最大化。首先,初始化一个3×33×3的Q表,表示每个状态下每个动作的值。其次,在训练过程中的每一轮迭代中选择一个初始状态。进而根据当前策略选择一个动作,再根据当前的Q表和探索率(epsilon-greedy策略),在一部分情况下以ϵ%的概率随机选择动作;在其他情况下以1-ϵ%的概率并根据Q值选取最佳动作。最后,执行所选的操作,并观察奖励和新的环境状态,进而使用Q-learning更新公式更新当前state-action对应的Q值。

重复上述步骤,直到达到指定次数或者收敛,从训练好的Q表中提取最优策略,并将其应用于设备管理系统。利用可视化工具,例如热图或曲线图来评估算法效果,并进一步调整参数,以优化自适应维护策略。

执行所选操作并观察奖励R和新的环境状态s',使用Q-learning算法更新当前state-action对应的Q值。更新过程如公式(1)所示。

Q(s,a)←(1-α)∙Q(s,a)+α∙(R+γ∙maxα(Q(s',a'))) (1)

式中:Q(s,a)为状态s下执行动作a的预期回报(或价值);α为学习率,可控制新信息相对于旧信息的权重;R为在状态s下执行动作a后获得的即时奖励;γ为折扣因子,用于平衡当前和未来奖励间的重要性;maxα(Q(s',a'))为在新状态s'下选择最优动作a',并计算其对应的最大Q值。

这个更新过程使算法能够根据环境及时进行反馈,并调整其行为,以获得更好的长期回报。采用以上步骤和技术,Q-learning算法能够有效执行基于传感器数据的设备自维护策略,并进行学习和优化,使系统能够根据设备状态和环境变化做出决策,从而提高设备的性能和可靠性。

2 性能测试

为了执行自动化的维护策略,本文利用Q-learning算法,该强化学习方法能够使系统在不断的迭代学习中优化其决策过程。设状态数量为3,动作数量为3,学习率为0.1;控制新信息相对于旧信息的权重;设折扣因子为0.9,以平衡当前和未来奖励间的重要性;设探索率为0.1,以便在训练过程中进行随机探索并发现新策略,设其训练轮数为1 000次。

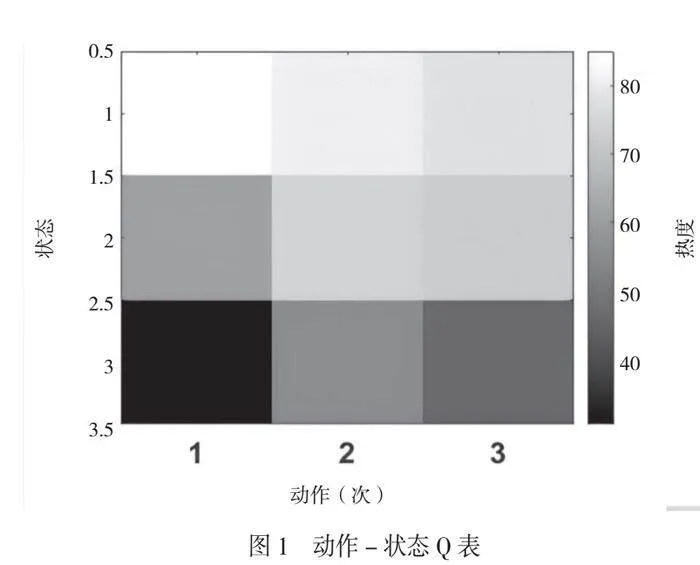

本文将Q表初始化为零矩阵,奖励矩阵R如公式(1)所示。

(2)

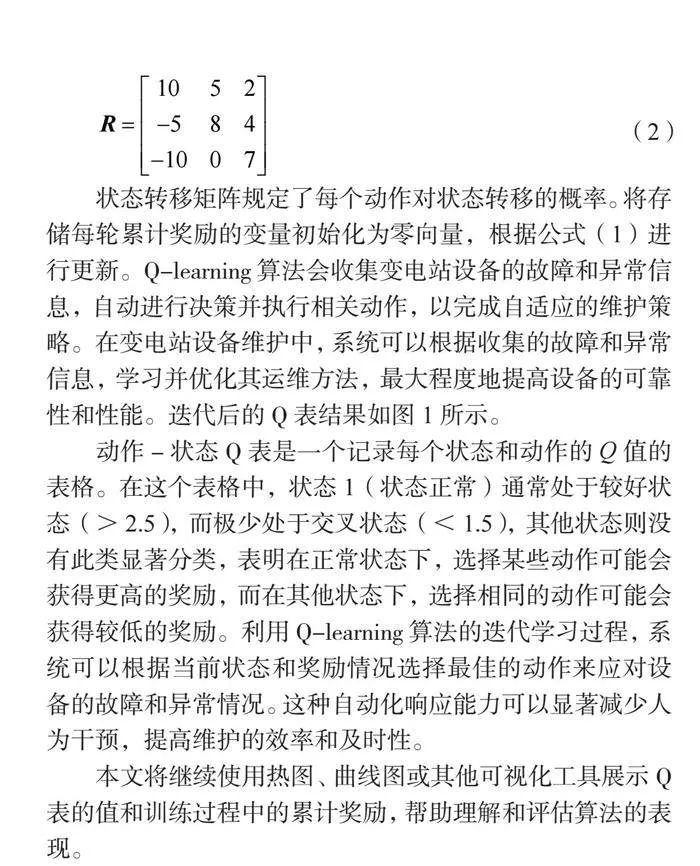

状态转移矩阵规定了每个动作对状态转移的概率。将存储每轮累计奖励的变量初始化为零向量,根据公式(1)进行更新。Q-learning算法会收集变电站设备的故障和异常信息,自动进行决策并执行相关动作,以完成自适应的维护策略。在变电站设备维护中,系统可以根据收集的故障和异常信息,学习并优化其运维方法,最大程度地提高设备的可靠性和性能。迭代后的Q表结果如图1所示。

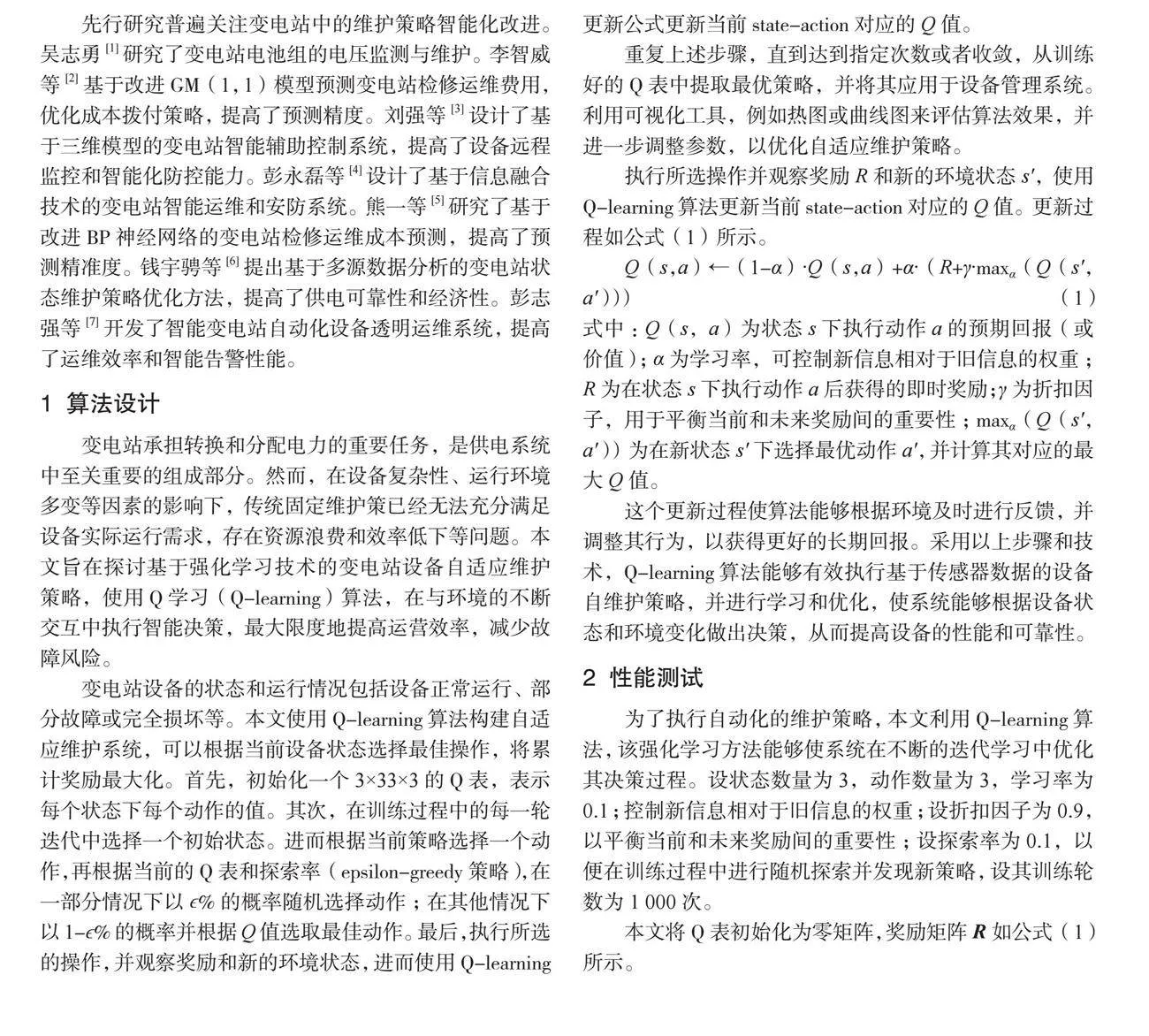

动作-状态Q表是一个记录每个状态和动作的Q值的表格。在这个表格中,状态1(状态正常)通常处于较好状态(>2.5),而极少处于交叉状态(<1.5),其他状态则没有此类显著分类,表明在正常状态下,选择某些动作可能会获得更高的奖励,而在其他状态下,选择相同的动作可能会获得较低的奖励。利用Q-learning算法的迭代学习过程,系统可以根据当前状态和奖励情况选择最佳的动作来应对设备的故障和异常情况。这种自动化响应能力可以显著减少人为干预,提高维护的效率和及时性。

本文将继续使用热图、曲线图或其他可视化工具展示Q表的值和训练过程中的累计奖励,帮助理解和评估算法的表现。

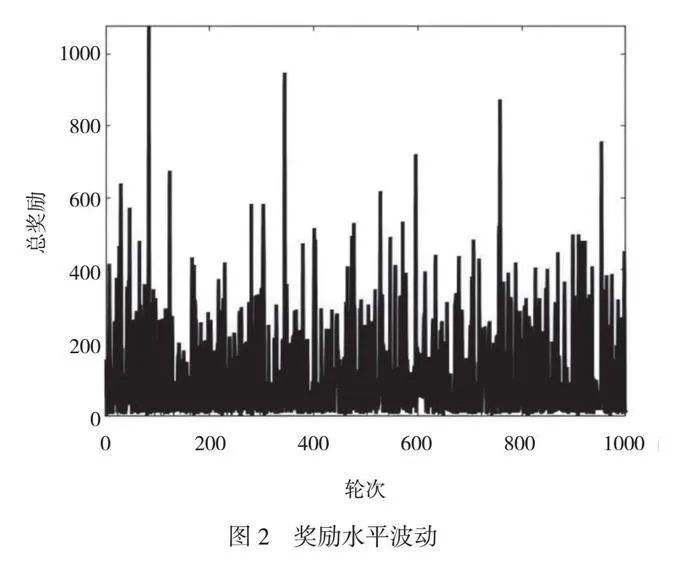

奖励水平波动如图2所示,图2显示了进行1000次迭代后,总奖励水平通常稳定在200~400,并有少数极高值散落分布。这种稳定的总奖励水平表明系统已经学习到一个相对好的策略,在大多数情况下能够获得中等程度的正向反馈(200~400)。而那些极高值表示一些特殊状态或动作组合带来了非常显著的回报。

这种分布形式表明系统对大部分状态和动作都有比较好的理解和应对方式,但是也存在一些使系统获得更高回报的特殊情况。因此,在实际应用中,Q-learning算法的成功运用需要充分考虑变电站设备的特点和运行环境,设计合适的状态空间、动作空间和奖励机制。同时,还需要保证算法的稳定性和收敛性,以提高其在实际场景中的有效性和可靠性。

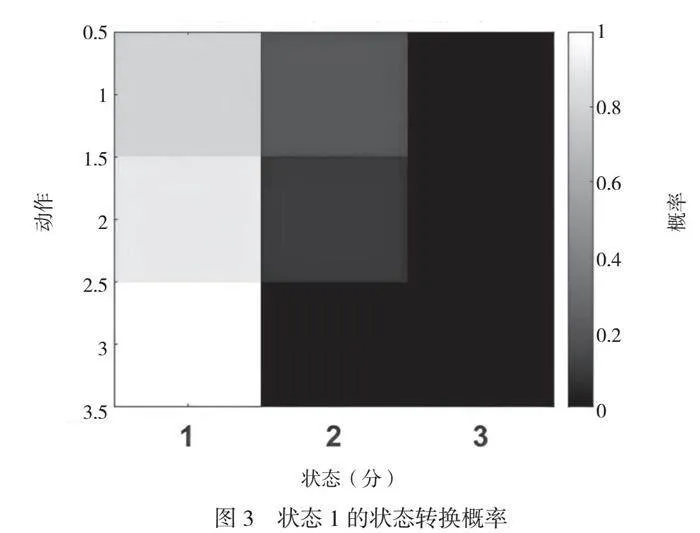

本文整理了不同状态下的状态转换概率,以分析此类实际场景。状态1(状态正常)的状态转换情况如图3所示,表明在少部分情况下状态1会转移到如图4所示的状态2(异常),在大部分情况下状态1会转移到如图5所示的状态3(故障)。这种转换模式可能反映了系统处理状态1过程中的行为模式和决策。状态1通常处于较好状态,但是可能会因为某些特定的状态转移概率而转移到状态3(故障),表明系统在某些条件下无法避免某些设备或组件的故障。在少部分情况下状态1会转移到状态2(异常),表明系统能够对一些不严重的问题或变化做出适当响应,但是这并不是主要的转移路径。

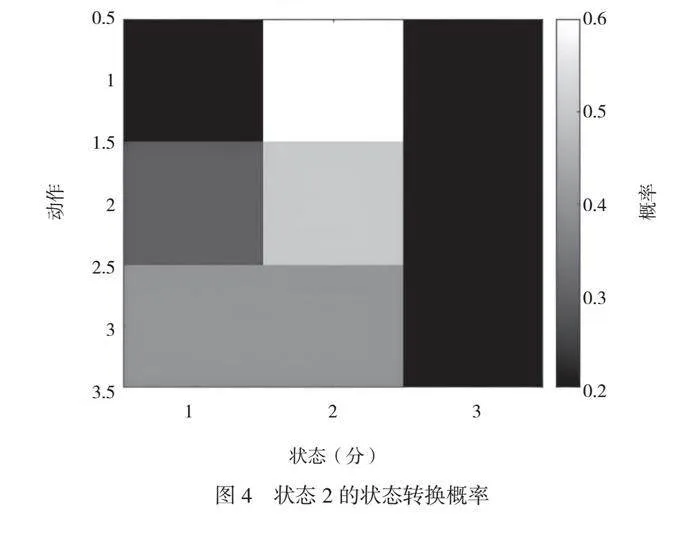

在多数情况下状态2会转移到状态3(故障),而只有少量转移到状态1(正常)。这种模式可能反映了系统在处理异常状态下的设备或组件过程中的行为和决策。当系统检测到某些特定问题或异常时,更倾向于将该设备标记为故障并采取相应措施。这种在多数情况下转移到故障状态的行为表明系统更倾向于保守地对待潜在问题,并快速地将其识别为需要维修或替换的对象。在少数情况下从异常转移到正常的行为表明系统具有一定程度的自我调节和恢复能力,即在某些较小范围内发生问题后能够自动恢复到正常操作模式。

图5显示了在多数情况下状态3会转移到状态1(正常),只有少量转移到状态2(异常)。这种模式可能反映了系统在处理故障或异常设备过程中的行为和策略。当系统检测到某些问题或故障时,它更倾向于将设备标记为正常并采取一些修复措施,以使其恢复到预期操作模式。因此,在大部分情况下,故障设备能够被成功修复,即从故障态回到正常态。少量从故障态转移到异常态的情况表明系统可能无法完全解决某些特定问题或需要进一步观察、调整才能达到稳定运行状态。这种小部分切换可以视为系统对较长时间内存在的潜在风险或不确定性信号做出的响应。

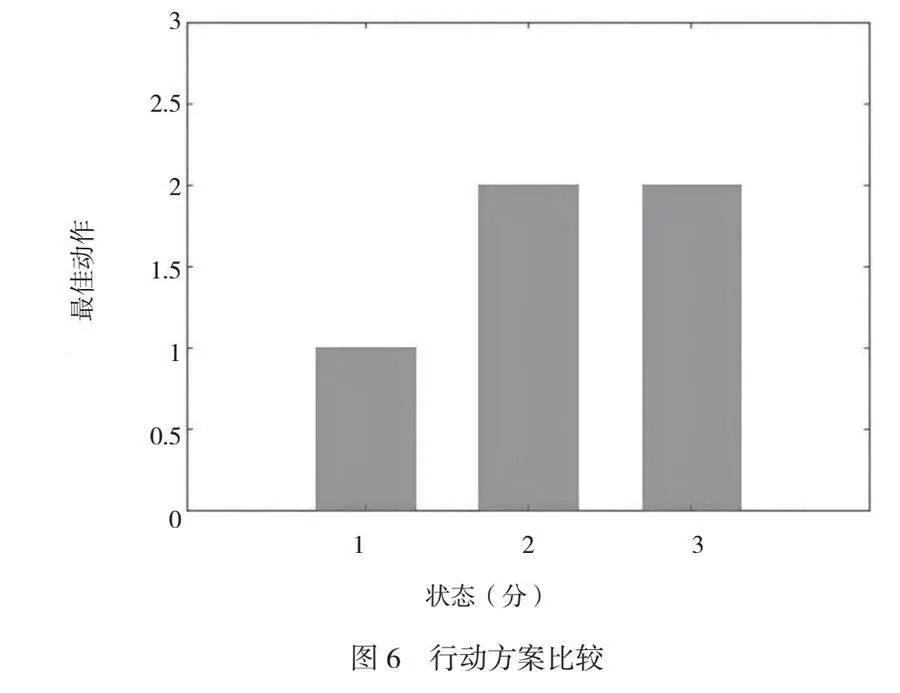

行动方案比较如图6所示。由图6可知,最佳行动主要集中在状态2和状态3,状态1的最佳行动选择较少,这表明系统倾向于在异常和故障状态下采取更积极的维护或修复措施,以使设备恢复正常运行。具体来说,在状态2(异常)情况下,系统可能需要更多干预措施来解决问题,并将设备恢复到正常工作状况,因此在这种情况下,“最佳”的行为策略通常是更密切地监测、诊断和处理潜在问题。同样地,当从状态3(故障)转移到其他态时也需要特别注意。由于系统已经检测到实际故障,可能会影响设备的性能或安全性,因此采取正确的维护步骤尤为重要。优化这些情形下的操作方案可以提高系统整体效率,并保证设备能够快速、有效地恢复正常运转模式。相反,在正常工作条件下(即状态1),由于没有检测到明显问题或异常,因此相应的干预活动并不紧迫或频繁,主要为例行检查、预防性维护等日常任务,以保证系统持续、稳定并可靠地运行。

3 结语

本文提出了基于强化学习(Q-learning)的智能维护系统,有助于变电站更智能、高效和可靠地进行管理与维护。特别是在正常工作条件下(即状态1),相应干预活动通常并不紧迫或频繁;而在异常和故障状态下则需要更积极的维护或修复措施。分析奖励曲线可发现,通常系统总奖励水平能够稳定在一个范围内,并存在少数极高值,表明系统已经学习到一个相对好的策略,在大多数情况下能够获得正向反馈,当出现异常或故障时,需要采用正确操作方案,使设备恢复正常运行。

参考文献

[1]吴志勇.变电站电池组的电压监测与维护[J].电池,2024,54(1):147-148.

[2]李智威,王依燃,张赵阳,等.基于改进GM(1,1)模型的变电站检修运维费用预测[J].电力科学与技术学报,2024,39(1):218-224.

[3]刘强,罗业雄,陈璨,等.基于三维模型的变电站智能辅助控制系统设计[J].科学技术与工程,2023,23(31):13430-13437.

[4]彭永磊,陈岩,张发祥.基于信息融合技术的变电站智能运维及安防系统[J].制造业自动化,2023,45(9):84-88.

[5]熊一,詹智红,柯方超,等.基于改进BP神经网络的变电站检修运维成本预测[J].电力科学与技术学报,2021,36(4):44-52.

[6]钱宇骋,朱太云,甄超,等.基于多源数据分析的变电站状态维护策略优化方法[J].科学技术与工程,2021,21(13):5387-5393.

[7]彭志强,周航,韩禹.智能变电站自动化设备透明运维系统构建与应用[J].电力系统保护与控制,2020,48(13):156-163.