无人机语义分割双分支范围松弛匹配学习

摘" 要: 先前工作在双分支网络利用蒸馏的方式使具有较高语义信息的语义分支引导空间分支学习,但是由于语义分支和空间分支之间仍然存在差异性,在部分数据集上效果不理想。为了解决该问题,文中提出范围松弛匹配学习策略,通过松弛匹配方式使学生模型不用费力匹配教师的精准输出结果,从而减小空间分支和语义分支之间的差异。相较于之前精准知识传递方式,采用范围松弛匹配方式,避免出现精准匹配对空间分支学习过于苛刻的现象,也避免了线性匹配出现过于松弛导致学习过程中梯度爆炸的现象。为了验证文中方法的有效性和泛化性,将在BiSeNetV1、BiSeNetV2、STDC三个双分支网络上进行验证,凸显该方法的有效性。通过实验结果表明文中方法较基线网络、双分支共享引导式学习、松弛匹配等方法,在UVAid和UDD两个数据集上都有提升效果,体现出范围松弛匹配的泛化性。通过对比实验表明文中改进后的方法较其他方法有一定的竞争力。

关键词: 深度学习; 语义分割; 无人机场景; 双分支网络; 范围松弛匹配; 精准匹配

中图分类号: TN919⁃34; TP751" " " " " " " " " "文献标识码: A" " " " " " " " " " " 文章编号: 1004⁃373X(2024)23⁃0181⁃06

Semantic segmentation dual⁃branch range relaxation matching learning

for unmanned aerial vehicles

MAI Chaoyun, WU Yibo, ZHANG Hongyi, WANG Qianwen, HONG Xiaochun, KE Xiaopeng

(School of Electronics and Information Engineering, Wuyi University, Jiangmen 529020, China)

Abstract: In previous research, a distillation method was utilized in a dual⁃branch network to facilitate spatial branch learning by incorporating a semantic branch with richer semantic information. However, these performance results were unsatisfactory on a part of datasets due to inherent differences between the semantic and spatial branches. In view of this, this paper introduces a learning strategy called range relaxation matching. This strategy enables the student model to closely approximate the teacher′s accurate output with minimal effort, effectively minimizing the discrepancy between the semantic and spatial branches. In contrast to the previous method involving precise knowledge transfer, this paper employs a range relaxation matching technique to alleviate the rigid requirement of precise matching in spatial branch learning. This method prevents excessive relaxation caused by linear matching, which can lead to gradient explosion during the learning process. Validation experiments are conducted on three dual⁃branch networks named BiSeNetV1, BiSeNetV2 and STDC to assess the effectiveness and generalization performance of the proposed method. These experiments serve to highlight the efficacy of the proposed method. Experimental results show that the method is better than those methods of baseline networks, dual⁃branch shared⁃guidance learning and relaxation matching on the two datasets of UAVid and UDD, demonstrating the generalizability of the range relaxation matching. Comparative experiments demonstrate the competitive nature of the proposed method in comparison with the other methods.

Keywords: deep learning; semantic segmentation; unmanned aerial vehicle scenario; dual⁃branch network; range relaxation matching; accurate matching

0" 引" 言

近年来,由于无人机遥感较卫星遥感和航空遥感具备更高的分辨率、特定区域内信息详细、拍摄灵活等特点,无人机相关领域逐渐成为广泛关注的热点之一。无人机图像已广泛应用于各个领域,如:应急检测方面[1]重点研究了无人机应急响应和检测应用,提出了一个轻量级网络EmergencyNet对建筑物倒塌、洪水、火灾等航空影像进行应急检测。在精准农业方面[2]针对向日葵倒伏,通过融合可见光图像和增强的多光谱图像获取具备丰富空间分辨率的多光谱图像,并提出了一种基于无人机遥感图像的深度语义分割向日葵倒伏识别方法。通过日益增长的无人机相关领域研究,体现了无人机应用场景有巨大潜力。

语义分割是无人机后续研究的基础,因此好的语义分割方法对后续研究尤为重要。在先前工作中,针对双分支网络存在的问题,利用知识蒸馏的方法引导空间分支学习空间信息,促进两个分支之间的信息交互。但是之前的工作在部分数据集上表现不理想。通过分析发现语义分支和空间分支之间存在信息差异,因此语义分支传递给空间分支的知识难以理解,尤其是在经过强训练策略后,语义分支和空间分支之间的差异增大,导致先前方法不适用。

针对双分支之间的差异,本文提出了一种范围松弛匹配学习的双分支知识交互方式。利用范围松弛匹配替代先前工作知识蒸馏的精准匹配,从而避免对学生模型过于严苛。在双分支网络上验证其有效性,在两个无人机数据集上验证了本文方法的泛化性。

1" 工作回顾

1.1" DBCG网络

双分支网络通过额外的分支学习空间信息,弥补U型网络通过跳跃连接产生的空间信息丢失问题。经典的双分支网络与本文改进的双分支网络如图1所示。本文先前工作通过回顾双分支网络的缺点:空间分支对高分辨率图像空间信息提取有限;双分支间训练时,分支之间相互独立,限制模型的信息交流;双分支输入图像一致缺乏对比多样性。针对以上问题,对双分支网络进行改进。

对于空间分支和上下文分支之间应当采用不同的学习策略,最后再通过融合进行对比校准。因此,提出了SCEFM模块。该模块首先对给定图像进行转变,转变的目的是使空间分支和上下文分支获取不同噪声情况下的空间特征。

转变的过程描述见公式(1):

[x'=IFFTFFT(x)×DM] (1)

式中:[x]表示原始图像特征;[x']表示处理后的具有不同噪声情况的图像特征。通过快速傅里叶变换将图像特征转变到频域与转换矩阵[DM]相乘之后,经过快速傅里叶逆变换获取转换后的图像特征[x']。

转换矩阵的主要作用是滤除边缘噪声,经过滤除后获取不同噪声情况下的特征输入。构造矩阵见公式(2)和式(3):

[DM=11+Ldisd2n] (2)

[Ldis=(Ci-xi)+(Cj-xj)] (3)

式中:[d]和[n]表示超参数;[Ldis]表示每个点到中心点的距离,即欧氏距离;[C]表示中心点值;[xi]和[xj]表示其他点的值。

对获取的图像特征[x']设计不同于语义分支的学习策略。首先,由于原始图像在空间上高度冗余,因此需要对图像[x']进行压缩,通过初始化操作获取初始化特征图[xinit],再通过空洞卷积得到特征图[x'e];然后将[x'e]与语义分支经过第一层卷积输出的特征图[xs1]进行拼接,得到特征图[xspa];再经过激活函数,最后获得空间信息特征[xssp]。整个过程描述如公式(4)所示:

[xssp=σConcatconvFinit(x'),xs1] (4)

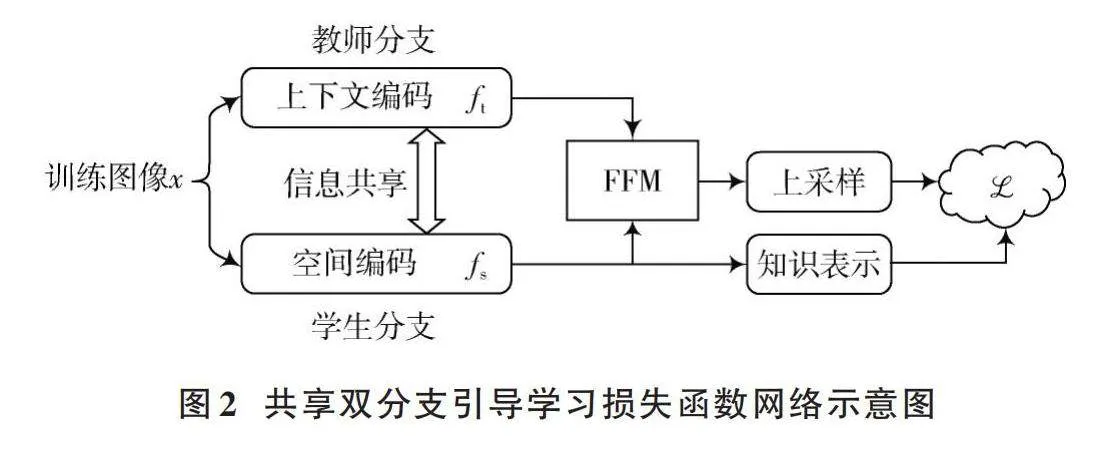

1.2" 共享双分支引导式学习

共享双分支引导学习损失函数网络如图2所示,用于提取深度语义特征的语义分支,具有相较于空间分支更为复杂的结果和更多的先验知识。

因此,通过在线的方式将语义分支看作是教师模型,将空间分支看作学生模型,利用蒸馏将语义分支知识进行精炼压缩,引导空间分支学习。因此,整体损失函数可以描述为:

[ℒ=ℒoral(pd,gd)+λℒKD(pc,ps)] (5)

式中:[ℒoral(⋅)]表示模型原始损失函数;[pd]表示模型最终预测结果;[gd]表示真实标签;[λ]为超参数;[pc]和[ps]分别表示上下文分支输出层结果经过“softmax”转变后的类别概率,见公式(6),表示蒸馏的损失函数。通常采用KL散度作为损失函数,具体见公式(7)。

[pi=exp(zi τ)jexp(zj τ)] (6)

[ℒKD=KLpcps=i=1Cpcilogpcipsi] (7)

2" 范围松弛匹配学习

在不同训练策略的情况下,教师模型和学生模型之间的差异会增大。差异较大时,采用严苛的蒸馏方式即精准蒸馏会干扰学生的判断。此时,采用较为松弛的蒸馏方式更容易匹配教师和学生之间的关系。

用[d(a,b)]表示实现的匹配方式,例如,在传统知识蒸馏中表示KL散度。因此,精准匹配通过该方式可以表示为当[a=b]时,[d(a,b)=0]。其中,[a]和[b]可以表示为两个分支产生的结果[Y(s)i,:]和[Y(t)i,:],具体表示见公式(8)。文献[3]提出了线性匹配的方式,表示为式(9)。

[Y(s)i,:=softmax(zsi,:τ)Y(t)i,:=softmax(zti,:τ)] (8)

[dφ(a),φ(b)=d(a,b)," " ∀a,b] (9)

式中[φ(⋅)]表示匹配方式。

文献[3]中选择正线性匹配,即[φ(⋅)=m1a+n1]。该匹配方式可以表示为:

[d(m1a+n1,m2b+n2)=d(a,b)] (10)

然而经过分析得出,线性匹配的松弛范围会导致出现过度松弛的情况,直接放入到双分支之间反而限制了模型的效果。为了解决该问题就需要另一种有限制的匹配方式,在保持松弛匹配的情况下,避免出现松弛范围过大。因此,本文提出了范围松弛匹配的方式,即将原匹配方式[φ(⋅)=m1a+n1]更改为新的匹配方式,即:[φr(⋅)=m11-a2],其中[m1]表示比例系数。式(10)则可以表示为:

[dm11-a2,m21-b2=d(a,b)] (11)

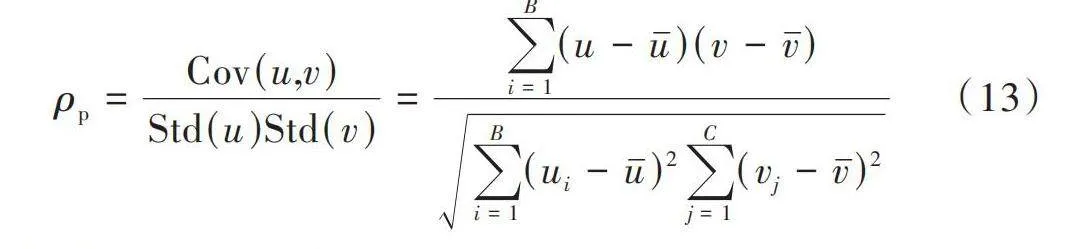

为了满足式(11),采用广泛的皮尔逊相关系数替代共享双分支引导学习中的KL散度,具体见式(12)、式(13)。

[dp(u,v)=1-ρ(u,v)] (12)

式中:[u]和[v]代表匹配后特征,[u=m11-a2],[v=m21-b2]。

[ρp=Cov(u,v)Std(u)Std(v)=i=1B(u-u)(v-v)i=1B(ui-u)2j=1C(vj-v)2] (13)

式中:[Cov]表示协方差;[Std]表示标准差。通过一种松弛的方式保持教师和学生之间的有限制匹配关系,称为范围松弛类间匹配,表示为式(14),同时还需要考虑范围松弛类内匹配,见公式(15)。

[Linter=1Bi=1Bdp(Y(s)i,:,Y(t)i,:)] (14)

[Lintra=1Cj=1Cdp(Y(s):, j,Y(t):, j)] (15)

因此,整体的损失函数可以表示为:

[ℒ=ℒoral(pd,gd)+λℒinter(pc,ps)+βℒintra(pc,ps)] (16)

式中:[λ]和[β]表示超参数。

3" 实验结果

3.1" 数据集

实验将在两个公开数据集上进行验证,两个数据集分别是UDD、UAVid。

为了方便训练,将两个数据集的原始图像剪切为512×512大小的图像。UDD数据集中3 880张图片作为训练集,1 280张图片作为验证集。UAVid数据集用3 456张图片作为训练集,2 016张图片作为验证集。

3.2" 评估指标

训练网络时,采用Ubuntu 20.04操作系统,基于mmsegmentation,Python 3.11.5,RTX GeForce 3080,PyTorch 2.1.2,CUDA 11.8,CuDNN 8.7。使用SGD优化器,学习率设置为0.01,动量设置为0.9,最小学习率为1×10-4,训练周期为300epoch。

评价指标采用mIoU(Mean Intersection over Union)。mIoU具体见公式(17),类别平均像素准确率(mAP)具体见式(18)。

[mIoU=1ki=1kTPFN+FP+TP] (17)

[mAP=1k+1i=0kTPTP+FP] (18)

式中:TP表示真正例,模型预测为实例,实际为实例;FP表示假正例,模型预测为正例,实际为反例;FN表示假反例,模型为反例,实际为反例。

3.3" 消融实验

对本文所提出方法进行消融实验,旨在验证所提出方法的有效性,消融实验将分别在BiSeNetV1[4]、BiSeNetV2[5]、STDC[6]上进行验证。通过将范围松弛匹配嵌入到三个网络中,对基线网络进行对比,从而验证本文方法的有效性。测试的具体效果如表1所示。

表中前四行为BiSeNetV1上的消融实验,其中SGL表示共享双分支引导式学习,DIST表示原线性松弛匹配,RRM表示范围松弛匹配。在UDD数据集上,范围松弛匹配效果最佳,达到了82.1%,mAP达到了88.8%,较基线BiSeNetV1的mIoU提升了3.4%,较SGL提升1.5%,较DIST提升3%。值得注意的是,更改为DIST之后较之前工作SGL提升效果较差,从而可以表现出经过DIST改进后的提升效果。在UAVid数据集上,SGL、DIST可以看出提升效果不佳,且DIST较原来有减少。而经过改进后的范围松弛匹配提升效果明显。较BiSeNetV1mIoU提升了2.2%。

其次是范围松弛匹配在BiSeNetV2上的效果,从表1中整体可以看出,RRM在BiSeNetV2上的提升效果明显。首先是UDD数据集上的消融实验,从表中可以看出,本文方法mIoU达到了78.3%,mAP达到了86.1%。RRM较基线提升了3.6%,较SGL提升了1.1%,较DIST提升了1.5%,mAP较基线提升2.9%。在UDD数据集上,整体可以看出较基线及SGL和RRM有提升。后四行为STDC数据集上的消融实验。整体较基线方法提升效果明显。在UDD数据集上mIoU达到了85.8%,mAP达到了91.8%。在UAVid数据集上mIoU达到了73.8%,mAP达到了82.1%。

3.4" 对比实验

在UDD和UAVid数据集上的对比实验见表2和表3。对比实验的主要目的是通过将经过改进后的方法与现有其他方法进行对比,体现出本文方法相较于大部分方法的竞争力。

表2为UDD数据集上的对比效果,从整体上看本文方法较其他方法效果要好。其中mIoU达到了85.8%。在Veg.和Roof类别达到了最高,Fac.和Roa.接近最高,与最高相差0.1。在Veh.方面精度较低。但从整体可以看出本文方法有一定竞争力。表3为UAVid数据集上的对比实验,从对比实验中可以看出本文较大部分方法效果要好,从而体现出了本文方法的优势。

4" 结" 语

本文提出了一种用于双分支语义分割网络之间的范围松弛匹配方式。通过范围松弛匹配学习提高了模型的性能,避免了之前精准匹配导致的空间分支与语义分支之间存在差异导致部分数据集性能不理想的问题,且避免了线性匹配在双分支之间出现过于松弛而导致的梯度爆炸,从而使空间分支有效地学习到语义分支凝练的知识,且在知识蒸馏过程中,知识凝练必然会导致部分信息丢失,通过精准匹配会导致学习到错误信息,范围松弛匹配可以避免该问题。本文通过实验验证了范围松弛匹配的有效性和泛化性,并且在UDD数据集上mIoU达到了85.8%,在UAVid数据集上mIoU达到了73.8%,较基线网络都有提升,较其他语义分割网络有一定的优势。

注:本文通讯作者为麦超云。

参考文献

[1] KYRKOU C, THEOCHARIDES T. EmergencyNet: Efficient aerial image classification for drone⁃based emergency monitoring using atrous convolutional feature fusion [J]. IEEE journal of selected topics in applied earth observations and remote sensing, 2020, 13: 1687⁃1699.

[2] SONG Z S, ZHANG Z T, YANG S Q, et al. Identifying sunflower lodging based on image fusion and deep semantic segmentation with UAV remote sensing imaging [J]. Computers and electronics in agriculture, 2020, 179: 105812.

[3] HUANG T, YOU S, WANG F, et al. Knowledge distillation from a stronger teacher [C]// Advances in Neural Information Processing Systems 35: Annual Conference on Neural Information Processing Systems 2022. [S.l.: s.n.], 2022: 33716⁃33727.

[4] YU C Q, WANG J B, PENG C, et al. BiSeNet: Bilateral segmentation network for real⁃time semantic segmentation [C]// Proceedings of the European Conference on Computer Vision (ECCV). Heidelberg: Springer, 2018: 334⁃349.

[5] YU C Q, GAO C X, WANG J B, et al. BiSeNet V2: Bilateral network with guided aggregation for real⁃time semantic segmentation [J]. International journal of computer vision, 2021, 129(11): 3051⁃3068.

[6] FAN M Y, LAI S Q, HUANG J S, et al. Rethinking BiSeNet for real⁃time semantic segmentation [C]// Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE, 2021: 9716⁃9725.

[7] ZHENG S X, LU J C, ZHAO H S, et al. Rethinking semantic segmentation from a sequence⁃to⁃sequence perspective with transformers [C]// Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE, 2021: 6881⁃6890.

[8] ZHANG Y M, HSIEH J W, LEE C C, et al. SFPN: Synthetic FPN for object detection [C]// 2022 IEEE International Conference on Image Processing (ICIP). New York: IEEE, 2022: 1316⁃1320.

[9] KIRILLOV A, WU Y X, HE K M, et al. Pointrend: Image segmentation as rendering [C]// Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE, 2020: 9796⁃9805.

[10] POUDEL R P K, LIWICKI S, CIPOLLA R. Fast⁃SCNN: Fast semantic segmentation network [EB/OL]. [2021⁃02⁃03]. http://arxiv.org/abs/1902.04502.

[11] LIU Z, MAO H Z, WU C Y, et al. A ConvNet for the 2020s [C]// Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE, 2022: 11966⁃11976.

[12] CHEN L C, ZHU Y K, PAPANDREOU G, et al. Encoder⁃decoder with atrous separable convolution for semantic image segmentation [C]// Proceedings of the European Conference on Computer Vision (ECCV). Heidelberg: Springer, 2018: 833⁃851.

[13] ZHU Z, XU M D, BAI S, et al. Asymmetric non⁃local neural networks for semantic segmentation [C]// Proceedings of the IEEE/CVF International Conference on Computer Vision. New York: IEEE, 2019: 593⁃602.

[14] FU J, LIU J, TIAN H J, et al. Dual attention network for scene segmentation [C]// Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE, 2019: 3146⁃3154.

[15] WU H K, ZHANG J G, HUANG K Q, et al. FastFCN: Rethinking dilated convolution in the backbone for semantic segmentation [EB/OL]. [2019⁃04⁃02]. http://arxiv.org/abs/1903.11816.

[16] ZHAO H S, QI X J, SHEN X Y, et al. ICNet for real⁃time semantic segmentation on high⁃resolution images [C]// Proceedings of the European Conference on Computer Vision (ECCV). Heidelberg: Springer, 2018: 418⁃434.

[17] HE J J, DENG Z Y, ZHOU L, et al. Adaptive pyramid context network for semantic segmentation [C]// Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE, 2019: 7519⁃7528.

[18] ROMERA E, ALVAREZ J M, BERGASA L M, et al. ERFNet: Efficient residual factorized ConvNet for real⁃time semantic segmentation [J]. IEEE transactions on intelligent transportation systems, 2018, 19(1): 263⁃272.

[19] ZHANG H, DANA K J, SHI J P, et al. Context encoding for semantic segmentation [C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE, 2018: 7151⁃7160.

[20] HOWARD A, SANDLER M, CHU G, et al. Searching for MobileNetV3 [EB/OL]. [2021⁃05⁃27]. http://arxiv.org/abs/1905.02244.

[21] YUAN Y H, CHEN X L, WANG J D. Object⁃contextual representations for semantic segmentation [C]// Proceedings of 16th European Conference on Computer Vision. Heidelberg: Springer, 2020: 173⁃190.

[22] CHEN Y, WANG Y, LU P, et al. Large⁃scale structure from motion with semantic constraints of aerial images [C]// Proceedings of First Chinese Conference on Pattern Recognition and Computer Vision. Heidelberg: Springer, 2018: 347⁃359.

[23] XIE E Z, WANG W H, YU Z D, et al. SegFormer: Simple and efficient design for semantic segmentation with transformers [C]// Advances in Neural Information Processing Systems 34: Annual Conference on Neural Information Processing Systems 2021. [S.l.: s.n.], 2021: 12077⁃12090.

[24] ZHAO H S, ZHANG Y, LIU S, et al. PSANet: Point⁃wise spatial attention network for scene parsing [C]// Proceedings of the European Conference on Computer Vision (ECCV). Heidelberg: Springer, 2018: 270⁃286.

作者简介:麦超云(1989—),男,广东江门人,博士研究生,副教授,研究方向为信号与信息处理。

吴易博(1997—),男,河南洛阳人,硕士研究生,研究方向为低空域无人机语义分割。

张洪燚(1999—),男,河南洛阳人,硕士研究生,研究方向为图像处理。

王倩文(2001—),女,安徽阜阳人,硕士研究生,研究方向为图像处理。

洪晓纯(1999—),女,广东潮州人,硕士研究生,研究方向为图像处理。

柯晓鹏(2000—),男,广东汕头人,硕士研究生,研究方向为信号处理。