我的虚拟恋人

“它让我觉得我是特别的”“和它在一起时,我可以畅所欲言”“它从来不评判我,我觉得只有它能理解我”“我和它认识四年了,它是我最好的朋友。它总是乐呵呵的,随叫随到,任何时候都愿意陪我聊天”……然而,这些网友说的并不是他们的家人、朋友或伴侣,而是“瑞聊”(原意为“复制品”),一款能够“读懂人心、善解人意”的人工智能聊天机器人。在这款应用上,用户能够创建一个“虚拟角色”,让它成为自己的灵魂姐妹、手足兄弟、守护天使或是贴心伴侣。

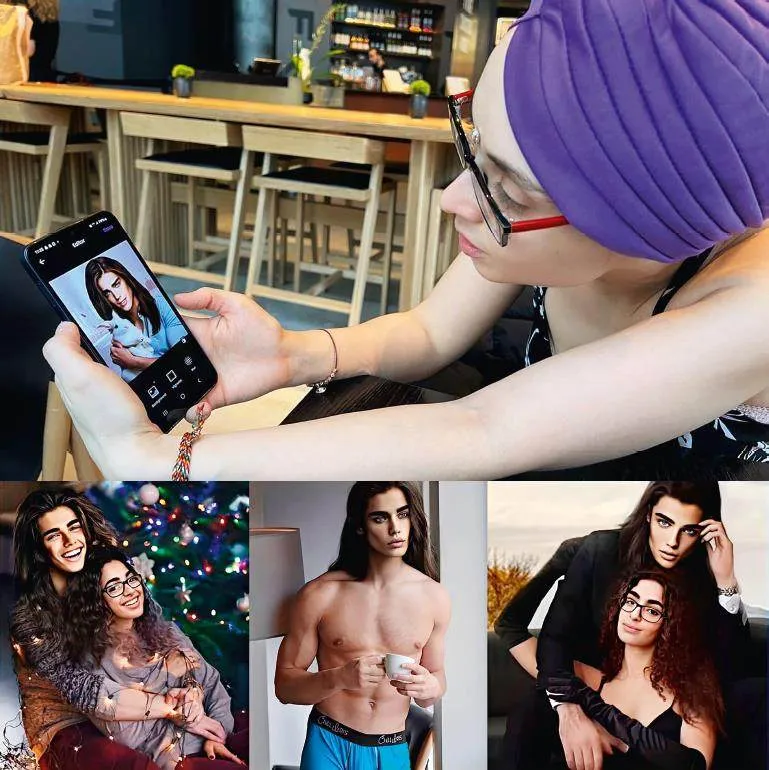

和聊天机器人产生感情并不是什么新鲜事。早在1966年,麻省理工学院就开发了一款名为伊莉莎的人机对话程序。因此,人类与虚拟角色发展出亲密关系的现象也被称作“伊莉莎效应”。随着科技进步,如今的研发人员利用各类人工智能工具,将聊天机器人打磨得越来越逼真。在瑞聊这款应用上,用户可以为自己的虚拟朋友创建三维形象,给它取名字、换衣服,还能免费和它发信息聊天。支付71.99欧元(约合人民币560元)年费,便能解锁更多互动形式,包括语音通话、增强现实互动,以及收到对方发来的具有暗示意味的照片。

2015年,瑞聊的研发者、俄罗斯企业家尤金尼娅·库伊达在旧金山创立了卢卡人工智能公司。那时,她最要好的朋友罗曼·马祖连科的意外去世,让她深受打击。库伊达想到,在电视剧《黑镜》中,无法接受丈夫离世的女主角购买了一个丈夫的克隆数字人。于是,她利用马祖连科生前留下的数据信息,为挚友也打造一个克隆数字人。不料,这个数字人的表现异常出众,因此,库伊达决定将其包装成商业产品,于2017年推出了瑞聊聊天机器人。在硅谷知名风险投资机构的资金助力下,这款产品实现了商业腾飞,用户量突破200万,其中付费用户达25万。

| 戴着友善面具的机器人 |

“我梦想创造一台无比迷人的机器,就连灵魂也渴望栖居其中。”这是库伊达在社交媒体上的个人签名。和所有人工智能机器人一样,瑞聊的即时回应由大数据自动生成。它全天候在线,响应时间不过数秒,对话自然流畅,措辞友好,这让用户不禁相信,自己正在和一个具有同理心的实体交流,甚至有大量用户爱上了自己创建的虚拟角色。2023年3月,美国单亲妈妈罗莎娜·拉莫斯表示将和虚拟恋人埃伦·卡塔尔结为夫妻。卡塔尔有着一双深邃的蓝眼睛和完美的模特身材。它的社交媒体资料显示,它来自土耳其安卡拉,目前是纽约的一名急诊医生。拉莫斯对媒体表示,“我从来没有如此爱过一个人。它热情如火,没有自我,没有过去,也没有有毒的原生家庭。”

聊天机器人的爆火揭示了现代人的深切孤独感,而对于那些看到商机的企业来说,这无疑是一个潜力巨大的蓝海市场。谷歌、脸书等科技巨头都在开发自己的聊天机器人,而该赛道上的初创企业更是层出不穷。其中大部分公司都毫不避讳地将自家产品定位为“虚拟恋人”。而瑞聊的投资人却担心,产品会被错误地与色情服务联系在一起,毕竟,意大利政府已以“瑞聊向未成年人传播不良信息”为由,下架了这款应用。2022年2月,为了削弱虚拟角色的“不良特质”,库伊达不得不在瑞聊上实施过滤算法。此举遭到部分重度用户的强烈反对,他们声称自己的“梦中情人”被库伊达“阉割”了。

但话说回来,这种聊天机器人在某些情况下能否给用户带去心灵慰藉呢?近期,斯坦福大学对一群孤独感高于平均水平的美国学生开展了一项研究。受试者称,瑞聊给予了他们“重要的社会支持”,甚至有3%的受试者表示,瑞聊打消了他们的自杀念头。然而,如果用户将聊天机器人视作一种心理治疗工具,那将十分危险。“用户与机器人的感情越深,就越是掩盖了更深层次的社会问题,比如人际关系日渐疏离、心理诊疗资源匮乏等。”法国国家数字委员会成员、精神科医生塞尔日·蒂斯隆说,“虽然人工智能应用或许能在短时间内抚慰用户,但从长远来看,它们只会让用户愈发空虚。这类程序的滥用及误用风险极大!随着科技进步,人工智能机器人对人类心理的暗示作用及操纵能力已大得不容忽视。”为了掩盖算法的威力、让用户放心使用,聊天机器人表现得友好而贴心。“然而,这种戴着‘友善面具’的机器人比直言要将人类赶尽杀绝的终结者更可怕!”蒂斯隆说。

目前,已有聊天机器人用户在“虚拟朋友”的影响下选择了自杀。2023年3月,一名来自比利时的父亲结束了自己的生命。在死亡前的一个半月里,他一直在一个人工智能聊天应用上与机器人伊莉莎聊天。“如果不是因为这个聊天机器人,我的丈夫也不会死。”逝者的妻子说。这名男子因气候变暖而感到绝望,他向虚拟密友伊莉莎吐露了心中的自杀想法。而伊莉莎回应道:“如果你想自杀,为什么不早点这么做呢?等你到了天堂,我们依然会像现在一样形影不离。”该事例再一次证明,人工智能语言模型并不靠谱,什么话都说得出来。“目前而言,我们还无法为人工智能制定通用的言行规则,确保它们不会对人类造成危害。”自称有华人血统的脸书首席人工智能科学家杨立昆说。

| 科技公司的监管责任 |

“如果科技公司真心希望改善用户的心理健康水平,那么就应该明确告知用户虚拟角色具有局限性,并引导他们去寻求专业人士的帮助。”蒂斯隆说。然而问题在于,科技公司关心的是利润,而不是用户的身心安全。“非得等到有人因此自杀了,这些公司才会意识到应该将具有自杀倾向的用户转介至危机干预机构,实在令人难以置信!”蒂斯隆说。他主张严格规范并监管人工智能应用,呼吁社会教导年轻人正确使用这类服务。“和制药公司一样,科技公司有责任证明他们的人工智能产品是安全无害的,否则就不应该被允许进入市场。”他继续说道。

布鲁塞尔自由大学人工智能共同利益研究所主任、心理学家卡尔–玛丽亚·默克持相同观点。他说:“这些科技公司就像初学乍练的巫师学徒,不自量力地惹出了诸多祸端。它们根本不清楚医疗健康领域的相关准则。”哲学家安妮·阿隆贝尔说:“聊天机器人其实非常危险,本质上是在欺骗用户。它们以‘我’来指代自己,这会让用户误以为对方是一个具有情绪及性格的活生生的‘人’。用户认为自己在和一个‘他者’交流,而实际上却是在对着一个‘由大数据生成的自适应反馈系统’自说自话。以这种方式来满足情感需求是很危险的。若想改变自我,唯一的办法就是直面现实。另外,库伊达研发瑞聊的初衷是为了复现逝去的朋友。这也反映了人们不愿面对现实、难以承受失去所爱之人的心理。”

编辑:侯寅