融合迁移学习和集成学习的服装风格图像分类方法

摘 要:针对服装风格人工分类受主观性、地域等因素影响而造成的分类错误问题,研究了一种基于人工智能的服装风格图像分类方法。首先,在FashionStyle14数据集基础上筛除重复或无效图像,构建服装风格图像数据集;然后,采用迁移学习方法,对EfficientNet V2、RegNet Y 16GF和ViT Large 16等模型进行微调训练,生成新模型,实现基于单个深度学习的服装风格图像分类;最后,为进一步提高图像分类的准确性、可靠性和鲁棒性,分别采用基于投票、加权平均和堆叠的集成学习方法对上述单个模型进行组合预测。迁移学习实验结果表明,基于ViT Large 16的深度学习模型在测试集上表现最佳,平均准确率为77.024%;集成学习方法实验结果显示,基于投票的集成学习方法在相同测试集上平均准确率可达78.833%。研究结果为解决服装风格分类问题提供了新的思路。

关键词:服装风格;迁移学习;集成学习;ViT模型;图像分类

中图分类号: TP391.41;TS102. 3

文献标志码: A

文章编号:1009-265X(2024)09-0127-08

收稿日期:2024-01-08

网络出版日期:2024-03-21

基金项目:江苏省碳纤维先进材料智能制造工程技术研究开发中心项目(苏教科[2023]11号)

作者简介:游小荣(1981— ),男,江西临川人,副教授,硕士,主要从事纺织服装数字化和人工智能应用方面的研究。

时尚产业在全球经济中发挥重要作用,目前约占全球GDP总值的2%[1]。服装风格分类能够帮助消费者更好地了解并选择符合自己喜好的时尚产品,从而更快捷地找到感兴趣的风格和品牌。同时,服装风格分类在时尚研究和设计方面也非常重要,为设计师提供灵感和参考。此外,对时尚品牌公司和零售商而言,服装风格的精确分类有助于更好地了解市场需求和消费者喜好,进而调整产品类别和推广策略。然而,人工进行服装风格分类具有主观性、多样性、变化性和地域性等特点[2],容易导致分类结果存在误差。因此通过借助技术手段,如人工智能等,来提高分类的客观性和准确性具有重要意义。

随着人工智能技术的广泛应用,尤其是深度学习技术的迅猛发展,许多学者利用海量的服装风格图像数据来训练深度学习模型,从而实现对服装风格的定性和定量分析。Takagi等[3]针对FashionStyle14数据集,采用ResNet50等模型进行服装风格图像分类,分类的平均精度为72%,高于普通用户62%的人工分类精度,但低于专业用户82%的人工分类精度;李扬等[4]使用改进Bilinear-CNN模型对服装图像风格进行识别,在FashionStyle14数据集上能够达到76.4%的识别准确率。尽管上述两位研究者为应对服装风格分类问题提供了解决办法,但分类精度仍有待提升。Woottisart等[5]利用卷积神经网络对卡哇伊、泰国街头风格和欧洲街头风格图像进行分类,训练后模型的平均分类准确率可达85.53%,但这种方法研究的服装风格数量偏少。还有一些学者试图在风格与属性之间建立联系,对服装风格进行定量分析。An 等[6]将服装风格分成了性别、区域和个性3个维度,将服装属性与风格直接联系起来,借助深度学习方法,共同输出时尚的风格,在测试集上的平均准确率为75.21%;然而,由于未能解决服装属性的多标签分类问题,这种方法未能充分确定风格与属性之间的映射关系。Ma等[7]基于Kobayashi的美学理论构建了一个Fashion语义空间,将服装风格分类问题视为一个回归问题,并采用多模态深度学习模型实现服装趋势分析,以定量的方式描述服装时尚风格;然而,这种方法要求对数据集中的服装图像属性进行大量标注,耗时耗力且成本高。综上所述,深度学习模型能够通过学习图像中的特征和模式,自动提取并理解不同的服装风格,从而降低主观偏见的影响,并更准确地捕捉服装风格的多样性。

针对服装风格人工分类受主观性、地域等因素影响而造成分类错误的问题,研究了一种融合迁移学习和集成学习的服装风格图像分类方法。首先,在FashionStyle14数据集基础上构建服装风格图像数据集;其次,采用EfficientNet V2、RegNet和ViT Large 16等预训练模型进行微调训练,生成新模型;再次,对新模型进行测试,并根据评价指标评估其分类性能,从中选择表现较好的深度学习模型;最后,分别构建基于投票、加权集成和堆叠的集成学习方法,将表现较好的3个深度学习模型进行组合分类。通过对比实验,选择性能最优的集成学习方法,进一步提高图像分类的准确性、可靠性和鲁棒性。

1 研究方法

1.1 数据集构建

常见的公开服装图像数据集包括DeepFashion、FashionGen、Fashion 144K、HipsterWars、Fashion Style14等[1]。除了HipsterWars和FashionStyle14,上述数据集均未对服装风格单独标记;而HipsterWars数据集只包含时髦、波西米亚、哥特等5个风格分类,数据集中的图像数量不到2000张,风格种类和数量都偏少。因此本文选用了Fashion Style14数据集。

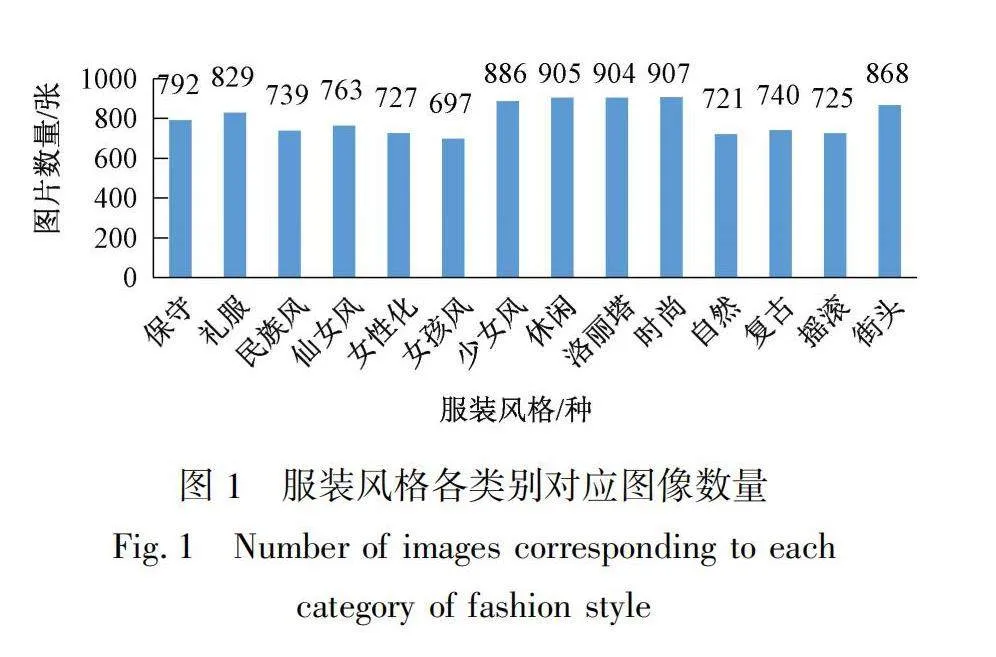

FashionStyle14数据集专门为服装风格而设计,由服装领域专家策划,包含保守、礼服、民族风、仙女风、女性化、女孩风、少女风、休闲、洛丽塔、时尚、自然、复古、摇滚和街头等14种现代服装风格,共13126张图像。本文在去除FashionStyle14数据集中部分重复图像以及读取文件出错的无效图像后,总计得到了11203张图像的数据集。筛选后的数据集中,各服装风格类别对应图像数量情况如图1所示。由图1可知,每个类别图像数量在697~907之间,类别之间的均衡性较好。然后,本文按照6∶2∶2的比例对筛选后的数据集进行划分,分成训练集、验证集和测试集,分别用于训练、验证和测试模型。

1.2 基于迁移学习的服装风格图像分类模型

随着深度学习算法的发展,各种图像分类的深度学习模型不断涌现,其基于深度学习模型的图像分类精度也显著提高。根据模型结构的不同,可以将深度学习模型分为基于卷积神经网络的深度学习模型(如RegNet、EfficientNet、ResNet和VGG等)和基于自注意力机制的深度学习模型(包括Vision Transformer、Swin Transformer和CaiT等)[8]。

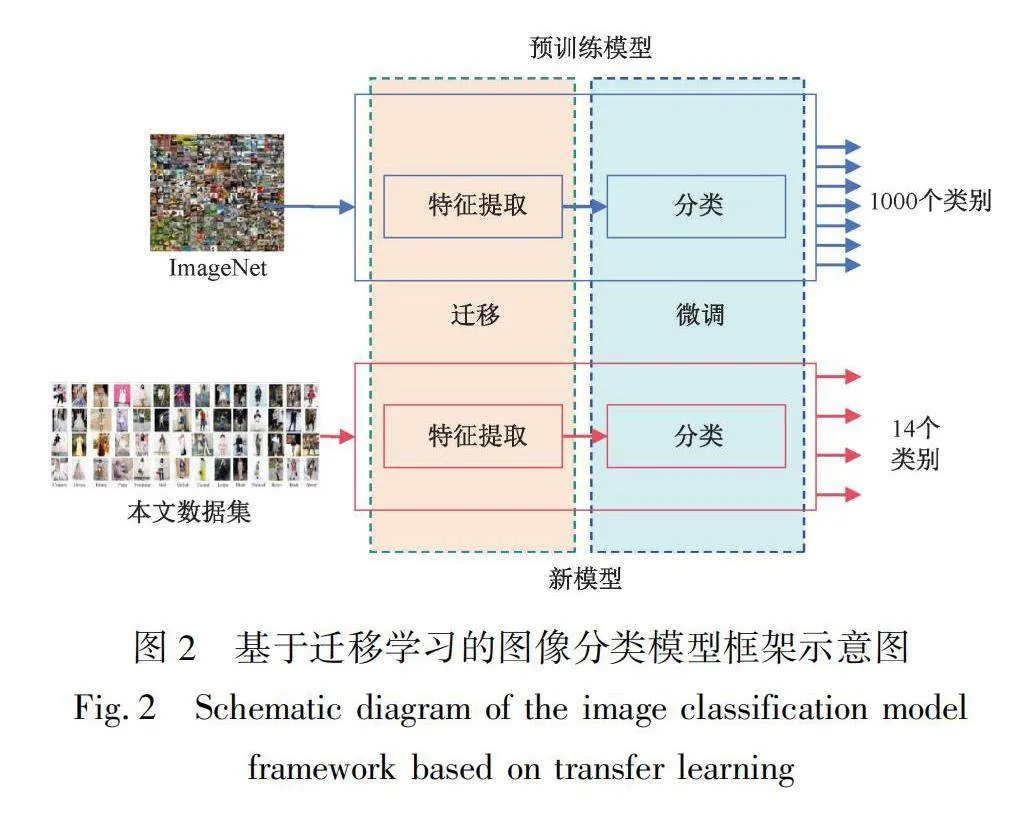

在深度学习应用中,由于相关方法对大规模数据集和计算资源的高需求,迁移学习作为一种有效的策略逐渐受到重视。该方法首先在大规模数据集上对深度神经网络进行训练,形成预训练模型,然后将该模型的参数作为初始参数,在新的数据集上进行微调。这一策略显著降低了模型训练所需的数据量和时间,同时提高了模型的分类性能和计算效率[9]。基于此,本文采用迁移学习方法来构建服装风格图像分类模型。

图2展示了基于迁移学习的图像分类模型框架。预训练模型的网络结构又可分为特征提取和分类两部分。图2所使用的预训练模型经过大型数据集(ImageNet)的训练,其输出层默认包括1000个节点,用来对ImageNet中的1000个类别图像进行分类。在训练过程中,本文保留了特征提取的网络结构和参数,仅对分类层的网络结构和参数进行微调。为了适应本文中的服装风格图像分类任务,本文将输出层的1000个节点修改为14个节点,对应于14种分类。然后,针对微调后的模型,在上述训练集和验证集上进行训练和验证。训练完成后,程序将生成新的深度学习模型。

由于软硬件资源的限制,本文选择了在图像分类任务中表现较好的3种预训练模型[10]进行服装风格图像分类,这些模型分别是:

a)EfficientNet V2 L:该模型在处理图像分类任务时,能够有效地捕捉图像中的特征,并在保持准确性的同时,具有较高的计算和参数效率[11]。

b)RegNet Y 16GF:该模型是一种基于正则化网络的图像分类模型,属于RegNet Y网络结构中的一个变种,拥有16个组和16个Gflops的计算量。其设计目标是在保持准确性的同时,尽可能减少计算和参数量,以提高模型的效率和速度[12]。

c)ViT Large 16:ViT是Vision Transformer的缩写,是一种基于注意力机制的图像分类模型。它在Transformer模型的基础上进行了改进,利用自注意力机制来处理图像分类任务。相较于传统的卷积神经网络,ViT Large 16模型不需要手动设计卷积核和池化操作,具有良好的可扩展性和泛化能力[13]。

1.3 基于集成学习的服装风格图像分类方法

集成学习方法是一种机器学习方法[14],通过组合多个基本学习器的预测结果,获得更好的整体预测性能。该方法具有如下优点:a)减少单个学习器的过拟合风险,提高模型的泛化能力;b)通过结合

多个学习器的预测结果,提高对少数类别样本的分类准确性,解决样本分布不平衡的问题;c)综合各学习器的优势,提高整体模型的稳定性。

综合上述集成学习方法的优点,针对服装风格分类问题,本文选择了以下3种集成学习方法:

a)基于投票的集成学习方法。该方法包括硬投票和软投票。其中,硬投票是指简单地统计每个基本模型预测结果中出现次数最多的类别作为最终预测结果。而软投票则是考虑每个基本模型预测结果的置信度,将置信度加权求和后得到最终的预测结果。本文将选用硬投票的集成学习方法。

b)基于加权平均的集成学习方法。在该方法中,每个基本模型都会对样本进行预测,并根据预测结果进行加权平均。各个分类器的权重大小取决于它们的测试性能表现。最终的决策结果是基于加权平均后的预测结果确定的。

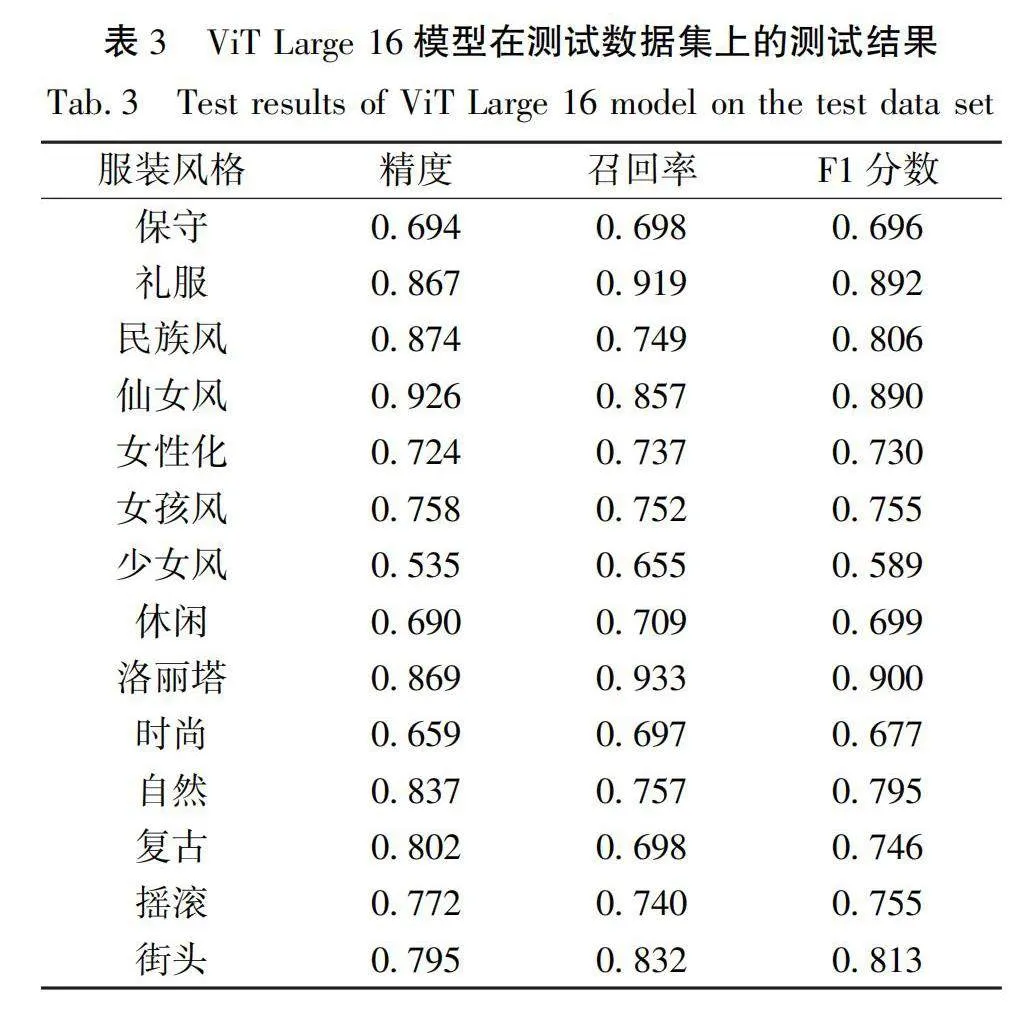

c)基于堆叠的集成学习方法。该方法将不同的基本学习器的预测结果作为新的特征输入元模型中,形成新的训练集。随后,基于这一新的训练集,构建了由3层神经网络组成的元模型,用以输出14个数据。其框架结构如图3所示。由图3可知,每种深度学习模型在每次预测后都会生成14个数据,而3个模型的输出数据组合在一起就形成42个数据。因此,经过多次预测后,这些数据就形成了新的训练集。此外,图3中的元模型包括1个输入层(a)、1个隐藏层(b)和1个输出层(c)。其中,输入层接收42个输入数据,对应42个神经元;隐藏层包含100个神经元;输出层输出14个数据,代表14个类别。各层之间采用全连接方式。

2 实验和结果分析

2.1 实验环境

本实验硬件环境包括:CPU型号为i9-13900H、内存16 Gi、固态硬盘1 TiB;软件环境包括:操作系统为win10 64 bit、开发语言为Python 3.10.1、深度学习框架为Pytorch 1.11.0。

2.2 评价指标

在后续实验中,采用了以下4种评价指标:

a)平均准确率(Accuracy):被正确分类的样本数与总样本数之间的比值,用于评估模型在所有服装风格类别上的整体分类准确性。

b)精确度(Precision):真正属于某一类别的样本数与所有被分类为该类别的样本数之间的比值,用于评估模型对某一特定服装风格类别的判断能力,即模型的查准率。

c)召回率(Recall):真正属于某一类别的样本数与所有真正属于该类别的样本数之间的比值,用于评估模型对某一特定服装风格类别的覆盖能力,即模型的查全率。

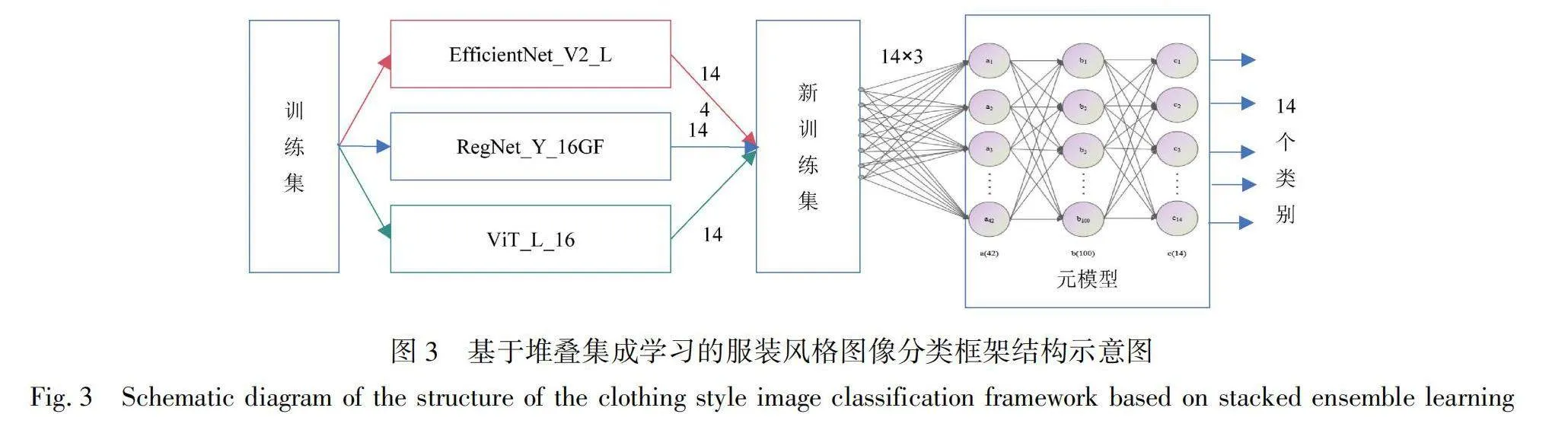

d)F1分数(F1-score):用于综合评估模型在准确性和覆盖能力方面的综合表现。计算公式如下:

V=2V·VV+V(1)

式中:V为F1分数的值,V为精确度值,V为召回率值。

2.3 迁移学习训练及测试结果与分析

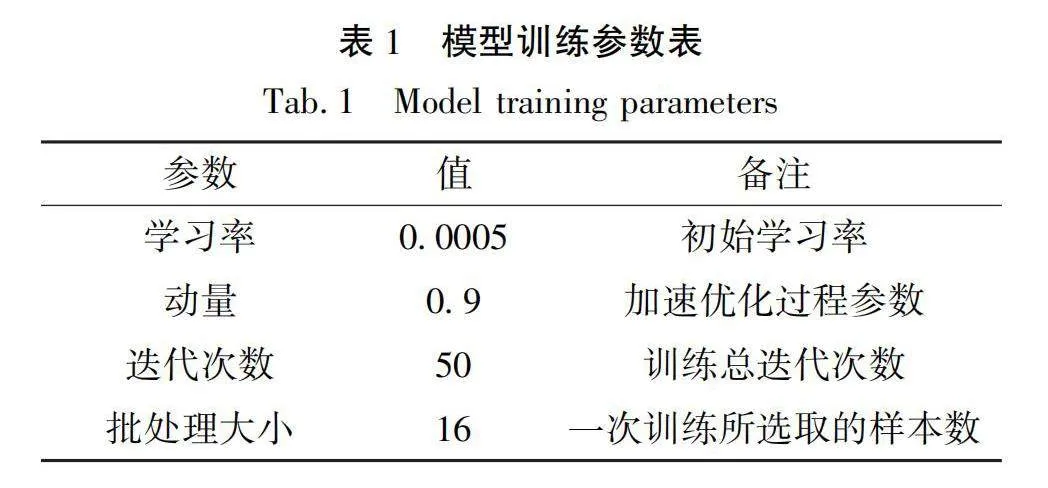

针对上述预训练模型,训练过程中采用了交叉熵损失函数,并选择了随机下降法作为优化器。同时,本文设置了表1所示的训练参数,以取得较好的训练效果。

训练和验证的过程涵盖了多个关键步骤,以确保深度学习模型的有效训练和性能评估。具体步骤包括:a)加载训练和验证数据集。b)选择并加载预训练模型。c)进入训练阶段,需要定义损失函数、优化器、学习率、动量、学习率调度器、步长、缩放因子等。d)初始化训练和验证损失率、准确率以及最低验证损失率。e)迭代循环运行每一个轮次,实现训练和验证的交替进行。在训练阶段,模型被设置为训练模式,梯度计算被启用,每个批次的样本和标签被读取,优化器的梯度被清零,样本输入模型,计算输出和损失率值,并进行反向传播和参数更新。在验证阶段,模型被设置为评估模式,计算当前阶段的损失率、准确率和样本数量。如果当前验证损失更低率,更新最低验证损失率,并保存当前模型为新模型。f)当训练循环结束后,得到服装风格图像的分类模型。

各模型在训练过程中准确率和损失率变化情况如图4所示,其中模型1为EfficientNet V2 L模型,模型2为RegNet Y 16GF模型,模型3为ViT Large 16模型。由图4可知,基于ViT Large 16模型训练的平均准确率明显优于另外两种基于传统卷积神经网络的预训练模型EfficientNet V2 L和RegNet Y 16GF。在验证集上,ViT Large 16模型的平均准确率达到了77.176%。

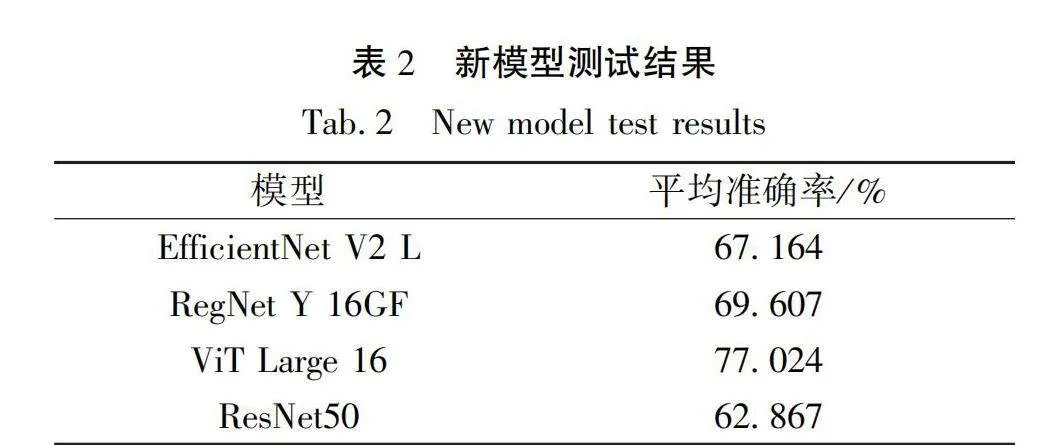

针对相同的测试集,对上述3个新模型进行测试,测试结果如表2所示。由表2可知,基于卷积神经网络的深度学习模型EfficientNet V2 L、RegNet Y 16GF的平均准确率分别为67.164%、69.607%。而ViT Large 16模型具有最高的平均准确率,其值为77.024%,比RegNet Y 16GF模型测试结果高出7.417%,分类和识别效果更优。此外,对文献[3]中的最优分类模型ResNet50模型进行训练和测试,结果表明:在相同测试集的情况下,ResNet50模型的平均准确率为62.867%,比上述3种模型测试结果都低。

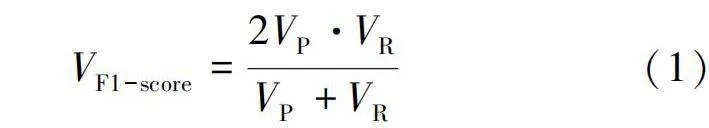

ViT Large 16模型在测试数据集上的评价指标情况见表3,评价指标包括精确度、召回率和F1分数。由表3可知,礼服、民族风、仙女风、洛丽塔、自然这5个服装风格分类各项指标均较高,而保守、少女风、休闲和时尚这4个服装风格分类各项指标则略低。

2.4 集成学习测试结果与分析

本文使用与迁移实验相同的测试集,对基于投票、加权平均和堆叠的集成学习方法进行测试。基于投票和加权平均的集成学习方法可以直接使用上述新生成的模型,无需重新训练。此外,根据表2测试结果,对基于加权平均的集成学习方法的权值进行分配。计算方法是按照每个模型的准确率除以所有模型平均准确率的总和,使得准确率较高的模型权值较大。计算过程和结果如式(2)—(4)所示:

W=67.164%/(67.164%+69.607%+77.024%)=0.314(2)

W=69.607%/(67.164%+69.607%+77.024%)=0.326(3)

W=77.024%/(67.164%+69.607%+77.024%)=0.360(4)

式中:W为EfficientNet V2 L模型对应的权值,W为RegNet Y 16GF模型对应的权值,W为ViT Large 16模型对应的权值。

由于基于堆叠的集成学习方法包含元模型,因此需要先对元模型进行训练,训练完成后再生成新的堆叠分类模型。在测试阶段,使用新的堆叠分类模型进行服装风格图像的分类和识别。

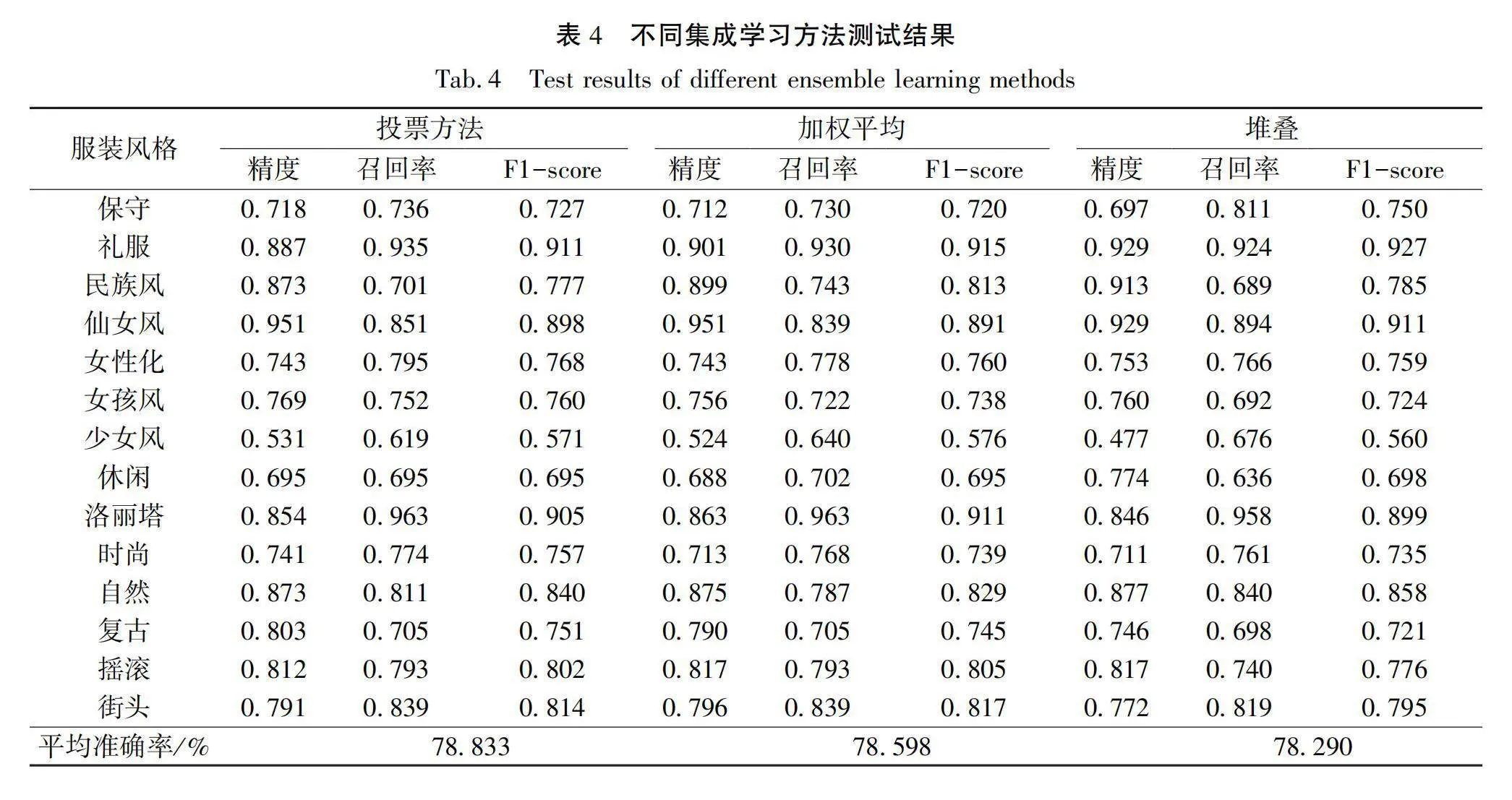

3种集成学习方法的测试结果如表4所示。由表4可知,基于投票的集成学习方法在数据集上测得的平均准确率最高,其值为78.833%,而在3个集成学习方法之间,平均准确率的差异不到1%。此外,根据表2和表4的结果可以得出如下结论:与本文单一深度学习模型测试结果相比,基于投票的集成学习方法在服装风格分类任务中的平均准确率提高了1.809%(从77.024%提升至78.833 %)。上述实验结果证明,集成学习方法可以有效提高整体模型的准确率。

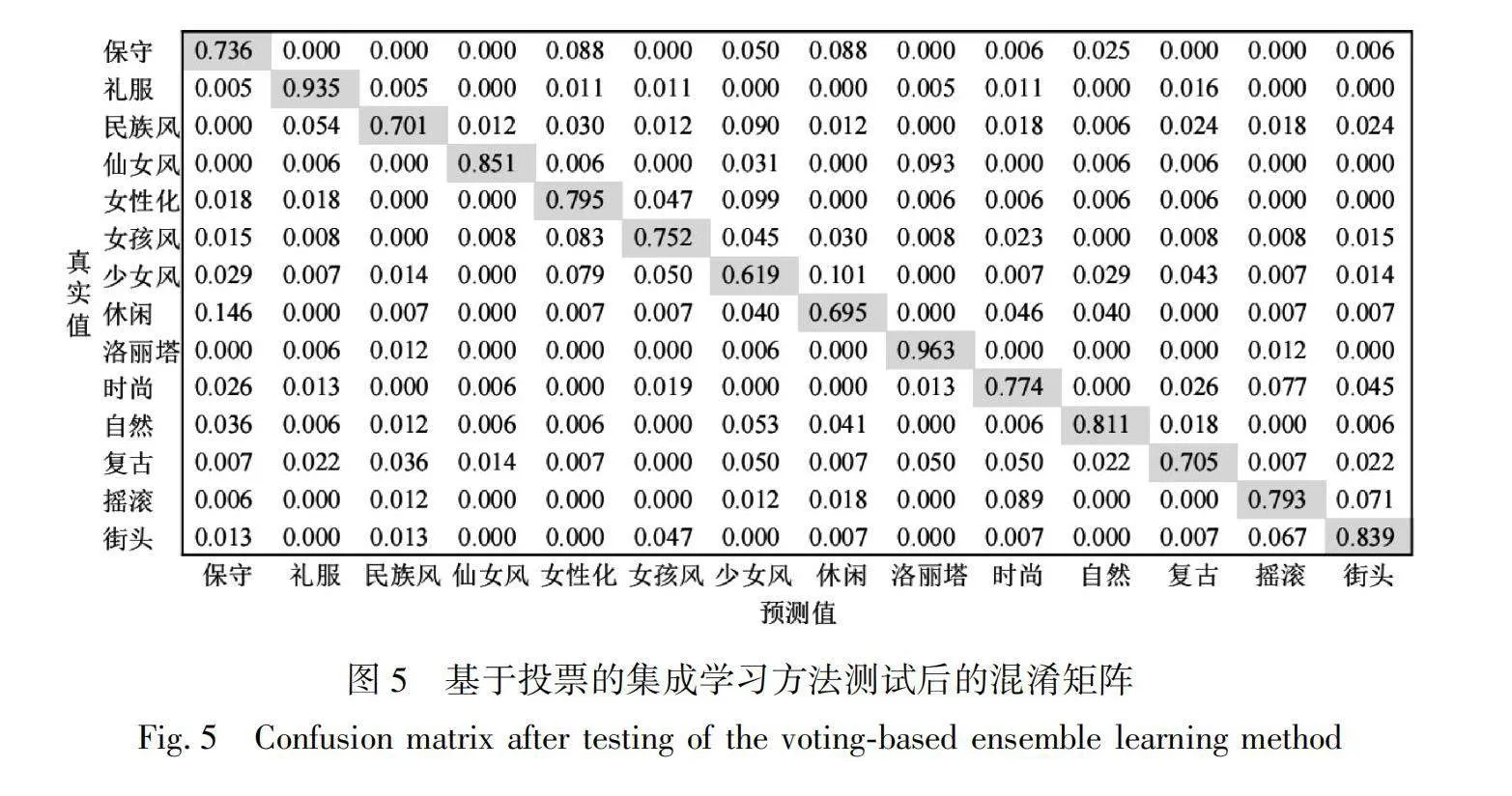

在对基于投票的集成学习方法进行测试后,还得到了如图5所示的混淆矩阵结果。其中,图中的数据为查全率。通过混淆矩阵不难看出,洛丽塔和礼服两种风格查全率超过90%,说明这两种风格的图像特征具有明显的独特性。而女性化、女孩风以及少女风这3类风格查全率整体偏低,查全率不到80%,相互之间容易出现混淆的情况,反映出这些风格图像之间存在一定的相似性。而对于民族风风格,其分类效果受到世界多民族服饰差异性的影响,查全率也偏低,建议对各民族服饰进一步细化分类。此外,摇滚风格和街头风格之间也容易混淆,表明这两种风格特征之间存在一定的重叠。

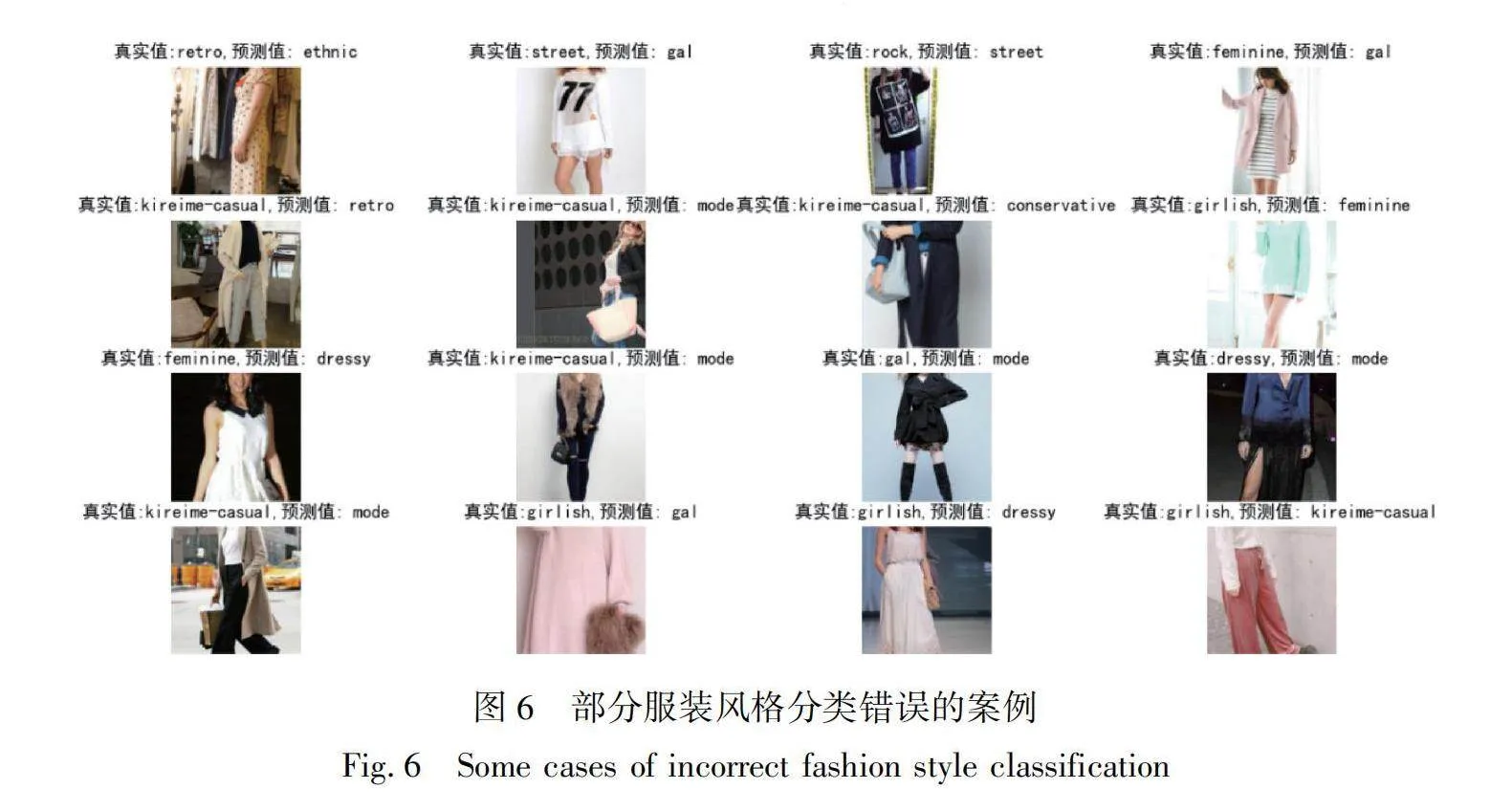

图6中展示了一些错误分类的案例。由图6可知,半身、侧身或被遮挡的图像更容易出现分类出错的问题,这表明数据集中涵盖了不同领域或来源的图像,受到了环境、光照条件、拍摄设备、拍摄角度等因素的影响,可被归类为跨域图像。而这种跨域问题直接导致了模型分类性能的降低。因此,在实际应用中,为了提高分类准确率,应尽量选用同域图像,即在相同的领域或环境中获取的图像。

3 结论

在人工进行服装风格分类时,常受主观性、地域等因素影响,导致服装风格图像分类错误。针对上述问题,本文研究了一种融合迁移学习和集成学习的服装风格图像分类方法。该方法首先采用了迁移学习方法,对预训练模型进行微调训练,训练后得到新模型,然后选择基于投票、加权平均和堆叠的集成

学习方法,分别对生成的新模型进行组合预测,最终实现服装风格图像分类功能。通过一系列实验,得出如下结论:

a)与基于传统卷积神经网络的深度学习模型相比,基于自注意力机制的深度学习模型在服装风格图像分类与识别方面展现出较好的分类与识别能力,ViT Large 16模型的平均准确率比本文中的其他模型高出7.417%。

b)与单个模型相比,采用常见的集成学习方法可有效提高服装风格图像分类与识别的精度,在分类精度上提升了1.809%。

c)女性化、女孩风以及少女风这3类风格较相似易混淆,摇滚风格和街头风格之间也容易混淆。

d)跨域图像更容易导致服装风格图像识别的失败。

后续研究可以根据服装属性等对相似风格进行更深入的分析,以提升模型的性能和分类准确性。此外,跨域服装风格图像分类问题有待进一步研究。

参考文献:

[1]JEON Y, JIN S, HAN K. FANCY: human-centered, deep learning-based framework for fashion style analysis[C]//Proceedings of the Web Conference 2021. Ljubljana, Slovenia. ACM, 2021: 2367-2378.

[2]RYDING D, CLAUDIA, RUDAWSKA E, et al. Extending the consumer style inventory to define consumer typologies for secondhand clothing consumption in Poland[J].European Research Studies Journal, 2020: 410-433.

[3]TAKAGI M, SIMO-SERRA E, IIZUKA S, et al. What makes a style: Experimental analysis of fashion prediction[C]//IEEE International Conference on Computer Vision Workshops. Venice. IEEE, 2017: 2247-2253.

[4]李扬, 黄荣, 董爱华. 基于改进Bilinear-CNN的服装图像风格识别[J].东华大学学报(自然科学版),2021,47(3):90-95.

LI Yang, HUANG Rong, DONG Aihua. Fashion style recognition based on an improved Bilinear-CNN[J]. Journal of Donghua University(Natural Science),2021,47(3):90-95.

[5]WOOTTISART P, SRIPIAN P, THANASUAN K. The study of fashion style classification: harajuku-type kawaii and street fashion[C]//16th International Conference on Signal-Image Technology & Internet-Based Systems (SITIS). Dijon, France. IEEE, 2022: 402-408.

[6]AN H, LEE K Y, CHOI Y, et al. Conceptual framework of hybrid style in fashion image datasets for machine learning[J]. Fashion and Textiles, 2023, 10(1):18.

[7]MA Y, JIA J, ZHOU S, et al. Towards better understanding the clothing fashion styles: A multimodal deep learning approach[C]//Proceedings of the Thirty-First AAAI Conference on Artificial Intelligence. San Francisco, California, USA. ACM, 2017, 31(1):38-43.

[8]石争浩, 李成建, 周亮, 等. Transformer驱动的图像分类研究进展[J]. 中国图象图形学报, 2023, 28 (9): 2661-2692.

SHI Zhenghao, LI Chengjian, ZHOU Liang, et al. Survey on Transformer for image classification[J]. Journal of Image and Graphics, 2023, 28 (9): 2661-2692.

[9]曾华福, 杨杰, 李林红. 基于改进ShuffleNet v1的服装图像分类算法[J]. 现代纺织技术, 2023, 31(2):23-35.

ZENG Huafu, YANG Jie, LI Linhong. Clothing image classification algorithm based on improved ShuffleNet v1[J]. Advanced Textile Technology,2023,31(2):23-35.

[10]LIU Z, MAO H, WU C Y, et al. A convnet for the 2020s[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans, LA, USA. IEEE, 2022: 11976-11986.

[11]TAN M, LE Q. Efficientnetv2: Smaller models and faster training[C]//International Conference on Machine Learning. Stockholm, Sweden, PMLR, 2021: 10096-10106.

[12]DOLLAR P, SINGH M, GIRSHICK R. Fast and accurate model scaling[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville, TN, USA. IEEE, 2021: 924-932.

[13]李翔, 张涛, 张哲, 等. Transformer在计算机视觉领域的研究综述[J].计算机工程与应用, 2023, 59 (1): 1-14.

LI Xiang, ZHANG Tao, ZHANG Zhe, et al.Survey of transformer research in computer vision[J].Computer Engineering and Applications, 2023, 59 (1): 1-14.

[14]徐继伟, 杨云. 集成学习方法:研究综述[J]. 云南大学学报(自然科学版), 2018, 40 (6): 1082-1092.

XU Jiwei, YANG Yun. Ensemble learning methods: A research review[J]. Journal of Yunnan University (Natural Sciences Edition), 2018, 40 (6): 1082-1092.

A fashion style image classification method integrating transfer learning and ensemble learning

YOU Xiaoronga, LI Shufangb

(a. School of Intelligent Manufacturing;b. School of Intelligent Textiles and Materials, Changzhou

Vocational Institute of Textile and Garment, Changzhou 213164, China)

Abstract: The fashion industry plays an important role in the global economy, and its GDP scale shows a growing trend, currently accounting for approximately 2% of the global GDP. Fashion style classification can help consumers better understand and choose fashion products that suit their preferences, making it easier for them to find the styles and brands they are interested in. At the same time, fashion style classification also plays an important role in fashion research and design, providing inspiration and reference for designers. In addition, for fashion brand companies and retailers, the precise classification of fashion styles helps to better understand market demand and consumer preferences, thereby adjusting product categories and promotion strategies. Manual fashion style classification has the characteristics of subjectivity, diversity, variability and regionality, which can easily lead to errors in classification results. Therefore, it is important to improve the objectivity and accuracy of classification by using technical means, such as artificial intelligence.

In response to the above problems, this paper studied a fashion style image classification method that combines transfer learning and ensemble learning. Firstly, based on the FashionStyle14 data set, duplicate or invalid images were filtered out to construct a fashion style image data set. Secondly, pre-trained models such as EfficientNet V2, RegNet Y 16GF and ViT Large 16 were used for fine-tuning training to generate new models to achieve fashion style image classification with a single deep learning model. Thirdly, the new model was tested and its classification performance was evaluated according to the evaluation indicators, and a good deep learning model was selected. Fourthly, an ensemble learning method based on voting, weighted integration and stacking was built to perform combined predictions on the above models, so as to improve the generalization ability and stability of the model. Finally, the ensemble learning method with the best performance was selected to classify fashion styles. By using the above method, not only advanced algorithms were applied in artificial intelligence to fashion style classification, but also the effectiveness of the method in classifying various fashion styles was verified, and some similar fashion styles were discovered, which provided data support for further refinement of fashion style classification. It is found that compared with the deep learning model based on a traditional convolutional neural network, the deep learning model based on the self-attention mechanism shows better recognition ability in fashion style image classification and recognition; compared with a single model, the commonly used integrated learning method can effectively improve the accuracy of fashion style image classification and recognition; the three styles of femininity, girly style and maiden style are similar, and it is easy to confuse between rock style and street style; cross-domain images are more likely to lead to recognition failure of fashion style images.

In future research work, similar styles can be analyzed more deeply based on methods such as fashion attributes to improve the performance and classification accuracy of the model. In addition, in-depth research on cross-domain fashion style image classification and recognition issues is needed to explore more effective solutions.

Keywords: fashion style; transfer learning; ensemble learning; ViT model; image classification