二维激光雷达与相机数据融合标定

摘要:针对单线激光雷达和相机之间外参标定速度慢、实时性差的不足,提出1种基于特征点的数据融合标定方法。在特殊设计的标靶上提取相机外参标定所需的像素特征点,通过激光雷达角度标定得到所需的点云特征点;采用特征点法融合标定像素与点云特征点,得到激光雷达数据与相机图像像素点对应的坐标序列,融合处理2种坐标序列计算出融合矩阵,且通过标定实验验证所提方法的可行性与有效性。结果表明:与传统标靶相比,采用特殊设计标靶的标定速度可提高31.4%;结合数据融合的处理方法可得到单线激光雷达和相机的标定参数,数据融合的平均重投影误差为1.9pixel、标准差为0.7pixel,雷达点云数据能够在标靶上较好地投影,使激光雷达点云与标靶图像成功匹配;通过融合矩阵只需较少对应的激光雷达点云和像素点,可避免计算标定的各个参数,标定过程更简便、快捷。

关键词:新型标靶;二维激光雷达;相机;特征点;数据融合;外参标定;联合标定

中图分类号:TN958.98文献标志码:A doi:10.12415/j.issn.1671−7872.24039

Calibration for the Integration of2D LiDAR and Camera Data

YAN Hongjie1,ZHU Zhifeng1,CAI Bohua2,YAO Yong2

(1.School of Electricalamp;Information Engineering,Anhui University of Technology,Maanshan243032,China;2.Anhui FCAR Electronic Technology Co.,Maanshan243000,China)

Abstract:Aiming at the shortcomings of slow calibration speed and poor real-time performance between single-line LiDAR and camera extrinsics,a data fusion calibration method based on feature points was proposed.The pixel feature points required for camera external parameter calibration were extracted from aspecially designed target,and then the necessary point cloud feature points were obtained by LiDAR angle calibration.The pixel feature points and point cloud feature points were jointly calibrated by the feature point method to obtain the coordinate sequence corresponding to the LiDAR data and the camera image pixel points.The two types of coordinate sequences were fused to calculate the fusion matrix.The feasibility and effectiveness of the proposed method were verified by calibration experiments.The results show that compared to traditional calibration targets,compared to traditional calibration targets.Combining the data fusion processing method,the calibration parameters of single-line LiDAR and camera can be obtained.The average reprojection error of data fusion is1.9pixel,with astandard deviation of0.7pixels.The LiDAR point cloud data can be projected well on the calibration target,which can successfully match the LiDAR point cloud with the target image.By the fusion matrix,fewer corresponding LiDAR point clouds and pixels are required,which can avoid the calculation of individual calibration parameters,thus making the calibration process simpler and faster.

Keywords:novel calibration target;2D LiDAR;camera;feature point;data fusion;external parameter calibration;combined calibration

在现代感知系统中,激光雷达[1]和相机[2]的融合标定已成为提高环境感知和目标检测准确性的关键步骤之一。相机能够获得三维场景的图像信息,激光雷达能够获得三维场景的距离信息[3]。相机和激光雷达联合标定方法主要分为棋盘格法[4]、角点检测法[5]、特殊几何形状标定法[6],这些方法都是通过两者之间的数据融合发挥单个传感器的优点,可获得更加丰富的环境信息,其在机器人定位、目标检测、路径规划以及无人驾驶等领域发挥了重要作用[7−8]。然而,激光雷达和相机的融合并非一项简单的任务,外参标定是其中关键的一环[4]。外参标定的准确性直接影响感知系统对环境的理解和对目标的识别定位能力[9]。此外,外参标定速度慢可能导致生产效率低下,以致实时性要求无法满足[10]。因此,研究二维激光雷达与相机数据融合标定,对于提高环境感知和目标检测的准确性,同时实现简便快捷的外部参数获取具有重要意义。

针对外参标定的准确性,Alai等[11]设计基于二维激光雷达和单目摄像头融合的高性价比车辆检测和跟踪系统,通过预测汽车与滑板车碰撞的实时危险来保护电动微型移动设备,操作和部署过程比较简单,但在远距离或大尺寸目标的检测和跟踪方面存在局限性。Wang等[12]提出1种较少算法交互、自动化较高的方法,用于测距传感器的外在参数,该方法采用三维棋盘格,可提高标定的效率与稳定性,但复杂度高,导致标定时间与成本增加。Deng等[13]提出1种面向路边一体化雷达摄像头融合传感器的自动外在参数标定方法,可使雷达和摄像头之间的标定过程更高效,但需精确度相对高的雷达和摄像头设备以及相应精确的车辆位置信息,限制了方法的适用范围和通用性。代军等[14]提出1种基于非 线性优化的联合标定方法,可减少误差传递和累积,提高标定结果的准确性和稳定性,但标定过程依赖于初始估计的准确性。武鹏柯等[15]提出1种基于 标定板特征关键点联合标定的方法,可解决传统手眼联合标定方法精度误差大、操作繁琐的问题,但依赖于关键点提取的准确性和稳定性,而在实际场景中关键点提取受到噪声、遮挡等因素的影响。谢婧婷等[16]为更好地利用激光雷达和相机数据之间的几何关系,采用点线面约束的方法,但涉及到多个参数的选择和调整,所需时间长。鉴于单线激光雷达扫描线的有限性和相机标定所需数据量大,加之外参标定任务复杂、耗时[17],根据相机与激光雷达传感器自身特点,设计1种特殊的标靶,在相机采集图像的过程中同时采集激光雷达的点云数据,快速得到单个传感器的参数;在此基础上,提出1种基于特征点的融合标定方法,通过激光雷达和相机之间的数据融合实现外参标定,以期为相机与激光雷达联合标定提供1种高效可行的解决方案。

1标定原理

激光雷达与相机联合标定的原理示意图如图1所示,其中oc-xcycz c为相机坐标系,ol-xlylzl为激光雷达坐标系,o-xy为图像坐标系,o-uv为像素坐标系[18]。

设空间存在某点q,在相机坐标系中坐标为(xc;yc;z c),在激光雷达坐标系中坐标为(xl;yl;zl),相机和激光雷达坐标系之间的转换关系如式(1)。

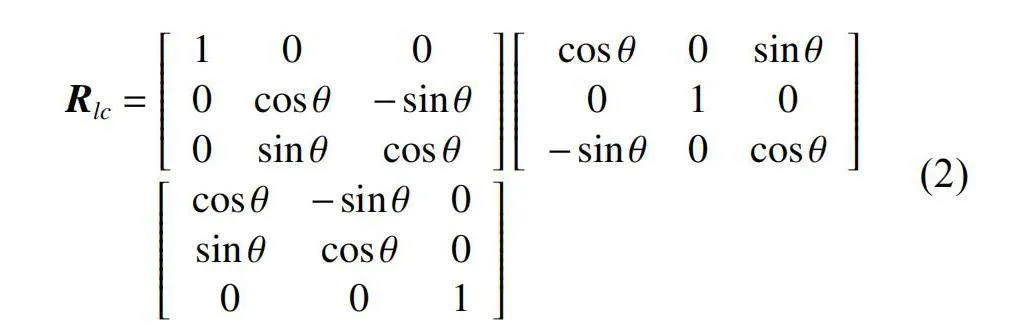

其中:Tlc=[tx ty tz]T,为激光雷达坐标系到相机坐标系之间的平移向量;Rlc为激光雷达坐标系到相机坐标系之间的旋转矩阵,Rlc=RxRyRz;Rx,Ry;Rz分别为激光雷达绕x轴、y轴、z轴逆时针旋转得到的旋转矩阵。所以Rlc的表达式如式(2)。

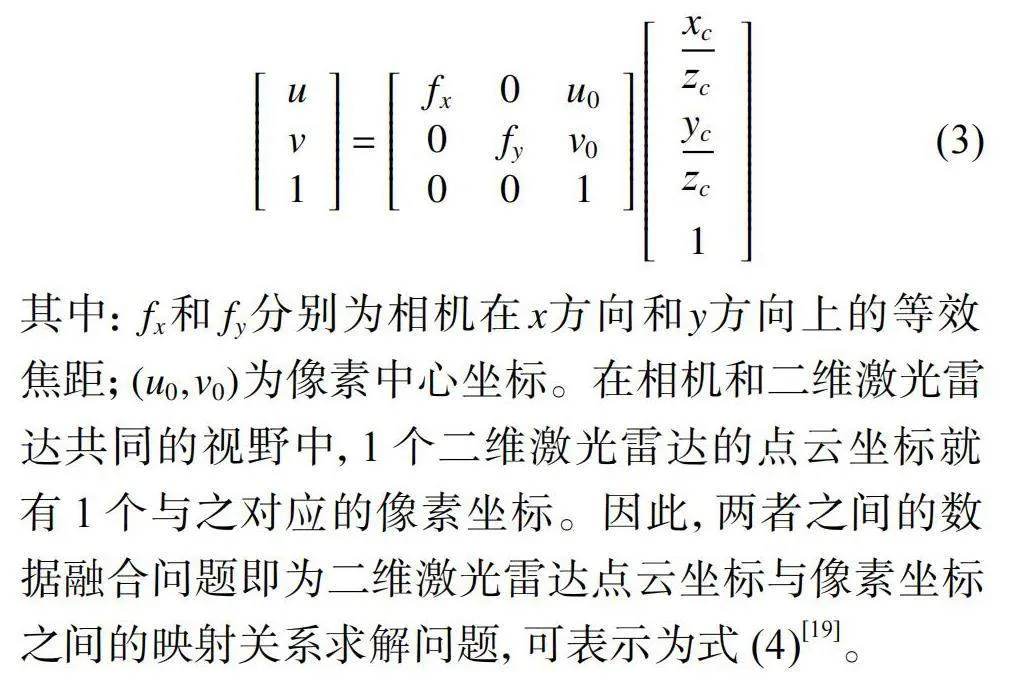

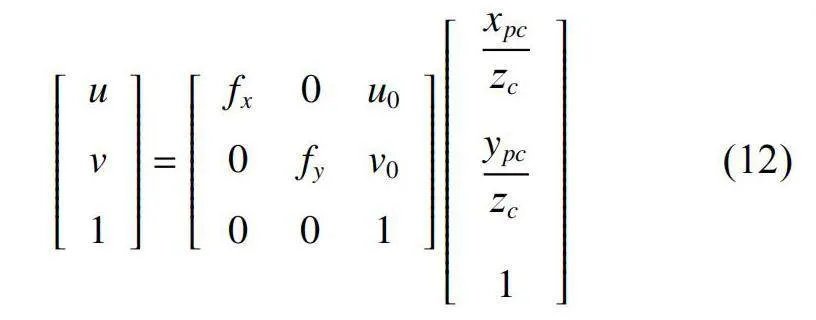

设点q对应的图像像素坐标为(u;v),则有如下的转换关系:

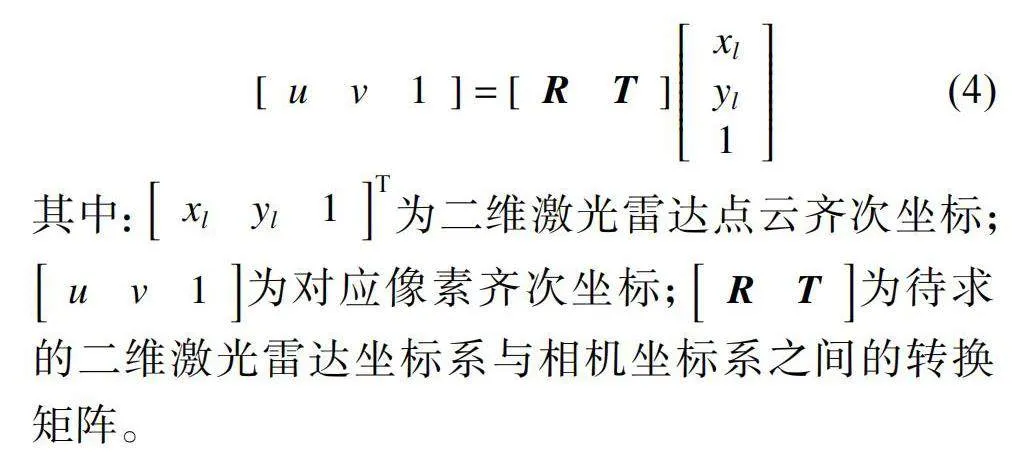

其中:fx和fy分别为相机在x方向和y方向上的等效焦距;(u0;v0)为像素中心坐标。在相机和二维激光雷达共同的视野中,1个二维激光雷达的点云坐标就有1个与之对应的像素坐标。因此,两者之间的数据融合问题即为二维激光雷达点云坐标与像素坐标之间的映射关系求解问题,可表示为式(4)[19]。

其中:[xl yl1]T为二维激光雷达点云齐次坐标;[u v1]为对应像素齐次坐标;[R T]为待求的二维激光雷达坐标系与相机坐标系之间的转换矩阵。

2标定方法

激光雷达的扫描线不可见,但扫描数据点的距离ρ和角度θ是已知的。因此,使用激光雷达扫描特殊的几何标靶时,会得到若干扫描数据点坐标(ρi;θi;),i表示某个雷达扫描点;采用最小二乘法对坐标进行直线拟合即可得到激光雷达的扫描线,同时利用扫描线在标靶上的特征点完成激光雷达和相机的联合标定。

2.1标靶设计

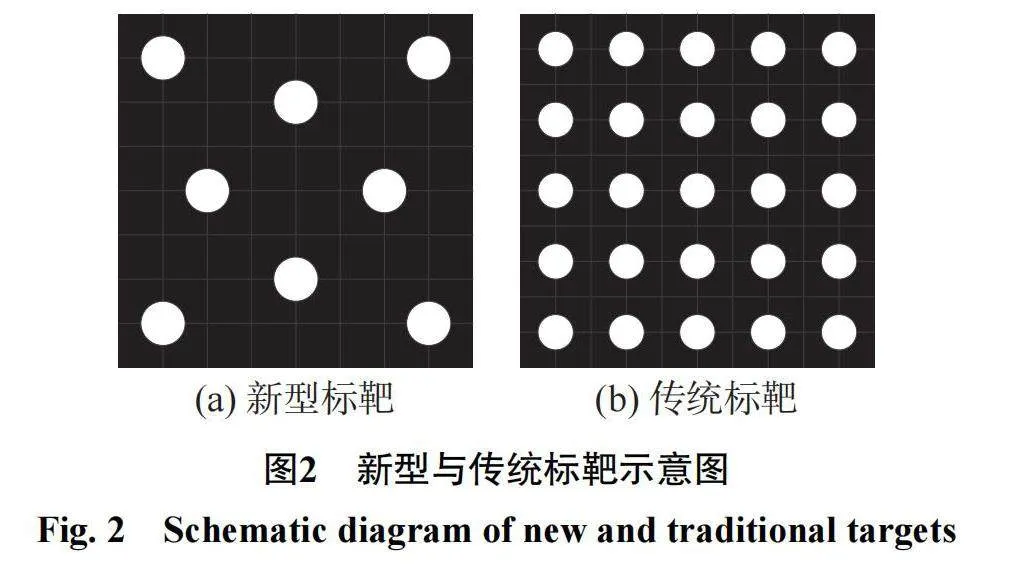

求解相机标定参数时,需从标靶特征点中随机选取4个不共线的特征点求解单应性矩阵,从而求解出相机的内参。传统的标靶共有25个小圆,即有25个特征点,根据排列组合随机选取4个特征点,共有45万多种取点方法,且其中还包含若干组4点共线的情况,程序在执行时会花费较多时间。为解决这一问题,设计1种新的标定标靶,采用8个小圆且以特殊阵列排布,共有70种取点方法,且保证每3个点均不共线,加快程序的执行。新型标靶示意图如图2。

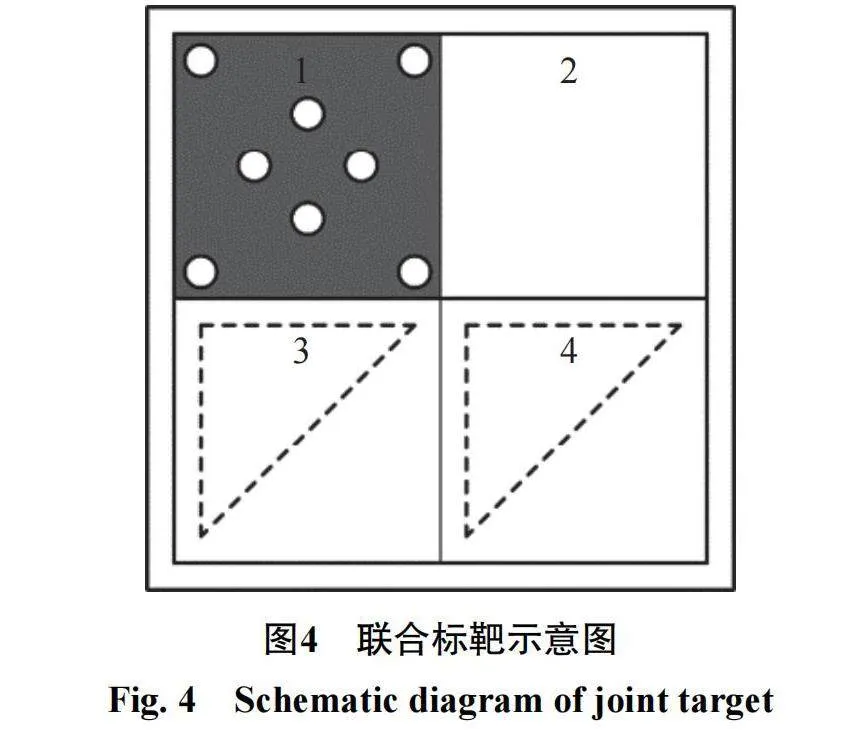

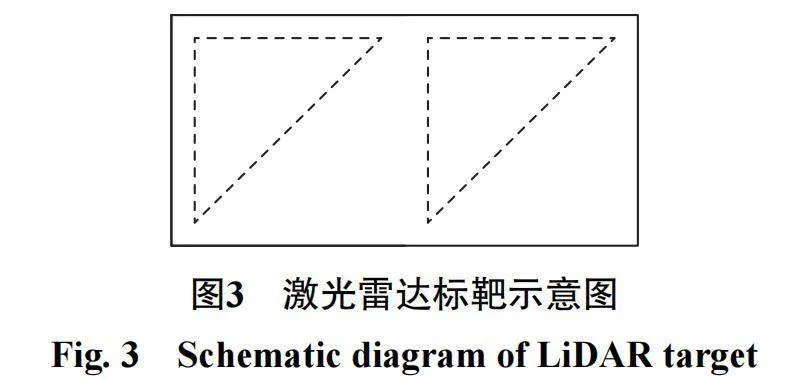

激光雷达不同于相机,其扫描点是不可见的,但通过点云信息可确定激光雷达照射至物体返回的距离和角度。因此,通过设计的特殊几何标靶获得激光雷达的特征点云信息。2个正方形雪弗板中有2个镂空的直角三角形,激光雷达照射该标靶时,镂空部分不能反射激光雷达信号,会在镂空与非镂空部分的边缘得到激光雷达的点云信息。雷达标靶示意图如图3。

将相机标定标靶和雷达标靶相结合,在相机和二维激光雷达的共同视野中实现数据的采集,联合标靶如图4。联合标靶的设计既可满足单个传感器的参数标定,也可满足2个传感器之间的拟合标定。单独使用等腰直角三角形标靶时,可标定出激光雷达俯仰角、侧倾角、偏转角。标靶的4个部分在同一平面,第3部分等腰三角形的1条直角边在第1部分左侧2个小圆的圆心距延长线上,且边长与圆心距相同。这样可通过图像坐标系坐标表示激光雷达在标靶上形成的特征点,从而得到对应的像素坐标。

2.2激光雷达角度标定

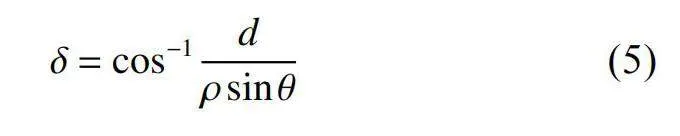

激光雷达的角度包括俯仰角、侧倾角及偏转角。利用图5所示的等腰直角三角形标靶可标定出激光雷达的俯仰角δ。图中ol-xlylzl为激光雷达坐标系,Old为激光雷达的光心,激光雷达照射等腰三角形标靶得到1条扫描线DF,d为激光雷达与标靶之间的距离,h为激光雷达的安装高度。激光雷达的扫描距离为ρ,扫描角度为θ,则俯仰角的求解公式如下。

利用图6所示的正方形标靶可标定出激光雷达的侧倾角α。图中激光雷达扫描线GF与EF之间形成的夹角α即为激光雷达的侧倾角,由余弦定理可知扫描线GF的公式如下。

故侧倾角α的计算公式如式(7)。

利用激光雷达发出的射线,将其投影到标靶坐标系,在标靶坐标系能够得到一系列的激光雷达特征点,将特征点拟合成1条直线,该直线斜率的反正切值即为激光雷达的偏转角γ。

2.3融合标定

将标靶固定在某一位置,激光雷达安置在距标靶距离为d的位置,激光雷达的安装高度为h。调整激光雷达水平扫描标靶,在标靶上留下1条近似水平的直线,激光雷达扫描效果如图7。图中:线段AG为激光雷达扫描线;A,G分别为扫描线在标靶边缘留下的特征点;B,C,D,E分别为扫描线在镂空部分与非镂空部分边缘留下的特征点;xpc;ypc为标靶坐标系下圆形标靶特征点坐标,计算机对圆心标靶图像进行处理时,默认左上角为原点坐标,水平向右为横坐标,竖直向下为纵坐标;xpl;ypl为标靶坐标系下雷达特征点坐标。

从激光雷达扫描数据可知扫描的角度θ和扫描的距离ρ,因此通过式(8)得到特征点在激光雷达坐标系下的坐标。

其中:xl为特征点在激光雷达坐标系下的横坐标;yl为特征点在激光雷达坐标系下的纵坐标。激光雷达扫描特征点在标靶坐标系下的坐标如式(9)。

其中:xpl为特征点在标靶坐标系下的横坐标;ypl为特征点在标靶坐标系下的纵坐标。

设6个雷达特征点在标靶上的坐标为(xpli;ypli)(i=1~6)。调整激光雷达安装位置,使落在标靶最左侧的初始特征点坐标为(0;ypl1)。采用最小二乘法求解特征点所在的直线方程,设直线方程y=kx+b,则雷达的偏转角Y可由式(10)表示。

Y=tan一1k(10)

为找到与雷达特征点对应的像素点,需将雷达特征点在标靶一的坐标统一到圆形标靶坐标系,转换关系如式(11)。

其中:xpc为特征点在圆形标靶坐标系下的横坐标;ypc为特征点在圆形标靶坐标系下的纵坐标;L为标靶的边长。因此6个特征点变换后的坐标为(xpli;L一ypli)(i=1~6)。标靶上的特征点坐标和像素坐标之间的转换关系如式(12)。

联立式(9),(11),(12)可得激光雷达特征点与像素坐标之间的对应关系。移动标靶至雷达不同距离处,多次采样得到激光雷达数据与像素点对应的坐标序列:{(xl1;yl1;u1;v1);(xl2;yl2;u2;v2);···;(xln;yln;un;vn)}。

2.4数据融合

由2.3得到的激光雷达数据与像素点对应的坐标序列可知,激光雷达点云数据点在像素坐标系中都能找到与之对应的像素点,因此对多组激光雷达数据与相机图像像素点对应的坐标序列进行函数拟合,即为两者之间的数据融合处理过程。设相机和激光雷达坐标系之间的转换矩阵M={aij}3×3。对像 素特征点与对应的雷达特征点之间建立约束方程组,如式(13),求解矩阵M中的9个元素。

1对特征点可建立3个方程,假设有n组特征点,则可建立3n个方程,对约束方程展开得到如式(14)的矩阵形式。

其中m=(a11;a12;a13;a21;a22;a23;a31;a32;a33)T。求解9个参数至少需3组对应的特征点,通常选取多组对应的特征点形成约束方程,通过线性最小二乘法求解。利用求得的标定参数将激光雷达点云数据投影到图像平面,得到像素坐标,通过式(15)比对重投影之后的像素点与实际像素点之间的误差,得到标定的精度。

其中:ui;vi为实际的像素点;udi;vdi为重投影的像素点;r为标定的精度。

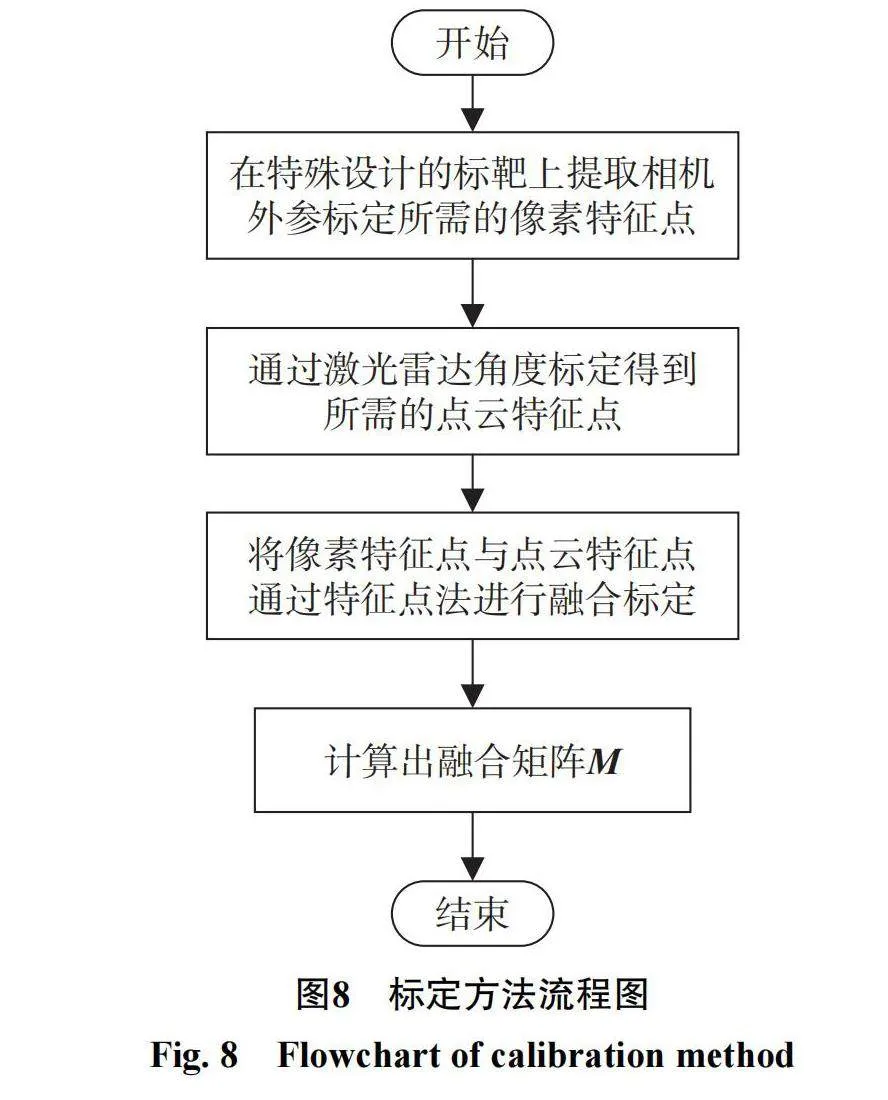

最后求出的转换矩阵M即为融合矩阵,通过融合矩阵可避免引入车体坐标系,避免计算标定的各个参数,标定过程更简便快捷。上述标定方法的标定过程如图8。

3标定实验与结果分析

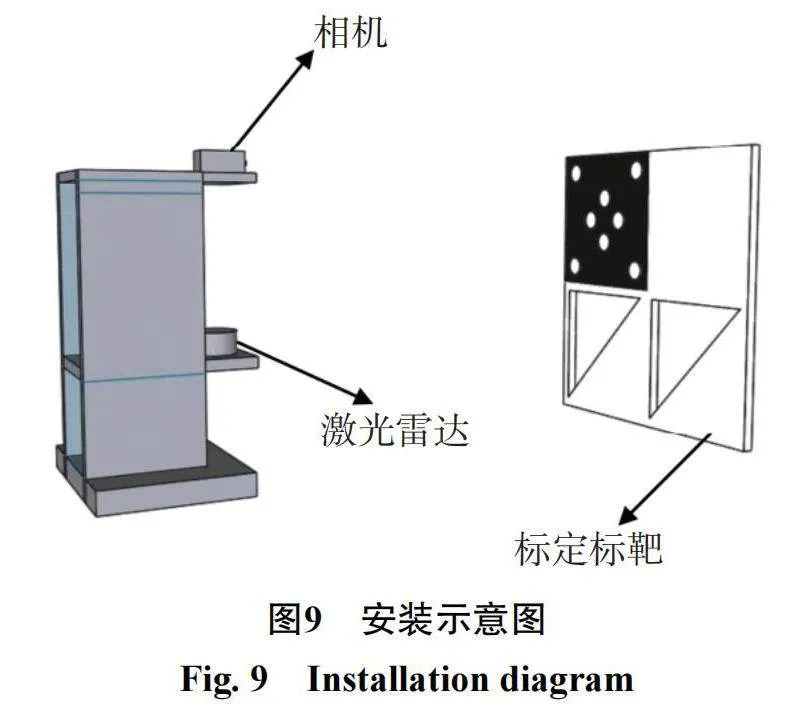

为验证本文提出融合标定方法的可行性与有效性,设计标靶标定和融合标定实验,比较分析新型标靶和传统标靶通过相机标定程序计算的相关参数、融合标定前后的结果。采用M2S500M–H2USB工业相机和Delta–1A激光雷达分别采集相机图像数据和雷达点云数据,激光雷达和相机的安装示意图如图9,实验现场如图10。

3.1标靶标定实验

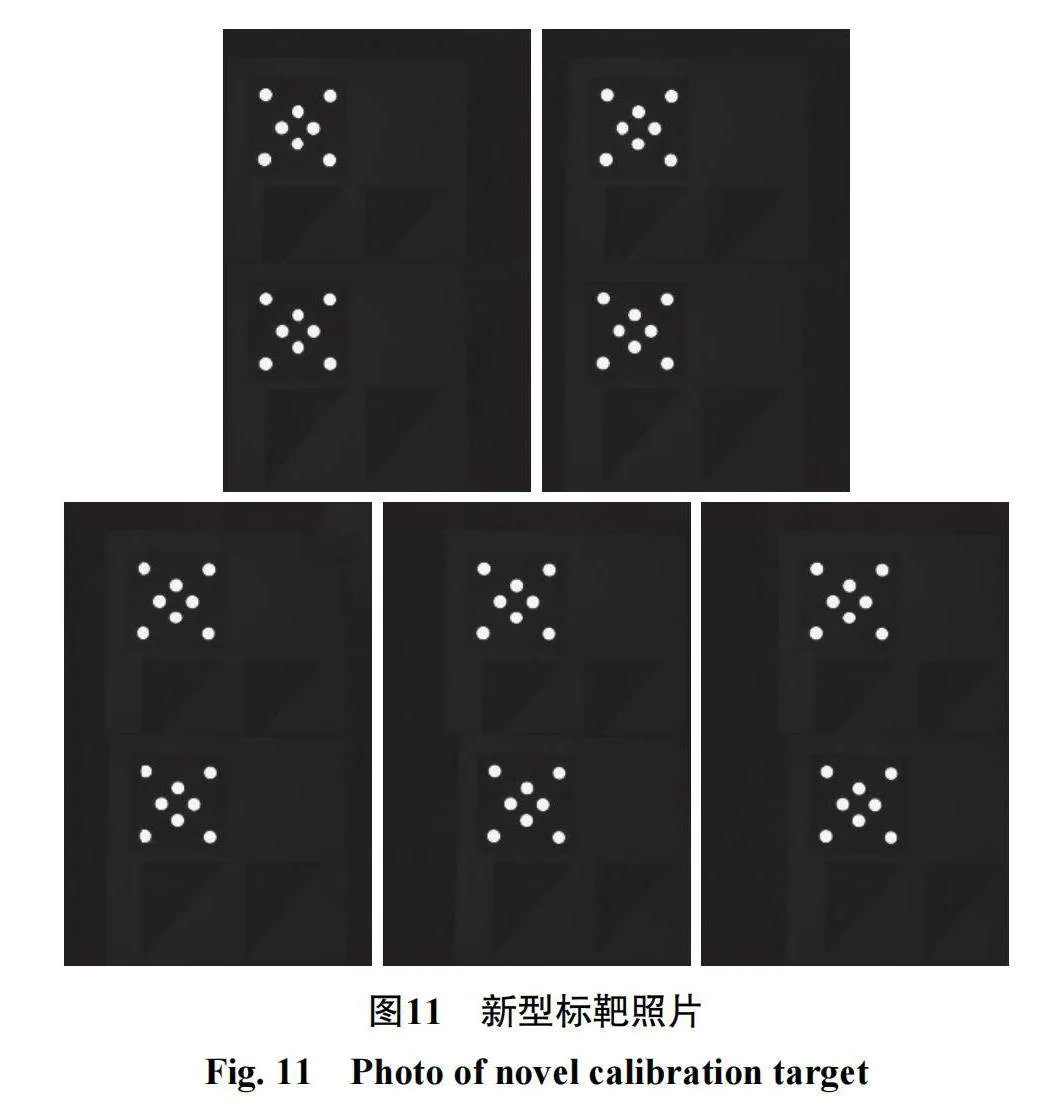

采用M2S500M–H2USB工业相机拍摄10张不同的新型标靶照片,为减小标定误差,使相机标定的结果更准确,每张照片相对相机的位置均不同,如图11。每张标靶照片的像素尺寸为640×480,通过相机标定程序对10张标靶照片进行处理;同时采用相机拍摄10张传统标靶照片,并通过相机标定程序进行处理,所得相关参数结果如表1。

分析表1可得:新型标靶标定时间为8.747s,较传统标靶标定时间(12.752s)减少了31.4%;新型标靶标定的像素平均误差和照片平均误差分别为0.254,0.088pixel,与传统标靶标定的结果(0.253,0.089pixel)接近。由此表明设计的新型标靶在保证标定精度的前提下,还可大大缩短标定时间,提高标定速度,验证了新型标靶设计的有效性。

3.2融合标定实验

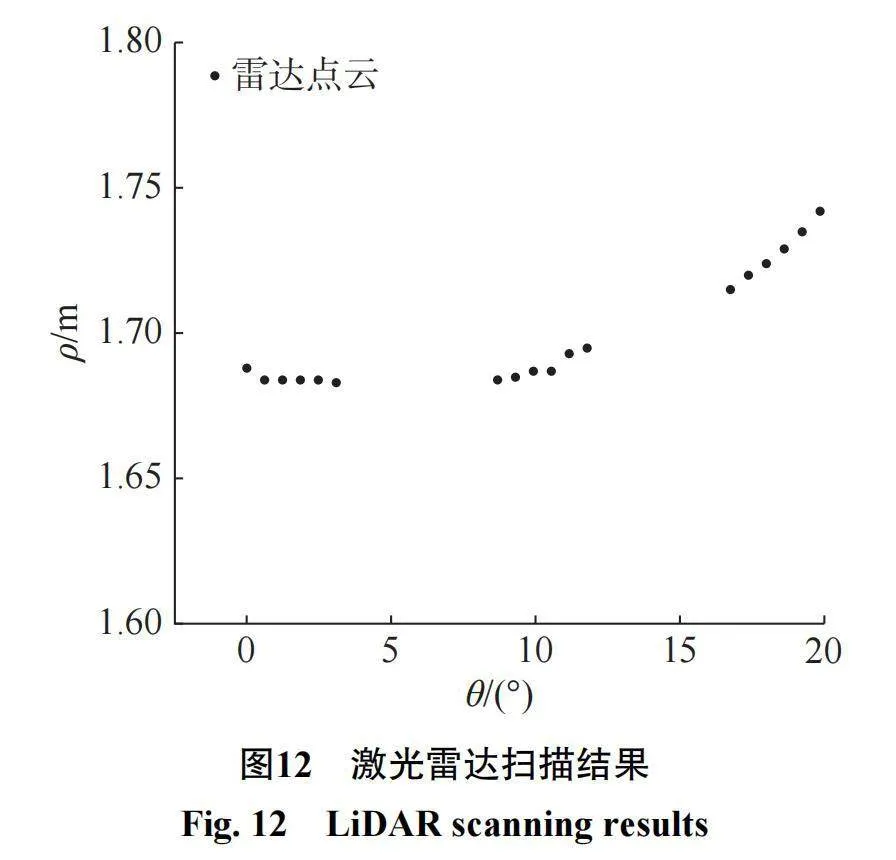

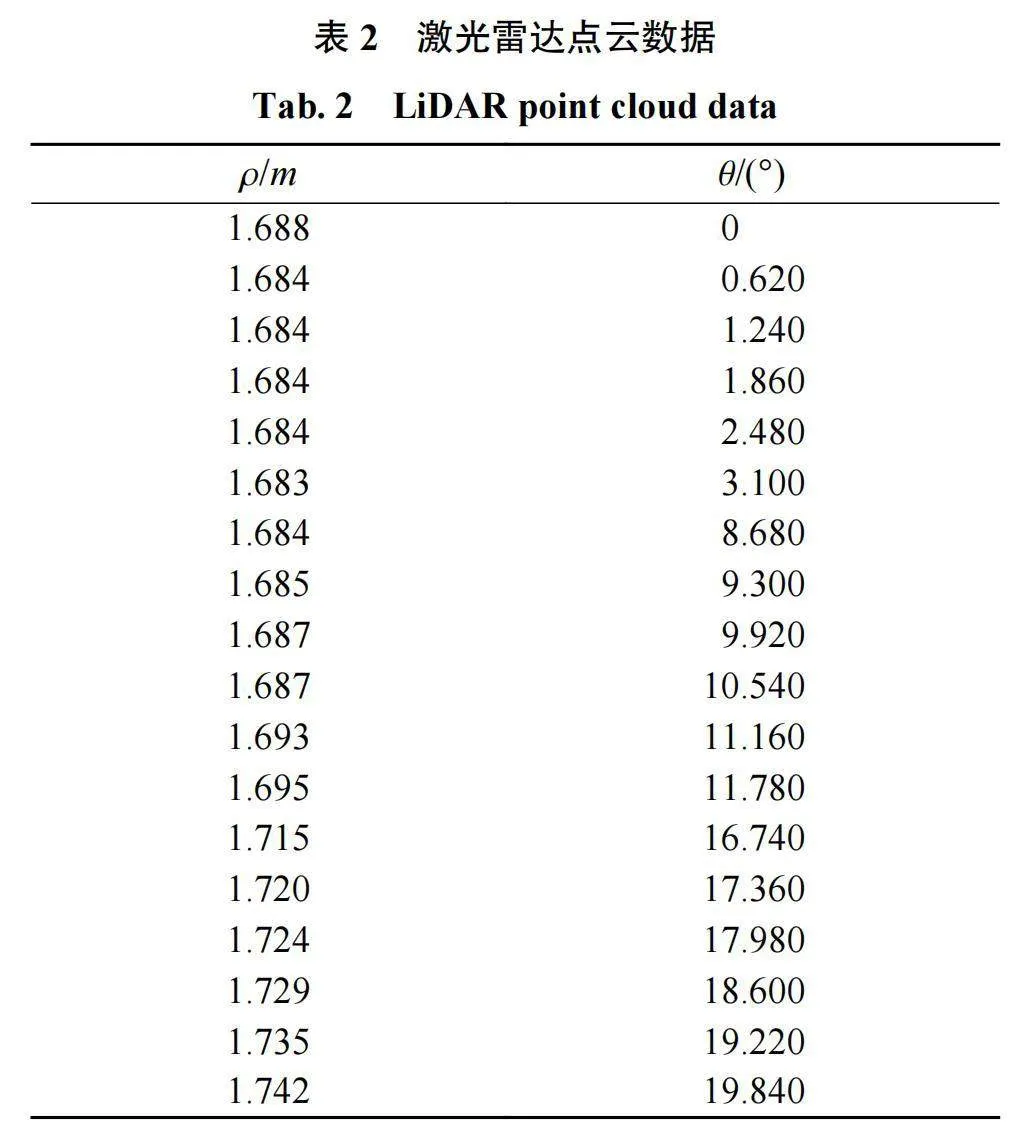

使用Delta–1A激光雷达扫描设计的新型标靶,激光雷达会在标靶形成1条扫描线,且能够读取相应的距离(ρ)和角度(θ)信息,通过调整激光雷达位置,使落在标靶最左侧的角度为0°,激光雷达点云数据如表2。在标靶标定实验的基础上,为使相机与激光雷达获得较好的共同视野范围,同时为方便采集数据,调整激光雷达位置,测得激光雷达安装高度为0.29m,标靶距离激光雷达1.66m。

通过对激光雷达点云数据进行提取处理,形成在标靶上的扫描结果,如图12。从图12看出激光雷达在标靶镂空与非镂空部分边缘留下扫描点,留下的扫描点即为激光雷达在标靶上的特征点,这些特征点如如表3。

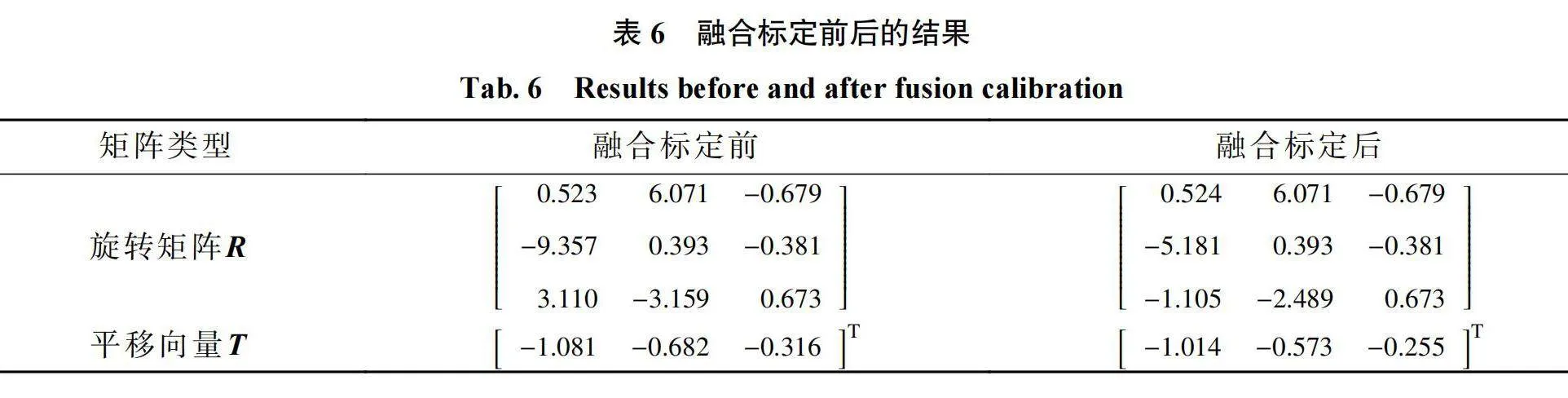

利用2.3融合标定方法,并结合式(8),(9),(12)对表3所示的激光雷达特征点进行坐标系转换,其在雷达坐标系、标靶坐标系、相机坐标系及像素坐标系对应的数据如表4。

利用最小二乘法对激光雷达在标靶上留下的扫描特征点进行直线拟合,结果如图13。由图13看出:直线的拟合系数R2为0.9921,且没有误差较大点,表明拟合效果好。

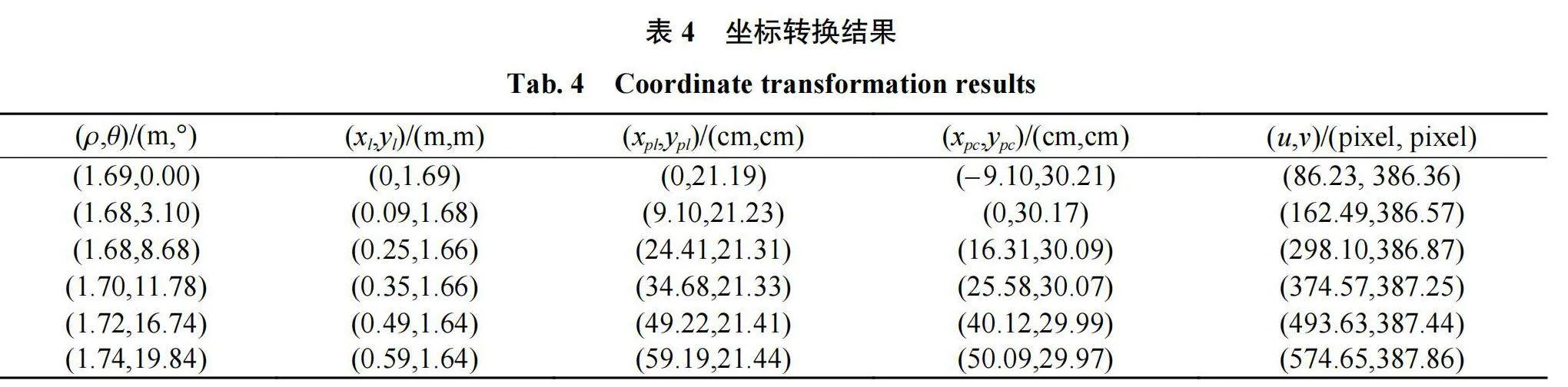

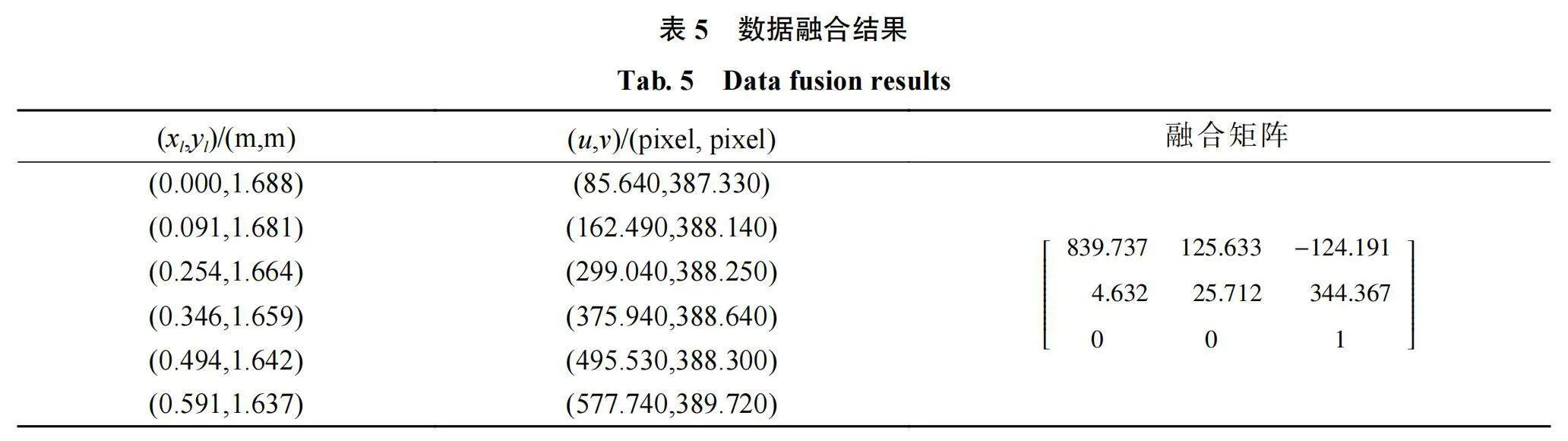

得到的直线方程为y=0.00426x+21.19301,根据式(5),(7),(10)分别计算得到俯仰角δ=2.65°,侧倾角α=1.63°和偏转角Y=0.23°。根据表4坐标转换的结果,可得到6组对应的激光雷达点云和像素点,通过式(13)计算可得数据融合的结果,如表5。

利用融合得到的矩阵对激光雷达点云进行重投影误差计算,得到重投影后的像素点,通过式(15)计算实际像素点与重投影后像素点之间的误差,判定标定精度。激光雷达的点云坐标在图像上的投影误差如图14。由图14可看出:激光雷达点云的最大重投影误差为3.7pixel、最小重投影误差为1.0pixel,其中有12组分布在1.0~2.0pixel区间,18组平均重投影误差为1.9pixel、标准差为0.7pixel;个别像素特征点误差偏大,但绝大多数特征点在平均重投影误差附近,因此个别像素特征误差对整体影响不大。

据投影到标靶图像中,结果如图15。由图15可见:激光雷达点云能够与标靶图像相匹配,相机和激光雷达传感器之间的配准较好;传感器之间的相对位置和姿态关系被准确估计和校准,可确保在投影过程中的对应关系正确。

融合标定前后的对比结果如表6。结合图14和表6可看出:融合标定方法的平均重投影误差为1.9pixel,而传统标定误差多在2.0pixel内;融合标定方法只需6组对应的激光雷达点云和像素点就可获得融合矩阵,并能得出所需的旋转矩阵R和平移向量T,融合标定前后参数基本一致。由此表明:提出的标定方法在保证标定精度的前提下,只需较少的特征点就能计算出外部参数,标定过程简便,验证根据计算的重投影像素点,将激光雷达点云数了融合矩阵的有效性。

综上可看出:本文提出的融合标定方法在保证标定精度的前提下,可有效改善单线激光雷达和相机之间的外参标定速度慢、实时性无法满足要求的问题。

4结论

针对单线激光雷达和相机之间的外参标定速度慢、实时性差的不足,提出1种相机与激光雷达数据融合标定方法。设计1种新型的标靶,采用镂空的直角三角形,用于获取激光雷达在标靶上的点云特征点和图像平面上对应的像素点;采用特征点法得到融合矩阵,并通过融合矩阵计算出外参。仿真实验结果表明:与传统标靶相比,新型标靶的标定时间减少了31.4%,可较大程度地提高标定速度;融合标定的平均重投影误差为1.9pixel、标准差为0.7pixel,且融合标定前后得到的参数基本一致,采用提出的标定方法只需较少的激光雷达点云和像素点就可获得外参,标定过程简便。但本文方法的像素特征点重投影误差还有待进一步降低,下一步研究可通过将相机采集的像素特征点进行特定筛选,进一步提高标定精度。

参考文献:

[1]刘今越,唐旭,贾晓辉,等.三维激光雷达-相机间外参的高效标定方法[J].仪器仪表学报,2022,40(11):64−72.

[2]吕申龙,时东锋,胡顺星.基于稀疏采样技术的激光雷达三维成像方法研究[J].量子电子学报,2018,35(1):95−101.

[3]XU R.Path planning of mobile robot based on multi-sensor information fusion[J].EURASIP Journal on Wireless Communications and Networking,2019,2019(1):1−8.

[4]刘振,王甦菁,李擎.一种3D激光雷达和摄像机的联合标定方法[J].现代电子技术,2019,42(18):18−21.

[5]许小徐,黄影平,胡兴.智能汽车激光雷达和相机数据融合系统标定[J].光学仪器,2019,41(6):79−86.

[6]黄志清,苏毅,王庆文,等.二维激光雷达与可见光相机外参标定方法研究[J].仪器仪表学报,2020,41(9):121−129.

[7]KOLHATKAR C,WAGLE K.Review of SLAM algorithms for indoor mobile robot with lidar and RGB−D camera technology[C]//Innovations in Electrical and Electronic Engineering:Proceedings of ICEEE.Antalya,Türkiye:ICEEE,2020:397−409.

[8]代天赐.汽车ADAS系统传感器联合标定技术研究[D].马鞍山:安徽工业大学,2022.

[9]LI Z,JIANG C,GU X,et al.Collaborative positioning for swarms:a brief survey of vision,lidar and wireless sensors based methods[J].Defence Technology,2024,33:475−493.

[10]付瑶.激光雷达、IMU联合标定及实时点云建图方法研究[D].北京:北京建筑大学,2023.

[11]ALAI H,RAJAMANI R.Low-cost camera and2D LiDAR fusion for target vehicle corner detection and tracking:applications to micromobility devices[J].Mechanical Systems and Signal Processing,2024,206:110891.

[12]WANG Q,YAN C,TAN R,et al.3D-cali:automatic calibration for camera and lidar using3D checkerboard[J].Measurement,2022,203:111971.

[13]DENG J,HU Z,LU Z,et al.Fusioncalib:automatic extrinsic parameters calibration based on road plane reconstruction for roadside integrated radar camera fusion sensors[J].Pattern Recognition Letters,2023,176:7−13.

[14]代军,李文波,赵俊伟,等.基于单目相机和多线激光雷达的联合标定方法研究[J].河南理工大学学报(自然科学版),2024,43(2):137−146.

[15]武鹏柯,冷星环,武建龙,等.一种基于关键点的相机雷达联合标定方法[J].农业装备与车辆工程,2023,61(11):58−62.

[16]谢婧婷,蔺小虎,王甫红,等.一种点线面约束的激光雷达和相机标定方法[J].武汉大学学报(信息科学版),2021,46(12):1916−1923.

[17]PAN Z,LI K,DENG H,et al.Obstacle recognition for intelligent vehicle based on dadar and vision fusion[J].International Journal of Roboticsamp;Automation,2021,36(3):178−187.

[18]NENASHEV VA,SHEPETA AP,KRYACHKO AF.Fusion radar and optical information in multiposition on-board location systems[C]//2020Wave Electronics and its Application in Information and Telecommunication Systems(WECONF).St Petersburg,Russia:IEEE,2020:1−5.

[19]PENG CW,HSU CC,WANG WY.High-accuracy lane geodetic coordinates extraction based on camera-lidar fusion[C]//2023IEEE International Conference on Consumer Electronics(ICCE).Las Vegas,NV,USA New

York:IEEE,2023:1−2.

责任编辑:何莉