融合CNN和Transformer的并行双分支皮肤病灶图像分割

摘 要:准确的皮肤病变自动分割对于协助医生临床诊断和治疗至关重要。针对现有卷积结构能提取局部特征信息但无法建模长程依赖关系,而Transformer能提取全局上下文信息但存在细节信息丢失的问题,提出了一种融合CNN和Transformer的并行多尺度自动分割网络PDTransCNN。首先以基于ResNet34的CNN分支和Transformer分支并行提取皮肤病图像的特征信息,构建多级局部相关性和捕获上下文信息间的长距离依赖关系;其次利用特征融合模块FM互补两分支特征间的关键信息,增强语义信息间的依赖关系;最后采用Transformer解码单元逐步融合编码块和融合单元所提取到的语义信息得到最终分割结果。该模型在ISIC2016、ISIC2017和ISIC2018数据集上进行测试,其Dice系数分别高达91.72%、87.34%和90.01%,IoU值分别为85.6%、79.55%和83.67%。实验结果表明,PDTransCNN相比其他分割模型具有更好的分割性能,能清晰有效地分割皮肤病变图像。

关键词:皮肤病变; 医学图像分割; CNN; Transformer; 特征融合

中图分类号:TP391 文献标志码:A

文章编号:1001-3695(2024)08-044-2554-07

doi:10.19734/j.issn.1001-3695.2023.10.0600

Parallel dual-branch image segmentation of skinlesions fusing CNN and Transformer

Tao Xiting, Ye Qing

(School of Computer Science, Yangtze University, Jingzhou Hubei 434000, China)

Abstract:Accurate automatic segmentation of skin lesions is crucial to assist physicians in clinical diagnosis and treatment. Aiming at the problem that convolutional structure can extract local feature information but cannot model long-range dependencies, while Transformer can extract global context information but suffers from the loss of detail information, this paper proposed a parallel multi-scale automatic segmentation network PDTransCNN that integrated CNN and Transformer. Firstly, it constructed multi-level local correlation and captured long-range dependencies between contextual information by extracting the feature information of dermatological images in parallel with the CNN branch based on ResNet34 and Transformer branch. Secondly, it utilized the feature fusion module(FM) to complement the key information between the two branches of features and enhance the dependencies of the semantic information. Finally, it used the Transformer decoding unit to gradually fuse the semantic information extracted from the encoding block and the fusion unit in order to obtain the final segmentation result. The model was tested on ISIC2016, ISIC2017 and ISIC2018 datasets with Dice coefficients as high as 91.72%, 87.34% and 90.01%, and IoU values of 85.60%, 79.55% and 83.67%, respectively. The experimental results show that PDTransCNN has better segmentation performance compared to other segmentation models and can segment skin lesion images clearly and effectively.

Key words:skin lesions; medical image segmentation; CNN; Transformer; feature fusion

0 引言

黑色素瘤是一种具有高度侵袭性的恶性皮肤肿瘤,产生于皮肤中的黑色素细胞。据世界卫生组织统计[1],2020年黑色素瘤病例高达325 000例,其中死亡病例约57 000例,年增长速度约3%~5%,是发病率增长最快的肿瘤之一。早期黑色素瘤外观上与痣相似,症状不明显,若病发早期及时干预治疗,其5年内存活率高达98%,而晚期黑色素瘤扩散到身体其他部位,其存活率低于15%[2],这种差异表明恶性皮肤病的早期诊断和治疗极为重要。

目前,皮肤病的检查方法大多采用安全无创的皮肤镜技术,分割皮肤病灶图像为正常区域和病变区域可为医生判断恶性皮肤病提供关键依据。然而在临床诊断中,病变区域本身情况复杂,存在图像对比度低、病变边界模糊,以及气泡、头发和标尺等不良残留物的干扰,医生根据经验诊断病灶耗时耗力且主观性强,难免出现误诊和漏诊的情况。因此,辅助医生评估和诊断的皮肤病灶区域自动分割方法被广泛研究,在临床领域具有极高的应用价值。

传统的皮肤病分割方法是基于纹理和结构等物理特征的,只提取了图像的表层信息,如基于阈值[3]、基于区域[4]、基于边缘的分割算法等,依赖于手工设计特征,无法刻画图像丰富的内在信息,易受毛发、噪声等干扰因素影响,分割效果有待提高。

近年来,随着深度学习技术的兴起,基于卷积神经网络的一系列架构应用于图像分割领域。Long等人[5]提出了全卷积神经网络,端到端的编解码结构首次实现了像素级别的图像分割。2015年,在该架构基础上,Ronneberger等人[6]提出具有跳跃连接的编解码U型网络(U-Net),编码器与解码器完全对称用于特征提取,编解码器之间的跳跃连接实现了浅层特征和深层特征的融合,辅以医学图像独特的结构特点,该模型成为医疗分割领域的最佳模型之一。在这之后,医学图像的分割算法大多是基于U-Net的结构变体,如U-Net++[7]、Attention U-Net[8]等。Tang等人[9]提出在上下文过程中采用多阶段U-Net,配合深度监督机制实现端到端的精准皮肤分割。Double U-Net[10]通过两级嵌套的U型结构细化分割结果,并引入ASPP模块获取不同尺度的感受野和多尺度信息,用于解决皮肤病灶区域大小各异的问题。王雪等人[11]在U-Net中引入多尺度特征融合模块来获取皮肤病变区域的多尺度信息。梁礼明等人[12]构造双U型皮肤病分割算法,粗分U型网络和细分U型网络分别提取图像的粗粒度特征和细粒度特征,增强特征学习能力。卷积分割模型不断改善优化,但受限于卷积固有的归纳偏置,模型感受野有限,难以获取全局上下文信息,缺乏长距离依赖。而全局信息关系到皮肤病灶的定位,背景与像素之间的长距离依赖对医学图像的精细级分割至关重要。

自然语言处理领域的Transformer模型可编码远程依赖关系,用于解决卷积架构的感受野局限性。Dosovitskiy等人[13]提出的ViT模型首次将Transformer应用于图像识别领域,其主要任务是分类,无法解决分割任务中的像素级密集预测问题。2021年提出的Swin-Transformer[14]可用作各类视觉任务中的通用骨干网络架构,包括图像分类、图像分割和目标检测等具体任务。采用移动窗口多头注意力,代替原有多头注意力获取非局域窗口之间的信息交互,使计算复杂度随图像大小线性增长,降低平方级增长的计算量。

虽然Transformer能建模全局上下文,但对细粒度信息的提取具有局限性。为同时具备CNN的局部细节提取能力和Transformer的全局信息建模能力,多数策略是将CNN和Transformer合并研究。Chen等人[15]提出的TransUNet模型,整体结构由CNN和Transformer混合而成,利用CNN提取浅层特征并将提取的特征图输入Transformer编码全局信息,在多器官分割和皮肤病变分割任务中取得优异成绩。Zhang等人[16]融合并行CNN分支和Transformer分支,将CNN提取的不同分辨率特征图与Transformer上采样特征图像结合以捕获皮肤病灶对等特征。梁礼明等人[17]提出多尺度Transformer的U型编解码皮肤病分割网络,分层编码器获取图像的粗细粒度特征信息,融合解码器利用皮肤病灶的多尺度特征信息来生成分割结果。普钟等人[18]利用基于Transformer的双通道融合模块代替U型网络中的跳跃连接,减轻Transformer和CNN编解码器间的语义差异。结果表明此种架构可获得更精准的分割结果,现有皮肤病分割工作大多采用卷积代替部分Transformer层或按顺序堆叠两者,未考虑两者空间和位置的相关性及两者特征融合时的信息缺失或冗余。

为解决上述问题,针对现有皮肤病分割方法的局限,从局部信息提取、上下文信息建模和特征融合角度进行研究,提出了一种基于CNN和Transformer的并行双分支皮肤病分割网络(parallel dual-branching Transformer-CNN,PDTransCNN)。该架构首先分别运行基于CNN和Transformer的编码器分支,用于特征提取和捕获长距离信息,接着是提出的特征融合模块(fusion module,FM)在不同层次上获取多尺度融合特征,跳跃连接获取的多尺度融合特征和编码器上下文信息的同时,将其输入基于Transformer的解码器分支中,得到最终分割结果,提升分割精度。

本文主要贡献如下:

a)为有效利用不同深度学习模型的优势,提出了结合CNN和Transformer两个深度学习模型来构建并行双分支编码器。CNN编码器以ResNet34为骨干网络提取上下文局部信息,Transformer编码器在Transformer基础上添加局部模块LU来捕获patch内部的局部关系和结构,Enchanced MLP代替MLP层区分特征并捕获长距离依赖。

b)针对特征融合,提出多尺度特征融合模块FM获取皮肤病灶的多尺度信息,利用空间注意力单元、通道注意力单元和全局-局部卷积相关性单元,融合来自两个分支不同分辨率的特征,将生成的三个特征图及掩码图像进行跨域融合得到不同域的多尺度融合特征。

c)Transformer解码器逐步融合来自上下文和跳跃连接两条路径的特征,增强特征表示能力。采用深度监督策略获取阶段及最终分割结果,构建损失函数。

d)为评价提出的PDTransCNN模型,使用不同分割模型在ISIC2016、ISIC2017、ISIC2018三个公开皮肤病数据集上进行对比实验,结果验证了该方法的有效性,取得了较好的分割结果。

1 方法

医学图像分割实质是像素级分类任务,同时获取皮肤病灶的全局和局部信息是提升分割性能的关键。CNN受限于固定的卷积核,感受野有限,无法建模全局信息,Transformer的自注意力机制通过计算可得全局上下文信息,但在切分和拉伸patch过程中易丢失内部信息。本文提出将ResNet34作为CNN骨干,结合Transformer模型构建双分支网络,融合来自双分支提取的特征,提高模型表达能力。在这部分,首先说明PDTransCNN的总体结构,然后介绍两个分支的工作流程,之后阐述两分支的特征融合模块FM如何融合和提取信息,最后简要说明解码过程。

1.1 框架总体

图1展示了本文模型的整体结构,针对皮肤图像的数据特点,模型由两个并行的分支组成。CNN分支中直接输入图像,逐渐增加感受野并提取局部信息。Transformer分支首先将皮肤病图像划分为若干个小的切片,再将切片展平成一个序列,通过线性映射层变换维度后,进入improved Transformer块提取全局信息并对特征图进行下采样。然后用FM模块整合两个分支上对应分辨率的特征图及掩码图像,将生成的融合特征图及编码后的特征图拼接馈送到Transformer解码器中,变形和上采样提取的特征图用于解码,得到输出特征图,并与两阶段的输出特征图按比例划分创建总损失函数,实现分割信息的补充。

1.2 Transformer分支-编码器

皮肤病灶分割存在整体定位和细节获取两个挑战,目标整体定位的关键是利用全局信息突出特征对象,而传统U-Net模型只运用卷积提取特征,感受野局限导致无法提取全局信息并造成特征丢失情况。基于此,使用能获取全局上下文特征的Transformer块代替卷积构建Transformer编码器分支。

对于Transformer分支,如图1所示,输入图像大小为x0∈Euclid ExtraaBpC×H×W,其中C、H、W分别表示输入图像的通道数、高度和宽度。首先将图像划分为N=HM×WM个小切片,其中M表示切片的尺寸,每个切片的形状为C×M×M。切片划分好后,将切片块展平为一个序列,进入输出维度为D的线性映射层,得到原始序列向量x∈Euclid ExtraaBpN×D,这里的维度D取值为64。

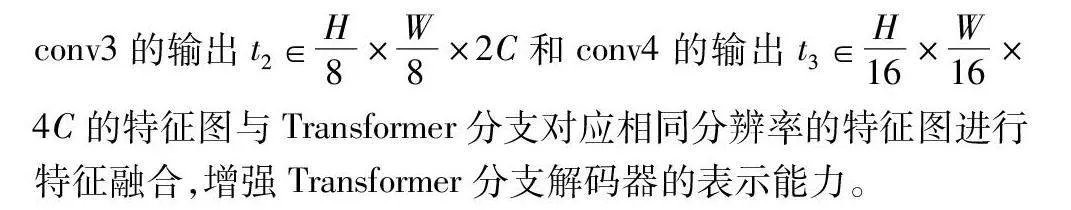

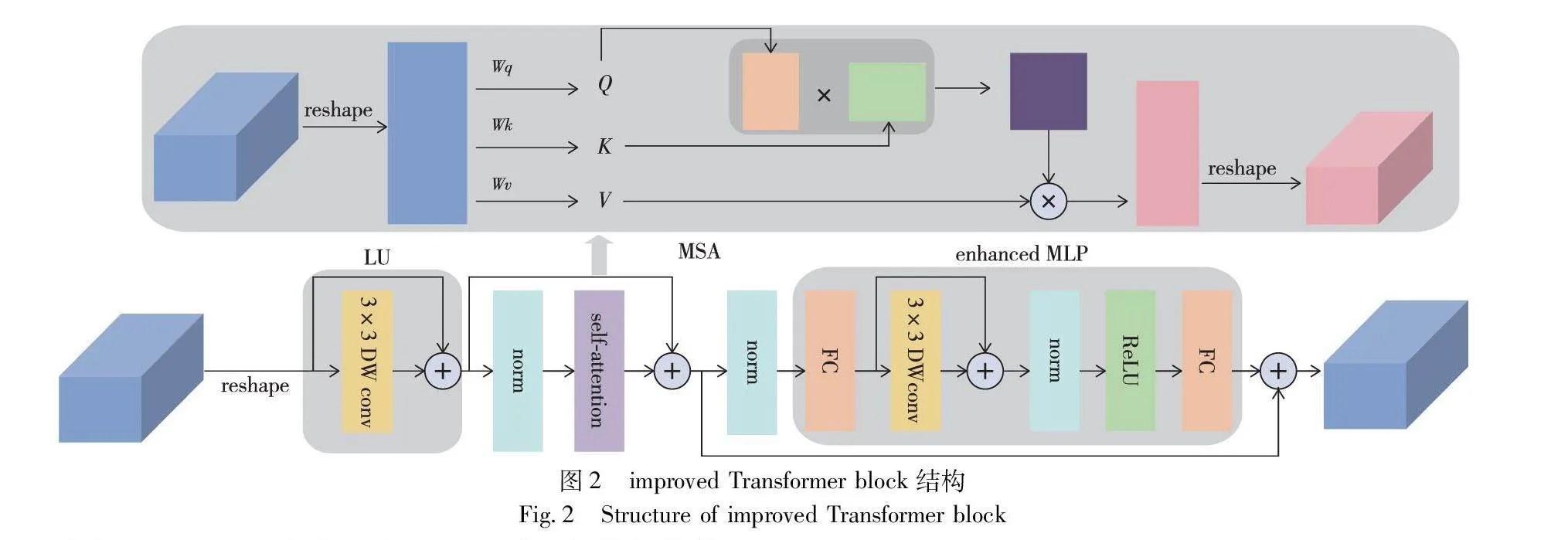

如图2所示,improved Transformer block包含局部模块(local unit,LU)、L层多头自注意力(multi-head self-attention,MSA)和增强多层感知机(enchanced multi-layer perception,Enchanced MLP)。LU模块利用DW卷积和残差结构获取切片内部信息,增强特征表达能力。自注意力中缺乏位置信息,Enchanced MLP模块对齐并区分提取特征,在前馈网络中引入深度卷积传递位置信息,在深度卷积之前应用残差连接,在连接后运用层归一化,可用式(1)(2)表示:

x′in=DWConv(FC(xin))+FC(xin)(1)

xout=FC(ReLU(LN(x′in)))(2)

所以说第L层的总输出Zl可用式(3)~(5)表示:

z′l-1=DWConv(zl-1)+zl-1(3)

z′l=MSA(LN(z′l-1))+z′l-1(4)

zl=EnchancedMLP(LN(z′l))+z′l(5)

其中:DWConv(·)代表卷积核为3×3的深度卷积操作;FC(·)代表线性映射;ReLU(·)代表使用ReLU激活函数进行非线性变换和梯度传播,LN(·)代表层归一化操作。最后improved Transformer层的输出序列向量为zl∈Euclid ExtraaBpN×D,将其变形为zl∈Euclid ExtraaBpH4×W4×D。

常用的patch merging操作忽略了patch块之间的相关性,导致patch周围特征的丢失。本文使用overlap patch merging模块对特征图下采样,在切分patch时,让每个patch之间存在重叠部分,其操作类似于卷积核在特征图上的移动,通过修改K、S、P三个参数的值控制特征图的分辨率,K表示patch的大小,S表示相邻patch间的距离,P表示填充的大小。每次合并操作后,特征图的尺寸减半,通道数翻倍。

根据空间分辨率,Transformer分支的编码器部分可分为四个阶段。第一阶段由patch嵌入层和两个improved Transformer块组成;第二至第四阶段由用于下采样的overlap patch merging块及提取长程依赖关系的improved Transformer块构成,每阶段improved Transformer块的数量分别为2、6、2。四个阶段中,每阶段的输出特征图分别用g1、g2、g3和g4表示,其大小分别为H4×W4×C、H8×W8×2C、H16×W16×4C、H32×W32×8C。保存四个不同分辨率的特征图,以便后续与CNN分支对应特征图的融合。

1.3 CNN分支

CNN分支通过ResNet34的编码块创建特征提取网络,实现高分辨率图像到低分辨率图像的转换。经过预训练的ResNet34自然特征丰富,能为皮肤病灶的分割提高初始权重,获取皮肤图像局部上下文特征和丰富的空间细节信息。如图1所示,conv1表示使用7×7的卷积核提取信息并修改通道数,然后依次经过ResNet34的三个块conv2、conv3和conv4,每个块都将特征图下采样2倍,将conv2的输出t1∈H4×W4×C、conv3的输出t2∈H8×W8×2C和conv4的输出t3∈H16×W16×4C的特征图与Transformer分支对应相同分辨率的特征图进行特征融合,增强Transformer分支解码器的表示能力。

1.4 特征融合模块

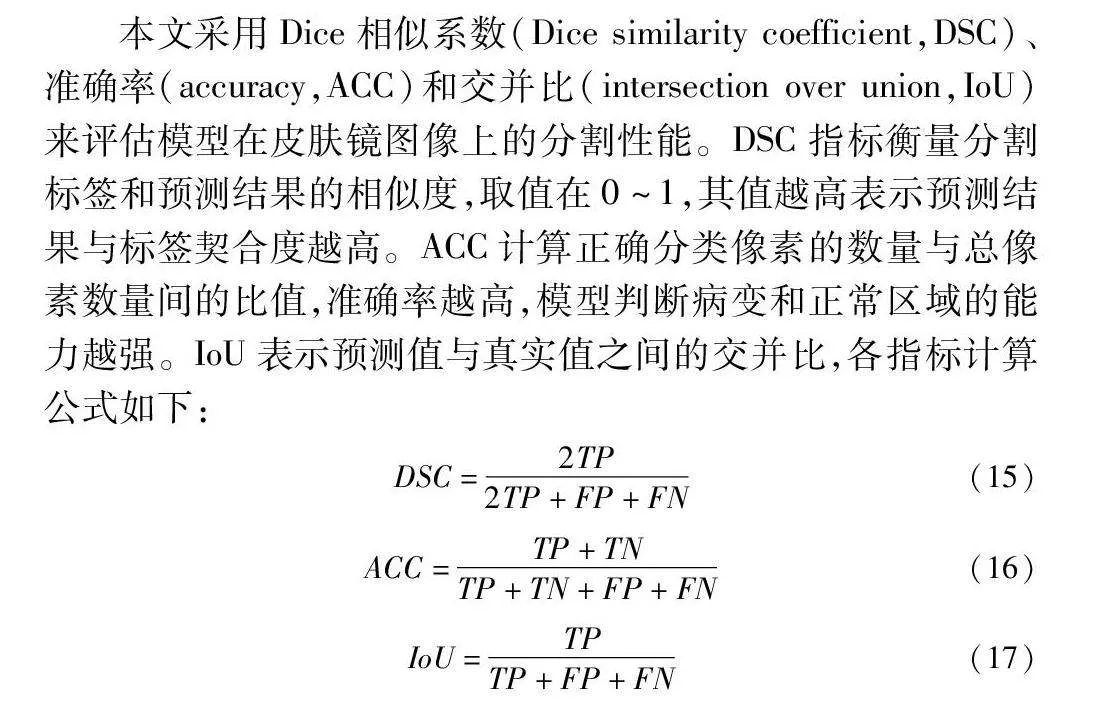

考虑到皮肤病变分割目标尺度各异、形状多变复杂,同时一些病灶边缘模糊且伴有毛发遮挡的问题,需充分结合来自Transformer分支和CNN分支的全局和局部特征信息,因此本文提出一个特征融合模块FM,有效融合不同分辨率的特征细节信息。该模块设计了通道注意力单元(channel attention unit,CAU)、空间注意力单元(spatial attention unit,SAU)、全局-局部卷积相关性单元(global-local conv unit,GLCU)和组跨域融合单元(group cross-domain unit,GCU)四个小模块,如图3所示。

第一块是通道注意力单元(CAU),将来自Transformer编码器分支的输出特征gi作为该模块的输入,用于获取特征图不同通道的重要程度,找到特征图关键通道上的重要信息并抑制其他通道的无关信息,提高特征表示能力。同时improved Transformer块中使用自注意力建模长距离依赖,将CAU应用于Transformer分支,相当于实现自注意力和通道注意力的混合,丰富注意力特征图的细节信息,缓解皮肤镜图像低对比度、颜色差异相近产生的噪声干扰。CAU的实现为文献[19]提出的SE-Block模块,包含压缩和扩张两部分,压缩部分将输入特征图gi∈Euclid ExtraaBpCi×Hi×Wi经过全局平均池化变换维度为Ci×1×1。扩张部分使用两个全连接层(FC),经过第一个FC层将通道数变换为Cg/r,r代表压缩比,设置为16,经过ReLU激活函数激活相关性大的有效通道后进入第二个FC层恢复原始通道数Cg,通过sigmoid函数进行不同通道间的非线性映射,与原始输入特征图相乘得到加权后的通道注意力特征图gi′。

第二块是空间注意力单元(SAU),浅层CNN特征存在噪声,将来自CNN分支的输出特征ti作为该模块的输入,加权特征图的空间位置,抑制背景噪声的影响,增强局部边界细节特征信息。采用文献[20]提出的CBAM模型中的空间注意力模块,将输入特征图ti∈Euclid ExtraaBpCi×Hi×Wi沿通道轴进行最大池化和平均池化操作,产生两个大小为1×Hi×Wi的通道注意力图,并将它们在维度方向上拼接。然后利用7×7的卷积操作获取特征之间的空间关系以便学习关键位置的重要信息,经过sigmoid函数后与初始特征图相乘得到空间注意力图ti′,如式(6)所示。

ti′=sigmoid(conv7×7 (AvgPool(ti)+MaxPool(ti)))ti(6)

第三块是全局-局部卷积相关性单元(GLCU),目前处理两个特征图时,大多采用单一的加或乘操作,忽略了特征图之间的对应关系和相关性。如图3所示,GLC是GLCU的子模块,将输入划分为两个部分,这两部分唯一不同之处在于通过逐点卷积交互空间位置前,一部分利用全局平均池化聚合了空间信息。将生成的特征图经过sigmoid函数后与初始图像对应元素相乘形成残差结构,如式(7)(8)所示。

convx(x)=LN(conv(ReLU(LN(conv(x)))))(7)

GLC(x)=xsigmoid(convx(GAP(x))⊕convx(x))(8)

其中:LN(·)表示批归一化操作;GLC(x)表示GLC模块的输出结果;表示对应元素相乘;⊕表示对应元素相加。给定分别来自CNN、Transformer分支的特征图gi、ti∈Euclid ExtraaBpCi×Hi×Wi,经过加权平均自适应生成融合了gi和ti关键信息的特征图mi′,如下所示。

mi=GLC(ti⊕gi)gi+(1-GLC(ti⊕gi))ti(9)

mi′=GLC(mi)gi+(1-GLC(mi))ti(10)

第四块是组跨域融合单元(GCU),通过分组聚合不同层次的特征,有效集成不同关键特征用于多尺度特征融合。GCU有四个输入:空间注意力特征图、通道注意力特征图、融合相关性特征图和解码器阶段产生的掩码图像。解码器每阶段的输出经过卷积产生对应的掩码图像协助多尺度特征融合。将三个特征图都沿通道轴分为四块,每组连接各个特征图的一块并级联掩码图像,获得四组融合特征。各组利用不同的扩张速率(1,2,5,7)提取不同尺度信息。拼接四组并使用1×1卷积生成跨域融合特征图,增强来自不同域的特征并实现特征间的交互。

1.5 Transformer分支-解码器

解码器由三个阶段组成,每阶段堆叠上采样、跳过连接和improved Transformer块。编码器第四阶段的输出作为解码器的输入d∈H32×W32×8C。解码器的每个阶段,首先将输入特征2倍上采样,然后利用跳过连接级联来自FM模块的相同分辨率的融合特征,并将连接后的特征馈送到解码块,在解码器中实现上下文交互并创建长距离依赖。三个阶段的输出分别为d1∈H16×W16×4C,d2∈H8×W8×2C,d3∈H4×W4×C,最后使用扩展率为4的上采样操作恢复图像大小,并通过卷积调整通道数,为分割类别数获得最终预测结果S1。

1.6 损失函数

本文采用加权IoU损失函数LIoU和二进制交叉熵损失函数LBCE进行模型训练,并使用深度监督方法额外监控Transformer编码器分支第四阶段的输出S2和FM第三融合阶段的输出S3,辅助模型训练学习,改善梯度流,最终的损失函数公式如式(11)~(14)所示。

LBCE=-[ylogy′+(1-y)log(1-y′)](11)

LIoU=1-yy'y+y'-yy'(12)

L=LIoU+LBCE(13)

Loss=αL(y,S1)+βL(y,S2)+γL(y,S3)(14)

其中:y表示真实分割标签图像;y'表示模型预测值;α、β、γ作为超参数表示不同阶段的权重,设置为0.5、0.3、0.2。

2 实验和结果分析

2.1 实现方法

PDTransCNN模型以待分割皮肤病灶图像为输入,以训练完成的网络模型作为输出,i表示不同阶段,具体实验步骤如下:

a)Transformer分支特征提取,将输入图像映射为嵌入向量,利用自注意力机制建模获取全局上下文信息gi,详细实现过程参见1.2节。

b)CNN分支特征提取,基于ResNet34组成的CNN特征提取网络获取皮肤图像丰富的局部信息ti,详细实现过程参见1.3节。

c)多尺度特征融合,为有效结合CNN分支和Transformer分支的编码特征,利用通道注意力增强gi特征表示能力,空间注意力增强ti局部细节信息,并利用卷积相关性单元加强两特征图之间的对应关系,分组集成关键特征来获取多尺度特征融合图fi,详细实现过程参见1.4节。

d)特征融合图fi与全局上下文特征图gi拼接后通过Transformer解码器逐步上采样,并将每阶段解码结果通过卷积生成对应掩码送入步骤c)的下阶段特征融合模块,采样至原始图像大小获取最终分割图像Si,详细实现过程参见1.5节。

e)构建损失函数计算真实值和分割图像Si的差值,并反向传播训练模型,计算评价指标。直至训练次数达标,获取训练好的模型,详细实现过程参见1.6节。

2.2 数据集和实验设置

为验证本文网络结构,在国际皮肤成像协会(The International Skin Imaging Collaboration,ISIC)发布的ISIC2016[21]、ISIC2017[22]和ISIC2018[23]三个公共数据集上进行综合实验。ISIC2016数据集包含900张训练图片和379张测试图片,将训练图片按8∶2划分为训练集和验证集。ISIC2017数据集包含2 750张图片,其中训练图片2 000张,验证图片150张,测试图片600张。ISIC2018数据集包含2 594张训练图片、100张验证图片和1 000张测试图片。每组数据都包含原图像和经专家手动标注的分割标准图像,图像分辨率都在450pi×600pi以上,本文统一将所有图像重塑为224pi×224pi大小,并通过翻转、剪裁等数据增强操作增加数据多样性。

所有实验基于PyTorch深度学习框架,处理器CPU为Intel Xeon Gold 5120,内存容量32 GB,显卡为NVIDIA GRID T4-16Q,操作系统为Windows 10,实验仿真平台为SageMaker Studio Lib,开发工具为PyCharm 2022.1.2社区版,编程语言为Python 3.8。训练过程中使用Adam算法优化模型,初始学习率为7E-5,一阶和二阶矩估计的指数衰减率分别为0.5和0.999,权重衰减为1E-5,实验进行25轮迭代,批处理大小设置为16。

2.3 评价指标

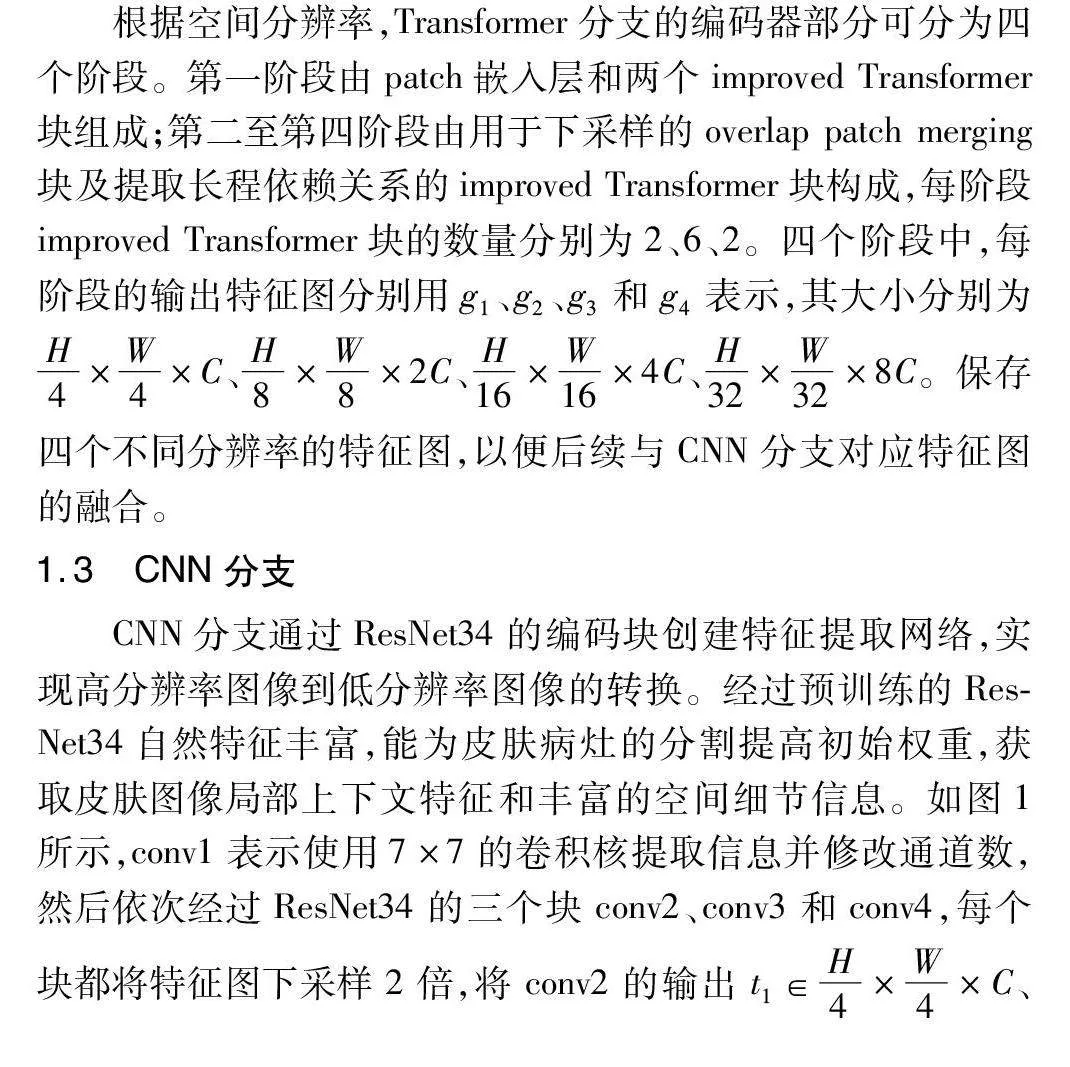

本文采用Dice相似系数(Dice similarity coefficient,DSC)、准确率(accuracy,ACC)和交并比(intersection over union,IoU)来评估模型在皮肤镜图像上的分割性能。DSC指标衡量分割标签和预测结果的相似度,取值在0~1,其值越高表示预测结果与标签契合度越高。ACC计算正确分类像素的数量与总像素数量间的比值,准确率越高,模型判断病变和正常区域的能力越强。IoU表示预测值与真实值之间的交并比,各指标计算公式如下:

DSC=2TP2TP+FP+FN(15)

ACC=TP+TNTP+TN+FP+FN(16)

IoU=TPTP+FP+FN(17)

其中:TP表示真阳性,代表病灶区域被正确分割;FN表示真阴性,代表正常区域被正确分割;FP表示假阳性,代表正常区域误分割为病灶区域;FN表示假阴性,代表病灶区域误分割为正常区域。

2.4 分割结果

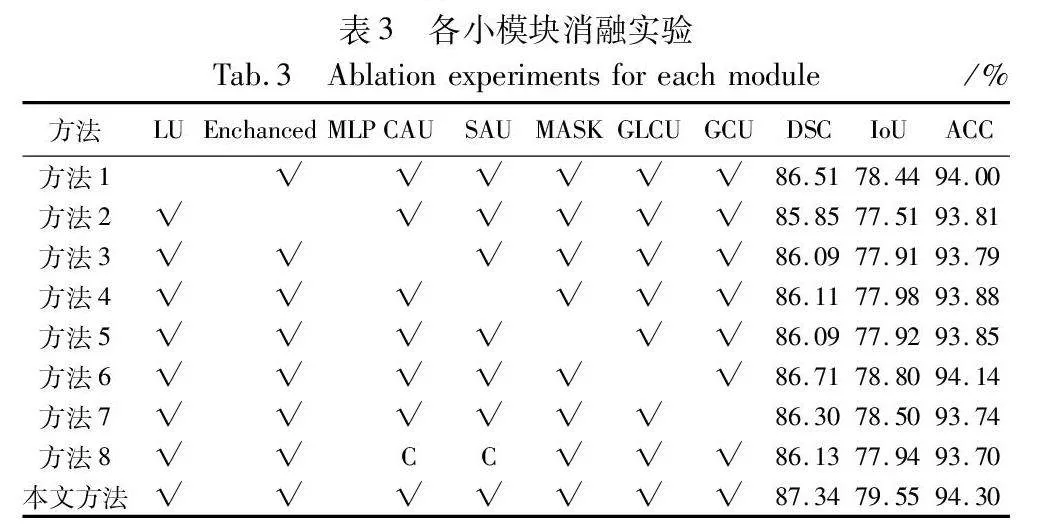

为验证本文模型PDTransCNN的有效性,根据上述训练设置参数和相同配置环境,选取U-Net、U-Net++、Attention U-Net、CE-Net[24]、TransU Net、UTNet[25] 、SegFormer[26]、Swin-UNet[27]、UNeXt[28]、MALUNet[29]、UCTransNet[30]、DCSAU-Net[31]、EGE-UNet[32]等语义分割基础网络和医学分割先进方法在ISIC2016、ISIC2017、ISIC2018三个皮肤病公开数据集上进行对比实验,不同网络预测的分割性能指标如表1、2所示。

从表1可得在ISIC2017数据集上本文网络PDTransCNN分割性能优异,在DSC、IoU和ACC指标上性能较好,分别达到87.34%、79.55%和94.30%。U-Net、U-Net++等模型是基于U形结构构建的,可捕获局部上下文信息和定位像素,但其缺乏全局信息,TransUNet、Swin-UNet等模型利用了Transformer建立长距离特征依赖关系,获取丰富的全局信息,但缺失细粒度局部信息。PDTransCNN与医学分割基础模型U-Net相比,在各项指标上分别提高了4.14、5.11和1.89百分点。比次优网络CE-Net在DSC指标上提高1.93百分点,IoU指标上提高2.32百分点,ACC指标上提升0.87百分点。相较于其他先进对比模型,PDTransCNN在三个指标中都达到最佳值,表明该模型能较为精准地区分皮肤病变区域像素和正常区域像素,其预测结果与真实值高度相似,CNN和Transformer的双向多尺度融合应用,使本文模型更好地感知并获取细节信息和关键特征,降低病变区域误分割的概率,提升分割精度。

此外,本文还对比分析了各医学图像分割模型的参数量和计算复杂度,结果如表1所示。PDTransCNN为了能提取更丰富有效的特征上下文信息,采用并行双分支结构分别获取全局和局部复杂信息,特征融合模块互补融合缺失信息,模块结构相对复杂,导致模型的参数量和计算复杂度稍高。相对于U-Net、U-Net++模型,本文参数量较高,但计算复杂度降低了3.33G和19.33G,相较于TransUNet、UCTransNet、UTNet等基于CNN和Transformer的模型,PDTransCNN参数量和计算复杂度大幅度降低,但相较于SegFormer、EGE-UNet等轻量级模型,PDTransCNN参数量和计算量指标相对较高。这是一个权衡的过程,但对于医疗领域,分割精度和准确性是至关重要的目标,增加的参数有利于提升模型分割效果。综合DSC等性能指标、参数量和计算复杂度,PDTransCNN在保持较高分割精度的同时具有适宜的参数量和计算复杂度。

表2展示了各模型在ISIC2016和ISIC2018数据集上的测试结果,其中DSC值达到91.72%和90.01%,IoU值达到85.60%和83.67%,ACC值达到95.72%和94.07%。比ISIC2016数据集上的次优网络CE-Net在各项指标上分别提升了0.41百分点、0.59百分点和0.23百分点。与ISIC2018数据集上的次优网络TransUNet相比,DSC值提升1.05百分点,IoU提升1.69百分点,ACC提升0.73百分点。PDTransCNN的分割预测结果更接近真实掩码图像。

为更直观地反映PDTransCNN相较于其他算法的优越性,图4可视化展示了14种网络在ISIC2017数据集上的分割结果,图中每行表示一例病例,每列表示使用的模型,image表示原图,mask表示专家对原图的分割结果。第三幅和第四幅病变图像中,病灶区域边缘轮廓清晰,且与正常皮肤组织区分度明显,各模型都产生良好的分割结果。在第一幅图像中,从左到右病变区域颜色逐渐变浅,浅色区域与正常区域像素差异小,边界模糊,U-Net和U-Net++未利用全局信息,导致难以定位边缘位置,其他模型都未完整分割病变区域,分割结果不完整。第二幅图像中存在毛发遮挡,且病变区域与皮肤组织颜色相近,UTNet等不能有效区分细节颜色相似的地方。第五幅和第六幅图像病变区域颜色深浅不一,存在漏检误检现象,U-NeXt、SegFormer难以获取细节特征易误分背景和病变区域。相比之下,本文模型具有获取局部细粒度信息和建模全局上下文信息的能力,同时多尺度特征融合强化特征信息,使其能较为平滑地分割病灶,皮肤边缘轮廓细节信息更加明显,漏检和误检较为轻微,分割结果更贴近真实掩码图像,但仍存在缺少部分边缘细节的情况。

2.5 消融实验

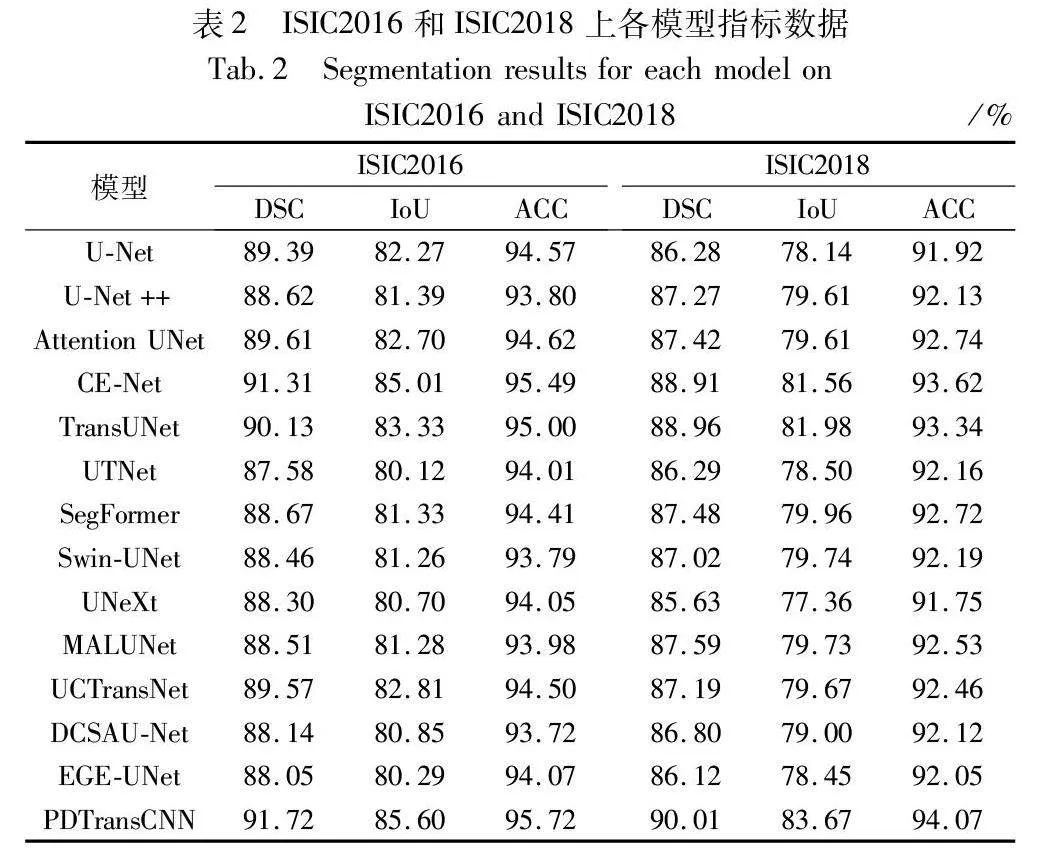

2.5.1 各模块消融实验

PDTransCNN模型共具有若干个小模块,为探讨不同小模块对模型性能的影响,利用控制变量的方法在ISIC2017数据集上进行各模块消融实验。如表3所示,方法1~9的编号分别代表添加对应模块所获得的量化指标。C表示交换通道注意力和空间注意力的输入特征为对应分辨率的CNN分支特征图和Transformer分支特征图。移除部分特征融合模块将导致高低级特征融合时丢失部分空间信息并获取无关通道信息,缺失关键的多尺度信息特征。CAU块筛选有效通道信息,掩码图像辅助特征融合,丰富特征像素。实验结果表明各模块的有效性,任一模块缺失将导致总体模型性能下降,相较于对比模型,本文方法能在皮肤病图像病灶分割上达到最好的分割效果。

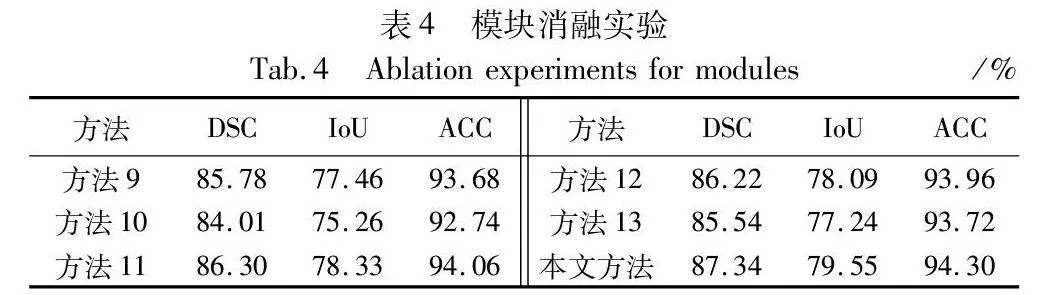

2.5.2 组合模块消融实验

表4展示了基于本文完整模型下,使用单分支及组合模块后的实验数据,默认使用深度监督机制。方法9只以ResNet34为编码器分支,方法10只以Transformer为编码器分支,方法11以CNN和Transformer并行双分支为编码器的基础上加入特征融合模块,不利用深度监督机制,方法12以CNN和Transformer并行双分支为基础加入普通卷积作为融合模块,方法13以CNN和Transformer并行双分支为基础,使用Transformer block代替improved Transformer block。由表4可知,将CNN和Transformer分支并行利用添加到PDTransformer网络中后,指标有大幅度提升,相较于单分支结构,DSC值分别提高了1.56百分点、3.33百分点,IoU值提高了2.09百分点、4.29百分点。同时学习图像的局部细节特征和全局依赖信息能实现病变区域的整体定位和边缘信息的获取。特征融合模块取代普通卷积能更好地互补高低级分辨率特征,减少图像关键信息的丢失,提取网络的深层特征和浅层特征。improved Transformer block模块利用残差思想和DW卷积提取丰富全面的特征信息,减少切片内的信息丢失。消融实验阐明了本文网络双分支结构和组合模块对于分割性能提升的有效性。

2.5.3 损失函数消融实验

为验证本文采用的目标损失函数的有效性,在本文模型结构基础上,和常用损失函数DiceLoss、IoULoss、BCELoss以及两者结合的BCEDiceLoss、IoUDiceLoss进行比较,实验结果如表5所示。本文所用的BCEIoULoss性能优于其他对比损失函数,比次优BCEDiceLoss在DSC和IoU指标上分别高出0.97百分点和1.32百分点。单独使用IoU或DSC损失函数训练,难以解决病变分割面临的正负样本不平衡问题,结合两者能综合考虑像素和区域级别的信息,缓解正负样本不平衡问题,产生最好的分割效果。

2.6 模型的应用

PDTransCNN主要应用于皮肤病灶自动分割,流程如图5所示。首先对皮肤镜图像进行预处理,包括统一图像分辨率、数据增强和图像归一化操作,使网络能更好地学习图像特征并加快收敛速度。随后将网络送入PDTransCNN模型,同时经过CNN分支和Transformer分支后,在Transformer解码器模块融合特征融合模块所提取的多尺度特征,输出各阶段皮肤病灶的分割结果并进行结果评估,最后将评估结果与初始皮肤镜图像一起显示在分割信息中。还可将训练好的模型用于新的皮肤镜图像数据,生成对应的分割信息,为后续诊断、治疗或研究提供支持。

3 结束语

为解决CNN结构存在的归纳偏置和Transformer结构的局部细节信息缺失问题,本文提出了一种用于皮肤病灶分割的融合CNN和Transformer的并行混合结构,通过并行分支对图像进行特征提取,并利用空间注意力单元、通道注意力单元和全局-局部卷积相关性单元构成强化关键特征信息的特征融合模块,交互来自两分支的细粒度特征,最大程度地利用多尺度信息。此外,采用深度监督机制构建损失函数,通过参数调整增强模型学习能力。对比13种经典的分割网络,在ISIC2016、ISIC2017、ISIC2018三个数据集上进行测试,实验证明本文网络可较好地分割皮肤病变图像,分割精度较高,在皮肤疾病的实际诊疗中有一定的参考价值。在未来的研究中,模型还存在轻量化的空间,降低模型参数量,优化模型至能实际应用到多种医学图像分割任务中。

参考文献:

[1]Sung H, Ferlay J, Siegel R L, et al. Global cancer statistics 2020: GLOBOCAN estimates of incidence and mortality worldwide for 36 cancers in 185 countries[J]. CA: a Cancer Journal for Clinicians, 2021,71(3): 209-249.

[2]Fontanillas P, Alipanahi B, Furlotte N A, et al. Disease risk scores for skin cancers[J]. Nature Communications, 2021, 12(1): 1-13.

[3]Yen J C, Chang F J, Chang S. A new criterion for automatic multilevel thresholding[J]. IEEE Trans on Image Processing, 1995, 4(3): 370-378.

[4]Tremeau A, Borel N. A region growing and merging algorithm to color segmentation[J]. Pattern Recognition, 1997, 30(7): 1191-1203.

[5]Long J, Shelhamer E, Darrell T. Fully convolutional networks for semantic segmentation[C]//Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ: IEEE Press, 2015: 3431-3440.

[6]Ronneberger O, Fischer P, Brox T. U-Net: convolutional networks for biomedical image segmentation[C]//Proc of the 18th International Conference on Medical Image Computing and Computer-Assisted Intervention. Cham: Springer, 2015: 234-241.

[7]Zhou Zongwei , Siddiquee M M R, Tajbakhsh N, et al. U-Net++: a nested U-Net architecture for medical image segmentation[C]//Deep Learning in Medical Image Analysis and Multimodal Learning for Cli-nical Decision Support. Cham:Springer, 2018: 3-11.

[8]Oktay O, Schlemper J, Folgoc L L, et al. Attention U-Net: learning where to look for the pancreas[EB/OL]. (2018-05-20). https://arxiv.org/abs/1804.03999.

[9]Tang Yujiao, Yang Feng, Yuan Shaofeng. A multi-stage framework with context information fusion structure for skin lesion segmentation[C]//Proc of the 16th IEEE International Symposium on Biomedical Imaging. Piscataway, NJ: IEEE Press, 2019: 1407-1410.

[10]Jha D, Riegler M A, Johansen D, et al. DoubleU-Net: a deep convo-lutional neural network for medical image segmentation[C]// Proc of the 33rd IEEE International Symposium on Computer-based Medical Systems. Piscataway, NJ: IEEE Press, 2020: 558-564.

[11]王雪. 基于U-Net多尺度和多维度特征融合的皮肤病变分割方法[J]. 吉林大学学报:理学版, 2021, 59(1): 123-127. (Wang Xue. Skin lesion segmentation method based on U-Net with multi-scale and multi-dimensional feature fusion[J]. Journal of Jilin University:Science Edition, 2021, 59(1): 123-127.)

[12]梁礼明, 彭仁杰, 冯骏,等. 基于多尺度特征融合双U型皮肤病变分割算法[J]. 计算机应用研究, 2021, 38(9): 2876-2880. (Liang Liming, Peng Renjie, Feng Jun, et al. Skin lesion image segmentation algorithm based on multi-scale feature fusion double U-Net[J]. Application Research of Computers, 2021, 38(9): 2876-2880.)

[13]Dosovitskiy A, Beyer L, Kolesnikov A, et al. An image is worth 16×16 words: Transformers for image recognition at scale[EB/OL]. (2021-06-03). https://arxiv.org/abs/2010.11929.

[14]Liu Ze, Lin Yutong, Cao Yue, et al. Swin Transformer: hierarchical vision transformer using shifted windows[C]//Proc of IEEE/CVF International Conference on Computer Vision. Piscataway, NJ: IEEE Press, 2021: 9992-10002.

[15]Chen Jieneng, Lu Yongyi, Yu Qihang, et al. TransUNet: transfor-mers make strong encoders for medical image segmentation[EB/OL]. (2021-02-08). https://arxiv.org/abs/2102.04306.

[16]Zhang Yundong, Liu Huiye, Hu Qiang. TransFuse: fusing transfor-mers and CNNs for medical image segmentation[C]//Proc of the 24th International Conference on Medical Image Computing and Computer Assisted Intervention. Cham: Springer, 2021: 14-24.

[17]梁礼明, 周珑颂, 尹江,等. 融合多尺度Transformer的皮肤病变分割算法[J]. 吉林大学学报 :工学版, 2024,54(4):1086-1098. (Liang Liming, Zhou Longsong, Yin Jiang, et al. Fusion multi-scale transformer skin lesion segmentation algorithm[J]. Journal of Jilin University :Engineering and Technology Edition, 2024,54(4):1086-1098.)

[18]普钟, 张俊华, 黄昆,等. 融合多注意力机制的脊椎图像分割方法[J]. 计算机应用研究, 2023, 40(4): 1256-1262. (Pu Zhong, Zhang Junhua, Huang Kun, et al. Spinal image segmentation method with multi-attention[J]. Application Research of Computers, 2023, 40(4): 1256-1262.)

[19]Hu Jie, Shen Li, Sun Gang. Squeeze-and-excitation networks[C]//Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2018: 7132-7141.

[20]Woo S, Park J, Lee J Y, et al. CBAM: convolutional block attention module[C]//Proc of European Conference on Computer Vision. Cham: Springer, 2018: 3-19.

[21]Gutman D, Codella N C F, Celebi E, et al. Skin lesion analysis toward melanoma detection: a challenge at the international symposium on biomedical imaging(ISBI) 2016, hosted by the international skin imaging collaboration (ISIC)[EB/OL]. (2016-05-04). https://arxiv.org/abs/1605.01397.

[22]Codella N C F, Gutman D, Celebi M E, et al. Skin lesion analysis toward melanoma detection: a challenge at the 2017 international symposium on biomedical imaging(ISBI) , hosted by the international skin imaging collaboration(ISIC)[C]//Proc of the 15th IEEE International Symposium on Biomedical Imaging. Piscataway, NJ: IEEE Press, 2018: 168-172.

[23]Codella N, Rotemberg V, Tschandl P, et al. Skin lesion analysis toward melanoma detection 2018: a challenge hosted by the internatio-nal skin imaging collaboration(ISIC)[EB/OL]. (2019-03-29). https://doi.org/10.48550/arXiv.1902.03368.

[24]Gu Zaiwang, Cheng Jun, Fu Huazhu, et al. CE-Net: context encoder network for 2D medical image segmentation[J]. IEEE Trans on Medical Imaging, 2019, 38(10): 2281-2292.

[25]Gao Yunhe, Zhou Mu, Metaxas D N. UTNet: a hybrid transformer architecture for medical image segmentation[C]//Proc of Internatio-nal Conference on Medical Image Computing and Computer-Assisted Intervention. Cham:Springer, 2021: 61-71.

[26]Xie Enze, Wang Wenhai, Yu Zhiding, et al. SegFormer: simple and efficient design for semantic segmentation with transformers[J]. Advances in Neural Information Processing Systems, 2021, 34: 1a7788ea1267ab3a3eb788c29d228d87ce93eff219cfa0211dc55ff10e27bc6e12077-12090.

[27]Cao Hu, Wang Yueyue, Chen J, et al. Swin-UNet: UNet-like pure transformer for medical image segmentation[C]//Proc of European Conference on Computer Vision. Cham: Springer, 2022: 205-218.

[28]Valanarasu J M J, Patel V M. UNeXt: MLP-based rapid medical image segmentation network[C]//Proc of International Conference on Medical Image Computing and Computer-Assisted Intervention. Cham: Springer, 2022: 23-33.

[29]Ruan Jiacheng, Xiang Suncheng, Xie Mingye, et al. MALUNet: a multi-attention and light-weight U-Net for skin lesion segmentation[C]//Proc of IEEE International Conference on Bioinformatics and Biomedicine. Piscataway, NJ: IEEE Press, 2022: 1150-1156.

[30]Wang Haonan, Cao Peng, Wang Jiaqi, et al. UCTransNet: rethinking the skip connections in U-Net from a channel-wise perspective with transformer[C]//Proc of AAAI Conference on Artificial Intelligence. Palo Alto, CA: AAAI Press, 2022: 2441-2449.

[31]Xu Qing, Ma Zhicheng, He Na, et al. DCSAU-Net: a deeper and more compact split-attention U-Net for medical image segmentation[J]. Computers in Biology and Medicine, 2023, 154: 106626.

[32]Ruan Jiacheng , Xie Mingye , Gao Jingsheng, et al. EGE-UNet: an efficient group enhanced U-Net for skin lesion segmentation[C]//Proc of International Conference on Medical Image Computing and Computer-Assisted Intervention. Cham: Springer, 2023: 481-490.