基于改进YOLOv5s的肠镜息肉多分类实时检测方法

DOI:10.3969/j.issn.10001565.2024.04.011

摘要:为了在肠镜检查过程中对结直肠息肉进行快速鉴别检测,提出一种基于改进YOLOv5s的肠镜息肉多分类实时检测模型.该模型采用ConvNeXt作为主干网络, 融入SimAM注意力机制提升检测性能,同时在颈部网络中使用基于GSConv的slim-neck模块减少网络参数.为了对模型进行训练和测试,构建了包含1 676张息肉图像并由专业医生标注的结直肠息肉数据集.提出的模型在测试集上的平均精度均值(mAP@0.5)为83.0%,相较于改进前提升8.4%,检测速度达到120帧/s. 此外,模型在边缘侧部署检测速度超过25帧/s.结果表明,改进的YOLOv5s满足临床结肠镜检查对实时性与准确性的要求.

关键词:息肉;腺瘤;检测;YOLOv5s;实时性

中图分类号:TP391.7文献标志码:A文章编号:10001565(2024)04042409

A real-time multi-class detection method for colonoscopy

polyps based on improved YOLOv5s

XUE Linyan1,2,3, LI Xuanang1, QI Chaoyi1, CAO Jie1, ZHANG Ying1, AI Shangpu1, YANG Kun1,2,3

(1. College of Quality and Technical Supervision, Hebei University, Baoding 071002, China;

2. National amp; Local Joint Engineering Research Center of Metrology Instrument and System,

Baoding 071002, China; 3. New Energy Vehicle Power System Lightweight

Technology Innovation Center of Hebei Province, Baoding 071002, China)

Abstract: To facilitate rapid identification and detection of colorectal polyps during colonoscopy procedures, a real-time multi-class detection model for colonoscopic polyps based on modified YOLOv5s is proposed. This model utilizes ConvNeXt as thebackbone network and incorporates the SimAM attention mechanism to improve detection performance. Additionally, a slim-neck module based on GSConv is employed in the neck network to reduce network parameters. For model training and testing, a colorectal polyp dataset containing 1 676 images annotated by professional doctors was constructed. The proposed model achieves a mean Average Precision (mAP@0.5) of 83.0% on the test set, which is an improvement

收稿日期:20240316;修回日期:20240506

基金项目:河北省自然科学基金资助项目(F2023201069);保定市创新能力提升专项项目(2394G027);河北大学研究生创新项目(HBU2024BS021;HBU2024SS011);河北大学科研创新团队项目(IT2023B07);大学生创新创业训练计划创新训练项目(DC2024376;DC2024381)

第一作者:薛林雁(1981—),女,河北大学副教授,主要从事生物医学图像处理方向研究.E-mail: lyxue@hbu.edu.cn

通信作者:杨昆(1976—),男,河北大学教授,博士生导师,主要从事生物医学图像处理方向研究.

E-mail: yangkun@hbu.edu.cn

of 8.4% compared to the model before modification, with a detection speed of 120 frames per second. Moreover,the model exhibits a detection speed exceeding 25 frames per second when deployed on edge devices. The results demonstrate that the improved YOLOv5s meets the clinical requirementsfor real-time and accurate colonoscopy examinations.

Key words: polyps; adenomatous polyps; object detection; YOLOv5s; real-time

根据2020年全球癌症统计报告,结直肠癌在全球的发病率高居第二[1].结直肠息肉主要包括增生性息肉和腺瘤性息肉[2].约85%的结直肠癌由结直肠腺瘤演变而来[3],故而对结直肠息肉进行精准分型至关重要.结肠镜检是检测和预防结直肠癌的金标准[4],但检查过程易受医生经验、息肉位置和形态以及疲劳操作等干扰导致漏检、误诊[5].因此,临床亟需精准、实时、鲁棒的方法,能够切实有效地提高结直肠腺瘤的诊断水平[6-7].

随着人工智能的发展,深度学习在结直肠息肉的分类与检测任务中表现出良好的性能[8].Ozawa等[9]采用SSD网络对结直肠息肉进行实时检测和六分类(腺瘤、增生性息肉、SSAP、腺癌、其他病变和正常),检测灵敏度为92%,分类准确率达83%,检测速度为48.7帧/s,但针对小型肿瘤关注不足.Alba等[10]对YOLOv3网络进行预训练,再基于目标跟踪算法进行后处理,显著提升了结直肠息肉实时检测系统的灵敏度和特异性,检测息肉图像的F1分数为88%,召回率为87%,精确率为89%.Mo等[11]首次将采用VGG16为骨干网络的Faster-RCNN框架应用于结直肠息肉检测,在CVC-Clinic2015DB数据集上取得了86.2%的检测准确率和98.1%的召回率,但检测速度最高仅达到17帧/s.Pacal等[12]在YOLOv4算法结构上引入CSPNet网络结构、Mish 激活函数和DIoU损失,构建结直肠息肉实时检测系统,在公开息肉数据集ETIS-LARIB上测试,精确率达到91.62%,召回率达82.55%,且检测速度可达到122帧/s.刘爽等[13]构建基于YOLOv5s的结直肠腺瘤实时检测方法,引入通道注意力机制并改进损失函数,使用结直肠腺瘤图像与肠镜检测的视频帧测试,平均精度达到93.6%,检测速度达93帧/s.

然而,上述研究仍存在一定的局限性:1)多数研究主要针对腺瘤/非腺瘤、息肉/正常这2种,很少针对结直肠息肉进行更精准全面地多分类与检测;2)大多数研究为了提升检测精度而加深网络或增加识别步骤,导致模型的实时性较差,无法满足边缘部署及实时性需求[14].基于此,本研究对轻量级网络YOLOv5s进行了一系列改进,主要贡献包括:1)为提高检测性能,使用融合SimAM注意力机制的ConvNeXt网络替换YOLOv5s的主干网络,以提取更多全局特征;2)为提高检测速度,在YOLOv5s的颈部网络采用基于GSConv的slim-neck结构,改进非极大值抑制方法,解决相邻息肉互相遮挡视野的问题;3)为验证边缘侧检测性能,选择英伟达Jetson Nano和瑞芯微RK3568这2款算力较低的高性能板卡作为边缘设备,将网络模型进行对应的框架转换和引擎加速,部署系统并进行性能测试.实验结果验证了本文提出的改进YOLOv5s网络能够有效提升息肉多分类检测的精度和实时性,并在边缘设备上验证了系统可行性.

1模型构建

1.1改进的YOLOv5s网络

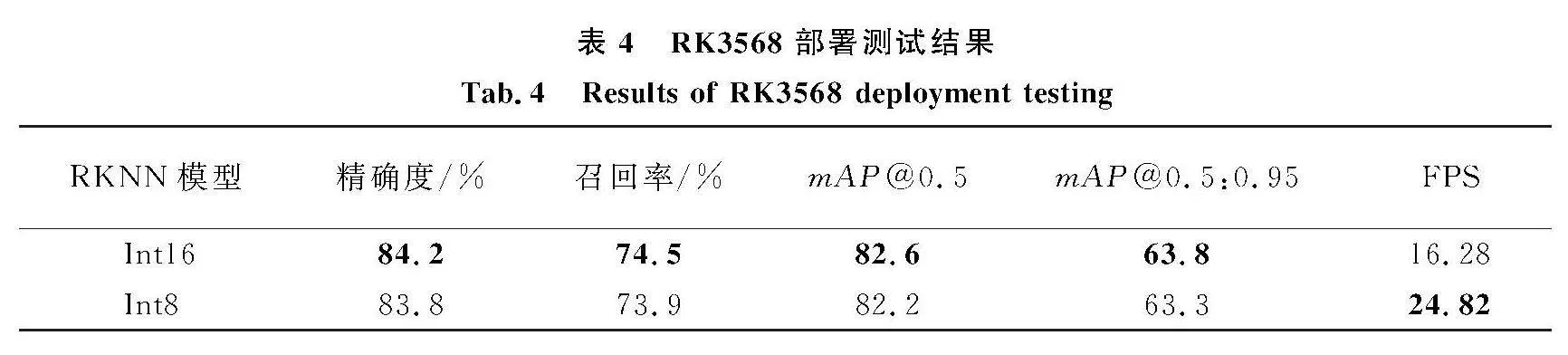

结合不同YOLO模型的特性[15-17],本研究基于检测性能较好且参数量较少的YOLOv5s对直肠息肉进行多分类实时检测.YOLOv5s由主干网络、颈部网络以及检测头模块3部分组成, 图1为改进主干和颈部网络后的YOLOv5s实时检测网络架构,在主干网络中设计了ConvN-Sim模块替换原有模块,以提取更丰富的息肉特征,同时捕获更多全局信息.在颈部网络采用基于GSConv的slim-neck结构,以进一步降低网络参数量,加快推理速度的同时保证输出准确率.为了提升模型在训练阶段的收敛速度,采用SIoU损失函数结合非极大值抑制方法,通过降低冗余检测框的权重,有效解决了肠镜检测中相邻病变相互遮挡的问题.

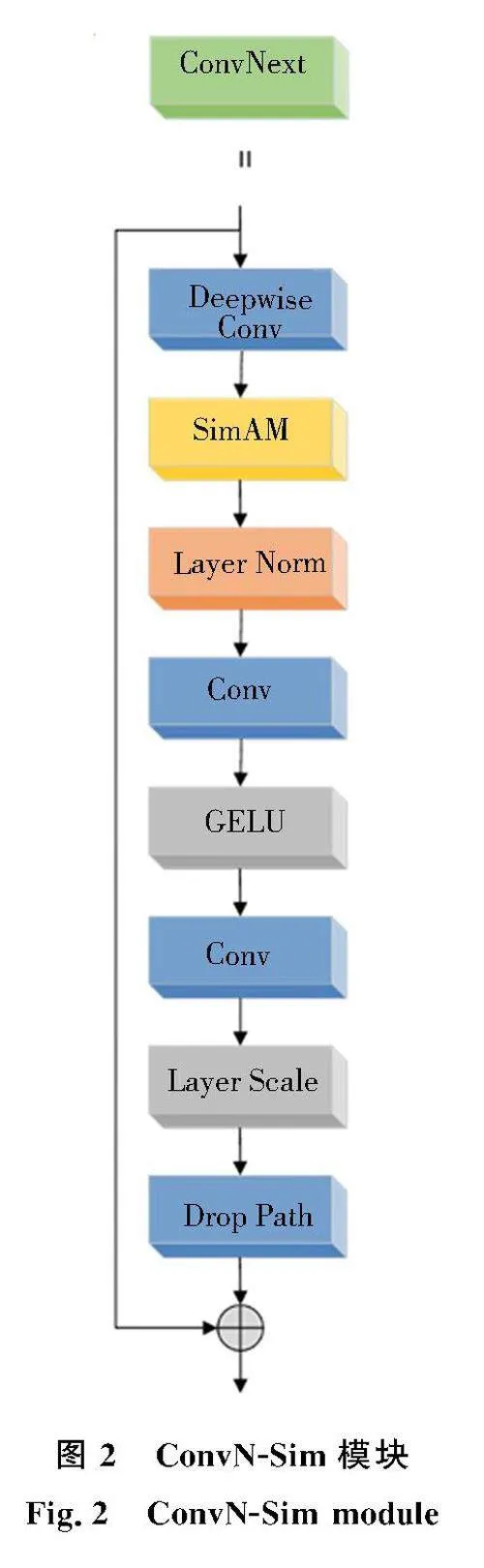

相对于CNN,Transformer[18]的自注意力机制可以扩展感受野,提取图像全局信息.本研究使用结合Transformer特性的CNN主干ConvNeXt[19],以适应医学图像的复杂性和多分类实时检测任务的需求.

由于肠道中存在的气泡、粪便等因素的影响,本研究添加SimAM注意力机制[20],不影响参数量的同时降低干扰因素的权重.图2为ConvN-Sim模块,由ConvNext模式与SimAM注意力机制组成,其中前者由深度卷积(Deepwisec Conv),层归一化(LN),标准卷积和GELU激活函数构成,SimAM注意力添加在深度卷积层后.

SimAM注意力机制使用能量函数确定注意力,计算如公式(1).t代表输入特征X中目标神经元,μ^和σ^2分别是其他神经元的平均值和方差(不包括t),λ的最佳值设为0.000 1.所得et值越小意味着能量越低,目标神经元与其他神经元差异越大,即该神经元的重要性越高.根据神经元的重要性增强特征图,计算公式如(2).e*t=4(σ^2+λ)((t-μ^)2+2σ^2+2λ),(1)

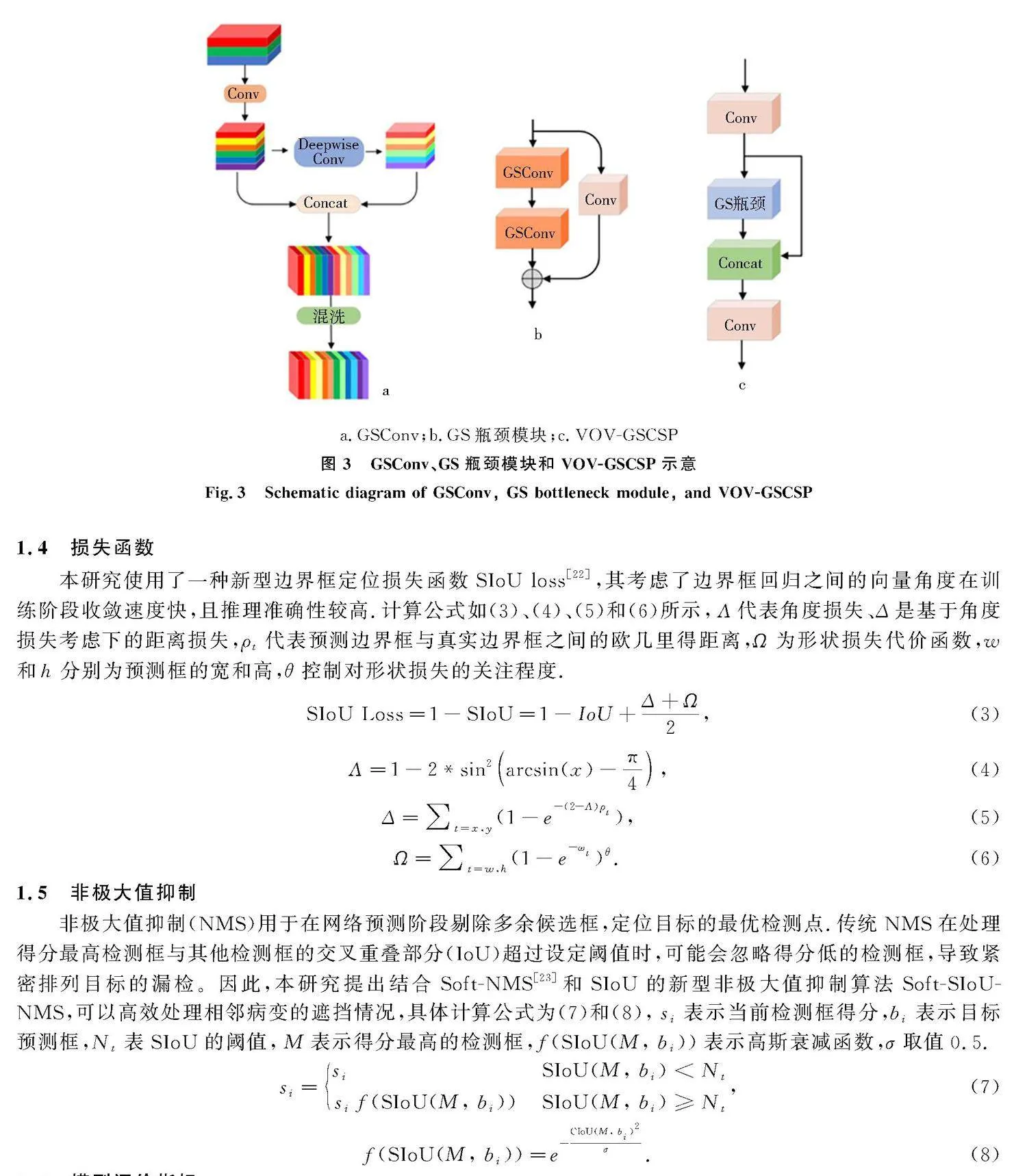

X=sigmod1E⊙X.(2)1.3颈部网络改进

为了实现息肉的实时检测,使用基于GSConv的slim-neck结构[21]改进YOLOv5s颈部网络.尽管大多数轻量化设计采用深度可分离卷积运算来减少模型的参数和浮点运算量,但可能导致输入图像的通道信息分离,丢失细节信息,因此在颈部网络的VOV-GSCSP中使用GSConv,通过混洗操作将标准卷积生成的特征信息在不同通道上均匀地交换局部特征信息,进而完全渗透到深度卷积的输出中,实现以较低的时间复杂度尽可能多地保留不同通道之间的隐藏连接,如图3a所示.

经上述操作,GSConv对模型学习能力的贡献与标准卷积相当,但计算成本仅为后者的一半.在GSConv的基础上设计轻量化的GS瓶颈模块,通过一次性聚合方法来构建跨阶段部分网络模块VoV-GSCSP.图3b和图3c显示了GS瓶颈模块和VoV-GSCSP,后者结合GSConv的深度可分离卷积和通道混洗,代替颈部网络的CSP模块.a.GSConv;b.GS瓶颈模块;c.VOV-GSCSP

1.4损失函数

本研究使用了一种新型边界框定位损失函数SIoU loss[22],其考虑了边界框回归之间的向量角度在训练阶段收敛速度快,且推理准确性较高.计算公式如(3)、(4)、(5)和(6)所示,Λ代表角度损失、Δ是基于角度损失考虑下的距离损失,ρt代表预测边界框与真实边界框之间的欧几里得距离,Ω为形状损失代价函数,w和h分别为预测框的宽和高,θ控制对形状损失的关注程度.SIoU Loss=1-SIoU=1-IoU+Δ+Ω2,(3)

Λ=1-2*sin2arcsin(x)-π4,(4)

Δ=∑t=x,y(1-e-(2-Λ)ρt ),(5)

Ω=∑t=w,h(1-e-ωt )θ.(6)1.5非极大值抑制

非极大值抑制(NMS)用于在网络预测阶段剔除多余候选框,定位目标的最优检测点.传统NMS在处理得分最高检测框与其他检测框的交叉重叠部分(IoU)超过设定阈值时,可能会忽略得分低的检测框,导致紧密排列目标的漏检。因此,本研究提出结合Soft-NMS[23]和SIoU的新型非极大值抑制算法Soft-SIoU-NMS,可以高效处理相邻病变的遮挡情况,具体计算公式为(7)和(8),si表示当前检测框得分,bi表示目标预测框,Nt表SIoU的阈值,M表示得分最高的检测框,f(SIoU(M, bi ))表示高斯衰减函数,σ取值0.5.si=siSIoU(M, bi )lt;Ntsi f(SIoU(M, bi ))SIoU(M, bi )≥Nt ,(7)

f(SIoU(M, bi ))=e-CIoU(M, bi )2σ.(8)1.6模型评价指标

性能指标采用精确率 (P, Precision)、召回率(R, Recall)、平均精度(AP, Average Precision)和平均精度的均值(mAP, mean Average Precision)作为评价指标.IoU表示真实标签框和预测框B之间的重合度.P-R曲线下的面积为AP,mAP反映了所有类别的精度,mAP@0.5表示IoU设置为0.5时的mAP值,mAP@[0.5:0.95]表示IoU在区间[0.5,0.95]内取值,步距间隔0.05计算平均mAP.为评估系统实时性和参数量,引入FPS(frames per second,每秒帧数)和FLOPS(floating point operations per second,每秒浮点计算次数)指标.

2实验研究

2.1实验环境

本实验在Linux操作系统运行,配置为Inter Core i7-7800*1以及128 G的DDR4运行内存,GPU为NVIDIA RTX2080Ti.深度学习框架为Python3.9.13、Pytorch1.10.1和Cuda 10.2.训练中采用随机梯度下降法SGD优化器,初始学习率设置为0.01,批处理大小设置为32,进行150个迭代轮数(epoch)的训练学习.

2.2数据采集与处理

实验数据来自河北大学附属医院,本研究已通过河北大学附属医院伦理委员会审核.数据涵盖2016年6月至2019年6月12 857例患者的病理信息.2名临床经验丰富的结直肠内镜医生对结直肠图像数据进行清洗与分类,排除充气不充分、有较多的粪便残渣、光晕、出血的结直肠图像,最终采用1 676张结直肠息肉图像,含管状腺瘤(651张)、绒毛状管状腺瘤(618张)、绒毛状腺瘤(51张)、增生性息肉(234张)和无蒂锯齿状 腺瘤/息肉(SSAP)(122张)5种临床常见病变.

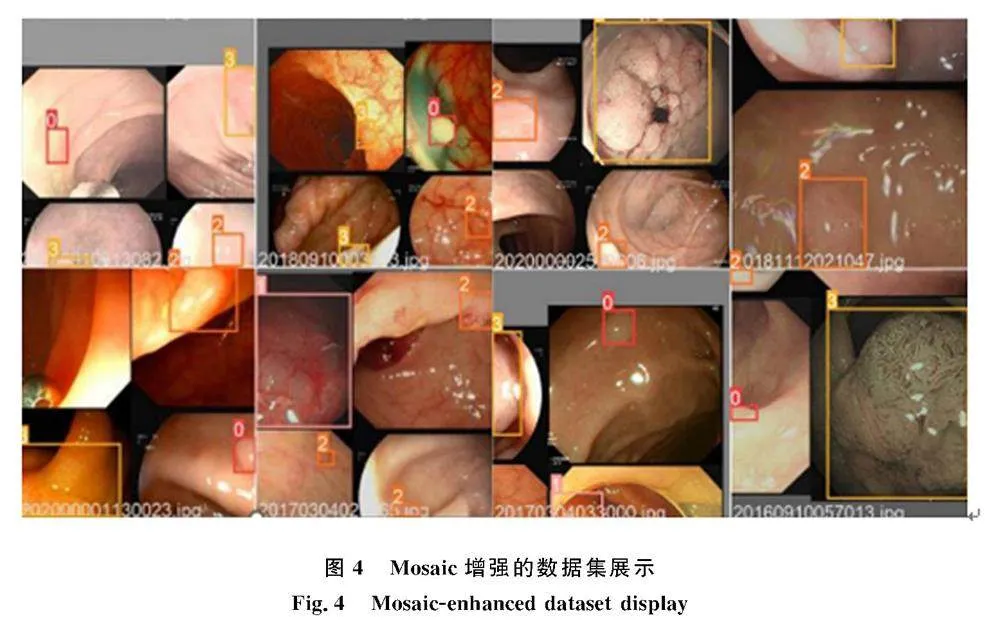

按照4∶1随机分配训练集和测试集,其中训练集包含1 340张图片,测试集包含336张图片.采用像素变换、旋转、翻转等几何变换方法进行数据增强,再加入噪声、调节明亮度,最终使用Mosaic增强来减小数据不平衡的影响.Mosaic增强是将4张照片随机裁剪后调整尺寸,再拼接到一张设定尺寸的图像上,在训练阶段中进行处理并输入到模型中.且由于原始图片均有对应的检测框,则所得图片中也包含对应框.图4是Mosaic增强的随机8张结果展示.

3实验结果及分析

3.1经典网络对比实验分析

结合ImageNet自然图像数据集和CVC-ClinicDB[24]结直肠息肉数据集,对改进的YOLOv5s检测网络预训练,利用迁移学习提高网络性能.

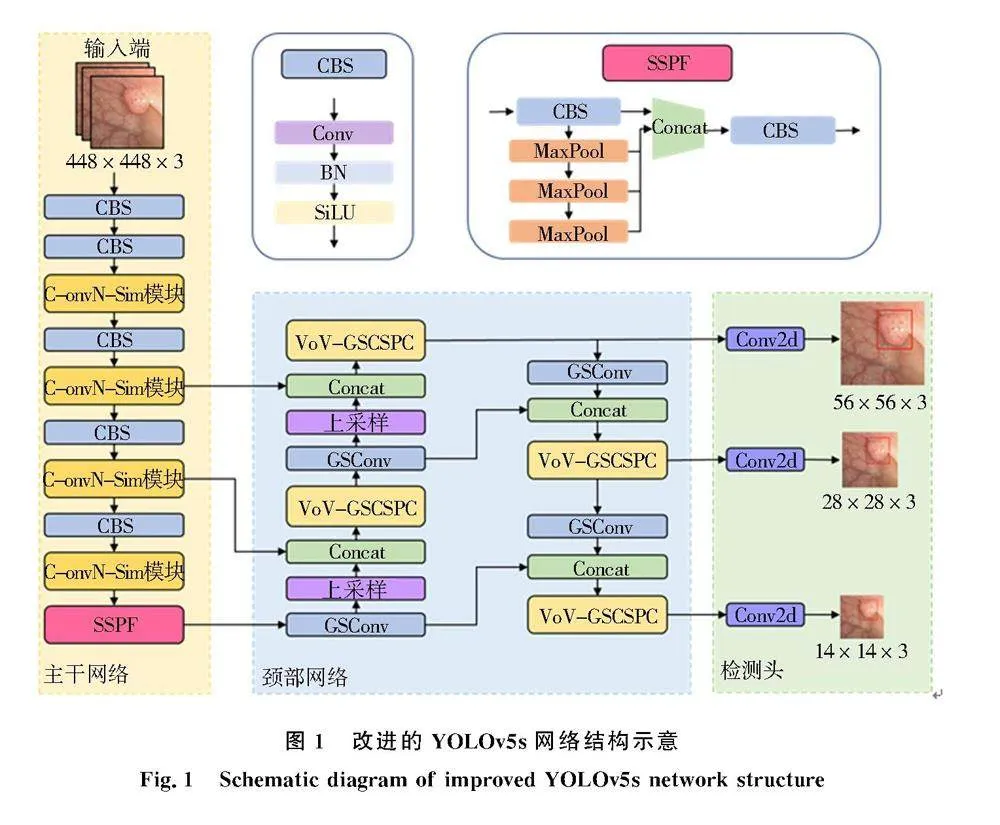

对比改进的YOLOv5s网络与经典目标检测网络,并使用mAP@0.5和mAP@[0.5:0.95]指标进行评估.

如表1所示,改进的网络在4项检测指标表现均具有明显优势,检测精度高于经典双阶段检测网络Faster-R CNN,速度优于同为单阶段网络的SSD和RetinaNet.mAP@0.5值达80.9%,mAP@[0.5:0.95]为62.9%,当IoU取值0.5时,对5类息肉的AP值相对于其他网络高出比例均大于19%,达79.6%~92.7%,其推理速度达120帧/s,兼顾高精确率和实时性.从表1中可以看到对增生性息肉和锯齿状腺瘤这些体积小、形态不明显、训练数据较少的类别,其余模型的检测效果均表现一般低于40%.最优结果以加粗字体表达(下同).

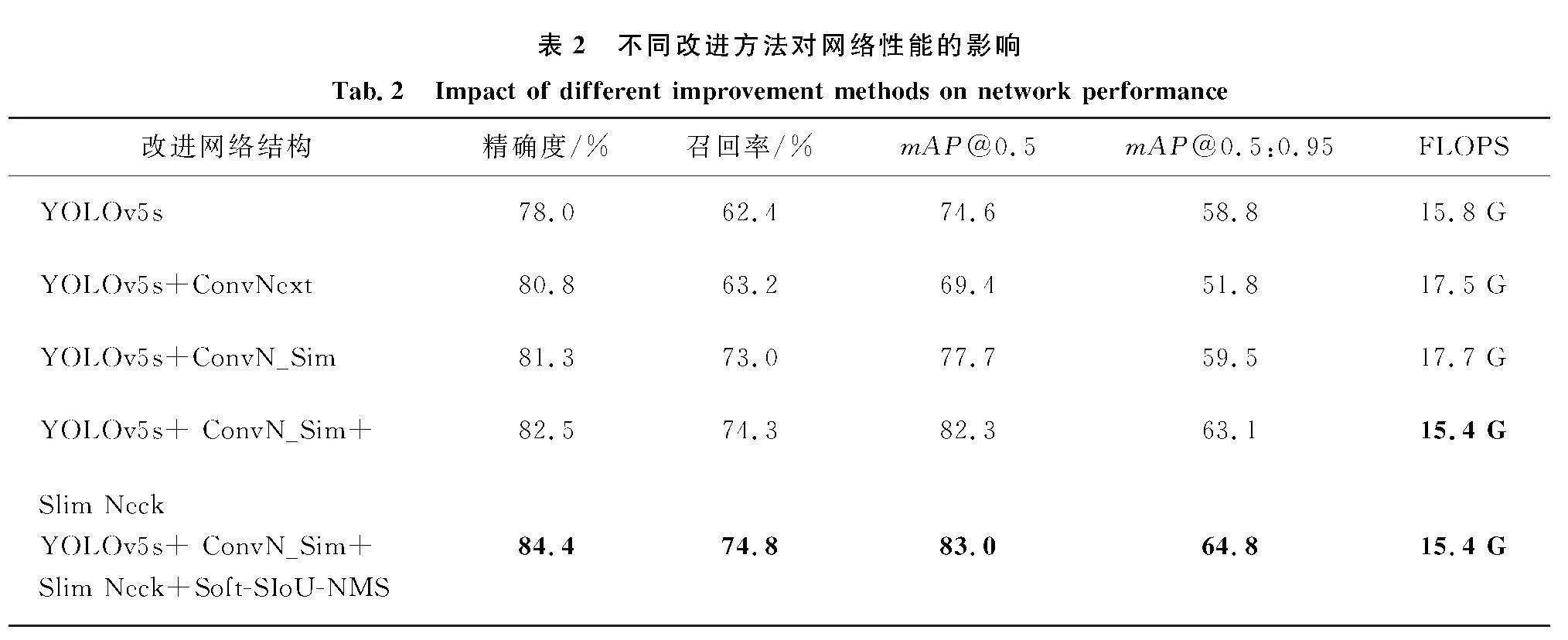

3.2各模块改进对比分析

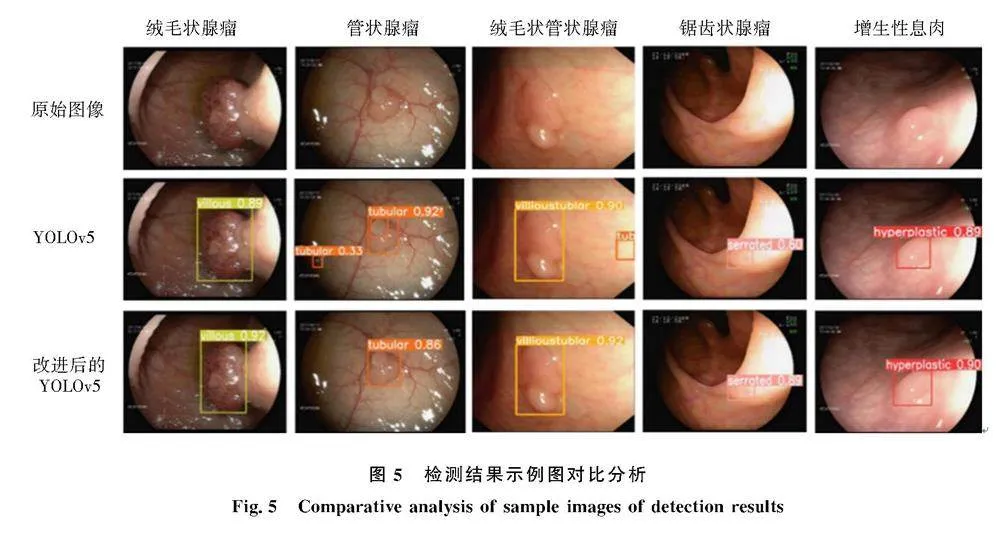

利用五分类结直肠息肉检测数据集对YOLOv5s网络和各模块结构效果进行实验评估(表2).图5是原始图像、YOLOv5s检测结果、改进后的YOLOv5s检测结果对比.

在5折交叉验证中,使用ConvNeXt替换主干网络Darknet53后,由于其更优的全局空间信息捕获能力精确度从78.0%提升至80.8%,召回率提高了0.8%.引入SimAM注意力机制增强了模型鲁棒性,使精确度提高0.5%,召回率达到73.0%,mAP在IoU设为0.5和[0.5:0.95]时均达到了77.7%和59.5%.此外,颈部网络中通过使用GSConv代替标准卷积,并将VOV-GSCSP替换原CSPnet,进一步提高了性能指标,同时降低参数量和计算量.最后,采用Soft-SIoU-NMS代替传统的NMS显著解决了息肉遮挡的问题,精确度提升至84.3%,召回率为70.5%,mAP@0.5和mAP@[0.5:0.95]分别提升了3.7%和2.4%.

4系统部署

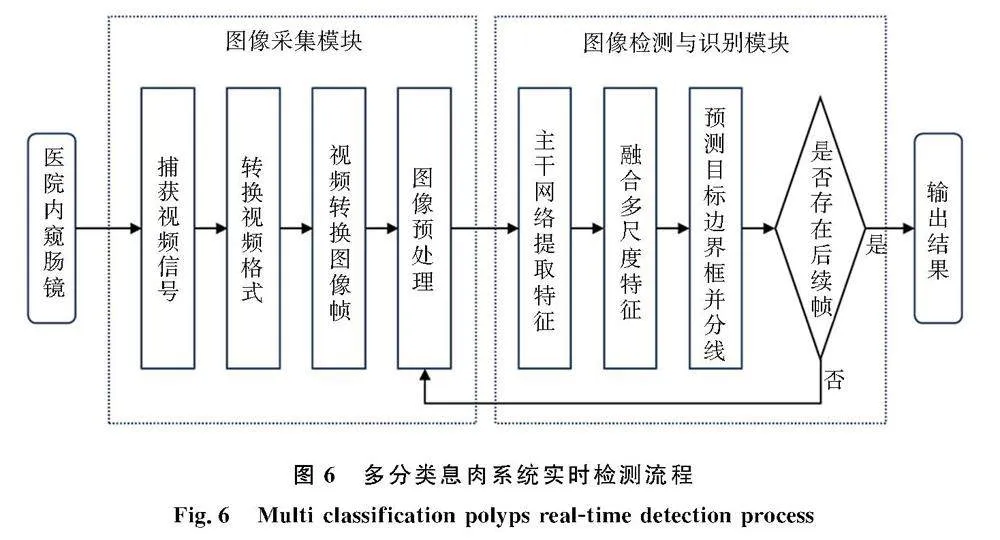

4.1多分类息肉系统实时检测系统

多分类息肉系统实时检测系统是针对医院内窥镜设备的图像采集和诊断分析系统.具体检测流程如图6所示,当使用电子内窥镜进行结肠镜检测时,视频格式转换卡转换视频信号,并对原始数据预处理.在图片检测与识别模块,主干网络对输入的图像帧提取特征,进行多尺度融合.生成的多尺度特征图用于提取注意力感兴趣区域信息和生成预测目标框,最终输出息肉位置和置信度的检测结果.

本次部署测试利用电脑模拟内镜设备作为内镜检查视频帧输入信号,连接视频转换器,通过USB3.0接口连接边缘侧网络英伟达Jetson Nano和瑞芯微RK3568AI计算单元进行推理,保存检测结果并显示.

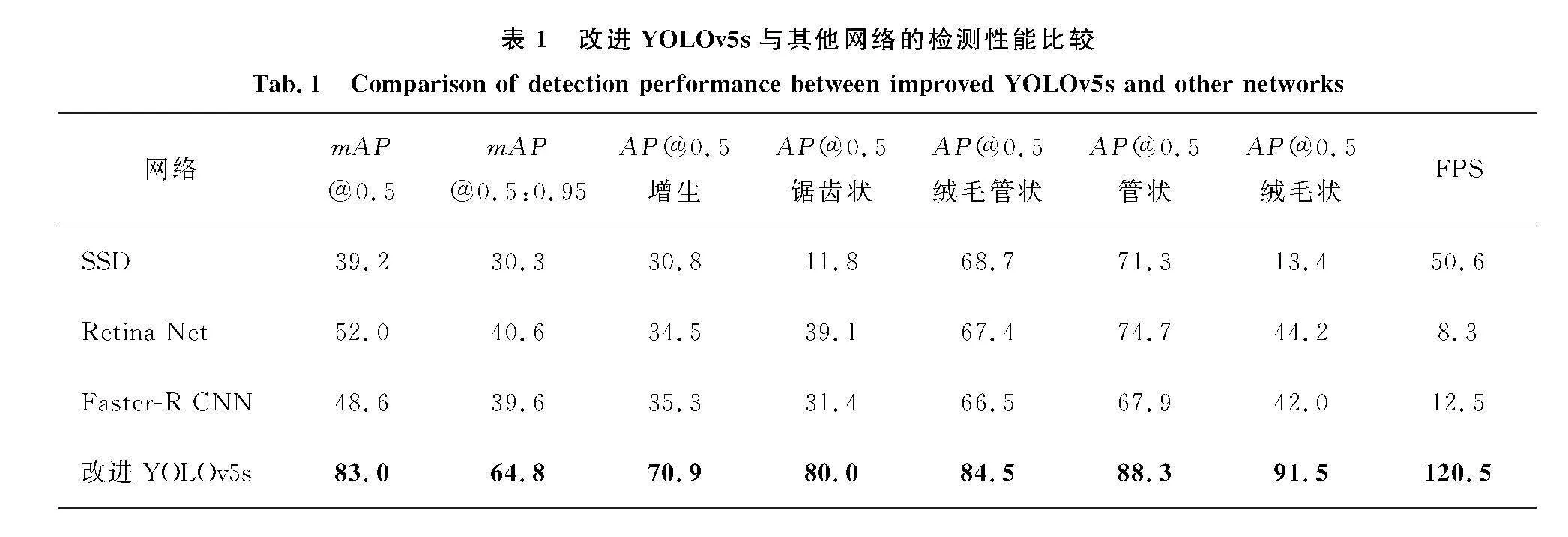

4.2Jetson Nano部署测试

Jetson Nano嵌入式开发板搭载128核Maxwell GPU,支持一系列流行的AI框架 .将本研究的网络模型在此设备上推理部署和加速,使用英伟达开发的TensorRT优化引擎进行模型压缩,降低模型参数精度,减小内存占用并加快推理速度.实验分别选择TensorRT的FP32和FP16这2种参数精度进行网络模型推理阶段性能测试,结果如表3所示.

在Nano部署后,基于Pytorch架构的推理速度仅有14.49帧/s.而将网络转换至TensorRT FP16半精度进行加速计算后,推理速度提升至28.57帧/s,且精度相比PyTorch架构和TensorRT FP32无明显变化.

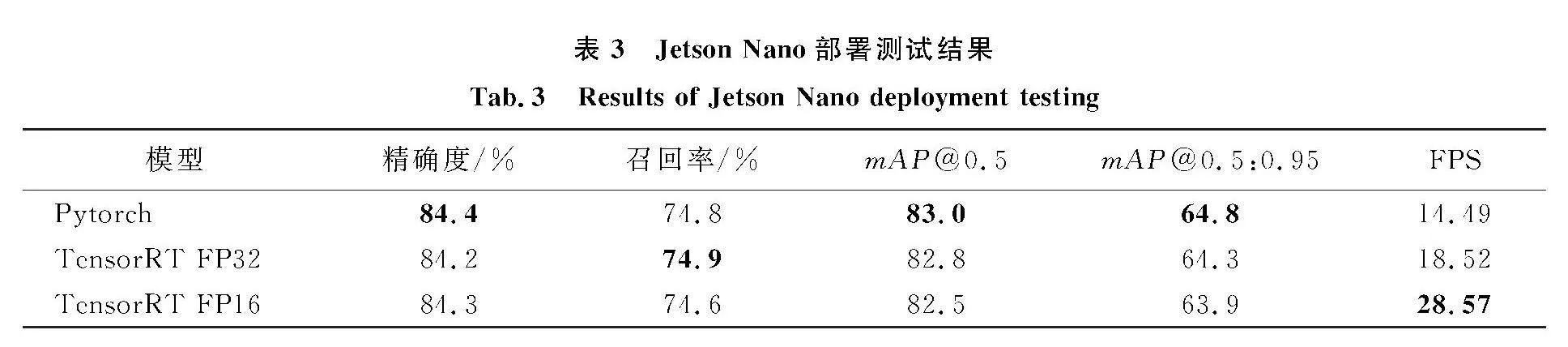

4.3RK3568部署测试

RK3568集成4核arm架构A55处理器、Mali G52 2EE GPU和1Tops算力的高效能AI加速器NPU,支持8bit/16bit量化运算,并且相较于GPU的功耗也大幅降低.通过使用RKNN-Toolkit将本研究的模型转换成RKNN模型,将RKNN模型部署到RK3568平台,测试结果如表4.

经转换得到int16精度的RKNN模型性能评价更好,但FPS不满足实时性需求.而通过量化转换得到int8精度RKNN模型,推理速度提升至24.82帧/s,基本满足实时性需求,且性能评估数据无明显下降.

通过在英伟达Jetson Nano和瑞芯微RK3568上部署肠镜多分类实时检测系统测试的结果,证明即使将本文提出的基于改进的YOLOv5s网络部署在算力较低的边缘侧设备上,可以保证结直肠息肉检测准确性与实时性需求,同时可以减少数据传输延迟,提升病人数据的安全性.

5结论

为了提高医生结肠镜检查的息肉检出率和腺瘤检出率,本文在YOLOv5s的基础上改进,首先为克服卷积神经网络结构的局限性,引入ConvNeXt网络和SimAM来获取更多全局上下文特征信息.再使用基于GSConv的slim-neck模块,在不影响网络性能的同时,降低参数量,加快推理速度.同时利用新的非极大值抑制方法Soft-SIoU-NMS来优化检测网络训练效果.本实验分别在云端服务器和边缘AI设备(模拟临床部署环境)上分别进行了性能测试,依据各项指标显示,改进后的YOLOv5s网络的mAP相较于原YOLOv5s网络整体提升了8.4%,云端部署推理速度达120.5帧/s,边缘侧设备部署推理速度均超过25帧/s,可基本满足临床内镜检查过程中多分类息肉辅助检测实时性与准确性的要求.

参考文献:

[1]刘宗超,李哲轩,张阳,等.2020全球癌症统计报告解读[J].肿瘤综合治疗电子杂志, 2021, 7(2):1-14. DOI:10.12151/JMCM.2021.02-01.

[2]RODRIGUEZ-DIAZ E, BAFFY G, LO W K ,et al. Real-time artificial intelligence-based histological classification of colorectal polyps with augmented visualization - ScienceDirect[J].Gastrointestinal Endoscopy, 2020.DOI:10.1016/j.gie.2020.09.018.

[3]DOUBENI C A, CORLEY D A, QUINN V P, et al. Effectiveness of screening colonoscopy in reducing the risk of death from right and left colon cancer: a large community-based study[J]. Gut, 2018, 67(2): 291-298. DOI: 10.1136/gutjnl-2016-312712.

[4]REX D K, BOLAND C R, DOMINITZ J A, et al. Colorectal cancer screening: recommendations for physicians and patients from the U.S. Multi-Society Task Force on Colorectal Cancer[J]. Gastrointest Endosc, 2017, 86(1): 18-33. DOI: 10.1016/j.gie.2017.04.003.

[5]ZHAO S B, WANG S L, PAN P, et al. Magnitude, risk factors, and factors associated with adenoma miss rate of tandem colonoscopy: a systematic review and meta-analysis[J]. Gastroenterology, 2019, 156(6): 1661-1674. DOI: 10.1053/j.gastro.2019.01.260.

[6]LUI T K L, GUO C G, LEUNG W K. Accuracy of artificial intelligence on histology prediction and detection of colorectal polyps: a systematic review and meta-analysis[J]. Gastrointest Endosc, 2020, 92(1): 11-22. DOI: 10.1016/j.gie.2020.02.033.

[7]BYRNE M F, SHAHIDI N, REX D K. Will computer-aided detection and diagnosis revolutionize colonoscopy?[J]. Gastroenterology, 2017, 153(6): 1460-1464. DOI: 10.1053/j.gastro.2017.10.026.

[8]蒋西然,蒋韬,孙嘉瑶,等.深度学习人工智能技术在医学影像辅助分析中的应用[J].中国医疗设备, 2021, 36(6): 164-171. DOI: 10.3969/j.issn.1674-1633.2021.06.040.

[9]OZAWA T, ISHIHARA S, FUJISHIRO M, et al. Automated endoscopic detection and classification of colorectal polyps using convolutional neural networks[J]. Therap Adv Gastroenterol, 2020, 13: 1756284820910659. DOI: 10.1177/1756284820910659.

[10]NOGUEIRA RODRGUEZ A, DOMNGUEZ CARBAJALES R, CAMPOS TATO F, et al. Real-time polyp detection model using convolutional neural networks[J]. Neural Comput Appl, 2021, 34(13): 1-22.

[11]MO X, TAO K, WANG Q, et al. An efficient approach for polyps detection in endoscopic videos based on faster R-CNN[C]//2018 24th International Conference on Pattern Recognition (ICPR). Beijing, China. IEEE, 2018: 3929-3934. DOI: 10.1109/ICPR.2018.8545174.

[12]PACAL I, KARABOGA D. A robust real-time deep learning based automatic polyp detection system[J]. Comput Biol Med, 2021, 134: 104519. DOI: 10.1016/j.compbiomed.2021.104519.

[13]CAI H, FENG X, YIN R, et al. MIST: multiple instance learning network based on Swin Transformer for whole slide image classification of colorectal adenomas[J]. The Journal of Pathology, 2023, 259(2): 125-135. DOI: 10.1002/path.6027.

[14]张文明,姚振飞,高雅昆,等.一种平衡准确性以及高效性的显著性目标检测深度卷积网络模型[J].电子与信息学报, 2020, 42(5): 1201-1208. DOI: 10.11999/JEIT190229.

[15]JIANG L, LI X.An efficient and accurate object detection algorithm and its application[J].IEEE, 2020.DOI:10.1109/ITOEC49072.2020.9141752.

[16]ADARSH P, RATHI P, KUMAR M.YOLO v3-Tiny: object detection and recognition using one stage improved model[C]//2020 6th International Conference on Advanced Computing and Communication Systems (ICACCS).IEEE, 2020.DOI:10.1109/ICACCS48705.2020.9074315.

[17]BOCHKOVSKIY A, WANG C Y, LIAO H Y M. YOLOv4: optimal speed and accuracy of object detection[EB/OL]. 2020: arXiv: 2004.10934. http://arxiv.org/abs/2004.10934.

[18]ZHAOYANG N,GUOQIANG Z,HUI Y.A review on the attention mechanism of deep learning[J].Neurocomputing, 2021.DOI:10.1016/j.neucom.2021.03.091. 555/3295222.3295349.

[19]LIU Z, MAO H Z, WU C Y, et al. A ConvNet for the 2020s[C]//2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). New Orleans, LA, USA. IEEE, 2022: 11966-11976. DOI: 10.1109/CVPR52688.2022.01167.

[20]Yang L, Zhang R-Y, Li L, et al. SimAM: A Simple, Parameter-Free Attention Module for Convolutional Neural Networks[C]//International Conference on Machine Learning. PMLR, 2021: 11863-11874.

[21]LI H L, LI J, WEI H B, et al. Slim-neck by GSConv: a better design paradigm of detector architectures for autonomous vehicles[EB/OL]. 2022: arXiv: 2206.02424. http://arxiv.org/abs/2206.02424.

[22]GEVORGYAN Z. SIoU loss: more powerful learning for bounding box regression. 2022: arXiv: 2205.12740. http://arxiv.org/abs/2205.12740.

[23]CHENG H, ANYUAN Y, HONGLIN H. 2021. Using combined Soft-NMS algorithm Method with Faster R-CNN model for Skin Lesion Detection. In Proceedings of the 6th International Conference on Robotics and Artificial Intelligence (ICRAI 20). Association for Computing Machinery, New York, NY, USA, 5–8. https://doi.org/10.1145/3449301.3449303.

[24]BERNAL J, SNCHEZ F J, FERNNDEZ-ESPARRACH G, et al. WM-DOVA maps for accurate polyp highlighting in colonoscopy: validation vs. saliency maps from physicians[J]. Comput Med Imaging Graph, 2015, 43: 99-111. DOI: 10.1016/j.compmedimag.2015.02.007.

(责任编辑:孟素兰)