基于多语言预训练模型的缅甸语分词研究

2024-06-03 05:04:11张啸岩张慧陈宇

电脑知识与技术 2024年11期

张啸岩 张慧 陈宇

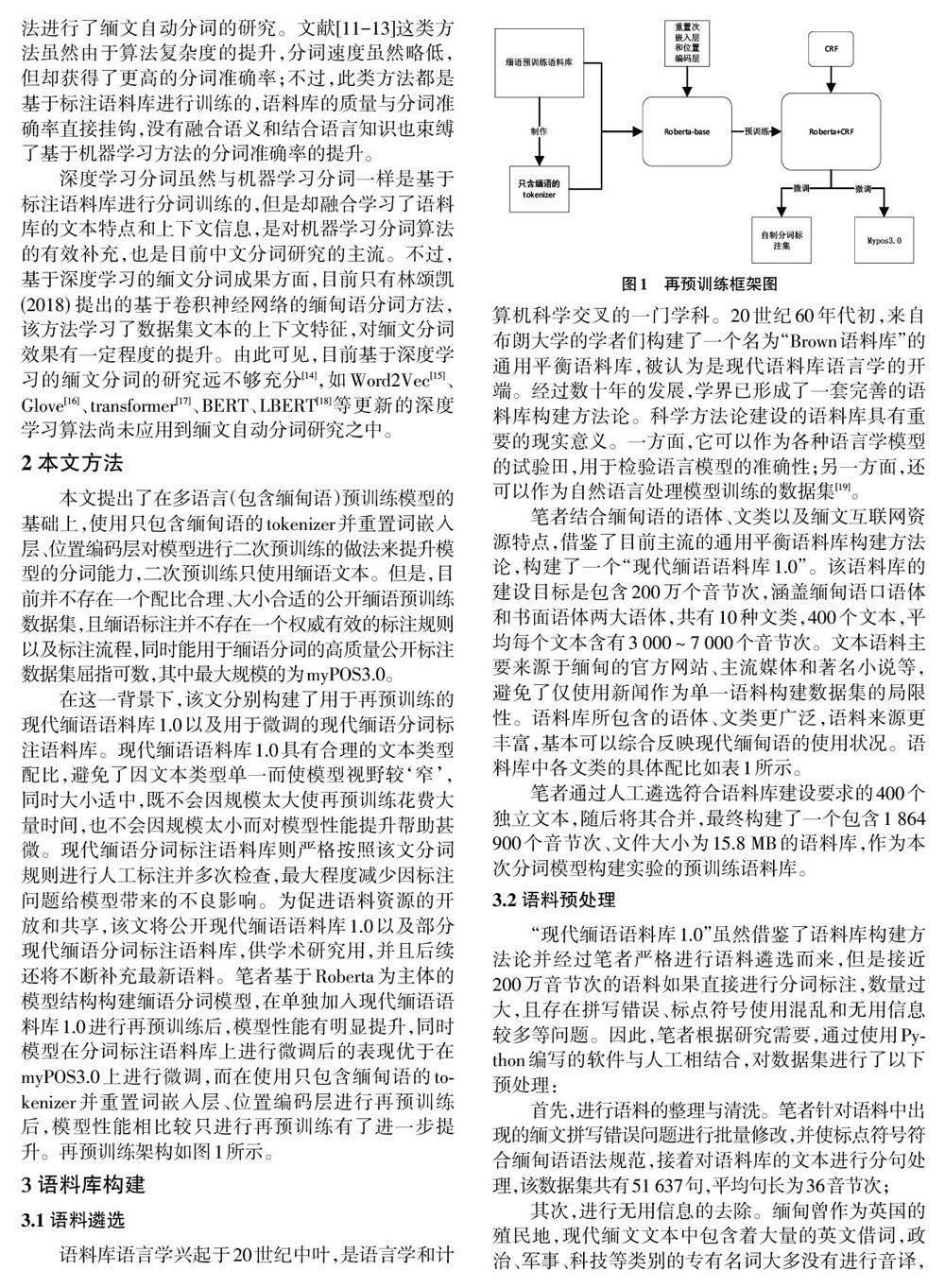

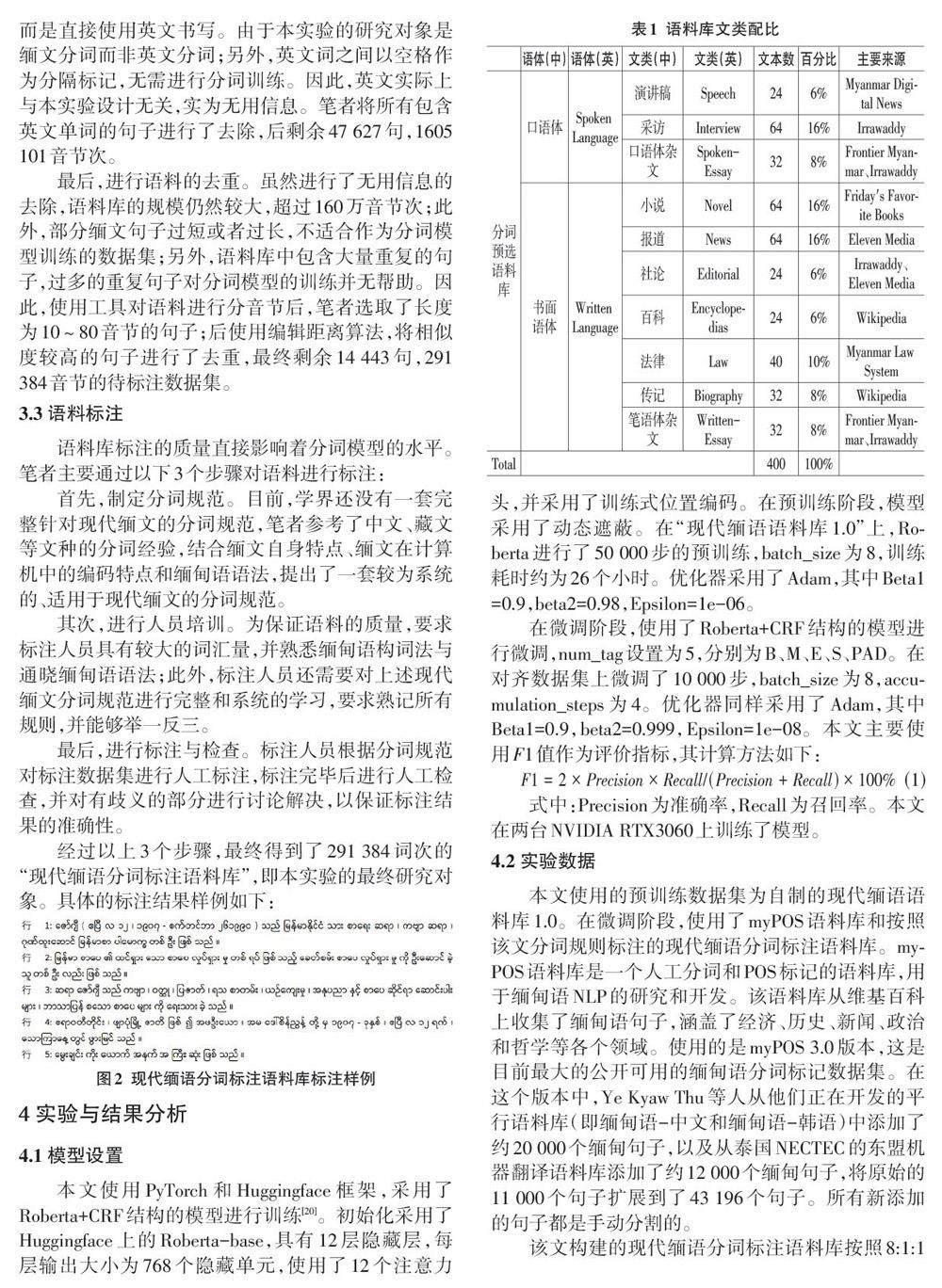

摘要:缅甸语属于低资源语言,收集大量缅语文本进行预训练是一项耗时耗力的工作。目前已存在一些在多种语言(包括缅甸语)上预训练的模型,例如bert-base-multilingual-cased和xlm-roberta-base。因此,文章提出了一种新方法,即在多语言(包括缅甸语)预训练模型的基础上,利用缅语文本进行再预训练,以提升模型的分词性能。首先,构建了缅语预训练语料库,并使用它制作了一个仅包含缅甸语的tokenizer。然后,重置了多语言预训练模型的词嵌入层和位置编码层,并在重置后的多语言预训练模型上使用自制的tokenizer加入缅语预训练语料库进行再预训练。最后,在自建的以及公开的分词标注数据集上进行了微调。与未进行再预训练的情况相比,模型在F1值上分别提高了2.23%和1.2%,且自建数据集的提升幅度高出公开数据集的1.34%。

關键词:缅甸语;自然语言处理;自动分词;Roberta;语料库

中图分类号:TP391 文献标识码:A

文章编号:1009-3044(2024)11-0022-07

猜你喜欢

天津外国语大学学报(2020年1期)2020-03-25 13:29:26

广东蚕业(2019年3期)2019-05-14 05:37:40

作文评点报·低幼版(2017年13期)2017-04-18 18:15:11

计算机应用(2016年12期)2017-01-13 01:24:36

电脑知识与技术(2016年10期)2016-06-16 21:16:32

求知导刊(2016年10期)2016-05-01 14:09:25

电脑知识与技术(2016年5期)2016-04-14 11:12:38

科技视界(2016年5期)2016-02-22 11:41:39

语言与翻译(2015年4期)2015-07-18 11:07:45

电脑知识与技术(2015年11期)2015-06-24 11:51:27