在线异步联邦学习的客户优化选择与激励

顾永跟 冯洲洋 吴小红 陶杰

摘 要:聯邦学习能够在保护用户隐私的前提下,使不同的客户端合作共同训练同一模型,如何激励高质量的客户端参与联邦学习是关键。在线联邦学习环境中,由于参与训练的客户端随机到达和离开,每轮参与报价的客户端动态变化,对客户端的在线质量评估与选择是一个难题。针对这一挑战提出了在线联邦学习激励算法,以优化在线客户端的选择和预算分配,提高预算约束下在线环境联邦学习的性能。该算法将预算按阶段划分并根据历史样本信息计算最优的质量密度阈值,其主要思想是对客户端模型质量进行动态评估,在此基础上采用质量阈值准入机制,同时对参与训练的客户端数量进行限制。从理论上证明了激励算法满足激励相容性、预算可行性和个体理性。实验结果表明,提出的在线激励算法在不同比例搭便车客户端的情况下都能有良好的性能,在预算充足且有搭便车和有误标标签的客户端情况下比已有方法在EMNIST-B和CIFAR-10两个数据集上分别提高约4%和10%。

关键词:联邦学习;激励机制;质量评估;在线场景;客户端筛选

中图分类号:TP391 文献标志码:A

文章编号:1001-3695(2024)03-009-0700-06

doi:10.19734/j.issn.1001-3695.2023.08.0333

Optimization selection and incentives of client in

online asynchronous federated learning

Gu Yonggen1,2,Feng Zhouyang1,Wu Xiaohong1,2,Tao Jie1

(1.School of Information Engineering,Huzhou University,Huzhou Zhejiang 313000,China;2.Zhejiang Province Key Laboratory of Smart Management & Application of Modern Agricultural Resources,Huzhou Zhejiang 313000,China)

Abstract:Federated learning enables different clients to collaborate and train a shared model while preserving user privacy.Motivating high-quality clients to participate in federated learning is crucial.In online federated learning environments,clients join and leave training dynamically,evaluating and selecting clients in real-time poses a challenge.To address this challenge,this paper proposed an online federated learning incentive algorithm to optimize client selection and budget allocation,thereby enhancing the performance of federated learning under budget constraints.The proposed algorithm divided the budget into stages and computed optimal quality density thresholds based on historical sample information.The main idea was to dynamically assess the quality of client models and employ a quality threshold admission mechanism while limiting the number of participating clients.In theory,this paper proved that the incentive algorithm satisfied incentive compatibility,budget feasibility,and individual rationality.Experimental results demonstrate that the proposed online incentive algorithm achieves good performance in scenarios with different proportions of free-riding clients.Specifically,compared to existing methods,it achieves approximately 4% and 10% improvements on the EMNIST-B and CIFAR-10 datasets,respectively,under sufficient budget and in the presence of free-riding and mislabeled clients.

Key words:federated learning;incentive mechanism;quality evaluation;online environment;client selection

0 引言

机器学习作为实现人工智能的基本方法,已在众多领域中得到应用。随着信息安全的普及,人们越来越注重数据的安全。而传统的机器学习在隐私保护方面有所欠缺,无法满足实际需求。随着移动智能终端技术的发展,大量具有高分辨率传感器的物联网设备、智能手机和自动驾驶汽车都连接到高速网络[1]。据统计,2022年全球有近144亿台联网物联网设备,预计到2025年将有大约270亿台联网物联网设备[2]。这些终端设备在使用时会收集大量的数据,这些数据对于设备或软件厂商有很重要的研究和分析价值。在传统的云中心方法中,设备收集的数据需要上传至云服务器或数据中心进行集中式的训练分析,然而这种方法不利于数据安全和隐私保护。

为解决隐私问题,谷歌的研究团队率先提出了一种新兴的机器学习范式——联邦学习(federated learning,FL)[3]。其不同于传统的集中式机器学习,参与设备无须将本地数据上传至服务器,只需从服务器接收模型参数,通过设备上的数据进行本地训练,训练后只需将更新后的模型参数上传给服务器,服务器会根据收到的所有模型参数更新得到新的全局模型。以此往复,直至全局模型收敛。

联邦学习能得到成功应用的关键在于大量高质量客户端或设备参与联合模型训练。目前的研究大多假设设备无条件自愿参与联邦学习训练,而现实中

在没有报酬的情况下,移动设备所有者往往

缺乏参与意愿。同时,目前大部分研究关注于静态同步更新的场景,即服务器接收到所有参与者更新后进行聚合,然而实际场景下,设备在训练中可能随机离开或加入,这给联邦学习的训练过程带来了不确定性。针对上述两个问题,本文将考虑在跨设备联邦学习中,如何在不确定环境下,以有限的预算招募高质量的客户端参与联邦学习,得到一个性能良好的全局模型。为达到上述目标,本文提出了基于客户端模型质量的在线联邦学习激励算法,以此激励客户端积极参与联合模型训练。

在最初提出的联邦学习模式中,服务器在每轮会从客户端中随机选择一定数量的客户端参与训练。而这样的设定在处理non-IID数据时会导致准确率大幅降低[4],因此客户端选择算法在针对客户端数据分布不均衡时会产生很大的影响。Nishio等人[1]提出了一个FedCS算法,该算法会从随机选择的客户端中筛选,在每轮训练开始前候选设备会向服务器发送计算能力、通信能力和数据量大小,服务器根据这些数据以贪心的思想尽可能多地选择参与者。Abdulrahman等人[5]提出FedMCCS算法,采用分层抽样过滤客户端,通过客户端的本地资源来预测客户端能否完成任务。郭佳慧等人[6]将背包模型引入客户端选择,结合客户端本地更新前后本地模型的权重差异,提出了OfflineKP-FL方法应用于离线场景。

单一的客户端选择算法在全局模型的精度上有所提高,但现实中客户端在服务器不提供报酬的情况下会表现出理性,不愿免费帮助服务器训练,并且会出现搭便车等恶意行为。因此有研究将激励机制引入联邦学习,一个好的激励机制既可以帮助服务器选择优质的客户端参与训练,同时也能激励更多的客户端参与到联邦学习中。在激励机制中,对于客户端训练的本地模型的评估,是选择参与者的重要指标,全局模型的性能取决于每个客户端的贡献[7]。目前在联邦学习应用中主要有三种贡献度量策略,即基于测试/自我报告的贡献评估、基于边际损失的贡献评估和基于相似度的贡献评估[8]。Deng等人[9]将客户端本地训练时的损失作为衡量客户端贡献的基础。Wang等人[10]针对水平联邦学习提出了一种直观的删除法来计算不同客户端在联邦学习中的贡献,通过对比删除某一个客户端后所形成的全局模型与原始模型之间的差异来衡量某个客户端的贡献。Nishio等人[11]设计一种没有开销流量且只有少量计算开销的逐步贡献计算的直观方法。Zhang等人[12]提出一种计算综合声誉的方法,以此来衡量客户端的训练和数据质量。

根据不同的衡量标准,国内外的研究团队提出了相应的激励机制。目前在联邦学习中应用的激励机制主要有博弈论、拍卖和契约理论三种,而拍卖方式拥有优秀的属性,它可以作为联邦学习激励机制的一个解决方案[13]。反向拍卖是一种与普通拍卖相反的拍卖形式,在反向拍卖中,有一个买家和多个卖家,在联邦学习的架构下,服务器可以看作是买家,而客户端则可以看作是卖家。Fan等人[14]设计了一种基于客户端数据量、EMD距离和报价的反向拍卖机制。但EMD距离通常包含客户端的数据分布,属于客户端的私有信息,现实中往往不会提供给服务器。因此,Zhang等人[12]提出了一种基于声誉的反向拍卖机制,声誉可以间接地反映客户端的数据质量。

上述激励机制的研究大多基于离线场景,会在联邦学习开始前进行客户端的选择,之后不再接受新的报价[15]。但在现实情况中,客户端可能会陆续到达,也可能会提前离开,这也使得现实场景更加复杂,现有的离线算法大多无法直接应用。动态不确定环境下的资源优化利用问题是一个经典的研究问题,已有大量的研究。在与联邦学习工作流程相似的众包领域,Zhao等人[16]讨论了在线众包场景下的激励机制,基于在线拍卖模型设计了在线机制。在私有云采购领域,Han等人[17]提出了一种剩余资源在线顺序采购拍卖,帮助云供应商在在线环境中采购服务器。联邦学习作为一个新的研究领域,同样面临参与训练者的随机性和动态不确定,在预算约束下如何在客户随机到达的情况下合理分配预算,优化选择客户端是提高联邦学习效率的一个关键问题。Mohammed等人[18]根据秘书问题思想,选择在测试精度方面最好的候选客户端参与训练。然而这会侵犯第一阶段的消费者主权,因此客户端倾向于推迟到达,从而使得任务“饥饿”。Zhang等人[15]设计了一个反向拍卖机制,将候选者分成两组,相互作对照组进行参与者选择。

为适应现实中的在线场景,本文结合已有的激励机制和在线场景的解决方案,提出了一个预算约束下的在线联邦学习激励算法。该算法能够在客户端随机到達的情况下合理分配预算动态选择客户端。并对已有的质量评估方法进行了改进,通过删除法计算模型在验证集上的损失来衡量客户端本地训练的模型对于全局模型的贡献,将客户端所训练模型的质量和报价作为选择客户端的标准。

1 系统模型

在线场景的定义即不同客户端的到达和离开时间是随机不确定的。因此,在客户端每轮都变化的情况下选择高质量的客户端参与训练是一个难题。

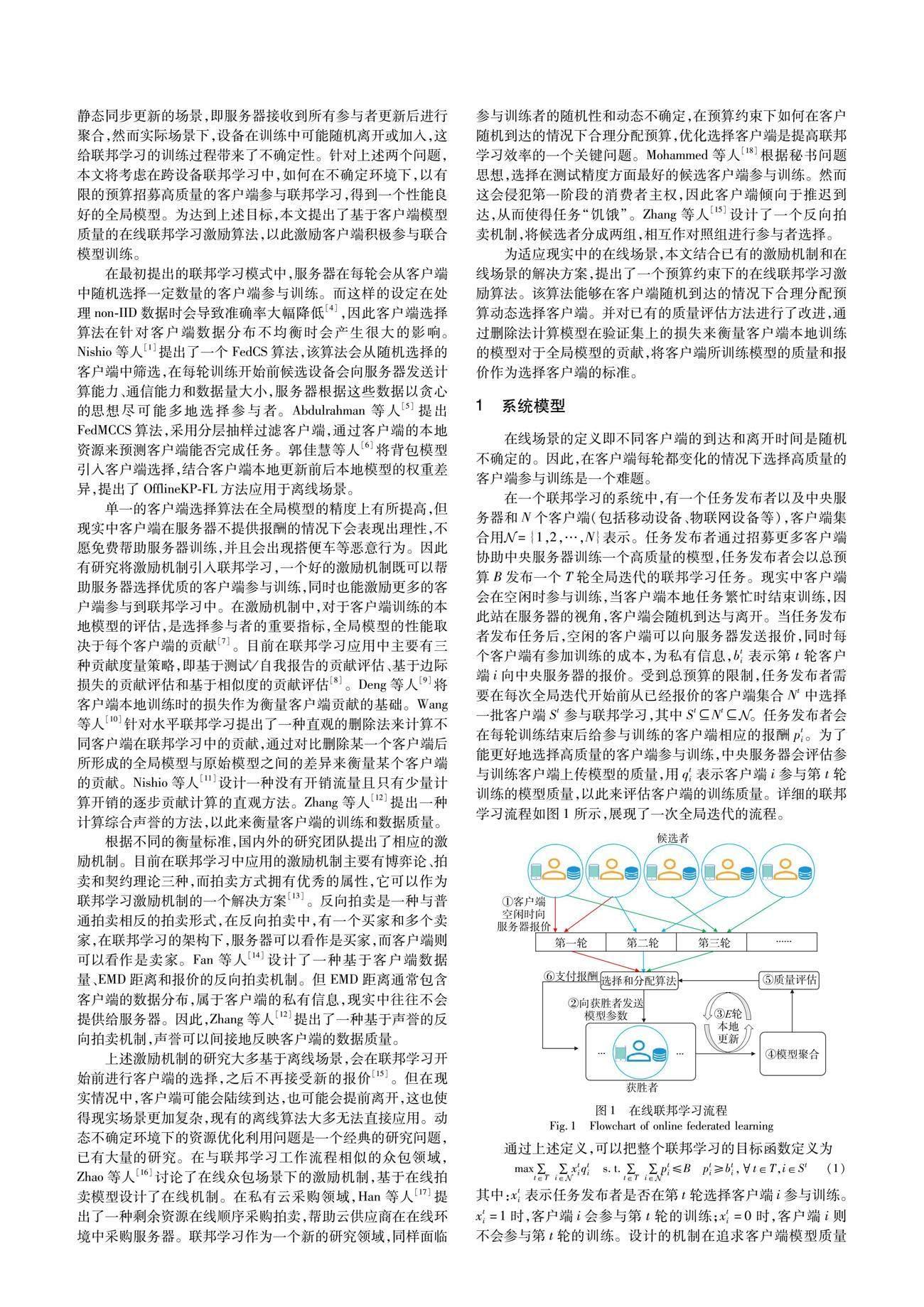

在一个联邦学习的系统中,有一个任务发布者以及中央服务器和N个客户端(包括移动设备、物联网设备等),客户端集合用Euclid Math OneNAp={1,2,…,N}表示。任务发布者通过招募更多客户端协助中央服务器训练一个高质量的模型,任务发布者会以总预算B发布一个T轮全局迭代的联邦学习任务。现实中客户端会在空闲时参与训练,当客户端本地任务繁忙时结束训练,因此站在服务器的视角,客户端会随机到达与离开。当任务发布者发布任务后,空闲的客户端可以向服务器发送报价,同时每个客户端有参加训练的成本,为私有信息,bti表示第t轮客户端i向中央服务器的报价。受到总预算的限制,任务发布者需要在每次全局迭代开始前从已经报价的客户端集合Nt中选择一批客户端St参与联邦学习,其中StNtEuclid Math OneNAp。任务发布者会在每轮训练结束后给参与训练的客户端相应的报酬pti。为了能更好地选择高质量的客户端参与训练,中央服务器会评估参与训练客户端上传模型的质量,用qti表示客户端i参与第t轮训练的模型质量,以此来评估客户端的训练质量。详细的联邦学习流程如图1所示,展现了一次全局迭代的流程。

其中:xti表示任务发布者是否在第t轮选择客户端i参与训练。xti=1时,客户端i会参与第t轮的训练;xti=0时,客户端i则不会参与第t轮的训练。设计的机制在追求客户端模型质量最大化的同时,需要满足以下三个性质:a)预算可行性,即支出不能超过总预算;b)激励相容性,即客户端每次报价等于其真实成本;c)个人理性,即支付给参与训练客户端的报酬大于等于其报价。

2 在线联邦学习激励机制设计

2.1 分阶段在线预算分配和质量评估

在线环境中,每轮能夠参与联邦学习的客户端会随着时间的推移而变动,传统的随机选择客户端方式在模型的准确率和收敛速度上都会存在一定程度的影响;同时由于预算限制,服务器需要在全局迭代中合理分配预算,使得整个联邦学习都有客户端参与训练;而客户端往往都是自私的,在没有限制措施的情况下会出现搭便车、误标标签和谎报价格等情况。因此,需要同时解决预算分配、客户端训练质量评估、客户端选择以及报酬支付四个难题。

McMahan等人[3]在最初的联邦学习设想中并未考虑动态变化的客户端集合,而是假定有一群固定的客户端集合,每轮会从这些客户端中选择一定比例的客户端参与联邦学习。然而现实中客户端参与时间具有不确定性,这也使得预算的分配成为一个难题,若简单地将总预算平均分配到每一轮,会出现客户端少时的预算浪费和客户端多时的预算不足。针对此特点,本文采用文献[17]所提出的多阶段采样接收方法,将T轮联邦学习划分为L=log2T」+1个阶段,如图2所示,每个阶段内期望训练轮次是前一阶段的两倍。特别地,当总训练轮数T不是2的指数次幂时,早期阶段的轮数可随实际情况变化。每一轮训练开始前会有一个单位时间来等待客户端报价,然后服务器会根据接收到的客户端报价进行选择参与训练的客户端。本文方法将根据单位时间内报价的客户端数量调整训练轮次。预算按照阶段进行划分,因每个阶段内期望轮次是前一阶段的两倍,所以从第一个阶段开始,预算分别为21-LB,21-LB,22-LB,…,2-L+l-1,2-1B,除第一个阶段外,其余阶段的预算都是前一个阶段的两倍。一个阶段内的所有训练轮次将共享该阶段的预算,在出现参与者数量波动时能根据选择的参与者灵活调整支付的费用。由于存在不确定性,预算可能在阶段内提前耗尽,也可能在阶段结束时还存在剩余,这些剩余的预算不会被再次分配或使用。这些历史阶段的预算使用情况和客户端到达数据将在下一阶段成为优化客户端选择的依据。本文将所有客户端每轮的报价信息保存在样本集中,在每个阶段结束时,通过样本集中的信息计算一个客户端质量密度阈值,该阈值将会在下一个阶段中作为客户端选择的参数。

计算质量密度阈值的基础是客户端质量评估。质量评估是客户端选择的一个重要指标,它不仅在每轮客户端选择时会用到,同时在每个阶段结束时的阈值计算中也会用到。在第1章相关工作中已经介绍了目前已有的客户端贡献的评估方法。文献[10]提出的删除法能够直观地展现出各个客户端使用本地数据更新的本地模型对于全局模型的贡献,其将客户端i的影响定义为influence-i=1n∑nj=1|j--ij|,其中n是数据集的大小,j是所有客户端训练的模型聚合的全局模型对第j个实例的预测结果,-ij是除了客户端i外其他客户端的模型聚合后的模型对第j个实例的预测结果。然而计算预测值在某些情况下会出现较大的波动,本文将除去客户端i聚合后的模型在验证集上的损失作为衡量客户端影响的标准。该模型损失越大则代表客户端i对全局模型的影响越大,即客户端i的模型质量较好;损失越小则代表客户端i对全局模型的影响越小,即客户端i的模型质量较差。本文具体的质量评估方法将在3.2节详细介绍。

2.2 预算约束下的在线联邦学习激励算法

在线环境中,每轮能够参与联邦学习的客户端是动态变化的,预算分配成为难题。同时,客户端是自私的,如果没有合适的激励机制,客户端存在搭便车、误标标签和谎报价格等情况。针对上述难点,本文参考文献[17]中所提出的在线顺序采购机制(online sequential procurement with budget constraint,OSPB),针对联邦学习场景,优化机制并提出了预算约束下的在线联邦学习激励算法(incentive algorithm for online federated learning,IAOFL)。OSPB机制是一个云服务器资源采购的算法,虽然与在线联邦学习场景类似,但无法直接将该算法应用于联邦学习场景。因此,本文对OSPB机制进行了改进,使其能够适用于联邦学习的场景。改进点如下:a)引入客户端模型质量代替原算法中的边际需求估值;b)设计min_num和max_num两个参数来限制参与联邦学习的客户端数量,以此避免由阈值选择客户端数量的波动而造成模型精度的波动。

3 实验分析

3.1 实验设置

本节将会评估IAOFL与其他激励机制在在线环境下的性能。实验将采用EMNIST-Balanced[20]和CIFAR-10[21]两个数据集进行实验。其中EMNIST-Balanced有47个标签类别,包含数字和字母,图片大小为28×28的灰度图像。数据集中共包含112 800个训练样本和18 800个测试样本。数据集的训练采用卷积神经网络架构,包括两层5×5的卷积层,每个卷积层后是ReLU激活函数和2×2的最大池化层。CIFAR-10包含10类不同类别的图像,图片大小为32×32的彩色图像。数据集共包含50 000个训练样本和10 000个测试样本。数据集的训练采用三层5×5的卷积层,每个卷积层后是ReLU激活函数和2×2的最大池化层。

实验中共有100个客户端,数据集中的训练样本将以独立同分布的方式平均分配给这100个客户端。为体现不同客户端的质量,实验中将会设置部分搭便车和存在误标标签的低质量客户端。搭便车客户端不会进行本地训练,包含误标标签的客户端会有30%标签存在误标。每个客户端的到达符合泊松分布,会在每轮加入适当的噪声来扩大不同轮次客户端到达数量的差异。到达后的报价在[0,1]随机生成,由于客户端的数据量是相同的,所以报价可以代表每个客户端所有数据的价值。

为了在在线环境中进行比较,共挑选了两个基准:第一个是OSPB机制(未改进的应于云服务器资源采购的在线算法);第二个是OSPM(online selection and payment mechanism)机制[15],该机制通过客户端的声誉与报价进行选择。为方便比较,将算法中的客户端声誉替换为客户端质量,并将客户端的报价调整为与本文场景一致。

3.2 质量评估

为了评估模型质量,将两个数据集中测试样本划分一半作为验证集,用于评估客户端训练质量,剩余一半样本用作全局模型的测试。第3.1节中已经阐述了可以运用删除客户端i后聚合的模型在验证集上的损失大小代表客户端i对全局模型的贡献,因此将贡献定义为

lossti=L(ωt-i)=1n∑ni=1L(xi,yi:ωt-i)(2)

其中:ωt-i表示除客户端i外其他参与训练客户端所聚合的模型;n为验证集的大小。而losst={lossti|i∈St}表示第t轮所有参与训练客户端贡献的集合。然而随着模型的训练,用删除法计算的损失会逐渐减小,直接使用该损失会对整个算法造成影响,因此在实验中会对损失进行归一化处理:

qti=min(lossti-min(losst)max(losst)-min(losst),ε)(3)

其中:ε是一个很小的正数,使得质量大于0。处理之后的质量将会映射到[ε,1]。而客户端i的最新质量定义为qlatesti=average(qi),qi是客户端i历史质量集合,即计算客户端历史质量的平均值。在选择客户端时会使用qlatesti进行比较和计算,通过所有历史质量计算出的结果更能表示客户端的质量。

由于L(ωt-i)能够在一定程度上代表客户端i在第t轮对全局模型的贡献,所以可以通过比较L(ωt-i)和L(ωt)来判断客户端i是否对全局模型有正向贡献。当L(ωt-i) 3.3 实验结果 本文进行了两组对比实验来验证IAOFL算法在不同场景和不同数据集上的表现。 a)如图3所示,是在预算256的情况下进行512轮联邦学习后得到的模型精度。设置了不同百分比搭便车客户端,用这些客户端模拟现实中的客户端。从图3(a)可以看出,IAOFL算法和OSPB机制通过动态选择客户端能够得到比OSPM更高的准确率,而改进后的IAOFL算法对比OSPB机制也有一定的提升。综合来看,在EMNIST-B数据集上,本文提出的IAOFL算法的平均精度比OSPM和OSPB机制分别高出5%和1%。图3(b)则是在相对较难的数据集CIFAR-10上的表现,可以看出本文IAOFL算法有较好的性能,在不同比例的搭便车客户端情况下都能训练出优于基準的模型。IAOFL算法的平均精度比OSPM和OSPB机制分别高出14%和6%。 b)图4是三种算法在预算为320的情况下经过512轮训练后的结果,100个客户端中有10%的搭便车客户端和10%存在误标标签的客户端。IOAFL算法由于加入了客户端数量限制和恶意客户端筛选,能在联邦学习的过程中跟随客户端到达的数量和训练的质量进行动态调整,从而聚合出模型精度更高的模型。在EMNIST-B数据集上,本文提出的IAOFL算法对比其他两个基准能有4%的精度提升;在CIFAR-10数据集上,IAOFL算法对比基准分别有10%和8%的精度提升。 表1中总结了不同场景中三种机制的性能表现,能够看出,本文提出的IAOFL算法在不同预算和恶意客户端类型的情况下都能取得更高的准确率。同时,在较难的数据集上会有比简单数据集上更大的优势,在CIFAR-10数据集的训练任务中,由于训练任务相对较难,任何恶意客户端都会对全局模型的聚合产生严重的负面影响,IAOFL则能够对部分恶意客户端进行识别,能在一定程度上解决恶意客户端对全局模型的影响。 3.4 算法应用讨论 Damaskinos等人[22]指出在线学习系统是许多流行应用的基础,比如新闻推荐或交互式社交网络(如Facebook、Twitter、Linkedin),这些系统涉及大量具有高时效性的数据,通常在几小时甚至几分钟内就会过时,意味着数据的实时性和及时处理对于这些应用至关重要。本文提出的IAOFL算法在这种环境中具有显著的应用潜力,算法的核心功能之一是帮助这些软件公司以合适的价格选择高质量的客户端进行本地训练。由于软件的使用者遍布全世界,各个地区的设备空闲时间存在差异,设备参与联邦学习的时间也存在较大差异,这导致不同时间段的参与者数量会波动。而IAOFL算法能够很好地适应这种环境,根据实时的客户端数量进行自适应的联邦学习,确保在不同时间和地点都能够高效地利用参与者的计算资源。通过IAOFL算法,能够选择高质量的客户端参与训练,且算法始终将客户端的数量控制在合理区间,这能帮助软件公司训练出更加稳健的模型。 在新聞推荐和社交网络等领域,IAOFL算法的应用有望为实时数据处理和个性化推荐带来显著的改进。通过适应性和高效性,它可以提供更快速和精确的结果,有助于提高用户体验和满足高时效性数据应用的需求。 4 结束语 本文针对更加符合实际应用的在线场景,提出了预算约束下的在线联邦学习激励算法,更好地帮助任务发布者在客户端动态变化的场景下选择高质量的客户端参与联邦学习。对选择的客户端数量和质量进行了有效地筛选,以此降低客户端数量和恶意客户端对全局模型的影响。同时,从理论上证明了本文算法具有激励相容性、个人理性和预算可行性,并通过实验验证了本文算法在有恶意客户端的情况下可以得到精度更高的模型。 目前质量评估中的恶意客户端筛选在训练后期识别准确率较低,同时全局模型的聚合采用的是联邦平均算法。未来将对筛选规则进行改进,使其在后期也能有较好的识别效果,而聚合算法的改进也是一个后续研究的方向。 参考文献: [1]Nishio T,Yonetani R.Client selection for federated learning with heterogeneous resources in mobile edge[C]//Proc of IEEE International Conference on Communications.Piscataway,NJ:IEEE Press,2019:1-7. [2]Hasan M.State of IoT 2022:number of connected IoT devices growing 18% to 14.4 billion globally[EB/OL].(2022).https://iot-analy-tics.com/number-connected-iot-devices/. [3]McMahan B,Moore E,Ramage D,et al.Communication-efficient learning of deep networks from decentralized data[C]//Proc of the 20th International Conference on Artificial Intelligence and Statistics.2017:1273-1282. [4]Zhao Yue,Li Meng,Lai Liangzhen,et al.Federated learning with non-IID data[EB/OL].(2022)[2023-07-01].https://arxiv.org/pdf/1806.00582.pdf. [5]Abdulrahman S,Tout H,Mourad A,et al.FedMCCS:multicriteria client selection model for optimal IoT federated learning[J].IEEE Internet of Things Journal,2021,8(6):4723-4735. [6]郭佳慧,陈卓越,高玮,等.基于背包模型的联邦学习客户端选择方法[J].物联网学报,2022,6(4):158-168.(Guo Jiahui,Chen Zhuoyue,Gao Wei,et al.Clients selection method based on knapsack model in federated learning[J].Journal of Internet of Things,2022,6(4):158-168.) [7]Warrier L C,Ragesh G K.A review on game theoretical incentive mechanism for federated learning[C]//Proc of the 19th IEEE India Council International Conference.Piscataway,NJ:IEEE Press,2022:1-5. [8]Huang Jiyue,Talbi R,Zhao Zilong,et al.An exploratory analysis on userscontributions in federated learning[C]//Proc of the 2nd IEEE International Conference on Trust,Privacy and Security in Intelligent Systems and Applications.Piscataway,NJ:IEEE Press,2020:20-29. [9]Deng Yongheng,Lyu Feng,Ren Ju,et al.FAIR:quality-aware federated learning with precise user incentive and model aggregation[C]//Proc of IEEE Conference on Computer Communications.Piscataway,NJ:IEEE Press,2021:1-10. [10]Wang Guan,Dang C X,Zhou Ziye.Measure contribution of participants in federated learning[C]//Proc of IEEE International Confe-rence on Big Data.Piscataway,NJ:IEEE Press,2019:2597-2604. [11]Nishio T,Shinkuma R,Mandayam N B.Estimation of individual device contributions for incentivizing federated learning[C]//Proc of IEEE Globecom Workshops.Piscataway,NJ:IEEE Press,2020:1-6. [12]Zhang Jingwen,Wu Yuezhou,Pan Rong.Incentive mechanism for horizontal federated learning based on reputation and reverse auction[C]//Proc of Web Conference.New York:ACM Press,2021:947-956. [13]Tu Xuezhen,Zhu Kun,Luong N C,et al.Incentive mechanisms for federated learning:from economic and game theoretic perspective[J].IEEE Trans on Cognitive Communications and Networking,2022,8(3):1566-1593. [14]Fan Sizheng,Zhang Hongbo,Zeng Yuchun,et al.Hybrid blockchain-based resource trading system for federated learning in edge computing[J].IEEE Internet of Things Journal,2021,8(4):2252-2264. [15]Zhang Jingwen,Wu Yuezhou,Pan Rong.Online auction-based incentive mechanism design for horizontal federated learning with budget constraint[EB/OL].(2022)[2023-07-01].https://arxiv.org/pdf/2201.09047.pdf. [16]Zhao Dong,Li Xiangyang,Ma Huadong.How to crowdsource tasks truthfully without sacrificing utility:online incentive mechanisms with budget constraint[C]//Proc of IEEE Conference on Computer Communications.Piscataway,NJ:IEEE Press,2014:1213-1221. [17]Han Jingti,Wu Xiaohong,Liu Jianguo.An online sequential procurement mechanism under uncertain demands in multi-cloud environment[J].International Journal of Approximate Reasoning,2018,103:152-167. [18]Mohammed I,Tabatabai S,Al-Fuqaha A,et al.Budgeted online selection of candidate IoT clients to participate in federated learning[J].IEEE Internet of Things Journal,2020,8(7):5938-5952. [19]Myerson R B.Optimal auction design[J].Mathematics of Operations Research,1981,6(1):58-73. [20]Cohen G,Afshar S,Tapson J,et al.EMNIST:extending MNIST to handwritten letters[C]//Proc of International Joint Conference on Neural Networks.Piscataway,NJ:IEEE Press,2017:2921-2926. [21]Krizhevsky A,Hinton G.Learning multiple layers of features from tiny images[M]//Handbook of Systemic Autoimmune Diseases.2009:158. [22]Damaskinos G,Guerraoui R,Kermarrec A M,et al.Fleet:online fede-rated learning via staleness awareness and performance prediction[J].ACM Trans on Intelligent Systems and Technology,2022,13(5):1-30.