基于动态频域分解的乐队指挥动作生成

贺鑫 刘凡 陈德龙 周睿志

摘 要:

近年來,音乐与人体动作之间的内在关联一直以来都在被广泛研究。然而,很少有人关注音乐驱动的乐队指挥动作生成这一任务,即以音乐为输入信号,生成与音乐节奏和语义相协调的乐队指挥动作。聚焦于这一任务,针对指挥动作多种语义成分时空重合的特性,提出基于动作动态频域分解(dynamic frequency-domain motion decomposition,DFMD)的指挥动作生成方法。具体地,首先利用节拍信息构建滤波器,将指挥动作分解成高频和低频分量;接着,通过深度卷积神经网络动态地学习这些分量;最后合成最终的指挥动作。在大规模指挥动作数据集ConductorMotion100上进行的实验中,基于DFMD的指挥动作生成方法得到的低频动作分量和高频动作分量的标准差分别达到了4.457 9和9.646 6,与真实动作十分接近。该方法突破了现有基于时域或空间域动作分解中连贯性与协调性不可兼得的局限,并有效避免了大幅值低频动作对小幅值高频动作的影响。可视化结果证明生成的动作自然、美观、多样,且与音乐信号紧密同步。为音乐与动作之间的关联提供了新的解释,并为音乐表演领域带来了创新的应用前景。

关键词:跨模态生成;人体动作生成;频域分解;动作分解;音乐驱动生成

中图分类号:TP391.4 文献标志码:A 文章编号:1001-3695(2024)03-042-0923-05doi: 10.19734/j.issn.1001-3695.2023.07.0321

Conducting motion generation based on dynamic frequency domain decomposition

He Xin, Liu Fan, Chen Delong, Zhou Ruizhi

(School of Computer & Information, Hohai University, Nanjing 210098, China)

Abstract:

In recent years, the intrinsic relationship between music and motions have been widely studied. However, very few efforts have been made to develop music-driven conducting motion generation models, which takes music as input signal to generate conducting motion in harmony with music rhythm and semantics. This paper proposed a music-driven conducting motion generation approach based on DFMD. Specifically, firstly it constructed a filter using the beat information to decompose the command action into high and low frequency components. Then, a deep convolutional neural network dynamically learnt these components, and it synthesized the final command action. Experimental results on the large-scale ConductorMotion100 dataset show that the standard deviation of the generated low-frequency and high-frequency motion components is 4.457 9 and 9.646 6, which are very close to the real motions. The proposed method breaks through the limitations of coherence and coordination in time-domain or spatial-domain motion decomposition, and effectively avoids the influence of large-value low-frequency motion on small-value high-frequency motion. The visualized results show that the generated movements are natural, beautiful, diverse, and closely synchronize with the music signal. It provides a new understanding of the connection between music and movement, and brings innovative application prospects to the field of musical performance. Key words:cross-model generation; human motion generation; frequency domain decomposition; motion decomposition; music-driven generation

0 引言

指挥是交响乐团的灵魂。自中世纪欧洲教堂唱诗班到二十一世纪的现代音乐,指挥技术与艺术不断发展,已经成为一门内容丰富的学科[1]。指挥的肢体语言复杂多变[2],需要在乐团演奏时实时地传达节拍、力度、情感、演奏法等多种信息[3],同时保持一定的风格与美感。近年来,随着深度学习算法理论的发展与计算性能的飞速提升,人工智能领域的学者已经成功地对多种人类艺术进行建模与学习。深度学习已经能生成包括诗歌艺术、绘画艺术、音乐艺术、舞蹈艺术在内的多种人类艺术形式。

然而,学界对于指挥艺术的建模研究还比较初步,且主要面向判别类的任务,如节拍跟踪、拍式识别、演奏法识别、情感识别等。生成式任务,即音乐驱动的指挥动作生成任务,指的是以音乐为条件控制信号,生成与之节奏同步且语义相关的指挥动作,而这部分的相关研究工作开展比较少。Wang等人[4]在2003年提出了首个指挥动作生成方法。随后,几种基于规则的生成方法[5~7]陆续被提出,但这些方法无法灵活地学习真实指挥动作的内在规律,导致生成动作重复性强、多样性差。目前,在各种生成任务中广泛成功的深度学习方法尚未被应用至音乐驱动的指挥动作生成任务上。

此外,指挥动作同时包含节拍、演奏法、力度以及音乐情感等信息,可视作由高频动作分量与低频动作分量叠加而成的一种稳定信号,其中高频分量包含了幅值较小但频率较高的节拍、力度等信息,低频分量包含了幅值较大但频率较低的情感以及身体朝向等成分。由于高低频动作分量之间幅值相差较大,模型对低频动作的学习将会占主导地位,这将导致高频动作的学习效果欠佳。为解决这一问题,常用的方法为动作分解方法,包括时域分解[8~12]与空间域分解[13,14],均存在一定的缺陷。如图1所示,时域分解将动作按照时间轴方向进行划分,虽然保留了动作的时域信息,但丢失了空间域信息,使得基于时域分解方法生成的动作往往连贯但不协调;而空间域分解将动作按空间轴方向进行划分,虽然保留了动作的空间信息,但丢失了时域信息,使得基于空间域分解方法生成的动作往往协调但不连贯。

本文提出了一种基于动态频域分解(dynamic frequency-domain motion decomposition,DFMD)的乐队指挥动作生成方法,可以同时保留时域信息和空间域信息。由于高低频动作的分布界限受音乐节奏影响,基于固定阈值的方法并不能够确保分解后的动作成分之间相互独立,所以本文提出根据音乐节奏自适应地确定用于频域分解的阈值,进行高低频动作的动态分解。具体地,首先通过音乐节奏估计算法动态地计算局部的音乐节奏,确定对指挥动作进行高通分解和低通分解的频率阈值,从而将动作序列分解为高频动作分量和低频动作分量两个;然后,通过两个生成器分别对高低频动作分量进行独立学习,再将两个模型的输出结果进行合成,得到最终的指挥动作。本文在ConductorMotion100数据集上进行实验,采用生成动作的标准差作为实验指标来衡量生成动作的多样性。实验结果表明,本文方法生成的指挥动作的多样性更接近真实动作,优于CVPR18[15]、MM18[16]、ICASSP18[17]中三个基于深度学习的方法。与文献[4~7]基于规则的指挥动作生成方法相比,本文方法可以生成更自然、美观、多样且与音乐同步的指挥动作。

1 相关工作

音乐驱动的指挥动作生成从属于音乐驱动的人体动作生成(audio-to-motion translation)领域。由于现在尚不存在基于深度学习的乐队指挥动作生成方法,本章将介绍现有的基于深度学习的音乐驱动的人体动作生成方法。双模态音频-动作生成任务涉及建立复杂的音频-动作依赖,相同音频条件下存在多种合理动作,使生成成为一对多病态问题,增加生成难度。以前,基于检索法从音频-动作数据库检索相似样本作为输出,但动作多样性低,时间复杂度高,受数据库规模制约。近年来,深度生成模型不断发展,并成功应用于人体动作条件生成任务,取得了一定进展。这类方法主要可以分为基于确定性模型的生成方法[18]、基于概率模型的生成方法[19~25]与基于动作分解的生成方法[11~14]三类。

确定性模型是最简单直接的人体动作条件生成方法,将生成动作与真实动作在样本空间中的欧氏距离作为损失函数来指导模型的学习。这类方法将人体动作的条件下生成问题建模为一个回归问题。文献[18]使用二维卷积神经网络提取音频频谱特征,随后使用长短期记忆网络(long short term memory,LSTM)學习动作与音频特征之间的时间依赖性。确定性模型与回归损失在人体动作的条下件生成缺陷,在于无法从给定音频输入生成多样的动作。

近年来,研究人员们逐渐意识到确定性模型与回归损失在人体动作的条件生成这一病态生成任务上难以避免的缺陷,因此基于概率模型的方法吸引了越来越多的注意力。与确定性模型不同,概率模型试图对真实人体动作的条件分布进行建模,使得模型不必严格生成与真实样本完全一致的动作,在一定程度上缓解了回归损失带来的过渡平滑问题。在近几年中被广泛研究的多种深度生成模型,例如变分自编码器、生成对抗网络、流模型等,都被成功地应用在了这一任务上。然而,绝大部分基于概率模型的生成方法[19~25]仍然保留着回归损失,同样存在确定性分解中使用回归损失的缺陷。

动作分解是人体动作条件生成领域内另一个值得注意的研究趋势。其中,舞蹈动作的时域分解是最常用的分解方法。这类方法首先将复杂的舞蹈动作在以节拍为依据分为基础的分解动作单元,再学习如何对这些单元进行排列组合。然而,这种方法引入了额外的数据标注量工作,且限制了生成动作的多样性。文献[11,12]分别令模型首先学习低层次的舞步单元(dance units)[11]或关键姿态(key pose)[12],再训练高层次的模型来编排学得的舞步单元或填充关键姿态之间的动作。其缺陷在于节拍检测的误差和数据错位都会极大影响模型的学习效果。还有学者提出了空间域的动作分解。文献[13,14]将小提琴家的演奏姿态数据分为左手、右手以及其余身体部分,并使用不同模型分别学习这些动作的生成。然而该种方法会使得该类方法生成的动作缺乏协调性。

2.5 网络结构

节拍检测器Ebeat根据二维的梅尔频谱图来预测所有的对应节拍位置。Ebeat分为三个部分:a)音乐编码器Emusic,用于从梅尔频谱图中提取音乐特征;b)分类头Hmusic,用于根据音乐特征对每一时间帧进行分类,得到对应的激活向量;c)动态贝叶斯网络(dynamic Bayesian network,DBN)[27],用于对激活向量进行解码,使得预测出的节拍位置具有更合理的全局分布。

Emusic包含三个组,每组由三个残差层[28]和一个池化层组成,最终输出的通道数为64。残差层中包含卷积核为3×3的卷积层、批归一化层(batch normalization)、ReLU激活函数与基于1×1卷积的残差连接。

Hmusic基于时域卷积网络(temporal convolutional network,TCN)[29],该网络有三个带残差连接的一维空洞卷积层、两个全连接层,每一个空洞卷积层的卷积核大小为5,通道数都是64。全连接层输出维度分别为32和1,用于降低通道数,此外,还包含了sigmoid激活函数,用于将输出结果控制在0~1,Hmusic的最终输出是激活向量,向量中每一个元素的大小表示对应时间帧出现节拍的概率。

动作生成器G也基于时域卷积网络,该网络有5个一维空洞卷积层和残差块。每一层的卷积核大小为5,由于每一个时间步长的输入是一个46维的音乐特征向量,第一层有46个通道,其他层通道数都是64。

由于最初的TCN是为预测类任务而设计的,所以它采用的是因果卷积。为了学习双向依赖,本文将其改为了非因果卷积。由于动作数据已归一化,本文使用tanh作为最后一层的激活函数,其他层的激活函数为ReLU。

3 实验

3.1 数据准备

本文采用ConductorMotion100[30]数据集进行实验。ConductorMotion100数据集中的每一个样本对为60 s的音频声波信号—指挥动作序列样本对,总时长为100 h,采样率为30 fps。其中,指挥动作序列Yi在每一个时间步为一个20维特征向量,对应于姿态序列中头顶、鼻子、颈部、双肩、双肘、双手、臀部这10个指挥动作关键点的二维坐标。

首先使用梅尔频谱提取器和音频特征提取器分别提取每一个样本对中Wi对应的梅尔频谱图Mi和音频特征序列Xi。其中,Mi在每一个时间步上的特征是一个128维的梅尔频谱特征向量(Mel bank features),为128个频带的输入表示,由于只包含梅尔频谱特征,梅尔频谱图的归一化处理是对整体进行的;Xi在每一时间步上的音频特征是一个46维特征向量,包括1维的频谱质心(spectral centroid)、1维的触发音力度(onset strength)、1维的主要局部脉冲(predominant local pulse,PLP)、20维梅尔频率倒谱系数(Mel frequency cepstral coefficients,MFCC),以及以上23维特征的一阶差分,与梅尔频谱图不同,音频特征的每一维独立地进行归一化处理。

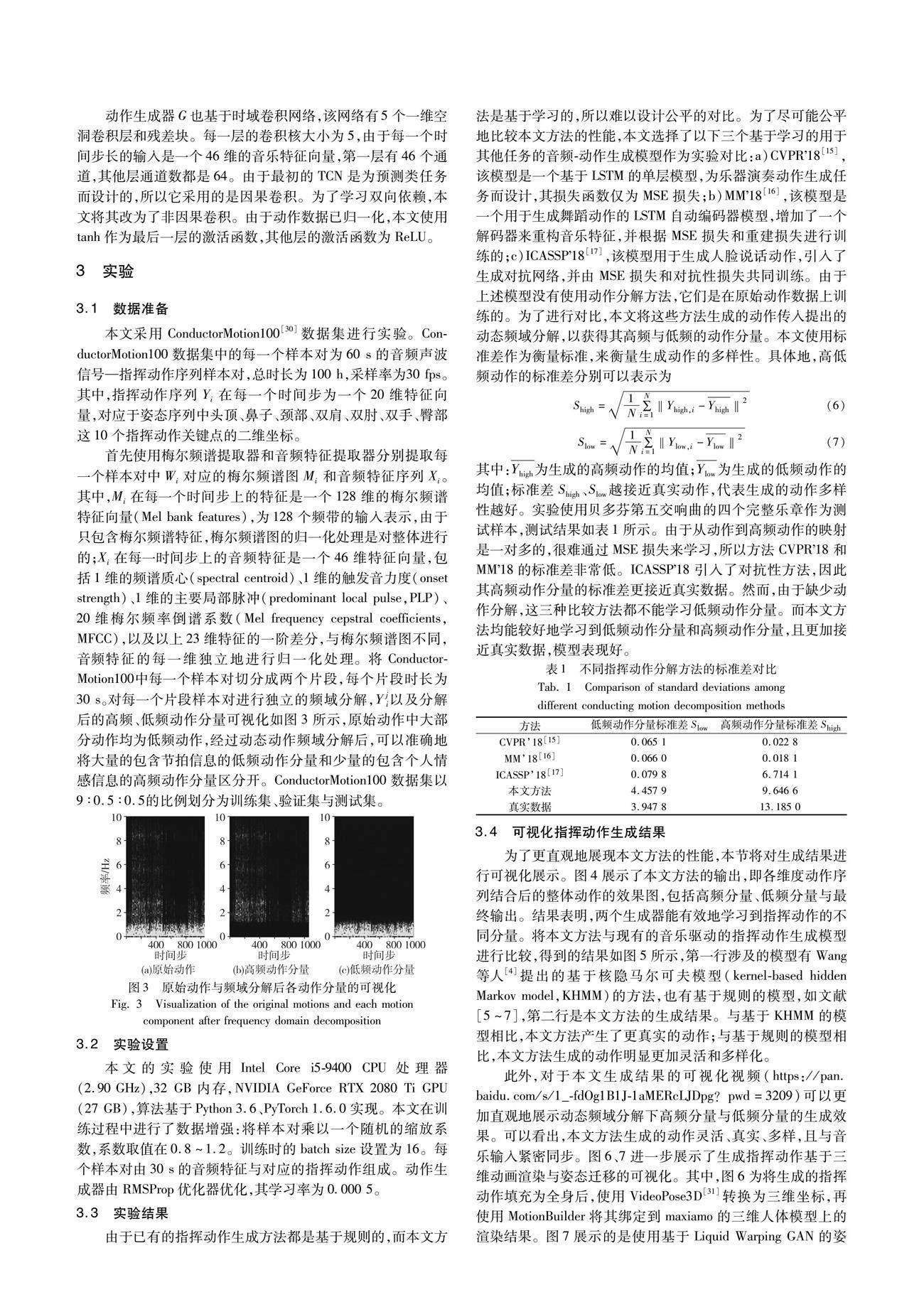

将Conductor-Motion100中每一个样本对切分成两个片段,每个片段时长为30 s。对每一个片段样本对进行独立的频域分解,Yji以及分解后的高频、低频动作分量可视化如图3所示,原始动作中大部分动作均为低频动作,经过动态动作频域分解后,可以准确地将大量的包含节拍信息的低频动作分量和少量的包含个人情感信息的高频动作分量区分开。

ConductorMotion100数据集以9∶0.5∶0.5的比例划分为训练集、验证集与测试集。

3.2 实验设置

本文的实验使用Intel Core i5-9400 CPU处理器(2.90 GHz),32 GB内存,NVIDIA GeForce RTX 2080 Ti GPU (27 GB),算法基于Python 3.6、PyTorch 1.6.0实现。

本文在训练过程中进行了数据增强:将样本对乘以一个随机的缩放系数,系数取值在0.8~1.2。训练时的batch size设置为16。每个样本对由30 s的音频特征与对应的指挥动作组成。动作生成器由RMSProp优化器优化,其学习率为0.000 5。

3.3 实验结果

由于已有的指挥动作生成方法都是基于规則的,而本文方法是基于学习的,所以难以设计公平的对比。为了尽可能公平地比较本文方法的性能,本文选择了以下三个基于学习的用于其他任务的音频-动作生成模型作为实验对比:

a)CVPR18[15],该模型是一个基于LSTM的单层模型,为乐器演奏动作生成任务而设计,其损失函数仅为MSE损失;

b)MM18[16],该模型是一个用于生成舞蹈动作的LSTM自动编码器模型,增加了一个解码器来重构音乐特征,并根据MSE损失和重建损失进行训练的;

c)ICASSP18[17],该模型用于生成人脸说话动作,引入了生成对抗网络,并由MSE损失和对抗性损失共同训练。

由于上述模型没有使用动作分解方法,它们是在原始动作数据上训练的。为了进行对比,本文将这些方法生成的动作传入提出的动态频域分解,以获得其高频与低频的动作分量。本文使用标准差作为衡量标准,来衡量生成动作的多样性。具体地,高低频动作的标准差分别可以表示为

其中:Yhigh为生成的高频动作的均值;Ylow为生成的低频动作的均值;标准差Shigh、Slow越接近真实动作,代表生成的动作多样性越好。

实验使用贝多芬第五交响曲的四个完整乐章作为测试样本,测试结果如表1所示。由于从动作到高频动作的映射是一对多的,很难通过MSE损失来学习,所以方法CVPR18和MM18的标准差非常低。ICASSP18引入了对抗性方法,因此其高频动作分量的标准差更接近真实数据。然而,由于缺少动作分解,这三种比较方法都不能学习低频动作分量。而本文方法均能较好地学习到低频动作分量和高频动作分量,且更加接近真实数据,模型表现好。

3.4 可視化指挥动作生成结果

为了更直观地展现本文方法的性能,本节将对生成结果进行可视化展示。图4展示了本文方法的输出,即各维度动作序列结合后的整体动作的效果图,包括高频分量、低频分量与最终输出。结果表明,两个生成器能有效地学习到指挥动作的不同分量。

将本文方法与现有的音乐驱动的指挥动作生成模型进行比较,得到的结果如图5所示,第一行涉及的模型有Wang等人[4]提出的基于核隐马尔可夫模型(kernel-based hidden Markov model,KHMM)的方法,也有基于规则的模型,如文献[5~7],第二行是本文方法的生成结果。与基于KHMM的模型相比,本文方法产生了更真实的动作;与基于规则的模型相比,本文方法生成的动作明显更加灵活和多样化。

此外,对于本文生成结果的可视化视频(https://pan.baidu.com/s/1_-fdOg1B1J-1aMERcLJDpg?pwd=3209)可以更加直观地展示动态频域分解下高频分量与低频分量的生成效果。可以看出,本文方法生成的动作灵活、真实、多样,且与音乐输入紧密同步。

图6、7进一步展示了生成指挥动作基于三维动画渲染与姿态迁移的可视化。其中,图6为将生成的指挥动作填充为全身后,使用VideoPose3D[31]转换为三维坐标,再使用MotionBuilder将其绑定到maxiamo的三维人体模型上的渲染结果。图7展示的是使用基于Liquid Warping GAN的姿态迁移方法[32],将生成的指挥动作迁移至给定图像上的效果。

4 结束语

本文提出了基于动态频域分解的指挥动作生成方法,相较于现有传统方法,本文方法可以生成更加自然、美观、多样,且与音乐同步的指挥动作,突破了现有动作分解方法中连贯性与协调性不可兼得的局限。本文提出的动作动态频域分解以音乐节奏为依据,将动作分解为高频分量与低频分量,显著降低了学习难度。未来的研究工作将考虑进一步拓宽本文提出的基于动态频域分解的乐队指挥动作生成方法的应用,在舞蹈生成、说话姿势生成等任务上验证本文方法的可行性。

参考文献:

[1]李严君. 乐队指挥及中西方指挥形式研究[J]. 北方音乐,2020,9(18): 251-252. (Li Yanjun. A study of orchestra conducting and Chinese and western forms of conducting[J]. Northern Music,2020,9(18): 251-252.)

[2]张金鑫. 多样化乐队指挥形式的探究[J]. 当代音乐,2018(6): 108-109. (Zhang Jinxin. Exploration of diverse band conducting forms[J]. Contemporary Music,2018(6): 108-109.)

[3]程酢培. 试论指挥“图式”的重要性[J]. 当代音乐,2016(14): 74-77. (Cheng Zuopei. The importance of “schema” in conducting[J]. Contemporary Music,2016(14): 74-77.)

[4]Wang Tianshu,Zheng Nanning,Li Yan,et al. Learning kernel-based HMMs for dynamic sequence synthesis[C]// Proc of the 10th Pacific Conference on Computer Graphics and Applications. Piscataway,NJ: IEEE Press,2002: 87-95.

[5]Ruttkay Z,Huang Zhisheng,Eliens A. Gestures for embodied agents with logic programming[C]// Proc of International Workshop on Constraint Solving and Constraint Logic Programming. Berlin: Springer-Verlag,2003: 266-284.

[6]Reidsma D,Nijholt A,Bos P. Temporal interaction between an artificial orchestra conductor and human musicians[J]. Computers in Entertainment,2008,6(4): 1-22.

[7]Ryosuke T,Yusaku M,Tomoo I,et al. Multiple virtual conductors allow amateur orchestra players to perform better and more easily[C]// Proc of the 20th International Conference on Computer Supported Coo-perative Work in Design. Piscataway,NJ: IEEE Press,2016:486-491.

[8]Ye Zijie,Wu Haozhe,Jia Jia,et al. ChoreoNet: towards music to dance synthesis with choreographic action unit[C]// Proc of the 28th ACM International Conference on Multimedia. New York: ACM Press,2020: 744-752.

[9]Guo Xin,Zhao Yifan,Li Jia. DanceIt: music-inspired dancing video synthesis[J]. IEEE Trans on Image Processing,2021,30: 5559-5572.

[10]Duan Yinglin,Shi Tianyang,Zou Zhengxia,et al. Semi-supervised learning for in-game expert-level music-to-dance translation[EB/OL]. (2020-09-27). https://arxiv.org/abs/2009.12763.

[11]Lee H Y,Yang Xiaodong,Liu Mingyu,et al. Dancing to music[C] // Proc of Annual Conference on Neural Information Processing Systems. 2019: 3581-3591.

[12]Li Buyu,Zhao Yongchi,Sheng Lu. DanceNet3D: music based dance generation with parametric motion Transformer[EB/OL]. (2021-05-18). https://arxiv.org/abs/2103.10206.

[13]Liu Junwei,Lin Hungyi,Huang Yufen,et al. Body movement generation for expressive violin performance applying neural networks[C]// Proc of IEEE International Conference on Acoustics,Speech and Signal Processing. Piscataway,NJ: IEEE Press,2020: 3787-3791.

[14]Kao H K,Su Li. Temporally guided music-to-body-movement generation[C]// Proc of the 28th ACM International Conference on Multimedia. New York: ACM Press,2020: 147-155.

[15]Shlizerman E,Dery L,Schoen H,et al. Audio to body dynamics[C]// Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ: IEEE Press,2018: 7574-7583.

[16]Tang Taoran,Jia Jia,Mao Hanyang. Dance with melody: an LSTM-autoencoder approach to music-oriented dance synthesis[C]// Proc of the 26th ACM International Conference on Multimedia. New York: ACM Press,2018: 1598-1606.

[17]Sadoughi N,Busso C. Novel realizations of speech-driven head movements with generative adversarial networks[C]// Proc of IEEE International Conference on Acoustics,Speech and Signal Processing. Piscataway,NJ: IEEE Press,2018: 6169-6173.

[18]Yalta N,Ogata T,Nakadai K. Sequential deep learning for dancing motion generation,SIG-Challenge-046-08[R]. [S.l.]: Japanese Society for Artificial Intelligence,2016.

[19]Sun Guofei,Wong Yongkang,Cheng Zhiyong,et al. DeepDance: music-to-dance motion choreography with adversarial learning[J]. IEEE Trans on Multimedia,2020,23: 497-509.

[20]Ren Xuanchi,Li Haoran,Huang Zijian,et al. Self-supervised dance video synthesis conditioned on music[C]// Proc of the 28th ACM International Conference on Multimedia.New York:ACM Press,2020:46-54.

[21]Ginosar S,Bar A,Kohavi G,et al. Learning individual styles of conversational gesture[C]// Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ: IEEE Press,2019: 3497-3506.

[22]Chen Lele,Li Zhiheng,Maddox R K,et al. Lip movements generation at a glance[C]// Proc of European Conference on Computer Vision. Berlin: Springer-Verlag,2018: 520-535.

[23]Zhou Hang,Liu Yu,Liu Ziwei,et al. Talking face generation by adversarially disentangled audio-visual representation[C]// Proc of AAAI Conference on Artificial Intelligence. Palo Alto,CA: AAAI Press,2019: 9299-9306.

[24]Eskimez S E,Maddox R K,Xu Chenliang,et al. End-to-end generation of talking faces from noisy speech[C]// Proc of IEEE International Conference on Acoustics,Speech and Signal Processing. Pisca-taway,NJ: IEEE Press,2020: 1948-1952.

[25]Song Yang,Zhu Jingwen,Li Dawei,et al. Talking face generation by conditional recurrent adversarial network[EB/OL]. (2019-07-25). https://arxiv.org/abs/1804.04786.

[26]Huang Yufen,Chen Tsungping,Moran N,et al. Identifying expressive semantics in orchestral conducting kinematics[C]// Proc of the 20th International Society for Music Information Retrieval Conference. 2019: 115-122.

[27]Krebs F,Bck S,Widmer G. An efficient state-space model for joint tempo and meter tracking[C]// Proc of the 16th International Society for Music Information Retrieval Conference. 2015: 72-78.

[28]He Kaiming,Zhang Xiangyu,Ren Shaoqing,et al. Deep residual learning for image recognition[C]// Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ: IEEE Press,2016: 770-778.

[29]Bai Shaojie,Kolter J Z,Koltun V. Convolutional sequence modeling revisited[C]// Proc of the 6th International Conference on Learning Representations. [S.l.]: OpenReview.net,2018.

[30]Liu Fan,Chen Delong,Zhou Ruizhi,et al. Self-supervised music motion synchronization learning for music-driven conducting motion generation[J]. Journal of Computer Science and Technology,2022,37(3): 539-558.

[31]Pavllo D,Feichtenhofer C,Grangier D,et al. 3D human pose estimation in video with temporal convolutions and semi-supervised training[C]// Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ: IEEE Press,2019: 7753-7762.

[32]Liu Wen,Piao Zhixin,Min Jie,et al. Liquid warping GAN: a unified framework for human motion imitation,appearance transfer and novel view synthesis[C]// Proc of IEEE International Conference on Computer Vision. Piscataway,NJ: IEEE Press,2019: 5904-5913.