基于改进 ResNet 网络和迁移学习的服装图像风格识别研究

夏明桂 田入君 姜会钰 董敏

摘 要:傳统的服装图像风格识别方法主要依赖于成功提取有效特征,这些方法在处理图像时不仅会消耗大 量的时间和精力,识别精度也较低。为了提高服装图像风格识别的性能,提出了一种基于改进的ResNet152 网络和迁移学习的服装图像风格识别方法。首先将ResNet152网络首层结构中的7×7卷积核替换成3个3 ×3卷积核组合层,其次把原始残差单元中的“卷积层(Conv)+批归一化层(BN)+非线性激活函数层(Relu)”的组合方式换成“批归一化层(BN)+非线性激活函数层(Relu)+卷积层(Conv)”的组合方式。这两个改进方 法有效地提升了网络性能,使其能够更好地捕捉不同尺度的服装风格特征。然后把在ImageNet数据集上训 练好的ResNet152网络模型参数迁移到改进的网络中,在此基础上,将女童服装数据集输入到网络中进行训 练验证以及微调网络参数。结果表明,所提出的方法风格识别准确率达到了94.2%,训练效果好,识别精度、收敛速度等均优于其他风格识别网络,可以更好的完成女童服装风格识别任务。

关键词:ResNet网络;迁移学习;服装图像;服装风格识别;识别准确率

中图分类号:TS195.644 文献标志码:A 文章编号:2097-2911-(2024)01-0012-09

Research on Clothing image Style Recognition Based on Improved ResNet Network and Transfer Learning

XIA Minggui a, TIAN Rujun a, JIANG Huiyu a, DONG Min b*

(a.College of Chemistry and Chemical Engineering; b.College of Mathematical Sciences, Wuhan Textile University,Wuhan 430200,China)

Abstract:Traditional clothing image style recognition methods mainly rely on the successful extraction of ef- fective features, and these methods not only consume a lot of time and energy when processing images, but also have low recognition accuracy. In order to improve the performance of clothing imagestyle recognition, this pa- per proposes a clothing image style recognition method based on the improved ResNet152 network and transfer learning. Firstly, the 7×7 convolutional kernel in the first layer structure of ResNet152 network is replaced by three 3×3 convolutional kernel combination layers, and secondly, the combination of "convolutional layer (Conv)+ batch normalization layer (BN)+ nonlinear activation function layer (Relu)" in the original residual unit is replaced by "batch normalization layer (BN)+ nonlinear activation function layer (Relu)+ convolutional layer (Conv)". These two improved methods effectively enhance the network performance and enable it to better capture clothing style features at different scales. The parameters of the ResNet152 network model trained on the ImageNet dataset are then migrated to the improved network, based on which the girl's clothing dataset is in- put to the network for training and validation as well as fine-tuning the network parameters. The results show that the proposed method in this paper has good training effect, and the recognition accuracy and convergence speed are better than other type recognition networks, which can better accomplish the task of girls' clothing style recognition.

Keywords:resNet network;transfer learning;clothing images;clothing style recognition;recognition accuracy

随着互联网技术的不断发展和服装类电子商务的日趋成熟,通过网络在各大电商平台购买服装的用户越来越多,人们对服装图像识别技术的进步寄予了更高的期望。然而,服装图像风格识别技术面临着多种挑战,其中包括服装图像的细粒度识别分类复杂性[1]、服装个性化的风格评判标准以及迅速演化的时尚风格特征[2]等,这些因素共同使得服装图像风格识别问题愈发复杂化。因此,如何高效地实现服装图像风格识别成为当前服装数字化研究的热点。

传统的服装图像风格识别方法主要依赖于有效特征的提取,如 CHAO等[3]将服装图像的风格使用方向梯度直方图和局部二值模式等特征来描述,然后通过测量这些特征之间的相似性来实现服装风格的推荐。庄立锋等[4]提出采用改进后的Canny算法来进行服装款式结构特征的识别和分类,能够很好地识别服装结构款式。高妍等[5]使用改进框架HSR-FCN将R-FCN中的区域建议网络和HyperNet网络相融合,改变图片特征学习方式,在模型中引入空间转换网络,对输入图像和特征图进行空间变换及对齐,加强了对多角度服装和形变服装的特征学习,能够有效地解决形变服装图像的识别问题。然而,这些传统服装图像风格识别方法在准确性和处理效率方面都存在不足,而且对于小样本数据集来说并不适用。

近年来,许多学者开始利用深度神经网络进行图像识别[6]。深度神经网络能够自动学习和提取图像中的特征,并且无需手动设计特征描述子,这使其成为许多图像识别任务的首选方法。KO- ZIARSKI等[7]提出了用深度神经网络来解释各种类型噪声的存在对图像识别任务的影响,在网络中引入噪声的类型以及严重程度这两种方法都比不考虑噪声的情况下图像识别性能好。SHU- BATHRA等[8]提出了用MLP、CNN、ELM这三种方法通过提取多种特征来识别服装图像,相对于其他两种方法,ELM方法识别的性能最优,服装图像识别时间短且准确率高。在此基础上,结合深度神经网络和迁移学习在图像识别领域的应用也取得了较好的效果。王军敏等[9]提出一种基于深度卷积神经网络和迁移学习的纹理图像识别方法,使用全局平均池化层替代深度卷积神经网络模型顶部的部分全连接层,用逐级微调的方法来处理迁移学习模型,确定最佳的冻结层以及可调整层的组合,以达到最佳的纹理服装图像识别精度。ELLEUCH等[10]使用Inception-v3网络在大型数据集进行预训练,把得到的预训练模型参数迁移到所设计的网络中,用创建的13种风格类别的80000张图像数据集在所设计的网络上进行训练验证,其训练速度加快且图像识别准确率进一步提高,证明了此方法对服装图像识别的有效性。

现有的研究主要集中在从服装图像中提取基础特征,这些特征用于对服装进行粗略的识别分类,但识别服装风格的细微差异需要更加具体和详细的特征,提取的基礎特征达不到风格识别的要求。LIN等[11]提出了双线性CNN模型,此模型使用两个并行的网络通路来提取图像特征,然后采用双线性池化方法来计算这两个并行特征之间的相关性,这个过程用于筛选细粒度子类的特征,使其充分挖掘细粒度特征。但双线性 CNN模型采用了两个并行的网络路径来提取特征,导致了参数量和计算量的成倍增加,训练时间和计算资源的消耗相应增加。

基于上述存在的问题,本文提出了一种基于改进的ResNet152网络和迁移学习的服装图像风格识别方法。对在ImageNet数据集上进行预训练的 ResNet 152网络,采用共享模型参数的迁移学习方法,把预训练模型参数迁移到所改进的ResNet152网络中,在此基础上,将收集的女童服装数据集输入到网络中进行训练和验证,得到新的网络模型,达到提升女童服装图像风格识别准确率的目的。

1 改进 ResNet152网络的服装风格识别模型

1.1 ResNet152网络

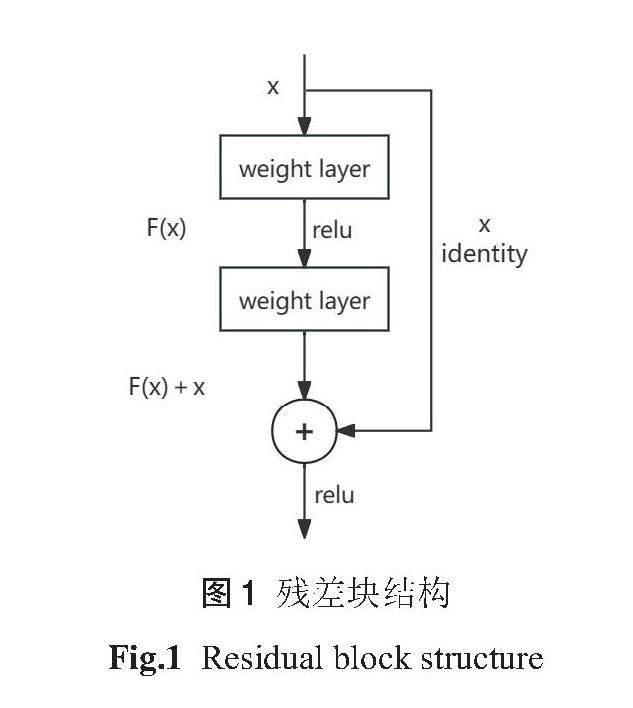

服装图像风格识别不仅需要考虑服装本身的颜色、纹理等基础特征信息,还需要考虑服装款式等细粒度特征信息。丰富的服装风格特征信息可以显著的提高识别准确率。为了获得丰富的特征信息,可以通过加深网络来解决。相比于 AlexNet、VGG、GoogleNet 等网络,ResNet 网络由于引入了残差块,允许网络学习残差,使其可以更有效地学习到特征信息,同时残差块结构通过跳跃连接将输入直接添加到层输出上,梯度可以轻松地传播回较浅层,减轻了梯度消失问题,也有助于防止网络的退化。因此ResNet可以更轻松地训练非常深的神经网络,而不会出现梯度消失、退化等问题。残差块结构如图1所示。

由于网络层数的不同,ResNet 网络包括 ResNet18、 ResNet34、 ResNet50、 ResNet101、ResNet152等,ResNet18和 ResNet34采用了 Ba-sicBlock 结构,ResNet50、ResNet101 以及 ResNet152采用了Bottleneck结构。为了处理复杂的服装图像风格识别任务,提取到更深层次的风格特征,本文选用ResNet152网络搭建模型,其结构如图2所示,总层数是152层,包括1个7×7的卷积层、阶段1至阶段4的Bottleneck结构、具有平均池化和softmax函数的全连接层。其中阶段1至阶段4中的阶段1有3个残差块,阶段2有8个残差块,阶段3有36个残差块,阶段4有3个残差块,每个残差块包含3个卷积层。

1.2 改进的ResNet152网络

1.2.1 改进网络首层结构

提高服装图像风格识别准确率,需要网络提取出更加细粒度的风格特征。为了实现这一目标,本文提出了一种将网络首层结构进行改进的方法。即在输入服装图像上提取风格特征的7×7卷积核用3个3×3的卷积核组合层来替代,保持卷积操作中的步幅(stride)和填充(padding)设置相同。网络首层结构改进前后如图3所示。

使用3个3×3的卷积核组合层来替代1个7×7卷积核可以保持网络中感受野和输出特征图大小不变。感受野是神经网络中某一层输出的特征图上的一个单元对输入的影响区域。其计算公式如(1)所示:

F(i)=(F(i +1)-1)× Stride + Ksize (1)

式中,F(i +1)表示第 i +1层的感受野,F(i)表示第 i 层的感受野,Stride 表示步长,Ksize 表示卷积核的大小。实验中设置 F(i +1)初始值为2,Stride 初始值为1。网络的第1层经过7×7卷积核,根据公式(1)可知: F(1)=(2-1)×1+7=8;

网络的第1层经过3个3×3的卷积核组合层,根据公式(1)可知:

F(1)=(2-1)×1+3=4

F(2)=(4-1)×1+3=6

F(3)=(6-1)×1+3=8

因此可知,使用3个3×3的卷积核组合层来替代1个7×7卷积核可以保持感受野大小不变,并且3个3×3卷积核的层次结构可以增加网络的深度,捕捉到多种尺度的风格特征,引入更多的非线性,减少过拟合,提升了网络的性能。

1.2.2 改进残差单元

ResNet残差网络由多个残差学习单元叠加而成。当输入的服装图像数据进入ResNet残差网络时,需要经过一系列处理。首先卷积层(Conv)对输入服装图像进行特征提取,接着通过非线性激活函数层(Relu)增强网络的非线性拟合能力,并经过批归一化层(BN)对数据进行归一化处理。然后,处理的结果被送入多个残差单元,这些单元通过批归一化层(BN)和多个全连接层进一步处理数据,最后得到输出的服装图像。

在深层网络中,原始残差单元可能会遇到梯度消失或梯度爆炸的问题。为了解决潜在的问题,本文提出了将残差单元的组合方式进行变化的方法。即“卷积层(Conv)+批归一化层(BN)+非线性激活函数层(Relu)”的组合方式换成“批归一化层(BN)+非线性激活函数层(Relu)+卷积层(Conv)”的组合方式。组合方式的变化引入了预激活(pre-activation)结构,它通过将BN层放在非线性支路的开始,有助于规范化激活值,使它们在合理范围内减少了梯度消失问题,使网络更容易训练。残差单元改进前后如图4所示。

1.2.3 不同网络改进方法的服装风格识别效果对比

为了证明ResNet152不同网络改进方法对服装风格识别效果的影响,把在ImageNet数据集上训练好的ResNet152网络模型参数迁移至改进的网络中,将本文收集的女童服装数据集分别输入到不同的改进网络中进行训练,得到不同网络改进方法的风格识别准确率如表1所示。

从表1可知,将改进网络首层结构方法和改进残差单元方法相结合,这时网络对女童服装数据集的风格识别准确率达到最高,为94.2%。因此,本文采用两种改进方法相结合的网络进行服装风格识别。

2 实验

2.1 实验前处理

2.1.1 迁移学习

迁移学习是指将模型在某些任务或领域中学习到的知识通过源域学习的迁移运用到目标任务或目标领域中[12-16],它可以有效地解决由于数据集稀缺而导致模型出现过拟合的问题。迁移学习方法可以分为多种类型,包括基于共享模型参数的迁移、基于特征的迁移、基于样本数据的迁移等。这些迁移学习方法允许在不同任务之间有效地利用已有的知识和技能,提高网络的性能和泛化能力。其中,基于共享模型参数的迁移学习方法的工作原理是结合迁移学习和深度学习,在 ImageNet 数据集上进行预训练的 ResNet 网络,采用共享模型参数的迁移学习方法,把预训练模型参数迁移到所改进的网络中,进一步优化网络参数。在此基础上,使用女童服装数据集在网络中进行训练,完成女童服装图像风格识别的任务。因此,本文选用基于共享模型参数的迁移学习方法。

2.1.2 数据集

本文所使用的女童服装图像数据集来自各大电商平台,由于女童服装风格的多样性,通过专家建议和查询相关资料,本文选用4个最具代表性的女童服装风格类型,分别为可爱风格、运动风格、学院风格、民族风格,每种风格包含300张图片,共1200张女童服装图片。其中80%图片作为训练集,用于训练网络模型和调整模型参数;20%图片作为验证集,用于验证网络模型的训练效果以及微调模型参数。在数据集标注的过程中,只需要将女童服装图像放到相应风格分类的文件夹里,不需要进行额外标注。数据集部分图像如图5所示,数据集中呈现了女童服装风格的多样化。同时,由于数据集中服装的拍摄角度、光照、褶皱、背景等因素的干扰,在一定程度上增加了女童服裝图像风格识别的难度。

2.1.3 数据预处理与增强

数据集中服装拍摄角度、光照等方面的变化会引入噪声和差异,从而增加了网络对女童服装图像风格识别任务的复杂度。为了应对这一挑战,可以采用数据预处理与增强技术来规范数据集,以降低这一因素的影响。

数据预处理[17-18]是指对原始数据进行一系列的操作和转换,以确保数据适用于模型的训练、验证。本文所使用的数据预处理方法是标准化(Normalize)和 ToTensor 。其中标准化是将数据调整为均值为0,标准差为1的分布,从而使数据在训练过程中更具稳定性。ToTensor 是将服装图像JPG格式转换为张量(tensor)格式的操作,以供后续的网络模型训练使用。

数据增强[19-20]是指在深度学习中使用一系列技术手段来增加数据集的大小和多样性,以改善模型的泛化能力。本文所使用的数据增强方法是随机缩放裁剪(RandomResizedCrop)和随机水平翻转(RandomHorizontalFlip)。其中随机缩放裁剪是在原始图像中随机选择区域,将该区域裁剪成指定的大小,将裁剪后的图像缩放到模型的输入尺寸。随机水平翻转是将图像以一定的概率水平翻转,从而生成新的训练样本。这两种操作增加了数据的多样性,提高了模型的泛化能力。

2.2 实验和方法

2.2.1 实验环境

本文采用的实验环境为Windows 11操作系统,AMD R76800H 处理器,16GB 内存,512GB 固态硬盘,采用Pytorch深度学习框架进行训练,训练后得到的识别准确率和损失函数,通过采用 Python的Matplotlib库可视化得到。

2.2.2 实验设置

本文设置一个对比实验,使用女童服装训练集分别对未使用迁移学习的ResNet152网络、未使用迁移学习的改进ResNet152网络、使用迁移学习的 ResNet152网络、使用迁移学习的改进ResNet152网络进行训练。训练完成后,为了验证迁移学习方法和改进网络对女童服装图像风格识别的影响,每迭代5次记录一次使用迁移学习和未使用迁移学习的 ResNet152和改进ResNet152识别准确率(val)和损失函数(loss)。设置网络模型学习率(lr)为0.0001、批大小(batch_size)为16,迭代总次数(epoch)为80次,预训练模型版本为resnet152-394f9c45.pth。

2.2.3 基于改进网络和迁移学习的服装图像风格识别

本文提出了一种基于改进ResNet152网络和迁移学习的服装图像风格识别方法,把ImageNet 图像数据集上输入至初始ResNet152网络模型进行训练,得到预训练模型。在此基础上,采用共享模型参数的迁移方法,把预训练模型参数迁移到本文所改进的ResNet152网络模型中,进一步优化网络参数。在女童服装图像数据集输入网络之前,由于数据集中服装拍摄角度、光照等因素的干扰,本文采用了数据预处理与增强技术来规范数据集,最后把数据集输入网络进行训练以及验证,完成女童服装图像风格识别的任务。上述过程如图6所示。

3 结果与分析

女童服装图像训练集分别输入至未使用迁移学习的ResNet152网络、未使用迁移学习的改进 ResNet152网络、使用迁移学习的 ResNet152网络以及本文所提出的使用迁移学习的改进 ResNet152网络中进行训练,得到相应的损失函数(loss)。训练完成后,将其验证集分别输入至上述四种网络中进行风格识别,得到相应的风格识别准确率(val)。

图7(a)、(b)、(c)、(d)分别展示了四种网络在同一女童服装数据集上得到的风格识别准确率(val)和损失函数(loss)。

图7(a)展示了未使用迁移学习的ResNet152网络在女童服装数据集上训练得到的损失函数和识别准确率,从曲线图看出此网络在小样本数据集上训练时,服装风格识别准确率低和损失函数高,网络模型共迭代80次,其中迭代至第68次时准确率最高,只达到65.0%,相应的损失函数为0.927。在此基础上可知初始ResNet152网络训练效果差,损失函数和识别准确率波动较大,模型可能发生了过拟合。

图7(b)展示了未使用迁移学习的改进 ResNet152网络在女童服装数据集上训练得到的损失函数和识别准确率,从曲线图看出此网络在小样本数据集上训练时,迭代至第40次时准确率最高,达到了85.9%,相应的损失函数为0.258。对比未使用迁移学习的 ResNet152网络,识别准确率提升了20.9%。通过改进网络首层的卷积核大小和调整残差单元中“卷积层(Conv)+批归一化层(BN)+非线性激活函数层(Relu)”排列顺序来改进网络,使得其风格识别准确率大幅度提高,网络性能得到了提升。

图7(c)展示了使用迁移学习的ResNet152网络在女童服装数据集上训练得到的损失函数和识别准确率,从曲线图看出此网络在小样本数据集上训练时,迭代至第68次时准确率最高,达到了92.9%,相应的损失函数为0.134。对比未使用迁移学习的ResNet152网络,识别准确率提升了27.9%。将在 ImageNet图像数据集训练好的模型,通过迁移其模型参数至ResNet152网络中,使得网络减少了计算资源的消耗,还大幅提高了风格识别准确率。

图7(d)展示了使用迁移学习的改进 ResNet152网络在女童服装数据集上训练得到的损失函数和识别准确率,从曲线图看出此网络在小样本数据集上训练时,迭代至第66次时准确率最高,達到了94.2%,相应的损失函数为0.093。与未使用迁移学习的 ResNet152网络、未使用迁移学习的改进 ResNet152网络以及使用迁移学习的 ResNet152网络识别准确率相比,使用迁移学习的改进 ResNet152网络在女童服装数据集中风格识别效果最好,识别准确率分别提高了29.2%,8.3%,1.3%。这表明本文所提出的方法在女童服装风格识别任务中的高效性。

4 结论

本文提出了一种基于改进的ResNet152网络和迁移学习的服装图像风格识别方法。对网络结构进行了改进,首先用3个3×3的卷积核组合层来代替首层结构的7×7卷积核,在此基础上,把网络残差单元中的卷积层、批归一化层、非线性激活函数层的排列顺序进行改变。这两种改进方法能捕捉到多种尺度的风格特征。然后用共享参数的迁移方法把在ImageNet图像数据集上训练的 ResNet152网络模型参数迁移至改进的网络中。女童服装数据集在进行网络训练前,采用数据预处理与增强技术来规范数据集,之后把数据集输入至网络进行训练验证以及微调网络。实验结果表明,与未使用迁移学习及未改进ResNet152网络方法相比,本文基于改进的ResNet152网络和迁移学习的服装图像风格识别方法收敛速度快,泛化能力和鲁棒性强,识别准确率高。因此,本文提出的女童服装图像风格识别方法对当前服装数字化研究具有一定的参考意义。

虽然本文提出的方法在收集的女童服装数据集取得良好的风格识别效果,但是仍存在着一些不足之处,例如:选择的女童服装风格类型较少、女童服装数据集样本较少等。在今后的工作中,增加女童服装风格类型以及相应的样本数量,把女童服装数据集输入至网络进行训练以及验证,完成女童服装图像风格识别的任务。

参考文献:

[1]赵浩如,张永,劉国柱.基于RPN与B-CNN的细粒度图像分类算法研究[J].计算机应用与软件, 2019, 36(3):210-213.

ZHAO Haoru, ZHANG Yong, LIU Guozhu. Re- search on fine-grained image classification algo- rithm based on RPN and B-CNN[J]. Computer Applications and Software, 2019, 36(3):210-213.

[2]钟晓东.基于认知特征的服装风格自主分类的研究与实现[D].上海:东华大学, 2012.

ZHONG Xiaodong. Research and implementa- tion of autonomous classification of clothing styles based on cognitive features[D].Shanghai: Donghua University,2012.

[3]CHAO X, HUISKES M J, GRITTI T, et al. A framework for robust feature selection for real- time fashion style recommendation[C]//Proceed- ings of the 1st International Workshop on Inter- active Multimedia for Consumer Electronics.2009:35-42.

[4]庄立锋, 林俊文.基于改进 Canny 算法的服装款式结构特征识别与分类[J].实验室研究与探索, 2020,39(5):264-268.

ZHUANG Lifeng, LIN Junwen. Recognition and classification of structural features of cloth- ing styles based on improved Canny algorithm [J]. Laboratory Research and Exploration, 2020,39(5):264-268.

[5]高妍,王宝珠,郭志涛,等.改进HSR-FCN的服装图像识别分类算法研究[J].计算机工程与应用,2019,55(16):144-149.

GAO Yan, WANG Baozhu, GUO Zhitao, et al. Research on the classification algorithm for ap- parel image recognition with improved HSR- FCN[J]. Computer Engineering and Applica- tions, 2019,55(16):144-149.

[6]HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Visionand Pattern Recognition.2016:770-778.

[7]KOZIARSK M, CYGANEK B. Image recogni- tion with deep neural networks in presence of noise-dealing with and taking advantage of dis- tortions[J]. Integrated Computer- Aided Engi- neering, 2017, 24(4):337-349.

[8]SHUBATHRA S, KALAIVAANI P C D, SAN- THOSHKUMAR S. Clothing image recogni- tion based on multiple features using deep neu- ral networks[C]//2020 International Conference on Electronics and Sustainable CommunicationSystems (ICESC). IEEE, 2020:166-172.

[9]王军敏,樊养余,李祖贺.基于深度卷积神经网络和迁移学习的纹理图像识别[J].计算机辅助设计与图形学学报,2022,34(5):701-710.

WANG Junmin, FAN Yangyu, LI Zuhe. Texture image recognition based on deep convolutional neural networks and migration learning[J]. Jour- nal of Computer- Aided Design and Graphics, 2022,34(5):701-710.

[10]ELLEUCH M, MEZGHANI A, KHEMAK- HEM M, et al. Clothing classification using deep CNN architecture based on transfer learn- ing[C]//Hybrid Intelligent Systems:19th Inter- national Conference on Hybrid Intelligent Sys- tems (HIS 2019) held in Bhopal, India, Decem- ber 10-12, 2019 19. Springer InternationalPublishing, 2021:240-248.

[11]LIN T Y, ROYCHOWDHURY A, MAJI S. Bi- linear CNN models for fine-grained visual rec-ognition[C]//Proceedings of the IEEE Interna- tional Conference on Computer vision, 2015:1449-1457.

[12]HAND, LIU Q, FAN W. A new imageclassifi- cation method using CNN transfer learning and web data augmentation[J]. Expert Systemswith Applications, 2018, 95:43-56.

[13]WEISS K, KHOSHGOFTAAR T M, WANGD D. A survey of transfer learning[J]. Journal of Big data, 2016, 3(1):1-40.

[14]PAN S J, YANG Q. A survey on transfer learn- ing[J]. IEEE Transactions on Knowledge and Data Engineering, 2009, 22(10):1345-1359.

[15]BENGIO Y. Deep learning of representations for unsupervised and transfer learning[C]//Pro- ceedings of ICML Workshop on Unsupervised and Transfer learning. JMLR Workshop andConference Proceedings, 2012:17-36.

[16]TAN C, SUN F, KONG T, et al. A survey on deep transfer learning[C]//Artificial Neural Networks and Machine Learning – ICANN 2018:27th International Conference on Artifi-cial Neural Networks, Rhodes: Springer Inter-national Publishing, 2018:270-279.

[17]BHATTACHARYYA S. A brief survey of col-or image preprocessing and segmentation tech- niques[J]. Journal of Pattern Recognition Re- search, 2011, 1(1):120-129.

[18]MISHRA P, BIANCOLILLO A, ROGER J M, et al. New data preprocessing trends based on ensemble of multiple preprocessing techniques [J]. Trends in Analytical Chemistry, 2020, 132:116045.

[19]SHORTEN C, KHOSHGOFTAAR T M. A sur- vey on image data augmentation for deep learning[J]. Journal of Big Data, 2019, 6(1):1-48.

[20]SCHLETT T, RATHGEB C, BUSCH C. Deep learning- based single image face depth data enhancement[J]. Computer Vision and Image Understanding, 2021, 210(3):103247.

(責任编辑:周莉)