基于神经网络的图像风格迁移研究进展

廉 露,田启川,谭 润,张晓行

北京建筑大学电气与信息工程学院,北京 100044

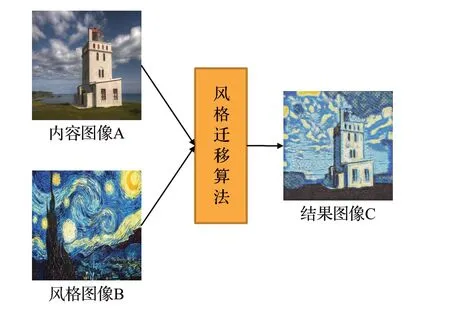

图像风格迁移是计算机视觉领域的一个研究热点,旨在将一幅图像中的风格、纹理等特征移植到另外一幅图像中,从而生成一幅新图像的过程,如图1 所示,即:将内容图像A 的内容特征与风格图像B 的风格特征进行结合,生成新的图像C[1]。由于图像的复杂性和多样性,要达到理想的图像风格迁移效果极具挑战性。许多学者尝试应用数学、物理和计算机等领域知识,不断拓展和改进图像风格迁移的理论方法,提出新的算法和模型,以提高图像风格迁移的效果。

图1 图像风格迁移示意图Fig.1 Schematic diagram of image style transfer

深度学习[2-4]的出现,因其强大的表征能力和学习能力,为图像风格迁移带来了新的实现途径,并推动图像风格迁移在计算机视觉领域取得了巨大的进展。

本文旨在梳理图像风格迁移方法的发展历程,探讨不同方法的原理和优缺点,分析目前面临的挑战和未来可能的研究方向。通过全面审视图像风格迁移领域的相关工作,进一步推动该领域的发展,为实现更准确、高效的图像风格迁移提供参考。

1 图像风格迁移的方法

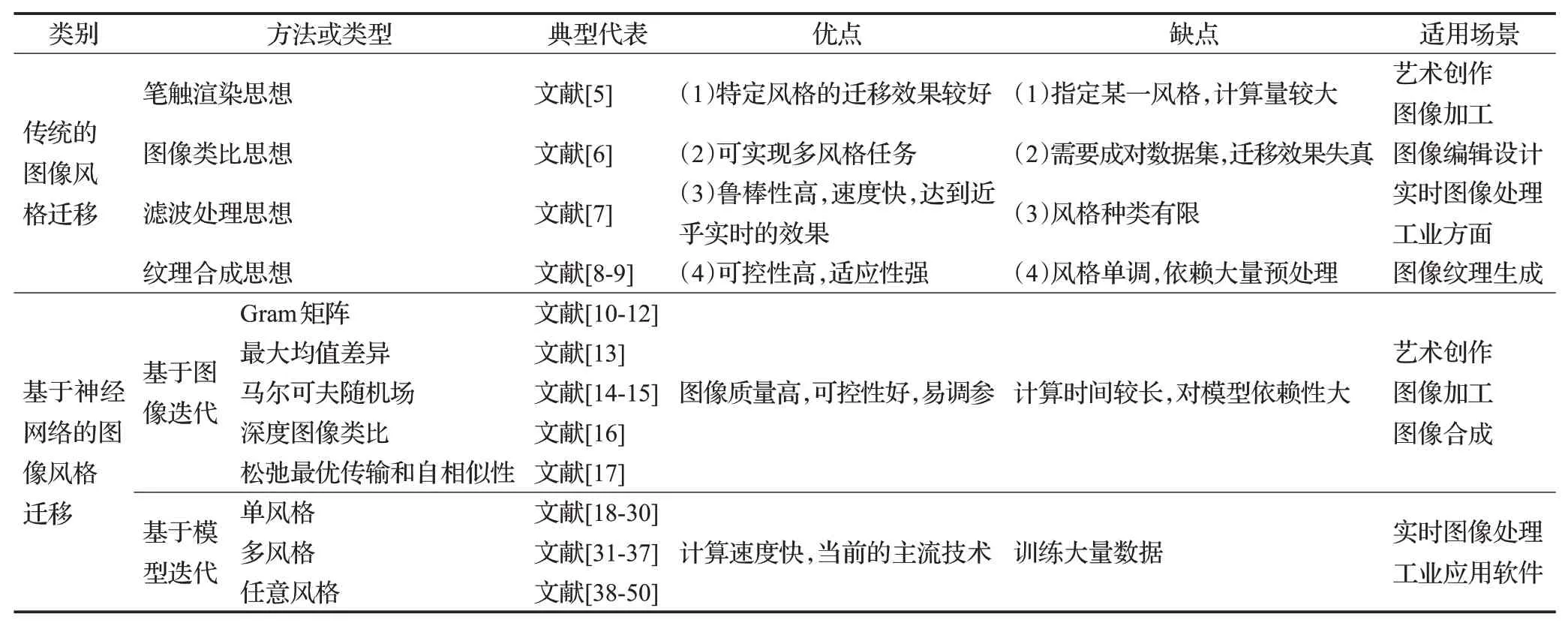

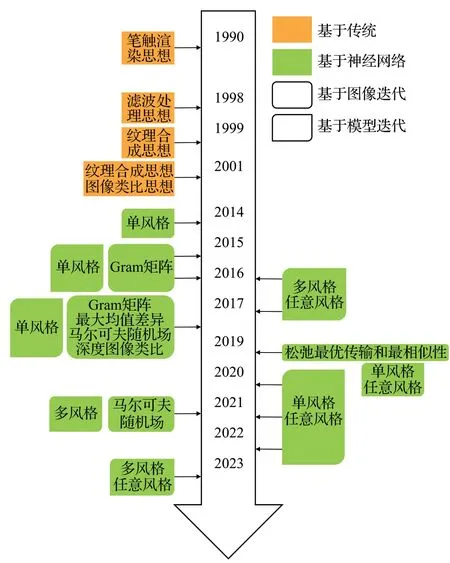

目前国内外广泛应用的图像风格迁移方法有多种,根据风格迁移的实现方法和理论基础的不同可划分为:传统的图像风格迁移与基于神经网络的图像风格迁移。其中传统方法侧重于人工设计特征提取和数学优化,而基于神经网络的方法则侧重于端到端的学习,以数据训练为主。整理了图像风格迁移的具体方法类型、优缺点和适用场景如表1 所示,其发展历程如图2 所示。从传统的图像风格迁移与基于神经网络的图像风格迁移两个方面来综述。

表1 图像风格迁移方法汇总Table 1 Summary of image style transfer methods

图2 图像风格迁移发展脉络图Fig.2 Evolution diagram of image style transfer

1.1 传统的图像风格迁移方法

传统的图像风格迁移主要从计算机图形学领域和计算机视觉领域进行探讨。基于计算机图形学领域的图像风格迁移,即非真实感绘制[51-54](non-photorealistic rendering,NPR),分为三类:基于笔触渲染思想的方法(stroke-based rendering,SBR)、基于图像类比思想的方法(image analogy)、基于滤波处理思想的方法(image filtering)。而基于计算机视觉领域,主要为基于纹理合成思想的图像风格迁移。传统的图像风格迁移方法虽然比较简单易懂,但在可控性、效果、速度等方面仍有些限制。

1.1.1 基于笔触渲染思想的图像风格迁移

1990年,Haeberli[5]首次提出了基于笔触渲染思想的方法,在需要进行风格迁移的内容图像上,通过控制单个笔刷的位置、颜色、形状、大小和方向,逐步增加笔触至收敛,得到以特定风格转化的图像,以探索单个图像的许多不同表示形式。基于笔触渲染的图像风格迁移方法对于某些特定的风格,能够得到较好的迁移效果,但前提是要先确定某一种风格特征,不能随时拓展转换为其他风格,并且计算量相比较而言较大。

1.1.2 基于图像类比思想的图像风格迁移

基于图像类比思想的图像风格迁移最早由Hertzmann等人[6]在2001 年提出,此方法基于多尺度自回归,通过对输入的内容图像与风格图像及对应的滤波后的图像进行特征提取,将其进行对应匹配,得到图像之间的映射关系,从而实现风格迁移。该方法虽然可以实现多风格的图像风格迁移,但是需要成对的数据集,在现实世界成对的数据集是很难得到的,并且对于特征信息的提取难以详细地捕捉,得到的迁移结果可能会出现语义模糊、细节丢失和非自然效果等问题,其效果并不理想。

1.1.3 基于滤波处理思想的图像风格迁移

基于滤波处理思想的图像风格迁移,通过滤波器对图像进行处理和渲染以达到简化及抽象的目的,呈现图像的另一种效果[7]。此方法实施简单,通过调整滤波器的参数,就可以控制渲染的程度,以此获得不同的风格效果。基于滤波处理思想的方法实现速度快,能够得到近乎实时的效果,对于需快速处理大量图像的应用场景非常有益。另外,该方法能够提供稳定的图像渲染的效果,使得迁移后的图像在视觉上更加平滑和连贯。但是由于采用特定的滤波器,图像风格的类型选择受到限制,不能适用于不同类型的图像风格,需根据具体需求对滤波器进行调整。这可能需要一定的时间和尝试,以获得最佳的图像风格迁移效果。

1.1.4 基于纹理合成思想的图像风格迁移

基于纹理合成思想的图像风格迁移,也称为纹理迁移(texture transfer)。在传统的风格迁移中,纹理合成通常被认为是最复杂和最有效的技术之一,因为它对图像的局部信息进行了一定程度的控制。1999 年,Efros等人[8]提出了基于非参数采样的纹理迁移算法,使用马尔可夫随机场(Markov random field,MRF)非参数模型,通过样本图像找到所有相似的邻域来估计已合成的所有邻域像素的条件分布。2001年,Efros等人[9]提出了image quilting,该算法主要解决了如何在图像中保持纹理的连续性和一致性。基于纹理合成的图像风格迁移具有可控性、适应性,但是生成的图像缺乏真实感和多样性,纹理效果比较单调,需要依赖大量的预处理工作。

1.2 基于神经网络的图像风格迁移方法

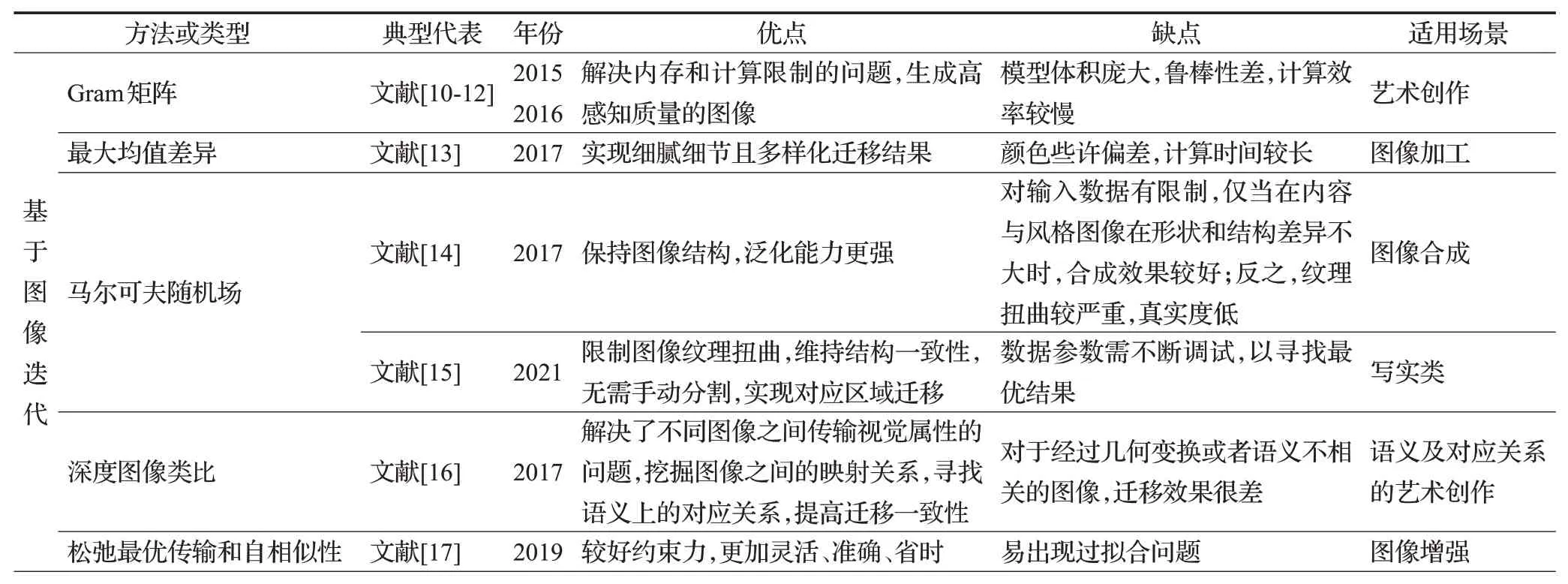

随着深度学习的发展和应用,基于神经网络的图像风格迁移[55-56]逐渐成为风格迁移研究的重要方向,主要分为基于图像迭代的图像风格迁移方法和基于模型迭代的图像风格迁移方法。其具体方法类型、优缺点及适用场景等,如表2所示。

表2 基于神经网络的图像风格迁移方法汇总Table 2 Summary of image style transfer based on neural network methods

1.2.1 基于图像迭代的图像风格迁移

基于图像迭代的图像风格迁移主要是对白噪声图像进行优化。其思想主要是通过对输入图像进行迭代优化来获得目标风格的效果。基本过程是使用白噪声图像作为初始输入图像,迭代中计算输入图像与目标图像在内容和风格上的差异,通过梯度下降的优化算法不断迭代调整输入图像的像素值,使其与目标图像在内容和风格上更加接近,直到达到满意的效果。

基于图像迭代的图像风格迁移方法的典型代表有五种,分别是基于Gram矩阵的图像风格迁移、基于最大均值差异的图像风格迁移、基于马尔可夫随机场的图像风格迁移、基于深度图像类比的图像风格迁移,以及基于松弛最优传输和自相似性的图像风格迁移。

(1)基于Gram矩阵的图像风格迁移

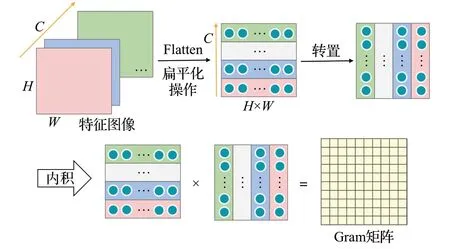

Gram矩阵[57]是线性代数和信号处理中常用的一个概念。如图3所示,将输入图像的特征图像进行扁平化操作和矩阵转置操作,再对两个作内积得到Gram 矩阵。总之,Gram矩阵用来度量向量之间的相似度、特征之间的相关性以及风格之间的差异,是一种用于描述向量关系的有效工具。

图3 Gram矩阵示意图Fig.3 Schematic diagram of Gram matrix

随着卷积神经网络(convolutional neural network,CNN)的迅速崛起,2015 年,Gatys 等人[10-12]首次通过重建VGGNet[58](visual geometry group network)的中间层抽象特征,从而实现基于神经网络的图像风格迁移的开山之作。其核心思想是利用VGG16中不同层次的特征表示能力,将图像的内容信息分离提取,并且Gram矩阵可以将风格信息进行分离提取,在优化过程中,为了可视化不同层的图像信息,通过使用梯度下降等方法,不断调整生成图像的像素值,达到最小化的总损失函数。具体而言,其总损失函数Ltotal()I,Ic,Is表示如下:

其中,I为随机白噪声图像,Ic为内容图像,Is为风格图像,α与β分别表示图像的内容损失函数Lcontent(I,Ic)和风格损失函数Lstyle(I,Is)重建的加权因子。其中,Lcontent(I,Ic)表示为两个特征之间的平方差:

其中,wl是每一层对总风格损失的加权因子,El表示在VGG16的第l层中的风格损失函数,表示如下:

其中,Nl表示l层中滤波器的数量,Ml表示l层中特征图像的大小,图像*在l层特征的Gram 矩阵,表示如下:

其含义是在第l层矢量化特征图像中的第i个和第j个之间的内积。表示图像在VGG16 的第l层上位于第i个过滤器的位置k处的激活值。

(2)基于最大均值差异的图像风格迁移

Gatys 等人[10-12]的结果令人惊叹,但其Gram 矩阵表示风格迁移的原理还不清楚。因此,2017 年,Li 等人[13]通过将其视为领域自适应问题,提出了一种新的神经风格迁移解释,即从理论上证明了匹配特征图像的Gram 矩阵等价于用二阶多项式核最小化的最大均值差异(maximum mean discrepancy,MMD)。这表明风格迁移本质上是图像之间神经激活的分布对齐过程,此外,还尝试了其他分布对齐方法,包括具有不同内核的MMD 和简化的矩匹配方法,实现了多样化且合理的风格迁移结果。

(3)基于马尔可夫随机场的图像风格迁移

在神经网络风格迁移算法之前,基于MRF 的图像合成一直是图像风格迁移的经典方式,神经网络问世后,Li 和Wand[14]最早提出了一种基于MRF 的深度卷积神经网络风格迁移算法,使用MRF 的损失函数代替了Gatys 等人[10-12]提出的Gram 矩阵的损失函数,将图像风格通过特征映射分成若干区域进行匹配,并寻找与其最接近的风格区域。其损失函数Lstyle如下:

其中,I为目标图像,Is为风格图像,Φ( * )为图像*的特征映射的集合,ψ(Φ( * ))为Φ( * )的一个局部区域块,ψNN(i)(Φ( * ))为与风格图像中的第i个局部区域最相似的风格区域,即最佳匹配块。该算法的优势在于内容图像和风格图像的内容相似时可以取得特别好的效果,但在二者差异较大时容易出现分割后的区域不能匹配的情况,使迁移结果不尽人意。

曾宪华等人[15]结合文献[10-12]和文献[14]的特征表达方法,使用Gram矩阵和MRF表达特征计算分别体现图像的全局风格损失和局部风格损失,从而构建总风格损失,再保留图像宏观与微观图像信息以提升了图像风格信息的质量,同时在颜色空间上约束图像变化来限制图像纹理扭曲,使生成图像更加真实。

(4)基于深度图像类比的图像风格迁移

为了更好地在两个输入图像之间建立语义上有意义的密集对应关系,2017 年,Liao 等人[16]提出了一种新的图像视觉属性迁移技术,即深度图像类比,利用图像类比的概念以及深度卷积神经网络构建一个深度特征空间[59],类比不同图像域之间的映射,实现视觉属性上的迁移。

由于直接匹配输入内容图像A与风格图像B′并非易事,此处将映射表述为双向约束的图像类比问题为A:A′::B:B′,其中A′与B是未知的潜在变量,显然这里的类比相当于两个潜在的约束:(a)A与A′(或B与B′)在相同的空间位置对应,即在内容信息特征相似;(b)A与B(或A′与B′)在外观上相似,即在风格信息特征相似。

深度图像类比算法从VGG19网络预先计算输入图像A与B′提取其在L层的特征映射,随机初始化映射关系函数,计算前向最近邻域(nearest neighbor field,NNF)和反向NNF,建立A与B的特征图像之间的对应关系以及A′与B′的特征图像之间的对应关系。当前层获得的NNF进一步上采样到下一层作为其初始化,并重复操作NNF,更新对应关系。在合成图像中保留源图像的内容和目标图像的风格,同时生成真实感高、细节准确和风格可控的风格迁移结果,并且注重局部特征的匹配和传递,提高了风格迁移的一致性。

(5)基于松弛最优传输和自相似性的图像风格迁移

Kolkin 等人[17]为了解决风格迁移算法中内容和风格之间的权衡问题,提出了一种基于松弛最优传输和自相似性风格迁移算法(style transfer by relaxed optimal transport and self-similarity,STROTSS)来定义内容和风格,并引入了用户指定的点对点或区域对区域的控制来提高用户对算法输出的控制能力。具体来说,通过梯度下降算法的变体RMSprop[60]来最小化两个图像之间的风格和内容差异来实现风格迁移。其中,风格相似性是通过计算两个图像的特征向量之间的EMD[61](earth movers distance)来近似计算的,内容保留是通过计算两个图像的余弦距离的差异来保留的,并通过用户指定的控制来约束输出的风格。其风格损失函数Lstyle(I,Is):

其中,I为目标图像,Is为风格图像,α表示内容保存对风格化的相对重要性,ℓm、ℓr和ℓp是Lstyle( )I,Is的风格项。在风格损失中使用EMD 发现其最佳成本太高,因此对于梯度下降的风格迁移使用松弛EMD[62](relaxed EMD,REMD),这里的计算主要由代价矩阵主导,即两个特征向量之间的余弦距离。但余弦距离忽略了特征向量的大小,导致输出图像中存在伪影,因此添加了一个矩匹配损失ℓm。此外,还添加了一个颜色匹配损失ℓp以使输出和风格图像具有相似的调色板。

1.2.2 基于模型迭代的图像风格迁移

基于图像迭代的图像风格迁移方法在一定程度上可以实现质量高、可控性好的目标风格的效果,但计算效率较差。而基于模型迭代的图像风格迁移方法,在很大程度上解决了计算效率低下的问题,即主要是对模型进行优化。

下面从生成单一风格、生成多风格,以及生成任意风格的图像风格迁移的经典方法进行综述。

(1)单一风格的图像风格迁移

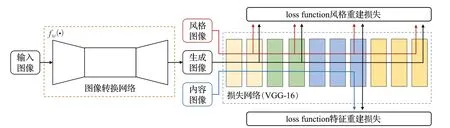

2016 年,Justin 等人[18]首次提出了使用模型迭代进行优化的图像风格迁移方法,被称为快速风格迁移(fast neural style transfer),如图4 所示,其网络架构主要由图像转换网络与损失网络两部分组成,其中图像转换网络以残差网络[63]为基础,使用随机梯度下降(stochastic gradient descent,SGD)训练,在MS-COCO(Microsoft COCO:common objects in context)数据集[64]上训练图像转换网络。

图4 快速风格迁移架构示意图Fig.4 Schematic diagram of fast neural style transfer architecture

其损失函数的加权组合表示为:

其中,λ*表示各损失函数的权重系数,特征重建损失函数Lfeat(I,Ic)表示图像之间的欧几里得距离,风格重建损失函数Lstyle(I,Is)是图像的Gram 矩阵之间差异的平方Frobenius 范数,而全变差正则化作为图像平滑损失函数LTV(I),以保障生成图像的空间光滑性。并且Lfeat(I,Ic)和Lstyle(I,Is)构成感知损失函数,以衡量图像之间的高级感知和语义差异。

Fast neural style transfer相较于Gatys等人[10-12]提出的neural style transfer 的创新之处在于模型中引入了图像转换网络,使用深层特征训练该网络,并结合梯度反向传播来调整网络参数,实现不同的图像转换任务,使生成图像具有风格图像的风格特征与内容图像的内容特征。

与之有着异曲同工之处的是Ulyanov等人[19]提出的“texture networks”算法,不同之处在于Justin 等人[18]主要探讨了如何使用感知损失函数来实现实时的图像风格迁移和超分辨率重建。Ulyanov等人[19]主要关注的是纹理合成和图像风格化,在Gatys等人[10-12]之后首次提出利用训练好的前馈网络实时生成纹理与风格,生成网络使用一个多尺度的金字塔,相比较Justin 等人[18]的模型缺少一定程度的自适应性。Wang等人[20]提出了一种分层的多模态卷积神经网络,该网络考虑了颜色和亮度通道结构的完整性表示,并通过不同尺度的损失分层执行风格化,通过离线进行更复杂的训练来近乎实时地执行风格迁移,并且使用多种模态在多个尺度上正确处理风格和纹理线索,不仅可以转移大规模、明显的风格线索,还可以传递更为细致的风格线索。2017年,Ulyanov等人[21]通过优化KL(Kullback-Leibler)散度,并引入了实例归一化(instance normalization,IN)模块来代替批量归一化[65](batch normalization,BN),显著提高了图像风格化的质量。

随着生成对抗网络[66](generative adversarial networks,GAN)的发展,研究者们开始探索如何将GAN应用于图像风格迁移任务。最早的基于GAN的图像风格迁移方法是通过训练一个条件生成对抗网络[22](conditional generative adversarial networks,CGAN)来实现的,其中判别器网络不仅能够判断图像的真伪,还判断图像是否与目标风格匹配,提取的图像特征具有很好的泛化性。但是这种方法需要大量的配对数据集,限制了其在实际应用中的可行性。而基于深度卷积生成对抗网络[23](deep convolution generative adversarial networks,DCGAN)的方法通过自动学习特征表示,能够更好地捕捉图像的内容和风格信息。该方法对于大规模数据集的训练需要较长的时间和大量的计算资源,在一些特定场景下可能会出现生成图像的内容与目标图像不一致的问题,即内容失真。Li 等人[24]在GAN 的基础上结合MRF,提出了马尔可夫生成对抗网络(Markovian generative adversarial networks,MGANs)训练生成神经网络,并在不使用大量数据的情况下,提高深度马尔可夫纹理合成的效率,可生成高质量的图像。为了突破配对数据集的限制,文献[25]采用了一种双向循环的结构,实现了循环生成对抗网络(cycle generative adversarial networks,CycleGAN),可以在源域和目标域之间学习图像转换,即在没有配对输入输出样本的情况下,将一组图像转换为另一组图像。其关键是将无监督学习与监督学习相结合,使用对抗性损失函数和循环一致性损失函数训练无监督GAN 模型,并以无监督的方式解决监督学习中的数据稀疏性问题。为了做到对特征的控制,Karras等人[26]提出了StyleGAN,但随着其广泛使用,该网络在生成图像时会出现纹理粘附效应,为了避免这类问题,Karras等人[27]改进网络StyleGAN2,模块之间的耦合度减少了很多,能够生成效果较好的图像,但在平移或旋转时,细节方面存在滞留现象,无法精细化处理。因此,Karras 等人[28]为了完全恢复网络的平移不变性,提出了StyleGAN3 架构,从根本上实现了真正意义上的空间位置不变性,大大提高了图像的质量。毛文涛等人[29]提出一种国漫生成对抗网络模型CCGAN(Chinese cartoon GAN),有效提升图像信息的同时,凸显中国传统美学的意蕴风格意境,同时无需大量计算,适用于视频风格化。孙天鹏等人[30]提出了Expression-GAN和SceneryGAN,并结合运用生成局部写实主义动漫模型,解决了细节丢失严重、色彩失真等问题并且消除了生成图像中的歧义像素块。

综上所述,以上方法需要为每种风格单独训练一个模型,使得扩展到其他风格的时间成本过大。

(2)多风格的图像风格迁移

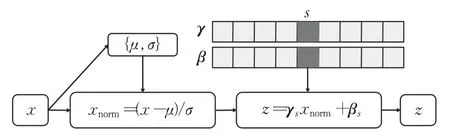

针对生成单一风格时间成本过大的问题,Dumoulin等人[31]在IN[21]的基础上为每个风格增加了一组γ和β参数,使它们是N×C矩阵,其中N是正在建模的风格数,C是输出特征图像的数量,提出了条件实例归一化(conditional instance normalization,CIN),使其能够学习多种风格。对风格进行条件化z如下:

其中,μ和σ是输入层的特征图像x在空间轴上取的均值和标准差,参数向量γs和βs是通过选择γ和β矩阵中索引风格标签s对应的行来获得的,其CIN 过程如图5所示。

图5 CIN过程示意图Fig.5 Schematic diagram of CIN process

CIN的目标是将一个层的激活x转化为针对风格s的归一化激活z。其网络的所有卷积权重都可在许多风格之间共享,并且在每种风格进行归一化后调整仿射变换的参数即可,其中一组γ和β代表一种风格。但是风格种类也不能训练太多,因为在内容和风格表达上可能随着参数的增加,网络效率降低,而导致结果的落后。

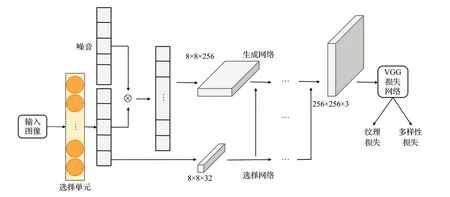

为了避免上述的问题,Li等人[32]提出了一种深度生成前馈网络的多样化纹理合成,可以有效地合成单个网络中的多个纹理,并能在测试阶段通过插值的方法生成新的纹理。这里将纹理表示为one-hot选择单元的连续嵌入向量,其体系架构如图6所示。

图6 多纹理合成网络体系架构Fig 6 Multi-texture synthesis network architecture

在构建纹理损失函数时,发现直接使用Gram 矩阵生成的纹理存在明显的伪影和颜色混合问题,因此提出使用计算两个激活之间的内积之前减去平均值去改进Gram 矩阵,其修改后的Gram 矩阵Gˉij以及纹理损失函数Ltexture如下:

其中,F*k为损失网络当前层位于k处的第*个滤波器的向量化的激活值,Fˉ为损失网络当前层中所有激活的平均值。为了衡量同种风格在不同噪声下结果的差异大小,加入多样性损失函数Ldiversity如下:

其中,N为输入的风格样本目标{P1,P2,…,PN}的个数,Φ( * )表示用VGG 网络Conv4_2 层提取到的特征,Pi为风格样本目标的第i个输出,Qi相当于对P进行重排。

此外,Chen 等人[33]的思想与Dumoulin 等人[31]遵循的想法一样,仅将少量参数绑定到每种风格。其关键在于StyleBank设计,由多个卷积滤波器库组成,每个滤波器库明确地表示一种风格。为了将图像转换为特定的风格,对应的滤波器库与单个自编码器生成的内容图像的中间特征图像进行卷积,将原始图像分解为多个特征响应图像,StyleBank 将映射到内容图像以产生不同的风格化结果。上述两者的方法花费时间短,但是随着学习风格数量的增加,模型规模通常会变大,进而影响图像质量和模型的灵活性。Zhang等人[34]通过充分探索单个网络的能力并将内容和风格结合到网络中进行风格识别,提出了一种新的CoMatch 层,用于匹配目标风格的二阶特征统计,从而实现了更准确的多风格建模。同时,构建了一个多风格生成网络(multi-style generative network,MSG-Net),提高了实时性。乔平安等人[35]为解决动漫风格迁移中出现的参数量较大、图像纹理和颜色损失等问题,提出了MC_CartoonGAN 模型,从而提高资源的利用率、降低参数量。Chung 等人[36]为了解决手绘和真实图像之间边缘结构的巨大差异,通过CycleGAN与pix2pix结合并添加景物标签功能建立BEGAN,从而增强边界图像的细节,生成更准确的真实图像。Wang等人[37]将水墨风格迁移看作非对称翻译任务,提出了一种asymmetric cycle-consistent GAN 的迁移方法,使用未配对数据集进行训练,有效学习从真实图像到水墨图像的风格映射关系,从而解决两个域之间的信息差异,生成逼真且程式化的水墨图像。

(3)任意风格的图像风格迁移

研究人员也不断探索如何实现基于任意风格的图像风格迁移,这意味着模型需要能够接受任意风格的输入,而不仅仅局限于预定义的风格样本。这样的任务更具挑战性,因为它要求模型具备对风格进行更细粒度的理解和学习能力。

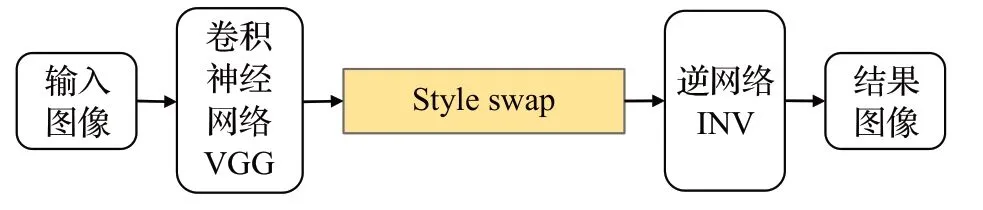

Chen 等人[38]引入了一种基于局部匹配的前馈网络的方法,旨在将内容结构和风格纹理通过交换层结合在预训练网络的单一层中,并且训练一个逆网络(inverse network,INV),从而实现图像的任意风格迁移。其基本思想是在预训练的VGG 网络特征空间中,找到与内容区域块匹配的风格区域块后,进行内容区域块与风格区域块的交换,然后提取多个内容特征块和风格特征块,并以逐块的方式用最接近的匹配风格特征块替换内容特征块(style swap),将style swap后的结果输入进INV中,得到风格化后的结果图像。文献[38]风格迁移过程,如图7所示。

图7 文献[38]风格迁移示意图Fig.7 Schematic diagram of style transfer in reference [38]

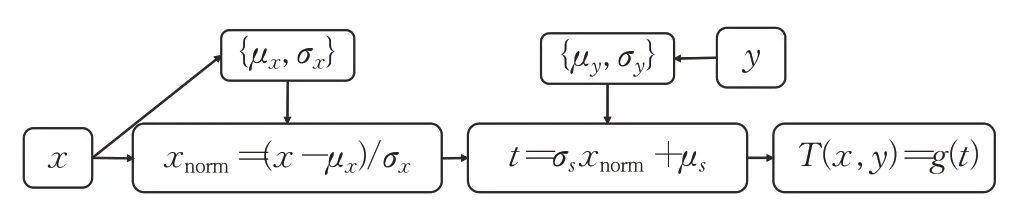

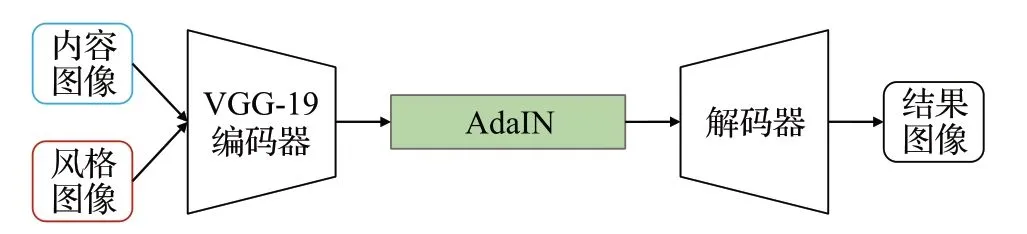

由于style swap 需要花费大量的计算时间,所导致整体效率的缓慢,Huang 等人[39]受IN[21]的启发提出了自适应实例归一化(adaptive instance normalization,AdaIN),利用编码和解码结构,无需学习任何仿射参数,首次实现了实时的图像的任意风格迁移,其公式如下:

其中,x和y分别表示内容图像与风格图像的特征图像,μ( * )和σ( * )分别是*的均值和标准差。AdaIN 过程如图8所示,得到输入图像的特征图像计算其均值和标准差,用内容特征减本身均值再除以标准差,从而实现去风格化,再乘以风格特征的均值加其标准差实现风格化,经过解码器映射出结果图像。其中,t为生成的目标特征图像,g( * )为解码器,T为生成风格化图像。

图8 AdaIN过程示意图Fig.8 Schematic diagram of AdaIN process

其整体思想如图9 所示,为使用固定VGG-19 网络的前几层来编码内容图像和风格图像,分别提取出内容图像和风格图像的特征图像,在特征空间中将特征图像输入到AdaIN层用于执行风格迁移,将内容特征的均值和方差与风格特征的均值和方差对齐,从而得到融合的特征图像,训练解码器以将AdaIN 输出反转到图像空间,使用相同的VGG 编码器来计算内容和风格损失。AdaIN对于图像风格迁移的速度较快,因其只关注风格的迁移而忽略了内容的保留,使得捕获风格图像的纹理不够细节化,风格化后的结果图像的风格特征不明显,更多的是颜色上的迁移,因此风格上的泛化能力有限。

图9 文献[39]风格迁移示意图Fig.9 Schematic diagram of style transfer in reference [39]

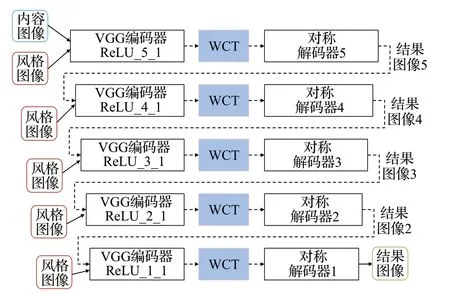

Li 等人[40]提出的白化和着色变换(whitening and coloring transforms,WCT),以匹配内容和风格中间特征之间的统计分布和相关性,来完全捕获风格从高到低层次的特征,其结果与泛化性能更好。其多级风格化流程如图10所示。

图10 多级风格化示意图Fig.10 Schematic diagram of multi-level stylized

采用预训练的VGG-19网络作为编码器,为了评估在不同层提取的特征,在VGG-19中设计五层对特征进行提取,并设计与之对应的解码器。输入的内容图像Ic与风格图像Is经过高层的编码器提取对应的特征图像fc、fs,对fc先减去其均值mc,再进行白化转换如公式(14),有助于从输入的内容图像中剥离风格特征信息,同时保留全局内容结构。同样对fs先减去其均值ms,再进行着色转换如公式(15),再加上之前减去的ms,完成整个WCT 操作,使内容特征图像的协方差矩阵Dc与风格特征图像的协方差矩阵Ds相匹配,解码器以将WCT的输出反转到图像空间,进行图像重建,得到风格化后的图像I*,其大小与原图大小相同。此时将前一层的I*作为较低一层的内容图像的输入,执行与上述同样的步骤,直至最底层完成,得到最终的结果图像I。

其中,E*对应*的正交矩阵。

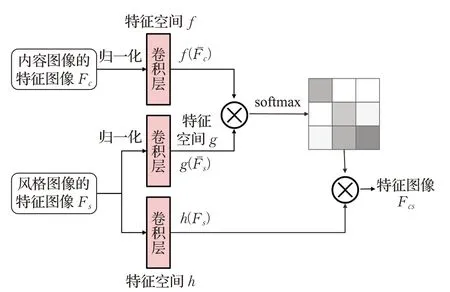

由于WCT 在面对多维特征时间成本过大,并且会对内容特征造成一定的扭曲。因此,Park等人[41]提出了风格注意力网络(style-attentional networks,SANet),其网络结构如图11所示。将提取的内容图像和风格图像的特征图像Fc、Fs进行均值方差归一化得到Fˉc、Fˉs,然后转换为两个特征空间f、g,进行softmax归一化,再与Fs经过转换为特征空间h,最终得到两者的特征图像Fcs。为了考虑内容特征和风格特征之间的全局统计和语义局部映射,Park 等人[41]还提出了一种身份损失函数,如下所示:

图11 SANet网络结构示意图Fig.11 Schematic diagram of SANet network structure

其中,λ*表示身份损失权重,Φi( * )为图像*在编码器第i层的特征图像,Icc(Iss)表示从两个相同的内容(风格)图像合成的输出图像。由于身份损失是从相同的输入图像计算,风格特征无差距。因此,身份损失能够同时维护内容结构和风格特征。

同年,Yao等人[42]针对结果图像细节不足的问题,提出了注意力感知多笔画模型(attention-aware multi-stroke,AAMS)。在自动编码器框架引入了自注意力机制,通过对自注意力组装自动编码器执行重建训练过程,注意力图可以掌握任何内容图像中的显著特征,有助于捕获图像区域之间的长期依赖关系。然后通过多尺度风格交换模块,将内容特征与多尺度风格特征交换混合不同的笔画模式,结合注意力图注入到多笔画融合模块中,执行多笔画风格迁移,实现了自动的空间笔画大小控制,但依旧存在仍然会出现局部失真。为解决这一问题,Liu等人[43]提出了一种新的注意力归一化模块,即自适应注意力归一化(adaptive attention normalization,AdaAttN),考虑内容和风格图像浅层特征和深层特征,学习空间注意力分数,并通过加权统计学来对每个点进行自适应的注意力归一化,实现特征分布的对齐,以减少内容失真。在此基础上,还提出了一种新的局部特征损失,以增强局部视觉质量,从而生成高质量的风格化结果。但是由于注意方法独立地渲染特征点,无法捕捉到特征的多样性分布,产生不一致的风格化结果。Luo等人[44]提出了渐进式注意力流形对齐框架(progressive attention manifold alignment,PAMA)来缓解不一致问题并提高风格化的质量。该框架多次执行注意力操作和空间感知插值,动态地将每个内容流形与其最相关的风格流形对齐,从而在区域之间实现一致的注意机制。然而,单个对齐不能为注意力模块在流形之间建立足够强的对应关系。因此,采用多阶段损失函数以及图像重建损失用于保持共享空间以进行流形对齐。

近年来,借助GAN[66]的训练,图像的任意风格迁移已取得令人满意的效果。Cho等人[45]受WCT[40]的启发提出了GDWCT(group-wise deep whitening-and-coloring transformation),通过正则化方法并拓展到分组的形式,有效反映风格特征,节省计算时间。Xu 等人[46]集合GAN[66]与AdaIN[39]两者的优点,引入了可以与掩码模块相结合的手动控制,进一步提出了一种适应测试图像的快速后处理方法,提高了风格迁移性能。Huo等人[47]尝试将内容特征与风格特征视为两组流行,提出了基于流形对齐的风格迁移(manifold alignment based style transfer,MAST),解决语义对齐的风格迁移问题。为了使结果图像更具真实感风格,引入了一种新的自适应权重跳跃连接(adaptive weight skip connection,AWSC),从而得到高质量的迁移效果。朱仲贤等人[48]针对结构一致性问题,并且受Han 等人[67]的启发,提出了基于对比学习的双向网络模型,以CycleGAN 为基础,采用双向训练,充分学习对应区域映射,并且引入一种新的联合对比损失,更好地利用图像信息,提高迁移质量。Zhang等人[49]提出一种Caster视觉组件解决了风格迁移动态学习特定领域和领域风格信息的问题,采用基于变分自动编码器的卡通风格创作模块(CSCM)来编码特定卡通图像的风格信息,将特定的卡通风格转换为内容特征,更好地控制所需风格,并将其扩展到其他卡通风格的迁移,并且通过对比学习来微调图像之间的颜色一致性。Yu 等人[50]通过结合语义和风格的约束提出了一种多通道生成对抗网络,利用注意力机制和条件归一化对网络进行优化,提取高质量的多层混合特征,此外,通过改进特征匹配损失和感知损失,使网络生成边缘更清晰、细节更丰富的图像。

2 应用现状

随着图像风格迁移方法的不断研究和创新,图像风格化效果的提升也呈现出高速发展的趋势。目前,基于神经网络的图像风格迁移技术在娱乐领域、商业领域、计算机视觉领域都具有广泛的应用。

2.1 娱乐领域

图像风格迁移在艺术创作、娱乐领域中被广泛使用。在日常社交网络中,图像风格迁移常常被用作图像美化,创作个性化的艺术作品或美化个人照片,增添创造力和趣味性。Prisma[68]作为首次使用基于深度学习的图像风格迁移算法的免费应用程序,可以实时地将用户的照片与著名艺术家的风格相结合。由于其高质量图像的生成,Prisma 在娱乐市场中取得了巨大成功,为用户提供了一种全新的图像处理体验。同样,DeepArt.io[69]平台也可以实现艺术风格与用户图像的融合与创新,除此之外还支持视频转换为动态的艺术作品。此外,图像风格迁移技术已经应用于许多电影、电视剧和游戏制作中,利用图像风格化技术可以快速将现实世界的素材转化为具有特定风格的画面。例如,在电视剧《权力的游戏》中,使用图像风格迁移技术将场景转化为油画风格,营造出浓厚的中世纪奇幻感。在电影《封神第一部》中,利用图像风格化技术将中国传统文化以及传统元素转化为庄重而神秘的美学氛围,增强了电影的动感和幻想感。这些作品通过图像风格迁移技术为观众带来了全新的视觉体验,提升了娱乐价值和观赏性。

2.2 商业领域

图像风格迁移在商业领域中也发挥着重要作用,许多知名品牌已经开始在广告宣传、产品展示等方面应用图像风格迁移技术。例如,时尚品牌Gucci利用图像风格迁移技术将其产品照片转化为艺术化风格,增加了产品的艺术性和独特性,吸引了更多消费者的关注。另外,餐饮连锁品牌KFC 在社交媒体上推出了独特的艺术风格化广告,通过图像风格迁移技术为其产品营造出别具一格的宣传效果。这些品牌的应用案例表明,图像风格化技术已经成为商业广告和产品展示的创新利器,能够吸引消费者的眼球并增加购买欲望。在广告和营销领域,可以使用图像风格迁移技术来创造出与品牌形象相吻合的视觉风格,使其与竞争对手区别开来,将品牌理念和特色通过独特的图像呈现出来,增强品牌的辨识度和吸引力,从而提升品牌识别度和消费者体验。此外,图像风格迁移在产品设计和虚拟试衣等方面也有潜力应用。

2.3 计算机视觉领域

图像风格迁移是计算机视觉领域中的一个重要主题,可用于图像增强、数据增强和图像翻译等任务。通过将特定风格的图像转化为其他风格,可以提供更多的数据样本用于模型训练,改善模型的泛化能力。例如,文物数字拓片生成技术[70]借助GAN的特征提取能力和数据拟合能力,在保留文物本身纹理细节的同时,增强生成拓片图像效果的真实性,对文物保护和文化传承发挥着至关重要的作用。图像风格迁移技术在安全方面的应用[71]可以加强图像识别、监控能力以及篡改防御技术,提高反恐、犯罪侦查等方面的效果。其次,在医疗影像分析方面[72-73],图像风格迁移技术可以用于将不同设备采集的医学图像转化为具有统一风格的高质量图像,并且将颜色信息与形态特征相关联,可以帮助医生和研究人员更准确地诊断和治疗疾病,为患者提供更好的医疗服务。此外,图像风格迁移技术在智能交通、自动驾驶等方面[74-75]也有着巨大潜力,应用此技术能够有效提高视觉感知能力。因此,在面对复杂的实际驾驶场景时,能准确识别和理解道路上的各种情况,来减少事故发生,提高整体的交通效率,从而推动交通安全和城市智能化的发展。

总的来说,图像风格迁移技术对娱乐体验、商业推广和计算机视觉技术领域带来了积极影响。为用户提供了丰富的创作和设计,同时为各行各业带来了更具吸引力的视觉效果和商业推广策略,并且在推动文物保护及安全等方面都是至关重要的,但从目前的研究现状来看,其潜在的价值还需继续挖掘。

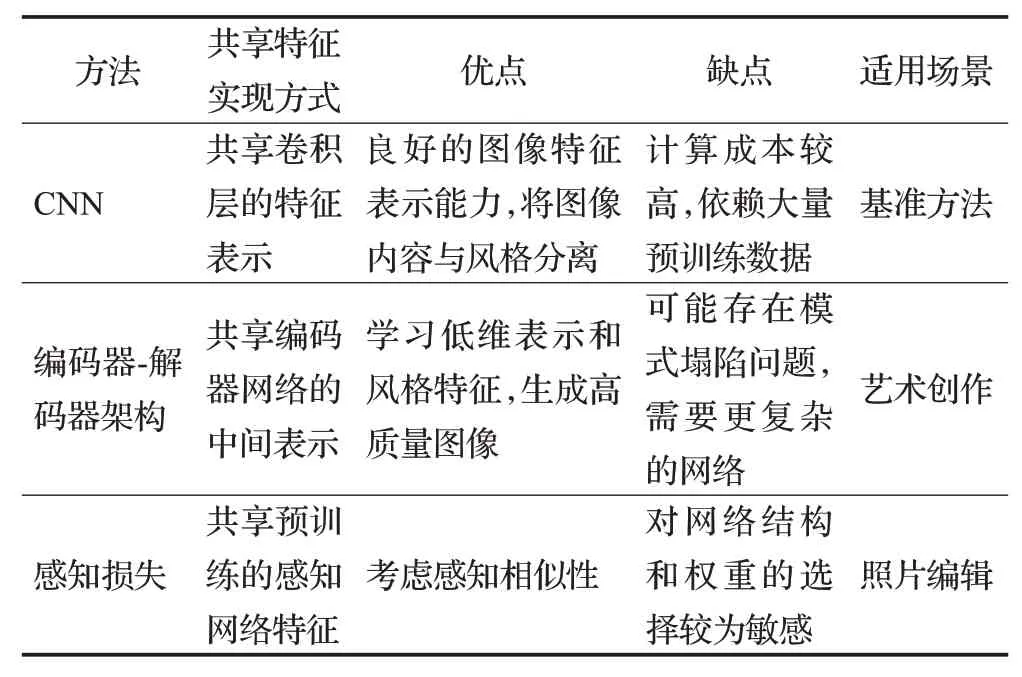

3 共享特征的主流方法对比分析

为了深入了解图像风格迁移中不同共享特征方法之间的差异和利弊,如表3 所示,列举和分析当前主流方法,并对其优缺点以及适用场景进行详细讨论。

表3 主流共享特征方法对比分析Table 3 Comparative analysis of mainstream shared characterization methods

通过对这些主流共享特征方法的对比分析,并对它们的优缺点和适用场景进行透彻探讨,以便提供清晰的理解和选择准则,根据特定需求在图像风格迁移中选择最合适的共享特征方法,有助于推动图像风格迁移研究的进一步发展,并促进其实际应用的推广。

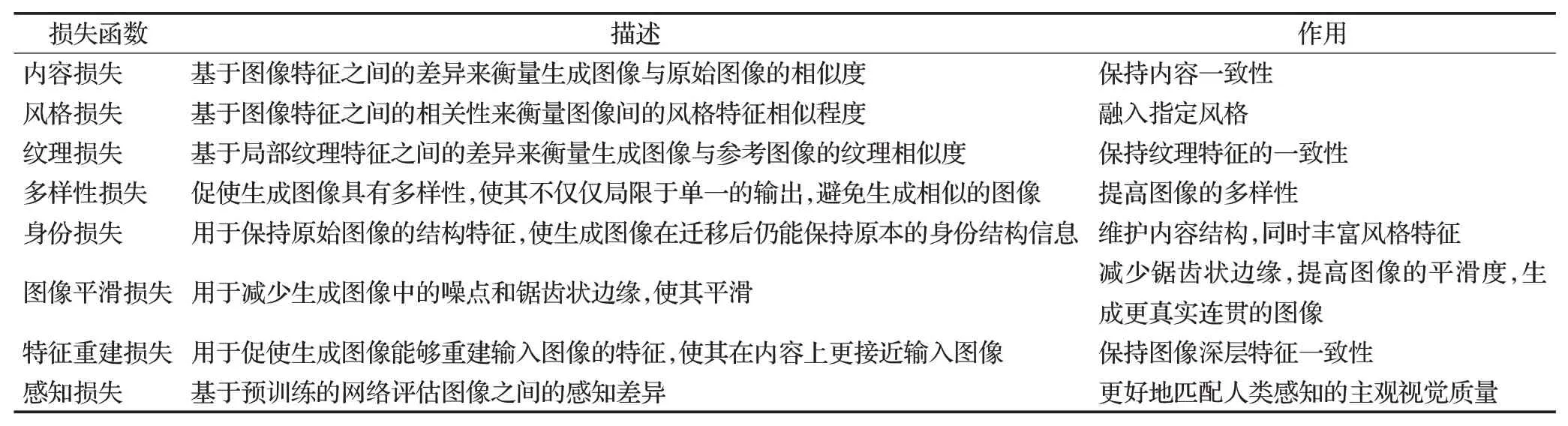

4 损失函数分析

为了更好地了解不同损失函数对模型的影响,本文列举了多个常用的损失函数,包括了内容损失、风格损失、纹理损失、多样性损失、身份损失、图像平滑损失、特征重建损失以及感知损失在内的八大损失函数。这些损失函数在图像风格迁移中分别起着重要作用,并且各自关注着不同的视觉特征。在此,将进一步对损失函数进行分析,并给出表4以便于对比。

表4 各类损失函数对比分析Table 4 Comparative analysis of various loss functions

通过对不同的损失函数的分析,可以更好地理解它们在图像风格迁移任务中的作用,进一步探索如何权衡损失函数的组合,并为实际应用提供更高效和可行的解决方案。

5 数据集与评价指标分析

图像风格迁移研究中数据集的选择和评价指标的使用是至关重要的。数据集提供了用于训练和评估图像风格迁移方法的样本图像,而评价指标则用于评估和比较不同方法的性能。本章将分析常用的图像风格迁移数据集及其特点,然后介绍常用的评价指标方法,并对其中重要方法在典型数据集中的表现进行补充列举和分析。

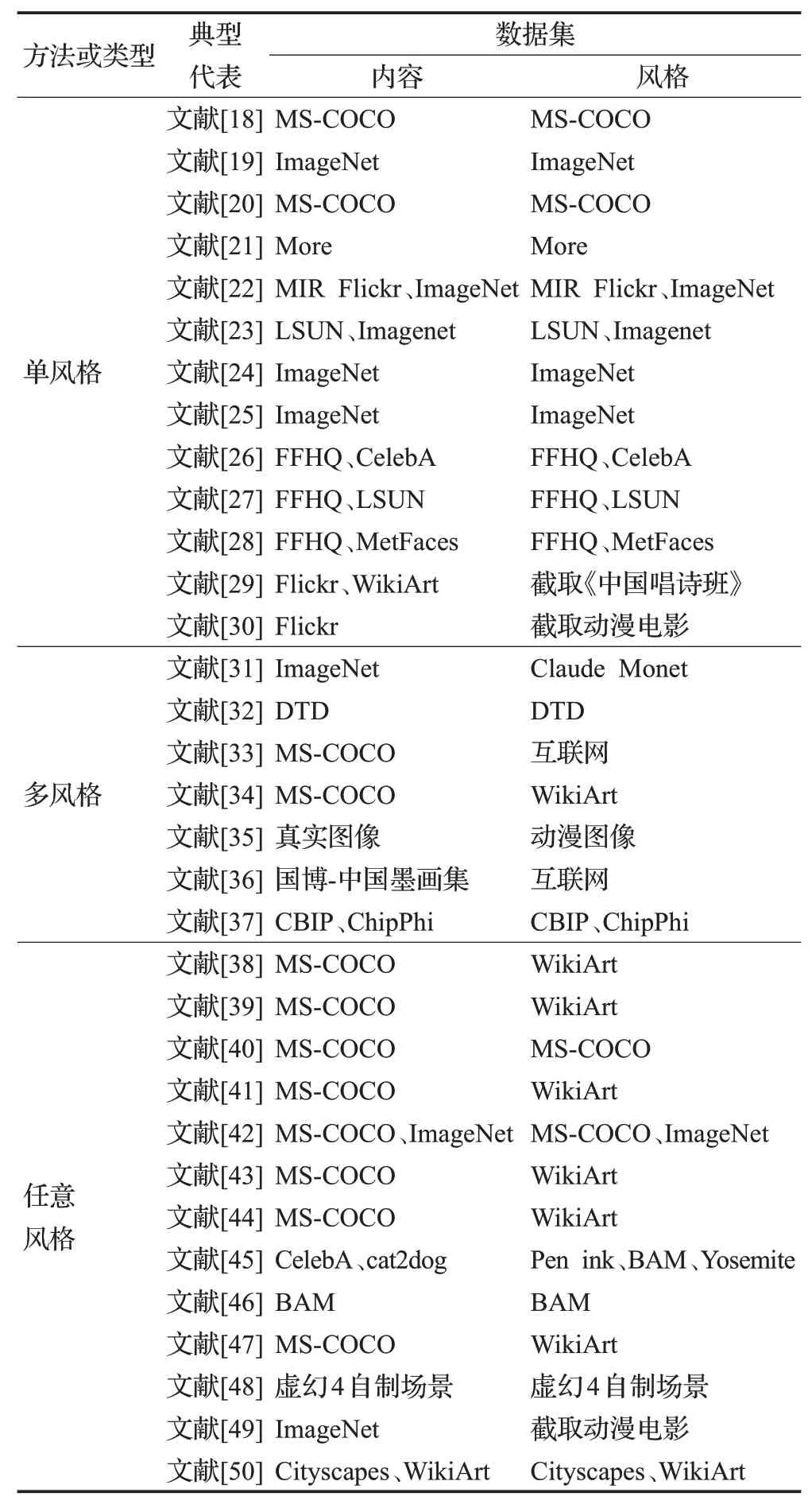

5.1 数据集分析

传统的图像风格迁移方法通常基于一些数学模型和规则,而不需要使用数据集进行训练,这些方法通过将输入图像进行各种操作和变换来实现风格迁移。基于图像迭代的方法不使用预训练的网络模型,无需训练数据,而是通过迭代优化的方式,逐步改变输入图像的内容以实现风格迁移。基于模型迭代的方法使用预训练的神经网络模型,通常需要使用大规模的数据集进行训练,训练过程是为了训练一个能够提取图像风格特征的模型。为了方便图像风格迁移,许多机构、平台提供了大量的数据集。基于模型迭代的图像风格迁移研究的数据集以及其特点、应用领域,如表5和表6所示。

表5 基于模型迭代的图像风格迁移方法数据集汇总Table 5 Summary of datasets for model iteration-based image style transfer methods

由表5、表6可知,MS-COCO[64]以及WikiArt[76]为图像风格迁移的常用训练网络的数据集。其中,MS-COCO[64]是一个广泛使用的图像数据集,包含了大量真实世界中各种场景的多个对象,并且每个对象都有对应的标注信息。其图像具有不同的视觉风格、光照条件等,对于训练风格迁移网络具有挑战性,有助于网络学习更复杂的图像风格。WikiArt[76]是一个收集了大量艺术作品的在线平台,包含了各时期艺术家的作品。在图像风格迁移任务中,使得网络能够学习不同艺术风格特征,并提供了高质量的图像,有助于网络更好地捕捉艺术风格的细微特征。

通过对数据集的分析,了解论文研究的基础和方法,验证其可行性,促进研究的可重复性和可扩展性,从而推动相关领域的持续发展和进步。

5.2 评价指标分析

图像风格迁移作为一个备受关注的研究领域,通过各种指标来评估其性能至关重要。在本节中,将从客观与主观两个角度来对图像风格迁移的评价指标进行全面分析。

5.2.1 客观的评价指标

客观的评价指标是基于计算机视觉和图像处理技术,通过数学公式量化生成图像与目标图像之间的差异进行评估。本小节将介绍以下常用的客观评价指标:峰值信噪比(peak signal-to-noise ratio,PSNR)、结构相似性指数[87](structural similarity index measure,SSIM)、Frechet 初始距离[88](Frechet inception distance,FID)和Wang 等人[89]提出的三个可量化因素,即内容保真度(content fidelity,CF)、全局效应(global effectiveness,GE)、局部模式(local patterns,LP)。通过对这些指标的分析,对图像风格迁移方法的性能进行客观的评估。

(1)峰值信噪比PSNR

PSNR 是评估图像结构相似性一种常用的指标,用于衡量生成图像与目标图像之间的噪声程度。其定义公式如下,其中MAXI为图像I的最大像素值。PSNR的数值越高,表示两幅图像之间的差异越小,生成图像质量越好。然而,PSNR只考虑了图像的像素级别差异,对于结构的差异较为敏感,忽略了感知上的细微差异,不一定与人类视觉感知一致。

(2)结构相似性指数SSIM

SSIM[87]是一种衡量感知相似性的评价指标,其公式如下,综合考虑了亮度、对比度和结构信息,并通过计算亮度相似度l、对比度相似度c和结构相似度s三个分量来得到最终的相似性指数。SSIM 数值越大,表示两幅图像相似度越高,图像失真越小。其中,I和I*表示两幅需要衡量的图像,α、β、γ为三个分量系数。SSIM将更多关注人眼感知上的差异,因此对于图像结构和纹理的保留有更好的鉴别能力,但对图像的细微差别不够敏感,在特殊情况下可能无法准确捕捉到风格迁移的变化。

(3)Frechet初始距离FID

FID[88]是一种用于评估图像之间距离的指标,具有较好的判别能力,能够较好地衡量生成图像与目标图像之间的分布差异。FID的数值越小,表示两幅图像之间的差异越小,生成图像质量越好,最好情况即是FID为0。然而,FID计算量较大,耗时较长且对于特定的风格迁移任务可能不够敏感或准确。其公式如下:

其中,(m,C)与(mw,Cw)分别代表来自模型生成数据的概率分布和来自真实的概率分布的均值和协方差,tr( *)表示矩阵的迹,即矩阵的对角线元素的和。

(4)三个可量化因素

Wang等人[89]将风格迁移评估分解为可量化的三个因素。其中,CF衡量了图像之间内容的相似程度,主要关注生成图像是否能够保留原始图像的关键内容,并在风格迁移的过程中尽量减少内容丢失或引入;GE 评估了生成图像是否具有良好的整体感知效果,该因素关注生成图像的整体一致性、风格清晰度和对风格特征的恰当表达,对人类视觉感知留下初步印象;LP是指生成图像是否能够恰当地保留原始图像中的局部细节和纹理信息,这一因素关注生成图像的局部特征是否与原始图像一致,并能够保持细节的准确性。三个质量因素不仅涵盖了以前的风格迁移方法和人类考虑的综合方面,但是指标的计算较复杂,需要一定的计算资源和时间。

综上所述,PSNR、SSIM、FID 这三个可量化因素在图像风格迁移研究中具有重要的应用价值。PSNR能够衡量生成图像的噪声程度,SSIM 关注图像的结构和纹理相似性,FID则量化了生成图像与目标图像之间的分布差异,而CF、GE、LP三个可量化因素在保留关键内容与风格细节的同时,关注整体的一致性。通过综合运用这些指标因素相互补充,能够提供对生成图像与目标图像之间差异的多个维度的量化评价,对图像风格迁移算法的性能进行全面评估,为算法的改进和比较提供参考依据。

5.2.2 主观的评价指标

相比之下,主观的评价指标是基于人类主观视觉感知和心理认知的评价方法,旨在获取用户对生成图像的主观体验和喜好。这种评价方法提供了一个以用户为中心的视角,更加贴近人类的感知和情感,能够提供直观、主动和富有情感的评价结果。

主观的评价指标通过用户研究,以便用户直观地感知两者之间的差异和相似度,开展人工主观评分实验或者用户调查问卷收集用户对生成图像与目标图像对比展示的反馈意见。其中,参与者可能会被要求根据视觉质量和风格一致性等标准对图片进行排序或评分,纳入主观评价可以更加直观地了解用户体验反馈,进一步了解用户对图像风格迁移算法的观感和喜好。因此,开发基于人类对一般图像合成问题的视觉感知的评估指标是一个有趣的方向。

总之,通过对评价指标的分析,全面了解不同图像风格迁移方法的性能。因此,评价指标的优势、局限性和最新进展应得到强调,通过介绍指标获得的结果,在图像风格迁移方法的评估和比较方面得到有价值的见解,促进算法的改进和优化,以提供更好的结果和用户体验。

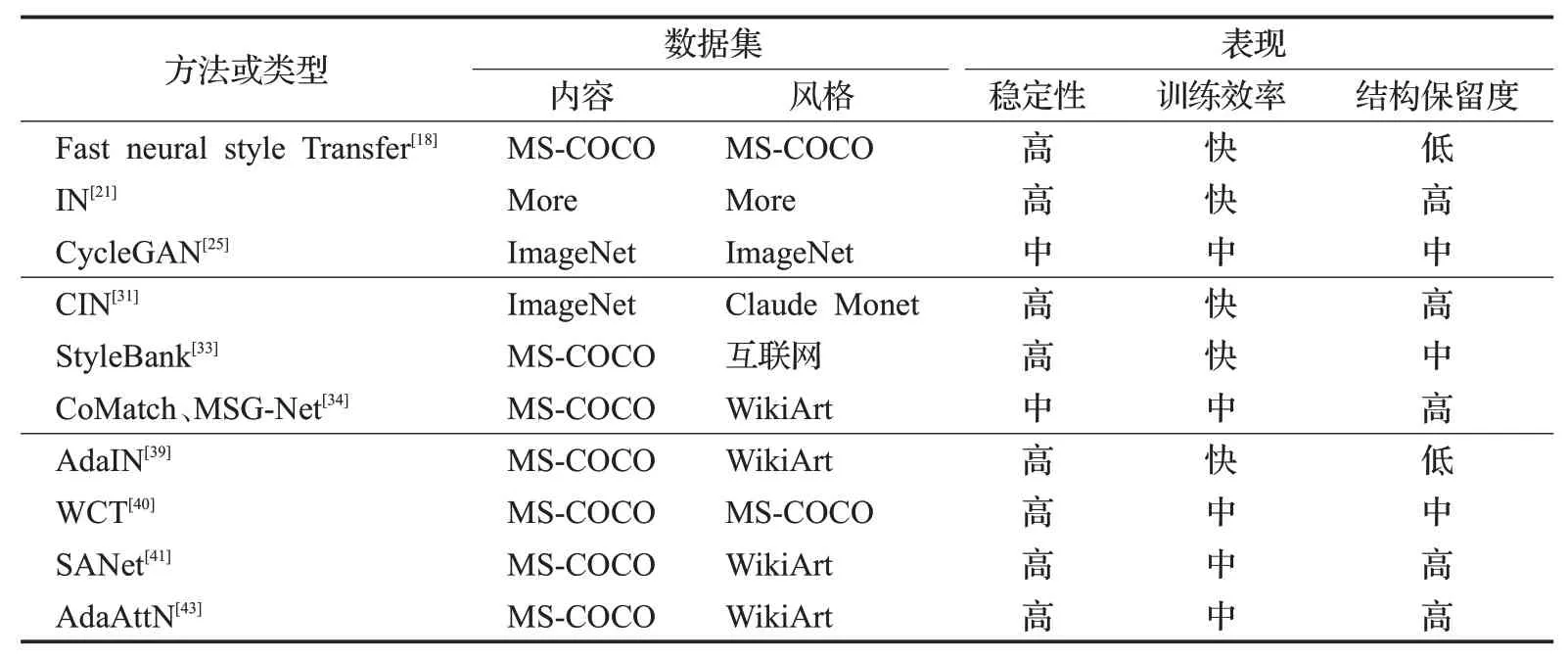

5.3 重要方法在典型数据集中的表现

为了全面评估图像风格迁移方法的性能,本节从稳定性、训练效率以及结构保留度三方面对其重要方法在典型数据集中的表现进行展示,如表7所示。

表7 重要方法在典型数据集中的表现Table 7 Performance of important methods in typical datasets

通过上述信息,了解不同方法在不同数据集上的优劣势,考虑到图像风格的多样性和个体差异,选择合适的方法仍然取决于具体应用需求和数据集特征,为研究者选择适合自己需求的方法提供参考。同时,也促进了对方法改进和比较的深入讨论,推动图像风格迁移领域的持续发展和进步。

6 主要问题及研究方向

目前,图像风格迁移算法以及模型已经取得大量研究进展,但是实现任意风格迁移和精细化控制仍然是难点问题。因此,总结了当前存在的主要问题及建议,如下:

(1)迁移学习理论的问题。如何更好地表示和提取知识是迁移学习的核心问题之一。目前的方法主要基于共享特征的假设,即认为不同任务或领域的特征可以存在一定的共享性。然而,如何确定共享的特征以及如何进行有效的知识迁移仍然是一个开放性问题。当源领域和目标领域之间存在显著的数据分布差异时,迁移学习的性能会受到影响。这种数据分布的差异被称为领域偏移。解决领域适应和偏移问题需要考虑如何进行领域自适应,即如何使得模型在目标领域上具有良好的泛化能力。在迁移学习中,不同任务或不同领域的知识可能存在冲突,如何进行有效的知识融合和冲突解决是一个挑战。

(2)模型轻量级的问题。目前风格化效果较好的模型通常具有数千万到数千亿级别的规模,这导致了较大的存储空间的占用和高计算复杂度,限制了模型的实施与发展。例如,图像风格迁移常用的VGG 模型参数量约为138×106,计算量约为15.5 GFLOPs,若增加其他机制,其规模也将会相应增加,通常需要更多的存储空间和计算资源,会对实时性和计算速度产生影响。因此,模型轻量化是该领域面临的挑战之一。如何使得模型轻量化,其实就是如何实现模型压缩的问题。可以考虑目前有几种常见的模型压缩和加速方法,包括模型量化、知识蒸馏、剪枝和分组卷积等。这些方法可以有效减少模型的参数量、计算量或内存占用,从而提高模型的效率和速度,以满足实际应用需求。

(3)多样化的任意图像风格迁移的问题。通过大量调研,不难发现,风格迁移与图像分类、图像分割、模式识别等方面存在交迭。例如,语义分割可以将图像中的主体和背景进行切割,通过这种方法,对背景与主体部分分别进行不同风格的迁移,最终的效果也会受到相关领域研究进展的影响。

(4)数据集与评价指标的问题。采取公开常用的数据集以及新的数据集进行模型验证和改进。在检验风格迁移效果上,并没有一个明确的评价指标,如何客观且主观地对内容和风格进行评价值得研究。

7 结束语

本文对图像风格迁移的相关文献经典方法进行了综述和评价,并对存在的主要问题以及未来研究方向做了进一步的分析和展望。总而言之,图像风格迁移不仅具有理论研究意义和实际应用价值,而且其研究对于人工智能、图像处理相关领域的开发应用也具有重要的参考价值,并能产生积极的推动作用。