基于语义不一致性的网络暴力舆情预警方法*

叶 瀚 胡凯茜 李 欣 孙海春

(中国人民公安大学信息网络安全学院 北京 102623)

0 引 言

随着微博、百度贴吧等互联网社交平台的快速发展与移动终端的广泛普及,在公开互联网平台中滋生的网络暴力舆情发生地愈发频繁。为此,及时预警网络暴力舆情对于防止进一步的伤害并确保舆情可控至关重要。

但网络暴力舆情预警也面临诸多挑战。其关键挑战之一是所需分析的目标数据量庞大。以主流社交媒体为例,每分钟都有数以百万计的帖子、评论和消息产生,导致很难实时识别潜在的网络暴力内容。许多研究使用动力学模型来模拟和预测特定话题的舆论演化趋势。然而,这些模型的构建需要大量的先验知识或专家知识。另一个挑战是网络舆情内容本身的高度复杂性和变化性。俚语、讽刺、反语等表达方法的使用,为模型正确识别网络暴力内容增加了极大的难度,为预测舆情整体趋势增大了难度。此外,网络暴力内容往往以极快的速度发展和变化。许多有监督模型可能会受到训练时所必需的人工标注数据的生产效率的制约,导致识别精度下降。

受到软件开发与自然语言处理中语义不一致性(Semantic Inconsistency,SI)概念的启发[1-3],本文提出了基于语义不一致性的网络暴力舆情预警方法,其原理是敏感地监测当前内容相对于历史内容的细微变化,从而实现预警。该方法能够尽可能同时减少对于先验知识的依赖、不需要全量完整数据、不依赖人工数据标注的方法来预警与网络暴力相关的潜在事件的爆发。

1 相关工作

1.1 网络暴力舆情的检测与预警

随着互联网的迅速发展,社交媒体平台成为人们沟通日常、分享信息、表达观点的重要渠道。然而,网络暴力、极端主义、网络色情等有害内容的泛滥已经成为网络空间内的严重问题。这些内容不仅会损害个人心理健康,甚至有可能对社会稳定和国家安全造成威胁。

近年来,研究人员运用了多种机器学习技术来检测和过滤网络暴力等有害内容[4-7]。例如,Pawar等人的研究表明[8],在检测社交媒体中的网络暴力内容方面,支持向量机(Support Vector Machines,SVMs)等有监督的机器学习算法能够取得较高的准确率。Ghosal和Jain使用无监督方法识别大规模数据集中的有害内容[9]。Mozafari等人研究使用预训练语言模型来检测和分类社交媒体上的网络暴力言论[10]。虽然以上研究在探测网络暴力内容中取得了较好的效果,但缺乏对于网络暴力舆情的预警预测能力。

在实现网络暴力舆情的监测预警方面已有多种不同角度的方案研究。研究人员开发了监测系统以监测Twitter中仇恨言论的演变[11]。此外,Lingiardi等人根据社交媒体内容和评论来实时监测少数群体可能的异常行为[12]。另一些研究通过融合各种数据源或数据特征来预测网络暴力舆情发生的可能性。Pratama等人提出利用社交网络分析方法来预测网络暴力舆情发生可能性[13]。类似地,Atoum设计了基于文本情感特征的方法来识别和预测可能参与网络暴力的个体[14]。

虽然这些研究在检测和预防网络暴力舆情方面取得了重大进展,但仍然缺乏能够在网络暴力内容大规模出现、造成严重网络舆情发生之前进行精确预警的技术方法,需要更高效、通用、简洁的方法以识别和预警网络暴力等有害内容所造成的网络舆情。

1.2 网络舆情趋势预测

网络暴力舆情的产生与发展极为迅速且高度不确定,往往会引发意料之外的舆情危机。通过预测网络舆情趋势可以更好地应对潜在危机。近年来已有许多方法可以对舆情进行精确模拟[15-17],并且能够预测互联网上特定主题的舆情趋势。

在早期的预测网络舆情趋势的研究中,研究人员通过舆情趋势预测现实活动。Tumasjan等人运用情感分析技术识别推文中蕴含的情感,然后基于Twitter数据探测选民的政治倾向,从而预测2009年德国联邦大选结果[18]。另外,Rizk等人结合情感分析技术[19-21]和机器学习技术,从基于地理位置的Twitter推文中预测2020年美国总统大选的结果[22]。

另一种预测舆情趋势的方法是在大规模的文本数据中使用主题建模技术识别潜在的主题以预测舆情[23]。Wang等人提出了基于主题建模技术的社交媒体舆情检测方法[24]。Zhang等人将主题建模技术应用于大型微博语料库中[25],分析了COVID-19疫情发展期间的舆情演化。

目前,基于深度学习的方法已经广泛应用于网络舆情趋势的预测中。例如,Ali等人在Twitter等社交媒体平台的基础上[26],设计了用于预测巴基斯坦大选结果的深度学习模型。Qian等人利用深度神经网络GloVe分析推文数据[27],以研究NFT交易量与Twitter相应主题的每日活跃度之间的相关性。

此外,研究人员还使用时间序列分析来预测网络舆情趋势。例如,Su等人提出基于ARIMA模型和改进的季节性灰色分解的集成模型[28],应用于“杭州林生斌事件”和“唐山打人案”这两个事件的舆论热度预测中,相较于与其他方法相比取得了较高的准确率。

综上所述,近年来研究人员已经应用情感分析、主题建模、深度学习和时间序列分析等多种方法以预测网络舆情趋势。这些方法达到了较好的效果,在实际应用中具有很大的潜力。而本文在上述研究基础之上,提出了一种专注于建模和监测语义不一致性的方法,以期实现网络暴力舆情的预警。

2 基于不同时序语义不一致性的网络暴力舆情预警方法

2.1 现实条件下的理想网络暴力预警模型

为设计现实条件下具备实践意义的预警模型,本文首先基于现实需求分析网络暴力舆情预警模型理应具备的基本特征。

a.低先验知识。很多预警模型在进行仿真实验时定向收集了特定关键词的数据,然而这在真实条件下是难以满足的。因此,为了提升网络暴力预警模型的现实可用性,本文所设计预警模型应当尽量减少对于事件关键词的依赖。因为网络暴力内容的主题是多样的、变化迅速的。

b.及时性。预警模型发出网络暴力舆情预警时,该事件应当仍然处于萌芽期或发展期。如果发出预警时事件热度已经处于顶峰,此时再发出预警将不具备现实意义。因此,理想的预警模型应当在网络暴力舆情讨论热度达到顶峰前的合理时间发出预警信号。

c.数据可行性。真实环境下的数据量过于庞大,难以全量获取数据,无法实现实时的内容分析。理想且可行的模式是通过采样的方式抽取部分特定内容以实现有效预警,而不必需要对目标网站的所有内容进行分析。

综上所述,本文认为现实需要的预警模型应当至少满足以下三个基本条件:①不需要与事件直接相关的特定关键词;②应当在事件讨论热度到达顶峰前的合理范围内进行预警;③不需要全量获取目标站点或平台的所有数据。

2.2 基于不同语义不一致性的网络暴力舆情预警模型

为了在上述条件下成功实现预警,需要考虑一个基本的事实:对于任意一个关键词,如果无人使用该词语在互联网中发表新的内容,那么不论何时搜索包含该关键词的内容,搜索结果的“内容成分”应当是保持相对不变的。相反,如果网络中即将出现某件极高讨论度的事件,那么将会出现大量相同主题的评论、转发内容和原创帖子。

考虑到上述事实,便可以着手考虑如何监测网络暴力舆情的发生。由上述分析可知,高热度的突发事件在发展过程中,必然存在一个用户讨论陡然激增的时期。在这一时期中,将会有大量文本内容集中于同一主题。因此,如果预警模型能够灵敏地捕捉到某个主题内容的快速激增,便可以实现网络暴力舆情的预警。

但问题在于,预警模型并不了解即将发生的网络暴力舆情的直接相关关键词。如果想要捕捉到有关某一个网络暴力舆情主题内容的快速激增,就只能实时监测目标平台的所有数据。这显然与2.1节提到的限制条件相悖。

为解决这一问题,本文考虑了网络暴力内容监测的特殊性。虽然每一起事件的直接相关关键词并不相同,但是网络暴力言语中的侮辱性词汇一般相对固定。这是因为人们向某一对象施加言语暴力时所使用的核心词汇并不会发生剧烈变化。

因此,利用上述假设提出以下预警监测方法:首先,收集网络暴力言语中常用的侮辱性词汇。这些词语往往相对固定,且在一系列网络暴力舆情中都被反复利用。然后,收集过去一段时间内包含侮辱性词汇的内容,并分析其语义。同时收集给定的历史时间段内包含这些词汇的内容。最后,比较过去一段时间和给定历史时期内的语义是否一致,如果存在较大变化,即可判定网络暴力舆情发生的可能性。

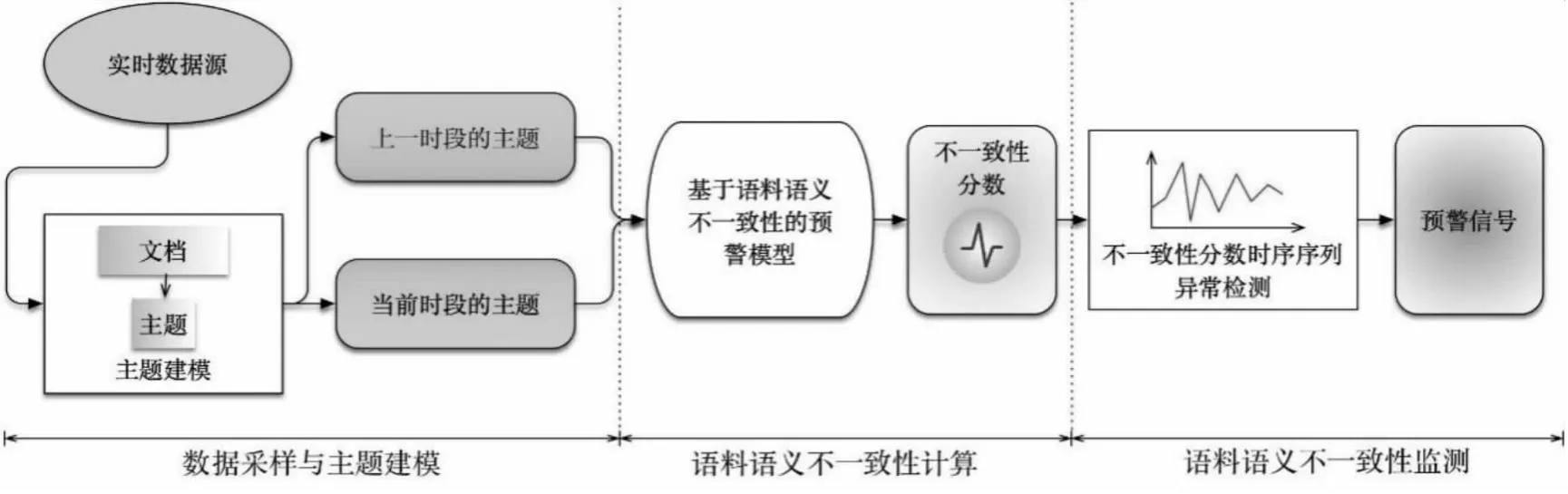

总的来说,如果能不断地监测和比对本时段和先前时段涉及特定关键词的内容的整体内容相异性,就可以对即将发生的高讨论度、高热度事件作出预报。本文模型的主要思路见图1,该图阐述了应用该思路的预警模型的主要框架。

图1 本文所提方法的框架

如图1所示,本文将整个过程划分为三个不同阶段:数据采样和主题建模、计算语义不一致性、语义不一致性指数监测。

a.数据采样和主题建模。该阶段需要从实时数据源中获取最近一个时段和过去一个时段中有关特定核心词汇的文本内容。然后利用主题建模技术对两个不同时段的内容进行分析,获取两个时段内的主题内容;

b.语义不一致性建模。该阶段将根据两个时段的主题内容计算语义的不一致性(SI)。SI越大,意味着两组不同时段的语义之间的差异性越大;

c.SI值监测。该阶段需要对SI时间序列进行监测,一旦出现异常值则会触发预警。

上述框架的实现存在以下几个难点:采用何种策略和方法进行实时数据的采样?采用何种主题建模技术?如何计算两组内容之间的语义不一致性?如何确认SI时间序列中的异常值的出现并据此发布预警?

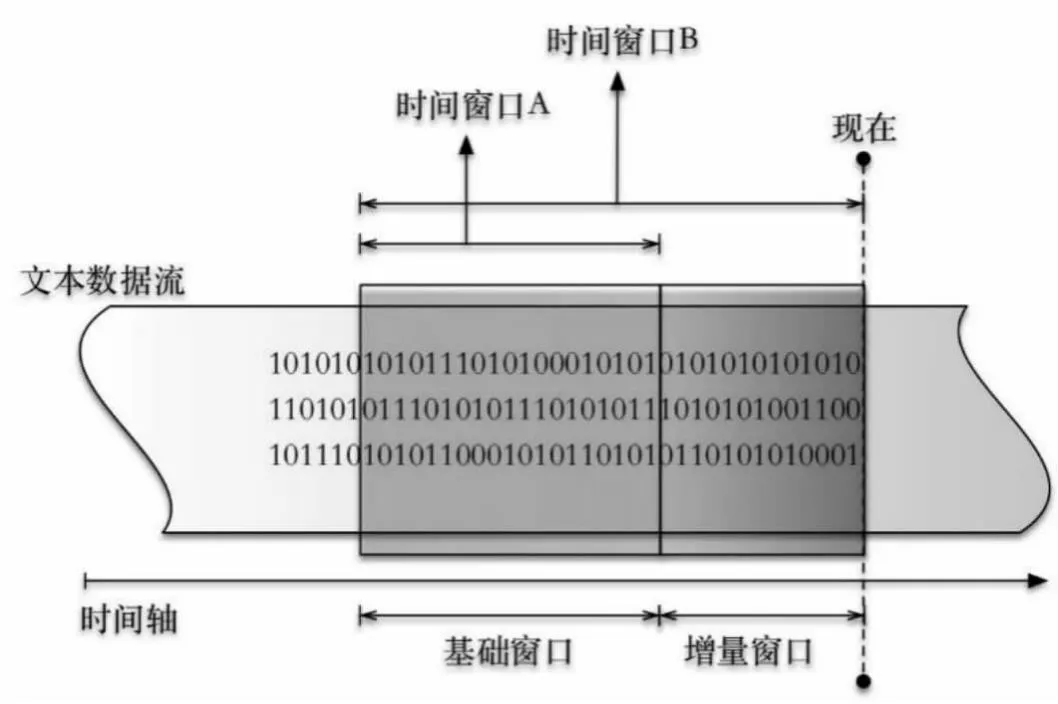

2.3 实时数据采样策略

如图2所示,对实时数据源采用的采样策略可以描述如下:模型需要对时间窗口A和时间窗口B的文本内容同时进行主题建模,分别以CA和CB表示。如式1所示,时间窗口A仅包含基础窗口(CBasic)中的文本,即过去一段时间的文本。如式2所示,时间窗口B同时包含了基础窗口和增量窗口(CIncre)中的文本。增量窗口中的文本是指发布时间距离当前时间最近的一部分文本内容。所有被采样的数据都必然包含与网络暴力直接相关的核心词汇。这些核心词汇被事先指定,因此采样时不需要获取平台中的所有数据。

图2 采样策略

CA=CBasic

(1)

CB=CBasic+CIncre

(2)

进一步来讲,在采样窗口B中同时获取基础窗口和增量窗口的数据,是因为如果仅采用增量窗口将会使得预警模型过于敏感。现有的采样策略能够很好的凸显出增量窗口与基础窗口之间的内容变化程度。

2.4 用于主题建模的LDA模型

LDA(Latent Dirichlet Allocation)是一种用于主题建模等领域的文档主题生成模型[29-30]。LDA模型在处理文本数据时,其输出作为输入文本的摘要,经常被用于各种领域。其输出可描述为:描述主题zn的一组词语Wz(以主题词命名)和属于主题zn的Wz中每个词wi的权重。

根据上述描述,LDA模型可以发现存在于文本文档x的潜在主题z,并将每个文档x分配到一个主题集中。LDA还将相关单词或标记映射到潜在主题集合z中,可以通过观察LDA的生成过程来理解它的输出。

文档x在LDA模型中的主题生成过程可以用以下步骤表示[31]:①选择N∈Poisson(σ);②选择θ∈Dirichlet(α);③对于长度为N的文档中的每个词语wn,选择一个主题zn∈Multinominal(θ),然后从p(wn|zn,β)中选择一个词语wn,即一个基于主题zn的多项式概率。

其中主题数K是预先定义的。而由一组词语组成的文档xi的边缘分布的定义见式(3):

(3)

词语概率由矩阵β∈[0,1)K×#W实现参数化。模型参数α和β可以通过使用最大似然估计或贝叶斯推断从语料库中观察到的词语计数来估计其数值。

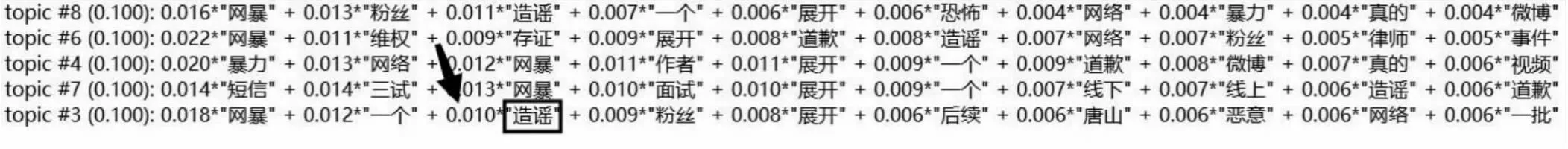

如式(4)和式(5)所示,采样窗口A和采样窗口B (CA和CB)中的内容需要经过LDA模型处理。LDA模型的输出(ZA和ZB)如图3所示。每一行代表文本中的一个话题。方框中的词语为该主题中的一个主题词,箭头所指的数字为该主题词在本主题中对应的权重。

图3 LDA模型输出示例

ZA=LDA(CA)

(4)

ZB=LDA(CB)

(5)

2.5 语义不一致性建模

在本文模型中,主题建模实现了对语义内容的提取,其输出的文本主题即为文本语义内容的高度概括。为了实现语义不一致性的建模,接下来需要计算两组主题间的不一致性。两组主题间的语义不一致性直接反映了两个时间窗口内语料语义的不一致性。

在每一组主题中往往包含着多个独立的主题。在计算两组主题的不一致性之前,需要考虑单独的两个主题之间的相似度如何计算。因为将两个主题之间的相似度取倒数或者取负数即可表征主题之间的不一致性,也即主题的语义相异性。本节基于LDA主题模型的输出结果,提出了一种权重加和算法以解决主题相似度的计算问题,如算法1所示。该算法的核心思想是,如果两个主题之间相同位置顺序(按词语权重大小排序)上相同的词语越多,则两个主题越相似。缩放因子(记为t)用于将最终输出分数s缩放到合理的范围。

算法1 主题相似性计算

输入:主题1的词汇集合WA,主题1的词汇权重QA,主题2的词汇集合WB,主题2的词汇权重QB.

输出:主题1与主题2的相似性分数s.

c←0

end if

end for

Returns

算法1的流程如下:

第1步,先输入相关数据集:分别为主题1、2的词集WA、WB,两个词集中每个词的权重QA、QB,缩放因子t。

第2步,初始化累加器c。

第3步,比较两个词集相同位置顺序(按照词语权重大小排序)的词语是否相同,如果相同,则把相同位置上词语的权重和累加入累加器c。

第4步,重复步骤3直至对两词集完成遍历。

第5步,.计算两个主题的相似度得分s。两个主题相同位置顺序上相同的词语越多,则两个主题越相似。再通过缩放因子将最终输出分数缩放到合理的范围。

接下来将描述两组主题之间的语义不一致性如何计算。首先,假设两组主题完全相似,那么这两组主题的语义不一致性指数应该非常低。一组主题中的任意一个应当可以找到另一组主题中的唯一一个与其对应。然而,主题模型输出主题时往往不具备特定的顺序。因此,本节使用遍历计算的方法,在一组主题中选择一个主题,并计算它与另一组主题中每个主题的相似度。然后保存这个过程中产生的最高分。最后将所有的最高分综合起来,作为两组主题的语义不一致性。更为重要的是,如果发现在最近一个时间段内的某一个主题无论如何也找不到与上一个时段相匹配的主题,那么该主题就有可能是即将发生的网络暴力舆情的主题。具体见算法2。

算法2 语义不一致性计算

输入:A主题集TA,B主题集TB.

输出:A主题组所代表的语料与B主题组所代表的语料之间的语义不一致性数值st.

st←0

smax←0

ifstmp>smaxthen

smax←stmp

end if

end for

st←st+fs(smax)

end for

Returnst

算法2是基于遍历计算的方法来解决两组主题之间语义相异性的计算问题。假设两组主题完全相似,一组主题中的任何一个应当可以找到另一组主题中唯一一个与其对应。但是考虑到主题模型输出主题时往往不具备特定的顺序,本算法使用遍历计算的方法。算法过程描述如下:

第1步,输入主题集TA、TB。每个主题集都有相同数量的主题。

第2步,选取主题集A中的一个主题,同时遍历主题集B中所有主题,利用算法1计算主题集A中的那个主题与主题集B中最不相似的主题的语义不一致性数值。

第3步,重复步骤2到步骤3直至主题集A中每一个主题都计算了其与主题集B中最不相似的主题之间的语义不一致性数值。

第4步,将主题集A中所有主题与主题集B中最不相似的主题之间的语义不一致性数值加和,输出两主题集相异性得分st。

t时刻SI计算可以描述为:

TDIt=FA(ZA,ZB)

(6)

式中FA代表算法2。

在实际计算过程中,算法2包含感应函数fs。公式st←st+fs(smax)将由算法1输出的主题相似度分数转化为SI,因此称之为相异性感应函数。本节设计了如下两种函数,分别称为函数A(式7)和函数B(式8),分别适用于不同的场景。

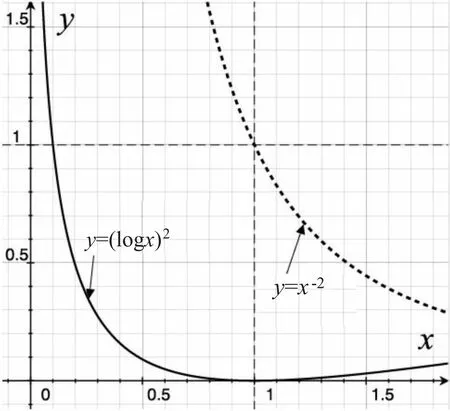

y=x-2

(7)

y=(log(x))2

(8)

为充分说明两种函数的性质,图4展示两个函数的图像。虚线代表基于反比例函数设计的相异性感应函数A,而实线是基于对数函数设计的相异性感应函数B。

图4 算法2中的两个可用函数

由于算法1输出的主题相似度分数的值域是[0,1],故相异性感应函数需要在[0,1]区间之内保持单调递减。如果两个主题越相似,那么他们的不一致性分数应该越低。

而本文提供的两种相异性函数均满足上述基本要求,但是这两种函数还是存在一些微妙的不同,因而适合不同的场景。如图4所示,函数A在输入为1时输出也为1,而函数B在输入为1时输出为0(参考图中垂直虚线与水平虚线)。随着输入x的减小,函数B的输出增长速度显然慢于函数A。这意味着函数A会非常显著地放大两个主题间的任何不同。但是函数B则不如函数A敏感。除非两个主题非常不同,否则主题间的差异很难用函数B感知。这两种函数具有不同的感受特性,在后续的实验中将会证实这两种函数具有不同的应用场景。

2.6 基于异常检测的不同时序语义不一致性的监测

在预警模型的实际运行中,每隔一段时间就会输出该段时间的SI。SI数值的时序序列处于波动之中,但并没有一个确切的预警阈值,须比较过往时间段内的SI数值来判断本时段的SI数值是否存在异常。

为此考虑使用无监督的时序异常检测方法来进行对SI数值的监测。无监督方法的优势在于无需人工识别和数据标注即可发现异常值,正是本文所指出的应用场景的关键需求。

本节采用双窗口波动率检测法对SI数值进行监测。两个窗口内数据(Dt1和Dt2)之间的波动率vn可以定义为:

(9)

其中σ(D)的定义是:

(10)

[Q1-c×IQR,Q3+c×IQR]

(11)

IQR由式(10)定义。

IQR=Q3-Q1

(12)

其中,Q1代表整体时序数据的第一四分位数,Q3代表第三四分位数。c是调节因子。

3 实 验

为了验证本文模型的有效性,本文需要确定现实世界中所存在的网络暴力舆情。因此,首先收集了社交媒体“微博”的真实数据,并为检测本文模型的性能而界定了高热度事件的标准,使用本文模型进行模拟预警。最后,通过比较真实数据和模拟的预警数据来计算本文模型的预警准确率和覆盖率。

3.1 数据收集与分析

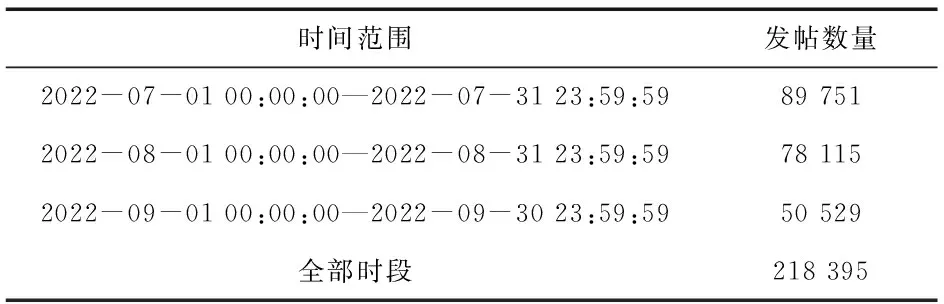

本节首先确定了在互联网社交媒体中所存在的一系列网络暴力内容中所使用的高频关键词。然后基于这些关键词收集了2022年第三季度社交媒体“微博”中的语料内容,总计218 395条。每月发帖数量见表1。

表1 预处理后的数据统计

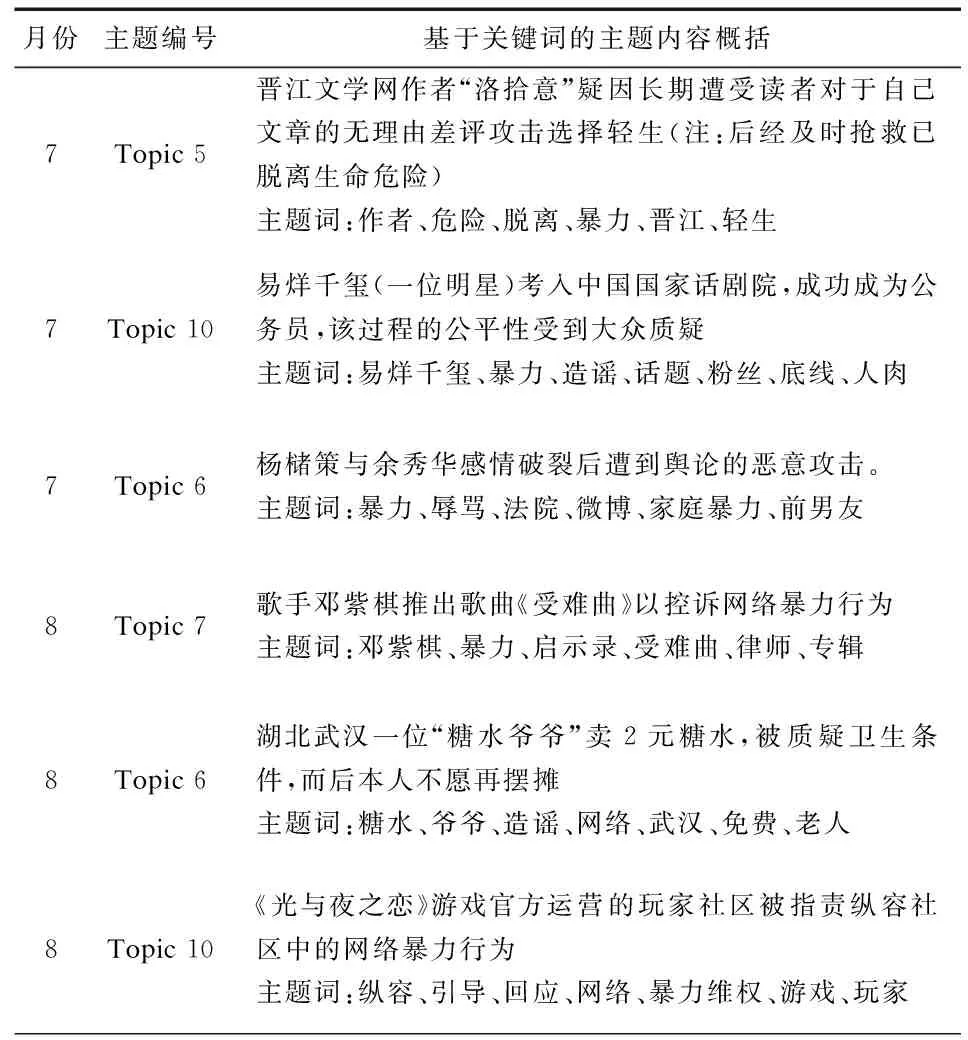

为了验证本文模型有效性,需要确认在此期间该社交媒体中出现了哪些高讨论度的网络暴力舆情。使用LDA模型对2022年第三季度内的每个月进行主题建模后,获取该月份内的语料中存在的主题内容,以及相关主题内容的时间分布。表2展示了部分月份的主要主题及主题词。部分主题涉及政治、性别、地域争议或严重的人身攻击,为避免不必要的争议,本文未详细阐述和展示所有主题,仅节选了部分主题进行展示。

表2 2022年7—9月期间部分主题内容总结

3.2 实验设置与评价指标

3.2.1实验设置

在数据预处理阶段,出现次数较多的词语不能突出不同文本样本之间的差别,而出现次数较少的词语能提供的有效语义信息较少且徒增计算量,因此,为合理地降低LDA模型所使用的词典大小,减少实际应用过程中运算及预警所需的时间,本节通过LDA模型实现词语的轻量过滤:如果一个词在LDA主题模型聚类词典中出现的次数少于10次或超过60 %,则在预处理过程中直接删除该词。

经大量测试实验发现,最佳的基础时间窗口大小为48~96小时。从原理上分析,如果采样时间过短,则主题内容的波动往往过大,导致预警的准确率急剧下降。如果采样时间过长,当前时间窗口内的数据变化将不再显著,同样会影响预警准确率。

本文将LDA模型进行文本成分分析时最佳的主题词数量设置为4~5。该数值范围的设置一方面是基于实验测试,另一方面可以由模型预警的原理进行分析:如果输出的主题数量过多(>10),就会导致语料整体语义的不一致性分散在不同的主题中,模型将难以灵敏地检测到两个时段中不同语料间的不一致性。另外,如果输出的主题数量过少(<4),两段语料的不一致性就会在极少的主题中被不合比例地放大,导致模型的误报率过高,同样影响预警模型的实际性能。基础时间窗口的采样数据量一般可以设置为1500(不超过2000)。如果采样数据量过大将会影响计算效率,从而大幅增加预警的时间消耗。

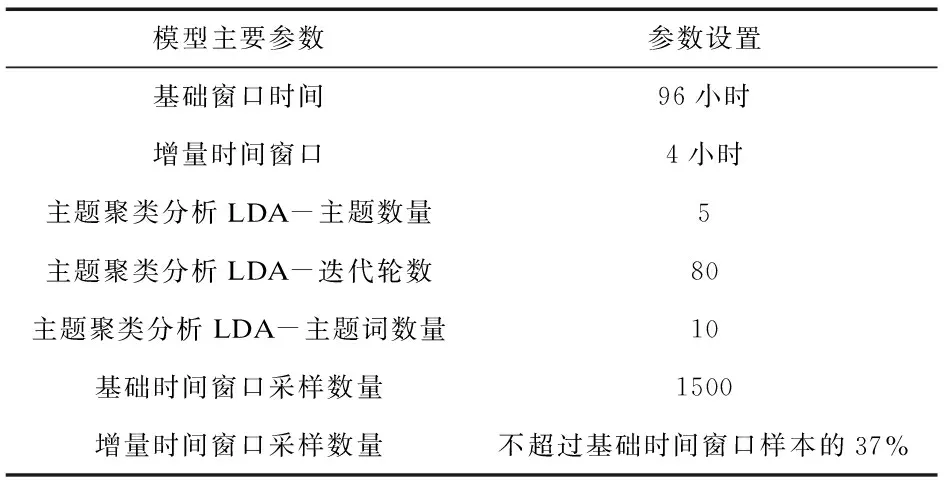

实验发现,为确保模型的有效性,增量时间窗口与基础时间窗口的采样比例应当不小于10%,不大于50%。因此本节将增量时间窗口的采样数据量设置为不超过基础时间窗口样本的37%。模型参数如表3所示。

表3 模型参数

3.2.2评价指标

本实验选择准确率作为评价指标之一,准确率可以定义为:

(13)

其中TP表示正确预测网络暴力舆情的预警次数,TN表示错误预测的预警次数。

另一个指标是覆盖率。覆盖率的含义是正确的预警覆盖了多少真实发生的事件,即有百分之多少的真实事件被正确地预报了。其计算公式如下:

(14)

其中,FP表示未被正确预测的网络暴力舆情的数量。

3.2.3网络暴力舆情的特征界定与有效预警界定

舆情事件内容热度变化基本符合正态分布假设,本节考虑到模型的灵敏性和通用性。本节提出了一种基于实际监测需求的网络暴力舆情的判别方法:如果某日该主题的发帖数量同时超过前两天任意一天发帖数量的2.5倍,则可以认为发生了网络暴力舆情。该判别标准还可以描述为:任意一天某主题的发帖数量相比于前两天任意一天的发帖数量增长率均超过了150%,则该主题所指向的舆情归类为突发网络暴力舆情。上述定义可以描述为:

ct=now>2.5×ct=now-△t∩ct=now>2.5×ct=now-2△t

(15)

其中ct=now表示当天在某一特定主题上的发帖数量。

该判别标准主要突出事件的突发性,即满足该标准的事件往往是讨论量突然激增的事件,符合对网络暴力舆情监测的要求。此外,在本文验证实验中,上述标准作为数据筛选的标准,所有验证数据还经过了人工进一步确认。

考虑到现实应用中,相关人员往往需要充足的时间和讨论以应对相关事态和作出有益的决定,因此一次有效预警信号发出的时间应当显著地早于网络暴力舆情的讨论热度到达最高点的时期。为有效检验本文模型的预警效率,在实验中将有效预警的标准界定为:高热度事件达到讨论峰值的当天12:00前36小时内发出预警信号即为有效预警。

3.3 实验结果

3.3.1模型预警结果

为了更好地展示相应主题的热度,图5、图6和图7中仅保留了表2中相应主题的热度折线,展示了网络暴力舆情的实际发生情况与模型发出预警的情况。需要说明的是,即便实验是在模拟场景下使用模型进行预警,但是模型进行预警时,仅能获取当前时间窗口的数据。因此模型的预警条件与真实应用场景无异。此外,网络暴力舆情的实际发生情况是基于当月的全量数据进行分析的,以确保对于事件发生时间和事件内容描述的准确性。

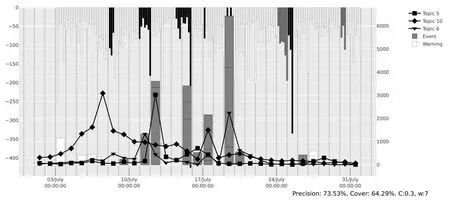

图5 2022年7月预警结果

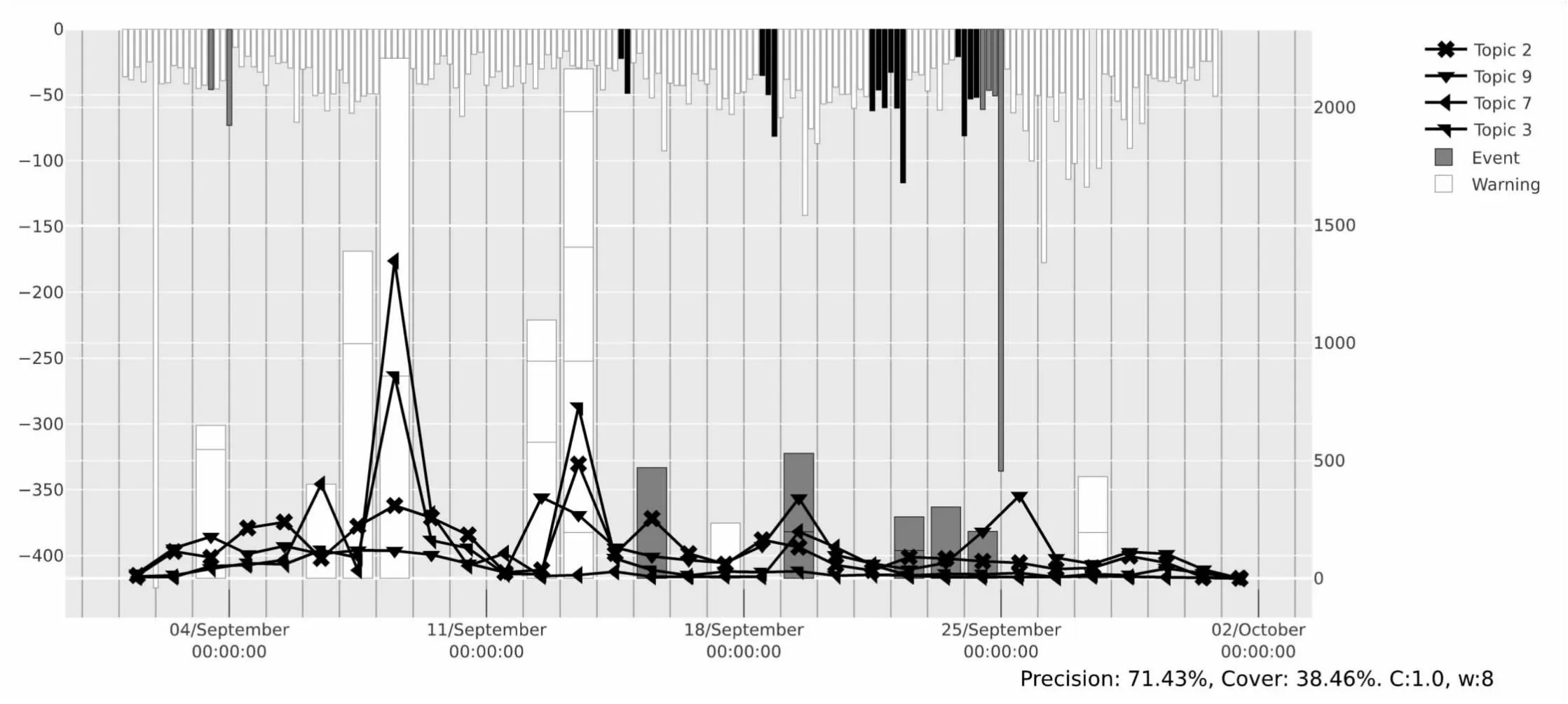

图7 2022年9月预警结果

首先,每张图片上方的柱状图为当月每4小时一次所计算的SI。为了更好地观察其变化趋势,取所有SI的相反数绘制成图。这意味着,对图中SI取绝对值才是真实的语义不一致性。其中白色条块表示该时段内的SI处于正常范围。而黑色条块表示该时段内的SI已被时序异常检测模块监测为异常值,模型发布预警,且在36小时内确实发生了网络暴力舆情,即有效预警。而灰色条块同样为时序异常检测模块检测为异常值,但是36小时内并没有发生网络暴力舆情,即错误预警。黑色区块越多,意味着模型预警的准确率越高。灰色区块越多,意味着模型的预警准确率越低。区块的高度代表该时段内SI数值。

然后是每张图片下方的柱状图。每一个条块意味着当天有网络暴力舆情的发生,其中有白色和灰色的条块。灰色条块即为模型成功预警的网络暴力舆情。白色条块为模型没有成功预警的舆情。而条块的高度表示着当天所发生的网络暴力舆情的讨论热度。

最后是每张图片下方的折线图。折线图为不同主题在每一天的发帖数量,与3.1节数据相同,详细的准确率和覆盖率数据汇总在表4中。

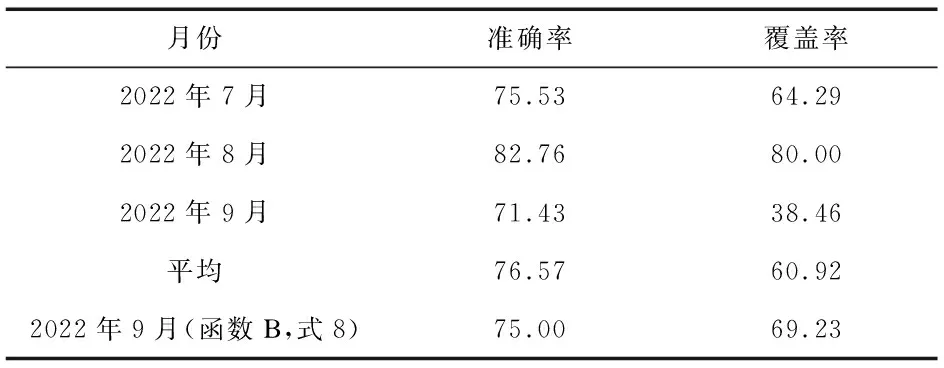

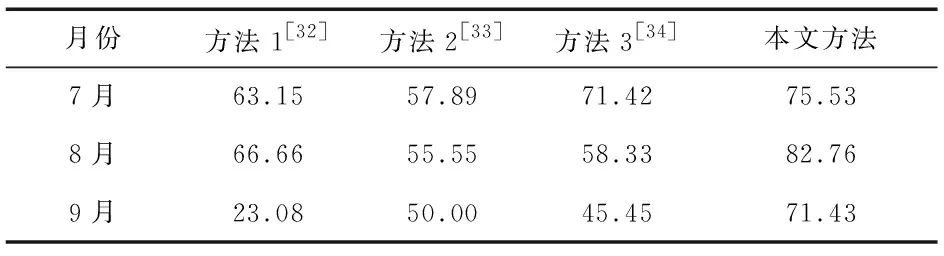

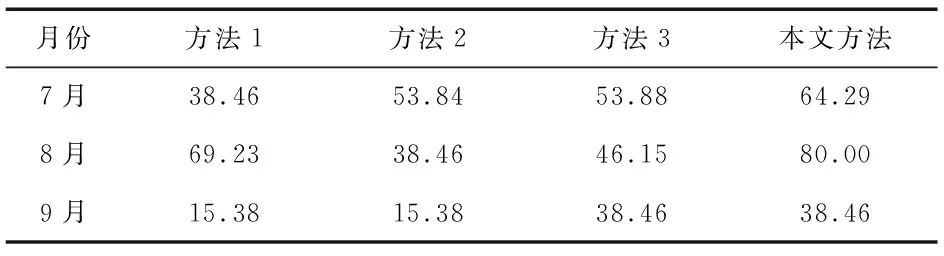

表4 准确率和覆盖率统计单位:%

3.3.2实验结果分析

从表4及图5—图7可以观察到,在长达92天的真实数据预测中,7月和8月的预测准确率和覆盖率均较高。模型在7月份准确预测了发生在7月10—7月24日之间的密集的高讨论度事件。模型在8月份的预警结果中表现出最高的准确率和覆盖率,除了8月16—24日之间的部分事件未能成功预测,其他的高讨论度事件均得到了很好的预测。在9月份,模型的预测准确度仍然比较高,但是模型的预测覆盖率大幅度下降,仅达到38%。经分析,可能是因为在9月份中存在部分主题(如图7中的Topic 10)持续保持较高的讨论热度,导致预测不准确。

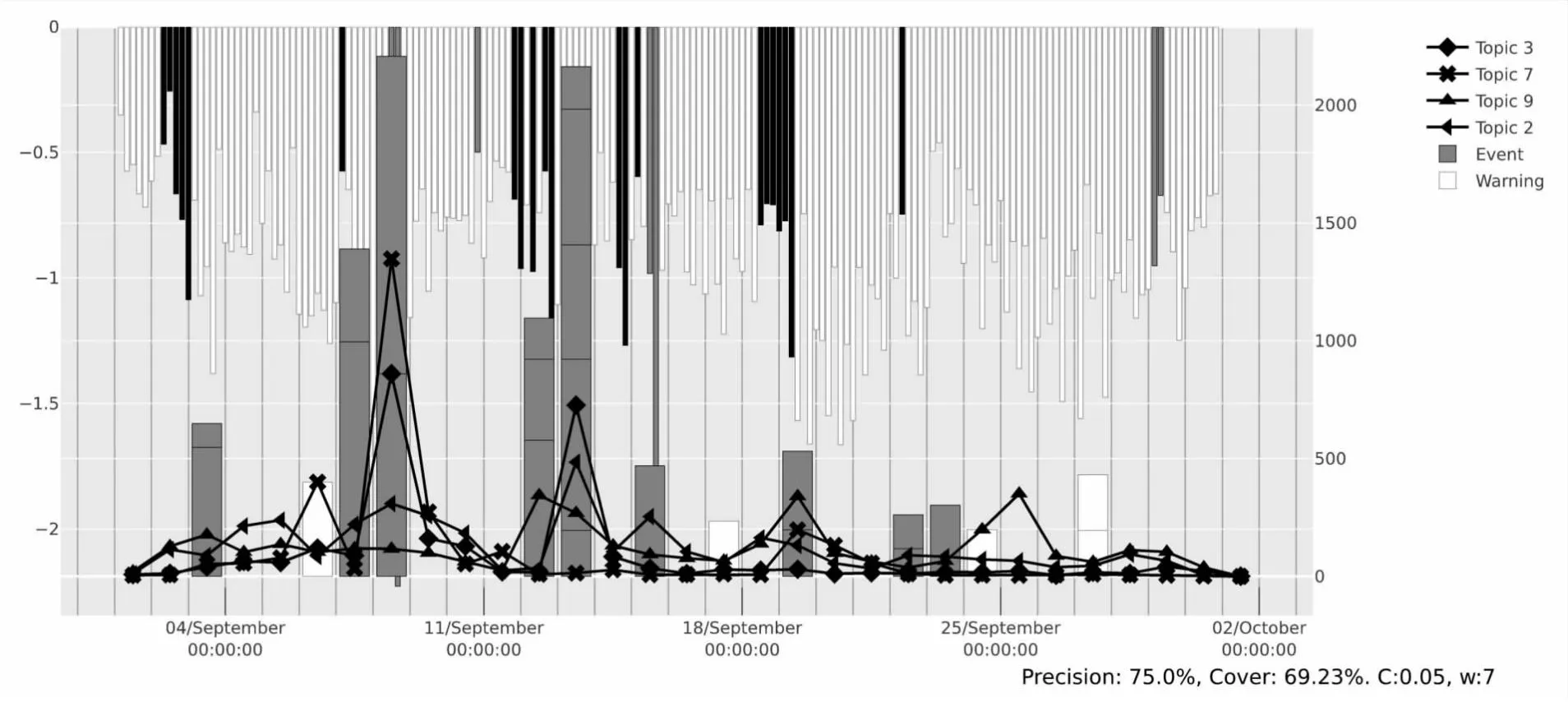

为此使用函数B重新对9月的数据进行另外的模拟预警实验,如图8所示。实验结果表明,使用函数B大幅度提升了预警模型在9月的预警效果,预警的准确率和覆盖率均得到了显著提升。在图7中可见原本使用函数A时无法准确预警的事件(9月4—11日之间)大多数在使用函数B时都得到了准确的预警。由此可见,函数B更加适合在有大量数据干扰的情形下进行准确预测。

图8 2022年9月函数B的预警结果

从实验数据来看,预警模型的整体覆盖率存在一定的波动,但就本文所采集的样本数据所进行的实验结果平均来看均能达到60%以上。通过仔细检阅未能覆盖的事件可以发现,未能覆盖且符合本文定义的、需要进行预警的网络舆情大多是早期事件的再次爆发或者反转内容。此时由于相关的主题信息已经存在于既往的时间窗口内,因此需要建立更加敏感的感应函数以探测极为细微的语义组织变化。总的来说,本文中所提到的“函数A”更适合监测事件刚开始的初期,“函数B”更适合监测已经发酵的事件是否存在突发反转或新的讨论点。此外,本文模型虽然未能达到绝对精准的预测预警精度,但可为“无先验知识预警”提供具备一定参考意义的实现方法。

3.3.3不同时序异常监测方法的比较

为了说明本文为语义不一致性所应用的时序异常监测方法具备相对的合理性,本文选取了三种主流无监督时序异常监测方法进行对比实验。表5和表6分别展示了包括本文方法在内的4种检测方法的准确率与覆盖率。其中方法1是基于时间窗口中位数波动的异常检测方法,方法2是基于时序数据广义方差的检测方法,方法3是基于自回归的异常监测方法。从表5和表6中的数据对比可见,本文方法在监测语义不一致性的异常方面具备较优越的性能。

表5 不同时序异常检测方法的准确率比较 单位:%

表6 不同时序异常检测方法的覆盖率比较 单位:%

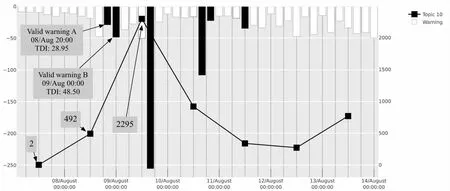

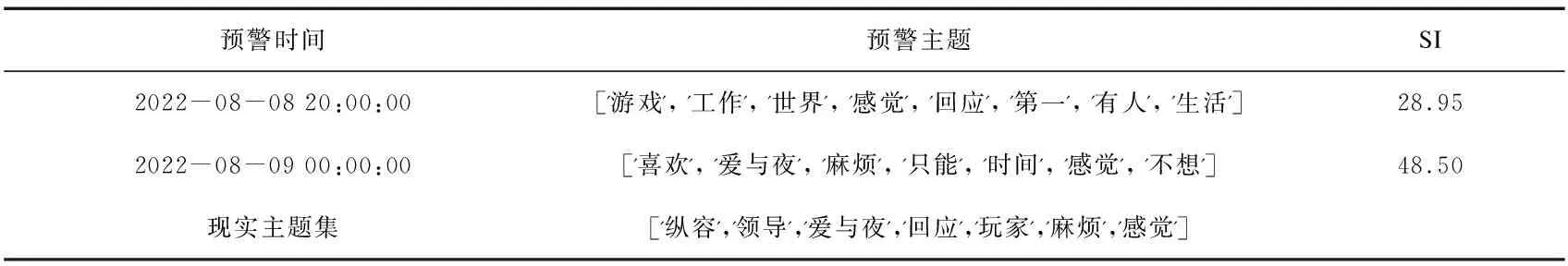

3.3.4预警案例研究为了展示本文预警模型对于网络暴力内容主题的预警能力,将展示2022年8月9日达到讨论最高峰的网络暴力舆情。该舆情的主题已经在表2中第6行展示,即8月的“Topic 10”《光与夜之恋》游戏官方运营的玩家社区被指责纵容社区中的网络暴力行为。

在图9所示的细节放大图中,描述了主题“Topic 10”的相关内容在8月7—14日一周之内的热度。折线图表示关于该特定主题的帖子数量,条形图则显示预警模型输出的SI数值。其中黑色的条块是对网络暴力舆情的成功预警,灰色条块代表该时段内模型未预警且没有网络暴力舆情发生。出于分析的目的,仅对图5中的相关主题进行说明。

图9 2022年8月9日爆发的网络暴力舆情

从图9中可以观察到,在8月7日时仅有两条相关的讨论。而在8月8日时相关讨论已经迅速增长到492条。最后在8月9日达到最高峰,采集数据达到了2295条。此后逐渐减弱,略有波动。

如表7所示,模型共有两次相关的预警,分别是图9中箭头所指的预警A和预警B。两次预警都成功输出了与所选事件相关的关键词。其中,加粗的关键词代表与所选事件成功匹配的关键词。对比实际的“Topic 10”内容可见,本文模型不仅可以对是否将要发生网络暴力舆情进行预警,还能够输出相关的主题关键词,为实际的预警监测与干预提供进一步的支撑。

表7 预警案例

4 结 语

互联网中的网络暴力内容正随着社交媒体的深度渗透而广泛存在且极易造成恶劣影响,但目前对于网络暴力舆情的预警仍然较为困难。因而本文提出了基于语义不一致性的网络暴力舆情预警模型。本文使用微博真实数据进行了长时间、大窗口的现实仿真实验与突发事件模拟预警。在长达92天的现实世界真实数据中,模型对网络暴力舆情的预测取得了较高的准确率和覆盖率。希望本文能够激发更多关于开发有效的网络暴力预警系统的研究,为创造一个更安全、更和谐的网络环境做出贡献。此外,模型所具备的“早期预警”特性和输出主题词的预警方法在一定程度上能够溯源重大网络舆情传播的起点,为相关工作人员提供指引,以及时关注实际应用中引发舆情的事实与缘由。