多尺度信息交互与融合的乳腺病理图像分类

丁维龙,朱峰龙,郑魁,贾秀鹏

1.浙江工业大学计算机科学技术学院,杭州 310023;2.上海派影医疗科技有限公司,上海 201306;3.宁波市临床病理诊断中心,宁波 315031

0 引言

乳腺癌是我国女性最常见的恶性肿瘤之一,在所有癌症中占比高达11.7%(Sung 等,2021;Xie 等,2021),同时也是全球女性死亡率最高的癌症之一(满芮 等,2020)。组织病理学检查是乳腺癌诊断的“金标准”(金旭 等,2020;颜锐 等,2021;徐贵璇 等,2021),其准确性和及时性直接影响患者治疗方案的选择和预后。一般地,组织病理学诊断流程是病理医生先在显微镜下对病理切片进行细致检查(称为镜检),而后给出癌症分级和分期。这种人工阅片方式需要医生对每一幅图像进行审阅,耗时耗力。由于不同医生的专业知识和临床经验不同,其个人主观性会影响最终的诊断结果。截至2018 年末,我国在册的病理医生(包括执业医师和助理执业医师)为1.8 万人,病理医生的缺口至少为6.6 万人(卞修武和平轶芳,2019),我国各级医院病理医师人数均显著低于原卫生部制定的要求(每100 张床至少配备1~2 名病理医师)。面对上述问题,迫切需要开发客观且精确的计算机辅助诊断系统来帮助病理医生进行诊断,识别癌症区域和癌症类型。

随着扫描技术的发展,病理切片可以数字化为全切片扫描图像(whole slide image,WSI)。病理专家无需借助显微镜在病理切片上费时费力地搜索癌变区域,而是直接通过电脑屏幕快速便捷地查看和分析病理图像。计算病理学的出现促进了计算机辅助诊断的发展。国内外已有诸多学者对乳腺病理图像自动分类展开研究,并取得了一定的进展。这些研究主要可以分为两类(颜锐 等,2021):1)基于人工特征提取结合传统机器学习的方法;2)基于深度学习的方法。对于机器学习的方法,Zhang 等人(2014)提出一种基于单类核主成分分析(kernel principal component analysis,KPCA)模型集成的医学图像分类方法,采用乘积组合规则集成多个KPCA模型,以产生分类置信度分数。王帅等人(2018)提出基于二次聚类与随机森林的腺管自动识别方法,通过一次聚类和二次聚类构建出待分割图像,最后使用随机森林分类算法进行分类。Ed-daoudy 和Malmi(2020)使用关联规则将特征空间维数由9 个降为8 个,然后输入到多个支持向量机中对乳腺癌进行分类。上述方法采用人工特征提取,不仅需要病理医生专业知识的支撑,整个过程耗时耗力且主观性强,往往存在特征空间小、泛化能力不强等缺陷。

基于深度学习的乳腺组织病理图像分类方法可以从数据中自动学习图像的高维特征,从而推动自身在医学图像的应用(Litjens 等,2017;Campanella等,2019;Senousy 等,2022;赵樱莉 等,2023)。现有的一些方法(Yu 等,2023;Zheng 等,2020;Wang 等,2016;Vesal 等,2018;Alom 等,2019;赵晓平 等,2023;Chhipa 等,2023)均采用单一倍率下的图像作为神经网络的输入(本文将其称为单尺度网络),忽略了相邻patch 之间的相关性。这可能会带来两个问题:1)乳腺组织病理图像中特定的结构被裁剪为多个部分,分布在相邻的patch 中,降低了patch 的特征表示能力;2)只使用高倍率下的图像,忽略其他倍率的图像,可能会丢失有用的信息。

为解决这些问题,Kang和Chun(2022)采用多尺度课程式学习策略来提高模型的准确率。然而,该方法并没有对模型进行改进,只是将不同分辨率下的图像组合成一个数据集训练网络。此外,Tong 等人(2019)利用WSI内置的图像金字塔结构来融合低倍率图像的上下文信息,以增强patch 的预测能力。Xie 等人(2021)提出一种基于ResNet50 的多尺度卷积网络。通过同时输入40× 和10× 放大倍率的图像,然后合并不同尺度的特征。Chen 等人(2022)提出一个多尺度模型,提取全局和局部信息用于胃组织病理学图像检测。上述实验结果表明,采用多尺度策略的神经网络的性能明显优于单尺度网络。但上述多尺度方法多是将不同倍率的图像输入网络模型,经过多层卷积层运算之后对提取到的不同特征进行拼接。这种特征融合方式较为简单,没有区分不同尺度图像特征之间存在的感受野上的差异。此外,在特征融合之前,模型对不同尺度的图像进行单独提取纹理、颜色等特征,并没有考虑不同尺度图像之间可能存在的关联性。

针对上述问题,本文提出一种基于多尺度和注意力机制的卷积神经网络改进策略,并应用于DenseNet 网络,提高了乳腺病理图像分类性能。本文的创新之处包括:1)设计信息交互模块,加强不同尺度的图像之间的联系,实现不同尺度的特征相互监督和引导;2)设计特征融合模块,对不同尺度的图像的特征有所侧重,并通过提出的分组注意力结合通道注意力来提高模型的特征提取能力和泛化能力。本文在公开数据集Camelyon16 上进行了实验。实验结果表明本文方法能有效提高乳腺组织病理图像的分类精度,为今后组织病理图像在多尺度网络方面的研究提供了重要参考。

1 方法

本文基于DenseNet(dense convolutional network)(Huang 等,2017)提出一种结合多尺度和注意力机制的卷积神经网络模型MA-DenseNet(multiscale and group attention dense convolutional network)。该模型能够接受多种尺度的图像作为输入,并在特征提取阶段加强不同尺度的特征之间的交互,以起到相互引导的作用,使得模型能够从多种倍率的图像中,提取到与分类任务相关的特征,进而提高模型的性能。此外,该模型在特征融合阶段,充分考虑不同尺度的特征的重要性程度,使用分组空间注意力机制和通道注意力机制对特征赋予权重,从而区分不同区域和通道的特征对乳腺癌组织病理图像分类任务的贡献度。

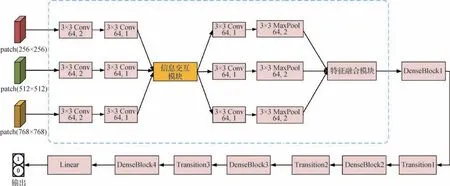

由于WSI 的尺寸较大(一般为40 000×40 000像素)(Wang 等,2022),受限于硬件条件(Ciga 等,2021),现阶段即使是对WSI进行下采样也需要对其进行滑动窗口处理才能输入到网络模型中。并且,下采样意味着分辨率的降低,会丢失大部分的细节信息,因而研究者往往将WSI 切割成尺度更小的patch(Lu等,2021;Gao等,2023)作为分类目标,尺寸一般为256×256 像素或512×512 像素。考虑到本文提出的多尺度网络需要不同倍率下的图像作为输入,因此,采用同一中心点对同一幅WSI图像切割出3 种尺度的patch,其尺寸分别为256×256 像素、512×512 像素、768×768 像素(下文分别记做256尺度、512 尺度和768 尺度)。根据下文的对比实验结果可以发现,20× 倍率下裁剪的512×512 像素的patch,作为单尺度网络的输入时所得到的分类性能较好。因此,在3个尺度中本文使用512尺度作为分类目标,模型所对应的标签使用512 尺度的标签。通过该切割方式,可以在对512×512 像素的patch进行分类时,融合从高倍率的patch(256×256 像素)和低倍率的patch(768×768像素)中提取的特征,达到充分考虑其上下文信息的目的。本文方法的网络结构如图1 所示,主要包括:1)信息交互模块,用于增强多种尺度的特征之间的联系;2)特征融合模块,用于区分不同尺度的特征的重要性程度。考虑到现有网络多采用模块化设计以提高模型的深度,其结构一般由一个卷积和池化组成的Stem 部分和多个特定的Layer 组成,如:ResNet 是以残差块的叠加形成一个Layer,而ViT(vision Transformer)则是通过多头自注意力和多层感知机的堆叠形成一个Layer。为了保证多尺度策略的通用性,将Stem 和第1 个Layer作为插入位置,然后根据信息交互模块和特征融合模块的插入位置不同,分为浅层插入方式和深层插入方式,对应的模型称为浅层多尺度(图1)和深层多尺度(图2)。

图1 浅层多尺度网络结构Fig.1 Shallow multiscale network structure

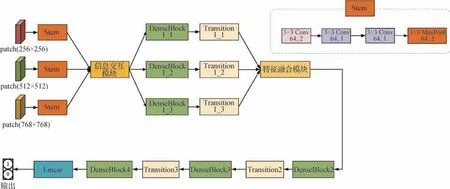

图2 深层多尺度网络结构Fig.2 Deep multi-scale network structure

图1 中,“3×3 Conv 64,/2”表示卷积核的大小为3×3,卷积核的数量为64,步长为2;“3×3Conv 64,1”表示卷积核的大小为3×3,卷积核的数量为64,步长为1;信息交互模块和特征融合模块将在下文进行详细描述;“3×3 MaxPool 64,/2”表示最大池化,池化核大小为3×3、步长为2;DenseBlock 表示DenseNet 网络中的密集连接块,总共有4 个;Transition 表示DenseNet 中的降通道模块,总共有3 个;Linear 表示全连接层,输出为网络模型对每个类别的预测概率。

图2 中,Stem 表示网络主干的头部,在原始DenseNet 中,Stem 主要包括一个步长为2 的7×7 卷积核以及最大池化操作,本文将其改成3 个3×3 级联,在保证感受野大小相同的情况下,减少模型的参数,并提高非线性泛化能力。与浅层多尺度的区别包括:1)信息交互模块放到Stem 之后,而不是放在两个卷积操作之后,同时将特征融合模块放到DenseNet 的第1 个Transition 模块之后,相对于放在DenseBlock1_1之后能够减少近一半的计算量。

1.1 信息交互模块

以往关于多尺度网络的研究中,不同尺度的图像特征在融合之前均是单独计算,容易丢失多尺度特征之间的关联性,从而导致特征的利用率低。为解决这个问题,本文提出的信息交互模块在特征融合之前进行基于空间注意力机制的加权信息交互,能够加强3种尺度输入之间的联系,使得256尺度和768 尺度中与512 尺度相关的局部信息获得更大的权重。考虑到256 尺度和768 尺度对于512 尺度的重要性程度不相同,本文使用加权特征融合的方式,将256 尺度和768 尺度乘以其相应的权重,再与512尺度的特征进行融合,然后反馈给256尺度和768尺度,引导这两个分支对相关特征施以更大的关注。该模块结构如图3 所示。具体步骤为:1)将256×256像素、512×512像素、768×768像素的输入图像经过卷积运算之后,分别记做finfo_256,finfo_512,finfo_768;2)使用空间注意力机制对finfo_256和finfo_768中与finfo_512相关的区域赋予更大的权重,计算结果记做finfo_256_spatial和finfo_768_spatial,然后乘以对应权重值,再与finfo_512进行逐元素相加,结果记做;3)将分别与finfo_256_spatial和finfo_768_spatial按通道维度进行拼接,并通过动态尺度选择模块(Feng 等,2020)选择两个尺度中重要的区域,促使256尺度和768尺度的分支关注与512尺度相关的特征信息。

图3 信息交互模块结构图Fig.3 Structure diagram of information interaction module

图3 和图4 中,Conv 表示卷积层,⊗表示逐元素相乘,⊕表示逐元素相加,a和b分别表示赋予给256 尺度,768 尺度的patch 的权重,用以区分不同尺度对于512 尺度的重要性,这两个权重是可训练参数,在模型的反向传播过程中会自动调整。对于256 尺度和768 尺度的特征图中与512 尺度相关的区域,本文采用空间注意力机制(Woo等,2018)赋予其更高的权重。空间注意力机制的结构如图5所示。

图4 动态尺度选择模块Fig.4 Dynamic scale selection module

图5 空间注意力机制Fig.5 Spatial attention mechanism

图5 中,输入特征记做F,维度为(B,C,H,W),按通道维度进行最大池化和平均池化操作,得到Fmax,Favg,维度均为(B,1,H,W);然后,将Fmax、Favg按通道维度进行拼接,得到Fpool,维度为(B,2,H,W);再将Fpool经过卷积运算并激活,得到权重张量,维度为(B,1,H,W);最后将原始特征F与权重张量逐元素相乘,并加上F后进行激活,得到最终输出特征Fs。具体表示式为

式中,Conv3×3表示卷积核大小为3×3,步长为1,padding 为1 的卷积操作;Concat表示将Favg和Fmax按通道维度拼接,σ表示sigmoid激活函数。

1.2 多尺度特征融合模块

一般地,多尺度网络是直接将多种尺度的输入所获得的特征直接按维度进行拼接,不同尺度的输入具有相同的权重,没有关注最终要进行分类的patch。这有可能会造成下述问题:对多个尺度的图像输入在卷积之后进行简单融合,容易引入和分类目标无关的特征以及对特征的利用率较低等问题。比如将512尺度的标签作为真实标签时,768尺度的图像能够提供更丰富的上下文信息,但不能保证所有的区域都与512 尺度的标签一致。直接将不同尺度的特征相加会引入较多噪声。同样地,在更高的放大倍率下获取到的256 尺度图像,拥有清晰的细胞形态结构,如果没有对最终分类目标相关的形态特征赋予更大的权重,则会造成特征利用率降低。

针对上述问题,本文提出基于分组注意力的多尺度特征融合模块。考虑到多种尺度的图像之间存在感受野的差异,利用空洞卷积实现网络内部的多尺度模块。通过以上步骤,能够较好地提高多尺度网络在特征融合过程中的特征提取能力。本文提出的基于分组注意力的特征融合模块结构如图6 所示。图6 中,1×1 Conv 表示卷积核大小为1×1,主要的作用有两个方面:1)降低通道数,从而减少计算量;2)让所有通道特征建立联系。3×3 Conv表示卷积核大小为3×3,dilation=2 表示空洞卷积的膨胀系数是2(3×3 的卷积核,在dilation=2 时,其所对应的感受野为5×5)。

图6 特征融合模块Fig.6 Feature fusion module

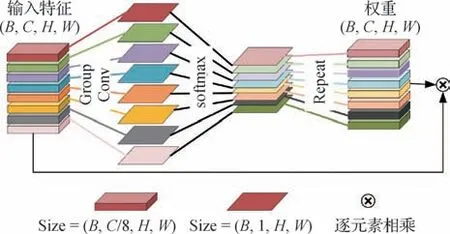

本文提出的分组空间注意力是通过分组卷积的方式,将特征图分为8 组,每组计算一个权重,从而保证更多特征得到激活,其结构如图7所示。Concat表示将3 种尺度的特征图按照通道维度进行拼接。由于Concat 操作会使得通道数翻倍,本文采用通道注意力机制区分不同特征通道的重要性程度,然后增强与任务相关的特征通道并抑制无关的特征通道,对应的结构如图8所示。本文考虑到512尺度的感受野是256 尺度的两倍,768 尺度是256 尺度的3 倍,当把3 种尺度的图像按通道维度拼接之后,存在特征图的感受野不一致问题。因此,本文采用空洞卷积的方式,构建了网络内部的多尺度模块。

图7 分组注意力机制Fig.7 Grouped attention mechanism

图8 通道注意力Fig.8 Channel attention

图7中,Group Conv表示分组卷积,相比于传统卷积操作,分组卷积能有效减少参数量和计算量,并具有一定的正则化作用。softmax表示对分组卷积的结果,按通道维度计算每组的权重向量。具体为

Repeat 表示将经过softmax 的权重进行扩张,每一个通道复制8 次,从而让原始特征图能够与注意力权重逐元素相乘。

图8中,输入的特征先经过全局平均池化和全局最大池化,将特征图的宽高变为1×1。随后池化结果经过全连接层FC1,降低通道数,r在本文中设置为8。然后,将结果通过ReLU(rectified linear unit)函数激活,再经过一层全连接层计算,将通道数恢复到C。最后,将两种池化结果相加并使用sigmoid 函数激活后,与原始特征进行逐元素相乘得到输出特征。

2 实验及结果

2.1 数据集介绍

本文在公开数据集Camelyon16(Bejnordi 等,2017)上进行实验,该数据集中的乳腺组织病理图像由the Radboud University Medical Center(Nijmegen,the Netherlands)和the University Medical Center Utrecht(Utrecht,the Netherlands)提供,均由苏木精—伊红染色。对于患有癌症的乳腺组织病理图像,该数据集提供了由专业的病理医生进行的像素级标注,标注信息以XML(extensible markup language)格式保存。本文为保证无癌(阴性)和有癌(阳性)的乳腺组织病理图像在数量上一致,将训练集的111幅有癌图像和测试集中的48 幅有癌图像进行整合,然后和训练集中的159 幅无癌图像形成新的数据集。本文在这318 幅乳腺组织病理图像上以滑动窗口切割的方式,裁剪出固定数量的patch,并划分为5 个部分,进行五折交叉验证实验,具体的数据分布如表1所示。

表1 五折交叉验证数据集分布Table 1 Distribution of 5-fold cross-validation dataset

2.2 数据集处理

由于乳腺组织病理图像的尺寸较大,Camelyon16数据集的平均图像大小为1.4 GB左右,图像的放大倍率为40 倍,每个像素点所代表的实际距离约为0.243 μm。受限于目前算力,卷积神经网络的输入一般为224×224 像素、256×256 像素、384×384 像素,因此需要对乳腺组织病理图像进行切割,获得能够输入到卷积神经网络中进行训练的图像块。此外,乳腺组织病理图像一般是由样本切片通过光学数字扫描仪获得的,包含大部分白色背景区域,需要对其进行去除以降低模型的计算量。具体有以下几个处理步骤:1)本文采用最大类间方差法(Otsu,1979)对乳腺组织病理图像进行阈值分割;2)在分割得到的掩码图像上以滑动窗口的方式选取patch 的中心坐标点;3)根据坐标点在原图上切割3 种尺度的patch,大小分别为256×256 像素、512×512 像素和768×768 像素;4)考虑到不同乳腺组织病理图像在制片过程中存在颜色差异,本文采用Reinhard(Reinhard 等,2001)方法,在保证组织结构不变的前提下,将原图像的颜色分布转换到目标图像上,保证不同图像的颜色一致性。

深度学习的性能与样本的数量有关,为了提高模型的泛化能力,本文采用数据增强方法,主要包括水平翻转、垂直翻转和旋转等操作。本文设计的是多尺度神经网络,对于同一中心点裁剪的不同尺度的patch要进行相同的数据增强操作。鉴于此,先将3 种数据增强的方式进行随机组合,根据产生的两个随机数是否大于0.5 来分别决定是否水平翻转和垂直翻转操作。同时,为了避免旋转操作可能带来的组织缺失问题,本文设定旋转角度为0°、90°、180°、270°,保证在旋转过程中不会引入空白区域,如图9 所示。最后,本文将随机组合的图像增强方法同时应用到不同尺度的图像上,如图10 所示,对不同尺度进行了图像增强操作的组合,包括水平翻转、垂直翻转和逆时针旋转270°。

图9 不同旋转角度对比图Fig.9 Comparison chart of different rotation angles map((a)original image;(b)rotation by 90°;(c)rotation by 180°;(d)rotation by 270°;(e)rotation by 50°)

图10 数据增强方式组合图Fig.10 Data augmentation method combination map((a)original 256 image;(b)transformed 256 image;(c)transformed 512 image;(d)transformed 768 image)

通过对输入的数据进行批归一化操作能够加快模型的收敛速度。本文并未使用随机的均值和标准差或是在ImageNet(Deng 等,2009)数据集上计算出的均值和标准差,来进行批归一化操作,而是在训练集上随机选取10 000 张patch,计算经过图像增强之后的均值和标准差作为批归一化参数。此外,无论是多输入网络还是单输入网络,在没有特别说明的情况下,本文都是将图像变换为224×224 像素,目的是为了适应网络的输入尺寸。

2.3 实验设置

本实验硬件环境为Inteli9-10940xCPU,两张3080Ti 显卡,单张显卡的显存为12 GB,操作系统版本为Ubuntu18.04。本文网络模型基于Pytorch 深度学习框架实现,Pytorch 版本为1.10。本文在模型训练中使用SGD(stochastic gradient descent)优化器(Loshchilov 和Hutter,2016),并设定初始学习率为0.01,权重衰减系数为0.000 3,动量系数momentum为0.9,模型的数据批次大小为32,在训练过程中使用ReduceLROnPlateau 作为学习率调整策略。对于五折交叉验证实验中的每一个实验,设定网络模型的训练批次为60 次,然后将5 个实验的结果在多个指标上计算平均值以及标准差,来客观评估模型的性能。本文采用准确率(Hossin 和Sulaiman,2015)、精确率、召回率、F1-score 以及AUC(area under curve)共5个评价指标,对乳腺组织病理图像识别模型进行评估。

2.4 实验结果

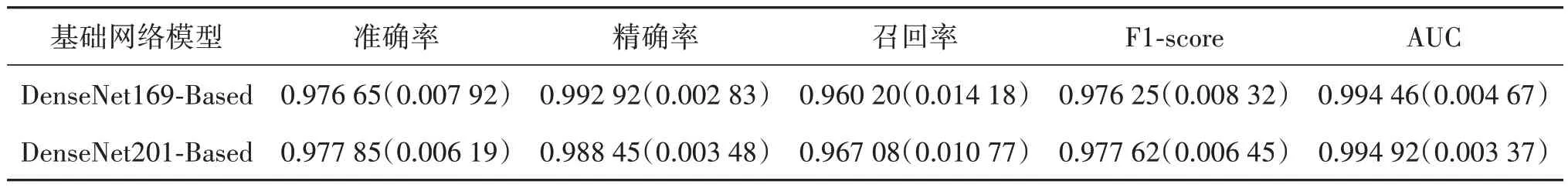

2.4.1 通用性实验

本文所提出的信息交互和特征融合模块是一种通用策略,能够让单尺度网络结构转变为多尺度网络,模拟病理专家在显微镜下多倍率观察病理切片的过程。为了验证本文模块的通用性,并且选取出更合适的网络结构,在多种主流的主干网络上进行实验,将本文所提出的两个模块加入到主干网络中,并采用上文提出的评价指标评判网络性能。首先针对浅层多尺度网络进行实验,结果如表2 所示,括号内的数值表示五折交叉实验中各项指标的标准差,括号外的数值表示五折交叉实验的平均值。从表2 可以发现,带有密集连接的DenseNet 网络结构在各项评价指标上具有较好的表现,在五折交叉实验中,基于DenseNet201 实现的多尺度网络在准确率、召回率、F1-score 和AUC 指标上都领先于其他主干网络。因为密集连接能够让浅层的特征随着网络深度的递进,传递给深层的网络,对于组织病理图像而言,能较好地保留浅层特征,如细胞形态、颜色和纹理特征等,使最终用于分类的特征更丰富。而SEResNet 虽然同时具备残差结构以及压缩激励模块,表现却低于ResNet50,可能是因为多层的压缩激励模块在识别细胞形态时关注了错误的特征,即对于无关的特征赋予更大的权重。

表2 不同基础网络的实验结果Table 2 Experimental results of different base networks

从表2 还可以发现,基于SEResNet50 实现的多尺度网络在各项评价指标中的标准差较大,表明该网络的稳定性较差,在5 个测试集中各项评价指标有较大波动。此外,为了验证深层多尺度网络和浅层多尺度网络的性能差异,本文对表2 中各项评价指标都较好的DenseNet 网络结构进一步实验,结果如表3 所示。可以发现,随着信息交互模块和特征融合模块插入位置的改变,在网络深层部分能够发挥更大的效果,取得比浅层多尺度更优异的性能。由于深层插入方式相对于浅层插入方式会增加网络的参数量和计算量,对本文使用到的网络模型进行相应数据的统计,结果如表4 所示。基于DenseNet169 的深层多尺度网络性能在参数量与浮点数计算次数上与浅层插入方式的DenseNet201 较为接近,但在各项评价指标上均优于后者。这表明本文所提多尺度策略在基于深层插入方式时,能够进一步提高模型的识别性能。在后续实验中,本文都将采用DenseNet201 作为多尺度改进的基础网络,并使用深层多尺度的插入策略。

表3 深层多尺度的实验结果Table 3 Experimental results of deep multi-scale

表4 网络模型的参数量与计算量统计表Table 4 Statistics on the number of parameters and computation of the network model

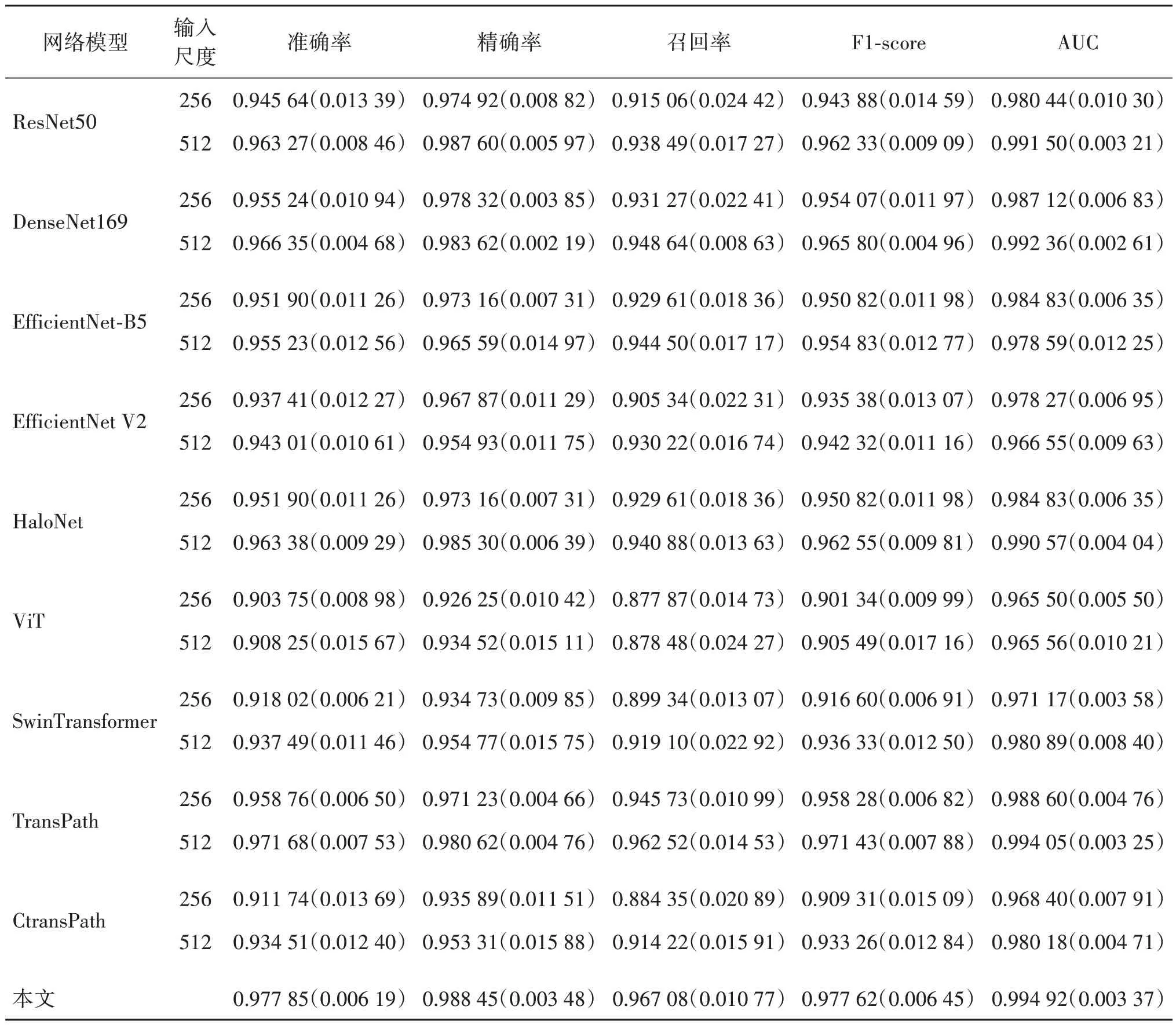

2.4.2 对比实验

为了验证所改进的网络结构的有效性,本文将所提出的多尺度网络模型和主流的卷积网络模型进行对比实验以及与Transformer网络模型进行对比实验,包括ResNet(He 等,2016)、DenseNet(Huang 等,2017)、EfficientNetV2(Tan 和Le,2021)、HaloNet(Vaswani 等,2021)、ViT(Dosovitskiy 等,2020)和TransPath(Wang 等,2021)。考虑到本文网络包含多个尺度的输入,为了实验结果的准确性,对于上述单尺度网络,分别在256尺度和512尺度进行实验。在图像输入到网络中进行之前,对图像进行上文提到的数据增强以及归一化操作,并调整图像大小为224×224 像素。HaloNet 网络由于具备局部自注意力机制,需要输入大小为8 的倍数,所以对应的图像输入调整为256×256像素。最终的实验结果如表5所示,所有评价指标均在5-fold 实验下计算平均值以及标准差。从单尺度网络的实验结果中可以发现,以512 尺度作为输入的网络,其各项评价指标都优于以256 尺度作为输入的网络,这也是上文选取512 尺度作为多尺度网络分类目标的原因。在单尺度网络中,ViT 模型的各项指标较低,这可能是因为ViT是将一张patch划分为多个小块,然后进行编码,使得每个小块对应一个一维向量。这个过程中可能导致同一性质的区域被分割开,并且ViT 相对于卷积神经网络来说存在训练困难的缺点,以上因素导致了本文中ViT 在patch 分类上的性能表现较差。在所有单尺度网络模型中,取得最好性能的是TransPath,该网络模型是Wang 等人(2021)通过将ResNetV2 和ViT 进行结合得到的,相较于ResNet50有接近0.8%的提升,在AUC和F1-score这两个评价指标上也优于其他的单尺度网络模型。本文提出的多尺度网络模型与TransPath 相比,在5 折交叉实验结果中,各项指标都有明显提升,其中AUC 达到了0.994 92,准确率达到了97.785%,精确率达到了98.845%,并且从各项评价指标的标准差中可以看出,本文所提出的方法稳定性优于其他方法。同时,本文采用纯卷积结构,与ViT 以及TransPath 相比具备训练简单和收敛速度快的优点(Liu等,2022)。

表5 对比实验结果Table 5 Results of comparative experimets

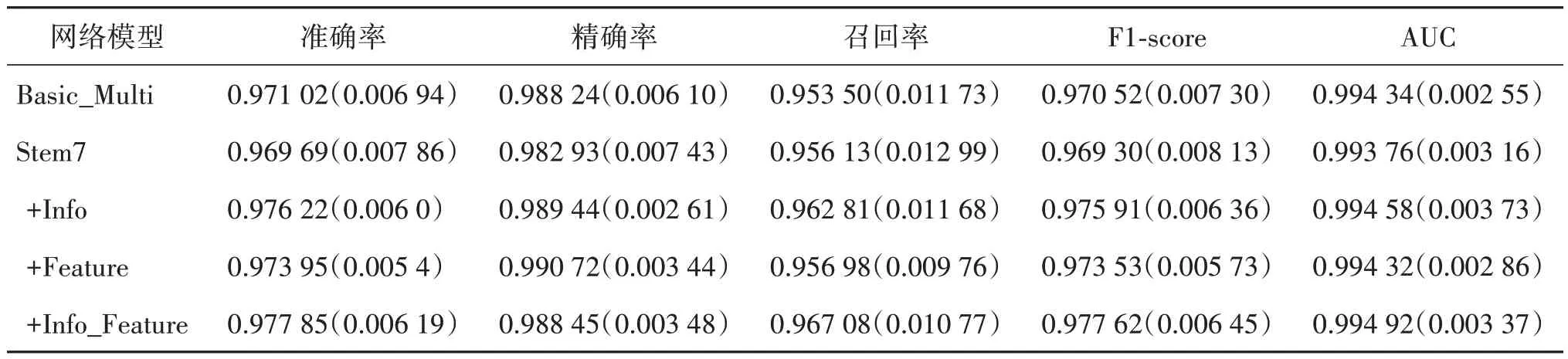

2.4.3 消融实验

为了验证本文提出的信息交互模块和特征融合模块的有效性,对各模块进行了消融实验。主要包含:1)一般多尺度模型,记做Basic_Multi,不包含信息交互模块和特征融合模块,并且采用全局平均池化的方式对卷积之后的特征图进行融合,这也是现有多尺度研究普遍采用的策略;2)在一般多尺度模型的基础上,使用原始的7×7大小的卷积核组成网络的Stem部分,记做Stem7;3)在Basic_Multi基础上添加了信息交互模块的多尺度模型,记做+Info;4)在Basic_Multi基础上添加了特征融合模块的多尺度模型,记做+Feature;5)在Basic_Multi 基础上同时添加信息交互模块和特征融合模块,即完整的多尺度网络模型,记做+Info_Feature。所有消融实验均在五折交叉验证实验下进行,并对每个评价指标取均值,并计算对应的标准差。实验结果如表6 所示,从表中可以看出,使用3 个3×3 卷积核来替换7×7卷积核,在保证感受野相同的条件下,对模型的性能能够起到较小幅度的提升,同时可以发现普通的多尺度网络得到的准确率等指标接近上文对比实验中的TransPath 网络。这表明在乳腺组织病理图像分类问题中,通过模拟病理专家在多倍率下诊断的流程,可以提高网络性能。通过在一般多尺度网络中加入信息交互模块(+Info),利用空间注意力机制从256 尺度和768 尺度中捕获与512 尺度关联密切的区域,使得网络模型的各项评价指标有较大提升,准确率达到97.622%,并且在五折交叉验证实验中,各项结果的标准差小于一般多尺度网络,表明其具有较好的稳定性。本文提出的基于分组空间注意力的融合策略(+Feature)可以减少一般空间注意力的特征激活不充分问题,特征金字塔结构能够缓解不同尺度图像之间的感受野差距问题,网络性能比一般多尺度网络有一定的提升。值得注意的是,从+Info和+Feature 两组实验对比结果可以得出,信息交互模块对于多尺度的性能影响比特征融合模块大,进一步验证了本文的思想:多尺度网络需要在特征融合前进行不同分支的特征流通与引导。本文将两个模块结合得到的网络在多项指标上都优于一般多尺度网络,并且也高于添加单一模块的性能,其精确率和召回率之间具有更好的平衡性,F1-score 达到97.762%。

表6 消融实验结果Table 6 Results of ablation experiments

3 讨论

通过在卷积神经网络,如ResNet、SEResNet 和DenseNet中加入本文提出的多尺度策略能有效提升模型的性能,相对于一般多尺度模型也有一定的提升。

目前大部分的乳腺癌病理图像分类研究采用的是单尺度网络,其中Wang 等人(2021)提出的Trans-Path 模型将卷积神经网络与ViT 进行结合,取得了97.168%的分类准确率,在单尺度网络模型中取得了SOTA(state-of-the-art)表现,而本文采用一般多尺度改进策略(Tong 等,2019;Xie 等,2021),将单尺度DenseNet201 转换成多尺度DenseNet 后,取得了97.102%的准确率,在其余各项指标上也与Trans-Path相接近。这表明通过多尺度网络来模拟病理专家在不同倍率下观察及诊断切片是可行的,具备良好的解释性和应用前景。一般多尺度策略中存在诸多问题,比如:1)特征融合方式较为简单;2)忽略了不同尺度的图像之间的相关性;3)在网络模型浅层部分提取图像的纹理特征时,没有考虑不同尺度图像之间的数据流通。为此,本文提出两个通用模块:信息交互模块以及特征融合模块。前者用于加强不同尺度的图像之间的特征流通和相关性,后者则用于提升不同尺度的图像特征利用率。将上述策略融合到DenseNet 网络后,在5 折交叉验证实验中取得了97.785%的分类准确率和0.977 62的F1分数,同时在其他各项评价指标上相较于一般多尺度网络和TransPath 网络也有一定提升。其中,加入信息交互模块以后,网络模型在各项指标上的提升较大。这可能是因为在网络浅层提取的是形态纹理和颜色等特征,信息交互模块可让多个尺度的特征信息相互流通,使得网络模型捕获到与预测目标更相关的特征,从而提升了模型的性能。

本文所提出的两个模块具有良好的通用性,将两个模块应用到不同的网络结构中并进行实验,结果表明加入模块后的网络取得了较好的性能提升,超过一般多尺度网络和单尺度网络中表现良好的TransPath。本文在验证所提出模块的通用性时,采用的是使用较为广泛的卷积网络结构,并未对Transformer网络结构进行改进和实验。计划在未来拓展该模块的有效性,并将改进后的多尺度网络应用于乳腺癌病理图像处理的下游任务,比如:用于多示例学习或自监督学习的主干网络,提取更丰富的patch 特征;基于patch 进行的乳腺癌组织病理图像分割等。

4 结论

本文提出了一种新的卷积神经网络改进策略,能够适应不同的网络结构,包括信息交互模块和特征融合模块,其中前者是为了加强不同尺度的分支之间的特征结合并且形成反馈;而后者能够较好地区分重要特征并减少不同尺度图像的感受野差异影响。本文在一些主流的网络架构上,比如ResNet、SEResNet 和DenseNet 上添加所提出的模块,然后在Camelyon16 公开数据集上进行五折交叉实验,结果表明本文方法在各项评价指标上都优于单尺度网络和一般多尺度网络,表现出较好的稳定性。此外,本文提出的多尺度网络模型可以很好地应用于乳腺组织病理图像的下游任务,比如:基于patch 进行的乳腺癌组织病理图像分割、基于patch提取特征进行乳腺癌大图判别。同时本文提出的多尺度网络也可以作为多示例学习或自监督学习的主干网络,提取更丰富的patch特征。

未来可以将本文提出的模块应用于其他网络中,验证其通用性。同时,可以改进信息交互模块的反馈策略,让不同尺度的特征分阶段交互并反馈。本文对图像增强方法并未做过多的选择和处理,之后可以使用其他的方法进一步提升模型性能。