基于高分辨率类激活映射算法的弱监督目标实时检测

孙 辉 史玉龙② 张健一 王 蕊* 王羽玥

①(中国民航大学电子信息与自动化学院 天津 300300)

②(南开大学人工智能学院 天津 300350)

③(天津滨海国际机场有限公司 天津 300399)

1 引言

随着目标检测技术的快速发展,以快速区域检测网络(Faster Region-CNN, Faster RCNN)[1]、单镜头多盒检测器(Single Shot multibox Detector,SSD)[2]和“你只看1次”(You Only Look Once,YOLO)系列[3-6]为代表的深度神经网络在各类计算机视觉任务中取得了优异的表现。然而,上述网络在学习和训练过程中,对数据集的实例标注具有较高要求,增加了制作数据集的时间和人工成本,限制了网络在实际场景中的应用[7,8]。相比之下,弱监督目标检测算法可以仅使用图像的类别标签即可较为出色地完成对目标的检测,降低算法对目标实例标签的依赖,具有重要的研究和实用价值,受到了国内外相关学者的广泛关注。

当前主流的弱监督目标检测算法主要分为基于多示例学习(Multiple Instance Learning, MIL)的方法[9-11]和基于类激活映射(Class Activation Mapping, CAM)的方法[12-15]。基于多示例学习的方法给出了“包”的概念,将每幅输入图像看作由目标候选集所构成的多个对象实例的包,但该类方法通常依赖于目标候选框的质量,如果候选框未能对目标位置进行较好的描述,容易导致此类方法陷入局部最优解,影响模型的检测性能和学习效率。在基于类激活映射方法的研究中,得益于文献[16]对卷积神经网络的探索,认为分类网络所提取的特征信息中既包含了目标的类别信息,也包含了目标的位置信息。为此,文献[17]利用全局平均池化(Global Average Pooling, GAP)提出了CAM算法,并利用该算法在分类网络中突出显示了目标的位置信息。然而,由于分类网络在特征提取过程中大多关注于对目标分类具有鉴别性的部分,这些部分通常无法覆盖目标的整体,且受破碎梯度的影响,生成的类激活图难以有效实现对目标的准确定位。

为解决上述问题,本文提出一种基于高分辨率类激活映射算法的弱监督目标实时检测方法,本方法将目标的检测细划分为弱监督目标定位和目标实时检测两个子任务。在弱监督目标定位任务中,本研究利用对比层级相关性传播理论设计了一种高分辨率类激活映射算法(High Resolution Class Activation Mapping, HR-CAM),对分类网络低级、中级和高级特征进行融合,产生高质量的目标类激活图,突出显示待检测目标的轮廓和位置。在目标实时检测任务中,本文选择SSD[2]网络作为目标检测器,将所生成的目标伪检测标注框作为真实检测标注框对该检测网络进行训练,并采用迁移学习的手段加快网络的收敛速度,实现对目标的实时检测。此外,为提升检测网络对待检测目标语义信息和位置信息的抽象能力,本研究基于高分辨率类激活图设计了一种新颖的目标感知损失函数(Object Aware Loss function, OA-Loss),该损失与分类损失和位置损失构成联合损失函数,共同监督SSD网络的训练过程,提升网络的检测性能。

本文其余部分安排如下:第2节分别从弱监督目标定位和对比层级相关性传播理论两个方面对本文相关工作进行介绍。第3节从设计的HR-CAM算法和目标实时检测两个方面对本文的主要工作进行介绍。第4节对提出的方法进行实验分析,并给出实验结果。第5节总结全文。

2 相关工作

2.1 弱监督目标定位

在弱监督目标定位研究中,文献[18]提出了一种对抗互补学习方法(Adversarial Complementary Learning, ACoL),该方法采用两个互补的并行分类器,用于获取目标位置区域,但需要较高的计算资源。文献[19]提出了一种基于注意力机制的丢弃层方法(Attention-based Dropout Layer, ADL),该方法通过引入自注意力机制来擦除目标的显著性区域。文献[20]提出了一种发散激活方法(Divergent Activation, DA),利用语义分散性思想传播激活区域,从而最大化不同层次特征图差异,实现目标定位。文献[21]通过学习整个数据集的全局一致性,并设计目标随机类间约束,来挖掘目标完整区域,实现目标的弱监督定位。文献[22]提出了一种多次擦除集成学习方法(Multiple Erasing Integrated Learning, MEIL),该方法通过将判别区域挖掘和对抗性擦除集成到神经网络的前向和后向传播中,从而发现完整的目标区域。文献[23]提出了一种几何约束网络(Geometry Constrained Network,GCNet),该网络由检测器、生成器和分类器3个模块组成,用于实现对目标进行几何约束,以端到端的方式学习更完整的目标区域。文献[24]提出了一种伪监督目标定位方法(Pseudo Supervised Object Localization, PSOL),在该方法中,分类网络仅用来实现分类任务,定位任务由回归网络完成,并与目标类别无关,在不同的数据集之间具有良好的迁移性。文献[25]提出了一种结构保持激活方法(Structure-Preserving Activation, SPA),该方法设计了受限激活模块和自相关图生成模块,用于缓解分类网络引起的结构缺失问题,实现良好的目标弱监督定位。

2.2 对比层级相关性传播理论

卷积神经网络由若干个非线性函数嵌套组成,在具有高度非线性和出色学习能力的同时,导致研究人员难以对网络决策行为进行解释。为此,文献[26]提出对比层级相关性传播理论,使用相关性分数衡量神经元对模型决策做出的贡献,突出显示目标的特征,这为本文的弱监督目标定位任务提供了重要理论依据。该理论首先使用式(1)对初始相关性分数中目标类别神经元和非目标类别神经元的比例进行了区分,即

其中,w和w分别表示连接第l层和第l+1层神经元的正、负权值;[U,V]表示神经元激活值的取值区间。

3 基于HR-CAM算法的弱监督目标实时检测

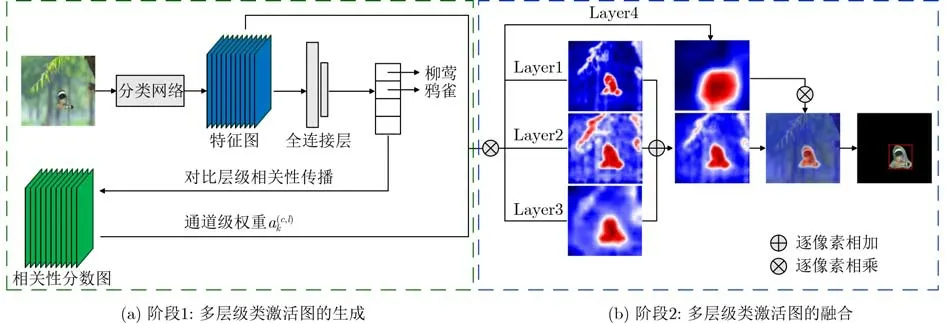

为降低制作数据集的时间和人工成本,实现仅使用图像类别标签完成目标的实时检测,本研究提出一种基于HR-CAM算法的弱监督目标实时检测方法,本方法将目标的检测细划分为弱监督目标定位和目标实时检测两个子任务,其整体框架如图1所示。从中可以看出,本研究首先将待检测目标输入分类网络中,利用HR-CAM算法生成目标类激活图,准确高效地获取目标伪检测标注框。其次,本研究选取SSD网络作为目标检测器,并基于类激活图设计了一种新颖的目标感知损失函数,与生成的目标伪检测标注框共同监督SSD网络的训练过程,以达到对目标实时检测的目的。本节也将从HRCAM算法和目标感知损失函数两个方面对基于HRCAM算法的弱监督目标实时检测方法进行介绍。

图1 基于HR-CAM算法的弱监督目标实时检测整体框架

3.1 HR-CAM算法

在弱监督目标定位任务中,为准确地获取目标伪检测标注框,本研究受文献[26]的启发,利用对比层级相关性传播理论提出了一种新颖的HR-CAM算法,本算法充分使用了分类网络提取到的图像低级、中级和高级特征,可以通过热力图的形式实现目标的准确定位,生成目标伪检测标注框。图2显示了本文设计的HR-CAM算法在Resnet50[27]分类网络中生成目标伪检测标注框的过程。

图2 HR-CAM算法生成目标伪检测标注框的过程

从图2可以看出,本研究设计的高分辨率类激活映射算法分为多层级类激活图的生成与融合两个阶段。在第1个阶段中,本文利用比对层级相关性传播理论和类激活映射算法获取Resnet50网络Layer1层、Layer2层、Layer3层和Layer4层特征图中每个位置对目标分类的贡献,生成对应的类激活图,并上采样到和输入图像相同的尺寸。以Layer1层为例,该层类激活图的计算过程如式(4)和式(5)所示

其中,R)(x, y)表示利用对比层级相关性传播理论反向传递获取的Layer1层第k个特征图中每个位置关于目标类别c的贡献,a表示第Layer1层中第k个特征图Ak关于目标类别c的通道级权重。

在图2的第2个阶段,本研究将Layer1层、Layer2层和Layer3层类激活图以相加的方式进行融合,以获取目标轮廓和纹理等细节信息,生成目标的前景区域。然而,这一过程同样也突出显示了和目标无关的背景噪声,无法准确地对目标进行定位。为此,本研究利用富含目标语义信息的Layer4层类激活图与融合的类激活图进行逐元素相乘,对背景噪声进行抑制,生成可以有效指示目标轮廓和位置的类激活图,并利用自适应阈值生成目标的掩码图,再使用包围框覆盖类激活图中最大的连通区域确定目标边界框,获取目标伪检测标注框。高分辨率类激活图MHR的生成和目标伪检测标注框的计算过程分别如式(6)和式(7)所示

其中,(x, y)表示类激活图中每个像素的位置,th=µ+δ表示本文设计的自适应阈值,µ表示激活图中像素值的均值,δ表示激活图中像素值的方差。

3.2 目标实时检测

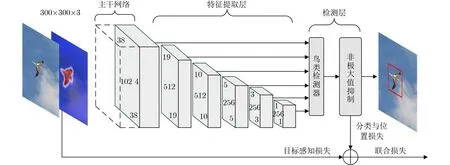

在目标实时检测任务中,本研究将3.1节采用HR-CAM算法生成的目标伪检测标注框作为真实检测标注框对检测网络进行训练,并综合以下两方面的考虑,选择SSD网络作为本文的目标检测网络。(1)SSD网络属于单阶段的检测网络,无需额外生成目标候选集,可以直接对目标进行推理,达到实时检测的效果;(2)SSD网络以Vgg16[28]作为主干网络,具有较高的通用性,便于使用迁移学习的方法加快网络的训练过程,降低过拟合的风险。图3展示了本文对SSD网络进行监督训练的过程。

图3 SSD网络监督训练的整体框图

由图3可以看出,为提升SSD网络对目标语义位置信息的抽象能力,本研究利用高分辨率的目标类激活图设计了一种新颖的目标感知损失函数(Object Aware Loss function, OA-Loss),将空间级的损失函数引入目标检测任务,使用具有丰富空间信息的类激活图对网络学习的特征进行约束,并对图像中的背景噪声进行抑制,提高网络对目标的推理能力。该目标感知损失函数定义如式(8)所示

其中,N表示图片的数量,MHR表示高分辨率的目标类激活图,MFA表示SSD主干网络中最后卷积层所有特征响应的集合。本研究在SSD网络的训练过程中,将提出的目标感知损失和分类损失与位置损失作为联合损失函数,共同监督网络的训练过程,提升SSD网络目标检测的性能。联合损失函数的定义如式(9)所示

其中,Lconf表示分类损失函数,Lloc表示位置损失函数,λ为控制目标感知损失函数权重的超参数。

4 仿真实验和分析

4.1 数据集及评价指标

本文根据文献[29]对天津滨海国际机场常见鸟种的研究,选取了52种天津机场常见鸟类作为待检测的目标,并通过网络收集和实地拍摄制作了TJAB52(52 species of birds at Tianjin Airport)数据集。TJAB52数据集共包含5 200张鸟类图像,分为3 640张训练图像和1 560张测试图像。部分TJAB52鸟类图像如图4所示。本文方法在CUB200[30]和TJAB52数据集进行了实验,两个数据集均提供了类别标签和边框注释。

图4 TJAB52数据集示例图

在弱监督目标定位与目标实时检测两项子任务中,本文统一选择使用分类准确率、Top-k定位准确率、GT-know定位准确率和每秒帧率(Frame Per Second, FPS)评价指标。其中,分类准确率是指网络预测正确的结果在测试集中的比例;Top-k定位准确率是指当网络预测目标类别与前k个类别相同时,且模型预测边界框和目标真实边界框的交并比大于0.5的比例;GT-know定位准确率是指模型预测边界框和目标真实边界框的交并比大于0.5的比例;每秒帧率是指模型每秒处理图像的个数,用来评价本文方法在测试集上的检测速度。值得说明的是,本文选择Top-k和GT-know定位准确率而非平均准确率和平均精度均值等常用的目标检测评价指标的原因及优势在于:(1)平均准确率和平均精度均值与目标被正确检测的数量相关,与预测边框和真实检测边框的重合程度无关;(2)定位准确率可以客观地表明本文方法使用HR-CAM算法生成目标伪检测标注框与真实检测标注框的接近程度;(3)定位准确率可以直观地反映采用目标伪检测标注框作为真实检测标注框对SSD网络进行监督训练的有效性。

4.2 弱监督目标定位实验

4.2.1 定量实验结果与分析

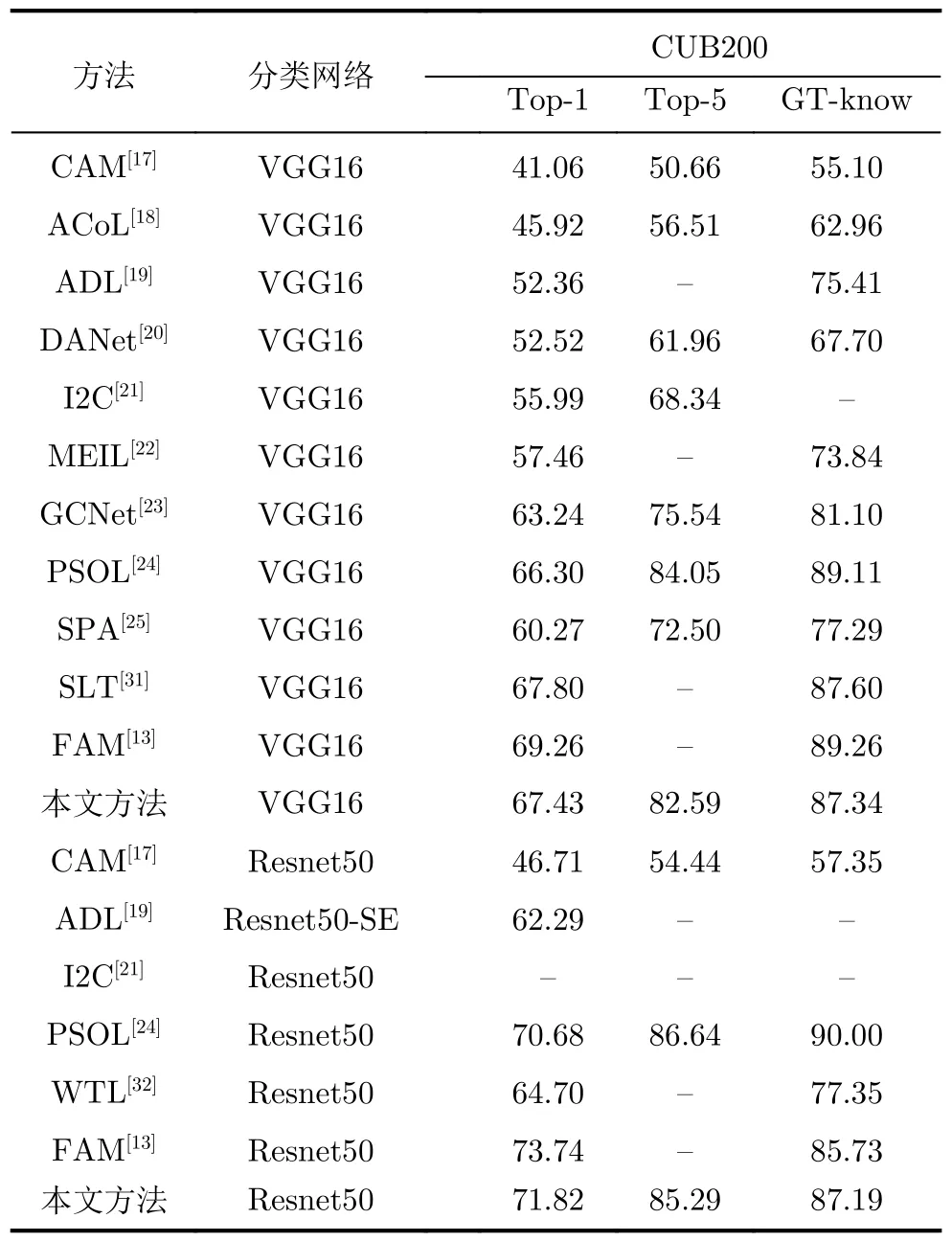

在定量实验中,本研究选取Vgg16和Resnet50网络作为目标的分类网络,采用HR-CAM算法生成高质量的类激活图,完成目标的弱监督定位,获取目标伪检测标注框。表1展示了本文方法在CUB200数据集中的评估结果。值得说明的是,在Vgg16网络中,本研究选择网络的第13层、第23层、第33层和第43层作为相关性分数反向传播的目标层;在Resnet50网络中,本研究选择网络的Layer1层、Layer2层、Layer3层和Layer4层作为相关性分数反向传播的目标层。这是由于上述的网络层在对图像特征进行处理时,进行了下采样的操作,产生了不同尺度大小的特征图,因此本研究利用HR-CAM算法对多尺度的特征图产生的类激活图进行融合,用于生成高分辨率的类激活图,准确高效地获取目标伪检测标注框。

表1 不同弱监督定位方法在CUB200数据集实验结果对比(%)

由表1可以看出,当分类网络为Vgg16时,网络对CUB200数据集的Top-1定位准确率为67.43%,Top-5定位准确率为82.59%,GT-know定位准确率为87.34%,相比于GCNet[23]和SPA[25],Top-1定位准确率分别提高了4.19%和7.16%,Top-5定位准确率分别提高了7.05%和10.09%,GT-know定位准确率分别提高了6.24%和10.05%。当分类网络为Resnet50时,网络对CUB200数据集的Top-1定位准确率为71.82%,Top-5定位准确率为85.29%,GTknow定位准确率为87.19%,达到了与POSL[24]和FAM[13]等先进方法相当的水平。

此外,本文采用HR-CAM算法在自制的TJAB52数据集中同样进行了弱监督定位的实验,并将生成的目标伪检测标注框和真实检测标注框进行比较。由表2可以看出,当分类网络为Vgg16时,TJAB52鸟类数据集的分类准确率为85.92%,Top-1定位准确率为76.68%, Top-5定位准确率为89.52%, GT-know定位准确率为90.83%。当分类网络为Resnet50时,TJAB52鸟类数据集的分类准确率为89.07%,Top-1定位准确率为81.35%, Top-5定位准确率为93.37%, GT-know定位准确率为94.96%。可以表明本研究设计的HR-CAM算法具有较高的通用性和泛化性能,在自制的TJAB52数据集中同样具有良好的弱监督定位性能。

表2 TJAB52鸟类数据集弱监督定位实验结果(%)

4.2.2 定性实验结果与分析

为直观地对本文方法进行定性分析,本研究通过可视化的方法在图5中列出了部分由HR-CAM算法在CUB200和TJAB52数据集中对目标进行弱监督定位的结果示例,并将生成的目标伪检测标注框和真实检测标注框进行比较。需说明的是绿色边框为目标真实检测标注框,红色边框为目标伪检测标注框。从中可以看出,本研究提出的HR-CAM算法在弱监督目标定位任务中具有以下3点优势:(1)在近视场或远视场图像中,本文方法均可以有效突出目标位置,产生准确的目标伪检测标注框。(2)本文方法融合了分类网络中目标的低级、中级和高级特征,对形态变化剧烈的鸟类具有较高的鲁棒性和泛化性能。(3)本文方法不仅能够对图像中单一存在的目标进行弱监督定位,在多目标的图像中同样具有良好表现。

图5 部分弱监督目标定位实验结果示例

4.3 目标实时检测实验结果与分析

在4.2节的实验结果中,本研究观察发现,先进的弱监督目标定位方法在Resnet50网络中对目标的弱监督定位性能通常要优于Vgg16网络,生成的目标伪检测标注框更接近于真实标注。为此,在目标检测实验中,本研究以Resnet50作为分类网络,利用HR-CAM算法生成的目标伪检测标注框作为真实检测标注框对SSD网络进行训练。由于SSD网络选择Vgg16网络作为主干网络,因此,本研究在SSD网络训练开始前,采用迁移学习的手段,将在弱监督定位任务中预训练好的Vgg16模型权重迁移到SSD网络中,加快网络的训练过程,降低过拟合的风险。此外,在SSD网络训练时,本研究采用目标感知损失函数、分类损失函数和位置损失函数作为联合损失函数对SSD检测网络进行了监督。为此,本研究首先使用分类准确率和Top-1定位准确率两个评价指标在CUB200数据集中对目标感知损失函数进行了消融实验,以确定联合损失函数中目标感知损失函数权值λ的取值范围,并证明本研究所提出的目标感知损失函数有助于提高SSD网络对目标的检测精度。目标感知损失函数的消融实验结果如图6所示。从中可以看出,随参数λ的增加,SSD网络对飞鸟的分类准确率和Top-1定位准确率曲线呈现先升高后降低的趋势,并在权重参数为λ=1.5时网络的性能达到了最优,因此本文将λ的取值设置为1.5。

图6 目标感知损失函数消融实验结果图

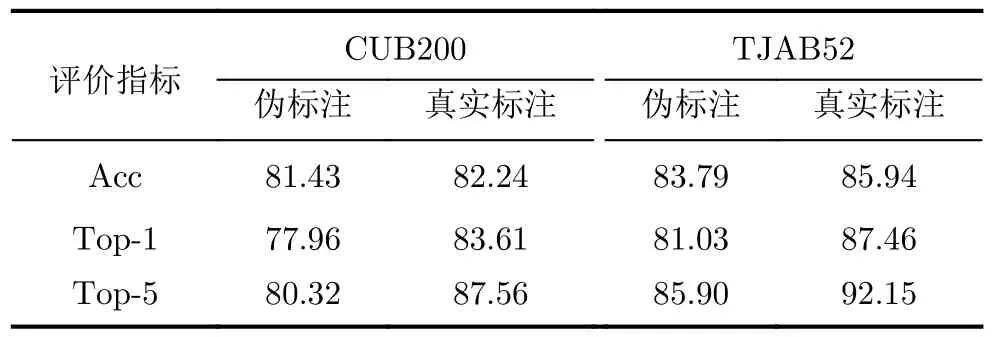

在确定目标感知损失函数权重λ的取值后,本研究使用分类准确率、Top-1定位准确率、Top-5定位准确率3个评价指标在CUB200数据集和TJAB52数据集中进行目标检测的实验。在实验中,本研究分别使用目标伪检测标注框和真实检测标注框对SSD网络进行训练,实验结果如表3所示。由结果可以看出,使用伪检测标注框训练的SSD网络在检测精度上虽然略低于真实检测标注框训练的SSD网络,但相较于数据集的前期准备工作而言,极大地降低了边框标注的时间和人工成本,在实际应用场景中更具有通用性。此外,采用SSD网络对目标图像进行推理时,网络的运算速度为37.6 fps,达到了实时检测的效果。

表3 CUB200和TJAB52数据集目标检测实验结果(%)

最后,为找到影响本文方法检测精度进一步提升的原因,在图7(a)和图7(b)中分别展示了本文方法部分检测成功与失败的结果示例。其中绿色边框为目标的真实检测标注框,红色边框为模型检测的结果。从可视化后的结果可知,当待检测目标具有以下两点特性时,易导致本文方法检测结果的失败。(1)当目标未完全显示且局部特征占据了图像的大部分区域时,本文方法所生成的类激活图趋向于突出待检测目标更具鉴别部分的特征,生成的伪检测标注框不完全,易使得检测结果存在较大偏差;(2)当目标与周围环境对比度较低时,类激活图易受到环境因素的影响,难以准确突出显示目标的轮廓与位置,影响了目标的最终检测结果。因此,在未来工作中,将更关注于上述两点问题,进一步提升本文方法的检测性能。

图7 部分检测成功与失败结果示例图

5 结束语

本研究提出了一种基于HR-CAM算法的弱监督目标实时检测方法,本方法将目标检测细划分为弱监督目标定位与目标实时检测两个子任务。在弱监督目标定位任务中,本研究基于对比层级相关性传播理论和类激活映射算法提出了一种HR-CAM算法,用于突出显示目标的轮廓和空间位置等信息,生成准确的目标伪检测标注框。在目标实时检测任务中,本研究基于高分辨率的类激活图设计了一种目标感知损失函数,与生成的目标伪检测标注框共同监督SSD网络的训练过程,提高网络对目标的推理能力。实验结果表明,本文方法在CUB200和TJAB52数据集上相比于其他方法,可以仅使用图像类别标签实现对目标的实时检测,在降低制作数据集时间与人工成本的同时,提升网络对目标的检测性能。在未来工作中,本研究将进一步对弱监督目标实时检测方法进行探索,提升模型的检测性能与泛化能力。