基于结构功能交叉神经网络的多模态医学图像融合

邸 敬, 郭文庆, 任 莉, 杨 燕, 廉 敬

(兰州交通大学 电子与信息工程学院,甘肃 兰州 730070)

1 引 言

现代医学影像设备提供了人体不同部位的病变图像,协助医生对疾病进行快速诊断和治疗。多模态医学图像通常分为两种类型:解剖医学图像和功能医学图像[1]。解剖医学图像有较高的分辨率,能够清晰地提供人体器官的结构信息,如计算机断层扫描(Computer Tomography,CT)和核磁共振成像(Magnetic Resonance Imaging,MRI)图像。功能医学图像主要反映人体器官的代谢信息,如单光子发射计算机断层扫描(Single-Photon Emission Computed Tomography,SPECT)和正电子发射计算机断层扫描(Positron Emission Tomography,PET)图像。由于单模态医学图像成像单一,不能提供病灶的准确信息。因此,多模态医学图像融合被广泛用于临床分析,实现对病灶部位准确、全面地描述[2]。

目前,图像融合分为特征级、决策级和像素级三个层次。特征级融合虽然降低了算法复杂度,但是融合图像容易丢失部分细节信息。决策级融合具有较好的实时性和自适应性,但会增加实验数据误差,导致图像信息损失最大。像素级融合是对图像的像素点进行信息融合的过程,也是当前主流研究方法。目前医学图像融合算法分为传统融合方法和深度学习融合方法。多尺度变换(MultiScale Transform,MST)是一类典型的传统融合方法,常用的MST 融合算法包括小波变换[3]、金字塔变换[4]、非下采样剪切波变换(Non-Subsampled Shearlet,Transform,NSST)[5]、非下采样轮廓波变换(Non-Subsampled Contourlet Transform,NSCT)[6]。近年来,诸多学者提出了许多人工神经网络方法用于模拟动物神经系统原理。例如,脉冲耦合神经网络(Pulse Coupled Neural Network,PCNN)[7],它正是根据小型哺乳动物视觉皮层神经系统模拟产生的,具有处理复杂信息的能力。PCNN 模型最早由Eckhorn 等人提出[8],此方法无需训练测试数据,网络框架可以直接提取特征信息。目前,深度学习的热潮迅速席卷全球,基于深度学习的方法在图像配准[9]、病变分割[10]、图像融合[11-12]等高级视觉任务中取得了较好的成绩。

然而,基于MST 融合算法需要多步分解操作。因此,它的适应性不好。基于PCNN 的融合算法模型中有大量的参数,增加了复杂度。基于深度学习的医学图像融合算法虽然结构简单、易于实现、适应性强,但在提取图像纹理特征、对比度、多任务融合能力和效率方面都需要提高。WANG 等提出一种模态合成和增强的弱监督医学图像融合方法[13],能有效增强MRI 图像的纹理和结构,但在此过程中忽略了CT 图像的骨骼信息,导致边缘轮廓模糊。陈永等将注意力机制引入图像融合中[14],其融合图像获得了源图像较多信息,但在融合模型中使用了单分支神经网络,并没有信息之间的交互,因此纹理细节较差。FANG 等提出了卷积神经网络和注意力机制的多模态医学图像融合[15],通过减少冗余信息的影响来提高模型的整体性能,但减少模型复杂度的过程中纹理细节严重丢失,并且仅适用医学领域,实时性较差。TANG 等人提出了多尺度自适应变换器来融合多模态医学图像[16],从不同尺度的角度充分获取了图像的结构信息,但在此过程中忽略了图像的功能信息,导致软组织信息丢失严重。ZHANG 等人提出了端到端的融合分解网络[17],通过融合分解使图像细节纹理更加清晰,但此网络在损失函数中的梯度损失和强度损失通过调整权重比例会造成融合图像轮廓信息丢失、对比度低,从而降低了医学图像融合结果质量。

为此,针对融合图像纹理细节模糊、边缘轮廓缺失和对比度低等问题,本文提出了一种结构功能交叉神经网络的多模态医学图像融合方法,采用结构功能模块和功能结构模块构成的交叉网络实现信息交互,提升融合图像的纹理细节信息。使用有效通道注意力机制和空间注意力机制(Effective Channel Attention mechanism and Spatial attention mechanism model, ECA-S)结合的改进注意力机制进行图像融合,来增强融合图像对比度。设计了融合图像到源图像的分解过程,使融合图像包含更多的边缘轮廓信息。本文的多模态医学图像融合是基于结构和功能信息的提取与重建,并设计了由结构项和功能项组成的损失函数。大量实验结果表明,本文方法融合的图像不但纹理细节清晰,而且图像整体对比对更高。最后将本方法扩展到红外与可见光和多聚焦图像融合,也取得了较好的融合结果,说明本文方法具有适用性。

2 本文方法

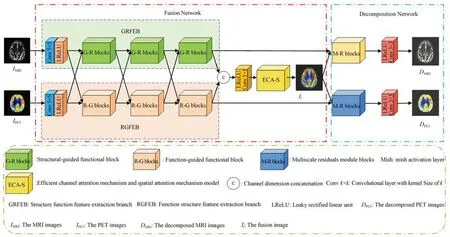

为了解决多模态医学图像融合结果中出现纹理细节模糊、边缘轮廓缺失和对比度低的问题,本文提出了基于结构功能交叉神经网络的多模态医学图像融合模型,网络总体框架如图1 所示。在融合网络模型中,两种单模态医学图像作为输入,通过结构功能模块和功能结构模块提取图像特征信息,ECA-S 注意力机制融合出最终图像。在分解网络模型中,由残差网络组成的分解网络迫使融合图像包含更丰富的信息。

图1 网络总体框架图Fig.1 General network framework diagram

2.1 结构功能交叉神经网络和注意力机制融合图像

为了使细节信息被充分提取,本文将交互神经网络引入图像融合中。将源图像分别馈送到结构功能特征提取分支(GRFEB)和功能结构特征提取分支(RGFEB)模块。GRFEB 包括一个核为5×5 的卷积和激活函数为Leaky ReLU(LReLU)的低级特征提取块以及三个结构引导功能块(G-R 块)组成。RGFEB 由低级特征提取块和三个功能引导结构块(R-G 块)组成,如图1所示。在G-R 块和R-G 块上设计了多个交叉连接,以实现GRFEB 和RGFEB 之间的结构和功能信息交互。每个G-R 块的输入不仅包括GRFEB 中前一块的输出,还包括RGFEB 中对应的前一块的输出。R-G 块也是如此。第三个GR 块和第三R-G 块的输出在通道维度上级联,并馈送到ECA-S 注意力机制,得到最终的融合图像。表1 列出了所提出方法模型的融合网络参数和分解网络参数,其中卷积层在每个块或模块中从左到右、从下到上编号。

表1 网络模型具体参数Tab.1 Specific parameters of network model

2.1.1 G-R 模块和R-G 模块

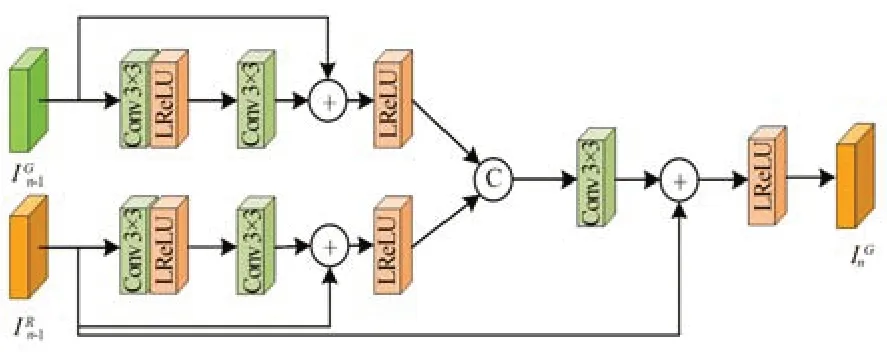

G-R 模块的网络架构如图2 所示。G-R 块的输入包括GRFEB 和RGFEB 中先前块的输出,即和,其中n∈[1,3]表示特征提取分支中的块索引。为了从MRI 图像中充分提取特征,使用了两阶段残差结构。具体来说,被送入第一级残差结构,该结构由两个3×3 卷积层和LReLU 层组成。输入与输出相加构成残差连接。由相同的残差结构处理,以加入从PET 或SPECT 图像中提取的特征。这两种残差结构的输出在通道中级联,然后用于特征融合和3×3 卷积层进行通道降维。第二阶段残差结构用于增强MRI 图像中的结构信息。原始输入与1×1 卷积层的输出相加得到最终输出。R-G 模块也采用了两级残差结构,如图3 所示。不同之处在于第二级残差连接是在RGFEB 中的先前块的输出上执行的(即),以增强PET 或SPECT 图像中的功能信息。

图2 G-R Block 网络结构Fig.2 G-R Block network structure

图3 R-G Block 网络结构Fig.3 R-G Block network structure

2.1.2 ECA-S 注意力机制模块

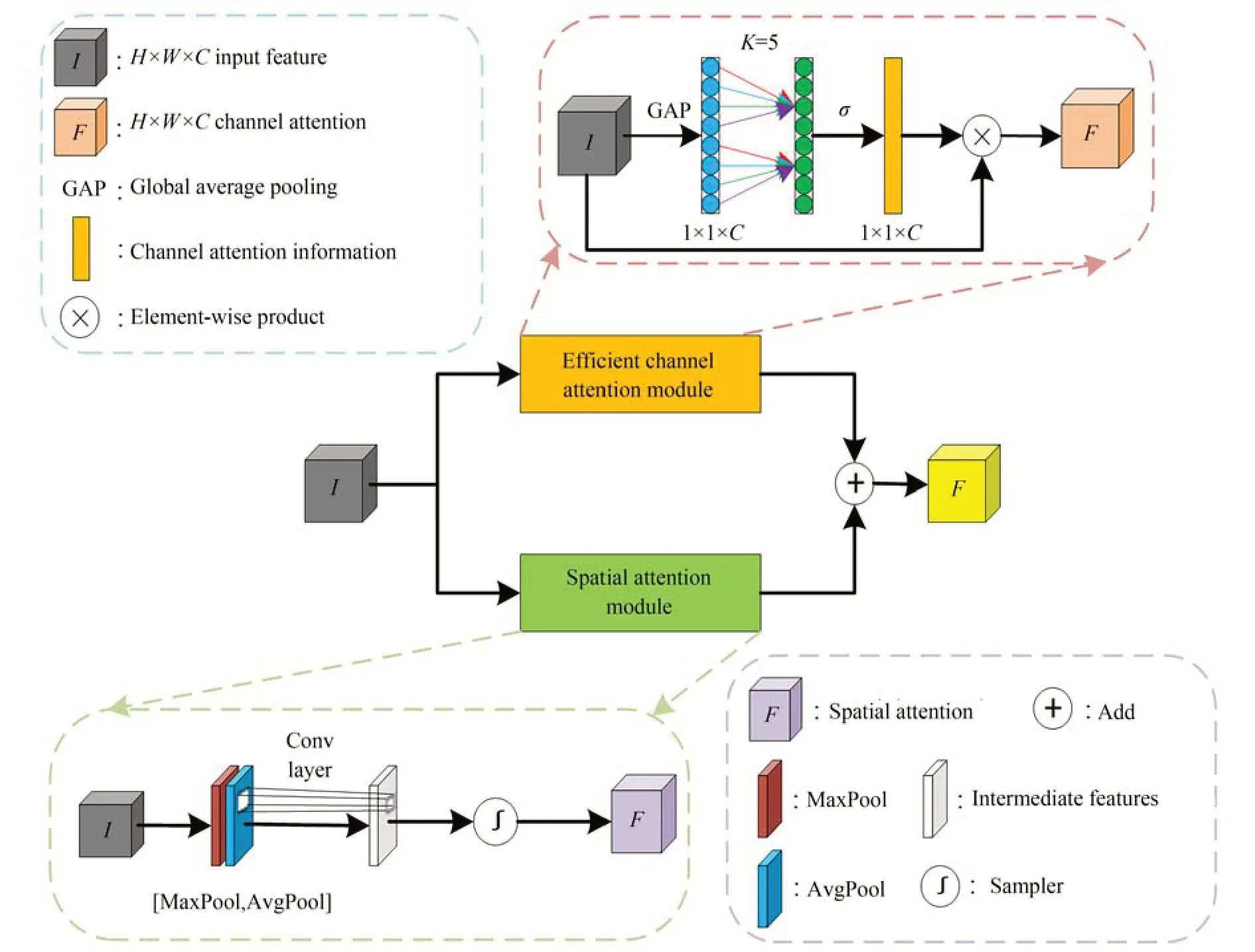

通过剖析有效通道注意力机制[18](Efficient Channel Attention,ECA),发现避免维度缩减对于学习特征信息非常重要。同时注意到医学图像中只有部分部位对融合结果有贡献,而空间注意力机制[19](Spatial Attention Mechanisms,SAM)主要处理图像重要部位信息。因此,将ECA 注意力机制和SAM 注意力机制“并行连接”,使两种注意力模块都直接学习原始的输入特征信息,从而无需关注空间注意力和通道注意力顺序,形成一个新的ECA-S 注意力机制模型,模型如图4 所示。

图4 ECA-S 注意力机制模块Fig.4 ECA-S attention mechanism module

ECA-S 注意力机制的一条分支由SAM 构成。首先,对输入特征图进行最大池化和平均池化并在通道维度堆叠。其次,使用1×1 大小的卷积核对堆叠特征图特征提取。最后,将提取到的特征信息结果经过sigmoid 激活函数空间权重归一化,再将输入特征图和权重相乘得到。

另一条分支由ECA 构成。首先,针对输入的特征层进行全局平均池化。其次,将池化后的特征长条进行卷积提取,通过sigmoid 激活函数生成每一个特征点的权值。最后,权值与原始特征层结合,便可以得到MECA。将其计算的MS与MECA相加得到MECA_S。其全部计算过程可以表示为式(1)~式(3):

其中:MS为SAM 输出特征信息,MECA为ECA 输出特征信息,MECA_S为ECA-S 输出特征信息,I为输入特征信息,σ为sigmoid 激活函数,AvgPool表示平均池化,MaxPool表示最大池化,GlobalAvg-Pool表示全局平均池化,⊕表示逐元素相加。

2.2 基于残差网络的分解模型

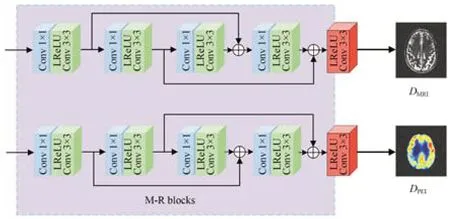

为了提取到更丰富的图像信息,本文引入分解网络模型。具体来说,不仅考虑了从源图像到融合结果的融合过程,而且考虑了从融合结果到源图像的分解过程,可以使融合结果包含更多的纹理细节。本文的分解网络模型如图5 所示,每一块先经过1×1 的卷积层,再经过3×3 的卷积层,组成多尺度结构,充分提取空间信息,最后再通过LReLU 激活函数输出特征信息。为了充分分解融合图像的特征信息,分解网络的输入分为两部分,一部分输入为通过ECA-S 注意力机制融合后的图像,另一部分为G-R Block 和R-G Block 的第三层的输出,其目的是经过ECA-S 注意力机制提取到的是图像的显著信息,而一些不重要的信息却容易被忽略,因此直接将G-R Block 和R-G Block 的第三层作为分解网络的一部分输出让分解过程中信息提取更充分。

图5 分解网络流程Fig.5 Flowchart of decomposition network

2.3 损失函数

本文的网络框架分为两个部分,融合网络特征提取生成单个融合图像。分解网络对结构和功能信息进行分解和重构,分解网络专用于从融合结果分解近似源图像的结果。相应地,损失函数也由两部分组成:融合损失Lsf和分解损失Ldc。

2.3.1 融合损失

图像中包含的信息可以分为结构信息和功能信息,因此,本文将多模态医学图像融合问题转化为提取和重建图像中的结构信息和功能信息的问题,融合损失也由结构损失项和功能损失项组成,损失函数可表示为公式(5):

其中,β用于平衡结构损失项和功能损失项。

本文设计了一个自适应结构损失函数Lstru来增加融合图像的纹理特征。自适应决策块通过高斯低通滤波器滤除噪声对图像的影响,尽可能减少噪声对决策块的影响。利用Scharr 算子求出结构图,结构图包含大量的纹理细节信息以及清晰的轮廓信息。之后根据结构的大小生成决策图。其原理图如图6 所示。

图6 自适应决策块Fig.6 Adaptive weight block

其中:i和j表示像素在第i行和第j列权重图,H和W代表图像的高度和宽度,I1和I2为源图像,Ifusion为融合图像,|·|表示绝对值函数,∇(·)为Scharr 算子,S(·)是由决策块基于源图像的结构水平生成的决策图,L(·)表示高斯低通滤波器函数,min(·)表示最小函数,sign(·)为符号函数。

功能损失函数Lfunc影响融合图像的对比度。功能损失函数通过对Frobenius 范数进行改进,改进后的Frobenius 范数与欧式距离有所不同,它是矩阵中每一个位置的元素的平方和取平均数再开方,其作用是衡量融合图像像素和源图像像素的距离,有效调整融合图像和两个源图像之间的权重,迫使网络选择更有效的信息。功能损失的公式可以表示为式(9):

2.3.2 分解损失

分解损失项Ldc要求融合图像的分解结果尽可能与源图像相似,可以表示为:

其中:I1_de和I2_de为融合图像的分解结果,I1和I2为源图像。由于分解后的图像与输入图像之间的差异程度决定融合结果的效果,因此分解损失函数将尽可能使融合结果获得更多图像信息,从而使融合质量达到最好。

3 实验结果和分析

本文模型包括融合网络和分解网络。无论是在训练阶段还是测试阶段,框架都使用Tensorflow 实现。所有实验均在Windows 11(64 位),硬件配置为Intel(R) Core(TM) i7-12700H 2.30 GHz笔记本电脑和16 GB RAM 软件上运行。

本节证明本文算法具有更好的性能,验证所提出的融合模型的实用性。对来自公开数据集哈弗医学库(http://www.med.harvard.edu/aanlib/home. html)的200 对256×256 的医学图像,共裁剪成39 200 个大小为120×120 的图像块进行训练。实验设置epoch=30,batch_size=32、学习率为1×10-4。在优化算法方面,选择适应性强的自适应优化算法Adam。此外,在总损失中包含的梯度损失、强度损失、分解损失的比例经过重复实验后设置为10,1,1。

3.1 客观评价指标

为了进一步说明本文算法的有效性,选择了包括空间频率(SF)[20]、平均梯度(AG)[21]、融合质量(QAB/F)[22]、相关系数(CC)[23]、熵(EN)[24]和互信息(MI)[20]等客观指标来评价融合图像的结果。AG 和EN 是衡量图像清晰度和信息量的指标,数值越大说明从输入图像中提取的信息越丰富和全面。MI 通过度量融合图像和源图像之间的相似程度,即融合图像获取了源图像信息量的多少。互信息越大,质量越好。两幅图像之间的相关性用CC 表示,数值越接近1 表示两幅图像之间的特征信息越接近。图像灰度的测量用SF 表示,SF 值越大,表明融合结果的灰度值越接近输入图像的灰度值。QAB/F是对融合图像信息表现程度的一种估计,数值越大说明信息量越大,图像质量越好。

3.2 方法比较

为了验证本文方法的有效性、实用性和时效性,与七种可比较的方法进行了主观视觉评价和客观数据比较:MLEPF[25],NSST[26],LEGFF[27],MATR[16],CNP[28],SDNet[17]和CFL[29]。

3.2.1 主观视觉评价比较

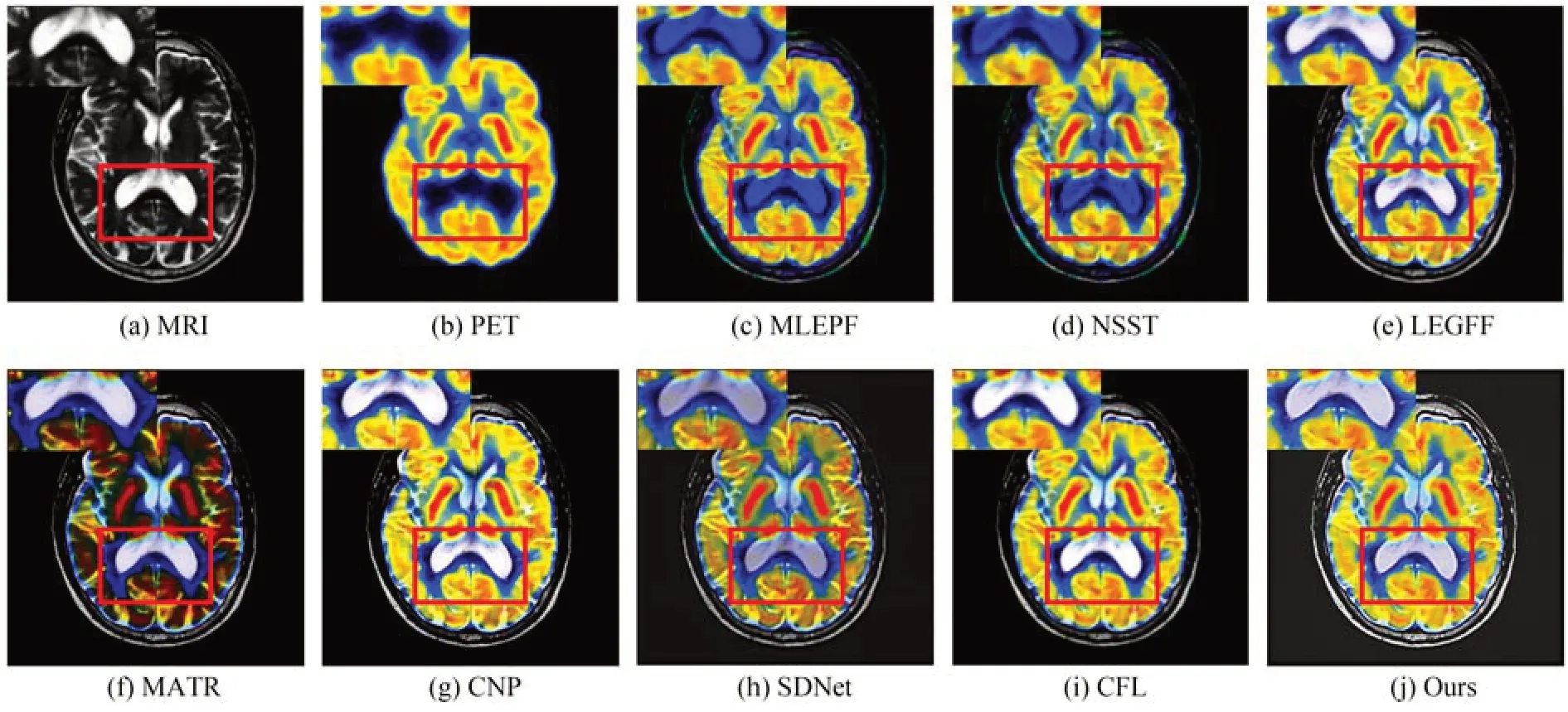

图7 展示了“轻度阿尔茨海默病”MRI-PET图像。图7(a)和图7(b)为MRI 和PET 源图像,图7(f)和图7(h)说明该实验结果对应的方法融合后的图像较模糊,存在纹理细节缺失。图7(c)和图7(d)实验结果对应的方法融合后的图像软组织中间区域出现紫色块效应。图7(i)实验结果对应的方法在软组织处亮度过于饱和,丢失MRI 软组织解剖信息。相比之下,图7(e)和图7(g)实验结果对应的方法融合图像获取了较多来自源MRI 和PET 图像中的细节信息。但是,目标边缘处比较模糊。对比来看,本文方法结果图7(j)保留了PET 彩色信息,并且获取了较多MRI软组织亮度解剖信息,纹理细节更清晰。

图7 “轻度阿尔茨海默病”MRI-PET 图像融合比较Fig.7 Comparison of MRI-PET image fusion in "mild Alzheimer′s disease".

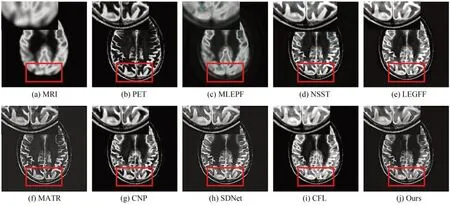

图8 展示了“转移性支气管癌”MRI-SPECT图像(彩图见期刊电子版)。图8(a)和图8(b)为MRI 和SPECT 源图像,图8(c)和图8(h)说明该实验结果对应的方法融合后的图像纹路模糊,导致软组织分辨率低。图8(d)说明该实验结果对应的方法融合后的图像软组织区域出现紫色块效应,无法正常观察病变区域。图8(e)和图8(i)说明该实验结果对应的方法包含了PET 图像较多的色彩信息,但没有较好得融入MRI 软组织解剖信息。图8(f)和图8(g)说明该实验结果对应的方法内部出现伪影,能量信息严重丢失。观察本文实验结果图8(j),不仅对比度增强,且软组织纹理细节和轮廓信息特征明显,融合图像色彩更自然。

图9 展示了“脑膜瘤”MRI-CT 图像。图9(a)和图9(b)为MRI 和CT 源图像,图9(c)说明该实验结果对应的方法融合结果图较模糊。图9(d)说明该实验结果对应的方法融合结果中纹理骨骼出现失真。图9(f)和图9(h)说明该实验结果对应的方法融合结果整体偏暗,导致纹理模糊。图9(e)和图9(i)说明该实验结果对应的方法融合结果对比度高,但边缘轮廓平滑,无法正确显示骨骼细节特征。综合来看,本文算法融合结果图9(j)保留了单模态医学图像的特征,能有效地提取软组织细节信息及灰度信息,能综合MRI 与CT 源图像丰富信息。

图9 “脑膜瘤”MRI-CT 图像融合比较Fig.9 Comparison of MRI-CT image fusion of "meningioma"

图10 “人物”多聚焦图像融合比较Fig.10 "Person" multi-focus image fusion comparison

图11 3 种不同场景下红外与可见光图像融合比较Fig.11 Comparison of infrared and visible image fusion in three different scenes

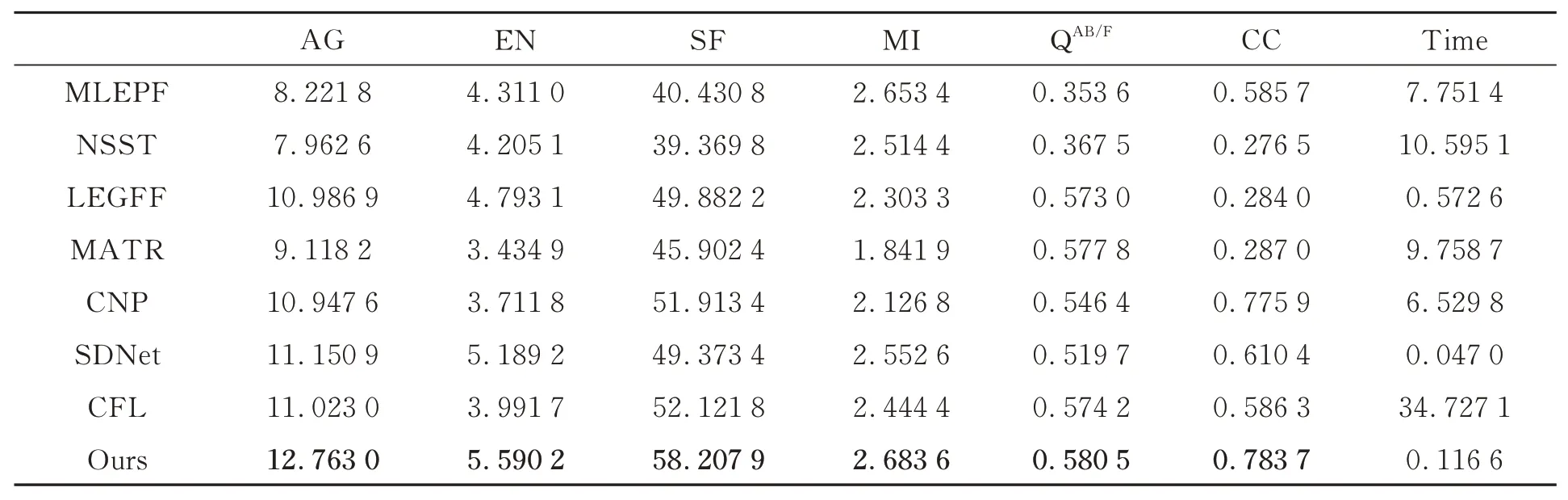

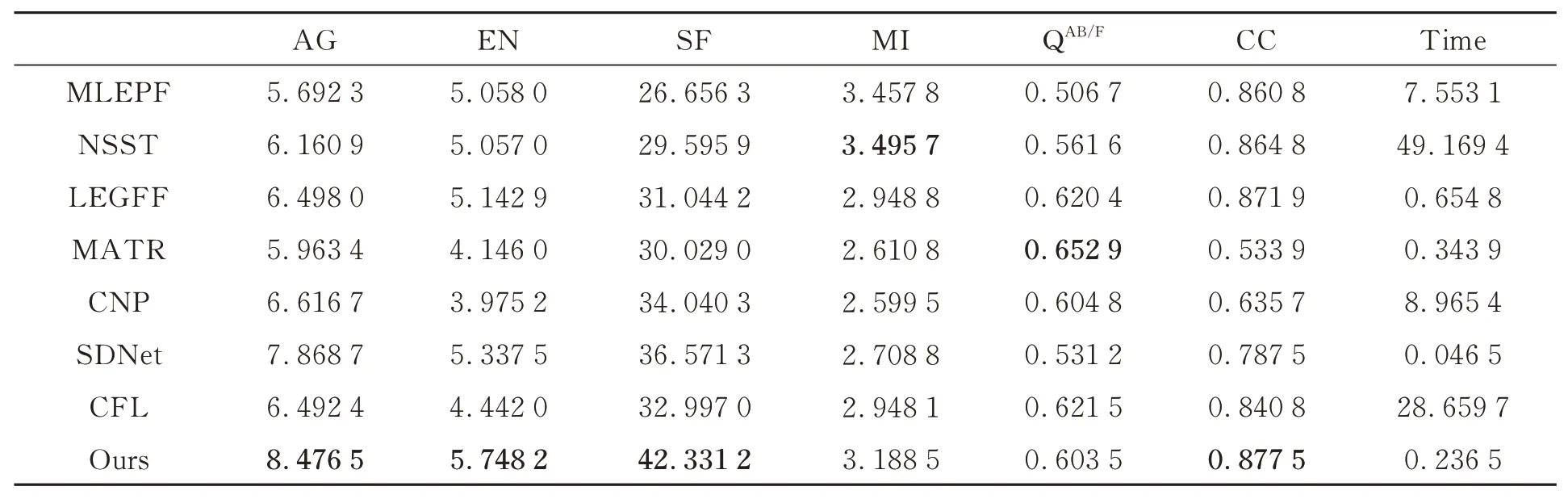

3.2.2 客观评价指标

从三组医学图像的融合结果表明,本文提出的结构功能交叉神经网络的多模态医学图像融合策略得到的融合图像高度符合人眼视觉特性,细节提取更充分,色彩更自然。从表2~表4 可以看出,AG,EN,SF,MI,QAB/F和CC 等指标均取得了较好的性能,但AG 和QAB/F在MRI-PET 和MRI-CT 图像中表现稍弱,这是因为在LEGFF,NSST,PCNN 方法中过度去关注对比度,是以图像的亮度去换取图像的细节信息,如在LEGFF方法融合MRI-CT 图像时,对比度指标AG 较高,但MI 却低于本文方法,说明信息提取较弱。在NSST 方法融合MRI-PET 图像中,整体亮度较高但软组织处出现失真,出现蓝色斑块,导致信息丢失。因此,与其他对比算法相比,本文的算法在融合过程中更注重PET 图像和SPECT 图像的色彩丰富度、MRI 图像的边缘轮廓信息和软组织信息,以及CT 图像的骨骼信息,使融合后的图像轮廓边缘更清晰,色彩更自然,更符合人眼视觉特性,可以辅助医生快速诊断和治疗疾病。

表2 “轻度阿尔茨海默病”MRI-PET 图像融合客观评价指标Tab.2 Objective evaluation indexes of MRI-PET image fusion in "mild Alzheimer′s disease"

表3 “转移性支气管癌”MRI-SPECT 图像融合客观评价指标Tab.3 Objective evaluation indexes of MRI-SPECT image fusion in "metastatic bronchogenic carcinoma"

表4 “脑膜瘤”MRI-CT 图像融合客观评价指标Tab.4 Objective evaluation indexes of "meningioma" MRI-CT image fusion

3.3 消融实验

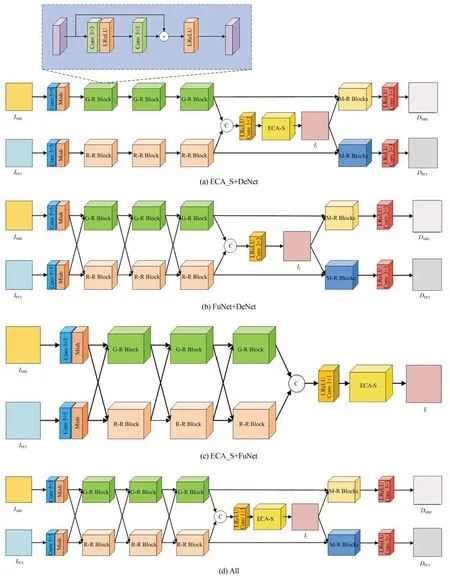

为了验证本文方法中结构功能交叉网络、改进注意力机制、分解网络的有效性,设计了四组消融实验。如图12 所示,所提出的方法被降级为三种不同的网络结构用于测试。

图12 消融实验的四种不同网络结构Fig.12 Four different network structures for ablation experiments

第一组实验将交叉网络变为双通道网络,每一个G-R Block 和R-G Block 模块变为蓝色区域的残差网络,其他网络结构不变,记为ECA_S+DeNet。第二组实验将改进注意力机制取消,其余网络结构不变,记为FuNet+DeNet。第三组实验将分解网络取消,其他网络结构均不变,记为ECA_S+FuNet。第四组实验将结构功能交叉网络、改进注意力机制、分解网络都放入模型中去观察融合结果,记为All。实验的具体流程如图12 所示。

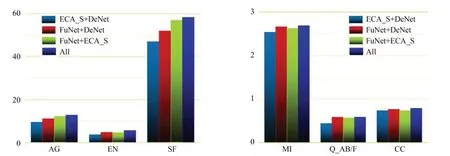

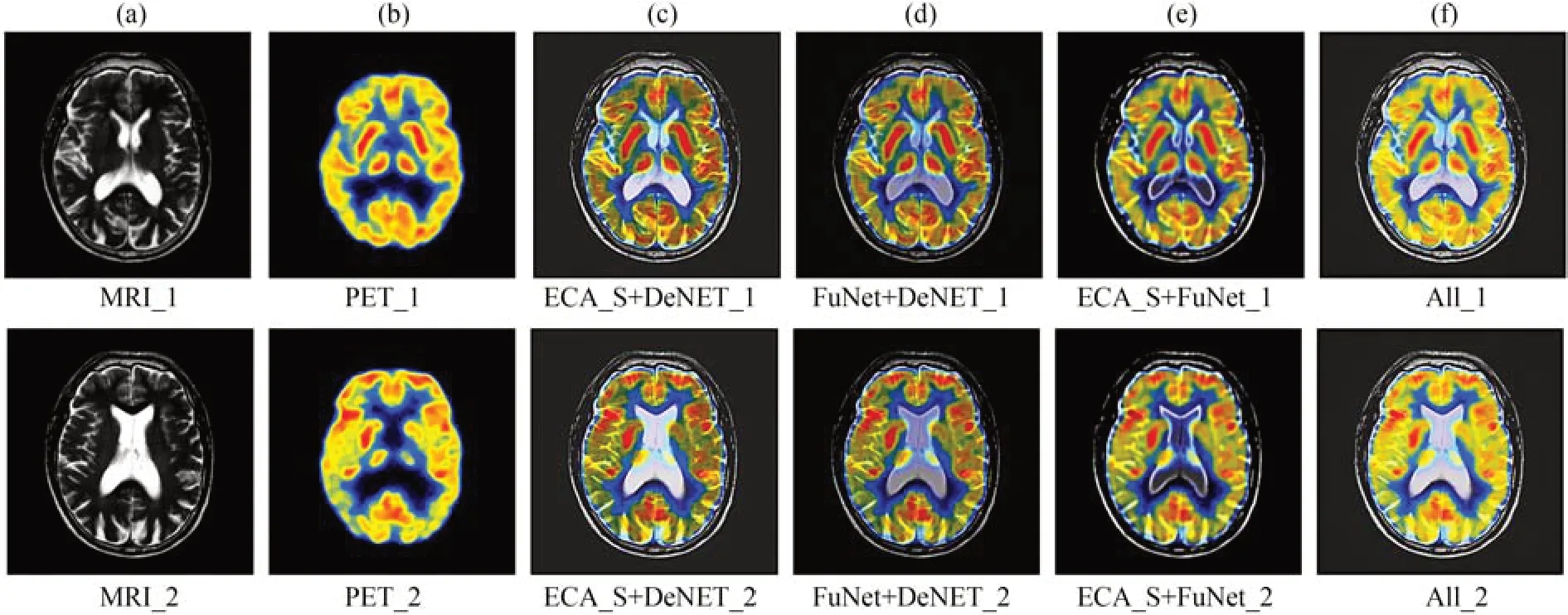

如图13 四种不同网络结构20 幅图像均值柱状图所示,在六个指标中完整架构在所有指标都获得最高值,这证明了在本文网络中采用的结构功能交叉神经网络、改进注意力机制和分解网络的重要性。图14 展示了由不同模型生成的两组融合结果,可以看出,四幅图视觉质量差异显著,完整模型在细节保留、对比度和边缘轮廓方面都优于其他三个降级模型。

图13 消融实验的四种不同网络结构20 副图像均值柱状图Fig.13 Histogram of the mean values of 20 images of four different network structures for the ablation experiment

图14 消融实验其中两组融合结果Fig.14 Fusion results of two groups of ablation experiments

3.4 效率对比

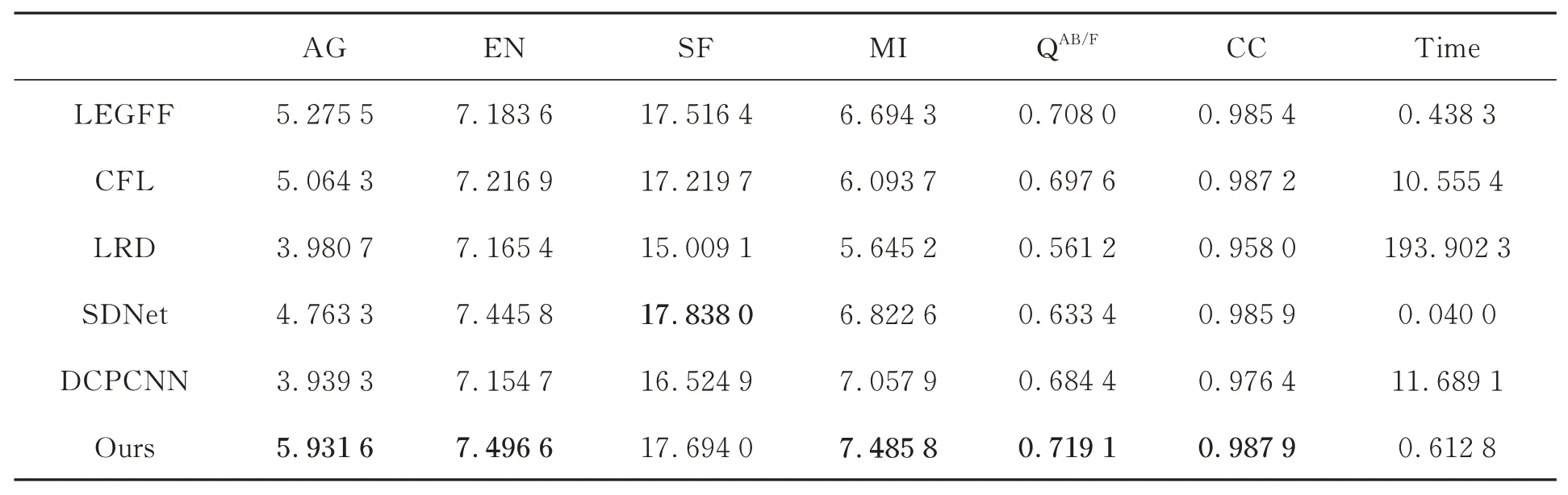

方法的运行时间也是评价性能的一个重要指标。表2~表6 记录了全部算法的运行时间,可以看出本文方法的网络运行时间略高于SDNet,但SDNet 算法融合图像的纹理细节和对比度都较差。因此,综合来看,本文算法的效率在时间和性能方面更好。

3.5 其他邻域应用

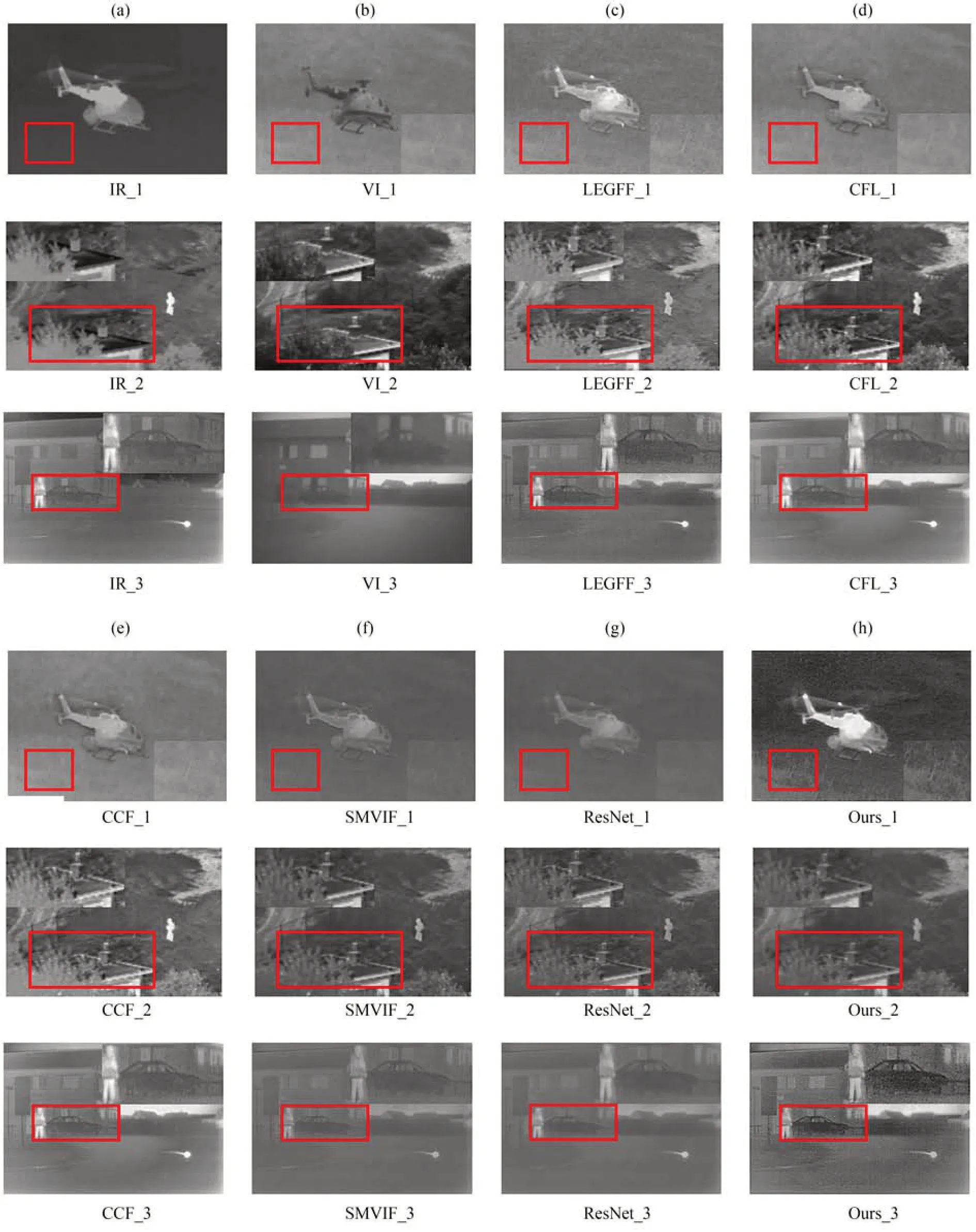

为了验证本文提出的算法在其他邻域的图像融合是否表现的同样有效,将其扩展到多焦点、红外和可见光图像。融合后的图像如图10 和图11 所示,表5 和表6 中提供了客观评价指标。可以看出,本文设计的结构功能交叉神经网络、改进注意力机制和基于残差网络的分解模型与人类视觉系统特点高度吻合。图10(a)和图10(b)显示了多聚焦输入图像,图11(a)和图11(b)显示了红外与可见光输入图像。本文融合方法与现有的LEGFF[27],SDNet[17],CFL[29],LRD[30],DCPCNN[31],SMVIF[32],ResNet[33]和CCF[34]方法进行了比较,所得融合结果如图10 和图11 的(c)~(h)所示。从融合结果的主观和客观评价得出,本文方法的融合结果很好地保留了输入图像的重要信息,并且在纹理、边缘轮廓和对比度方面处理都较好。充分证明了本文的方法在其他图像融合领域也具有很强的适应性。

表5 “人物”多聚焦图像融合客观评价指标Tab.5 Objective evaluation index of multi-focus image fusion of "people"

4 结 论

为了提高医学图像的融合质量,本文提出了一种结构功能交叉神经网络的多模态医学图像融合方法。在融合阶段,通过结构功能交叉神经网络完成图像结构信息和功能信息交互,使其充分提取源图像中的信息,并将提取的特征信息通过ECA-S 注意力机制得出融合图像。在分解阶段,为了提取到更多的图像信息,再将融合图像分解为两幅源图像,与输入图像比较尽可能减少其信息损失。实验结果表明,本文提出的方法客观评价指标AG,EN,SF,MI,QAB/F和 CC 均 提 高 了 22.87%,19.64%,23.02%,12.70%,6.79%,30.35%,因此本文方法不但对比度高,纹理细节清晰,且更符合人眼视觉特性。此外,通过客观实验数据显示,本文方法在多聚焦图像融合、红外和可见光图像融合领域的应用也有很大优势。本文方法的不足之处在于处理实时性任务,即没有在提取特征信息之前加入图像预处理。因此,下一步工作将在提取特征信息之前加入图像配准,并将其应用在实时性任务中。