在线视频学习过程中学习者的情感状态识别及其影响因素研究*

单美贤 张瑞阳

在线视频学习过程中学习者的情感状态识别及其影响因素研究*

单美贤 张瑞阳

(南京邮电大学 教育科学与技术学院,江苏南京 210023)

学习者的情感状态作为影响在线视频学习质量的重要因素,一直以来受到研究者的广泛关注。当前基于数据驱动的研究方法虽然可以提供在线视频学习过程中学习者认知行为的重要信息,但基于数据的在线视频学习过程中学习者情感状态及其影响因素的研究成果非常有限,情感状态的识别及其影响因素有待进一步研究。为此,文章首先开发了面部表情识别工具;接着通过准实验研究,检验面部表情识别工具的准确率;然后根据情感状态数据和SAM自我报告数据的分析,把握在线视频学习过程中学习者的情感状态变化;最后通过问卷调查和回顾性访谈,了解视频内容对学习者情感状态和满意度的影响。研究结果显示,面部表情识别工具整体上能够高度准确地识别出学习者的情感波动,视频内容对学习者的情感状态和满意度有极其显著的影响,并且情感状态在视频内容与满意度的作用过程中具有完全中介作用。通过研究,文章旨在为在线视频内容设计提供参考,促使学习者保持较高的唤醒度与愉悦度,改善其在线视频学习体验。

在线视频学习;面部表情识别;情感状态;视频内容;满意度

引言

情感1“情感”一词在学术界至今仍没有统一的定义,情感(Affect)、情绪(Emotion)、心情(Mood)和感觉(Feeling)等术语已被用来表示或解释一个人的情绪体验,情感和情绪可以具有相同的含义且可以互换使用。参考:AINLEY M. Connecting with learning: Motivation, affect and cognition in interest processes[J]. Educational Psychology Review, 2006,(4):391-405.构成了人们如何学习、学习什么、何时学习以及为何学习的关键部分,正如Immordino-Yang所说:“从神经生物学的角度来讲,在没有情感的情况下建立记忆、进行复杂的思考或做出有意义的决定是不可能的”[1]。研究发现,学习者的情感状态会显著影响其学习动机、学习行为甚至学习成果[2]。而作为当下重要的学习方式,在线视频学习环境中由于缺乏人际互动、社交存在和情感支持,更容易使学习者经常感受到无聊、沮丧等消极情绪,从而出现调节和维持动机的困难。因此,针对在线视频学习过程中学习者情感状态的识别及其影响因素的研究就显得尤为重要。

然而,现有关于学习者情感状态的科学认识,主要建立在面对面学习情境中得出的研究结果之上,许多研究发现并不适用于在线视频学习环境。数据驱动(如脑电波、眼球运动等)的研究方法虽然可以提供在线视频学习过程中学习者认知行为的重要信息,但基于数据的在线视频学习过程中学习者情感状态及其影响因素的研究成果非常有限。此外,在线视频学习环境中学习者情感状态的研究需要将外部可观察数据(如可感知的面部特征、姿势、言语和行动)与学习者个体内部数据(如自我报告)相结合,这样才能更好地把握学习者的情感状态。基于此,本研究拟采用面部表情识别、情感自我报告方法和回顾性访谈法来收集学习者的情感数据,分析在线视频学习过程中的情感状态及其影响因素,以期为在线视频学习资源设计提供参考。

一 研究现状

1 在线视频学习的研究现状

在线视频学习的相关研究主要集中在以下两个方面:①在线视频的设计研究,大多基于在线视频学习的认知因素展开,如关注如何在视频中呈现信息[3]、如何通过让学习者参与练习或其他学习任务来支持其从教学视频中获取知识[4]。②在线视频的应用效果研究,大多采用数据驱动方法研究在线视频学习环境中学习者的状态,如基于学习者的在线学习日志分析其知识构建过程和学习能力[5]、根据学习者的生理数据(如脑电波、眼球运动和皮肤电)分析其参与度[6],这些研究大多从认知维度探讨了在线视频学习环境中学习效果的影响因素。

目前,虽有研究通过自我报告或问卷调查的方式来分析学习者的满意度、学习态度或学习行为,如在学习者可以选择使用视频和现场讲座的描述性态度研究中,有研究者发现学生持有积极的态度,他们愿意向其他人推荐视频支持的此类课程[7];有研究者发现与传统教育以及免费的基于文本的电子学习相比,视频使用对学习成绩和学习满意度都有明显的影响[8];有研究者从在线视频学习平台特征的角度分析了学习者产生消极态度的原因[9]。但在线视频学习环境中的情感维度尚未得到系统研究,需要将数据驱动方法与自我报告相结合,以更好地把握在线视频学习过程中学习者的情感状态,进而确定如何以最有效的方式使用在线视频内容,提升学习者的学习效率。

2 情感状态及其表示模型

情感是主观和客观因素之间的一组复杂相互作用,可引起情感体验(如快乐/不快乐的感觉)、产生认知过程(如与情感相关的感知效果、评估过程)、激活对唤醒条件的广泛生理调节。在学习过程中学习者经历了丰富多样的情感状态,而目前不同研究者对在线视频学习中学习者情感状态的理解有所不同,如有研究者认为,情感状态是在特定情况下在特定时间测量的学习行为状态[10];也有研究者将学习情感状态定义为学习者的参与程度,并提出学习情感状态是一种稳定且可调节的心理状态[11];还有研究者认为,情感状态是学习者的认知与情感参与水平[12]。综上,本研究认为情感状态是由学习者的自我调节能力与具体的学习情境相互作用决定的心理状态。

在情感计算研究中,为融合来自不同输入渠道的情感数据,以提高情感识别的鲁棒性和准确性,要求情感计算研究者使用相同的情绪表示模型或提供适当的模型映射。当前,情感状态的表示模型一般分为两种:①离散模型,将情感系统描述为一组基本情绪,包括愤怒、厌恶、恐惧、喜悦、悲伤和惊讶,以及由它们组合而成的复杂情绪。②维度模型,认为情感是不同心理维度的组合体,其中有代表性的是Russell[13]提出的二维情感模型,即把情感状态表示为分布在一个包含效价度(情绪的积极与消极程度)和激活度(情绪的激烈程度)的二维空间上的点。本研究拟把实时识别的学习者情感状态的离散维度映射到Russell的二维情感模型空间中,以直观地反映学习者在视频学习过程中的情感变化过程。

3 情感状态的测量

提高学习者对自身情感状态的认识,有助于显著改善学习过程,然而在线视频学习环境尤其是远程学习、MOOC等环境中学习者情感状态数据的收集极具挑战性。目前,收集学习者情感数据的方法可以分为三类:①基于感知的估计,包括从面部表情、声音和身体动作中识别情感;②情感的生理测量,使用安装在身体上的设备(如EEG)进行测量,重点是潜意识的情感反应(如心跳、血压和出汗);③主观感受,由情感的自我报告组成。其中,基于感知的估计和情感的生理测量相对客观,更适合在实验室条件下进行,反映的是情感意识的内隐水平。而Mejbri等[14]通过系统文献综述发现,无论是单模态系统还是多模态系统,目前在线视频学习的情感状态测量方法中,面部表情识别是最常用的方式手段,其次是自我报告方式。

面部表情被认为是表达情感的主要通道,其较为自然且直接。自Ekman等[15]提出面部动作编码系统(Facial Action Coding System,FACS)以来,面部表情一直被用于推导学业情绪,其主要假设学习情境中面部表情与特定的情感状态有关。利用面部表情检测学业情绪的研究表明,使用面部表情获取情感状态是有意义和可靠的,但这些研究大多是在智能导学系统或者是需要高水平认知活动(如解决问题和编程)的学习环境中进行的。而在线视频学习过程中,学习者可能没有特定的成就目标,也可能不涉及认知要求高的任务,因此有必要研究在线视频学习环境中的学生情感状态及其影响因素。

常用的情感自我报告量表有积极/消极情感量表(Positive Affect and Negative Affect Scale,PANAS)、E-Learning情感自我报告工具(Emotion Report for E-Learning,EMORE-L)和自我评定量表(Self-Assessment Manikin,SAM),其中SAM[16]是较成熟的评估情感工具。SAM包含3个量表:愉悦度(愉快/不愉快)、唤醒度(紧张/放松)和控制度(抑制/不抑制),每个量表有5个象形图。参与者可以选择每个象形图之间的空白处来表示中间状态,因此每个量表的答案可以在1~9之间取值。鉴于SAM是基于维度的,因此它可以与情感的维度模型相互兼容。基于此,本研究一方面借助SAM量表对在线视频学习的整体情感状态进行自我评定;另一方面,利用面部表情识别软件来实时捕捉学习者情感状态的离散维度,并把离散数据映射到Russell的二维情感模型空间中,直观地反映学习者在视频学习过程中的情感变化过程及整体情感状态,主要关注以下3个研究问题:①面部表情识别工具能否有效地识别在线视频学习过程中学习者的情感状态?②视频内容对学习者情感状态的影响是否具有显著性?③视频内容是如何通过情感状态影响满意度的?

二 研究设计

1 研究对象

本研究针对南京A大学大三和大四的30名本科生(15名女生和15名男生,专业涵盖工科、理科、艺术学、教育学等)展开,这些学生至少有一年的在线视频学习经历,充分掌握了在线视频学习的特点,具有较高的信息素养。此外,在选择研究对象时对其都进行了先验知识的测试,确保他们从未观看过本研究使用的学习视频,以减小实验误差。

2 研究工具

(1)视频内容的选择与评价

使用与满足(Uses and Gratification,U&G)理论认为,用户是积极的消费者,他们对自己的媒体消费有控制能力,并对自己的媒体使用、兴趣和动机有足够的自我意识,进而能够解读媒体并将其融入自己的日常生活中[17]。将U&G理论应用到教育媒体的视角中,可以认为学习者有意识地选择能够满足其学习需求的媒体。为了促使在线视频学习过程中学习者获得三种类型的满足(内容满足、过程满足和社会满足)[18],本研究对在线学习视频内容的选择经过了三轮预实验,第一轮和第二轮预实验依据“内容满足和过程满足”进行筛选,第三轮预实验依据“社会满足”(当视频使用能够形成和加深社会联系时获得的满足)进行筛选:第一轮通过访谈的方式(访谈对象为南京A大学进行视频资源研究的4名教师),确定在线学习视频内容为科普类的纪录片,时长为15~25分钟。第二轮通过初步筛选的方式确定纪录片主题,随机挑选南京A大学的4名硕士研究生观看各科普类纪录片,包括《局部》《家园》《地球脉动》《但是还有书籍》等,本研究根据U&G理论中三种满足类型设计了访谈题纲(访谈题目包含“您觉得视频内容呈现效果怎么样?”“视频中情节冲突设计的怎么样?”“看完后最想与谁分享?”等),4名硕士研究生一致认为《但是还有书籍》(共11集)纪录片更合适。第三轮预实验邀请另外10名硕士研究生观看这11集内容,并填写根据U&G理论设计的相应问卷,最后确定《成为漫画家》和《绘本中的奇妙世界》作为在线学习视频资源(每个视频时长30分钟)。

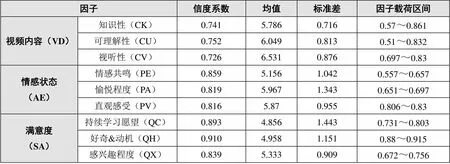

为了解学习者对视频内容的评价,本研究基于U&G理论设计“视频内容对情感状态影响的调查问卷”。问卷采用7分制李克特量表,共计25题,包含视频内容、情感状态、满意度3个因子。其中,视频内容包括知识性(视频内容丰富、视频内容翔实严谨、视频内容实用、补充完善自己的知识水平)、可理解性(贴近生活、直观形象、生动有趣、情节变化)、视听性(视觉感受、色彩搭配、音效效果、画面特效)3个维度;情感状态包括情感共鸣、愉悦程度和直观感受3个维度;一般来说,满意度是对先前期望和感知成就之间差异的感觉,依据Keller[19]对学习满意度的定义,本问卷中的满意度包括持续学习愿望、好奇&动机和感兴趣程度3个方面。通过KMO和Bartlett检验(KMO=0.755,<0.000)及载荷因子分析,发现问卷收敛效度良好;整体信度系数是0.929,各维度信度系数均大于0.7(如表1所示),表明问卷具有较好的信效度。

表1 调查问卷各因子的信度系数及描述性分析

(2)面部表情识别

为了实现在线视频学习环境中学习者面部表情数据的实时识别,本研究开发了基于Web的在线实时面部表情识别软件系统,系统中嵌入了Affectiva公司提供的面部识别插件Affdex SDK,并将面部表情识别的数据可视化。其中,Affdex SDK可以实时识别人脸的面部表情数据,并返回检测到的一组离散情绪的置信度值,它可以检测7种基本的离散情绪,即快乐、悲伤、惊讶、愤怒、恐惧、厌恶、蔑视。系统将识别到的情感状态数据存储于数据库,为后续可视化呈现及相关研究服务。为了让学习者了解自身在学习过程中的情感状态,系统借助Echarts库(使用JavaScript实现的开源可视化库)设计并实现了可视化功能模块,情感状态可视化的目的在于为学习者提供其时间趋势的情感状态变化图。

本研究自主开发的面部表情识别软件是非侵入式的,可以借助低成本的摄像头(如笔记本电脑内置摄像头)方便地部署于在线学习环境中,不会干扰学习者的学习过程。本研究根据在线视频学习过程中面部表情识别获得的数据,分析学习者的情感状态及相关的情感参数(情绪的效价、唤醒度及情绪转化阈值等)。

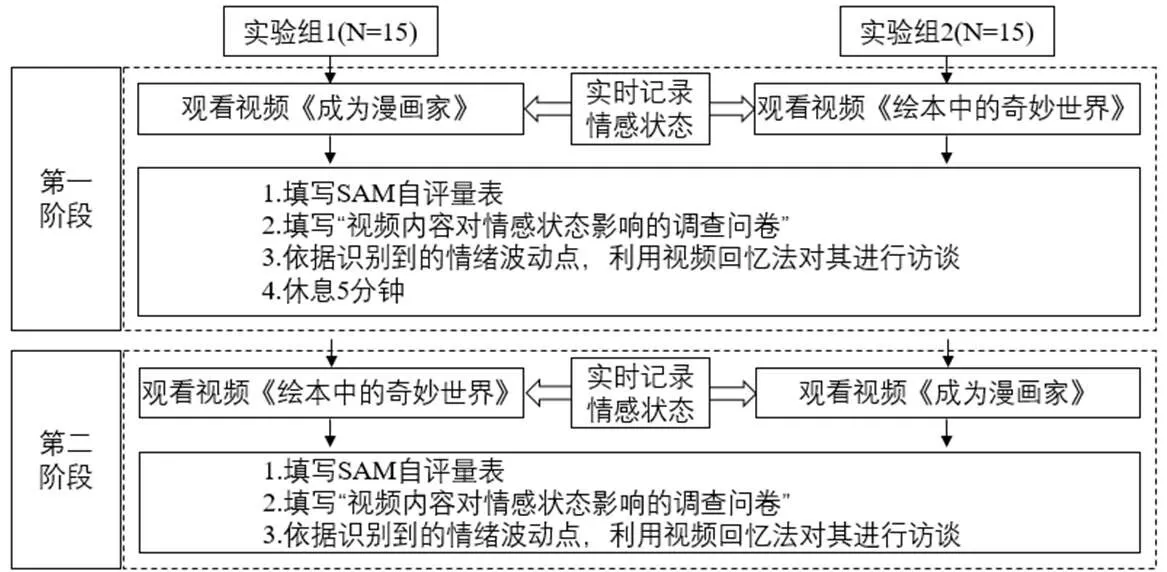

3 研究过程

考虑到每个视频时长约30分钟,本研究分两个阶段进行,各阶段除了视频内容不同,其他过程一致(如图1所示),具体为:①把研究对象随机分为两组(每组15人),每组观看的视频顺序不一样,以检验视频观看顺序对情感状态的影响是否有差异。②为收集学生在视频学习过程中的实时情感状态,本研究使用自主开发的软件并借助笔记本电脑内置摄像头实时记录其情感状态。③视频观看结束后,使用SAM量表请学生评估自身体验的效价水平和唤醒度。同时,对面部表情识别的情感状态数据进行相应处理后,结合SAM量表数据分析回答研究问题2。④通过“视频内容对情感状态影响的调查问卷”数据分析回答研究问题3。⑤根据识别到的情绪波动点,对学生进行访谈:“这一时间段情绪有波动,您看到这段视频时是什么样的情感状态?为什么会有这样的情感?”,结合情绪波动点的情感状态值和访谈数据的分析回答研究问题1。

图1 研究过程

三 研究结果

1 面部表情数据分析

本研究通过面部表情识别工具,共捕捉到2084个情感波动点(30名学生都观看了两个视频内容,每个视频内容时长30分钟左右)。根据情感波动点截取有效视频片段进行访谈,被试确认在此视频片段处存在情感波动的有效视频片段为1885个,情感波动识别错误的片段为199个,面部表情识别工具的准确率约为90.4%。

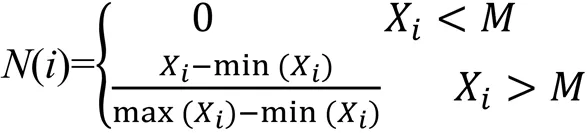

①进行归一化处理。根据有效情感波动点之时间节点对应的7种基本情感状态,将面部表情识别收集到的学习者实时的离散情感数据进行归一化处理,计算方法如公式(1)所示。

②将离散情感数据映射到二维模型空间中。依据Baldassarri等[20]提出的情感状态离散数据映射到Russell空间的方法,每条离散情感数值的效价与唤醒度坐标(,)的计算如公式(2)所示。

其中,()为归一化处理的结果,x是类二维坐标中情感效价的标准数值,y是类二维坐标中情感唤醒的标准数值。x与y的确定借鉴了中国科学院心理研究所设计的PAD情感量表(含7种离散情感的愉悦度与唤醒标准数值)[21],如表2所示。其中,P(x)表示愉悦度,A(y)表示唤醒度。

表2 离散情感对应的愉悦度与唤配度标准值

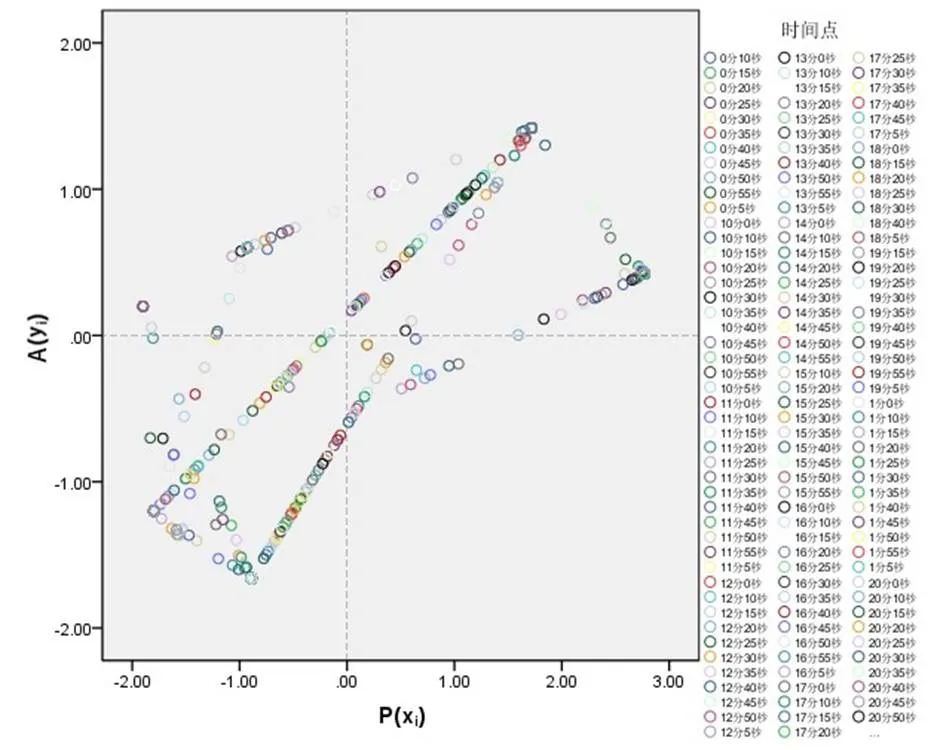

将所有数据代入上述公式,得到离散情感数据在Russell二维情感模型中的映射,《绘本中的奇妙世界》(视频1)的情感二维坐标如图2所示,《成为漫画家》(视频2)的情感二维坐标如图3所示。

图2 《绘本中的奇妙世界》的情感二维坐标

图3 《成为漫画家》的情感二维坐标

由图2和图3可以看出,视频1的面部表情识别结果集中于第一和第三象限,视频2的面部表情识别结果集中在第一、第二和第三象限,说明两个视频内容的整体唤醒度中等、愉悦度较高。根据Kort等[22]提出的认知-情感四象限空间模型,可得在线视频学习过程中的第一象限表明学习者对视频内容感到好奇和着迷,第二象限表明学习者在主动构建知识,而第三象限表明学习者解构原来的知识以保持学习的顺利进行。

2 SAM自评量表结果

根据描述性统计分析和相关性检验分析,得到愉悦度、唤醒度与控制度的相关结果如表3所示。表3显示,愉悦度、唤醒度和控制度的均值都超过了6分(满分为9分),表明视频内容学习过程中学习者的整体情感状态较好,这与面部表情数据分析的结果一致。相关性检验发现,愉悦度与唤醒度极其显著相关,愉悦度与控制度显著相关。

表3 愉悦度、唤醒度与控制度的相关分析结果

注:***表示<0.001,**表示<0.01,*表示<0.05,下同。

3 情感状态的作用机制分析

为了回答研究问题3,本研究首先进行了相关性分析,结果表明:视频内容、情感状态与满意度间都存在非常显著的正相关关系(<.01)。在此基础上进行回归分析,以探索情感状态对视频内容和满意度的中介作用,结果如表4所示。

表4 情感状态对视频内容和满意度的中介作用

表4显示,在第一步回归分析中,视频内容对满意度有极其显著的影响(β=0.522,<0.000);在第二步回归分析中,情感状态对满意度有极其显著的影响(β=0.655,<0.000);在第三步同时引入视频内容和情感状态后,视频内容对满意度的影响不显著(β=-0.038,>0.05),但情感状态对满意度的影响极其显著(β=0.684,<0.000),表明视频内容影响满意度的过程中情感状态具有完全中介作用。根据表4的内容,本研究绘制出视频内容、情感状态、满意度的结构方程模型,以便清晰地呈现三者间的关系,如图4所示。

图4 视频内容、情感状态、满意度的结构方程模型

四 研究结论

本研究探讨了在线视频学习过程中学习者的情感状态变化,以及视频内容、情感状态和满意度三者间的关系。研究结果表明,面部表情识别工具整体上能够高度准确地识别出学习者的情感波动;视频内容对学习者的情感状态和满意度有极其显著的影响,并且视频内容影响满意度的过程中情感状态具有完全中介作用。

1 面部表情识别工具可以较好地识别在线学习者的情感状态变化

本研究面部表情识别工具的准确率约为90.4%,表明非侵入式的面部表情识别工具借助低成本的摄像头可以方便地部署于在线学习环境中,不会干扰学习者的学习过程。借助面部表情识别工具获得的实时数据,一方面可以让学习者了解自身的参与情况和学习状态,另一方面也可以开发相应的工具(如适时反馈工具、定制学习体验工具等)以改善学习者体验,真正拓展学习空间。此类工具的应用意味着更多创新即将产生,如用于监控和检测远程学习者认知和情绪状态的人工智能工具,英特尔和Classroom Technologies正在合作开发的新型虚拟学校软件Class Collaborate,就可以分层应用于Zoom会议室,有望通过评估学生的面部表情和互动来检测他们是否感到无聊、分心或困惑[23]。Grafsgaard等[24]通过对学习者的微表情研究发现,通过表情强度和面部动作运动频率可以对学生学习情感状态进行有效性观察和检测,这为进一步提高学习过程中的面部情感识别应用提供了基础。

2 视频内容对学习者情感状态有极其显著的影响

问卷调查数据的回归分析表明,视频内容对学习者情感状态有极其显著的影响。同时,访谈过程中,98%的参与者表示,视频内容引发了他们强烈的情感共鸣、无论是视频内容还是视频呈现方式(如动画、配音、节奏感等)在吸引其注意力的同时也引发了一定的联想。这与当前针对基于视频学习的研究方向一致,即在扩展“传统”设计原则的同时,探索新颖的设计原则,并充分考虑学习者情感状态在视频学习中的作用。本研究的面部表情识别数据表明,视频内容中引起情感波动的时间大多集中于视频的开始阶段和中间阶段,结合参与者的回溯性访谈数据可知,视频开始阶段的讲述方式激发了学习者的好奇心,加之背景音乐和画面给人带来愉悦感,吸引了学习者的注意力,而视频中间阶段无论是视频内容还是视频呈现方式,都能较好地引起情感共鸣或联想。

此外,本研究的面部表情识别数据还表明在线视频学习者的整体唤醒度与愉悦度较高,这与SAM自评数据一致。过高或过低唤醒的情感状态都会干扰学习过程,而Lee等[25]的研究发现,基于视频异步学习的学习者反馈无聊的根源来自其与视频内容本身的互动,静态的呈现模式会使学习者处于低唤醒状态(如放松),进而很容易感到无聊。因此,视频内容的设计需要从维持学习者学习动机的角度考虑。通过教学视频改善学习成果的有效方法有两种:一是分段,即将视频分成更小且有意义的片段;二是混合视角,即从第一人称和第三人称混合拍摄[26]。本研究在视频内容选择的过程中,充分考虑了视频内容的分段(30分钟的视频分为三个小故事片段)和拍摄的混合视角(漫画家/绘本创作者的第一人称叙述及解说者第三人称视角)。

3 视频内容影响满意度的过程中情感状态具有完全中介作用

表4和图4的结果表明,在线视频学习过程中的视频内容对满意度有极其显著影响,视频内容影响满意度的过程中情感状态具有完全中介作用,这与荷兰对730名国际新生群体的调研结果“成就情绪在学生参与在线教育中起着重要的中介作用”一致[27]。访谈内容也表明,参与者与视频中的创作者产生了很强的同理心,“每个创作者都是值得被尊重的”;参考者纷纷表示后期会把《但是还有书籍》全集看完并且非常愿意推荐给他人,“视频的每一秒都长着翅膀,轻盈又落在地上”。

在远程和异步学习中,学习者的情感状态更为重要,是成功教育的关键因素。在线视频内容的设计与组织需要超越现有的用于程序学习的多媒体演示设计原则,“朝着更好地调整教学方法、学习材料、过程测量和学习结果测量的方向发展”[28]。一方面,可以通过激发学生对某一主题的兴趣和想象力来促进学习与创造,学习者的兴趣感可以将他们的注意力引导到对认知要求更高的信息寻求和问题解决行为上,帮助他们摆脱低唤醒的被动状态;另一方面,可以在视频讲座中插入更多认知要求更高的活动(如提出复杂的问题、自我解释)和有趣的例子,在最小化低唤醒状态(如放松、无聊、疲倦)的同时,引起一定程度的焦虑和兴趣,以获得积极的激活情绪(如好奇心和注意力)。

五 结语

在面对面的教学环境中,教师和学习者在教学空间中相遇,识别学习者的无聊、沮丧等情感状态,可以帮助教师解决学习者大部分的学习动机和兴趣问题。本研究开发的面部表情识别工具可以用于探索在线视频学习过程中的学习者情感状态,旨在为在线视频内容设计提供参考,但不足之处在于:①研究样本较少,导致结果的可推广性较低,下一步会尝试将其部署于本研究已创设的MOOC平台视频学习环境中以获取更多的数据;②虽然使用了面部表情识别数据分析学习者的情感状态,但面部表情识别因其自身的局限性无法很好地检测学习者的注意力变化过程,后续研究可以结合多模态数据(如眼动追踪、脑电信号)获得更客观的学习者学习状态数据;③仅从情感状态的角度探讨了在线视频学习过程中视频内容对满意度的影响,而没有考虑认知因素(如认知方式、任务难度等),后续研究需要进一步探讨在线视频学习过程中认知与情感的交互作用机制。此外,后续研究还可以收集非侵入性生理数据,如面部表情、眼动追踪、身体姿势等,开发情感状态识别和适应性系统,检查学习者的行为模式和情感状态,并借助相关反馈技术调整学习者的动机和注意力。

[1]Immordino-Yang M H. Emotions, learning, and the brain: Exploring the educational implications of affective neuroscience[M]. New York: W. W. Norton & Company, 2016:18.

[2]Ou C, Joyner D A, Geol A K. Designing and developing video lessons for online learning: A seven-principle model[J]. Online Learning Journal, 2019,(2):82-104.

[3]De Koning B B, Hoogerheide V, Boucheix J M. Developments and trends in learning with instructional video[J]. Computers in Human Behavior, 2018,89:395-398.

[4]Poquet O, Lim L, Mirriahi N. Video and learning: A systematic review(2007-2017)[A]. Proceedings of the 8th International Conference on Learning Analytics and Knowledge[C]. New York: Association for Computing Machinery, 2018:151-160.

[5]Wang Y, Liu Q, Stein D, et al. Measuring students affective states through online learning logs-an application of learning analytics[J]. International Journal of Information and Education Technology, 2019,(5):356-361.

[6]Akcapinar D, Bayazit A. Investigating video viewing behaviors of students with different learning approaches using video analytics[J]. Turkish Online Journal of Distance Education. 2018,(4):116-125.

[7]Soong S K A, Chan L K, Cheers C, et al. Impact of video recorded lectures among students[OL].

[8]Nagy J T. Evaluation of online video usage and learning satisfaction: An extension of the technology acceptance model[J]. International Review of Research in Open and Distance Learning. 2018,(1):160-185.

[9]Oluwalola F K. Effect of emotion on distance e-Learning——the fear of technology[J]. International Journal of Social Science and Humanity, 2015,(11):966-970.

[10]Schmitz B, Klug J, Schmidt M. Assessing self-regulated learning using diary measures with university students[A]. Handbook of Self-regulation of Learning and Performance[C]. London: Routledge, 2011:251-266.

[11]Ansari A, Montoya R, Netzer O. Dynamic learning in behavioral games: A hidden Markov mixture of experts approach[J]. Quantitative Marketing and Economics, 2012,(10):475-503.

[12]Pardos Z A, Baker R S J D, San P M O C Z, et al. Affective states and state tests: Investigating how affect throughout the school year predicts end of year learning outcomes[J]. Journal of Learning Analytics, 2014,(1):107-128.

[13]Russell J A. A circumplex model of affect[J]. Journal of Personality and Social Psychology, 1980,(6):1161-1178.

[14]Mejbri N, Essalmi F, Jemmi M. et al. Trends in the use of affective computing in e-learning environments[J]. Education and Information Technologies. 2022,(27):3867-3889.

[15]Ekman P, Friesen W V. Facial action coding system: A technique for the measurement of facial movement[M]. Palo Alto, CA: Consulting Psychologists Press, 1978:45-60.

[16]Bradley M M, Lang P J. Measuring emotion: The self-assessment manikin and the semantic differential[J]. Journal of Behavior Therapy and Experimental Psychiatry, 1994,(1):49-59.

[17]Levy M. The concept of audience activity[A]. Media Gratifications Research: Current Perspectives[C]. Beverly Hills, Calif: Sage Publications, 1985:109-122.

[18]Stafford T F, Staffor M R, Schkade L L. Determining uses and gratifications for the Internet[J]. Decision Sciences Journal of Innovative Education, 2004,(2):259-288.

[19]Keller J M. Motivational design of instruction[A]. Instructional Design Theories and Models: An Overview of Their Current Status[C]. New York: Routledge, 1983:386-434.

[20]Baldaasrri S, Hupont I, Abadia D, et al. Affective-aware tutoring platform for interactive digital television[J]. Multimedia Tools and Applications. 2015,(74):3183-3206.

[21]李晓明,傅小兰,邓国峰.中文简化版PAD情绪量表在京大学生中的初步试用[J].中国心理卫生杂志,2008,(5):327-329.

[22]Kort B, Reilly R, Picard R W. An affective model of interplay between emotions and learning: Reengineering educational pedagogy -building a learning companion[OL].

[23]刘聪.硬币的两面——人工智能助推职场归属感的前景探讨[OL].

[24]Grafsgaard J F, Wiggins J B, Boyer K E, et al. Automatically recognizing facial expression: Predicting engagement and frustration[A]. Educational Data Mining[C]. NY: IEEE, 2013:159-165.

[25]Lee J, So H, Ha S, et al. Unpacking academic emotions in asynchronous video-based learning: focusing on Korean learners’ affective experiences[J]. The Asia-Pacific Education Researcher, 2021,(30):247-261.

[26]Fiorella L, Mayer R E. What works and what doesn’t work with instructional video[J]. Computers in Human Behavior, 2018,89:465-470.

[27]Tempelaar D T, Niculescu A, Rienties B, et al. How achievement emotions impact students’ decisions for online learning, and what precedes those emotions[J]. The Internet and Higher Education, 2012,(3):161-169.

[28]Fiorella L, Mayer R E. What works and what doesn’t work with instructional video[J]. Computers in Human Behavior, 2018,89:465-470.

Study on the Recognition of Learners’ Affective States during Online Video Learning Process and the Influencing Factors

SHAN Mei-xian ZHANG Rui-yang

As an important factors affecting the quality of online video learning, learners’ affective states have been widely concerned by researchers. Although current data-driven research methods can provide important information about learners’ cognitive behaviors during online video learning process, the number of studies on learners’ affective state based on data during online video learning process and the influencing factors are very limited. Therefore, this paper firstly developed the facial expression recognition tool and examined the accuracy of the facial expression recognition tool. Then, according to the analyses of affective state data and SAM (Self-Assessment Manikin) self-report data, the changes of learners’ affective state during online video learning were grasped. Finally, questionnaire surveys and retrospective interviews were conducted to understand the influence of video content on learners’ affective states and satisfaction. The research showed that the facial expression recognition tool could identify learners’ emotional fluctuations with high accuracy on the whole, and video contents had a significant effect on learners’ affective states and satisfaction, and the affective states had a full mediation effect on video content and satisfaction. Through the research, this paper aimed to provide reference for online video content design, promote learners to maintain a high level of arousal and pleasure, and improve their online video learning experience.

online video learning; facial expression recognition; affective states; video content; satisfaction

G40-057

A

1009—8097(2023)12—0065—11

10.3969/j.issn.1009-8097.2023.12.007

本文为2023年度江苏省高校哲学社会科学研究重大项目“iVR学习环境中学习者的认知与情感交互作用机制研究”(项目编号:2023SJZD030)、2022年江苏省研究生教育教学改革课题“高校研究生课程思政有效教学的实证研究”(项目编号:JGKT22_C021)的阶段性研究成果。

单美贤,教授,博士,研究方向为学习过程中的情感状态分析,邮箱为shanmx@njupt.edu.cn。

2023年6月22日

编辑:小时