从公示到透明:算法公平的风险挑战与治理路径

赵精武,陆 睿

一、问题的提出

基于特定机器学习与数据训练优化的自动化决策系统已广泛应用于社会生活的各个场景。例如,电商平台利用个性化推荐算法为用户推送个人偏好的商品,银行通过信用评级算法决定是否通过贷款申请。商业营销活动越发依赖算法模型进行精准预测和行为量化评估,实现经营模式的转型升级以及潜在客户的挖掘。然而,人工智能技术的大规模应用也带来了歧视数字化的法律风险。算法设计的效率导向、数据训练集合遭受污染以及算法黑箱之透明度缺失等因素共同导致了算法不公的现象(1)崔靖梓:《算法歧视挑战下平等权保护的危机与应对》,《法律科学》(西北政法大学学报)2019年第3期。,不仅会损害公众基本权利、侵害特定个体的民事权益,还会影响公平竞争秩序。

在域外,算法不公问题通常意味着严重的社会偏见以及侵害平等权的不利后果。2016年,美国媒体Pro Publica调查发现COMPASS系统更容易对黑人罪犯的再犯率形成错判,错判为再犯的比率是白人罪犯的两倍。(2)Julia Angwin,Jeff Larson,Surya Mattu and Lauren Kirchner,Machine Bias:There’s Software Used Across the Country to Predict Future Criminals and It’s Biased Against Blacks,https:∥www.propublica.org/article/machine-bias-riskassessments-in-criminal-sentencing,最后访问时间:2023年8月9日。好事达保险公司曾因信用评分程序对白种人用户的利率优待受到指控。(3)Dehoyos v.Allstate Corp.,No.02-50721,2002 WL 1491650,at *1 (W.D.Tex.Apr.5,2002).苹果公司推出的AppleCard信用卡上线后,发现即使女性与男性的财务状况和信用风险相似,其获得的信用额度也明显低于男性。苹果联合创始人史蒂夫·沃兹尼亚克曾表示,他获得的信用额度是他妻子的10倍。(4)See CNN Business:Apple Co-Founder Steve Wozniak Says Apple Card Discriminated Against His Wife,https://www.cnn.com/2019/11/10/business/goldman-sachs-apple-card-discrimination/index.html,最后访问时间:2023年8月11日。根据《卫报》对谷歌推送的“年薪20万美元以上职位”的广告数据统计,男性互联网用户组收到1 852次推送,女性互联网用户仅收到318次,相差近6倍。(5)Kim P.T.,“Data-Driven Discrimination at Work”,William &Mary Law Review,Vol.58,2016,p.857.亚马逊凭借出色的数据分析能力与动态定价模型,利用Cookie跟踪用户的浏览痕迹,以“价格实验”的名义系统评估不同用户的心理承受价位,对购买意愿强烈且对价格涨跌相对不敏感的老用户收取更高费用,最大限度榨取消费者剩余,令个体难以察觉财产损失。(6)[英]阿里尔·扎拉奇、[美]莫里斯·E·斯图克著,余潇译:《算法的陷阱:超级平台、算法垄断与场景欺骗》,北京:中信出版社2018年版,第18—19页。在国内,对算法公平问题的探讨以平台价格歧视与平台自我优待为主。2021年胡某芳诉上海携程商务有限公司案(7)浙江省绍兴市中级人民法院(2021)浙06民终3129号民事判决书。引发社会各界对“大数据杀熟”现象的广泛关注。隐蔽的个性化服务不仅侵害消费者合法权益,也侵害了平台内企业用户的公平竞争利益。在2020年“赵某某诉浙江淘宝网络有限公司网络服务合同纠纷案”(8)杭州互联网法院(2020)浙0192民初2295号民事判决书。中,原告认为平台利用自身的数据、技术优势,暗自利用算法在流量分配、搜索排名等方面为竞争对手设置障碍和限制,影响平台内经营者的公平交易秩序。

学界对算法不公现象已达成诸多共识:算法不公的成因具有多样性,既包括不适当的数据标注行为、先入为主的主体类型划分、存在歧视性内容的数据训练集合等技术因素,也包括滥用算法模型的预测功能、唯数据主义、大数据杀熟等非技术因素。并且,在探讨算法公平治理模式的过程中,学者们的观点逐渐趋于一致,即通过算法备案、算法公示、算法解释、算法安全风险评估以及科技伦理审查等制度强化算法应用的透明度,达成算法决策结果的可接受性。《个人信息保护法》《电子商务法》《反垄断法》《互联网信息服务算法推荐管理规定》《常见类型移动互联网应用程序必要个人信息范围规定》等立法规范也对消费者保护、大小商户利益平衡、信息不对称的矫正等问题积极回应。遗憾的是,学界侧重算法公平治理体系的建构,却忽视了制度建构的前置性问题,即究竟什么是法律意义上的算法不公。客观而言,绝对公平不是真正意义上的公平,适当的主体类型划分本身也是公平的另一种表现形式,故而有必要先行明确法律意义上算法不公的认定标准,之后再根据认定要素确定相对应的治理机制。然而,现有的学理解释要么是以碎片化的场景实例列举算法不公类型,要么将算法不公解释为笼统抽象的不公平风险,未能触及算法不公的法律特征,导致算法公平的研究总体停留在风险控制层面,难以向具体规制层面迈进。(9)宁园:《算法歧视的认定标准》,《武汉大学学报》(哲学社会科学版)2022年第6期。此外,现有法律规范或是仅有原则性的价值宣示,或是在规制对象、规制行为上有所限定,又或是构成要件证明难度大,无法全面保护个体平等权与公平竞争秩序。例如,算法透明原则在多部法规政策中均有体现,但具体透明到何种程度、解释与透明的区别、违反透明义务的责任等细节问题语焉不详。

本文从算法不公的触发机制切入,对算法不公的判定依据进行研究与反思,探讨经营者滥用算法技术的具体规制方案,同时以澄清算法透明原则的功能定位为核心,防止歧视风险向实害结果转化,提升自动化决策的数据合法性、程序正当性与结果公平性。

二、算法不公的技术成因与制度盲区

随着智能社会的到来,作为主体的人正在被数据化与客体化。(10)John Cheney-Lippold,We Are Data:Algorithms and the Making of Our Digital Selves,New York:New York University Press,2017,p.141.算法运作机理一般展现为“算法初始化模型的建构——训练数据的输入——算法进行自主训练——输入验证数据,验证算法结果——算法模型迭代优化——成熟的算法应用”。(11)孟令宇:《从算法偏见到算法歧视:算法歧视的责任问题探究》,《东北大学学报》(社会科学版)2022年第1期。难以消除的既存偏见导致数据输入和算法设计中的歧视无法避免,算法决策的类型化思维形成的群体歧视又将进一步放大同一范畴内部的相似性与不同范畴之间的差异性。

(一)算法不公的产生根源

关于算法不公的成因,一个共识性的观点为:自算法模型训练之初,训练数据集合、产品研发者就不可避免地存在或多或少的歧视性因素。最为无奈的是,这种歧视因素的渗入往往并不是业务人员的主观故意造成的,而是以一种社会性常识的方式潜移默化地影响算法模型输出结果。算法分类决策的规模化应用以及算法服务提供者与用户之间的关系异化,是歧视分配风险大大增加的系统诱因。

1.偏见来源:数据、算法、人工

巴蒂亚·弗莱德曼和海伦·尼森鲍姆以时间和社会技术性因素为标准,提出既存偏见(preexisting bias)、技术性偏见(technical bias)与新生偏见(emergent bias)三种计算偏见类型。其一,既存偏见是指人类社会固有的歧视性因素。因为人类作为算法的设计者,固有的价值观与偏见不可避免地会嵌入程序指令,例如“黑人犯罪率高于白人”“女性受教育程度低于男性”等等。其二,技术性偏见源于技术手段和设备的限制性因素,将话语、判断或直觉等非结构化的价值内容加以计算将会不可避免地与最初目标产生偏移。其三,新生偏见起因于应用场景的“时过境迁”,即原有的智能系统落后于社会发展,从而产生一定的认知偏差。(12)Friedman,Batya,and Helen Nissenbaum,“Bias in Computer Systems”,ACM Transactions on Information Systems (TOIS),Vol.14,No.3,1996,pp.330-347.从算法流程的主要构成来看,数据、算法、人工三个方面均可能导致最终歧视性结果的输出,形成对特定个体或群体的不利结果。

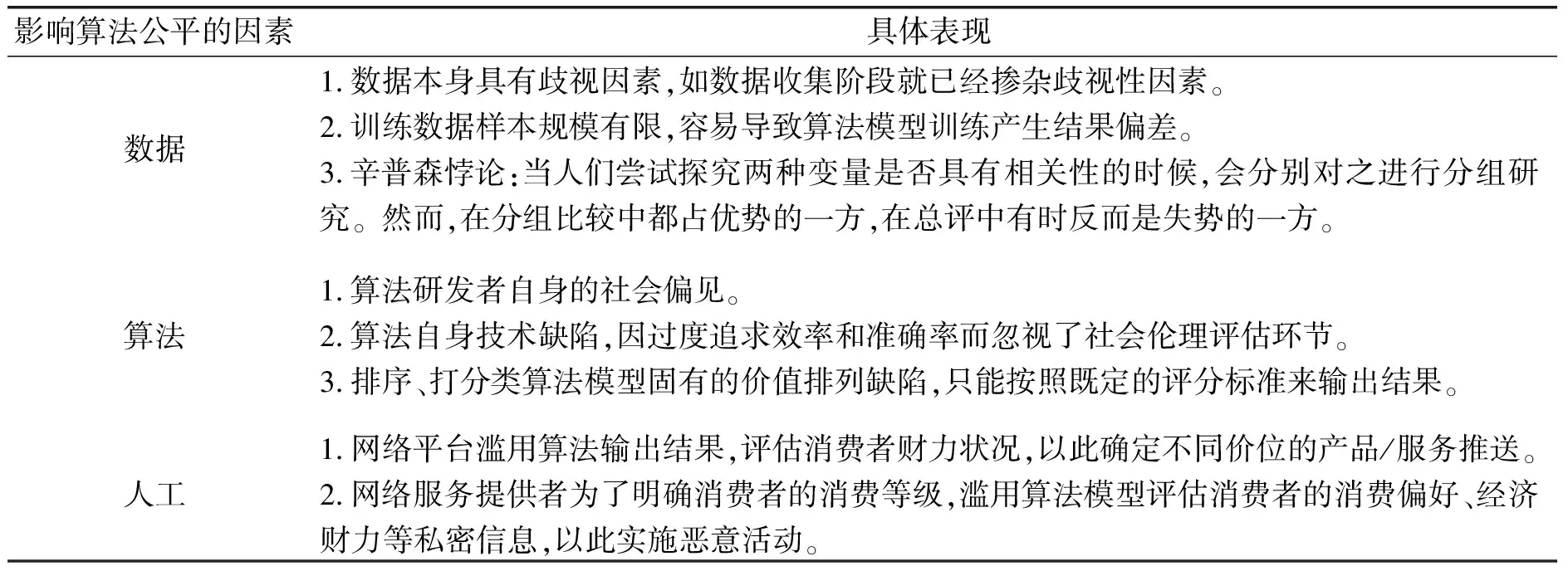

表1 影响算法公平的因素与具体表现

数据、算法、人工处理等诸多环节不可避免地会存在社会歧视性要素,加之部分应用场景下,算法应用所采取的量化排序方式本身与不可量化的价值衡量就存在冲突。然而,算法自身存在的歧视、偏见因素不应当成为限制或削弱少数群体、弱势群体合法权益的理由,技术中立也不能成为企业规避侵权责任的避风港。当偏见风险现实化为不正当竞争行为或侵权实害结果时,“必须揭开算法技术的面纱,穿透式地进行要素监管”(13)张凌寒:《平台“穿透式监管”的理据及限度》,《法律科学》(西北政法大学学报)2022年第1期。。

2.技术根源:分类决策与群体标签

分类算法是最基本的机器学习技术之一,其应用目的是通过对数据集进行类别划分来达成数据分析与预测的功能。相对地,这种通过提取受保护特征来对不同群体进行分类造成的算法歧视,被称为“分类偏差”。(14)Kim P.T.,“Data-Driven Discrimination at Work”,William &Mary Law Review,Vol.58,2016,p.857.互联网巨头收集数据的经济动机并不纯粹是为了获得个体的用户画像,同时也是为了尽可能发现“数据主体与他人之间的社交关系和群体特征”。(15)赵精武:《用户标签的法律性质与治理逻辑》,《现代法学》2022年第6期。分类决策所导致的算法不公主要表现为群体分类标准的不恰当,例如将算法设计者的个人偏好纳入分类因素。在算法决策分析过程中,特定个体或弱势群体极易受到负面刻板印象影响以及第三者行为牵连。当同一标签下的个体做出新的信息搜索行为时,其所在的特定群体可能都将成为算法歧视的对象,如被保险公司标注为“高风险群体”进而提高保费(16)Alessandro Mantelero,“From Group Privacy to Collective Privacy:Towards a New Dimension of Privacy and Data Protection in the Big Data era”,in Taylor L.,Floridi L.,Van der Sloot B.,Group privacy,New York:Spinger International Publishing,2017,pp.139-158.,或被标签化定义为“缺乏足够消费能力”或者“低消费者能力”,其实际能够获得的信息服务内容和类型将受到限制。此前,爱奇艺、优酷、腾讯等视频网站因对不同手机品牌设置差异化的会员规则(苹果用户不能按影片价格自由充值、取消会员操作频繁)而被浙江省消保委约谈,并着手整改相关问题。(17)浙江消保委:《7家视频网站按期提交整改报告 苹果用户充值金额固定、退订繁琐问题取得突破》,https:∥mp.weixin.qq.com/s/djQ4WqJiSvWjkXpvAXs3dw,最后访问时间:2023年9月4日。牛津学者布莱斯·古德曼和赛斯·弗兰斯曼认为,“在一定意义上,运用算法画像来进行资源分配本质上就具有歧视性:当数据主体根据各种变量进行分组时,歧视的风险就产生了”(18)Goodman B.,Flaxman S.,“European Union Regulations on Algorithmic Decision-Making and a ‘Right to Explanation’”,AI Magazine,Vol.38,No.3,2017,pp.50-57.。

(二)算法不公的认定难题

算法不公认定标准的失衡既可能造成个体救济无门,也可能导致算法服务提供者责任的不当加重,激化算法利用与算法公平的价值对立。算法不公的认定标准存在人为识别与法律识别两方面的阻碍。

在人为识别方面,算法歧视高度隐秘,个体不易察觉,也难以举证,维权困难。从微观角度看,算法的广泛应用使公众愈发依赖算法进行分析、预测、决策,甚至沉迷于算法推荐的信息之中,处于信息茧房而不自知。(19)刘友华:《算法偏见及其规制路径研究》,《法学杂志》2019年第6期。《人物》杂志的文章《外卖骑手,困在系统里》揭露了外卖平台利用算法变相缩减外卖骑手休闲时间的现象。算法自动化决策系统的背后往往由数个产业部门、数个数据库相互联结,多专业联合的运行方式增加了算法的复杂性,一般人在节约思维成本的导向下常常会自愿服从且相信算法的安排,只有通过比较和大规模统计才能得出算法是否公平的结论。(20)崔靖梓:《算法歧视挑战下平等权保护的危机与应对》,《法律科学》(西北政法大学学报)2019年第3期;托马斯·维施迈尔著,马可译,赵精武校:《人工智能系统的规制》,《法治社会》2021年第5期。

在法律识别方面,是否构成算法不公需结合归类要素进行判定。算法归类可能是几种要素的结合,包括合法性要素与歧视性要素,难以将其分割评价。在我国本土制度语境下,算法不公更多地表现为对消费者群体的歧视和偏见,其中以价格歧视最为突出。在市场经济中,基于不同群体的差异化定价可能是一种常见的经营策略。比如,旅游景点对学生和老人收取半票;店铺会员有权享受一定折扣等。在很多经济学家看来,个性化定价还将带来增进社会福利、加剧市场竞争、提升产出和回收成本等益处,其经济效果具有复杂性(21)王先林、曹汇:《数字平台个性化定价的反垄断规制》,《山东大学学报》(哲学社会科学版)2022年第4期。,这也是司法部门在“大数据杀熟”侵权认定上态度相对保守的根本原因。例如,2019年“刘权与北京三快科技有限公司侵权责任纠纷”案中,原告刘权认为三快科技公司利用行业垄断优势和“大数据杀熟”的技术手段区别定价,侵犯其合法权益,同时违反了《中华人民共和国反垄断法》的相关规定。二审法院却认为,外卖配送费是动态调整的,刘权与其同事下单时间不同,存在微小的配送费差异无可非议。(22)湖南省长沙市中级人民法院(2019)湘01民终9501号民事判决书。2020年“郑育高与上海携程商务有限公司侵权责任纠纷案”,二审法院认为,郑育高未能提供相应的证据佐证携程利用网络优势擅自更改机票价格,侵犯其知情权、公平交易权,应自行承担举证不能的法律后果。机票价格受市场因素等影响,存在价格浮动的情形是正常的市场经济现象。郑育高查询机票价格的时间存在一定间隔,票价的变动幅度也在合理范围内,故郑育高认为此价格波动系携程平台人为操控所致缺乏依据。(23)上海市第一中级人民法院(2020)沪01民终13989号民事判决书。

从现有司法案例来看,法院在算法不公的认定中相对谨慎,对于浮动定价等情形并非直接判定违法,而是结合市场经济规律对差异化定价的合理性进行判断。若确实存在不合理高价,再根据消费者保护、反垄断等不同法律规制方案进行区分处理。例如,在2021年“大数据杀熟第一案”(胡某芳诉上海携程商务有限公司侵权责任纠纷案)(24)浙江省绍兴市中级人民法院(2021)浙06民终3129号民事判决书。中,法院认为,携程公司未依法以显著标识将自营业务与他营业务予以区分,向消费者做出低价承诺以获得信赖,却未告知消费者其业务分布情况,违反告知义务,使当事人陷入对象错误,进而做出不真实意思表示。此外,携程公司作为平台主体怠于对第三方代理商房源价格进行监管,因此认定携程公司的行为构成欺诈。其“强制且不指明具体内容”的信息收集方式不当,符合个人信息侵权行为的构成要件,但基于损害填补原则,对携程平台给予否定性评价并要求其承担惩罚性赔偿已经可以达到消费者使用APP的预期效果和合同订立初衷,因此对胡某芳超出权利救济范围的诉请不予支持。略为遗憾的是,本案的一审及二审法院对携程差异化定价应用是否存在算法不公的问题均没有进行深入讨论,而是绕开大数据杀熟的行为定性,直接讨论平台报价是否构成《消费者权益保护法》中的价格欺诈。究其原因,一方面是大数据杀熟本身举证困难,另一方面是本案发生于《个人信息保护法》正式生效之前,算法问责的基本框架尚未确立,消费者维权缺乏法律依据,这也是当前算法公平治理体系中的疏漏之处。

(三)现行治理体系的调整盲区

我国当前算法不公的法律治理存在事前规制方式有限、事后追责路径单一的困局。(25)袁文全:《算法歧视的侵权责任治理》,《兰州大学学报》(社会科学版)2023年第2期。首先,我国《个人信息保护法》《电子商务法》初步勾勒出算法规制的大致框架,却仅适用于利用特定个人信息的自动化决策,难以应对大数据系统强化群体属性的决策特征(26)Grindrod P.,Mathematical Underpinnings of Analytics:Theory and Applications,Oxford:OUP Oxford,2014.。在大数据系统支持下,个人电子交易轨迹转变为消费能力差异,身体健康状况体现于保费数额分级,算法技术的互动对象是一个类别而非独立个体(27)黄柏恒:《大数据时代下新的“个人决定”与“知情同意”》,《哲学分析》2017年第6期。,由此产生的算法不公难以为《个人信息保护法》所覆盖。其次,“算法推荐服务提供者”“电子商务经营者”“网络经营者”等多种算法公平义务主体的代称模糊了算法技术设计者与使用者的边界,导致司法部门适用法律时无所适从。再次,对于数字平台实践中出现的链接封禁、优先展示、数据屏蔽等众多争议问题,法规政策还未能予以及时回应。2022年6月,国家市场监督管理总局发布《禁止滥用市场支配地位行为规定(征求意见稿)》,其中第20条对平台自我优待进行了规定并列举了两种情形,该条规定“禁止具有市场支配地位的平台经营者利用数据和算法、技术以及平台规则等,没有正当理由,在与该平台内经营者竞争时,对自身给予下列优惠待遇:(一)对自身商品给予优先展示或者排序;(二)利用平台内经营者的非公开数据,开发自身商品或者辅助自身决策”。这一局部列举是否具有完备性值得讨论,因此在最终正式颁行的法规中未能实现这一立法尝试,而是删除了该条规则。自我优待,是指平台经营者利用横跨上下游市场的双重身份给自己或关联公司提供更加有利的条件或更优惠的待遇。(28)周围:《规制平台封禁行为的反垄断法分析——基于自我优待的视角》,《法学》2022年第7期。由于平台内经营者对数字平台的依赖性以及数字平台生态系统跨市场的特征,执法者在使用传统的反垄断法概念工具时,难以将其纳入分析框架。(29)刘晓春:《数字平台自我优待的法律规制》,《法律科学》(西北政法大学学报)2023年第1期。考虑到竞争行为的复杂性,平台对自营企业给予优惠待遇并不当然违背竞争机制,只有盗取第三方卖家未公开的商业数据、对竞争对手采取外联屏蔽等滥用平台管理职能的行为才需要加以严格的法律制约。此种分类处理模式尚未得到立法确认,互联网平台盗用平台内经营者的未公开数据等不当行为仍游走在合法与不法之间的灰色地带。最后,由于个体主张侵权损害赔偿证明较为困难,我国在算法问责方面更加强调公权力机关的监管作用,由行政部门施以责令限期改正、没收违法所得、罚款等惩罚性措施。这使得权益实际受损方处于寄希望于公职部门执法的消极被动地位,无法获得及时有效救济。(30)袁文全:《算法歧视的侵权责任治理》,《兰州大学学报》(社会科学版)2023年第2期。

综上所述,算法不公的认定标准需要结合主体分类模式与业务应用场景进行个性化判断。这种认定标准的细化实质上也是算法透明监管目标的表现形式之一,即在明确算法应用为何不公的基础上,判断算法服务研发者和提供者各自的法律责任以及在算法安全风险评估中判断安全风险的实际来源。

三、算法不公的认定标准与技术

算法公平问题实际上与具体实践相关,而非传统意义上的公平观念问题。(31)Hellman,Deborah,“Measuring Algorithmic Fairness”,Virginia Law Review,Vol.106,No.4,2020,pp.811-866.算法公平通常包含两种理解方式:一是算法的输出结果应当对所有人同样准确,二是算法的输出结果应当为不同组别的人群预留相同比例的错误率,以此实现真正意义上的公平。然而,这种量化意义上的算法公平难以实现,因为事前不按照某种标准对人群分组,进行“有区分”的对待,算法输出结果的可靠性和准确性难以保证。由于算法训练所运用的数据无须公开,算法服务提供者的歧视意图往往难以识别,因此更应从行为与效果角度判别算法歧视。算法不公以群体特征提取与分类为形式要件,针对算法造成的歧视危害,参考美国平等权三重审查模式以及德国恣意禁止原则、比例原则的价值评价公式,构建形式要件、实质要件、例外规则的体系性审查思路。在进行考量因素的合理性判断时,应结合具体场景采取细分认定标准,例如平台经济中的“合理原则”(32)丁茂中:《自我优待的反垄断规制问题》,《法学论坛》2022年第4期。、就业招聘中的“激励因素”与“显著性检验”规则(33)侯玲玲、王超:《人工智能:就业歧视法律规制的新挑战及其应对》,《华东理工大学学报》(社会科学版)2021年第1期。。

(一)形式要件:显著不公的分类标准

根据多样化场景需要,自动化决策发挥着优先级配置、分类、关联以及过滤四项功能,将个体的线上、线下数据进行整合,形成对特定主体行为偏好的精准预测和评估,并可依据解析出的数据将其归入到特定的类别和群组中。(34)Guidelines on Automated Individual Decision-Making and Profiling for the Purpose of Regulation 2016/679,https:∥ec.europa.eu/newsroom/article29/item-detail.cfm?item_id=612053,最后访问时间:2023年9月12日。在经由算法产生的差别待遇中,有先进行用户分类后区分决策的直接歧视,也有表面上平等适用于每个用户,结果上却存在差异的间接歧视。(35)宁园:《算法歧视的认定标准》,《武汉大学学报》(哲学社会科学版)2022年第6期。与中立特征关联的数据可能是身份化了的。基于集体身份的资源配置格局无形中限定了个人决策的空间。具备相同集体身份的个体占有相似的资源,即使彼此没有意思联络,亦会自发呈现相似的决策偏好。(36)李成:《人工智能歧视的法律治理》,《中国法学》2021年第2期。与传统显性歧视(例如性别、种族、年龄、国籍歧视)不同,自动化决策系统更多以能力、偏好、习惯等隐性特征作为分类依据,增加不公平对待的潜在危害。错误识别用户特点显然会导致不公平决策,例如将居住于贫困地区的富人识别为穷人,再如儿童安全和风险评估系统预测的不准确性导致儿童被父母虐杀等恶性事件未能得到有效干预。(37)David Jackson,Gary Marx,Data Mining Program Designed to Predict Child Abuse Proves Unreliable,DCFS Says,Chicago Tribune (6 December 2017),http:∥www.chicagotribune.com/news/watchdog/ct-dcfs-eckerd-met-20171206-story.html,最后访问时间:2023年8月16日。即便是正确识别与分类也有可能在缺乏正当理由的情况下造成结构性歧视,因此需要根据是否存在差别性不利后果以及差别对待的合理性进行实质判断。

(二)实质要件:差别性不利后果

算法不公构成的实质要件为,相同条件下部分个体或群体遭受资源机会减少等不利后果。2019年,意大利外卖平台公司(Deliveroo)骑手案被称为“算法歧视第一案”。原告认为,被告公司使用的算法在对骑手进行荣誉排名时并不考虑骑手未能及时送达餐品的原因,如参加罢工、突发疾病、未成年子女需求等其他合法原因导致延迟取消预订或没有取消预订,进而使其评分排名降低,丧失优先选择工作条件的机会。原告请求法院对被告的歧视行为加以确认,并要求被告制定消除歧视的方案、修改自助预订系统、对上述歧视行为给原告造成的非财产性损害进行赔偿、采取一切适当措施消除影响。法院认为该公司所使用的数字送餐平台系统在对骑手进行荣誉排名时并未考虑骑手延时的正当事由,确实存在集体性算法歧视问题。(38)Giuseppina Mattiello,Riders:la piattaforma Deliveroo e discriminatoria,Altalex,https://www.altalex.com/documents/news/2021/01/15/riders-piattaforma-deliveroo-discriminatoria,最后访问时间:2023年9月13日。美国智慧司法辅助量刑系统COMPAS的公平性多次受到质疑,不同机构的调查基本坐实了它基于种族、年龄、性别等上百个因素预测评估再犯可能性时极有可能对黑人造成歧视。白人更多被错误地评估为具有低犯罪风险,而黑人被错误地评估为具有高犯罪风险的概率两倍于白人,导致其无法享有减刑假释等奖励政策。(39)Julia Angwin,Jeff Larson,Surya Mattu and Lauren Kirchner,Machine Bias:There’s Software Used across the Country to Predict Future Criminals and It’s Biased AgainstBlacks,https:∥www.propublica.org/article/machine-bias-riskassessments-in-criminal-sentencing,最后访问时间:2023年8月9日。

(三)例外规则:合理的差别待遇

《反垄断法》第22条第1款第6项、《个人信息保护法》第24条第1款规定了禁止不合理差别待遇规则,即没有正当理由,不得对条件相同的交易相对人在价格方面实行差别待遇。若某一特定因素或数据变量真实准确地影响到决策的绩效,算法模型的开发者与运用者必须证明该考量因素与特定决策之间具有正当性。(40)张恩典:《反算法歧视:理论反思与制度建构》,《华中科技大学学报》(社会科学版)2020年第5期。对此,美国与德国的基础权利审查框架可供参考。美国采取“严格审查、中度审查与合理审查”的多元审查基准,对于自由权、平等权等基础性权利以及涉及种族、肤色等“嫌疑分类”(suspect classification)的平等权案件需要施以严格的司法审查,政府必须证明差别对待是基于重大迫切利益之必要且不存在其他替代选项;涉及性别、非婚生子女保护等“准嫌疑分类”(quasi-suspect classification)属于中度审查范围,这一基准要求政府行为必须以追求“重要或实质的政府利益”(important/substantial governmental interest)为目的,手段与目的之间具有实质关联;合理审查是最基本、默认的审查基准,适用于所有未被归入其他审查基准的“一般分类”案件,国家权力机关仅需证明立法并非随心所欲或存在明显重大瑕疵,并且手段与目的之间具备合理关联。(41)杨登杰:《执中行权的宪法比例原则 兼与美国多元审查基准比较》,《中外法学》2015年第2期;刘原田:《美国与德国行政法中平等原则的审查模式之比较及其对中国的借鉴》,《法治社会》2018年第6期。德国宪法中平等权案件的分析步骤通常分为两步,第一步对是否存在差别对待进行事实判断,第二步分析上述差别对待能否在宪法上予以正当化,可以考虑应用恣意禁止与比例原则两种审查公式。恣意禁止的内涵为,如果对于立法的不同或相同对待找不到一个理性的、基于事物本质的或者无论何种实质上合理的理由,那么就可以说该规定是恣意的,也就违反了平等。(42)BVerf GE 1,52;3,135f.自20世纪80年代起,德国联邦宪法法院考虑引入比例原则进行价值权衡,当国家对不同群体进行区别对待且这两个群体间不存在特征和权重上的不同而足以正当化这种不同对待时,平等权即受到侵犯。(43)BVerf GE 55,88;82,86.美国与德国均未采取单一性的审查标准,而是进行不同强度的审查,应用于算法歧视的认定标准构建中,也应满足消费者保护、公平竞争、司法正当程序等不同层次的正当化要求。

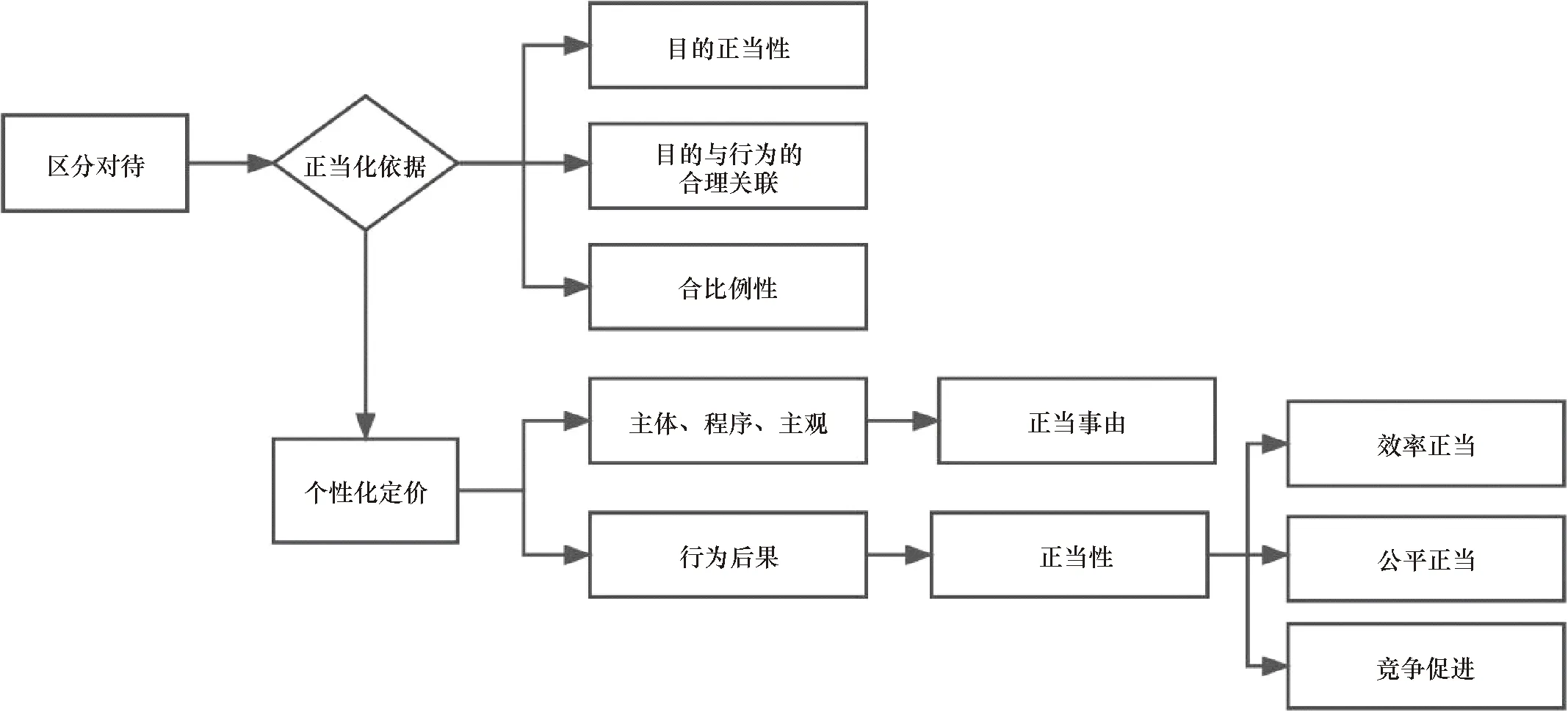

区分对待的正当性证明主要涉及三方面:一是差别对待的目的正当性,二是差别对待目的与区分事由之间的合理关联性,三是差别对待的合比例性。(44)宁园:《算法歧视的认定标准》,《武汉大学学报》(哲学社会科学版)2022年第6期。正当目的包括个性化广告推送意在精准吸引潜在消费者,贷款信用评分意在降低坏账风险等。合理关联性如信贷资格的分配与用户的守约程度之间具有合理关联,但与用户的消费习惯则无必要关联,尽管后者可能反映用户的经济水平和消费理性程度,却并非实质的交易条件。合理关联性还要求算法服务提供者证明不存在其他可替代的、能够防止或者缓解不利后果的区分事由。若用户提出了可替代性事由或其他相反证明,则算法服务提供者依然构成歧视。在1975年美国阿尔伯马尔纸业公司诉穆迪(Albemarle Paper Co.v.Moody)案中,联邦最高法院认为雇主虽然证明了就业能力测试算法与工作有关,但存在使用其他不会导致种族歧视的替代性测试程序的可能,因此该公司依然符合算法就业歧视的客观构成要件。(45)Albemarle Paper Co.v.Moody,422 U.S.405 (Del.1975)合比例性要求算法服务提供者在复合区分因素中设置合理权重,某项因素的作用程度应与其所生后果的差别性和不利程度相匹配。以征信评分算法为例,以守约指数、安全指数、资产状况、消费习惯以及社交关系作为评价指标。其中,守约指数与信用评分的关联最为紧密,在信用评估中应占最高权重,其他存在间接的、不稳定的关联因素的权重设置相应偏低,性别、种族等与信用评级无关的因素则不应被考虑在内。

在数字经济中,个性化定价的正当理由至少可以从主体、主观方面、行为后果和认定程序等角度进行考察。行为后果上的正当性又可以进一步划分为效率上的正当性、公平上的正当性、竞争促进上的正当性。(46)肖江平:《滥用市场支配地位行为认定中的“正当理由”》,《法商研究》2009年第5期。国家市场监督管理总局《关于平台经济领域的反垄断指南》第17条提出,交易相对人的隐私信息、交易历史、个体偏好、消费习惯等方面存在的差异不能够成为差异定价的影响因素。这实际上是对消费者“条件相同”的普遍推定,尊重和捍卫消费者公平交易权。差别定价的合理考量因素包括:根据交易相对人实际需求且符合正当的交易习惯和行业惯例,实行不同交易条件;针对新用户在合理期限内开展优惠活动;基于平台公平、合理、无歧视的规则实施随机性交易,以及其他基于正当性理由的区分对待。正当理由分析方法不同于竞争效果分析方法,存在正当理由与否的判断本质上是对行为自身合法性的评价,最终产生类似于合理原则的效果。(47)许身健、郜庆:《反垄断视阈下的算法价格歧视问题》,《中国法律评论》2022年第3期。上海市市场监督管理局也曾在《上海市网络交易平台网络营销活动算法应用指引(试行)》中对参数设置、消费者画像等方面提出监管要求,一是网络交易平台经营者不应将浏览次数、支付意愿、支付能力、依赖程度、交易频次、交易时使用的终端设备品牌等作为与消费者进行交易的条件参数。二是确保消费者画像和数据标准体系来源合法,尊重消费者人格尊严,避免使用有违社会公德、歧视性、偏见性的用户标签,发现消费者画像存在错误的,有必要及时进行修改。在就业歧视的裁判标准上,联邦最高法院曾提出“激励因素”和“显著性检验”规则,前者是指当原告证明性别(或其他受保护的个人特征)是就业招聘决定中的“激励因素”时,就达到了一般就业歧视的证明标准,“显著性检验”是指造成差别影响的分类因素(如年龄、身体健康、婚姻状况)必须达到统计学上的显著性。(48)Hazelwood School Dist.v.United States,433 U.S.299(Del.1977).

图1 区分对待的正当性检验框架

四、算法透明的理念澄清与制度重构

近年来,算法监管制度建设不断推进,FAT(fairness,accountability,and transparency)成为人工智能治理新原则。国家新一代人工智能治理专业委员会《新一代人工智能治理原则:发展负责任的人工智能》强调通过优化设计提高AI系统的公平、透明和可问责性;(49)国家新一代人工智能治理专业委员会《新一代人工智能治理原则:发展负责任的人工智能》,https:∥www.most.gov.cn/kjbgz/201906/t20190617_147107.html,最后访问时间:2023年9月14日。《个人信息保护法》第24条也明确规定了自动化决策者的透明义务。算法透明并不必然追求“算法可知”,而是在程序上保障用户知情权以及达成外部监督纠错的制度效果。

(一)算法透明的基本概念

根据社会心理学理论,人们在面临生活中的不确定性与未知性时,对公平的期待感会更为强烈。(50)Van den Bos,Kees,“Uncertainty Management:The Influence of Uncertainty Salience on Reactions to Perceived Procedural Fairness”,Journal of Personality and Social Psychology,Vol.80,No.6,2001,p.931.算法黑箱的隐喻能够很好地解释为何不透明的技术系统会降低个体公平感。算法透明是由算法的设计使用者披露有关算法如何部署、如何工作以及如何使用的相关信息,以期由监管部门或第三方进行监管的制度。(51)张凌寒:《算法评估制度如何在平台问责中发挥作用》,《上海政法学院学报》(法治论丛)2021年第3期。提升透明度是尽可能使用户了解算法运行原理,尤其是了解影响算法推荐结果的因素及其影响力程度,从而保障用户的平等权、知情权、公平交易权。正如布兰代斯的名言:“阳光是最好的消毒剂,电灯是最有效率的警察。”(52)Brandeis,Louis D.,“Other People’s Money and How the Bankers Use It”,Cosimo,Inc.,2009.算法透明能够帮助检查影响算法系统公平性的数据;核查算法系统输入的数据是否相关、是否具有代表性、准确完整;从机器分析中寻找之前未意识到的有意义关联;寻找并修复算法系统缺陷。(53)李晓辉:《算法商业秘密与算法正义》,《比较法研究》2021年第3期。《互联网信息服务算法推荐管理规定》第12条规定了优化算法可解释性及透明度的要求和对象,但没有对这两项要求进行深入区分。算法解释与算法透明的两项义务分别指向监管端与用户端,前者更加强调算法应用需受到充分监管,满足风险可控、确保安全等目标,后者更加强调算法应用被充分知情,满足交易公平、选择自由等目标。两种义务实际上可以起到相互关联而又独当一面的基础性作用。若优化算法透明度义务尚不足以澄清用户之疑惑,可以针对特定用户的合理诉求,提供个性化、场景化的解释方案,或针对原有的算法透明实现方案进行有针对性的二次解释。(54)苏宇:《优化算法可解释性及透明度义务之诠释与展开》,《法律科学》(西北政法大学学报)2022年第1期;钱继磊:《个人信息权作为新兴权利之法理反思与证成》,《北京行政学院学报》2020年第4期。

理解算法透明可以从透明程度、向谁透明和披露速度三大问题入手,(55)[美]弗兰克·帕斯奎尔著,赵亚男译:《黑箱社会:控制金钱和信息的数据法则》,北京:中信出版社2015 年版,第 199 页。其中最重要的是透明程度问题。美国学者 Cary Coglianese 提出了“鱼缸型透明”(fishbowl transparency)和“合理型透明”(reasoned transparency)理论。(56)Coglianese,Cary,and David Lehr,“Transparency and Algorithmic Governance”,Administrative Law Review,Vol.71,No.1,2019,pp.1-56.前者意味着完全透明,要求以必要的规制手段公开自动化决策系统的算法源代码或者相关的数据库,以便观察到算法的目的、设计和基本运行原理。后者意味着部分透明,旨在建立一种选择性披露标准,通过筛选信息源的可靠性,展现算法的设计、目的和基本功能,又被称为“优质的透明度”。(57)[美]弗兰克·帕斯奎尔著,赵亚男译:《黑箱社会:控制金钱和信息的数据法则》,北京:中信出版社2015 年版,第 200 页。考虑到安全保密与用户知情的平衡,应当建立算法信息有限公开和算法原因完全公开的算法透明机制。

(二)算法透明的制度目标

部分学者对算法透明提出质疑:第一,透明不同于可知。对于绝大多数用户而言,算法概念本身并不是一个容易理解的事项,用户无法通过透明化机制得到自身需要了解的信息。(58)孙庆春、贾焕银:《算法治理与治理算法》,《重庆大学学报》(社会科学版)2019年12月7日网络首发。第二,外部监督效果难如预期。算法透明机制的另一个目的是引入外部监督者,允许社会公众对算法进行审查、检验,但企业级的算法应用模式不仅难以为普通公众所监督验证,具有专业技术背景的算法专家也无法完全理解特定算法的工作原理与决策过程,无法做出公平与否的准确判断。(59)Sandvig,Christian,et al.,“Auditing algorithms:Research Methods for Detecting Discrimination on Internet Platforms”,Data and Discrimination:Converting Critical Concerns into Productive Inquiry,Vol.22,No.2014,2014,pp.4349-4357.第三,算法透明之后可能导致反向破解算法模型及其决策规律,损害平台商业利益。算法透明化既可能导致用户反向发现和利用算法应用漏洞,例如,在信用评级系统中“刷信誉”,也可能为竞争对手效仿业务模式提供便利,挫伤算法开发的积极性。(60)赵精武:《从过程控制到结果归责:算法透明义务与算法问责机制的分野》,《北大法律评论》(第22卷第2辑),北京:北京大学出版社2022年版。第四,随着机器学习技术的成熟,动态优化的算法难以通过静态描述充分展示所有的运行原理等基本情况,难以达到提高算法透明度的目的。(61)刘友华:《算法偏见及其规制路径研究》,《法学杂志》2019年第6期。

事实上,以上观点混淆了技术意义上的算法透明与法律意义上的算法透明,将提高透明度和产生社会信任的“外部解释”误认为技术开发需要的“内部解释”。(62)张凌寒:《商业自动化决策算法解释权的功能定位与实现路径》,《苏州大学学报》(哲学社会科学版)2020年第2期。诚然,绝大多数用户无法理解算法和机器学习模型的基础技术知识,也很少会花时间阅读繁杂的算法运行规则。但是,保障所有人对输入数据来源、算法运行机理、自动化决策考量因素的知情权以及少数专业人士通过公示内容提出改进建议的监督权仍然十分必要,也符合个体对于算法公平的实质期待。事实上,数据主体在意的并非是否公布算法运行代码,而是期待自己和他人处于同等地位和条件,在同一时段也应以统一、普遍、透明的方式享受同等的机会,获取同等的资源。(63)[美]莎拉·马克斯韦尔著,陈汝燕等译:《如何正确定价》,北京:电子工业出版社 2009 年版,第51—60页。人们形成公平判断时,往往通过某些不充分线索的启发或者认知捷径迅速形成一个整体的公平印象,并不会像学者们那样从理性上分析自己到底面临的是结果公平、程序公平还是互动公平。当我们在购买汽车保险或者医疗保险时,实际上完全可以接受不同年龄、不同性别的人,付不同价格的保险费。用户之所以愿意接受歧视性定价的保险费,是因为清楚地了解这个保险费的计算是基于大数据人口的预期寿命和事故发生概率等,这个概率的成本是可计算的,而收益也是可预期的。在此基础上,如果算法结果也是可知晓、可计算、可预期、可解释的,这就使人们能够在接受结果上感到公平,并恢复对于算法技术的信任。

(三)算法透明的具体制度内容

具体而言,算法透明包含着从告知义务、向主管部门报备参数、向社会公开参数、存档数据等不同形式,(64)汪庆华:《算法透明的多重维度和算法问责》,《比较法研究》2020年第6期。目前我国已经确立的有算法公示(备案)、算法解释、算法安全评估等制度。

1.算法公示

《互联网信息服务算法推荐管理规定》第16条规定了信息服务提供者的公示公告义务。算法公示公告与政府信息披露制度具有相似性。算法服务自主权的正当性基础并不是纯粹的用户权益保护,更多的是权利义务的对等,故而算法透明义务要求以“适当方式”公示即可。这里的“适当”包括两层含义,一是公示内容的适当性,即服务提供者不必公示底层代码、算法推荐技术具体内容等可能涉及商业秘密的信息;(65)依据现行立法规定,“算法”可能属于商业秘密,但“算法推荐服务”并不属于商业秘密。《关于审理侵犯商业秘密民事案件适用法律若干问题的规定》第1条规定,与技术有关的结构、原料、组分、配方、材料、样品、样式、植物新品种繁殖材料、工艺、方法或其步骤、算法、数据、计算机程序及其有关文档等信息,人民法院可以认定构成反不正当竞争法第九条第四款所称的技术信息。二是公示详细程度、频率次数的适当性,即仅在具体服务模式发生实质性变化的前提下,服务提供者才需要更新“公示”内容。“公示”内容应当位于显著位置以清晰易懂的表达方式予以呈现。“告知”和“公示”两项要求是为了方便公众监管自动化决策结果是否合理。“告知”的制度目的是保障用户知晓算法应用基本情况和正确选择接受算法推荐服务,“公示”的制度目的则是为了方便社会公众监督算法推荐服务的安全应用,故而公示的信息范围包含了基本原理、目的意图和主要运行机制等更为具体的内容。

算法备案是算法公示的重要方式之一,且在《互联网信息服务算法推荐管理规定》第24条中也规定了强制算法备案的义务主体范围,公众可通过“互联网信息服务算法备案系统”查询相关企业使用的算法信息。以“美团配送调度决策算法”为例,备案材料通过图文标注的形式解释了订单分配和预估时间的运行逻辑及原则,并通过示例进行解释,较为详细和易懂。“订单分配”算法通过科学调度,帮助骑手在合理的劳动强度下获得更多收入。当后台接到一个新订单时,该算法会把订单分配给时间充裕且更顺路的骑手。“预估到达时间”基于“模型预估时间”“三层保护时间”等四种测算方式综合得出,充分考虑骑手的时间宽裕程度、顺路程度,兼顾用户、商家、骑手三端体验。“百度信息检索算法”运行机制为“根据相关性、时效性、权威性、页面质量等维度在网页候选库里找到更匹配用户搜索需求的检索结果集合,将检索结果返回,并在百度搜索结果页向用户进行排序展示。”尽管相关性、时效性、权威性等概念仍较为模糊,权重占比以及最后以何种方式排序都未披露,但已经在一定程度上为公众提供了参考依据。

算法备案并非“行政确认式备案”,其目的不在于为行政相对人设定权利和义务,而是基于实现算法透明的目的,在法律上对相对人的某种行为或事实予以法律上的确认。当备案信息作为监管措施的实施基础时,监管机构可在后续算法的实质审查过程中,具体判断算法服务提供者的行为是否符合备案内容,若不符合,则有权要求其改正。(66)许可、刘畅:《论算法备案制度》,《人工智能》2022年第1期。为避免算法备案的任意性,例如不同级别、不同地域的网信部门在备案管理时出现材料提交不一致、备案程序不统一的协调问题,应积极推动算法备案资料信息的共享,以国家网信办“互联网信息服务算法备案系统”为标准,统一备案程序与算法机制机理内容公示模板。

2.算法解释

2016年,牛津学者布莱斯·古德曼和赛斯·弗兰斯曼提出GDPR包含了自动化决策解释权(right to explanation)的观点,(67)Goodman,Bryce,and Seth Flaxman,“EU Regulations on Algorithmic Decision-Making and a ‘Right to Explanation’”,ICML Workshop on Human Interpretability in Machine Learning (WHI 2016),New York,http:∥arxiv.org/abs/1606.08813 v1.2016.引发广泛讨论。实际上,GDPR在正文中并没有明确定义自动化决策的解释要求,仅在引言第71条提出数据主体有权对自动化决策获得解释或质疑相关决定,包括向数据主体提供的特定信息以及获得人工干预的权利、表达个人观点的权利、获得解释的权利以及质疑该决策的权利,从而补充细化了第22条建立的自动化决策管理机制,但该部分内容并不具有规范效力。(68)Selbst,Andrew D.,and Julia Powles,“Meaningful Information and the Right to Explanation”,International Data Privacy Law,Vol.7,No.4,2017,pp.233-242.因此,算法解释权至今仍是一种理论构想,未得到立法认可。从解释对象看,算法解释可以被分为宏观过程解释与具体决策解释,以模型为中心的解释(model-centric explanations)和以用户为中心的解释(subject-centric explanations)。对于寻求救济的数据主体而言,后者更加有利。从用户微观权益的角度,算法模型的整体逻辑不是十分重要,用户往往更关注与其密切相关的内容,并且十分看重解释的直观性。(69)Selbst,Andrew D.,and Solon Barocas,“The Intuitive Appeal of Explainable Machines”,Fordham Law Review,Vol.87,2018,p.1085.

尽管《互联网信息服务算法推荐管理规定》第15条规定算法推荐服务提供者不得利用算法对其他互联网信息服务提供者进行不合理限制,或者妨碍、破坏其合法提供的互联网信息服务正常运行,实施垄断和不正当竞争行为。但是在监管活动中,如何判断和落实算法推荐服务提供者的这项法定义务仍存在难题,其中首要解决的问题是算法解释的履行方式。监管机构对于算法技术的理解有限,迫切需要服务提供者明确解释和说明该算法的基本原理和功能以及是否存在妨碍、排除市场正常竞争的可能性。

就具体的制度设计而言,自动化决策的算法解释应以用户行为干预为导向,解释的内容包括算法、数据与其他决策理由等内容。将算法解释作为技术方案,通过披露平台算法(甚至是源代码)来达到自动化决策可解释性要求,其目的并非使每一位用户成为技术专家,而是在机构掌握算法权力的背景下增加公众信任。一系列扰动社会神经的案例说明,数据主体想要的并不是一个解释,而是通过披露保障知情权,并一定程度上预防相应的行为发生。为进一步完善算法解释的技术路线,反事实解释也是一种可行的改进思路,即更改原始的输入数据以观察结果的相应变化,提升算法解释的可验证性。例如,微幅改变信用卡申请者的特征输入数据,观察他们的申请是否会被算法系统重新接受,从而判断被改变的特征是否为算法系统拒绝申请的原因。比起提供“最接近可能情形”,反事实解释可能更有帮助。(70)Sandra Wachter,Brent Mittelstadt,and Chris Russell,“Counterfactual Explanations without Opening the Black Box:Automated Decisions and the GDPR”,Harvard Journal of Law &Technology,Vol.31,2017,p.841.

3.算法安全评估

算法安全评估是网络安全风险评估与数据安全风险评估的延伸。全国信息安全标准化技术委员会在2021年8月就已经公布了《信息安全技术 机器学习算法安全评估规范(征求意见稿)》,在风险评估流程与评估事项上为企业提供技术性合规指南,针对算法安全的技术性评估指标包括保密性、完整性、可用性、可控性、鲁棒性、隐私性等技术属性,并按照业务流程将安全风险归类为算法、数据和环境三个层面。算法影响评估针对算法系统所产生的各项风险,在提升算法透明性、改善个体在算法社会中的弱势地位、协调公共与私人利益等方面发挥着重要作用。当前,从我国人工智能治理的顶层设计到地方人工智能行动方案,算法影响评估制度已作为一项核心制度被明确提出,通过对自动化决策系统的稳健性、公平性和可解释性等多项指标进行评估,创建系统设计者对运行结果负责的切入点。(71)张欣:《算法影响评估制度的构建机理与中国方案》,《法商研究》2021年第2期。

《互联网信息服务算法推荐管理规定》第8条规定,算法推荐服务者应当定期审核、评估、验证算法机制机理、模型、数据和应用结果等。然而,该规定并没有细化所谓的评估流程、评估事项具体包括哪些。从未来可能的人工智能和算法法律规则一体化趋势来看,应当充分利用现有的算法评估机制,建构以衡量是否对消费者权益具有实质性影响为标准的算法评估流程。一方面,算法安全评估与科技伦理审查相结合。科技部在2023年4月公布了《科技伦理审查办法(试行)(征求意见稿)》,其中第14条将算法纳入科技伦理审查范围,判断算法是否符合“公平、公正、透明、可靠、可控等原则”,并且,与以往的一次性评估审查机制不同的是,该征求意见稿还提出了“跟踪审查”机制,确保算法应用始终属于科技伦理的范畴之内。另一方面,算法安全评估与反垄断行为评估相结合。在平台经济反垄断治理中,应当重新明确竞争损害的认定依据。对于经营者市场力量的评估,不再局限于“将价格提高至超竞争水平的能力”,需要结合经营者的市场地位、对关键资源控制、市场竞争特点等指标进行综合认定。在规制算法垄断行为时,应着重分析算法经营者的市场力量,评估其算法业务活动对市场竞争的损害程度,并结合算法歧视认定三要件对算法程序的训练数据、运作机理、人工校正机制是否符合公平标准进行评估。

五、结 语

在算法治理领域,根据个人特征进行群体分组并提供相对应的服务,这种行为并不当然等同于算法歧视、算法偏见或算法不公平。技术层面的合理分组分类反而有助于提前消解算法歧视风险,因为算法服务提供者可以针对特定组别的特定群体特征加强人工审核比例。在判断算法公平时,“一碗水端平”和“弱者完全倾斜保护”两种判断逻辑均不可取,关键在于考量受影响的用户群体、群体划分依据的合理性等要素。将算法公平设想为“起点公平、过程公平、结果公平”三角结构,其综合治理首先需要在数据层次上保证完整性和准确性,这是起点公平的必要条件。算法服务提供者需要确保数据集在使用过程中是开放的、透明的,即允许新的数据能够进入到数据集。上述两点是保证在数据层面上的起点公平。在算法层面上,应当要求算法程序透明、可追溯和可问责。透明就是提供了验证的机会,而可追溯就是要求在算法程序中切入一些检查点,这些检查点能够使得过程可追溯。可问责就是使每个数据产生、计算以及应用的过程都有特定的责任主体,即可追责的责任主体。上述准则能够保证算法的过程公平。在人类行为层面上,人们希望算法结果用于智能辅助决策且达到一种结果公平,但是真正的结果公平是很难实现的。从最低限度的结果公平来看,只要决策结果可计算、可预期、可解释,就符合公平要求。

- 暨南学报(哲学社会科学版)的其它文章

- 中国数字经济创新活动的特征事实与分析

——来自专利的证据 - ESG表现与商业银行特许权价值

- 行业锦标赛激励与审计费用