基于人工智能的图书馆书籍定位机器人自动化控制系统设计

薛谢辉,马同霞

(1.南昌职业大学 工程技术学院,南昌 330500;2.南昌职业大学 经济管理学院,南昌 330500)

为提高管理效率,提升图书馆管理智能化水平,应用机器人技术进行书籍管理则成为首选方法[1]。机器人用于图书馆后,能够实现对馆内所有书籍的扫描、定位、统计等处理,实现图书馆的智能化服务,并且极大程度提升图书馆的管理效率和服务质量。书籍定位作为机器人在图书馆中的重要作用之一,其能够精准获取数据的位置,为图书寻找提供有效帮助。但是,在实际应用过程中,由于馆内书籍的大小、薄厚等均存在差异,因此,机器人在进行书籍定位时,仍旧会发生定位误差[2]。因此,为保证机器人对于书籍的精准定位,需提升机器人的控制效果。文献[3]针对该需求,基于多传感器融合,提出相关控制方法,该方法通过卡尔曼滤波算法实现机器人测距数据和里程数据的融合,在此基础上获取机器人的坐标信息,实现机器人控制。但是该方法在应用过程中,对于机器人位姿角的控制误差较大;文献[4]则基于ROS 构建机器人模型,在考虑机器人一定角度和距离权重的前提下,利用随机数算法完成机器人运动规划,实现机器人控制。该方法在应用过程中,对于突发障碍物的避障效果较差。

为解决控制误差大,避障效果较差的问题,本文设计基于人工智能的图书馆书籍定位机器人自动化控制系统。

1 图书馆书籍定位机器人自动化控制系统

1.1 书籍定位机器人自动化控制系统结构

书籍定位机器人在应用时需准确定位书籍的位置,为书籍管理提供可靠保障,为保证机器人对于不同大小、不同厚度书籍的定位效果,快速完成书籍的寻找,需提升机器人的控制效果。本文结合书籍定位寻找需求,设计基于人工智能的书籍定位机器人自动化控制系统,系统结构如图1 所示。本系统整体分为人机交互层、行为评估层、运动规划层以及机器人执行层,人机交互层可下达机器人运动指令,行为评估层对机器人接受控制后的运动行为进行评估,运动规划层依据评估结果对机器人进行自主控制,通过机器人执行层执行控制结果。

图1 人工智能书籍定位机器人控制系统结构Fig.1 Structure of positioning robot control system for artificial intelligence

1.2 自主控制器结构

运动规划层在进行机器人自主控制时,主要依据自主控制器完成,控制器结构如图2 所示。自主控制器的主要作用是实现远程端控制、本地端控制两种控制模式下机器人行为的自主控制,该控制器以TMS320F2812 处理芯片为核心,与上位机、复位电路、传感器、光电编码器以及各类串口等相连接,实现图书馆定位机器人的自主控制。其在控制过程中,能够依据接口电路将控制指令传送至电机驱动器,完成该驱动器的控制;并且在控制过程中,以eCAN总线为依据,实现该控制器和PC 上位机之间的实时通信,保证控制指令可迅速精准的执行。

图2 自主控制器结构Fig.2 Autonomous controller structure

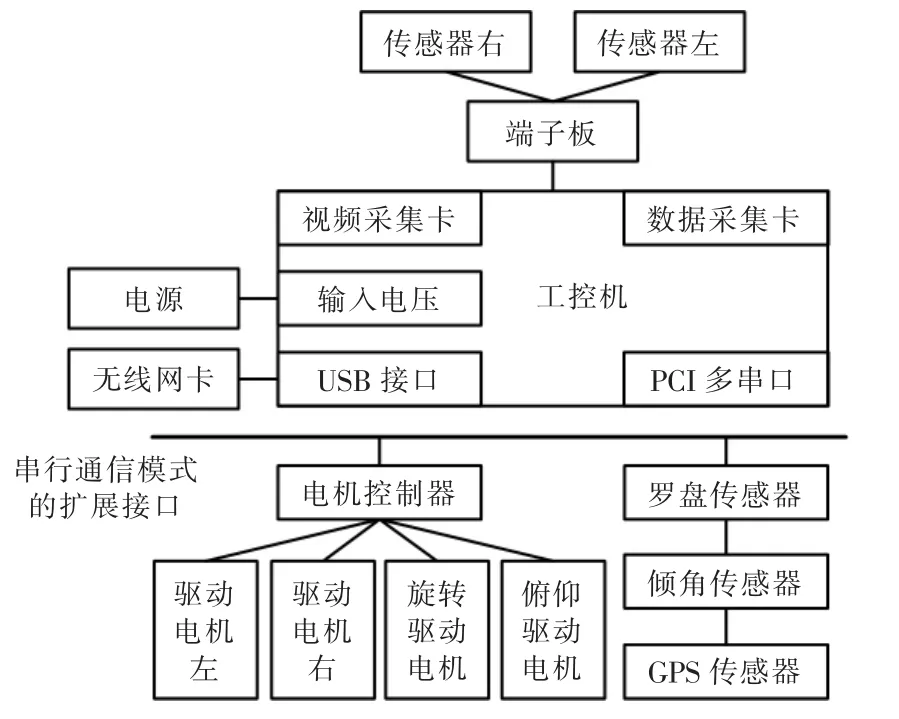

1.3 图书馆书籍定位机器人硬件

机器人执行层是系统的基础支撑,其主要通过机器人实现该层的运行,机器人硬件结构如图3 所示。依据图3 可知,该机器人以工控机为核心,并且工控机内设有视频采集卡、数据采集卡、USB 接口、PCI多串口以及射频识别,其中视频采集卡连接智能视觉装置,数据采集卡连接传感器、激光雷达测距仪等;PCI 多串口通过串行通信模式的扩展接口实现罗盘、倾角以及射频识别传感器和工控机之间的双向通信;与此同时,通过该双向通信串口,将工控机和机器人的电机控制器相连接,实现书籍定位机器人的左、右2 个驱动电机、旋转和俯仰2 个驱动电机的控制,以实现对于机器人位姿角的精准控制。

图3 图书馆书籍定位机器人硬件结构Fig.3 Library book positioning robot hardware structure

1.4 书籍定位机器人的自主控制

1.4.1 机器人作业环境区域识别

由于视觉装置采集的作业环境图像为彩色图像,为精准检测识别作业环境区域的目标图像,以为后续的定位控制提供可靠的支撑。因此,利用Roberts算子完成对所采集到彩色图像的灰度处理,获取图像色彩突出部分后,依据色彩分布的梯度变化对图像进行分割以及边缘检测。将视觉装置获取的图书馆环境图像色彩分布用函数f(x,y)表示,其像素点用(x,y)表示,该像素点在x、y 两个方向上的表达公式为

对于目标图像(x,y)而言,其区域矩计算公式为

式中:p 和q 均表示阶数;s 表示采集图像的整个区域。

对(x,y)进行二值化处理后,(x,y)=1,此时零界矩m00的计算公式为

式中:m00即为图像中目标区域的面积,其一阶矩计算公式为

目标区域的质心(xc,yc)计算公式为

为了保证该质心区域被更好地识别,文中采用人工聚类方法,对质心位置进行分类,以此获取机器人书籍定位作业区域。其详细流程如下所述:

(1)构建聚类中心,将计算获取的(xc,yc)结果定义为聚类中心;

(2)计算质心样本数据{X},按照最小距离对计算结果进行划分,使其归属于某个选定的聚类中心

(4)采用计算得出的均值向量作为新的聚类中心,并依据聚类准则,保证函数值最小;

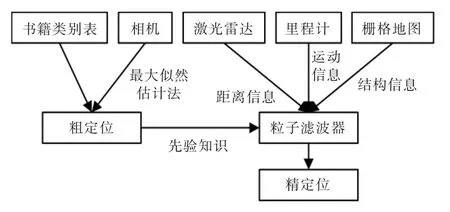

1.4.2 重定位增强方法

获取机器人作业区域识别结果后,为提升机器人对于书籍的定位精度,自主控制器中设有基于粒子滤波的重定位增强方法,依据该方法完成机器人对书籍的定位。该方法结构如图4 所示。该方法是在确定作业区域的基础上,获取二维栅格地图和作业区域环境内的语义信息并对其进行遍历;在此基础上,依据栅格地图完成作业区域内书籍所在的环境划分,使其形成多个功能区块,并获取各个区块的语义信息,将其定义为功能区特征。环境匹配依据语义信息完成,即通过最大似然估计法完成书籍的粗定位,将粗定位结果作为粒子滤波器的先验知识,以此实现书籍的精定位。

图4 重定位增强方法结构Fig.4 Repositioning the enhanced method structure

机器人定位可采用连续时间概率计算问题描述,采用贝叶斯和马尔克夫理念对该问题进行描述为

式中:b(St)表示置信度;St表示在t 时刻下机器人的状态估计结果;η 表示归一化因子;ut表示控制量;zt表示机器人搭载的激光雷达获取的书籍测量数据;m 表示全局地图。

公式(7)中,包含了2 个部分,分别为预测和更新,其中p(St∣St-1,ut)的主要作用是完成机器人状态预测,该预测是依据生成的先验概率完成;p(zt∣St,m)表示测量似然概率,和p(St∣St-1,ut)结合后,完成机器人状态估计结果更新。

粒子滤波方法在进行机器人精定位时,概率分布通过粒子密度分度表示,b(St)则采用n 个粒子集合表示,其精定位流程为

(1)以t-1 时刻下机器人的状态估计结果St-1、ut以及机器人运动模型采样,获取t 时刻下机器人可能发生的状态;

(2)通过传感器观测模型计算各个粒子包含的观测数据zt以及地图匹配度

(3)采用匹配度重采样处理后,生成后验概率分布,并通过循环迭代处理后,获取机器人的位姿结果,实现机器人定位控制,以此可保证机器人对于书籍的定位精度。

2 测试分析

为验证本文系统在图书馆书籍定位机器人控制中的应用效果,以某市图书馆为实例研究对象,并对该图书馆内使用的书籍定位机器人进行控制测试。该机器人为双足机器人,其详细参数如表1所示。

表1 双足机器人详细参数Tab.1 Detailed parameters of biped robot

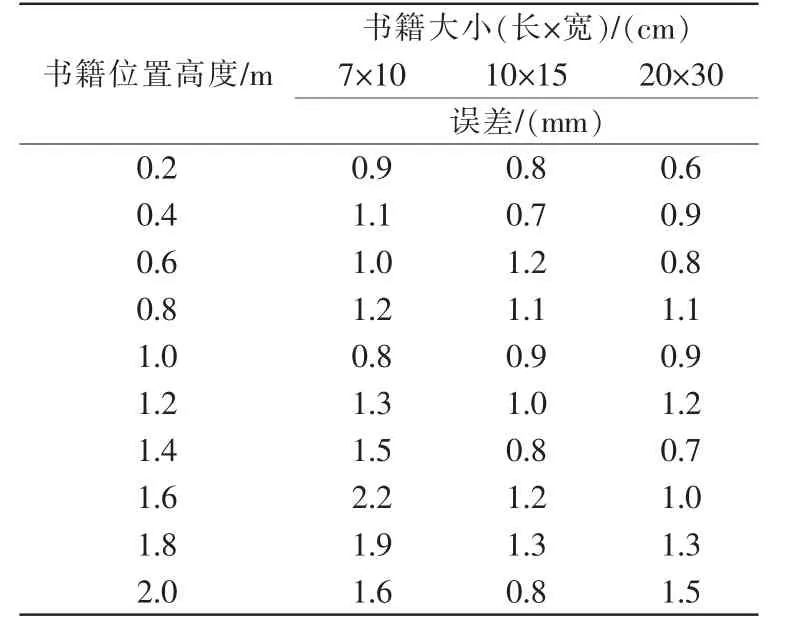

为验证本文系统应用后,定位的精准性,获取本文系统应用后,机器人在不同书籍位置高度下,对于不同大小书籍的定位误差结果(期望误差低于2.5 mm),如表2 所示。

表2 不同大小书籍的定位误差结果Tab.2 Results of localization errors of different sizes

根据表2 测试结果可知,本文系统应用后,能够极大程度提升机器人的定位精度,即使书籍大小尺寸较小时,机器人依旧能够精准完成书籍定位,误差结果最大值仅为2.2 mm,在期望误差方位内。因此,说明本文系统具有良好的机器人控制效果,应用后可保证机器人对于书籍的定位效果。

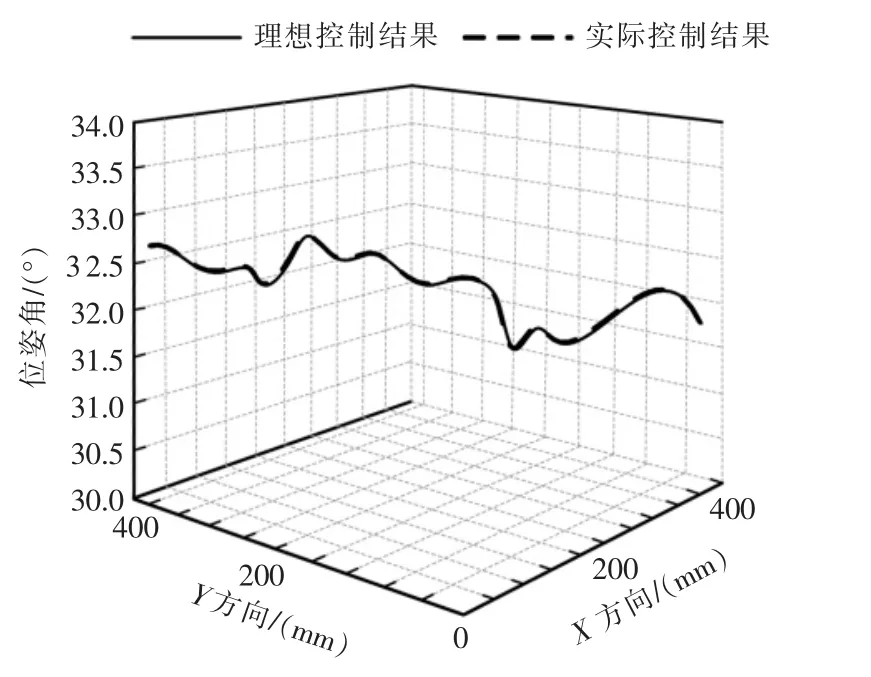

为验证本文系统应用后对于机器人的控制效果,获取机器人的位姿角控制结果,并将控制结果和理想结果进行对比,测试结果如图5 所示。

图5 机器人位姿角控制结果Fig.5 Robot pose and angle control results

根据图5 测试结果可知,本文方法应用后,能够有效控制机器人的位姿角,控制后的位姿结果与期望位姿结果一致,未出现机器人位姿角偏差。因此,说明本文系统能够有效实现机器人位姿控制。

为验证本文系统的应用效果,获取本文系统应用后,机器人在书籍寻找过程中,突发行人闯入后,机器人的自主避障效果,结果如图6 所示。

图6 机器人的避障效果测试Fig.6 Barrier avoidance effect test of robot

根据图6 测试结果可知,本文系统应用后,机器人在目标书籍定位过程中,面临行人突然闯入后,机器人能够自主躲避行人,不会和行人发生碰撞,并且躲避行人后能够自主重新规划行驶路径,完成目标书籍寻找。

为进一步验证本文系统的实用性,以机器人的避障精准度为实验指标,采用文献[3]方法与文献[4]方法进行对比测试,结果如图7 所示。

图7 机器人避障精准度对比结果Fig.7 Comparison results of robot obstacle avoidance accuracy

根据图7 可以看出,应用本文系统后,机器人避障精准度最高达到98%,而文献[3]方法的机器人避障精准度最高为87%,文献[4]方法的机器人避障精准度最高为83%,均低于90%。相比之下,本文系统的避障精准度高,由此说明本文方法具有实用性。

3 结语

为提升机器人对于书籍的定位精度,本文设计基于人工智能的图书馆书籍定位机器人自动化控制系统。对该系统进行测试后得出:本文系统具有较好的应用效果,能够精准完成不同大小书籍的定位,并且可完成馆内作业环境识别,精准实现机器人位姿控制,并且可呈现不同控制模式下的人机交互结果。