边缘计算下的联邦学习挑战及进展

中国电子科技集团公司第三十二研究所 张燕 胡明星

近年来,边缘计算和联邦学习技术受到了学术界和工业界的广泛关注。边缘计算充分利用位于边缘设备、边缘节点及边缘服务器上的计算和存储资源,减少对通信资源的消耗,提供了分布式计算和数据处理的能力。联邦学习作为一种分布式的机器学习方法,通过在本地进行模型训练,以达到保护数据隐私安全的目的。边缘计算和联邦学习这两项技术的结合,不仅可以实现边缘端的智能决策,还能减少通信开销,保护用户数据隐私安全。本文首先描述了边缘计算下的联邦学习所面临的一系列挑战,例如,通信、计算资源及能耗等受限,设备异构、数据异构、设备连接不稳定以及安全隐私保护等,然后分别从这三个方面对近两年有代表性的研究进展进行了概括,最后对全文进行了总结。

联邦学习是一种分布式的机器学习技术,由多个参与方分别持有本地数据,在本地进行模型训练,然后将本地训练的模型参数上传,而非将本地数据上传,进行模型聚合和参数更新,共同完成对全局模型的训练。边缘计算从终端采集到的数据直接在本地设备或网络中进行分析,将智能服务提供到靠近物或数据源头的网络边缘侧,无需传输到云端数据处理中心。

在边缘侧使用联邦学习,不仅可以保护用户的隐私安全,还可以充分利用边缘设备的计算能力、存储资源,减少通信开销,因此联邦学习和边缘计算技术的结合吸引了大量的关注与研究。但同时边缘计算应用场景中存在的问题,如:受限的通信资源、计算资源及能耗、更加不均衡的用户数据、不稳定的通信条件以及隐私与安全需求等也为联邦学习本身带来了新的挑战。

本文的结构如下:首先,介绍了边缘计算下的联邦学习所面临的挑战,然后分别从通信及其他资源受限、数据及系统异构、隐私安全这三方面对近两年有代表性的研究工作进行了概括归纳,最后进行了总结。

1 面临的挑战

综述[1]中总结了联邦学习技术当前的挑战,包括:通信效率短板明显、隐私安全仍有缺陷等。这些挑战在边缘计算环境下依然存在,并且由于边缘计算环境本身的特质,上述问题还会变得更加严峻。本节将从以下三个方面:(1)资源受限;(2)异构;(3)隐私安全来简述边缘计算环境下的联邦学习技术所面临的挑战。

1.1 资源受限

首先,在联邦学习中,设备之间需要频繁交换模型参数和梯度信息,由于边缘设备的带宽通常很有限,无法同时处理大量数据和传输数据,设备之间的通信可能会出现较高的延迟,从而影响模型的训练效率和准确性。其次,边缘计算设备的计算能力、存储资源也有限,另外,边缘计算设备对能耗也有着更高的要求,这些限制对联邦学习这种分布式机器学习方法提出了挑战。

1.2 异构

数据异构,特别是数据非独立同分布,一直是联邦学习的一个挑战,而这个问题在边缘计算下由于边缘设备的异构性而变得更加突出。边缘设备不仅本身的差异非常大,例如,智能传感器、边缘智能路由、ICT 融合网关等,这些设备产生的数据更是复杂多样,并且由于受到设备性能及网络等因素影响,边缘设备可能产生数据缺失,以及产生的数据往往还具有实时性的特征,也容易引起数据时效性问题。另外,边缘设备还存在移动性和不稳定性,边缘网络中链路的带宽资源可能发生变化,不仅影响链路的实际带宽,甚至还可能出现连接中断的情况,这些给联邦学习带来了更大的挑战。

1.3 隐私安全

联邦学习在隐私安全方面的研究一直是一个热门话题,因此,在边缘计算背景下的联邦学习隐私安全问题也同样受到关注。另外,对边缘服务器本地子网络进行部分参数聚合,不仅可以减少通信开销,还可以更好地实现隐私安全保护。因此,边缘计算本身也为隐私安全保护提供了新的思路。

2 研究进展

本节从边缘计算下的联邦学习的挑战角度出发,对近两年具有一定代表性的研究工作进行了概括和总结。

2.1 通信资源受限

边缘计算下的联邦学习通信资源受限问题引起了研究者的广泛关注。针对分层联邦边缘学习系统(H-FEEL),Wen 等[2]将子信道分配和助手调度问题抽象为非线性规划问题的理论分析,在某些特定情况下给出了最优解/次优解。Wu 等[3]则考虑云-边-端协同的情况,通过同步客户端-边缘模型聚合和异步边缘-云模型聚合相结合的方式,并通过大量实验证实,WAN 通信开销有非常明显的减少。

空中计算的通信资源受限问题也受到了广泛关注,Wang 等[4]利用可重构智能表面(RIS),来缓解朝向边缘服务器的信道条件最差的设备的限制。Yang 等[5]对设备选择和波束成形问题的组合算法进行设计,提供了一种稀疏和低秩建模方法,并对这个非凸二次约束的组合优化问题进行处理。

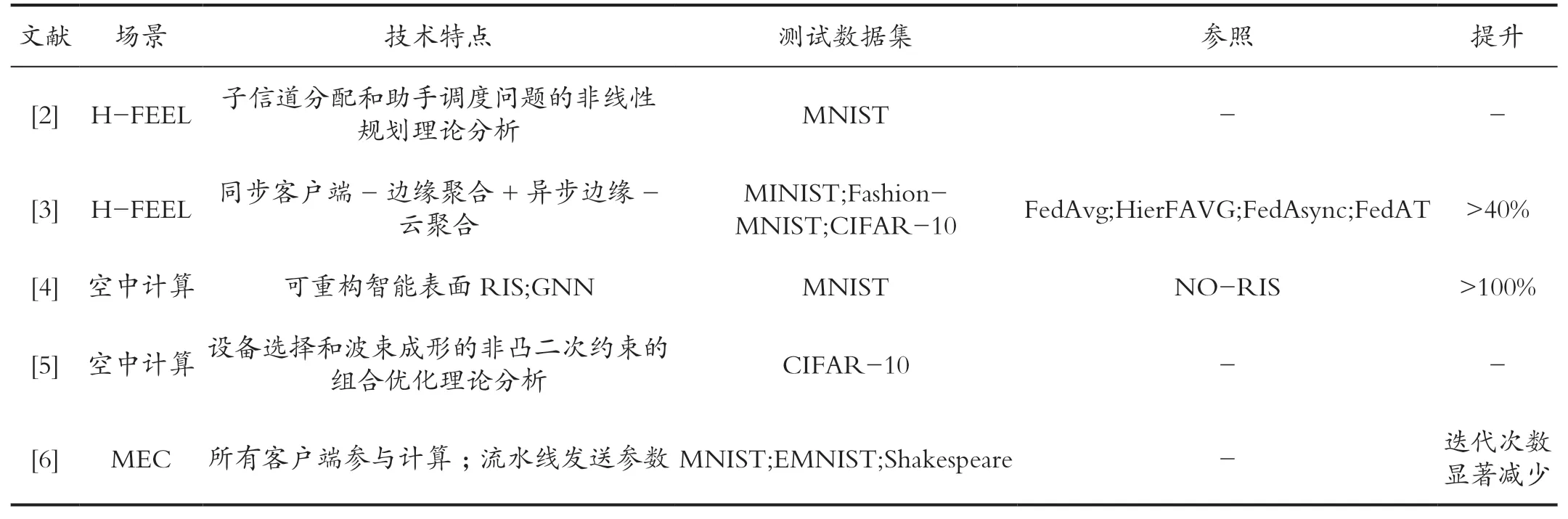

此外,引用[6]基于移动边缘计算(MEC),提出用通信流水线来上传所有客户端的本地更新来减少迭代次数,但未对总的通讯开销及所有用户参加计算过程所涉及的隐私安全情况展开讨论。通信资源受限的问题研究总结如表1 所示。

表1 通信资源受限问题研究总结Tab.1 Summary of research on communication resource limitation

2.2 计算及能耗资源受限

针对移动边缘计算(MEC)场景下的计算及能耗资源受限问题,有一些研究通过模型压缩减少计算资源的消耗,还有一些研究利用联邦学习框架,来解决任务卸载最小化延迟和能耗的组合优化问题。

2.3 数据异构

对于数据异构挑战,一些学者通过增加全局信息来缓解数据异构问题,如设计一个本地网络架构和一个全局原型对比损失来调节本地模型的训练;或者是生成满足全局分布的联邦虚拟数据集。另一种思路则是通过对客户端进行分组来缓解数据异构问题,如提出自动对用户进行分组的机制,以及利用权重来调整偏差。

2.4 系统异构及不稳定

边缘设备的移动性和不稳定性给联邦学习带来了巨大挑战,近两年,很多研究者也在系统异构及不稳定方面做了大量的研究工作。

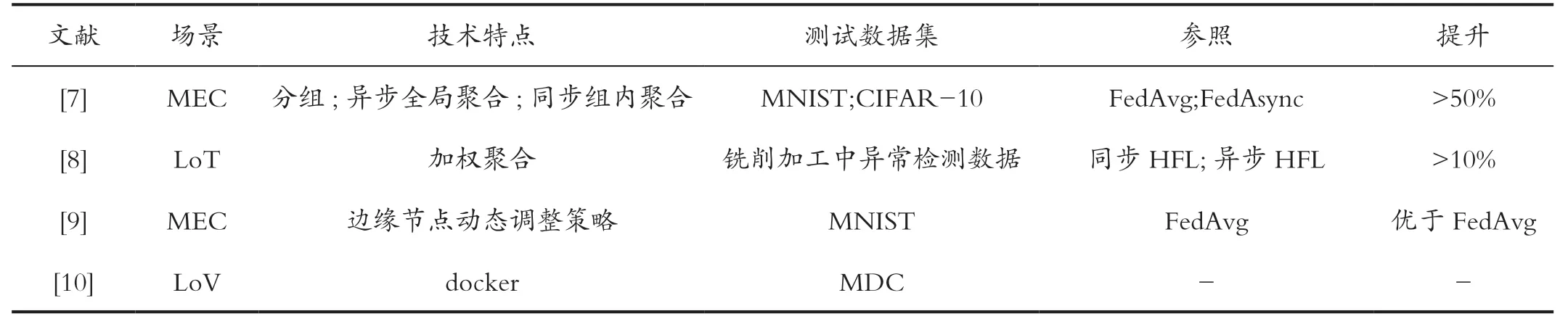

首先,一部分研究者考虑了客户端方面,如引用[7]提出了根据客户端的异构训练能力将所有客户端分组到多个集群中。集群间采用异步方式进行全局集合,而同一集群内则采用同步方式将其本地更新转发给集群头进行聚合。Herabad[8]使用加权聚合方法来克服在异构智能物联网边缘环境中的不平衡训练问题。

其次,也有一部分研究者利用边缘服务器等边缘节点来进行优化,如引用[9]提出了一种每个边缘节点能够根据网络动态自适应地调整其训练策略的方法。Chahoud等[10]利用容器化技术(Docker),使用任何类型的客户端设备作为志愿设备,来处理部分移动和车辆设备无法作为联邦学习中的客户端使用问题。系统异构方面的工作总结如表2 所示。

表2 系统异构问题研究总结Tab.2 Summarizes the research on system heterogeneity

2.5 隐私安全

针对边缘计算背景下的隐私安全挑战,一些研究者对联邦学习技术本身进行了进一步提高,如利用云-边缘-端协作,提出分层的联邦学习框架,以提高对恶意攻击的抵抗能力,以及使用多种隐私计算技术,如,多方安全协议、差分隐私等,对客户端上传的参数及服务器的聚合结果进行检查。此外,区块链技术与联邦学习的结合也是当前联邦学习隐私安全研究方面的一个热点,其中综述[11]提供了一个关于基于区块链的联邦学习方法在物联网应用中的详细文献综述。

3 总结

当前研究者们针对边缘计算背景下的联邦学习所面临的挑战开展了大量的研究工作,但这些研究主要还是面向具体的应用场景,对现有的联邦学习算法进行了不同程度和方向上的优化和改进,理论分析相对缺乏且难度较大,还有对在其他同类型应用场景中的扩展讨论较少,以及对通用的解决方法研究较少,因此,边缘计算下的联邦学习挑战仍然存在,还需继续研究完善。随着6G 等通信技术的不断进步,边缘设备计算能力的不断提高以及联邦学习技术的不断完善,相信边缘计算下的联邦学习将为各行各业带来更安全、高效和可持续的机器学习解决方案。

引用

[1] 周传鑫,孙奕,汪德刚,等.联邦学习研究综述[J].网络与信息安全学报,2021,7(5):77-92.

[2] WEN W,CHEN Z,YANG H H,et al.Joint Scheduling and Resource Allocation for Hierarchical Federated Edge Learning[J].IEEE Transactions on Wireless Communications,2022,21(8):5857-5872.

[3] WU Q,CHEN X,OU Y T,et al.HiFlash:Communication-Efficient Hierarchical Federated Learning with Adaptive Staleness Control and Heterogeneity-aware Client-Edge Association[J].IEEE Transactions on Parallel and Distributed Systems,2023,34(5):1560-1579.

[4] WANG Z X,ZHOU Y,ZOU Y N,et al.A Graph Neural Network Learning Approach to Optimize RIS-Assisted Federated Learning[J].IEEE Transactions on Wireless Communications,2023,(99):1.

[5] YANG K,JIANG T,SHI Y M,et al.Federated Learning Via Over-the-Air Computation[J].IEEE Transactions on Wireless Communications, 2020,19(3):2022-2035.

[6] KEÇECI C,SHAQFEH M,AL-QAHTANI F,et al.Clustered Scheduling and Communication Pipelining for Efficient Resource Management of Wireless Federated Learning[J].IEEE Internet of Things Journal,2023,28(3):1.

[7] WANG Z,XU H,LIU J,et al.Accelerating Federated Learning with Cluster Construction and Hierarchical Aggregation[J].IEEE Transactions on Mobile Computing,2022,22(7):3805-3822.

[8] Mohammadsadeq Garshasbi Herabad.Communication-efficient Semi-synchronous Hierarchical Federated Learning with Balanced Training in Heterogeneous IoT edge Environments[J].Internet of Things,2023,21(1):642-656.

[9] SUN W,ZHAO Y,MA W,et al.Duong.Accelerating Convergence of Federated Learning in MEC with Dynamic Community[J].IEEE Transactions on Mobile Computing,2023,2 (2):1-17.

[10] Mario Chahoud,Safa Otoum,Azzam Mourad.On the Feasibility of Federated Learning Towards on-Demand Client Deployment at the Edge[J].Information Processing & Management,2023,60(1):150-160.

[11] ISSA W,MOUSTAFA N,TURNBULL B,et al.Blockchainbased Federated Learning for Securing Internet of Things:a Comprehensive Survey[J].ACM Computing Surveys,2023,55(9):1-43.