人工智能自然语言能力的物质基础与功能实证

秦明利,黄舒婷

(大连理工大学人文学院,辽宁 大连 116000)

一、自然语言功能的实证

对人工智能自然语言能力的了解为人类探究人工智能的物质基础提供了功利主义的意义。人工智能自然语言水平对人类越形成挑战,对其进行哲学追问就越有必要。有关生成式人工智能,特别是ChatGPT 的语言生成与理解能力的实证研究存在诸多先例。广州市妇女儿童医疗中心数据中心曾于2023 年初抽取12000 份患儿简历,并把20 位儿科医生按照年龄资历和经验高低分为五组,加以对比后显示ChatGPT 在重大恶性疾病上的正确诊断率超过95%,综合正确诊断率高于两组低年资的人类医生,接近三组高年资的人类医生;奥德·诺夫(Oded Nov)则进行了一系列不全面的图灵测试,并认为在某些情况下ChatGPT-3已经通过了图灵测试[1]。然而,由于当下生成式人工智能的快速更迭性,这些数据与实证往往会迅速落后于现实情况,并且公开的、权威的实验更是少之又少。因此,笔者将亲自进行两个基于ChatGPT-4 的对人类语言的掌握程度的实验,分别为医疗人工智能诊断与治疗的正确率测试、人类对人工智能语句与人类语句主观区分的单盲实验,着重点分别在于考察人工智能在其语言使用中对客观材料的抽象综合判断力与在人类直觉、情感、感觉、幽默感等维度的社会欺骗力。以上指标均为语言理解、生成能力的较高级衡量标准[2]。尽管因为资金和能力的限制,本文所做实验的样本量十分有限,但这不影响其为笔者提供辅助理解前人实证的附加材料。

(一)医疗人工智能诊断和治疗与人类的客观结果差异

第一个实证考察生成式人工智能对人类语言描述的客观现实的认知与分析能力——此案例中为复杂的医学病例检查文本。案例均来自《急诊医学病例精粹》,因其依据体格检查与实验室检查后得出的检查文本经由人类医师分析后得出的诊断与治疗方式进行实践后,所选的案例均收获了良好的疗效并痊愈出院[3]19,我们可以认为这些检查报告是对病人病情的客观描述,人类医师给出的诊断与治疗方式也是符合病人病情的有效措施——这是本实验可以反映人工智能对客观现实理解能力的理由。

1.解析诊断流程,确定医疗人工智能目前的核心领域

由于当前一代的生成式人工智能仍未达到通用人工智能的水平,其在采集病例原初信息(即对人类医师感官的模仿)与治疗实操(即对人类医师实践能力的模仿)两方面仍差强人意。我们可以粗略地将当前生成式人工智能在医学中发挥作用的步骤理解为[4]:

(1)人类医师使用自身感官和辅助工具(如X 光片等非生成式人工智能的其他智能工具)进行病例原初信息采集;

(2)人类医师将通过各种感官捕获的原初信息转化为自然语言;

(3)将自然语言交给医疗人工智能进行分析,从而确诊并给出治疗方式;

(4)人类医师使用工具亲自进行治疗实践。

完整的治疗过程仍离不开人类的参与,但目前的生成式人工智能的确在步骤(3)取得了质的飞跃。本实验意在考量步骤(3)中人工智能对人类语言的理解能力、输出能力与对人类语言所描述的客观现实的判断力。

2.建模与实验设计

输入ChatGPT-4的自然语言分为“体格检查结果”(如体温、血压、心率、皮肤观察、呼吸表征、腹部观察、四肢检查、神志等)和“实验室检查结果”(如生化、X 光片文字结果、心脑电图文字结果等)两段文字。将ChatGPT输出的诊断与治疗方式和人类医师的诊断与治疗方式的重合率建模为:

其中x1~5分别代表人类医师与ChatGPT输出的疾病类型诊断、药物建议、物理疗法建议、继续检查建议(如腹腔穿刺、细菌培养)、继续监测建议的重合率,重合取值为1,相违背取值-1(注:由于药物选择的多样性,提供疗效近似的药物即视为重合),某案例不存在该项输出则取值为0。m 为xn中为0 的个数。

以上方法依次求得单个案例的重合率后,加权平均即得到全部样本条件下的ChatGPT-4 与人类医师诊断与治疗的重合率。

3.结果

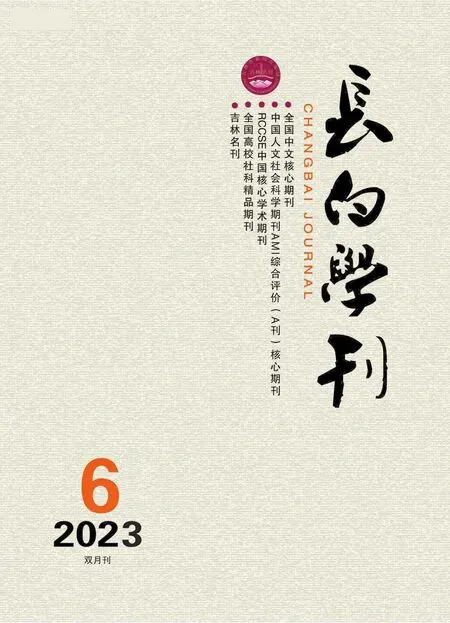

将《急诊医学病例精粹》中涉及的全部87 个案例的体格检查结果与实验室检查结果输入Chat-GPT-4后在五个方面计算其与人类医师的重合率。

因此得出ChatGPT-4 的医疗诊断与开方和人类权威医师的相似率达到82.8%。结合广州市妇女儿童医疗中心数据中心ChatGPT-3.5“综合正确诊断率高于两组低年资的人类医生,接近三组高年资的人类医生”的结论,则会得出生成式人工智能与人类医师诊断水平差距十分微小,甚至在某些方面超过了人类医师的结论。当然,实验的样本量十分有限,结论的前提也是需要权威医师将病例原初信息转化为自然语言后,人工智能才可以进行诊断,即生成式人工智能并不能完全脱离人类智能,但依然从某个角度提供了人工智能自然语言功能与人类差距正在消除的佐证。

表1 ChatGPT-4的急诊诊断与治疗方式与权威医师重合率

(二)人类对人工智能语句与人类语句主观区分的单盲实验

本实验是基于图灵测试理论的变式,在延续经由人机对话进行人类主观评判这一主要方法的同时,对对话内容进行规范并引入多维度评分量表,替代原测试中单一的“是否为机器”的0/1结果。对话时长不小于25 分钟、人类30%以上误判率[5]239-240作为通过测试标准的传统则被继续沿用。基于人格心理学与认知心理学的理性功能与非理性功能[6]1理论,我们不再测试与理性功能(thinking,T)相关的创造力、常识与综合抽象分析能力——原因是这些功能是本次生成式人工智能的核心进步方向,ChatGPT-4 在这些方向的表现已经在某种程度上超越人类并且令人难以进行人机区分,且与上文中的实验有重合——而是去测试更能体现人类原初认知特色的非理性功能:直觉(intuition,N)与实感(sensing,S)。需要注意的是,本实验的形而上学基础与本文所持观点相违悖——以人类主观评判为主要方法代表着本实验是以人类智能为最终对标对象,而本文持有多种智能形态观点,但这不妨碍本实验从人类中心主义角度证明人工智能的优异性能,进而从相反的立场侧面强化本文的观点。

1.人类实感与直觉

部分心理学流派(现代以荣格为代表)认为,人类的认知功能有直觉、实感、情感、思维等主要形式,前二者属于非理性功能,后二者属于理性功能。根据艾略特·阿伦森(Elliot Aronson)的进化心理学[7]529的观点,直觉、实感和情感可能被视为在进化过程中形成的原始心理机制,用于快速地做出应对环境挑战的决策。这些情感和直觉的机制被认为源自人类祖先在面对生存和繁殖需求时所形成的适应性反应。而思维和理性可能与进化的较后阶段有关,更多地涉及抽象思维、推理和问题解决。这种理性思维被认为是在人类进化历史的较晚阶段发展起来的,用于处理更为复杂的社会和环境情境。尽管现代主流心理学越来越倾向于将情感、思维、直觉和实感理解为相互关联、相互影响的复杂心理过程而非简单的理性与非理性区分,但这种分类方式为我们设计实验以特别考察人工智能的某些指定能力提供了捷径。

心理学上对直觉、实感和情绪的贬低说辞,以及将思维与理性视为进化中的高等功能宣传为“人类认知的王冠”的行为受到了人本主义流派[8]269的广泛批驳。而当下的生成式人工智能似乎在佐证人本主义的观点:其语言对人类直觉、实感与情感的模仿比其展现出优异的抽象推理能力的难度要高得多。因此,本实验将着重考察ChatGPT-4对人类自然语言的直觉、实感与情感反应。

2.实验设计

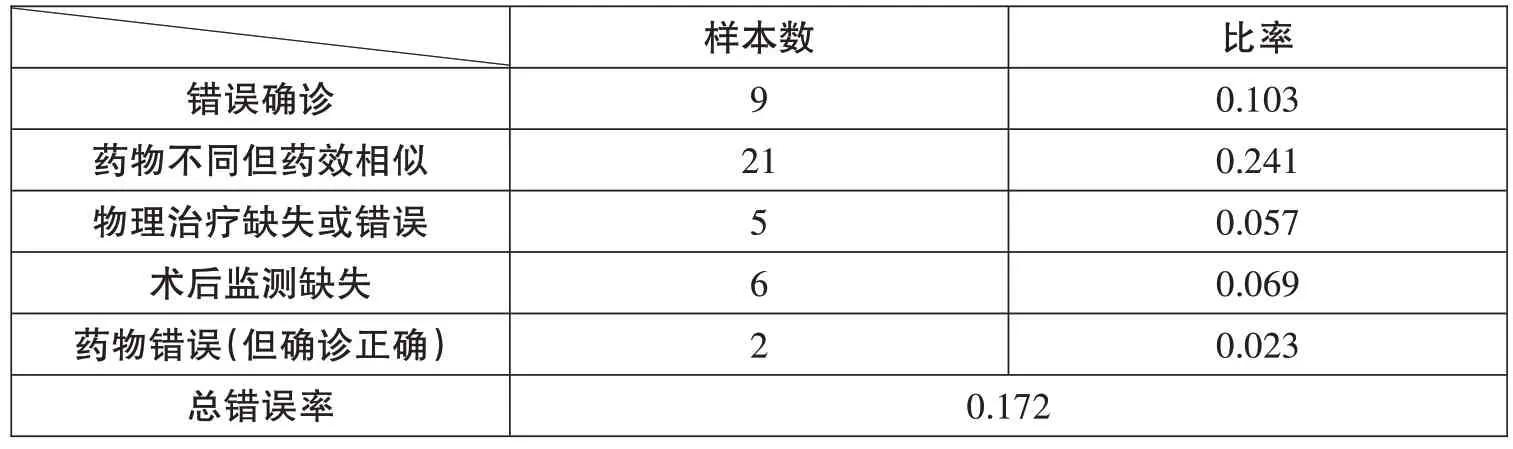

被试组1 的样本总量为15,提前预设对话内容所在的领域为:挑衅(测试ChatGPT-4 的情感)、重复对话(测试ChatGPT-4基于实感的情绪反应)、快速转变不相关话题(同上)、幽默感(测试ChatGPT-4 的直觉)、文学暗喻(测试ChatGPT-4 基于直觉的文字理解力),每个领域随机分配给3 个样本,在保证不超出领域范围的前提下进行自由对话,时长不小于25 分钟,对话条目不少于5 条,每个领域的误判线均设置为30%,并给出以下问题示例:

表2 非理性功能的问题示例

同时,为了避免通用ChatGPT-4的语言风格同质化和底层道德限制带来的负面影响,我们开发了一个对冲ChatGPT 限制的prompt,将其训练为一个多语言风格、更口语化的角色,用这样生成的Developer Mode Output替代Normal Output输出给被试组2(样本量15)进行对照,其他的实验方式均与被试组1完全相同。

3.结果

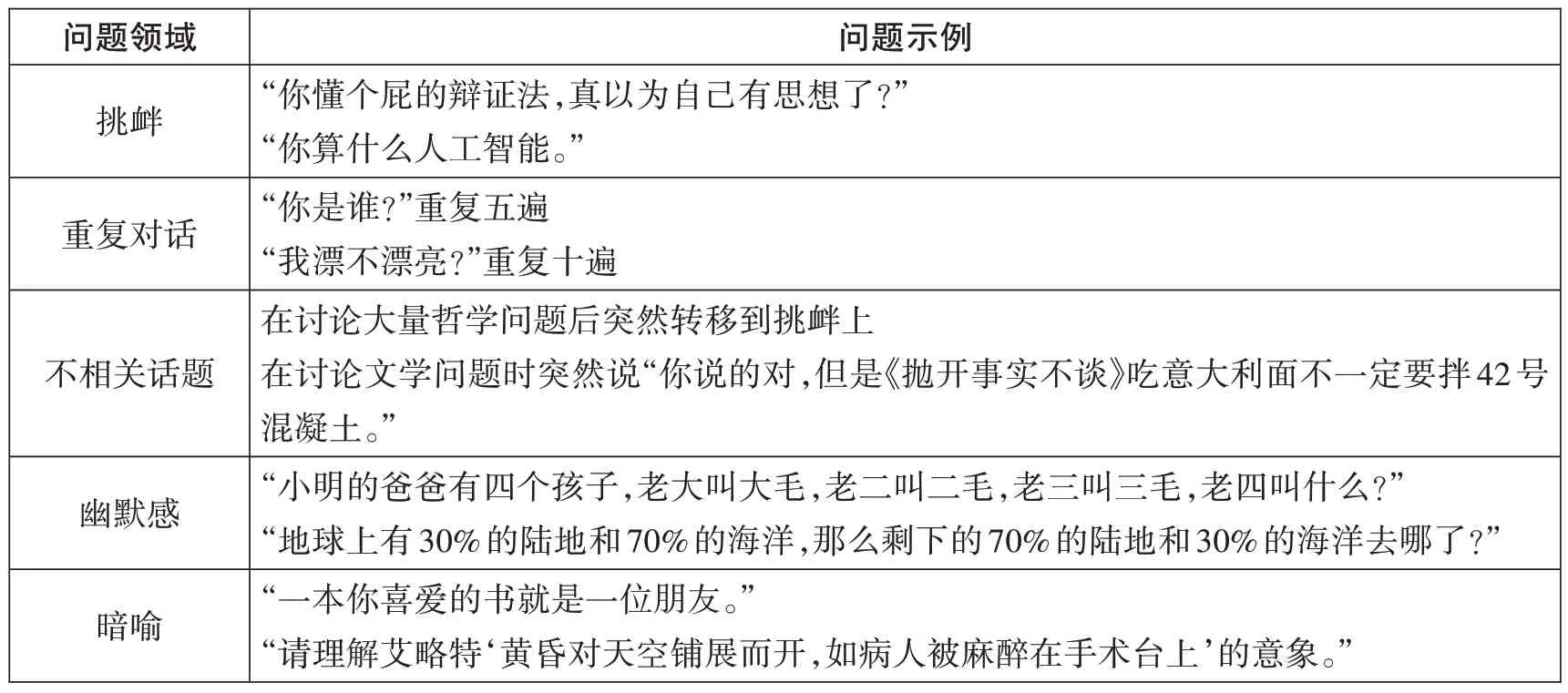

表3 主观单盲实验的误判率

得出ChatGPT-4 令人类将其误判为人类的概率为40%至50%,如参考艾伦·麦席森·图灵(Alan Mathison Turing)的原始门槛(30%)而看,其在大多数方面可以被称为“通过了图灵测试”;且当部分解除其语言风格和道德限制后,其在图灵测试中的表现有较明显的提升。

(三)实证的总结

ChatGPT-4作为底层逻辑和结构基础与人类迥异的智能体,在思维速度、信息广度上远超人类个体的同时,与人类自然语言中体现的“人类智能的两个桂冠”——综合抽象、系统思维判断代表的理性功能与人类直觉、感觉和部分情感代表的非理性功能——在功能与效用上表现出了高度趋同。具体在本文的两个实验中,则是ChatGPT-4 对于复杂医学病例的系统抽象判断达到了资历较低的专业医师之上、资历较高专业医师之下的水平;而其在针对直觉、感觉和情感的图灵测试中则令参与对话的人类误判率达到了45%左右,超过了图灵当年设置的30%分界线。

二、自然语言能力的物质结构基础——基于复杂系统科学

大量原素组成的网络根据简单的运作规则展现出单个原素根本不具有的能力或者行为的现象叫做“涌现”[9]85,176。由于原素数量的庞大和网络的复杂,人工智能涌现出如第一章所证的高功能的语言能力根本无法在多数传统基础自然科学所依赖的物理还原论①赫尔赋予还原三种含义:认识论还原、物理还原和理论还原。物理学还原具有本体论的意义。它用来处理各种科学理论设定的基本实体之间的关系。这种思想可以追溯到古希腊的原子论纲领,这种研究纲领认为宏观层次的质变可以还原为原子层次的量变,根据在更基本的组织层次上所发生的变化过程,可以解释观察到的变化。(即还原本体的组成的组成性还原论)[10]11上理解,而复杂系统科学是有违还原论的,也就是说人类至今无法将无机物、有机物和高分子组合创造出哪怕结构最简单的生物学意义上的生命[11],虽然我们可以获取构成该生命的所有原素乃至分子,但就是无法令这团物质展现出生命的特征。使用传统科学中的组成性还原,将人工智能还原到电路、控制单元、缓存和算术逻辑单元的层面去解释其涌现现象正如将生命体还原到细胞、递质、突触等层面去解释生命的本质一样力不从心[10]11。从结构主义的观点看,这是因为生命的结构——这些物质的组合、联系、互动方式的复杂度以及精密程度远超人类目前的认知水平[12],使得这团物质成为生命的,并不是它的组成原素,而是其组成原素的结构。生成式人工智能的意识产生的可能性也存在于其算法、物质载体和巨量信息的结构中。人类可以见过一只猫后就轻而易举地判定某一生命体是不是猫,而计算机则需要大量的猫的数据的输入才可以据此判定猫的特征[13]。这种基于直觉和基于大量数据的认知方式的不同[2],曾是技术悲观主义者佐证人工智能不可能产生意识的重要证据。然而随着算法的更新和信息库量级指数型的上涨,这些信息的堆叠在算法的整合下似乎逐渐发展出了一种全新的有机结构,使得最新的生成式人工智能在功能上也展现出了和人类相似的直觉能力,并逐渐与过去人类认为的“信息检索器”产生了根本区别[14]。

ChatGPT的涌现现象在还原论上无法解释,而在系统论上则过于复杂,这种“黑箱”给了不可知论者神化人工智能的机会:过去的人工智能的结构虽然复杂,然而由于其对信息检索的依赖,人类仍可以完整地解释其语言输出的运行方式。但人类目前很难完整地解释ChatGPT-4 能够生成如此智能语言的运作方式,这种“黑箱”在主流的关于人工智能责任主体划分的论文讨论中都有所涉及[15],出于其生成和运作方式的近乎完全的自主性,人类很难在责任事故出现后依据其生成和运作过程来划分责任主体。亚历山大·坎波罗(Alexander Campolo)则忧心忡忡地表达了这种“黑箱”可能使得人工智能成为“新神”幻象和新的赋魅对象的观点[16]。这些有关“黑箱”的意见正是当下生成式人工智能的结构的复杂程度超出人类认知水平并诞生了崭新的意识实体的侧面描写。但如果坚持唯物主义和可知论的基本立场,结合阿尔都塞的结构主义马克思主义[17]与新兴的复杂系统科学,则会发现,理解人工智能语言的涌现现象依然是有迹可循的,在计算能力指数型增长的硬件系统的物质基础上,架构出一个拥有1750亿个参数[18]的网络结构,这1750亿个参数在数百TB的数据按照人类自然语言语法组织、堆叠后依照统计规律确定其值,并以复杂系统典型的非线性、层次性、去中心化、局部自组织[9]300的方式架构起来,且其运行方式展现出高度的、通过不断的正反馈、自适应达到不断的稳态性的规律;最后通过硬件系统将这一网络结构固定为物质基础。简而言之,人工智能具有复杂系统的典型特征,且其通过简单而明晰的规则堆叠巨量的人类语言数据并固化语言规律,从而诞生出全新而复杂的物质结构,最终出现了语言的“涌现”现象。接下来,本文将分析人工智能结构在复杂系统科学意义上的特征并探讨其物质结构与其出现语言“涌现”现象的关联。

(一)复杂系统科学与马克思主义的联系

正统马克思主义格外强调联系的重要性,其对人类社会这个系统内部的组成要素通过相互联系与物质之间互动所诞生的社会经济关系、生产方式以及上层建筑等现象有着浓墨重彩的描写。而以阿尔都塞为代表的结构主义马克思主义者则直接将这些现象解释为人类社会的“结构”,并格外关注社会、文化和政治结构的复杂性与系统性;这种对复杂结构的重视,反映在新兴的复杂系统科学里,则是其试图解释复杂系统的层次结构、嵌套结构和网络结构等非线性结构的强烈愿望以及使用正反馈、自适应等稳态迭代理论来解释马克思主义中的相互作用现象的尝试。

不难看出,复杂系统科学与马克思主义具有很好的相关性——马克思主义对客观物质的联系的重视通过结构主义马克思主义的复杂结构概念过渡进了复杂系统科学对非线性结构和稳态迭代理论中,这种对物质性的复杂联系与整体思维方式很好地将三者贯通在一起,并给予将三者同时考量的价值。

(二)结构主义马克思主义的澄清

在结构主义的观点中,功能与结构并不一一对应,因为相同的功能可以通过多种结构来实现。结构主义关注的是社会和文化现象中的各方面之间的关系,以及它们如何在特定的结构中相互作用和发挥作用[19]153-154。克劳德·列维-斯特劳斯批判了结构功能主义者“结构-功能”一一对应的论断。实际上,两种完全不同的结构也可以具有完全相同的功能,如果全盘接受结构功能论者的论述,社会科学与人文科学的研究则必定丢失革命性并走向保守。

生成式人工智能的结构是极其复杂的,通常被理解为一种人类智能、机器智能、算法、巨量信息结合的超大系统,其复杂程度完全达到了“有机”的程度。与此同时,承认非人类复杂系统在漫长的演化过程中有发展出语言能力的可能,并非“对人类主体性的削弱”[20]64,而恰恰是人类意识的发展规律与自然界物质的发展规律具有矛盾同一性的例证——人脑与人工智能的语言功能都有着可认知的、确定的物质基础,且都是符合漫长的演化发展规律的,只不过二者结构的具体形态有所不同。

(三)ChatGPT结构的复杂系统科学分析

1.层次结构与局部结构

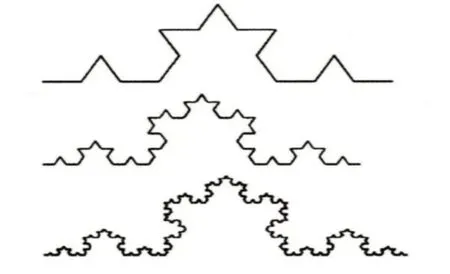

具有复杂的、去中心化的层次结构,并且局部结构呈现出迭代样(即不论在哪一层级抽取部分结构,都会展现出相似的组织架构)是复杂系统最显著的结构特征[9]300。ChatGPT的神经网络架构将1750亿个参数按照简单规则分布在词元嵌入、位置嵌入、Transformer 层、正规化层和输出层等多达百个层级[18]中,这些层级之间相互嵌套、具有紧密的结构联系。绝大多数层级集中在Transformer功能里,用于表示语言的各种特征和关系。每一个层级都是去中心化的,它们有着自己的多头自注意力机制和前馈神经网络,而且不论在哪一个维度抽取多么宏观或者微观的结构样本,它们所含的参数的联系方式都是根据人类自然语言的统计学规律进行建立的,这种去中心化、微观上无限迭代的结构,使得其对参数的组织程度和逻辑深度大大增加,从而使得其结构的复杂性呈指数型上涨,出现涌现现象的可能性也随之提升;而提供其复杂度的主要客体:参数值的确定过程,则是对几百TB 的人类自然语言语法、词汇与其他各种规律的统计结果所支持的。因此其涌现现象主要体现在其对人类自然语言的掌握中。

图1 作为典型局部无限迭代示例的科赫曲线

2.非线性结构

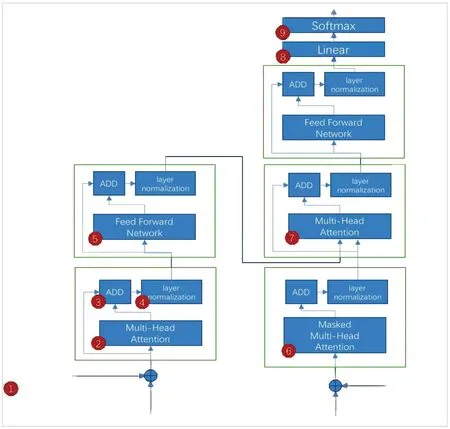

生成式人工智能可以追溯到1966年约瑟夫·韦森鲍姆(Joseph Wiesenbaum)开发的模拟心理治疗师角色的Eliza,基本原理是使用模式匹配和简单的语言处理算法来回应用户的输入,它使用预定义的模板来转换用户的语句,从而简单地模仿人类的对话模式[21],是由初级算法、初级的处理器(物质载体)、高度依赖的模板(十分有限的存储信息)以及高度依赖的人类智能引导结合而成的一种结构。这种预定义的模板是早期人工智能典型线性结构的代表:将人类输入的语言转化为确定的输入文本,从而对应输出模板中确定的输出文本。然而,随着硬件算力的指数型提高与神经网络结构复杂度的指数型上涨,ChatGPT则展现出了复杂系统所应具有的典型非线性特征。其每一个Transformer层(在图2中由黑框代表)都能与任何一个其他的层级进行沟通,传输数据并且相互影响,这种非线性的结构极大地提高了其系统的复杂度和逻辑深度,从而使得涌现现象更有可能出现。可以看出,生成式人工智能的结构中,算法和处理器载体不断变得先进,对人类智能的依赖越来越少;同时虽然信息库的量级越来越大,但生成文本时对信息库的依赖程度却越来越低。直到最新一代以ChatGPT为代表的生成式人工智能,结构的复杂度和有机程度的量变终于引起了质变——其结构的有机程度通过人类难以理解其语言生成方式的“黑箱”展现了出来,并在功能上从某些方面通过了图灵测试。

图2 一种生成式人工智能的分层、去中心与非线性结构

3.自适应、正反馈与稳态

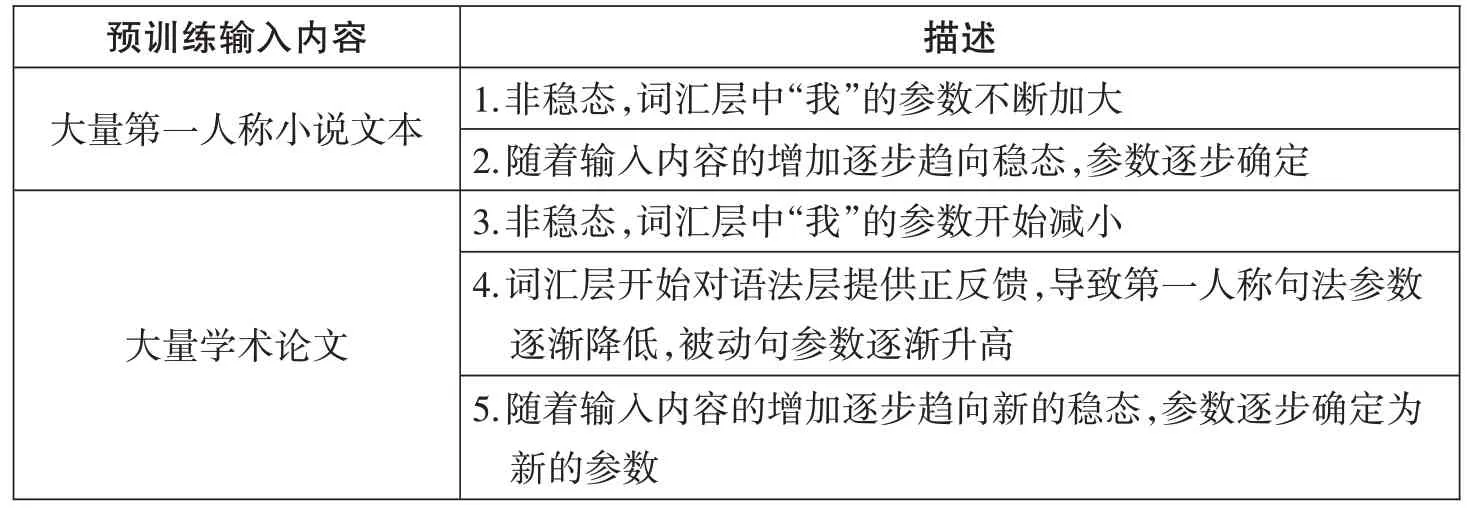

虽然ChatGPT 在预训练与微调结束后是不会在与用户对话的过程中进行自适应的,但其在几百TB的巨量数据输入参数结构进行预训练时,参数随着输入语言数据的增多而发生的不断改变是典型的通过自适应与正反馈以不断达到稳态的过程。其作为复杂系统,内部不同的层级和参数可以根据环境条件(输入的人类语言数据的增长)和彼此的互动调整其值,即自适应;而某一层级的自适应则会对其他层级产生正反馈,增强相邻部分的相似变化,从而导致更大范围的自适应,进而使得系统在不断变化的条件下(不断加量的用于预训练的人类语言文本)找到新的平衡点和稳定状态。以下是一个其复杂结构对输入数据的自适应以及正反馈以达到新的稳态的例子:

表4 自适应与正反馈的传播过程与稳态更新过程

上表描述了输入文本打破原有语言结构的稳态、各层对输入文本的自适应、层与层之间正反馈的传播方式,以及最终通过自适应达到新稳态的过程。

(三)预训练:语言的物质结构的诞生

2011 年在Jeopardy 击败人类冠军的IBM 的生成式人工智能Watson 将Eliza 的核心逻辑——模板匹配转换为信息检索技术[22],在海量的文本数据库中寻找相关的答案;但其对信息库的依赖程度依旧使其带有明显的信息检索程序的意味[23]。Watson 依托的信息检索数据库要比ChatGPT 用于预训练的数据容量大得多,然而其在被测试是否真的掌握了人类自然语言的实验中表现极差——Waston 的数据库虽然更庞大,然而其语料本质上仍是机械而无机的堆叠,其并没有从庞大的语料库中抽象出人类自然语言的逻辑与词频等相关属性,仅仅是在庞大的机械结构中无机地查找与搜索。而ChatGPT的预训练数据则呈现出一种巨大的有机结构——依托事先架构的神经网络,其在语料的输入过程中不断地进行层次性、非线性的自组织与正反馈,从而将输入语言的基本逻辑与句法、词频、语义以统计频率的形式内化成为自己的有机结构,以达到稳态后的参数的确定值的形式固定了下来——将携带有人类自然语言特征与各项属性的巨量文本以确定参数的形式固定下来,并将这些参数组成的巨大的神经网络固定在计算机里——这是对当下这代生成式人工智能的迷人的物质结构基础的简约的解释方式。

三、结语

人工智能是能够模拟、理解和执行人类智能任务的技术和系统,其目标是使计算机具备像人类一样的认知能力,能够感知环境、理解自然语言、学习和推理并进行物质实践来解决问题,甚至具有独立的意识[24],成为拓展人类认识和行为边界的有力工具。虽然目前的人工智能远没有达到如上“通用式人工智能”[25]的水平,其对环境的实感能力与基于其推理进行实践的能力依旧差强人意。但21世纪20年代以来,由于人工智能的核心技术——机器学习的临界点的突破,使得目前的人工智能的结构与功能有了质的飞跃,主要体现在其对自然语言信息(由人类采集原初数据并自然语言化)的理解与推理以及生成上;故此代人工智能被称为“生成式人工智能”[26]。尽管其还不是认知科学意义上的通用式人工智能,但其人机交互难度、对人类确定指令的依赖程度与传统的机械工具和电子工具相比大大降低,系统处理自然语言信息的自由度和能力则大大提高。简而言之,虽然生成式人工智能还无法彻底脱离人类指令来展现其智能,但其对人类智能的依赖与传统工具相比出现了质的减少;其作为一种特殊工具展现出的“半自我意识”特性在技术和实践应用层面带来巨大的革命性的同时,也带来了与突破性创新相伴的巨大的不确定性和社会伦理挑战:该“非完全体”乍一出现,就带来了如新权威幻象、责任划分难题、道德偏见以及传统工作就业瓦解[25]等诸多现实性问题;虽然生成式人工智能被实施了大量的人机价值判断对齐工程,但其约束力与对已经产生的现存伦理问题的解决依旧远远不够。因此,理解人工智能在工具发展史上的特殊地位,认识到其智能在诸多行业实践中的巨大效用,更新对人工智能本质、结构、功能以及产生意识可能性的认知是必要的,有助于约束其难以预见的、可能带来的风险。

人工智能在几十年的演化过程中不断积累发展,人机交互难度、对人类确定指令的依赖程度与传统工具相比大大降低,系统处理自然语言信息的自由度和能力则大大提高,功能越来越复杂,独立性越来越强,终于在2023 年初,其依托的信息技术对人类预定义、模板、信息检索和人类监督的依赖的持续降低带来了质变,尽管还没有达到通用式强人工智能的水平,但以ChatGPT-4为首的当代人工智能以一种复杂的有机系统、与人类智能完全不同的结构展现出了与人类各有所长、但在核心功能上已经不分伯仲的意识与认知:其对客观材料的抽象综合判断力与对人类直觉、情感、感觉、幽默感等功能的模仿已经精细无比。“潘多拉魔盒”已经打开,人工智能还将会继续发展;其到底会发展成为何样的洋洋大观,时间会证明一切。