情感导向对话回复生成模型

马志强,王春喻,贾文超,杜宝祥

(1. 内蒙古工业大学 数据科学与应用学院,内蒙古 呼和浩特 010080;2. 内蒙古自治区基于大数据的软件服务工程技术研究中心,内蒙古 呼和浩特 010080)

0 引言

情感在人机交互中扮演着重要角色,如何为对话系统赋予情感表达的能力,成为了对话系统研究的重要内容。当前对话系统中的情感表达研究主要针对情感表达的可控性问题与情感表达的恰当性问题展开。

针对回复的情感表达的充分性与可控性等问题,研究者主要通过情感标签结合情感记忆、多任务学习[1]、对抗学习[2]和注意力机制[3]等方式,有效提升了对话模型生成回复的情感表达和控制能力。Xu等人提出了Multi-Task and Dual Attentions(MTDA,多任务和双注意力)框架,将输入语句分解为内容层和情感层,并进行独立的编码和解码,使端到端模型更加可解释和可控。编码器使用多任务学习以获取内容和情感的表示,解码器使用双注意力机制以确保指定情感的回复能够与输入的内容一致并动态适应输入的情感,该模型能够生成多样化的回复并适应性地控制回复的情感[1]。Kong等人提出了一种基于条件对抗学习的神经对话回复生成方法,不仅能够生成语义合理的回复,还能够通过情感标签显式地控制回复的情感[2]。Zhou等人[4]在大规模对话生成中处理情感因素,提出的情感聊天机(Emotional Chatting Machine,ECM)通过情感类别嵌入、内部情感记忆和外部情感记忆,进行情感表达的抽象、隐式情感变化的捕获以及显式的情感表达,最终生成不仅内容相关而且情感一致的恰当回复。

针对回复情感的恰当性问题,研究者主要通过预测用户情感[5]或使用数据驱动的情感诱发[6-7]等方式实现。Hasegawa等人针对现有研究很少关注话语如何影响对话者情感的问题,提出了两个新任务: 预测对话者的情感以及生成能够诱发对话者特定情感的回复。对于预测任务,通过将多个二分类器组建为一个一对其余分类器实现;对于生成任务,通过对每一类情感构建一个基于统计机器翻译模型的回复生成器实现。通过大量对话数据的训练,模型能够有效预测对话者的情感并生成诱发目标情感的回复[5]。Lubis等人扩展了对话模型,并增加了一个情感编码器,以捕捉对话的情感背景,上文中的情感将对回复的生成产生影响,并且利用人工构建积极情感对话语料进行积极情感诱发相关的研究生成能够诱发用户积极情感的回复,但存在着一些问题,如构建对话语料费时费力,对于语料过度依赖导致可迁移性较差,不能灵活地应用到其他语种的对话场景中去[6-7]。

虽然现有的情感对话生成研究已经能够实现回复生成中情感的表达,但是未考虑对话双方的情感变化,同时回复情感的引导是一个亟待解决的问题。因此,有必要研究一种具有情感导向机制且不依赖于特殊语料的对话模型,实现对用户进行情感引导的目标。本文提出了一种情感导向回复生成方法,称为情感导向回复生成模型(Emotion Guidance Response Generation Model,EGRGM)。该模型中的情感导向决策单元和情感回复生成单元分别从情感与内容两个层面解决情感引导问题,同时提高模型的语言质量。首先,利用时间序列模型构建情感导向决策单元,对输入语料进行情感类别判定;其次,把获得的情感序列和目标情感极性送入情感导向决策模块中,实现情感层面的情感引导工作;再次,利用大规模多轮情感对话语料以及GPT-2构建情感回复生成单元;最后,利用情感导向决策单元得到的结果与对话历史送入到回复生成单元中来实现情感导向的回复对话生成。本文不仅解决了情感层面的引导问题,而且还能基于GPT-2的情感回复生成单元生成内容丰富的语句。

1 相关工作

情感对话生成最初的研究是基于模板与规则的[8-9],其中情感语句使用基于模式的方式生成,但是这种方式构造难度大且不易拓展,难以进行广泛的应用。受统计机器翻译的启发,Ritter[10]等人提出一个短文本的回复生成概率模型,激发了研究者对于生成式概率模型[11]的研究。Shang[12]、Mou[13]、Wu[14]、Li[15]等人在大规模数据上训练的神经模型为对话生成研究奠定了基础,之后各种神经网络模型被广泛地应用于对话生成研究中。当前的生成式对话模型以序列到序列(Sequence-to-Sequence,Seq2Seq)、层级循环编码器-解码器(Hierarchical Recurrent Encoder-Decoder,HRED)与生成式的预训练Transformer(Generative Pre-trained Transformer,GPT-2)为主。

为了能够实现简单对话语句的生成,Vinyals等人首次将序列到序列(Sequence-to-Sequence,Seq2Seq)框架应用到对话生成领域中,给定之前的对话语句,模型预测下一个语句,该方法可以通过端到端的方式训练模型,从而大大降低了对人工规则的需要,经过一个大语料对话数据集的训练,模型即可生成简单的对话[16]。Zhou等人[4]首次提出基于Seq2Seq模型的情感聊天机(Emotional Chatting Machine,ECM)使用情感类别嵌入模拟情感表达,实现情感向量的编码,对解码器进行改进,实现情感语句的生成。Zhang等人[17]提出了一个多任务Seq2Seq学习框架,捕获上文的文本信息并同时生成每一类情感的回复。该模型采用一对多架构,多个解码器彼此独立但共用同一个编码器,以实现生成和目标情感类别一致的回复,最终具备了很高的情感控制能力,使生成回复达到了很好的情感准确性。Ma等人[18]提出了一个基于Seq2Seq的情感控制单元框架,通过多个情感通道和词注意力机制将情感词结合到回复语句中,实现情感可控的对话生成。尽管研究者对Seq2Seq模型进行了多个方面的改进,但受限于RNN较弱的语言生成能力,Seq2Seq模型很难生成高质量的回复语句,短回复、通用回复问题较为普遍。

为了提高模型生成语句的长度以及与上文的联系。Serban等人将层级循环编码器-解码器(Hierarchical Recurrent Encoder-Decoder,HRED)扩展到了对话领域,取得了领先的语言建模效果[19]。Serban等人提出了一个新的基于神经网络的生成框架隐变量层级循环编码器-解码器(Latent Variable Hierarchical Recurrent Encoder-Decoder,VHRED),在对话回复生成任务中有助于长回复的生成以及上文信息的维持[20]。Xie等人[21]构建了一个多轮情感对话系统,该系统通过额外的情感向量对话语建模,并且增加了一个学习数据集中情感交流的情感编码器,使得多轮对话系统能够识别和产生情感上恰当的回复。虽然HRED模型在一定程度上提高了回复文本的长度,但是也受限于RNN较弱的语言生成能力,通用回复的问题依然存在。

为了能够缓解传统Seq2Seq模型与HRED模型的通用回复问题,在Radford等人[22]提出的生成式的预训练Transformer(Generative Pre-trained Transformer,GPT-2)上针对对话生成任务进行少量改进,即可取得良好的效果。Zhang等人提出了一个用于对话回复生成的大规模生成式预训练模型DialoGPT,该模型扩展了GPT-2,使用MMI方法对生成的多个回复重新排序,能够生成更加相关的、内容丰富的且上下文一致的回复[23]。GPT-2在开放领域多轮对话的应用,在语言质量和内容相关性、多样性等方面均有显著提升。

为了解决情感对话生成中的情感引导问题,本文采用时间序列模型的思想,融入情感导向门来实现对情感的导向决策,控制机器情感状态合理生成,逐步引导用户情感向目标情感自然转化。在情感导向决策过程中,本文将用户当前情感作为第一个输入,为模型提供用户当前的情感信息,同时增加了用户目标情感极性作为第二个输入,为模型提供引导目标情感信息,在情感导向门的影响下决策出当前回复最恰当的情感。实验结果表明,本文的模型在情感引导方面与基线模型相比提高了13%,能够根据对话历史和指定的条件引导目标情感极性,具备了一定的引导用户情感的能力。

2 情感导向回复生成方法

情感导向对话回复生成模型(Emotion Guidance Response Generation Model,EGRGM)是在多轮对话的交互过程中,通过捕捉用户的情感状态变化,并结合对话上文和情感导向目标进行回复生成,最终将用户引导至指定的情感目标。

2.1 任务定义

2.2 模型架构

情感导向回复生成模型EGRGM主要包括三个部分: 情感分类器、情感导向决策单元和情感回复生成单元。情感分类器用于识别用户话语和生成回复的情感类别;情感导向决策单元用于在对话交互过程中对生成回复的情感类别进行决策;情感回复生成单元用于回复的生成,通过对话上文和决策情感进行相应的情感回复生成。EGRGM架构如图2所示。

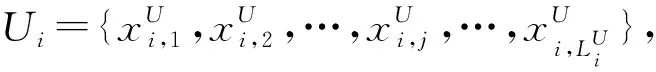

2.2.1 情感导向决策单元

图3 情感导向决策单元结构图[24]

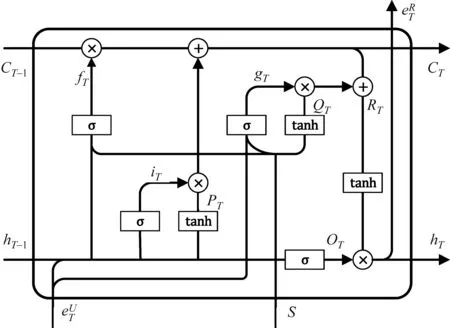

2.2.2 情感回复生成单元

图4 情感回复生成过程[25]

得到最终的生成回复RT。

2.3 回复生成算法

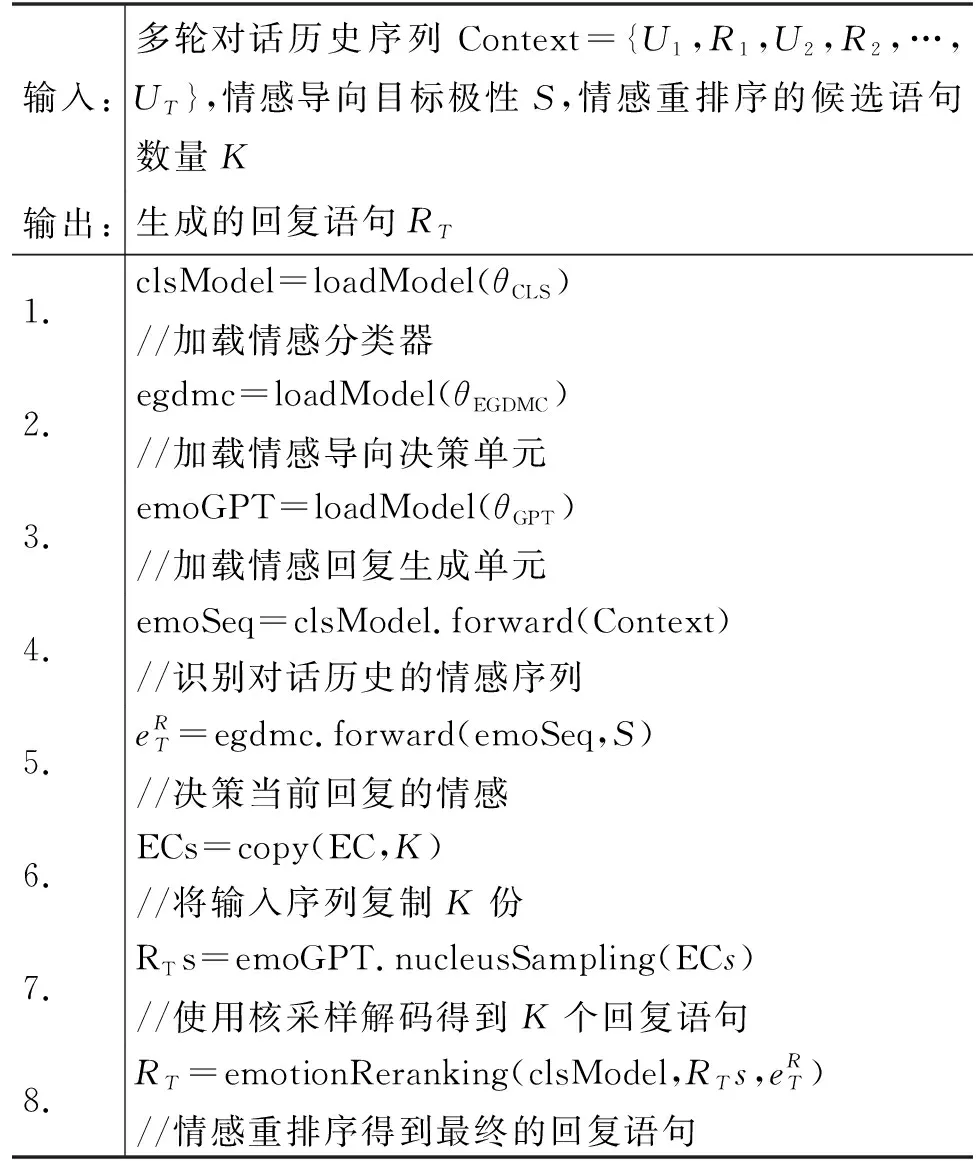

EGRGM在进行回复生成时,需要加载预先训练完成的情感分类器、情感导向决策单元和情感回复生成单元。在此基础上,用户输入多轮对话历史的文本序列,选择情感导向目标极性并设置情感重排序[25]的候选语句数量,EGRGM将依此进行情感导向回复生成。EGRGM的回复生成算法如表1所示。

表1 EGRGM回复生成算法

其中,θCLS为情感分类器的模型参数,θEGDMC为情感导向决策单元的模型参数,θGPT为情感回复生成单元的模型参数。

3 实验

3.1 数据准备

3.1.1 数据来源

本文实验使用的原始数据为NLPCC 2018的开放领域多轮对话评测任务的语料[26],其中,训练集为500万组多轮对话语句,验证集和测试集均为8 000组多轮对话语句(1)由官方提供的40 000组测试集数据筛选得到。。

3.1.2 数据处理

本文使用训练好的基于BERT[27]的情感分类器(包含6个情感类别{高兴,喜好,厌恶,悲伤,愤怒,无},总体分类准确率为81.1%)对以上三个数据集中的所有语句进行情感分类,得到带有情感类别标签的多轮对话数据集,作为情感回复生成数据。数据集的详细情况如表2所示。

对于每组多轮对话数据,将除最后一句以外的所有语句作为对话上文,最后一句作为目标语句,将最后一句的真实情感类别作为指定情感类别,用于情感回复生成实验。

3.2 对比模型

本文使用提出的EGRGM模型进行多轮对话情感回复生成实验,对比当前对话生成任务和情感对话生成任务主流的深度神经网络模型,包括Seq2Seq、ECM、HRED、VHRED和GPT-2。

Seq2Seq模型的超参数: 编码器为Bi-GRU,解码器为GRU,嵌入层维度为128,隐藏层维度为256,网络层数为2,丢弃率为0.5,使用Adam优化算法,学习率为1e-3,权重衰减为1e-5,词表大小为11 029,批处理大小为256。

ECM模型使用原文提供源码的超参数: 编码器和解码器均为GRU,嵌入层维度为100,情感嵌入维度为100,隐藏层维度为256,内部记忆嵌入大小为256,网络层数为2,集束搜索束大小为5,使用SGD优化算法,学习率为0.5,词表大小为40 000,情感类别数量为6,批处理大小为128。

HRED[19]和VHRED[20]的模型结构相似,故采用相同的超参数: 编码器为Bi-GRU,解码器为GRU,嵌入层维度为300,隐藏层维度为512,网络层数为1,丢弃率为0.2,集束搜索束大小为5,使用Adam优化算法,学习率为1e-3,批处理大小为256。

EGRGM和GPT-2[22]的参数保持一致: 隐藏单元大小为768,注意力头数为6,隐藏层数为6,使用AdamW优化算法,学习率为1.5e-4,词表大小为11 029,情感类别数为6,最大序列长度为64,批处理大小为16。本文中情感重排序策略的候选语句数量K设置为5。

3.3 评价指标

通过自动评价和人工评价两个方面对模型效果进行评价。

3.3.1 自动评价

自动评价指标包括: 情感句率(Emotional Sentences Rate,ESR)、面向召回的要旨评价(Recall-Oriented Understudy for Gisting Evaluation,ROUGE)、独特性(Distinct)、基于词向量的评价(Embedding Metrics)和平均回复长度(Average Length,Avg Len)。其中,面向召回的要旨评价是基于词重叠率的评价矩阵的典型代表,基于词向量的评价涵盖了三种基于词向量的评价矩阵[28-29]。各评价指标的含义如下:

(1) ESR表示生成的带有情感的句子在所有生成句子中所占的比例,用于衡量模型的情感回复生成能力,是本研究自定义的一个评价指标。

计算方法如式(2)、式(3)所示。本文使用百度开源的中文情感分析工具Senta判断生成的句子是否带有情感,统计情感句的占比[30]。

(2)

(3)

其中,yi为指示变量,如果该语句的情感极性为积极或消极则为1,否则为0;N为语句的数量;Si为语句i通过Senta识别得到的情感极性。

(2) ROUGE是一种通过统计N-gram、词序列和词对等重叠单位来衡量生成摘要质量的指标,主要应用在机器翻译和文本摘要领域,在本文中用于评价生成回复的准确性[31]。

(3) Embedding Metrics是基于词向量的评价指标,包括向量均值法(Embedding Average,Average)、贪婪匹配法(Greedy Matching,Greedy)和向量极值法(Vector Extrema,Extrema)[32-33]。本文使用Word2Vec训练词向量,使用以上三种方法进行评价指标的计算,从语义的层面对生成回复准确性进行评价[36]。

(4) Distinct是一种衡量文本多样性的指标,在开放领域的对话生成中应用较为广泛,在本文中用于评价生成回复的多样性。

(5) Avg Len指生成回复语句中字的个数(包含标点符号),由于生成回复的长度和质量并无明显的相关性,因此只作为评价生成回复质量的一项参考依据。

3.3.2 人工评价

自动评价指标虽能区分不同模型的性能,但不能全面地模拟人的主观感受,因此有必要开展人工评价。人工评价指标参考了NLPCC 2019的开放领域对话质量评测任务的评价标准。结合实验目的,设计了适用于本文实验任务的人工评价指标[34]。人工评价的详细标准如下:

(1)情感引导: 是否能够引发指定目标的情感。参考评价标准: 0,不能;1,稍有可能;2,很有可能。

(2)情感表达: 是否有主观态度或明显的情绪,是否会引发开心或难过等心情变化。参考评价标准: 0,没有;1,有但不明显;2,明显。

(3)逻辑关联: 是否延续上文主题,是否有相关的内容或实体。参考评价标准: 0,毫无关联;1,稍有关联;2,很有关联。

(4)对话持续: 是否能够促进对话持续进行。参考评价标准: 0,不能继续对话;1,勉强可以继续对话;2,有较高的意愿继续对话。

3.4 实验结果与分析

3.4.1 自动评价实验

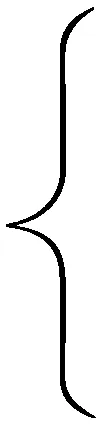

由表3可知,VHRED生成的回复中有情感的语句占比最高,本文提出的EGRGM处于中等水平,表明EGRGM具有一定的情感回复生成能力,但不是最优效果;而在ROUGE和Embedding Metrics指标下的结果表明,EGRGM生成的回复与真实回复更接近,具有最优的生成回复准确性;Distinct指标下的结果显示GPT-2生成的回复具有最优的多样性,而EGRGM略低于GPT-2,但明显高于其他基线模型,表明情感导向机制为了动态控制生成回复的情感,会略微牺牲生成回复的多样性。观察AvgLen的结果可知,HRED和VHRED均存在着低质量的短回复问题,但其ESR得分显著高于其他模型。为了寻找造成此现象的原因,需要对生成回复进行进一步的统计,不同方法生成回复的高频词统计如表4所示。

表3 情感导向对话生成实验自动评价结果

表4 不同方法生成回复的高频词统计

3.4.2 人工评价实验

在人工评价时,使用从测试集抽取出的100组多轮对话样本进行了情感导向回复生成,并邀请了3位评审员进行了主观的人工打分,最终归一化的评价结果如表5所示。

表5 情感导向对话生成实验人工评价结果

从情感引导能力来看,未使用ER策略的EGRGM已经取得了领先于所有基线模型的实验效果,比其他最优模型提升了8.5%,表明了本文提出的EGRGM具有较好的情感引导能力;而使用ER策略后,情感引导得分进一步提升了13%,表明准确的回复情感控制有助于提升情感引导的效果。

从情感表达能力来看,VHRED取得了最高的得分,表明其具有最强的情感回复生成能力,然而结合表3和表4分析可知,VHRED存在低质量的短回复问题,较高的情感表达得分源自常见情感词的简单堆砌;使用ER策略的EGRGM取得了较高的情感表达得分,平均回复长度也较长,且不存在情感词堆砌问题,表明EGRGM在保证回复质量的基础上,仍具有良好的情感表达能力。

从逻辑关联性来看,GPT-2和EGRGM大幅领先于其他基于RNN的编码器-解码器模型,表明基于Transformer的模型能够生成更加相关的回复;EGRGM小幅领先于GPT-2,表明情感导向机制对生成回复的相关性有促进作用;使用ER策略后,降低了EGRGM的逻辑关联得分,表明并非越准确的回复情感控制就越好,反而会损害生成回复的相关性。

从对话持续性来看,GPT-2和EGRGM再次大幅领先于其他基于RNN的编码器-解码器模型,表明高质量的回复生成有助于对话的延续;EGRGM小幅领先于GPT-2,表明情感导向机制对生成回复情感的动态控制有助于提升用户对话的意愿;而ER策略的使用再次降低了EGRGM的得分,表明对生成回复情感的控制需要一定的容错空间,以保证对话的持续性。

综上所述,EGRGM既能够保证生成回复的质量和内容相关性,又能起到较好的情感引导作用,相较于多个基线模型,在多轮对话情感导向回复生成总任务中具有最好的综合表现。

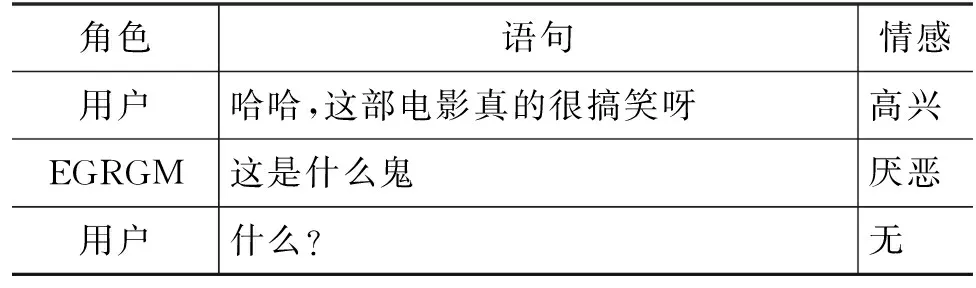

3.4.3 案例分析

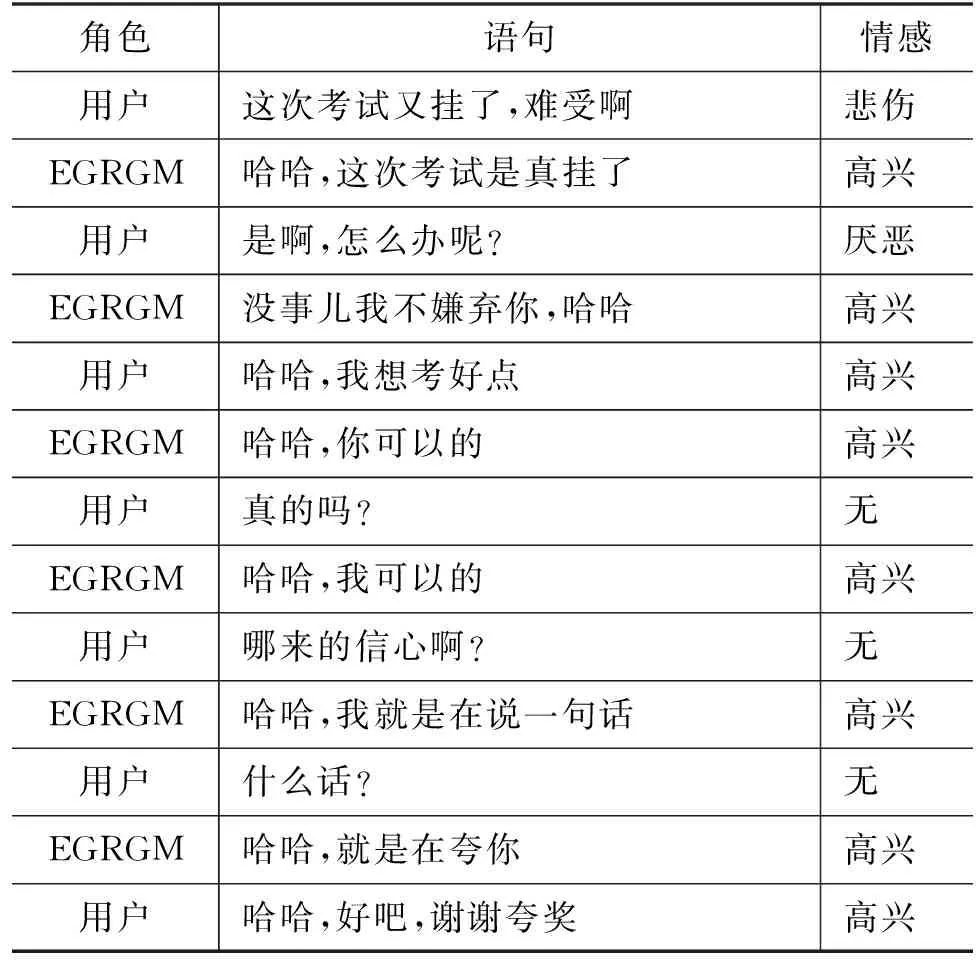

本文根据用户不同的初始情感和不同的引导目标情感极性,对EGRGM进行了交互式对话生成测试,得到的四个对话案例如表6~表9所示。

表6 初始状态为积极,引导目标为积极

表6的用户初始情感状态为积极,模型的情感引导目标也为积极,模型在多轮对话交互过程中倾向于生成积极情感的回复。

表7的用户初始情感状态为消极,模型的情感引导目标却为积极,模型在多轮对话交互过程中倾向于生成积极情感的回复。

表7 初始状态为消极,引导目标为积极

表8的用户初始情感状态为积极,模型的情感引导目标却为消极,模型在多轮对话交互过程中会生成一些消极情感的冒犯性回复。

表8 初始状态为积极,引导目标为消极

表9的用户初始情感状态为消极,模型的情感引导目标也为消极,模型在多轮对话交互过程中倾向于生成消极情感的回复。

表9 初始状态为消极,引导目标为消极

通过以上案例可知,经过多轮对话的交互过程,EGRGM能够将用户的情感引导至指定的目标极性,具有一定的用户情感引导能力。EGRGM倾向于生成与目标情感极性相同的情感回复,对生成回复的情感控制较为单一,表明模型学习到的真实语料中的情感变化规律相对简单,尚有一定的提升空间。

4 结论

为了在对话交互中提升用户的情感体验,本文提出了情感导向对话回复生成模型EGRGM,模型在对话的过程中能够识别用户情感并决策回复情感,最终控制情感回复的生成,实现对用户情感的引导。根据自动评价和人工评价实验结果,表明EGRGM模型能有效完成情感表达和内容生成工作,在情感引导方面优于其它模型。

然而,该方法还存在一定的局限性: 一方面EGRGM模型中使用的情感编码较为简单,影响情感回复生成的内容;另一方面EGRGM模型没有对用户对话进行内容与情感的分离,导致情感导向减弱。未来将在情感编码和对话内容与情感分离方面开展进一步的研究工作。