用于行人轨迹预测的场景限制时空图卷积网络

陈浩东,纪庆革

1.中山大学计算机学院,广州 510006;2.广东省大数据分析与处理重点实验室,广州 510006

0 引言

行人轨迹预测是汽车自动驾驶、社交机器人及安全监控领域内一项至关重要的任务。例如,当无人驾驶汽车在车道上行驶时,需根据车载摄像头拍摄周围人群和场景,经系统数据提炼后对周围行人的未来路径进行预测,从而调整速度和方向,避免发生交通事故。行人轨迹预测的本质为根据行人过去一段时间内产生的轨迹坐标,预测未来一段时间内的行人路径。

由于人类并不是按照特定程序执行命令的机器人,人类运动和行为并不能由一段复杂的数据公式来解释。行人轨迹规划具有确定性和随机性。确定性可解释为无论中间路径会发生什么样的偏移,行人仍会抵达最终目的地。随机性可解释为行人之间相互依赖,目标行人规划未来路径时会考虑周围行人的位置、行为和外貌状态等因素,根据社交礼仪和本地习俗等调整中间过程速度大小和方向。

随着行人轨迹预测领域的不断发展,行人空间交互对行人轨迹的调整作用得到了学者们的大量研究,例如社会力模型(social force model)(Helbing 和Molnár,1995)建模行人之间因为相同目的地产生的引力以及为了避免碰撞而产生的斥力,社会长短期记忆网络(social long short-term memory,Social LSTM)(Alahi 等,2016)提出社会池模块建模目标行人空间特征受周围行人空间交互行为的影响,然而行人在前行过程中除了会考虑动态代理(行人、车辆等)的物理特征外,还会基于周围静态事物(如建筑物、草坪等)调整自身运动规划,避免发生碰撞。场景元素对行人轨迹的调整作用是不可忽视的。有学者对结合场景的行人轨迹预测方法进行了初步研究,如深度随机循环神经网络编码器—解码器(deep stochastic recurrent neural network,DESIRE)(Lee 等,2017)、符合社会注意力和物理注意力的生成对抗网络Sophie(Sadeghian 等,2019)和多生成器模型(multi-generator model,MG-GAN)(Dendorfer等,2021a)。Sophie 提出物理注意力机制来建模场景限制作用,社会注意力机制来建模行人限制作用。MG-GAN 在Sophie 的基础上使用路径模式网络来建模轨迹多模态性。这些方法通常将场景图像展平后通过多层感知机来生成场景特征。然而,展平操作会破坏场景空间性质,无法充分利用场景空间信号所包含的隐藏有利信息,同时也无法直观地解释场景对行人运动的调节作用。

为了更直观地捕获行人运动所具备的空间属性以及行人交互相关依赖性,有学者提出基于图注意力网络(Kosaraju 等,2019)的方法,将行人作为图节点,行人轨迹特征作为节点属性,行人之间的空间交互作为图中的边,以此来建立行人时空图表示。这类方法依赖于图表示来建模场景下行人之间的社会交互,能直观、自然且有效地建模行人之间的空间交互行为。GAT(graph attention network)编码不同行人对目标行人的影响权重因子,然后将权重因子与行人运动特征对应相乘,旨在学习全局模式下行人间的社会交互。然而,在拥挤场景下,由于人群密度过大和社会交互更为复杂,基于注意力机制的时空图神经网络可能会发生权重分配紊乱现象,导致精度不佳。

为了解决以上两个局限性,本文提出受场景限制的时空图卷积神经网络(scene-constrained spatial temporal graph convolutional neural network,Scene-STGCNN)。该模型是一种可训练的端到端的深度学习模型。为了解决基于图注意力机制的时空图神经网络具有的局限性,Scene-STGCNN 以图卷积神经网络代替图注意力机制作为主体框架,对场景下行人速度时空图表示进行时间和空间双通道卷积编码操作,更关注局部模式下行人空间交互的相互关联性以及行人动态信息的上下文依赖关系。为了解决结合场景信息的方法无法直观解释场景对行人运动的调节作用的问题,本文设计了一个基于场景的微调模块,该模块以手工制作的场景特征(场景块内语义变化面积占场景块总面积比例)为输入,通过对其在空间通道做卷积操作,自适应地提取出能有效调整行人运动特征的场景特征表示。该模块对人—场景交互进行显式建模,旨在学习场景语义对行人运动行为的实时性调节作用。

本文在公开数据集ETH(Pellegrini 等,2010)和UCY(Lerner 等,2007)上进行实验,并通过移除基于场景的微调模块验证其在学习场景对行人轨迹的调节能力上广泛的有效性。实验结果表明,Scene-STGCNN 在行人轨迹预测任务中相较于几种基准方法取得了明显的优势,获得了显著的精度提升。

本文主要贡献如下:1)提出一种用于行人轨迹预测的场景限制时空图卷积网络Scene-STGCNN,基于时空图卷积交换,融合行人时空特征。与基于图注意力机制的时空图神经网络相比,其更关注局部模式下的行人运动,实现更加精确的预测;2)设计了一种基于场景的微调模块,显式建模场景对行人运动的调节作用,解决了结合场景信息的轨迹预测方法无法直观解释场景对行人运动的调节作用的问题;3)公开数据集ETH 和UCY 上的实验结果表明,Scene-STGCNN相比于其他方法达到了最优结果。

1 相关工作

1.1 社会交互建模

行人轨迹预测领域引入了许多以行人运动数据为基础、建模行人社会交互的方法。前期的工作大多为基于手工定制特征的方法。社会力模型以封闭形式的数学模型建模了两种力:目的地对行人的吸引力和行人之间的排斥力。经济学领域内的离散选择模型(discrete choice model)(Antonini 等,2006)也在行人轨迹预测领域中得到应用。除此之外,还有高斯过程(Gaussian process)(Tay 和Laugier,2007)、基于代理的行为模型(agent-based behavioral model)(Yamaguchi 等,2011)等方法。基于手工定制特征的模型是根据特定规则或减少能量消耗建模行人间的社会交互行为,然而,在拥挤场景下,由于社会交互的大规模和复杂性,其可能无法实现有效、精确地预测。

循环神经网络(recurrent neural network,RNN)在机器翻译、语音识别和自然语言处理等领域表现出优秀性能,它也被引入到行人轨迹预测领域。人群交互深度神经网络(crowd interaction deep neural network,CIDNN)(Xu 等,2018)设计了基于RNN 的运动编码模块编码行人权重。社会生成对抗网络(social generative adversarial network,Social GAN)(Gupta 等,2018)在Social LSTM 基础上使用生成对抗网络(generative adversarial network,GAN)建模轨迹的多模态性,并通过多样性损失(variety loss)进一步加强模型的多模态学习能力。时空图注意力网络(spatial-temporal graph attention network,STGAT)(Huang 等,2019)基于行人时空图表示使用图注意力机制来建模社会交互。Trajectron(Ivanovic 和Pavone,2019)基于图结构通过RNN 编码行人运动特征。除此之外,还有一些经典的社会交互建模方法,如社会路模型(Amirian 等,2019)、预测终点条件网络(predicted endpoint conditioned network,PECNet)(Mangalam 等,2020)以及时空图变换框架(spatio-temporal graph Transformer framework,STAR)(Yu 等,2020)等,它们使用图注意力网络或多头注意力机制建模社会交互。

图注意力机制由于其给图节点分配重要性权重的特性在许多领域均有应用,如帮助医生快速识别轻重症患者的结构图注意力网络(刘彦北 等,2022)、基于图注意力网络的场景图到图像生成模型(兰红和刘秦邑,2020)。行人运动的时空属性让学者们想到构建行人时空图结构来建模行人的社会交互。图注意力机制通过编码行人时空图给不同行人分配权重因子,旨在学习全局模式下行人间的社会交互。然而在拥挤场景下,其可能会发生权重分配紊乱现象,导致精度不理想。随着时空图卷积神经网络(spatiotemporal graph convolutional neural network,ST-GCNN)(Yan 等,2018)的出现,上述问题得到了很好的解决。社会时空图卷积神经网络(Social STGCNN)(Mohamed 等,2020)首先在数据预处理阶段将行人速度制作为时空图和基于速度的邻接矩阵,之后使用时间图卷积神经网络和时间外推卷积神经网络(Lea 等,2017)来建模局部模式下的行人交互。

本文提出的Scene-STGCNN 与Social STGCNN类似,但不同的是,在空间编码阶段,Social STGCNN只有面向行人速度的ST-GCNN,Scene-STGCNN 除了面向行人速度的运动模块,还包括基于场景的微调模块,实时地调节运动模块生成的中间运动特征。除此之外,在中间阶段,本文设计了一种时空卷积作为过渡编码网络,而Social STGCNN并未采取任何措施实现空间编码阶段到时间编码阶段的过渡。最后,在时间编码阶段,Scene-STGCNN 使用了Social STGCNN 的时间外推卷积,不同的是,Social STGCNN 将时间外推卷积的层数设置为5,而Scene-STGCNN 简单地设置为1,本文认为过多层数的时间外推卷积可能会模糊行人轨迹差异,增加算法预测损失。

1.2 人—场景交互建模

在实际场景下,同一空间中除了相互运动依赖的行人还有静态事物,如:草坪、周围建筑物等。同时考虑行人以及静态事物对目标行人的运动影响可以使得算法更具实际场景下的适用性,然而,很少有工作考虑到场景对于行人运动的调节作用(如行人空间位置无法出现在建筑物墙壁之中,行人轨迹在建筑物拐角处发生大幅度的方向偏转等)。而考虑到场景因素的方法,如Sophie、Goal-GAN(Dendorfer等,2021b)、Trajectron++(Salzmann等,2020)和Y-Net(Mangalam 等,2021),仅仅将场景特征与运动特征做合并处理,无法直观、直接地解释场景对行人运动的调节作用。本文对场景与人交互行为的研究旨在设计一种基于场景的微调模块,能显式建模场景对行人运动的调节作用,进而减少模型在实际场景下的预测损失,生成更多实际可行的轨迹。

2 方 法

行人有一种来源于长久积累经验的直觉能力。基于这一能力,行人在行进过程中能根据行人间的社会交互(如碰撞避免、群体移动)规划未来路径。除此之外,行人会根据场景因素(如周边建筑、草坪)对未来路径做实时性调节。现有的方法大多数关注于社会交互的构建,只有少数方法考虑到场景与行人之间的交互,而这种考虑往往是将深度神经网络编码后的场景图像展平之后与运动特征合并,破坏了场景空间信号,无法直观、直接地解释场景对行人未来路径的调整作用。为了解决这一问题,本文提出了一种结合场景限制的时空图卷积架构。这一节首先介绍行人轨迹预测定义,然后详细描述模型架构。

2.1 问题定义

2.2 Scene-STGCNN模型

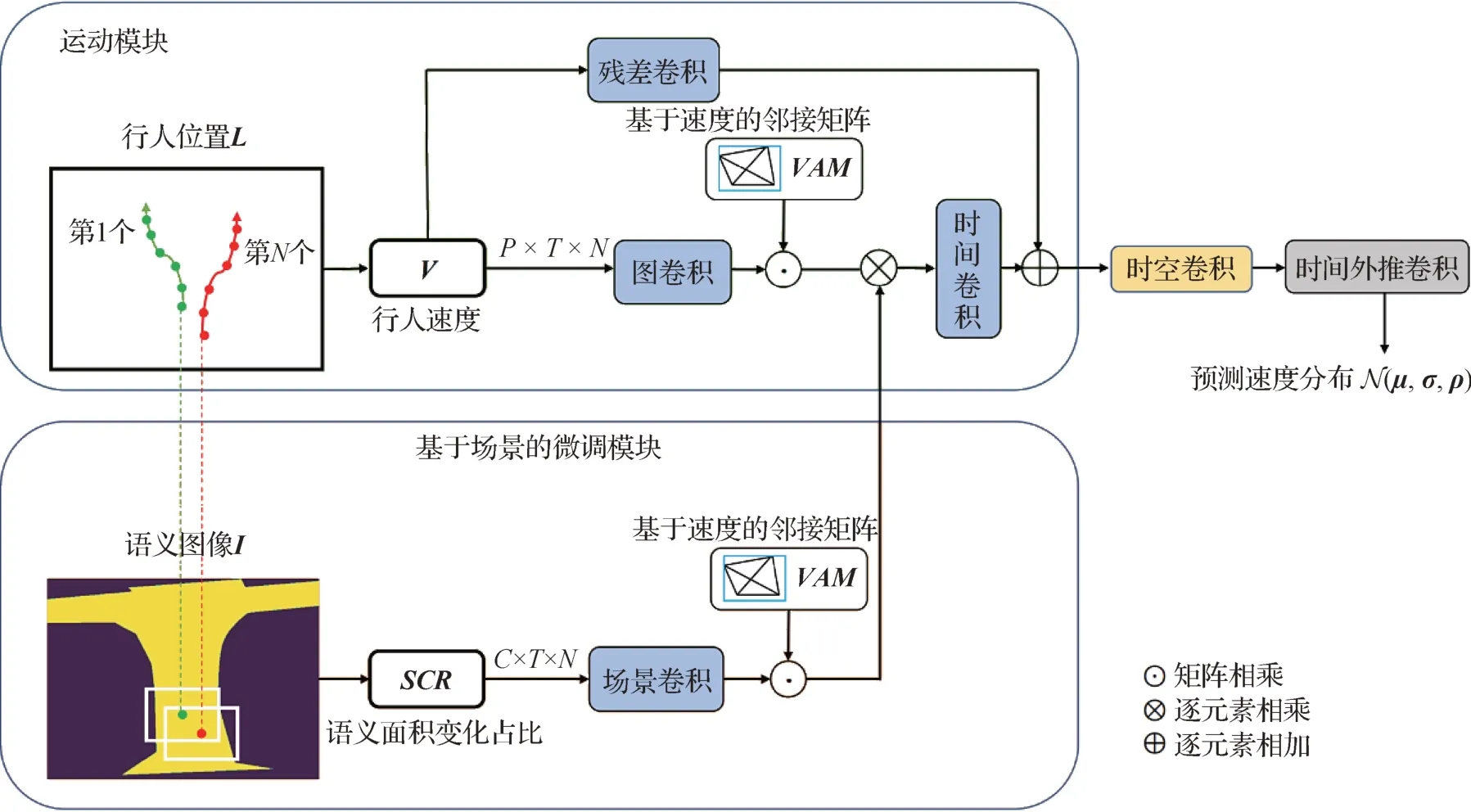

Scene-STGCNN 模型主要由4 部分组成,分别为运动模块、基于场景的微调模块、时空卷积和时间外推卷积。对于行人运动时空图,运动模块对其做运动编码。对于语义变化时空图,基于场景的微调模块将其嵌入为场景掩模矩阵,从而调节中间运动特征。时空卷积作为过渡编码网络进一步加强运动特征的时间相关性。最后时间外推卷积输出不同未来帧的速度分布。模型架构如图1所示。

图1 Scene-STGCNN模型架构Fig.1 Scene-STGCNN model framework

2.2.1 行人时空图

首先介绍行人时空图结构,行人作为图节点,行人之间的社会交互作为图中的边,行人运动信息(如位置、速度)或场景信息(如语义面积变化占比)作为节点属性。当节点属性为速度时,行人时空图结构如图2所示。

图2 行人时空图结构Fig.2 Pedestrian spatial-temporal graph structure

基于行人时空图结构的聚合或卷积操作实质上是在局部模式下的属性特征提取,通过提取关键特征,可以有效减少算法预测损失。

2.2.2 运动模块

获得邻接矩阵VAM 后,还需对其正规化处理,具体为

基于行人速度时空图,运动模块通过图卷积操作提取局部行人运动特征,这一操作不改变时空图结构,只会改变节点属性。对于定义在行人运动特征上的图卷积操作为

式中,l表示卷积层序号,B(vi)={vj|d(vi,vj) 值得注意的是,式(5)中vi并非只表示行人i在2 维空间中的速度,它还表示图卷积编码后的多维运动特征。残差卷积在图卷积的基础上增加了BN(BatchNorm)层来将运动特征做归一化处理。时间卷积沿用了Social STGCNN(Mohamed 等,2020)的设置,由BN 层、PReLU(parametric rectified linear unit)激活函数、图卷积、BN 层和Dropout 层组成。注意,本文中所提的图卷积本质上为非固定形状的卷积层,可以有不同的输入通道数、输出通道数、卷积核大小和填充长度,其针对行人速度时空图做空间通道上的节点属性聚合和交换。 2.2.3 基于场景的微调模块 式中,∑表示对布尔矩阵的求和,⊕表示不同布尔矩阵之间的异或运算,M表示布尔矩阵的面积(与场景块面积相同,固定不变)。 式中,si并非只表示行人i所对应的语义变化面积占比,它还表示场景卷积编码后的场景特征,B(si)={sj|d(si,sj) 2.2.4 时空卷积 在运动模块中,中间行人运动特征与基于场景的微调模块编码后的场景掩模矩阵做逐元素相乘,之后通过时间卷积与残差卷积编码后的运动特征做求和操作,最后输入到时空卷积中。运动模块与基于场景的微调模块仅在对应特征的空间通道执行卷积操作,而时间外推卷积仅在对应特征的时间通道执行卷积操作,本文认为,中间需要有个网络来实现过渡。受交通预测领域中的STGCN(spatial temporal graph convolutional network)方法(Yu 等,2018)启发,将STGCN 微调之后作为时空卷积应用到行人轨迹预测中,作为过渡编码网络对行人特征做卷积操作。时空卷积结构如图3 所示。时间门控单元对不同时刻的行人特征执行卷积操作从而输出掩模矩阵,掩模矩阵与行人特征做元素对应相乘从而加强算法在时间维度上的敏感度。空间卷积对不同行人的空间特征执行卷积操作从而加强行人之间的空间依赖。 图3 时空卷积结构Fig.3 Spatial-temporal convolutional structure 2.2.5 时间外推卷积 时空卷积的功能是加强行人特征的时空关联,然而,算法的目的是为了预测未来一段时间内行人轨迹所服从的2 维高斯分布,时间外推卷积在此发挥作用。时间外推卷积直接作用于时空图结构的行人特征,将其时间维度扩展到所要预测的时间段长度。时间外推卷积由空间卷积、PReLU 激活函数和空间卷积组成,其中,第1 层空间卷积为输入通道数Tobs,输出通道数Tpred的3 × 3 卷积层,第2 层空间卷积为输入通道数Tpred,输出通道数Tpred的3 × 3 卷积层。时间外推卷积依赖于特征空间上的卷积操作,直接操作于输入特征的时间维度,与常见的递归神经网络相比,包含的训练参数量更少、推理更快。 此外,受水湖泊生物的种群密度也是常用的评估指标,包括浮游动植物以及底栖生物的数量与生物量。富营养化湖泊蓝藻密度的减少是反映引水调控工程对湖泊水生态改善的直接指标,而部分藻类摄食性浮游动物数量的增加也能够体现引水工程对湖泊水生态的间接改善作用。底栖动物群落通常用来表征湖泊水生态健康,其数量与生物量的改变也被视为引水对湖泊生态影响的重要指标。 Scene-STGCNN 由运动模块、基于场景的微调模块、时空卷积和时间外推卷积构成。对于模型配置,时间外推卷积层数设置为1,场景语义类别数设置为2(障碍物和通道),本文将场景块形状设置为正方形,在定量分析部分,基于不同长度场景块条件下的对比实验,采取最优设置,将场景块长度设置为64。在训练阶段,设置批大小为64,训练轮数为200,使用Adam 作为优化器,同时设置学习率为0.001。本文方法代码的实现基于PyTorch 框架,显卡型号为NVIDIA GeForce RTX 2080。 为了验证Scene-STGCNN 性能,本文在行人轨迹预测领域内两大公开数据集ETH(Pellegrini 等,2010)和UCY(Lerner 等,2007)上进行实验。在俯视视角下拍摄的社会场景视频经过先进的视觉跟踪技术被提炼出表示行人位置坐标的时间序列,形成ETH 和UCY 数据集。ETH 数据集包含ETH 和HOTEL 两个子数据集,UCY 数据集包含ZARA1、ZARA2 和UNIV 这3 个子数据集。ETH 和UCY 数据集覆盖了多种运动模式,如群体移动、碰撞避免和行人跟随等,符合实际场景下大部分行人行为情况。 令Yi=表示第i位行人从h+1到T时刻的真实轨迹,为对应的预测轨迹。本文使用两个基于距离的误差指标来评估模型性能。 平均位移误差(average displacement error,ADE)表示预测时间段内预测坐标与真实坐标的平均欧氏距离,计算为 最终位移误差(final displacement error,FDE)表示最终预测时刻预测坐标与真实坐标之间的欧氏距离,计算为 模型测试后所得到的ADE 和FDE 越小则表示方法性能越好。鉴于其他主流方法在测试阶段都采用了20 个样本中取最优的设置,本文所有实验也将使用此设置,后续不再说明。 3.3.1 对比实验 首先,为了获取在数据预处理阶段场景块大小的最优值,在主流公开数据集ETH 和UCY 上对不同场景块半长的Scene-STGCNN 进行对比实验,取平均值作为最终结果,实验结果如表1 所示。总体上,不同场景块半长的模型之间性能差别很小,本文认为导致这一结果的原因为行人在行进过程中可观测视野有限,不同大小的视野能注入的有用场景信息差别很小,因此不同半长条件下的模型测试得到的ADE 和FDE 相差很小,ADE 在0.38~0.40 区间内,FDE 在0.60~0.62 区间内。最优结果对应的场景块半长为64,模型取最优设置。 表1 不同场景块半长的对比实验结果Table 1 Comparative experiment of different half-lengths 为了验证Scene-STGCNN 模型性能,本文在主流公开数据集ETH 和UCY 上与当前主流方法进行对比实验,实验结果如表2所示。 表2 ETH和UCY数据集上的对比实验结果Table 2 Comparative experiment on ETH and UCY datasets 总体上,相较于其他主流方法,Scene-STGCNN的性能达到了最优。对于ADE指标,Scene-STGCNN达到了0.38,相比于次优的0.43 减少了12%。对于FDE 指 标,Scene-STGCNN 达到了0.60,相比于Causal-STGCNN 取得的次优结果0.66,改进幅度为9%。对于不同数据集上的ADE 和FDE 指标,本文所提出的Scene-STGCNN 除了在HOTEL 数据集上没有达到最优结果之外,在其余数据集上均达到了最优,这是由于HOTEL 数据集包含了大量的线性轨迹,而Scene-STGCNN 的网络结构决定了其预测轨迹很难呈现线性状态。值得注意的是,在ETH 数据集上,本文方法在FDE 指标上达到了0.77,相比于Social STGCNN,实现了31%的改进幅度,这是因为本文使用了基于场景的微调模块来建模场景对行人轨迹的调节作用,同时还设计了时空卷积来增强运动特征的时间相关性和空间依赖。除此之外,从表2 中可看出,本文方法在ETH 数据集上所取得的FDE 指标也显著优于其他主流方法,同时本文方法在UNIV 数据集上取得的最优ADE 和最优FDE 表明,即便是拥挤场景下的行人运动,Scene-STGCNN也能做出比较精确的预测。 一个能应用在实际领域的模型需要在保持轻量级的同时还具备较高的性能。在实际生活中,模型参数总量不能超过具体应用设备的存储上限,否则无法开展大规模应用。一个优秀的行人轨迹预测方法除了达到较低的预测误差之外,其网络参数总量也要保持较低水平。为了验证Scene-STGCNN 在这一方面的表现,将Scene-STGCNN 与一些主流方法进行比较,结果如表3 所示,其中,预测误差为不同方法在ETH 和UCY 上的平均值。Scene-STGCNN 模型的参数总量为3 KB,相较于次优的Social STGCNN 模型的参数总量7.6 KB,减少了61%,而其余方法网络参数总量远远超过10 KB。除此之外,Scene-STGCNN 在ETH 和UCY 数据集上所取得的预测误差也是最优的。值得注意的是,Sophie 的参数总量为26 230.9 KB,约为25.6 MB,远远超过了其余方法的参数总量。这些结果说明了本文所设计的Scene-STGCNN 方法在将参数总量保持在一个低水平的条件下还能实现较低的预测误差,证实了本文方法的优越性。 表3 不同方法模型参数总量和预测误差对比Table 3 Comparison of parameters count and predictions errors of different methods 3.3.2 消融实验 为了验证本文设计的基于场景的微调模块能帮助模型理解场景与人之间的交互行为,从而实现更精确的预测,本文在公开数据集ETH 和UCY 上进行了Scene-STGCNN与Scene-STGCNN*(移除基于场景的微调模块之后的Scene-STGCNN)的对比实验,实验结果如表4 所示。总体上,Scene-STGCNN 表现优于Scene-STGCNN*。就具体数据集来分析,在ETH数据集上,Scene-STGCNN 表现显著优于Scene-STGCNN*,ADE 和FDE 分别减少了19%和46%,在HOTEL、UNIV 和ZARA1数据集上,两个方法表现几乎相同,在ZARA2 数据集上,本文方法Scene-STGCNN 相较于Scene-STGCNN*在ADE 指标上取得了7%的改进幅度,在FDE 指标上取得了6%的改进幅度。本文认为导致这一现象的原因是ETH 数据集对应场景中建筑物占了很大的空间比例,所以行人在考虑路径时会很大程度地考虑场景元素的影响,因此在ETH 数据集上优化效果较为显著,而其余数据集对应场景比较空旷,场景对于行人轨迹的空间限制作用很小甚至没有,所以行人在规划未来路径时不会过多考虑场景元素,导致在其余4 个数据集上两个方法表现接近甚至相同。 表4 基于场景的微调模块的消融实验Table 4 Ablation experiment of scene-based fine-tuning module 定量分析中的对比实验结果表明,就ADE 和FDE指标而言,本文提出的Scene-STGCNN相对于其他主流方法达到最优表现。同时消融实验显示,基于场景的微调模块能很好地建模场景对行人运动行为的调节作用。本节对Scene STGCNN 如何捕获行人运动的内在模式以及如何考虑预测分布展开定性分析。首先展示Social-STGCNN(Mohamed等,2020)与本文方法Scene-STGCNN 在不同运动模式下的可视化结果,如图4所示。 图4 不同运动模式下的可视化结果对比Fig.4 Comparison of visualization in different motion mode((a)collision avoidance;(b)group movement;(c)pedestrian merging) 图4(a)展示了两种方法在碰撞避免模式下的表现,两种不同的颜色代表两位行人,通过历史轨迹和真实未来轨迹可观察到两位行人在前进过程中都处在彼此的视野范围内,为了避免碰撞,他们的未来运动更偏向于绕过对方。Social STGCN 并没有很好地学习到这一“绕过”行为,具体表现在,对于蓝色代表的行人,Social STGCNN 预测的轨迹分布很大程度地覆盖了红色代表行人的预测轨迹分布,对比而言,Scene-STGCNN 预测两位行人的轨迹分布的交集面积较小,因此生成的行人轨迹能在很高程度上诠释“绕过”行为。图4(b)展示了两种方法在群体移动模式下的表现,两种方法预测的轨迹分布都很好地再现出并列行走的模式,但对于蓝色行人,Scene-STGCNN 预测的轨迹分布与真实未来轨迹更加贴合,预测更加精确。图4(c)展示的是对应于行人合并模式下两种方法的不同表现,与Social STGCNN对比,Scene-STGCNN 预测的对应两位行人的轨迹分布区域较细,因此与真实未来轨迹更接近,然而分别对应于两位行人的预测分布区域存在小面积的重叠部分,这与两条真实轨迹所表现的无相交现象不符。 综上所述,对于在碰撞避免、群体移动、行人合并这3 种运动模式下的行人运动,相比于Social STGCNN,本文方法Scene-STGCNN 预测的轨迹分布都与真实未来轨迹更加贴合,同时在碰撞避免和群体移动模式下能更有效地学习到行人的行为表现,验证了本文方法精确的预测表现和高学习能力。 为了进一步理解Scene-STGCNN 如何生成轨迹样本,本文基于Scene-STGCNN 在群体移动、碰撞避免和行人跟随运动模式下的预测轨迹分布生成多条轨迹样例,通过在对应场景下行人轨迹的可视化进行具体分析,可视化结果如图5 所示。第1—4行分别代表真实轨迹、接近真实的预测轨迹样例、方向有较大误差的预测轨迹样例和速度有较大误差的预测轨迹样例。对于群体移动模式下的接近并行的行人轨迹曲线,从第2—4 行展示的预测未来轨迹曲线都高程度地表现出并行状态,然而,与第1 行中展示的真实未来轨迹相比,第3 行中蓝色行人的预测未来轨迹方向有微小偏转,呈现出靠墙行走的现象。对于碰撞避免下展现“绕过”行为的行人,从第2—4 行展示的预测未来轨迹高度还原了这一行为状态,但在第3 行中,浅蓝色行人“绕过”角度过大,几乎与建筑物发生碰撞。行人跟随运动模式下第3 行中红色行人预测未来轨迹与第1 行红色真实未来轨迹相比,呈现出幅度较大的方向变化。除此之外,在群体移动、碰撞避免或行人跟随运动模式下,第4 行中至少有1 位行人的预测未来轨迹,相对于真实未来轨迹发生了速度大小的改变。 图5 Scene-STGCNN生成的轨迹样例Fig.5 Samples trajectories generated by Scene-STGCNN((a)group movement;(b)collision avoidance;(c)pedestrian follow) 本文提出了一种用于行人轨迹预测的场景限制时空图卷积神经网络Scene-STGCNN,基于时空图卷积编码行人时空图表示,旨在学习局部模式下的行人交互。Scene-STGCNN 通过设计的基于场景的微调模块提取场景调节特征,聚合不同历史帧的场景变化信息,显式建模场景对行人轨迹的调节作用。在实验中,相比于行人轨迹预测领域内的其他主流算 法,Scene-STGCNN 的ADE 和FDE 指标分别为0.38 和0.60,达到了最优性能,同时Scene-STGCNN在可视化结果中也实现了相当优秀的表现。本文工作为建模人—场景交互方向的行人轨迹预测算法提供了一个全新的研究视角,若结合其他行人运动特征(如目标点、运动模式等),可进一步减少模型的预测误差,从而增强框架性能。本文还存在提升空间,未来将从更好的场景微调模块设计、更强的运动特征提取框架、目标地点信息注入方式和更优的模型更新策略出发,设计或改进整体模型。

3 实验及分析

3.1 模型配置和训练设置

3.2 数据集和评估指标

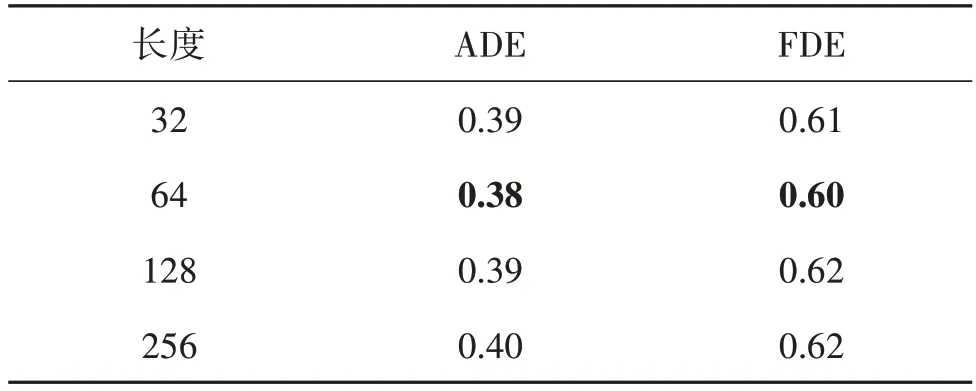

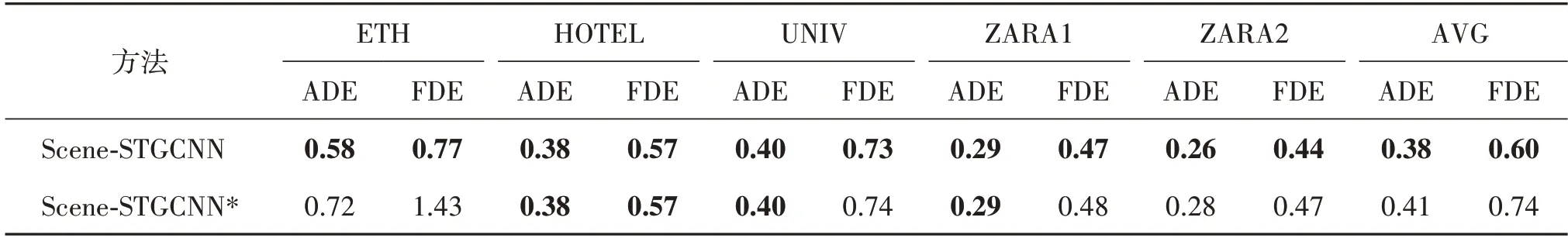

3.3 定量分析

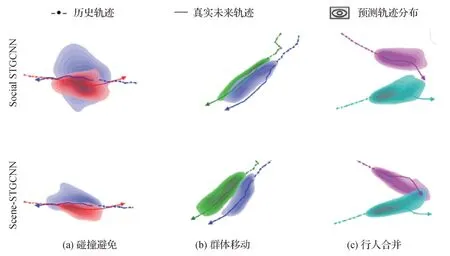

3.4 定性分析

4 结论