短时记忆与CenterTrack的车辆多目标跟踪

张瑶,卢焕章,王珏,张路平,胡谋法

国防科技大学电子科学学院自动目标识别重点实验室,长沙 410073

0 引言

智能交通监控系统已经得到了广泛应用,面向智慧城市的交通视频分析技术已经引起学者广泛研究(赵耀 等,2021)。通过智能交通视频监控系统可以动态分析了解交通路况、交通秩序等方面。其中多目标跟踪技术是智能交通监控的关键技术,也是当前的研究热点。传统的多目标跟踪算法常用于雷达及红外等表观信息匮乏的场景,需要处理大量虚假检测,导致关联阶段设计复杂,常利用概率统计理论判定检测目标之间的关联关系。

随着深度学习神经网络尤其是卷积神经网络(convolutional neural network,CNN)在目标检测领域取得重大突破(曹家乐 等,2022),从R-CNN(regionbased convolutional neural network)检测器(Girshick等,2014)、YOLO(you only look once)检测器(Redmon 等,2016)、SSD(single shot multibox detector)检测器(Liu等,2016)到CornerNet(Law和Deng,2018)、CenterNet(Zhou 等,2019)等检测算法性能不断提升,多目标跟踪领域也进入到更依赖深度学习检测器性能的跟踪模式。Sort(simple online and realtime tracking)(Bewley 等,2016)基 于R-CNN 系列的Faster R-CNN(Ren 等,2017)深度学习检测算法,在关联阶段使用简单的卡尔曼滤波加匈牙利算法就大大提高了跟踪算法的性能表现。DeepSort(Wojke等,2017)在Sort基础上增加目标重识别网络提取目标重识别(re-identification,Re-ID)特征,减少了遮挡目标存在的频繁身份切换(ID switch,IDs)问题。此后,先基于深度学习检测器确定视频帧中跟踪目标的位置,再通过设计一个特征提取网络确定检测目标的Re-ID特征保持跟踪目标的稳定性,这种双阶段方法成为基于深度学习的视觉多目标跟踪普遍模式。

对于算法实时性要求较高的场景,这种同时具有两个计算量庞大的独立神经网络的多目标跟踪模式常常受到限制。对这个问题,Wang 等人(2020)通过改进YOLOv3(Redmon 和Farhadi,2018)目标检测网络,同时学习到目标检测特征与Re-ID 特征的单阶段跟踪方法,将两个网络功能融合在一个检测器中,权值共享,减少算法推理时间,但算法的跟踪准确度较双阶段跟踪模式方法表现不佳。FairMot(Zhang 等,2021)通过实验验证,提出单阶段跟踪方法跟踪准确度降低的原因在于anchor-based 目标检测方法常出现多个锚框估计同一个真实目标,导致网络学习不到最优的Re-ID 表观特征。因此,Fair-Mot 采用anchor-free 检测模型,同时进一步平衡检测模块与Re-ID 模块,达到了较好的跟踪效果。为了进一步简化多目标跟踪模式,CenterTrack(Zhou等,2020)并未构建Re-ID 特征学习模块,而是学习相邻两帧的图像输入以及前一帧的目标检测结果,进一步增强目标检测性能,借由检测能力的增强,CenterTrack实现了很好的跟踪性能。

以上多目标跟踪算法借由基于深度学习检测器性能的不断提高都实现了较好的跟踪效果,这些算法性能在行人多目标跟踪场景下进行了充分验证,但是在交通监控车辆多目标跟踪场景下仍存在一些问题。CenterTrack 对视野远处的小目标关注度不够,缺少对轨迹后处理的进一步优化处理。因此,本文提出一种基于交通视频监控场景下的车辆多目标跟踪方法,先分析交通监控场景下车辆多目标跟踪存在的远处小目标漏检与车辆IDs问题,在CenterTrack方法的基础上增加小目标样本扩增模块与短时轨迹记忆模块,通过实验验证本文提出的跟踪算法,有效提高了在交通监控场景下车辆多目标跟踪表现。

1 场景分析

采用高速高清摄像头实现高速公路、城市道路和主要道路口等的车辆监控已经非常普遍。海量视频监控数据使得自动化视频分析的需求变得非常迫切。传统多目标跟踪方法因检测算法性能不足,目标特征提取能力受限,致使难以满足复杂多变的场景需要,越来越多的智能化方法,例如深度学习类,用来弥补传统方法的不足,取得不错的成效(Zhang等,2021),但仍然在IDs、样本获取等方面存在挑战。

1.1 远处小目标车辆漏检

在交通监控场景中,车辆存在从远处的小目标到中等尺度目标再到近处大目标的持续尺度变化,如图1 所示,用红框标注的车辆在视野中可以从远处的16 × 18 的小目标到中等尺度的200 × 400 目标,再到近处的400 × 500 大目标。这种跨度较大的尺度变化给多目标跟踪带来了较大挑战,车辆目标快速尺度变化造成了训练数据样本的不均衡,从而造成了远处小目标车辆大量漏检现象。

对大量交通监控视频数据分析可知,车辆尺度变化造成的样本不均衡的原因在于:1)小目标车辆滞留时间短,由于车辆目标的运动速度快,定义的远处小目标车辆在15 × 15 至50 × 50 尺度区间存在的时间较少,缺少较多持续帧;2)小目标车辆自身携带的表观特征信息量低,利用神经网络多次提取特征信息量快速消失。远处小目标在视野中的相对数量较少,作为训练样本进行下采样后特征量快速消失,导致真实的进入网络的有效训练样本量进一步减少,而这种样本不均衡导致了算法对远处小目标车辆的漏检。

本文对应提出小目标样本扩增模块,通过小样本数据增强与过采样提高进入网络的有效小目标车辆训练样本所占比例,改善训练样本数量不均衡状态以降低远处小目标车辆的漏检数量。在交通监控中进一步拓宽对远处的小目标车辆的关注,可以实现对车辆从视野中出现到离开视野全流程的检测跟踪,扩大监控系统的有效性预警范围,加速对交通事故快速及时的反馈响应,减少可能存在的生命财产损失。

1.2 跟踪车辆的IDs

车辆多目标跟踪的目的除了定位车辆目标位置,需对视频序列中各个目标维持唯一正确的ID。因此,优秀的跟踪算法除了需要具备良好的检测性能,也要正确关联各帧检测目标ID。不同应用背景下,跟踪过程中的IDs 现象成因各有不同,在自动驾驶背景下,车辆所处的背景是动态变化的,背景的快速变化干扰导致提取的目标特征前后变化较大,造成IDs。而在交通视频监控场景中,监控摄像头在道路上方呈俯拍状态,背景较为稳定,车辆按特定的道路以较快速度行驶,很少存在车辆长时间被背景或其他同类目标遮挡造成IDs 的问题。但是交通监控场景仍存在车辆IDs现象,如图2所示。在视频序列第91 帧ID 为6 的车辆,在第92、93 帧未检测到,第94 帧再出现时这个车辆目标ID 变为7,产生IDs问题。

图2 车辆短时帧间漏检造成IDs的过程Fig.2 The IDs process caused by the missed detection of vehicles in a short time frame((a)the 91st frame;(b)the 92nd frame;(c)the 93rd frame;(d)the 94th frame)

分析交通监控场景下的车辆IDs 现象源自检测器性能不足,检测器无法在每帧中实现对感兴趣目标的正确检测,尤其当车辆所处背景发生变化扰动时,车辆的漏检现象更为严重。在交通监控场景中,车辆目标运动速度较快,而且不存在长时的车辆背景变化,仅存在短时漏检现象。车辆目标漏检后,轨迹立刻终止,当车辆目标再次出现时,建立新轨迹ID,短时漏检是造成交通监控场景下车辆IDs 的主要原因。

在本文应用场景下,跟踪车辆的IDs 与帧间短时目标漏检相关,而一味提高检测器的性能将花费较大计算成本与训练成本,且仍不可避免存在漏检情况。因此,本文提出短时轨迹记忆模块,通过记忆轨迹历史运动信息预测当前帧漏检目标可能存在的空间位置,弥补检测器检测性能的不足,进而改善交通视频监控场景下车辆频繁的IDs。

2 本文算法

基于对交通监控车辆多目标跟踪问题的分析,本文在CenterTrack 的基础上结合交通监控背景,针对性地提出一种融合短时轨迹记忆与CenterTrack的车辆多目标跟踪方法。

2.1 算法整体框架

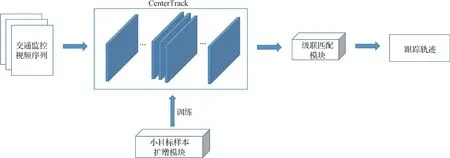

CenterTrack 网络结构如图3 所示,通过优化热力图损失函数,在一定程度上改善了目标训练样本不均衡的问题。

图3 CenterTrack模型Fig.3 The structure of CenterTrack

为了进一步改善交通监控场景中存在的训练样本不均衡问题导致的远处小目标漏检问题与帧间漏检导致的IDs 问题,本文在CenterTrack 方法的基础上,推理阶段增加短时轨迹记忆模块降低IDs,在训练阶段进行小目标数据扩增和小目标过采样提高来降低远处小目标漏检数,算法的模块框架如图4 所示,具体步骤如下:

图4 本文算法处理模块Fig.4 The algorithm processing module of this paper

1)利用小样本扩增模块增加训练样本中远处小目标车辆的数量,进一步改善场景中远近车辆目标的训练样本不均衡问题;

2)扩增后的数据输入CenterTrack进行训练;

3)输入测试视频序列到训练好的CenterTrack模型中确定目标中心点位置与相邻帧之间车辆目标中心位移向量;

4)通过级联匹配模块记忆关联失败的轨迹历史信息,分级循环关联轨迹与待匹配的车辆检测目标,降低跟踪车辆的IDs问题,输出跟踪轨迹。

2.2 短时轨迹记忆模块

在CenterTrack 学习到的当前帧检测基础上,以学习到的相邻帧中心位移向量作为关联基础,通过相邻帧间的中心点位移传递ID,实现多目标跟踪功能。这种简洁的跟踪模式提高了跟踪速度,但在较为复杂的应用场景下,出现了频繁的IDs 问题。由于长时的轨迹记忆降低跟踪速度并且容易造成新的错误关联,因此,本文提出短时轨迹记忆模块,降低IDs,提高车辆多目标跟踪的准确性。短时轨迹记忆模块的具体实现过程如下:

输入:上一帧跟踪轨迹Tt-1,最长轨迹记忆时间agemax=3,当前帧输出检测结果Ot,相邻帧中心位移向量dt。

输出:当前帧的跟踪轨迹结果Tt。

1)在Tt-1和Ot基础上,用dt作为关联依据,得出关联代价矩阵Wi,j。

2)根据Tt-1中轨迹关联失败的累计次数(age)参数确定待关联轨迹优先级,按优先级循环先后与新检测到的目标关联。

3)若轨迹优先级一致,随机排序关联检测目标。

4)根据argminWi,j确定与当前轨迹关联代价最小时的检测目标。

5)设置关联是否成功的阈值κ=,其中wi、hi为检测框的宽、高。

6)比较argminWi,j与κ。

7)若argminWi,j<κ,轨迹与检测目标关联成功,并根据当前检测更新轨迹得到新轨迹Tt。

8)轨迹与检测目标关联失败,关联失败的轨迹预测其在当前帧的位置,age加1。

9)轨迹与检测目标关联失败,新的检测目标建立新的轨迹,得到Tt。

两个主要处理流程如下:

1)当轨迹关联新的检测目标失败时,通过记忆短时的轨迹历史运动信息预测轨迹在当前帧的位置。当轨迹对应的当前帧目标存在部分遮挡或检测器性能不足导致未检测到目标而存在漏检时,轨迹关联失败,此时终止轨迹,若短时间内被遮挡的目标重新出现或检测器重新检测到该目标时,产生新的轨迹ID,导致IDs。因此,短时轨迹记忆模块保存轨迹在短时间内的历史运动信息,当轨迹关联失败时,假定目标在短时间内做匀速直线运动,预测轨迹在当前帧的位置,直至轨迹再次成功关联到检测目标,维持轨迹的连续性,降低跟踪过程的IDs。

2)轨迹分级,并按优先级关联检测目标。本文假定轨迹关联检测失败时做匀速直线运动,但实际的车辆运动常存在不确定性,车辆可能在加速、减速、转弯等。因此,这种短时轨迹记忆存在不确定性,而随着预测的帧数越多,轨迹的不确定性越高。假设每次预测的正确概率为p,则连续多帧的预测正确概率为(1-p)t,其中t为预测的帧数,而待关联的轨迹常存在多对一的情况,即几条轨迹同时关联同一个检测目标的情况。因此,由于关联失败后轨迹预测的不确定性随着关联失败时长的增加而增加,为了提高关联的正确性,本文提出的短时轨迹记忆模块还将轨迹进行分级。关联失败时间越短的轨迹预测越可靠,优先级越高;关联失败时间越长的轨迹预测越发散,优先级越低,按照轨迹优先级的高低前后与检测目标匹配。

2.3 小目标样本扩增模块

深度学习本质上是以大数据量为基础驱动特征学习,CenterTrack进行的数据增强提高了训练样本的数据量,但是这种针对全局图像进行的空间与色彩维度的增强变换对于局部小目标这种自身缺少足够信息量的样本来说增强效果非常有限,本质上仍未解决输入网络中训练的远处小目标车辆数量不足的问题,导致对远处小目标车辆的检测能力较弱。

为了改善不同尺度目标样本数量不均衡的问题,算法新增一个小样本数据扩增模块,在数据预处理阶段实质地增加小目标车辆数量作为训练正样本的数量,此外,对图像中小于50 × 50 的小目标车辆样本进行多次采样,综合提高小目标样本在训练样本中的数量。具体实现步骤如下:

1)在原有训练数据集的基础上,随机抽取部分视频序列,根据图像的真实标注框裁剪出车辆目标框如图5所示。

2)对裁剪后的车辆目标进行随机缩放操作至10 × 10~50 × 50 之间,再将裁剪后的车辆目标框添加到原图车辆目标附近,对图像进行扩增的具体扩增效果如图6所示。

图6 训练视频序列小目标车辆扩增效果对比示例Fig.6 A comparison example of the expansion effect of a small target vehicle in a training video sequence((a)original image;(b)expended image)

3)在网络训练过程中,当采样到的车辆目标框样本小于50 × 50时,设置此样本采样次数为3,即网络重复3 次采样该样本作为正样本输入网络进行计算。

3 实验结果与分析

本文算法运行在Intel Core i7-9700K CPU,GPUNVIDIA GeForce RTX 2080 SUPER GPU 上,操作系统为Ubuntu16.04,使用的视觉开发环境为CUDA v10.0,OpenCV 4.4.0,Pytorch 1.4.0。

3.1 实验数据集

为测试本文算法的有效性,采用公开的交通监控场景下车辆多目标跟踪数据集UA-DETRAC(University at Albany detection and tracking)(Wen 等,2020)。UA-DETRAC 数据集包括在中国北京和天津的24个不同地点使用Cannon EOS 550D相机拍摄的10 h 视频,视频以25 帧/s 的速度录制,分辨率为960 × 540 像素。考虑到数据集中存在多个重复的场景,导致数据集较为冗余,本文通过在UADETRAC 抽取15 个不同场景下的序列作为训练数据集,同时为了保证测试数据场景的多样性,抽取5个在不同环境场景下的视频序列作为测试数据集。抽取的训练视频序列与测试视频序列按其在UADETRAC数据集中文件夹的命名划分如表1所示。

表1 UA-DETRAC训练与测试数据集划分Table1 Training and test datasets division in UA-DETRAC

考虑到交通监控场景的多样性,数据集涵盖了晴、多云、夜晚和降水等自然环境条件,也包含车辆密集、车辆稀疏等车况条件,具体的训练数据与测试数据序列场景图像如图7和图8所示。

图7 UA-DETRAC训练视频序列场景样例Fig.7 Examples of training video sequence scene in UA-DETRAC((a)MVI_20032;(b)MVI_39851;(c)MVI_40204;(d)MVI_39781;(e)MVI_39371;(f)MVI_39511;(g)MVI_40131;(h)MVI_40742)

图8 UA-DETRAC测试视频序列场景样例Fig.8 Examples of testing video sequence scene in UA-DETRAC((a)MVI_39051;(b)MVI_40981;(c)MVI_63521;(d)MVI_39861;(e)MVI_40191)

为了进一步测试改进算法在不同数据集下的实验结果,增加了公开的交通视频监控数据集Urban Tracker(Jodoin 等,2014)中的Sherbrooke 场景。其中,Sherbrooke 视频序列是在Montreal 的Sherbrooke十字路口拍摄,视频分辨率为800 × 600 像素,视频序列示例如图9所示。

图9 Sherbrooke测试视频序列场景样例Fig.9 Examples of testing video sequence scene in Sherbrooke((a)the 3 492nd frame;(b)the 3 525th frame)

本文采取CLEAR MOT(Bernardin 和Stiefelhagen,2008)及IDF1(Ristani等,2016)指标评判多目标跟踪方法的有效性,其中MOTA(multiple object tracking accuracy)是CLEAR MOT 指标体系的一个综合性指标,计算为

式中,FN和FP分别表示与检测器性能高度相关的漏检指标(FN)、虚检指标(FP);IDs表示衡量跟踪模块性能的关键指标IDs;GT表示真实目标数量GT。

IDF1 指标是ID 识别的F 值,IDTP(ID true positive)、IDFP(ID false positive)、IDFN(ID false negative)分别为ID 的真正数、假正数及假负数,将这些指标视为变量(IDF1、IDTP、IDFP、IDFN)时,IDF1对轨迹ID的评价更为精确,计算为

3.2 算法性能分析

3.2.1 小目标样本数据扩增模块有效性分析

为了验证训练阶段加入小样本数据扩增模块对交通监控场景下车辆多目标跟踪的有效性,训练阶段通过小目标样本扩增模块新增训练数据884 帧,同时在训练过程执行小样本过采样,对训练时采样到的车辆目标框小于50 × 50时,重复采样3次,综合实现远处小目标车辆样本数据扩增,训练好后的模型在测试数据集上得到相应的实验结果。

定性分析实际序列如图10 所示,由于训练样本中远处小目标车辆缺乏导致训练样本不平衡,从而导致算法对远处小目标车辆存在漏检问题。如图10(a)中运行的CenterTrack 算法对于存在的远处小目标车辆长时间漏检,在同样序列中运行增加小目标样本扩增模块后的算法跟踪结果如图10(b)所示,算法连续检测到车辆ID15 和ID16 的远处小目标车辆,基于CenterTrack 网络模型增加小目标样本扩增模块大大增强了对远处小目标车辆的检测能力。

为进一步定量分析改进算法的有效性,在UADETRAC 测试数据集上对改进前后的算法进行测试,指标表现如图11 所示。通过添加小目标样本扩增模块,显著提升了CenterTrack 网络的小样本检测性能,如图11(b)所示,CenterTrack+小目标样本扩增模块在4 个测试序列中的FN 值都有大幅度的降低,降低幅度依次为68.61%、31.39%、9.56%和9.37%。检测器对于小目标车辆性能的提升不可避免地在一定程度上提升了FP数值,如图11(c)所示,主要体现在序列MVI_40191 中,原本真实测试序列中未关注到的低于15 × 15 的车辆目标也被关注到,或道路中一些非车辆目标也检测到造成了FP 指标的提升,但是整体来看,检测器的性能仍有较大提升。检测性能的提升同时降低了关联过程中由于漏检造成的车辆IDs 如图11(d)所示,在4 个测试序列中IDs 都有明显降低。对于综合性指标MOTA 与IDF1,在5 个测试序列中都有提升,但在MVI_39861中提升最为显著,这是因为MVI_39861中,存在几乎占整个序列1/3时间长度的15 × 15~50 × 50尺寸小目标车辆,而原始的CenterTrack 算法对远处小目标车辆存在大量漏检。

图11 CenterTrack与CenterTrack+小目标样本扩增模块方法在UA-DETRAC测试指标对比结果Fig.11 CenterTrack and CenterTrack+small target sample expansion module method comparison results in UA-DETRAC((a)MOTA;(b)FN;(c)FP;(d)IDs;(e)IDF1)

为了进一步验证本文算法的有效性和适应性,对另一个测试数据集Sherbrooke 的定量分析结果如表2所示。可知在Sherbrooke测试数据集中,在CenterTrack 中加入本文提出的小样本扩增模块有效地提高了目标的检测能力,大幅度降低了目标检测的FP 值(从319 降低至34),检测能力的提升也降低了跟踪过程中车辆目标的IDs、提高了IDF1 值,有效提升了整体跟踪能力。

表2 CenterTrack与CenterTrack+小样本扩增方法在Sherbrooke测试指标对比结果Table2 CenterTrack and CenterTrack+small target sample expansion module method comparion results in Sherbrooke

通过定性与定量分析CenterTrack+小目标样本扩增模块方法与单独的CenterTrack 方法在具体测试序列的实际运行结果及其在5 个测试序列的综合性评价指标MOTA、IDF1 与单独的FP、FN、IDs 指标上的比较表现,证明了增加的小目标数据扩增模块对于跟踪效果的有效提升。

3.2.2 短时轨迹记忆模块有效性分析

进一步验证本文算法中的短时轨迹记忆模块对于提升交通监控场景多目标跟踪性能的有效性,训练阶段用UA-DETRAC 中抽取的训练集对Center-Track 训练70 轮次,获得训练好的模型后,得出CenterTrack 在测试集上的结果,再在CenterTrack 后添加本文的短时轨迹记忆模块输出CenterTrack+短时轨迹记忆模块在测试集上的输出结果。

定性分析视频序列如图12所示。首先,如图12(a)所示,CenterTrack 跟踪结果中,车辆92 在中间帧由于存在阴影导致目标漏检,车辆92 的轨迹终止,当车辆又重新出现时,被赋予新的ID93,导致车辆目标发生IDs。其次,在同样的序列中运行Center-Track+短时轨迹记忆模块后的结果如图12(b)所示,同样的车辆ID 为58,中间帧漏检后,短时轨迹记忆模块维持目标运动状态,设定车辆目标在短时间内做匀速直线运动,预测目标在当前帧可能存在的位置,当目标再次被检测到时重新关联车辆的正确ID,未发生IDs,证明了短时轨迹记忆模块在轨迹关联失败时,保存轨迹历史运动信息并进行预测的有效性。

图12 改进前后算法在测试数据中跟踪运行结果对比示例Fig.12 Comparison example of algorithm tracking results in test data before and after improvement((a)tracking results of CenterTrack ;(b)tracking results of CenterTrack+short-term trajectory memory module)

定量分析CenterTrack+短时轨迹记忆模块的有效性,得出算法与CenterTrack 相比相应的评价指标在UA-DETRAC 的测试结果对比如图13所示。新增的短时轨迹记忆模块并未改变算法的检测能力,FN与FP 指标不变,仅分析MOTA、IDs、IDF1 指标。如图13(b)所示,在不改变检测能力的基础上,本文提出的CenterTrack+短时轨迹记忆模块大幅度降低了5 个测试场景中的IDs,在测试序列中的降低幅度分别为78.95%、33.33%、92.86%、77.24% 和65.26%,综合性指标MOTA 如式(1)所示,在FN 与FP 值的数值远大于IDs 值时,IDs 的大幅度降低对MOTA 的指标有小幅度提升,如图13(a)所示,同样IDF1如图13(c)所示,在UA-DETRAC 的多个测试序列中,改进算法均有提升。

图13 CenterTrack与CenterTrack+短时轨迹记忆模块方法指标对比结果Fig.13 CenterTrack and CenterTrack+short-term trajectory memory module method comparison results((a)MOTA;(b)IDs;(c)IDF1)

为了进一步分析本文算法的有效性和适用性,在测试数据集Sherbrooke中进行测试,结果如表3所示。可以看出,增加的短时轨迹记忆模块在Sherbrooke 数据集中同样适用,大幅度降低了IDs 值(从40 下降至14),有效提升了IDF1 数值,但同样由于检测性能指标FN 与FP 数值远大于IDs 数值,MOTA数值仅有接近1.5%的提升。

表3 CenterTrack与CenterTrack+短时轨迹记忆模块在Sherbrooke测试指标对比结果Table 3 CenterTrack and CenterTrack+short-term trajectory memory module method comparion results in Sherbrooke

通过定性与定量分析,本文提出的Center-Track+短时轨迹记忆模块在具体的序列中明显改进了跟踪效果,而且总体的评价指标也有小幅度提升,验证了本文提出的短时轨迹记忆模块在交通监控场景下多目标跟踪的有效性。

3.2.3 整体算法有效性分析

为了表明在交通监控车辆多目标跟踪场景下本文方法的有效性,选取YOLOv4(Bochkovskiy 等,2020)算法结合DeepSort 多目标跟踪算法构成先检测后跟踪的两阶段多目标跟踪算法YOLOv4—Deep-Sort进行比较分析。

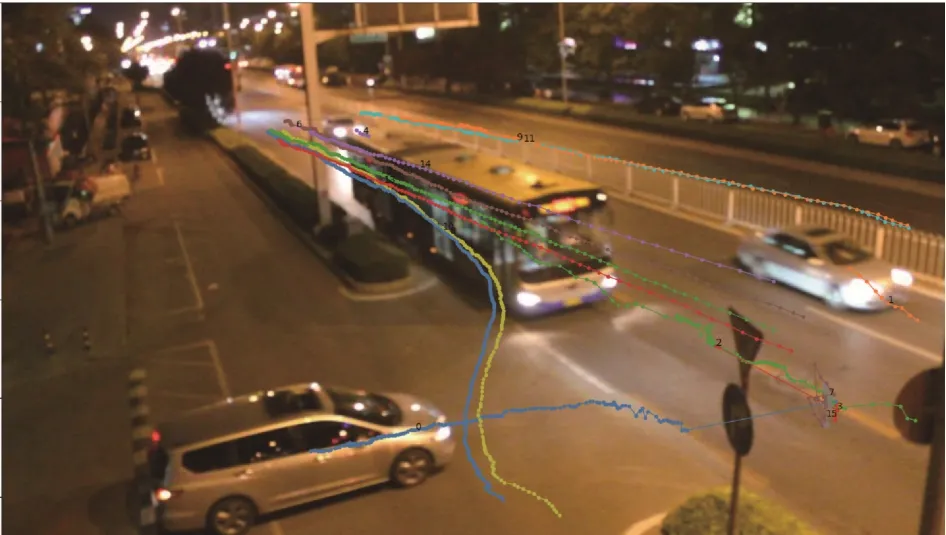

定性分析以MVI_39861 为例,分析YOLOv4-DeepSort、CenterTrack 以及本文方法在整个序列中的轨迹表现,结果如图14—图16 所示。可以看出,CenterTrack 方法对远处小目标车辆存在长时间漏检,同时由于帧间漏检造成较多轨迹碎点,表现欠佳。YOLOv4-DeepSort 与本文方法表现较好,轨迹较为完整。

图14 YOLOv4-DeepSort方法跟踪轨迹结果Fig.14 Tracking trajectory result of YOLOv4-DeepSort method

图15 CenterTrack方法跟踪轨迹结果Fig.15 Tracking trajectory result of CenterTrack method

图16 本文方法跟踪轨迹结果Fig.16 Tracking trajectory result of Our method

具体分析两条车辆跟踪轨迹,图17 为Center-Track、YOLOv4-DeepSort、本文方法跟踪轨迹与真实轨迹gt 在x方向上的x-t结果对比图,同时设置图中线的标记位置在轨迹的中点。通过图17 可知,本文方法得出的轨迹更接近真实轨迹,CenterTrack 对远处小目标存在较长时间的漏检,同时当目标漏检后,错误地产生新的轨迹ID,与YOLOv4-DeepSort 方法相比,本文轨迹对远处小目标的漏检数更少。

图17 不同方法的轨迹与真实轨迹在x方向的x-t对比图Fig.17 The x-t comparison diagram of the trajectory obtained the relevant method with the real trajectory in the x direction

定量分析3 种方法在UA-DETRAC 的跟踪指标结果如图18 所示。通过图18(b)(c)观察不同方法的,检测性能。基于CenterTrack网络算法的FP数值更低,FN 除了MVI_40191序列中车辆数目密集度较高导致YOLOv4-DeepSort 算法检测性能表现不佳,FN 数值较高之外,在其他4 个序列中,FN 与本文算法相当,而CenterTrack 表现次之。在轨迹关联方面,由于YOLOv4-DeepSort 算法和本文算法都进行了轨迹记忆优化,整体在测试序列中的IDs 数值较低。本文算法在对应用场景针对性地优化轨迹后的处理阶段,IDs 数值更低,而CenterTrack 的IDs 数值表现较高。基于本文算法在当前应用场景中检测与轨迹关联针对性的优化,本文算法的综合性指标MOTA 对于YOLOv4-DeepSort 分别提高了0.89%、10.16%、23.15%、15.92%和9.93%,如图18(a)所示,IDF1 指标也有显著提升,如图18(e)所示,相较于CenterTrack算法跟踪性能也有明显提升。

图18 本文方法与YOLOv4-DeepSort、CenterTrack在UA-DETRAC的指标对比结果Fig.18 Comparison results of our algorithm with YOLOv4-DeepSort and CenterTrack in UA-DETRAC((a)MOTA;(b)FN;(c)FP;(d)IDs;(e)IDF1)

为了进一步说明本文方法的有效性,比较本文方法与UA-DETRAC 数据集中排名靠前的跟踪方法,获得在跟踪关键性指标MOTA 上的对比如表4所示。分析可知,对比的3种榜单算法均为检测器+跟踪器模式,且跟踪器部分均未提取已检测目标的深度特征。而本文方法达到了更好的跟踪性能,与UA-DETRAC 中已发布的最佳车辆多目标跟踪方法相比,本文方法的跟踪准确度提高了近20%。

表4 本文方法与UA-DETRAC中Top3方法平均性能对比Table 4 The average performance comparison between the Top3 methods in UA-DETRAC and ours

4 结论

本文通过分析在当前交通监控场景下车辆多目标跟踪存在的远处小目标车辆检测难问题、车辆跟踪IDs 问题,提出了一种面向交通视频监控场景,在CenterTrack方法的基础上结合小样本扩增方法与短时轨迹记忆的车辆多目标跟踪方法,能够较好地解决交通监控场景中训练样本数量不均衡以及跟踪车辆目标IDs的问题。

在本文测试的两个数据集中,根据评价跟踪算法的两个综合性指标MOTA、IDF1可知,本文方法对比原始的CenterTrack 有较大提升,与流行的两阶段YOLOv4-DeepSort 多目标跟踪算法相比,在4 个测试场景中分别提升了10.16%、23.15%、15.92% 和9.93%的,具备更好的跟踪性能,与UA-DETRAC 数据集中排名前列方法相比性能增加近20%。

多目标跟踪的性能依赖于检测网络,而神经网络过于脆弱,本文中目标背景的微动干扰即造成检测器帧间漏检,后续研究可以进一步提高基于神经网络检测器的鲁棒性以进一步降低轨迹关联设计的复杂度。

致谢此次实验过程中获得了国防科技大学李冬冬老师的细心指导,在此表示感谢。