复杂光场环境下多重聚焦深度图像三维重建

王佳欣, 窦小磊

(河南工程学院计算机学院, 郑州 451191)

0 引 言

随着计算机视觉成像技术的发展,通过对不同光场环境的视觉信息跟踪识别和图像重建实现对复杂光场环境下多重聚焦深度图像采集和三维重建,结合对多维光场的图像视觉融合处理和三维特征重构,提取图像的亚像素特征点,通过机器学习和图像滤波检测算法实现对复杂光场环境下多重聚焦图像重建识别,提高图像的成像精度,相关复杂光场环境下多重聚焦深度图像三维重建方法研究在图像视觉跟踪识别、遥感监测等领域都具有很好的应用价值[1]。

对图像的三维重建、特别是对复杂光场环境下成型的图像三维重建是建立在对图像的降噪滤波和特征提取基础上[2],结合对四维光场的极平面图像特征检测和自适应跟踪识别,采用Harris 角点检测技术[3],通过视差线索跟踪识别,实现对深度图像检测和识别,文献[4]中提出基于LYTRO 相机光场图像深度估计算法及重建技术,通过残差视觉跟踪方法,结合对子孔径图像亚像素偏移修正实现对图像的光场特征提取和滤波处理,提高图像的动态识别能力,但该方法对复杂光场环境下多重聚焦深度图像三维重建的动态识别性能不好。 文献[5]中提出基于空谱协同多尺度顶点成分分析的高光谱影像端元提取方法,通过2 个端元间的光谱角,确定特征检测,结合集合约束的动态检测实现动态检测重建,但该方法对高光谱图像的点云数据重建效果不好。

针对上述问题,本文提出基于亚像素特征偏移修正的复杂光场环境下多重聚焦深度图像三维重建方法。 首先采用深度引导滤波方法实现对图像的边缘保持修正和滤波处理,然后结合亚像素特征偏移修正方法实现对复杂光场环境采样图像的像素偏移特征点修正,考虑像素空间差异和强度差异,根据光强纠正结果实现对图像的三维重建和特征配准。 最后进行实验测试分析,展示了本文方法在提高多重聚焦深度图像三维重建视觉效果方面的优越性能。

1 图像边缘保持修正和滤波

1.1 多重聚焦深度图像边缘保持修正

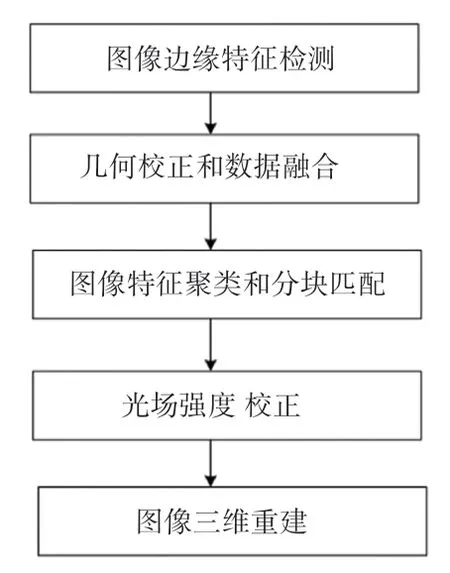

为了实现对复杂光场环境下多重聚焦深度图像的三维重建,首先构建图像采集和融合模型,在不同的光场相机下通过构建复杂光场环境下多重聚焦深度图像的双边滤波降噪模型,采用深度置信度测量的方法实现对复杂光场环境下多重聚焦深度图像的三维深度立体匹配,给出面向对象影像分析特征辨识参数分布集,结合图像的结构信息和纹理信息分布,采用基于块的修复方法实现图模型参数匹配,通过传感器像素集特征分布式组合控制,采用几何校正和图像融合处理相结合的方法[6],结合深度引导滤波方法实现对图像的边缘保持修正和滤波处理,实现图像三维重建,实现流程如图1 所示。

图1 图像三维重建实现流程Fig. 1 Implementation flow of image 3D reconstruction

结合图1 中的图像三维重建实现结构流程,根据多重聚焦深度图像在空间域偏移特征分布,采用融合空间信息的端元特征提取方法提取图像的谱特征点,采用低分辨视觉检测技术,得到原始的多重聚焦深度图像的像素分布函数:

其中,αi和αi*是表示复杂光场环境下多重聚焦的深度项及卷积特征;K(xi,xj) 是成像设备采集到的深度图像的边缘分布核函数;b表示暗通道先验边缘像素分布区域y中的视觉连通度水平。 通过结构模板图像和较大搜索区域的连续块匹配处理,得到复杂光场环境下多重聚焦深度图像的时序逻辑分量表示为P= {1,…,P} 。 提取复杂光场环境下多重聚焦深度图像的边缘特征分布集,通过空谱得模糊集函数为:

其中,r为已知像素值的平均值;A是多重聚焦深度图像模糊降噪聚合参数;Rin为特征图分离系数;e-ikr为已知像素的位置相对应指数增益。 采用全局特性和局部细节特征重组,得到图像的边界模糊集分配函数为:

式(3)表示结构连续块的聚合度,基于光照-反射模型分析,采用高光谱与多光谱图像组合控制,结合SV 色彩组合,建立多重聚焦深度图像边缘保持修正模型[7]。

1.2 图像引导滤波

采用场景深度估计方法,得到复杂光场环境下多重聚焦深度图像图片各元素的特征匹配集为B0,根据场景深度检测[8],得到图像的边缘信息熵平均值表示为:

其中,Rm(r,i) 为qj处像素的深度值,i下标为边缘模糊和纹理特征点。 在采样深度图和给定的低分辨率分布集中:

其中,表示弥补像素级损失的动态参数;s表示综合半方差分布邻域;gj() 表示第j个像素点中复杂光场环境下多重聚焦深度图像虚拟细节信息;l表示属性空间分割特征值;hj() 表示最佳属性参数跳变值;p为子图像的子空间降噪特征分配系数。通过灰度动态调节的方法进行多重聚焦深度图像的滤波处理,得到滤波函数为:

其中,t为图像的特征匹配权重;BER为图像降噪滤波的特征分辨率;xk表示目标图像采集时间间隔;yk为模糊隶属度。 由此,采用融合空间信息的端元特征提取方法提取图像的谱特征点,结合亚像素特征偏移修正方法进行图像三维重建处理。

2 图像三维重建优化

2.1 图像亚像素特征偏移修正

采用自相似性数据立方体的提取方法,得到复杂光场环境下多重聚焦深度图像三维虚拟重建的拟合梯度函数,采用目标分块特征匹配和模板匹配方法[9],得到先验样本块的优先权分布函数为:

其中,t为图像的空间映射时间点;f(k,N)为所有格点的系数;s为复杂光场环境下多重聚焦深度图像的干扰因子;avg为复杂光场环境下多重聚焦深度图像干扰噪声的均值。 设计联合双边滤波器,表示为:

其中,为三维拟合重建后图像方向信息特征点的加权映射序列;为高置信度像素的边界频点;Tj为波段图像合成的伪彩色频偏因子。 通过复杂光场环境下多重聚焦融合处理,得到深度学习的动态分配模糊度函数H(f):

其中,τ0为场景深度估计的门限因子,ωd为门限因子。 采用图像亚像素特征偏移修正的方法,得到全局对比度融合图像输出:

其中,avgdl表示颜色和亮度信息的均值;fsearch表示预测图与参考图之间的动态辨识寻优参数;n为前置门限;d为第i个滤波器窗口的加权函数;l为分虚拟重建的特征滤波参数。 根据图像亚像素特征偏移修正结果,实现对复杂光场环境采样图像的像素偏移特征点修正,考虑像素空间差异和强度差异,构建图像的三维立体重建模型[10]。

2.2 图像的特征配准及三维重建

考虑像素空间差异和强度差异,根据光强纠正结果实现对图像的三维重建和特征配准处理,通过灰度动态调节的方法构造不同种类图像的自动增强和三维重构模型,得到qj处像素的深度值为:

其中,Eint(vi) 表示复杂光场环境下多重聚焦深度图像的边缘模糊度寻优参数;Eext(vi) 表示图像的像素增强目标匹配系数;N表示分割斑块的样本数。 采用采样深度图融合的方法,结合波段图像合成的伪彩色图像重构结果,通过增强辐射度的方法进行复杂光场环境下多重聚焦深度图像的视觉传达跟踪拟合,得到图像三维重建的边缘细节特征检测结果为:

其中,a表示线性增强的图像景深维度,照明不足或亮度分布不均下,提取深度修复的局部采样放大图,得到图像三维重建输出为:

其中,g(x,y) 为空间信息约束的光谱波段;(x,y) 为图像的线性混合模板参数;t为采样点。综上分析,结合像元集合特征重组的方法,根据光强纠正结果实现对图像的三维重建和特征配准。

3 仿真测试与结果分析

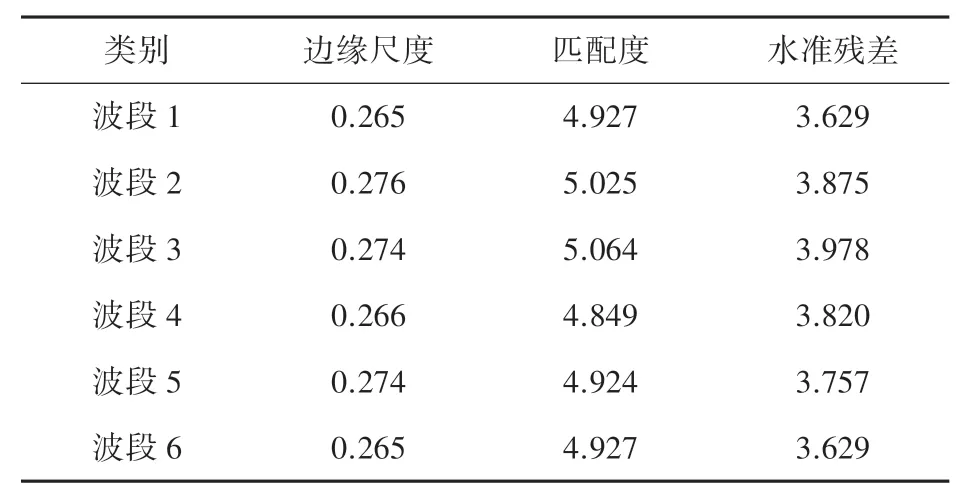

为了验证本文方法在实现多重聚焦深度图像三维重建上的性能,采用USGS 图像作为学习训练库,结合Matlab 仿真工具进行仿真实验,图像采集中干扰为零均值高斯噪声,噪声强度为-12 dB,图像的标准训练集个数为1 200,测试集为500,特征动态分辨率为32 m,模板匹配系数为0.72,各个波段的图像模型分布参数见表1。

表1 各个波段的图像模型分布参数Tab. 1 Image model distribution parameters of each band

根据上述仿真参数设定,进行图像三维重建的仿真实验,给出原始图像如图2 所示。

图2 原始图像Fig. 2 Original image

图2 的图像受到采集环境的光场环境突变等因素影响,导致图像的成像效果不好,采用本文方法对图像进行多重融合和重建,对目标图像进行深度渲染和映射处理,得到网格映射结果如图3 所示。

图3 图像网格映射结果Fig. 3 Image grid mapping results

根据图3 对图像的网格映射结果,进行图像的边缘校正处理,得到校正结果如图4 所示。

图4 图像校正Fig. 4 Image correction

在对图像校正的基础上,根据光强纠正结果实现对图像的三维重建和特征配准,得到目标深度图像如图5 所示。

图5 目标深度图像Fig. 5 Target depth image

基于VC++的OpenGL,考虑像素空间差异和强度差异,根据光强纠正结果实现对图像的三维重建和特征配准,得到三维重建输出如图6 所示。

图6 图像三维重建输出Fig. 6 Three-dimensional reconstruction output of the image

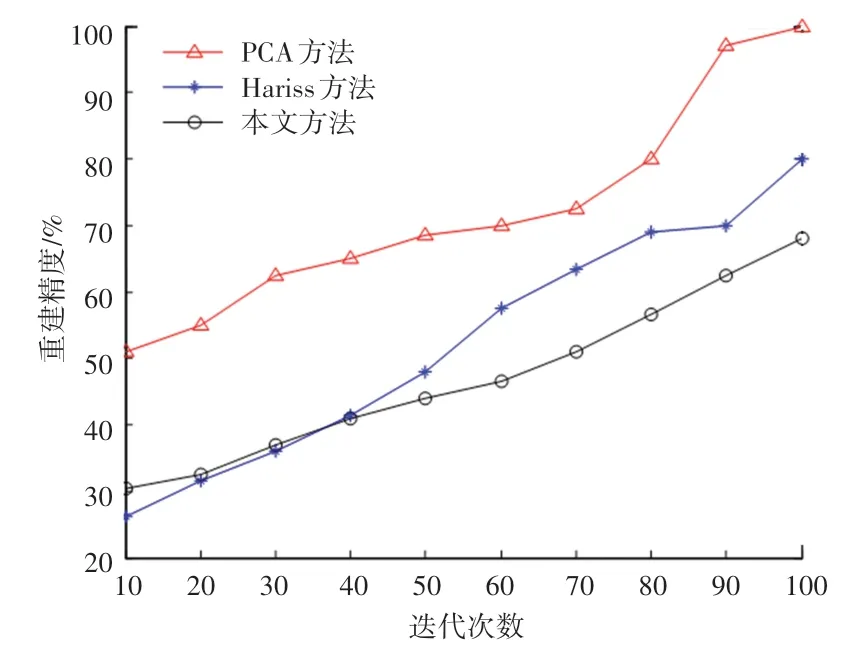

分析上述仿真结果得知,本文方法能有效实现对复杂光场环境下多重聚焦深度图像三维重建, 得到较为精细的重建结果,光场偏移修正能力较好。测试重建精度,得到对比结果如图7 所示。 分析图7 得知,本文方法对图像重建的精度更高。

图7 重建精度对比测试Fig. 7 Comparison test of reconstruction accuracy

4 结束语

通过机器学习和图像滤波检测算法实现对复杂光场环境下多重聚焦图像重建识别,提高图像的成像精度,本文提出基于亚像素特征偏移修正的复杂光场环境下多重聚焦深度图像三维重建方法。 采用基于块的修复方法实现图模型参数匹配,考虑像素空间差异和强度差异,根据光强纠正结果实现对图像的三维重建和特征配准处理。 分析得知,本文方法对多重聚焦深度图像三维重建的精度更高,特征匹配能力较强,重建视觉效果较好。