RISNet:无监督真实场景图像拼接网络

朱永 付慧 唐世华 王一迪

摘 要:图像拼接目的是获得一张高清无缝的全景图,现有方法依赖于特征匹配的准确性,会错误地对齐图像,产生伪影和失真等现象。为此提出一种新的无监督真实场景图像拼接网络,能够适应存在移动目标的真实场景拼接,保证全景图的精度无损失,包含配准和重建两个网络。在配准网络中引入内容感知分支,学习内容掩码,排除移动目标和误导性区域对于变换矩阵的负影响;在重建网络中添加边缘检测分支,构造边缘一致性感知损失,约束重建过程,优化图像细节,实现高清、无伪影的拼接效果。实验结果表明,该方法RMSE、PSNR、SSIM分别达到1.81、26.56、0.85,客观评价指标整体优于其他经典算法,用户调研结果也说明该方法获取的全景图清晰度更高。该方法有效地完成了真实场景下的无监督图像拼接,并能够泛化至其他场景的拼接任务中。

关键词:计算机视觉; 深度学习; 图像拼接; 单应性估计; 边缘引导

中图分类号:TP311 文献标志码:A

文章编号:1001-3695(2023)09-047-2856-07

doi:10.19734/j.issn.1001-3695.2022.11.0820

RISNet:unsupervised real scene image stitching network

Zhu Yong1, Fu Hui1, Tang Shihua2, Wang Yidi1

(1.School of Information Science & Technology, Beijing Forestry University, Beijing 100083, China; 2.Joint Operations College, China Peoples Liberation Army National Defence University, Shijiazhuang 050084, China)

Abstract:The purpose of image stitching is to obtain a high-definition, seamless panoramic image. Existing methods rely on the accuracy of feature matching, which will misalign images and produce errors such as artifacts and distortions. This paper proposed a new unsupervised real scene image stitching network which could adapt to real scene stitching in the presence of mo-ving targets and ensure no loss of accuracy in the panorama, including two networks of alignment and reconstruction. It excluded the negative influence of moving targets and misleading regions on the transformation matrix through content branching, and optimized image details by constraining the reconstruction process through edge branching to achieve high-definition and artifact-free stitching effects. The experimental results show that the methods RMSE, PSNR, and SSIM reaches 1.81, 26.56, and 0.85, respectively. The objective evaluation indexes are better than other classical algorithms overall, and the user research results also indicate that the method obtains higher definition of panoramic images. The method effectively accomplishes unsupervised image stitching in real scenes and can be generalized to stitching tasks in other scenes.

Key words:computer vision; deep learning; image stitching; homography estimation; edge guidance

0 引言

圖像拼接是计算机视觉图像处理领域中的一项关键且具有挑战性的任务,由于视野有限,一张照片无法显示出完整的感兴趣区域(region of interest)。图像拼接技术可以通过拼接来自不同观察位置的图像以获得高分辨率且具有更宽视野的全景图像[1],在生物[2]、医疗[3]、视频监控、虚拟现实[4]和自动驾驶[5]等领域发挥着重要作用。

图像拼接技术主要分为传统拼接方法和基于深度学习的方法。传统图像拼接解决方案是基于特征的方法[6],其严重依赖于手工制作稀疏特征的精确定位和均匀分布[7],因此在特征较少或视角变化较大的场景中,拼接图像中重叠部分极易产生伪影或错位现象,拼接性能急剧下降,甚至导致拼接失败。

由于卷积神经网络(convolutional neural network,CNN)拥有强大的特征提取能力,通过数据驱动的方式可以自适应地提取到最适合任务的特征。近年来,越来越多的研究人员尝试将CNN应用于图像拼接中,按学习方式可分为有监督方法和无监督方法。

Van,Shi等人[8,9]在图像拼接的特征检测阶段采用CNN,使用神经网络提取的特征点进行配准,但该方法不是一个完整的基于深度学习的拼接框架。Chen等人[10]提出了MVLidarNet,该方法由两个模块组成,低分辨率变形模块学习从双鱼眼到全景图像的变形规则,高分辨率递归模块以递归方式通过高分辨率图像引导提高拼接结果的分辨率,但该方法只能拼接拍摄于固定视角的图像,而不能用于任意视角的图像拼接。Nie等人[11]提出了第一个完整的基于深度学习的任意视角图像拼接框架VFISNet,拼接图像需要经过单应性估计、空间变换和内容优化三个阶段。但是,由于网络中各层完全连通,VFISNet无法处理任意分辨率的输入图像,实际应用中的拼接质量也不理想。在此基础上,Nie等人[12]提出了一种保留边缘的图像拼接网络EPISNet,消除了输入分辨率的限制,显著提高了真实场景中的拼接性能。在这些固定视角拼接方法中,可以通过深度单应估计、空间变换扭曲和图像融合来完成基于深度学习的图像拼接,但上述的解决方案都是基于有监督学习方法。由于真实场景中没有拼接标签,目前还没有真正用于深度学习的有监督图像拼接数据集,所以这些网络只能在合成数据集上进行训练,导致在真实场景中的应用不尽如人意。

为了克服基于有监督学习解决方案的局限性,Nie等人[13]提出了一个无监督深度学习图像拼接框架UDISNet,在图像对齐网络中提出了拼接域转换层,使输入图像在此拼接域内占用更小的空间进行扭曲,还提出从特征到像素重建拼接图像的思想,通过图像重建方式消除伪影,实现更好的拼接效果。然而,在配准阶段,该方法本质上是一种基于单一单应性矩阵的配准方法,只能实现输入图像粗对齐,并不能精确配准图像。当输入图像存在较大前景或者移动目标时,该方法的配准效果会急剧下降。同时,随着视差的增加,配准网络的性能会逐渐降低,重建网络的重建能力也并不是无限的,通过重建网络生成后的拼接图像会损失一部分图像分辨率,在图像细节丰富的区域,该方法也会产生一些伪影或者结构不一致的区域。

使用单应性矩阵在图像配准时出现误差的主要原因是受到错误匹配特征点的影响,当输入图像中具有移动目标时,因为移动目标上的匹配特征点与图像背景的变换矩阵并不相同,所以会干扰图像单应性矩阵的计算。减少错误匹配点常用的有RANSAC方法,但在深度学习网络中目前还没有很好的模型实现这一功能。为了减少这部分特征点的干扰,本文将输入图像分为移动目标与背景两个部分,构建内容掩码分支消融输入图像中的移动目标[14],对配准网络进行约束,达到减少错误匹配的目的。由于移动目标的变换矩阵与背景不同,所以利用估计的单应性矩阵获取的拼接结果图像中运动目标必然无法对齐,从而产生伪影。为了结合图像的精度与准度,利用图像重建网络生成全景图像,使用原始图像的边缘信息作为重建网络的引导。

基于以上分析,为了克服传统拼接与深度学习方法的局限性,本文采用UDISNet作为骨干网络提出一种新的无监督真实场景图像拼接网络RISNet(real scene image stitching network),其包含内容感知配准网络和边缘引导重建网络两部分。在第一部分中,针对配准网络在某些场景下配准性能较差等问题,引入内容分支突出图像中对于单应性估计贡献较大的区域。在第二部分中,针对边缘轮廓信息在重建过程中丢失等问题,在重建网络中引入边缘分支引导网络关注结构信息丰富的区域,避免拼接结果产生伪影等现象。

本文在Warped MS-COCO与RISD数据集上进行了大量实验,结果表明,无论在合成图像还是真实场景图像中,RISNet与文献[13,15]相比均占优势。综上所述,本文贡献如下:

a)提出了一种适用于图像拼接的内容感知配准网络,可以更加准确地进行单应性估计,更好地对齐预配准图像。

b)提出了一种使用边缘信息显式引导重建过程的边缘引导重建网络,通过构造边缘一致性感知损失在更好地保留图像细节的同时尽可能不产生伪影现象。

c)提出了一个用于无监督真实场景图像拼接的数据集,包含室内、室外、黑暗、低纹理、小前景和大前景等多种真实环境,与现有公开数据集相比,添加了更多包含大前景和运动物体的场景,使模型对于真实场景具有更好的泛化性能。

1 RISNet介紹

RISNet由内容感知配准网络(content aware image registration network,CAIRNet)与边缘引导重建网络(edge guidance image reconstruction network,EGIRNet)两部分组成。

1.1 内容感知配准网络

CAIRNet以参考图a和目标图b两张高分辨率图像作为输入。首先使用内容感知分支预测内容掩码(content-masks);然后将内容掩码与特征金字塔特征进行特征融合(element-wise addition),输入单应估计模块中估计得到单应性矩阵H;最后在拼接域变换模块(stitching-domain transformer)中对输入图像进行扭曲变形,以两张预配准图像作为输出,实现输入图像预配准。

整个网络结构可分为内容感知分支、单应性估计和拼接域变换三个模块,如图1所示。

1.1.1 内容感知分支

在非平面场景中,尤其是包含移动对象的场景中,不存在可以对齐两个视角的单一单应性矩阵。在传统算法中,RANSAC[15]被广泛应用于寻找单应性估计的内点,从而求解场景对齐的最近似矩阵。

受到CA-UDHN[14]的启发,本文通过构建一个子网络来自动学习内点的位置,提出一种内容感知分支m学习生成一个内容掩码,掩码的大小与特征图Fa和Fb的大小相同,利用内容掩码加权特征金字塔特征,得到两个加权特征Ga和Gb,然后将加权特征G送入到单应性估计模块中。此过程如式(1)所示。

Mβ=m(Iβ),Gβ=FβMβ,β∈{a,b}(1)

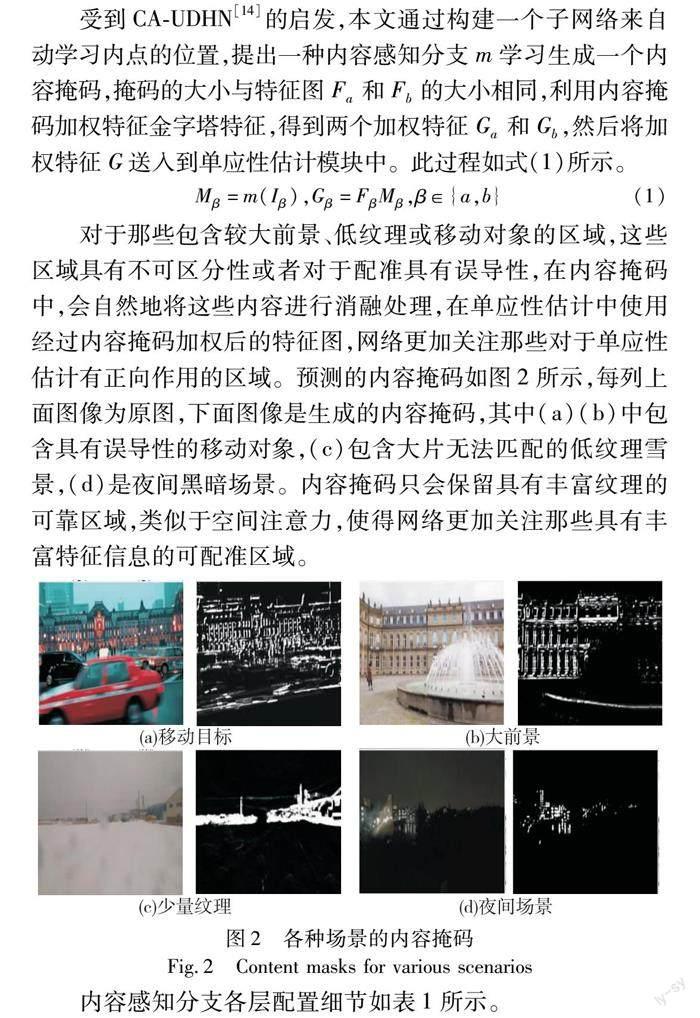

对于那些包含较大前景、低纹理或移动对象的区域,这些区域具有不可区分性或者对于配准具有误导性,在内容掩码中,会自然地将这些内容进行消融处理,在单应性估计中使用经过内容掩码加权后的特征图,网络更加关注那些对于单应性估计有正向作用的区域。预测的内容掩码如图2所示,每列上面图像为原图,下面图像是生成的内容掩码,其中(a)(b)中包含具有誤导性的移动对象,(c)包含大片无法匹配的低纹理雪景,(d)是夜间黑暗场景。内容掩码只会保留具有丰富纹理的可靠区域,类似于空间注意力,使得网络更加关注那些具有丰富特征信息的可配准区域。

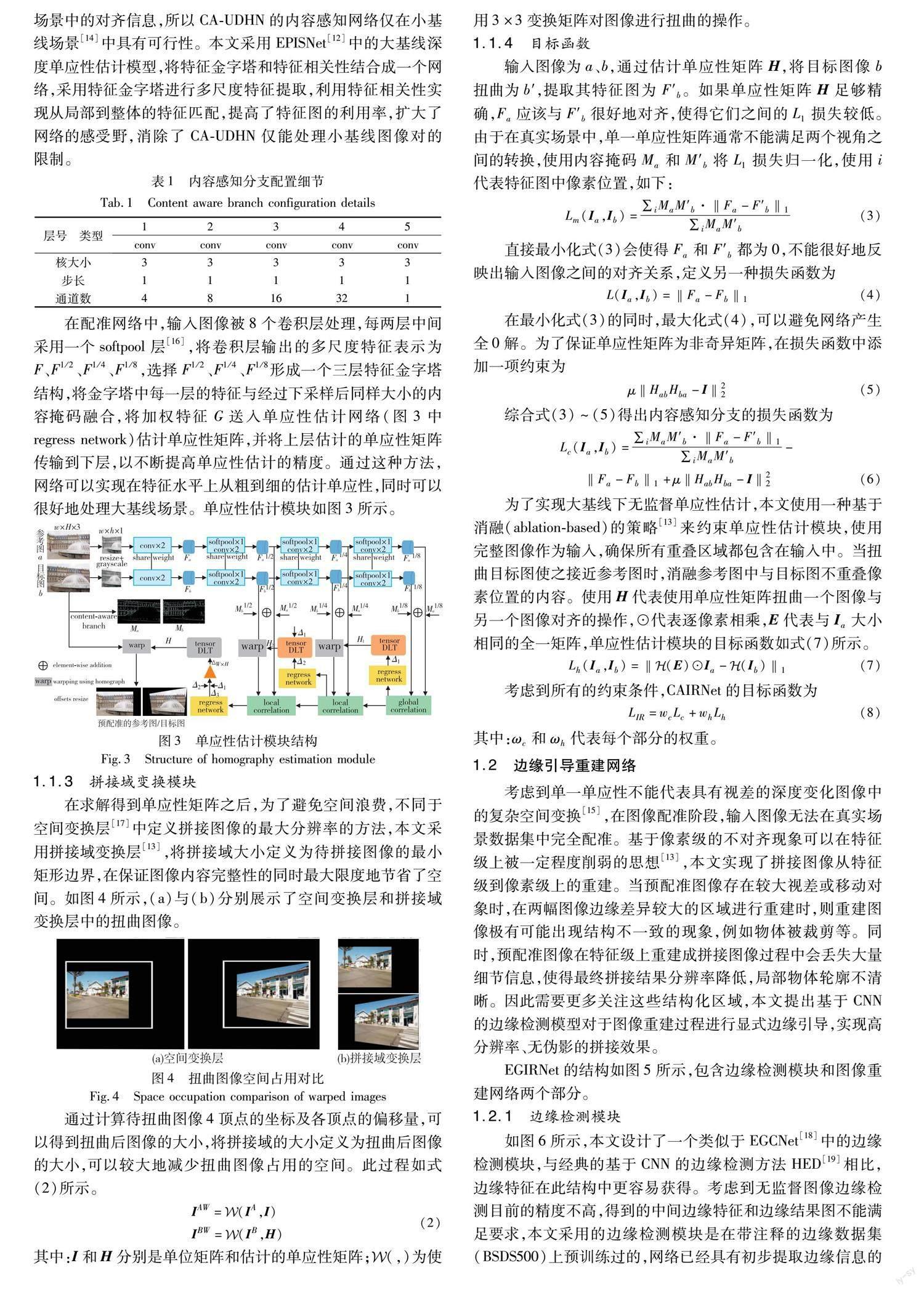

内容感知分支各层配置细节如表1所示。

1.1.2 单应性估计模块

图像拼接是在大基线场景[12]下拼接图像,以构建具有更宽视野的全景图,而在大基线的场景中,图像之间重叠率过低,CA-UDHN的感受野明显受限,网络无法提取到适用于大基线场景中的对齐信息,所以CA-UDHN的内容感知网络仅在小基线场景[14]中具有可行性。本文采用EPISNet[12]中的大基线深度单应性估计模型,将特征金字塔和特征相关性结合成一个网络,采用特征金字塔进行多尺度特征提取,利用特征相关性实现从局部到整体的特征匹配,提高了特征图的利用率,扩大了网络的感受野,消除了CA-UDHN仅能处理小基线图像对的限制。

在配准网络中,输入图像被8个卷积层处理,每两层中间采用一个softpool层[16],将卷积层输出的多尺度特征表示为F、F1/2、F1/4、F1/8,选择F1/2、F1/4、F1/8形成一个三层特征金字塔结构,将金字塔中每一层的特征与经过下采样后同样大小的内容掩码融合,将加权特征G送入单应性估计网络(图3中regress network)估计单应性矩阵,并将上层估计的单应性矩阵传输到下层,以不断提高单应性估计的精度。通过这种方法,网络可以实现在特征水平上从粗到细的估计单应性,同时可以很好地处理大基线场景。单应性估计模块如图3所示。

1.1.3 拼接域变换模块

在求解得到单应性矩阵之后,为了避免空间浪费,不同于空间变换层[17]中定义拼接图像的最大分辨率的方法,本文采用拼接域变换层[13],将拼接域大小定义为待拼接图像的最小矩形边界,在保证图像内容完整性的同时最大限度地节省了空间。如图4所示,(a)与(b)分别展示了空间变换层和拼接域变换层中的扭曲图像。

通过计算待扭曲图像4顶点的坐标及各顶点的偏移量,可以得到扭曲后图像的大小,将拼接域的大小定义为扭曲后图像的大小,可以较大地减少扭曲图像占用的空间。此过程如式(2)所示。

2 实验结果与分析

2.1 实验数据和环境

1)数据集 本文使用两种数据集进行训练。第一种是目前最著名的深度单应性估计合成数据集Warped MS-COCO[21]。第二种是真实场景数据集,为了更好地训练RISNet,受到文献[13,14]的启发,本文提出了一个用于无监督图像拼接的真实场景数据集,它是从视角可变的移动视频中获得的,用到的视频一些来自文献[13,14],另一些是笔者自己实地拍摄的。通过从这些视频中提取不同间隔时间的帧图像,得到了包含不同重叠率、不同视差程度的图像对。这个真实场景数据集包括室内、室外、黑暗环境、低纹理、小前景和大前景等多种场景,如图9所示,该数据集包含10 812对训练图像和1 023对测试图像,本文将这个数据集命名为真实场景图像拼接数据集(real image stitching dataset,RISD)。

2)实验细节 RISNet训练过程分为CAIRNet和EGIRNet两部分完成。首先在CAIRNet中,使用合成数据集训练150个轮次,在提出的RISD中微调50个轮次。然后在EGIRNet中,使用RISD训练30个轮次。训练过程中采用的方式都是无监督学习方式,这意味着RISNet只需要参考/目标图像作为输入,而不需要任何标签(groundtruth)。采用的优化器为Adam, 学习率呈指数衰减,初始值设置为10-4。由于神经网络模型在训练初期不稳定,所以RISNet在训练最初的两个epoch里,采用学习率热身的方式将学习率从0平滑地增加到初始学习率。式(3)中参数μ设为0.01,式(10)和(13)中的参数均设置为λi=10-6和λs=2。根据各部分对于单应性估计的不同影响,将CAIRNet中的参数ωc和ωh分别设置为10和1,将EGIRNet中的参数ωE、ωLR、ωHR和ωCS分别设置为0.25、100、1、1。在测试中,拼接两张分辨率为512×512的输入图像,大约需要0.6 s的时间。RISNet使用TensorFlow实现,训练和测试均在单个NVIDIA GTX 1080 Ti上进行。

2.2 算法性能分析

2.2.1 配准性能评估

为了客观地评价RISNet的配准性能,将RISNet与传统拼接方法SIFT+RANSAC、有监督拼接方法DHN[21]、无监督拼接方法UDHN[22]、CA-UDHN[14]、UDISNet[13]分别在合成数据集和RISD上进行了比较。

1)合成数据集 在Warped MS-COCO数据集上进行RISNet与其他方法的比较,所有基于深度学习方法的模型都是在该数据集上训练,RISNet-S是RISNet在该数据集上以无监督方式训练得到的模型。采用DHN[21]的评价标准,通过对估计的顶点偏移量与真实偏移量之间进行比较,得到的均方根误差RMSE值越小代表估计得越准确。结果如表2所示。

2)RISD 由于RISD中不包含配准结果真值标签,采用文献[13]中提出的重叠区域的PSNR(峰值信噪比)和SSIM(结构相似性)来评估其配准性能,使用公开的DHN和UDNH预训练模型进行测试,RISNet-R是RISNet-S在RISD上微调50个时代后的模型,UDIS_v2是与RISNet-R相同方式训练得到的模型。结果对比如表3所示。

通过分析表2、3可知:

a)无论是与传统方法还是深度学习方法对比,本文提出的RISNet在合成数据集和真实场景数据集中均占优势,能够更加准确地进行单应性估计,其中CA-UDHN由于感受野受限,无法在适用于图像拼接的单应性估计数据集上进行准确估计。

b)与参考的骨干网络UDISNet对比,RISNet在RMSE上提升約为12.1%,在PPNR和SSIM上提升分别约为16.2%和14.9%,说明本文提出的内容感知分支及系列损失约束对于单应性估计有正向作用。

2.2.2 拼接效果评价

为了验证RISNet在图像拼接方面的优越性,将RISNet与SIFT+RANSAC[15]、VFISNet[11]和UDISNet[13]方法的拼接结果进行对比。VFISNet是公开的基于深度学习的有监督图像拼接方法,可以拼接任意视角的图像,但由于网络中全连接层的限制,VFISNet只能拼接128×128尺寸的图像,所以使用双三次插值(Bicubic)来调整拼接图像的大小,以VFISNet+Bicubic方法作为对照。同时为了公平起见,UDISNet与RISNet一样,都是在RISD上微调后的模型。

1)用户调研 为了评估图像拼接结果的优劣,采用基于视觉质量的用户调研。具体来说,将RISNet与其他三种方法其一产生的两幅结果图作为一组,同时匿名随机地显示在一个屏幕上,用户可以自由放大图像,并被要求回答这组图像中哪张拼接效果最好或两张都好或都不好。这个研究中选取的图像部分来自RISD的测试集,部分来自其他公开图像拼接数据集,总共包括300组图像。为了获得更公平、更清晰的结果,邀请了50名志愿者参与,其中30名是具有计算机视觉背景的研究人员或学生,20名是其他专业领域内的学者。

用户调研结果如图10所示,忽略都好与都坏的结果后,无论与哪种方法相比,偏好RISNet结果的用户均占多数,这意味着本文结果在用户心中具有更好的视觉质量,拼接效果更佳。此外,对于某些黑暗环境或低纹理图像中,人眼无法准确感知是否有效拼接的情况下,小部分用户选择了都坏(both bad)选项,如图11所示。

2)视觉质量对比 为了进一步展示RISNet的拼接性能,图12对比展示了各方法在RISD数据集中的拼接结果。

此外,在图13中展示了更多RISD的测试结果。为验证RISNet在其他数据集上的泛化性能,图14展示了在一些公开数据集上的测试结果,所有展示案例均有不同程度的视差。

通过图12可知,由于使用了原始图像的边缘信息作为约束,RISNet结果在图像细节上更加清晰(如第1、2行);由于边缘一致性感知损失的加入,在其他深度学习方法结果均产生伪影的图像中,RISNet也达到了很好的视觉效果(如第3行中的人影);通过配准网络中使用的内容分支区分运动目标与背景,RISNet实现了更好的对齐效果,拼接结果也更加合理(如第4行中移动的门)。本文模型RISNet并未在包含航拍图像的数据集中进行训练,但在图14其他公开数据集中的航拍图像表现同样良好,表明本文方法具有一定的模型泛化能力。同时,本文采用无监督学习方式,对于所有图像无须拥有其真实拼接标签,可以在任何场景下进行有效的图像拼接。

2.2.3 消融实验

1)内容感知分支 为了验证内容感知分支的有效性,对于CAIRNet进行了消融实验,在没有内容感知分支的参与下重新训练了配准网络(表4中v1),以相同的评价指标PSNR和SSIM进行比较,结果如表4所示。由于没有内容掩码消融输入图像中包含移动对象或大前景物体等对于单应性估计具有负作用的区域,v1模型在测试集的后40%图像中配准性能较差,而在RISNet中,内容掩码可以自然且有效地去除这些不可靠区域对于单应性估计的影响,得到一个较好的配准结果。

2)边缘检测模块 为了验证检测模块对于高分辨分支优化图像细节的有效性,在RISD上进行了消融实验。结果如图15所示,v2代表缺少边缘检测模块的模型,在优化图像细节、丰富图像内容时,v2由于缺乏边缘一致性感知损失的约束,拼接结果会出现不同程度的边缘不对齐现象。而RISNet中,通过边缘信息来引导重建过程,使得网络能够生成边缘连续、视觉效果合理的拼接结果。

3 结束语

本文提出了一种无监督真实场景图像拼接网络RISNet,包括内容感知配准网络和边缘引导重建网络。在配准阶段,提出基于内容掩码的内容感知分支来优化真实场景下的图像配准,并采用一种基于消融的损失函数来约束大基线场景下的单应性估计。在重建阶段,提出了边缘检测分支用来引导图像重建过程,并设计了一个边缘一致性损失让输出结果图边缘连续,视觉效果更佳。此外,本文在现有无监督图像拼接数据集中添加了更多真实场景,提升了网络的泛化性能。实验结果表明,RISNet优于现有的其他拼接方案,用户研究也说明,本文拼接结果的视觉质量更受到用户的青睐。后续在超大视差等场景应用时,可考虑通过采用多网格估计多个单应性及增大重建网络的感受野等方法,进一步提高拼接的精度与准度。

参考文献:

[1]许向阳, 袁杉杉, 王军, 等. 基于全局和局部特征的图像拼接方法[J]. 北京理工大学学报, 2022,42(5): 502-510. (Xu Xiang-yang, Yuan Shanshan, Wang Jun, et al. Image stitching method based on global and local features[J]. Trans of Beijing Institute of Technology, 2022,42(5): 502-510.)

[2]Chalfoun J, Majurski M, Blattner T, et al. MIST: accurate and scalable microscopy image stitching tool with stage modeling and error minimization[J]. Scientific Reports, 2017,7(1): article No.4988.

[3]Liu Desheng, He Qiang, Liu Chunli, et al. Medical image stitching using parallel SIFT detection and transformation fitting by particle swarm optimization[J]. Journal of Medical Imaging and Health Informatics, 2017,7(6): 1139-1148.

[4]Wang Lang, Yu Wen, Li Bao. Multi-scenes image stitching based on autonomous driving[C]//Proc of the 4th IEEE Information Technology, Networking, Electronic and Automation Control Conference. Piscataway, NJ: IEEE Press, 2020: 694-698.

[5]Kim H G, Lim H T, Ro Y M. Deep virtual reality image quality assessment with human perception guider for omnidirectional image[J]. IEEE Trans on Circuits and Systems for Video Technology, 2020,30(4): 917-928.

[6]劉杰, 游品鸿, 占建斌, 等. 改进SIFT快速图像拼接和重影优化[J]. 光学精密工程, 2020,28(9): 2078-2084. (Liu Jie, You Pinghong, Zhan Jianbin, et al. Improved SIFT fast image stitching and ghosting optimization algorithm[J]. Optics and Precision Engineering, 2020,28(9): 2078-2084.)

[7]唐云, 帅鹏飞, 蒋沛凡, 等. 基于多尺度残差网络的单应估计方法[J]. 计算机应用研究, 2022,39(10): 3179-3185. (Tang Yun, Shuai Pengfei, Jiang Peifan, et al. Homography estimation method based on multi-scale residual network[J]. Application Research of Computers, 2022,39(10): 3179-3185.)

[8]Van D H, Diem P T, Nguyen G N, et al. Deep feature extraction for panoramic image stitching[J]. Intelligent Information and Database Systems, 2020,4(2): 141-151.

[9]Shi Zaifeng, Li Hui, Cao Qingjie, et al. An image mosaic method based on convolutional neural network semantic features extraction[J]. Journal of Signal Processing Systems, 2020,92(2) : 435-444.

[10]Chen K, Oldja R, Smolyanskiy N, et al. MVLidarNet: real-time multi-class scene understanding for autonomous driving using multiple views[C]//Proc of IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway, NJ: IEEE Press, 2020: 2288-2294.

[11]Nie Lang, Lin Chunyu, Liao Kang, et al. A view-free image stitching network based on global homography[J]. Journal of Visual Communication and Image Representation, 2020,73: 102950.[12]Nie Lang, Lin Chunyu, Liao Kang, et al. Learning edge-preserved image stitching from large-baseline deep homography[EB/OL]. (2020)[2022-11-23]. https://arxiv.org/abs/2012.06194.

[13]Nie Lang, Lin Chunyu, Liao Kang, et al. Unsupervised deep image stitching: reconstructing stitched features to images[J]. IEEE Trans on Image Processing, 2021,30: 6184-6197.

[14]Zhang Jirong, Wang Chuan, Liu Shuaicheng, et al. Content-aware unsupervised deep homography estimation[C]//Proc of European Conference on Computer Vision. Cham: Springer, 2020: 653-669.

[15]万琴, 颜金娥, 李智, 等. 基于改进RANSAC算法的全景图像拼接技术[J]. 光电子·激光, 2021,32(12): 1253-1261. (Wan Qin, Yan Jine, Li Zhi, et al. Panorama image stitching technology based on improved RANSAC algorithm[J]. Journal of Optoelectronics·Laser, 2021,32(12): 1253-1261.)

[16]Stergiou A, Poppe R, Kalliatakis G. Refining activation downsampling with SoftPool[C]//Proc of International Conference on Compu-ter Vision. Piscataway, NJ: IEEE Press, 2021: 10337-10346.

[17]Jaderberg M, Simonyan K, Zisserman A,et al. Spatial transformer network[C]//Proc of the 28th International Conference on Neural Information Processing Systems. Cambridge, MA: MIT Press, 2015: 968-976.

[18]Dai Qinyan, Fang Faming, Li Juncheng, et al. Edge-guided composition network for image stitching[J]. Pattern Recognition, 2021,118(9): 108019.

[19]Xie Saining, Tu Zhuowen. Holistically-nested edge detection[C]//Proc of IEEE International Conference on Computer Vision. Pisca-taway, NJ: IEEE Press, 2015: 1395-1403.

[20]He Kaiming, Zhang Xiangyu, Ren Shaoqing, et al. Deep residual learning for image recognition[C]//Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2016: 770-778.

[21]DeTone D, Malisiewicz T, Rabinovich A. Deep image homography estimation[EB/OL]. (2016)[2022-11-23]. https://arxiv.org/abs/1606. 03798.

[22]Nguyen T, Chen S W, Shivakumar S S, et al. Unsupervised deep homography: a fast and robust homography estimation model[J]. IEEE Robotics and Automation Letters, 2018,3(3): 2346-2353.

收稿日期:2022-11-23;修回日期:2023-01-18 基金項目:国家自然科学基金资助项目

作者简介:朱永(1998-),男(通信作者),安徽合肥人,硕士研究生,主要研究方向为计算机视觉图像拼接(zhuyong98@qq.com);付慧(1978-),女,北京昌平人,副教授,硕导,博士,主要研究方向为深度学习、数字图像处理及可视化;唐世华(1980-),男,河北石家庄人,高级工程师,博士,主要研究方向为系统工程;王一迪(1995-),女,吉林扶余人,硕士研究生,主要研究方向为图像识别与分类.