图神经网络在命名实体识别中的应用研究

束文豪,奚雪峰,3,崔志明,3,顾晨凯

1.苏州科技大学 电子与信息工程学院,江苏 苏州 215000

2.苏州市虚拟现实智能交互及应用技术重点实验室,江苏 苏州 215000

3.苏州智慧城市研究院,江苏 苏州 215000

命名实体识别(named entity recognition,NER)[1]是信息抽取任务之一,在自然语言处理(natural language processing,NLP)任务中得到了广泛的应用,如自动问答、机器翻译和自动文本摘要等。NER的主要目的是从非结构化文本中提取预先指定的“专有名词”,如人名、地名、机构名,和日期[2]。但随着研究的不断深入,学者们对名词类型做了更加细粒度的划分。例如,地名可以细分为国家、省、州和城市[3]等,人名可以细分为政治家、演员和其他角色[4]等。随着神经网络的快速发展以及中文NER研究的进一步开展,近几年,越来越多的学者对中文NER 进行了深入的研究。与英文NER 相比,中文NER中的实体因缺少明确的边界,以及复杂的词序构造和嵌套实体关系的定义,而更加难以识别。对于解决中文NER 中存在的实体边界问题,本文整理了行之有效的解决方法,并研究了在特定领域以及低资源领域的NER。同时,本文还分析了NER中实体消歧、实体链接和嵌套NER等相关任务的最新研究进展。

早期NER 技术通常依赖于人工构建规则和模板。例如,20 世纪90 年代初,Rau 等人[5]手动构建了大量规则和模板,并使用启发式算法成功地从财经新闻中识别出公司的企业身份。该方法远超人工提取的效率,并且评估指标超过90%。但是这种方法需要领域专家自定义规则,耗费时间和精力,不能应用于其他领域,泛化能力和可移植性较差。

随着将机器学习应用于NER 任务之后,领域专家不再需要手动构建规则和模板,而是借助于带注释的语料库来训练模型。其中,隐马尔科夫模型(hidden Markov model,HMM)和条件随机域模型(conditional random field,CRF)就是具有代表性的模型。例如,2015年,韩春燕等人[6]使用CRF 提取特征级别、句子级别和词汇级别的特征,并将它们与词典特征一起输入到另一个CRF 中,用于微博等网络社交领域的实体识别。随后,Feng 等人[7]结合了HMM 和词汇特征以及桥梁领域的专有规则来识别桥梁实体。但由于这两种方法都是基于机器学习的,需要提取特征,因此在训练过程中模型中会出现误差传播。鉴于此,学者们逐渐开始将研究重点转向深度学习。

深度学习已经成为一种直接从数据中学习特征表示的强有力的方法。与传统浅层机器学习相比,基于深度学习的实体识别可以在原始数据中自动学习特征,在一定程度上降低了对领域专家的依赖,解决了模型训练中的误差传播问题。因此,在NER中,基于深度学习方法的准确率已经超越基于传统浅层机器学习的方法。NER 任务中主要用到的深度学习方法包括各类神经网络,下文将逐一介绍。

在2011年,Collobert等人[8]首次在NER任务中应用卷积神经网络(convolutional neural network,CNN)。2019 年,Cao 等人[9]在CNN 的基础上增加了CRF,并提出了CNN-CRF 模型,用于中文电子病例的实体提取。使用该模型后,精度和速度都有所提高。由于传统的CNN模型不能解决长距离信息丢失的问题,在2021年,Kong 等人[10]提出了一种增加注意力机制的CNN 模型,该模型中不同卷积核和残差结构的CNN融合提高了从不同维度捕获长文本上下文信息的能力,以此来处理长距离信息的丢失。

循环神经网络(recurrent neural network,RNN)在NER 任务中也得到了广泛的应用。Huang 等人[11]提出将长短期记忆网络(long short term memory,LSTM)应用于NER任务,并提出了基于LSTM的多个变体模型,其中双向长短期记忆网络(bi-directional long short term memory,BiLSTM)最具代表性。利用BiLSTM 模型可以得到文本在过去和未来两个方向上的特征。在此基础上,Yang等人[12]使用BiLSTM模型从电子病例数据中提取了22 种实体类型、如疾病、症状、身体部位和其他成分,实验F1 值达到80.52%。2019 年,Ji 等人[13]在BiLSTM 模型的基础上引入了注意力机制来计算文本中关键特征的权重,提高了文本特征的提取能力。2020 年,Liu 等人[14]提出了一种新的网络结构,即结合CNN和LSTM 端到端的模型结构,CNN和CRF都被用于获得基于词的表示。

近年来,除了CNN 和RNN 之外,利用Transformer模型进行NER 也成为学者们研究的热点。Transformer主要由注意力机制实现,这不仅提高了识别精度,还缩短了训练时间。在NER 中使用Transformer 的代表有Yan 等人[15]提出的TENER 模型和Li 等人[16]提出的Transformer-CRF 模型,该模型在提取文本特征的基础上,引入CRF 对实体进行分类和识别。Shen 等人[17]在2022 年提出了BERT-BiLSTM-CRF 模型。该模型将RNN与注意力机制结合,通过神经网络提取句子特征,利用注意力机制解决长距离依赖问题,有效地提高了模型的整体识别能力。因此,注意力机制在NER 任务中的应用拓展了NER的研究方向。

随着研究发现,在编码层中,CNN和RNN都存在梯度消失、梯度爆炸和数据空间限制等问题,这严重影响了模型的准确性和扩展性。但是,研究人员发现图神经网络[18]在NER上也能取得很好的效果,并且该模型打破了神经网络的序列化处理结构,充分发挥了图的优势,实现了从欧几里德空间向非欧几里德空间的突破,能有效地解决上述问题。本文接下来将着重介绍图神经网络及其应用,最后进行本文总结和展望。

1 图神经网络的基本概念

1.1 图神经网络

图神经网络(graph neural network,GNN)是深度学习在图结构上的一个分支,除了能够学习结构化数据之外,还能学习到非结构数据,比如文本和图像信息等,并能够在提取出的图结构中进行推理。早期的GNN存在许多问题,之后衍生了诸多变体,本文将在1.2节、1.3节、1.4节中详细介绍。下面给出GNN的说明和定义。

GNN的目标是学习得到一个状态嵌入向量hv∈Rs。这个向量包含每个节点的邻居节点信息,其中,hv表示节点v的状态向量,这个向量可以用于产生输出ov,比如输出可以是节点的标签;设f是带有参数的函数,叫作局部转化函数,这个函数在所有节点中共享,并根据邻居节点的输入来更新节点状态;设g为局部输出函数,这个函数用于描述输出的产生方式。那么hv和ov按照如下式子产生:

其中,xv、xco[v]、hNv和xNv分别表示节点的特征向量、节点v边的特征向量、节点v邻居节点的状态向量和节点v邻居节点特征向量。

假设将所有的状态向量,所有的输出向量,所有的特征向量叠加起来分别使用矩阵H、O、X和XN来表示,那么可以得到更加紧凑的公式:

其中,F表示全局转化函数,G表示全局输出函数,分别是所有节点f和g的叠加形式,H是方程(3)的不动点,并且在F为收缩映射的假设下H被唯一地定义。根据Banach 的不动点定理,GNN 使用如下的传统迭代方法来计算状态参量:

其中,Ht+1表示H的第t个迭代周期的张量,方程(5)迭代的系统按指数级收敛,收敛到最终的不动点。

但早期的GNN对不动点使用迭代的方法来更新节点的隐藏状态效率并不高,并且GNN 在迭代中使用相同的参数,而其他比较著名的模型在不同的网络层采用不同的参数来进行分层特征提取,使得模型能够学习到更深的特征表达。

同时图中的一些边上可能会存在某些信息特征不能被有效地考虑进去。此外,如何学习边的隐藏状态也是一个重要问题。

1.2 图循环神经网络

图循环神经网络(graph recurrent network,GRN)是在传播步骤中使用门循环单元(GRU)[19]或LSTM[20]这样的RNN 的门机制,以减少早期GNN 模型的表达结果,并提高图中信息长期传播的有效性。

Li 等人[21]提出了在支撑步骤中使用GRU的门控图形神经网络(gated graph neural network,GGNN)算法。它对固定数目的T步骤展开RNN,并通过时间反向传播计算梯度。具体传播模型的基本递归如下公式:

节点v首先聚合来自其邻居节点的信息,其中Av是邻接矩阵A的子矩阵,表示节点v与其邻居节点的连接。类似于GRU-like的更新函数使用每个节点的邻居节点上的信息和上一个时间步骤的信息来更新节点的隐藏状态。向量a收集节点v、z和r的邻域信息,同时这三个节点也是更新和重置门,⊙是Hardamard 乘积运算。

GGNN 模型是针对图上需要输出序列的问题而设计的,而现有模型只能生成单一的输出,如节点级或图级分类。

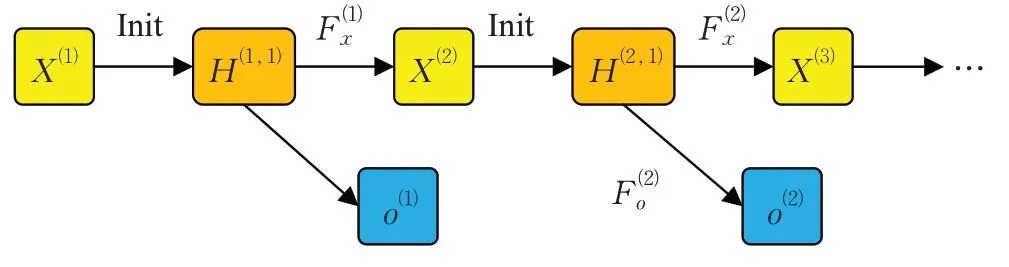

Li等人[22]进一步提出了门控图序列神经网络(gated graph sequence neural network,GGS-NN),它使用多个GGNN产生一个输出序列o(1),o(2),…,o(K)。如图1所示,对于k-th输出步骤,节点注释的矩阵表示为X(k)。该体系结构使用了两个GGNN:F(k)o预测从X(k)到o(k)的过程和F(k)x预测从X(k)到X(k+1)的过程。本文用H(k,t)来表示k-th输出步骤的t-th传播步长。

图1 门控图序列神经网络的架构Fig.1 Architecture of gated graph sequence neural network

每个步骤k的H(k,1)的值由X(k)初始化。每个步骤t的H(t,1)的值初始化为X(t)。F(k)o和F(k)x可以是不同的模型,也可以共享相同的参数。

1.3 图卷积神经网络

对于一个给定节点vi,图卷积神经网络(graph convolutional network,GCN)[23]使用卷积函数在hit-1的基础上计算hit。假定用于信息交换的上下文与GRN例子情况相同。分别采取式(11)和式(12)来为无向图和有向图计算mti和xit:

GCN和GRN之间的主要区别在于更新节点隐含状态的方式不同:GRN 采用LSTM 来更新节点状态,而GCN则使用卷积函数进行这一操作,如式(13)所示:

式(13)可以被视作一个标准卷积滤波器操作,其中,Wm、Wx和bx是模型参数。

一种GCN的变体使用不同的权重收集来自不同类型边的信息(即具有不同标签的边)。即将连接节点vi和vk的边标签表示为l(i,k),将vi和vk的边的方向表示为dir(i,k)。可以通过将式(13)替换为式(14)、(15)来定义GCN。

其中,是用于替换式(13)中Wm的|L|×2 组模型参数;L是边标签的集合。同样地,类似的方法可以用于扩展Wx和bx。

为了控制从hk传递到hi的信息量,可以在式(14)、(15)的基础上添加控制门,形成另一种GCN 的变体。具体来说,控制门gi,k t的值如式(16)所示:

使用控制门后,可以将式(14)拓展为式(17)的形式:

1.4 图注意力神经网络

图注意力神经网络(graph attention network,GAT)[24]可以被视为一种通过对邻居节点进行操作来表示每个节点的自注意力神经网络(self-attention network,SAN)[25]。具体而言,为了计算在时间步t时刻的vi节点的隐含状态hit,使用其相邻节点的先前状态的加权和,如式(18)所示:

式中的权重αik是由先前的隐含状态hit-1和htk-1计算得到的,如式(19)和式(20)所示:

其中,W是模型参数。相较于早期GNN来说,GAT采用的注意力机制能够为不同的邻居节点分配不同的权重。

2 图神经网络在命名实体识别中的应用

随着NER 技术的不断成熟,目前GNN 已应用到多个NER任务中,并取得了不错效果。GNN在NER中主要应用于实体边界检测、实体链接、实体消歧、(特定)低资源NER、关系抽取以及嵌套NER 等相关任务。本章详细介绍研究人员对上述任务做的相关工作及成果。

2.1 实体边界检测

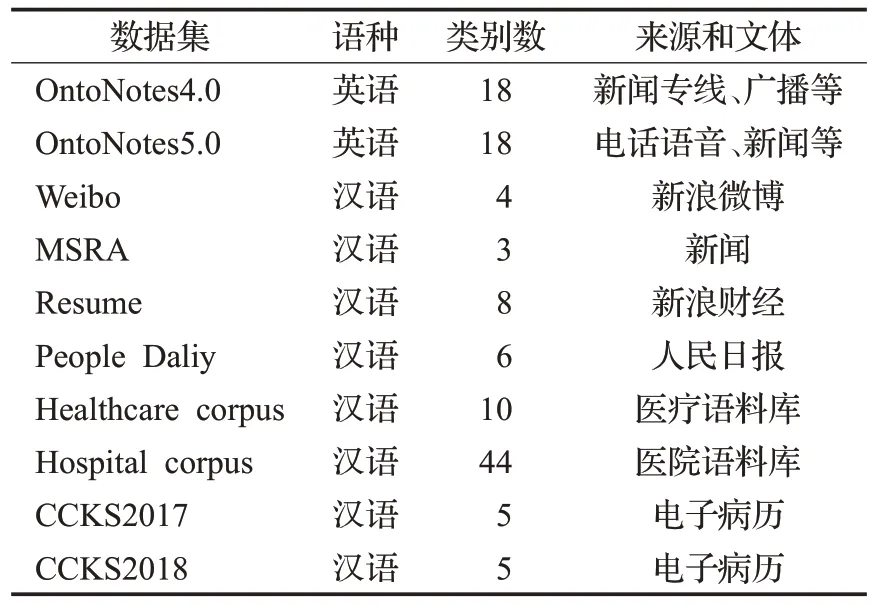

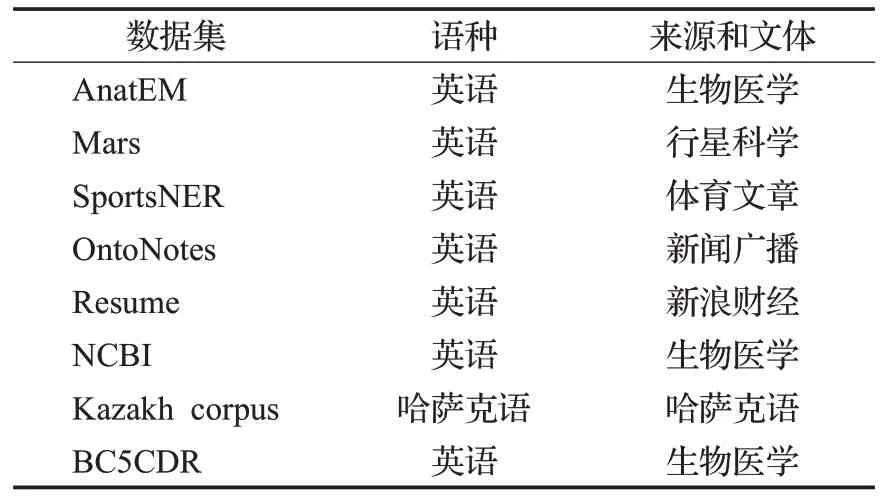

NER 的目标是检测文本中实体的边界和实体的类型,表1 展示了边界检测的相关数据集。相较于英文NER,中文命名实体识别(CNER)研究难度更大。在英文文本中,单词作为阅读的基本单位是以空格作为划分。而在中文文本中,语句由汉字紧密排列组成,并且没有明确的分界符号。汉字是中文阅读的基本单位,人在阅读过程中会主动对语句进行分词。相较于英文的词粒度嵌入向量,中文的词粒度向量需要进行分词任务,然而分词产生的错误会导致实体识别错误,甚至会改变文本语义表达。

表1 边界检测的实体数据集Table 1 Entity datasets for boundary detection

为了解决上述问题,Chen等人[26]提出了一种边界增强的方法。首先,利用Star-Transformer[27]构建了一个轻量级baseline 系统。由于Star-Transformer 具有独特的星形拓扑结构,因此在表示长距离序列方面具有更大的优势,从而使得模型的baseline 性能达到了与SOTA 相当的水平。该方法从两个角度增强了边界信息。一方面,添加了一个附加的GAT 层来捕获短语的内部依赖关系。通过这种方式,可以隐含地区分界限,同时增强短语中的语义信息;另一方面,增加了一个辅助任务来预测实体的头部和尾部。最后,利用多任务学习框架学习边界信息。

Sui 等人[28]提出了一种基于字符的协同图网络(CGN),具体来说,在图层中有三个字符交互图。第一个是C图,它是为整合自匹配词汇而设计的,模拟了字符和自匹配词汇之间的联系。第二个是T图,它建立了字符和最近的上下文匹配词之间的直接联系,有助于直接整合最近的上下文单词。第三个是L图。L图通过多跳隐含地捕获自匹配词汇和最近的上下文词汇的信息。这些图是在没有外部NLP工具的情况下构建的,可以避免错误传播的问题。此外,该模型第一次将GAT和自动构建语义图引入NER任务。

上述方法使用了词典信息和图网络来识别实体,但由于词之间的依赖关系有助于确定实体边界,利用与句法依赖关系相关的信息来提高NER性能至关重要。因此,Zhu 等人[29]提出了一种新颖的基于GGNN 的句法依赖图信息学习模型,并将学习到的信息融合到经典的BiLSTM-CRF 模型中,此外,他们还从多个中文分词(CWS)和词性标注任务(POS)中提取了各种任务特定的隐藏信息,进一步改进了NER模型。最后,利用多个自注意力组件来整合多种提取的信息用于NER。在CNER中,实体边界还存在重叠字词的情况,因此Zhong等人[30]提出一种基于GGNN的CNER模型。首先,利用BERT 生成字符的预训练编码向量,引入全局节点获取全局信息,然后构造一个GGNN 来表示相应的字符和词。通过图形结构中字符、匹配词和整个句子全局节点信息的多重交互对中文实体进行识别。

虽然通过引入多图注意力网络,使CGN 模型获得了较强的知识整合能力以及高效的处理速度。但该模型在嵌入层中没有充分利用词边界的信息,而且采用传统静态的GAT 影响了图注意力的表达能力。因此,宋旭晖等人[31]在对该模型中的GAT进行改进的基础上,提出了一种融入分词信息的CNER 方法。该方法首先在嵌入层融入词语的分词信息以生成包含词边界信息的字向量,从而更好地利用词的边界信息。其次在编码层使用BiLSTM模型初步获取文本的上下文信息,并利用改进后的GAT 对文本特征进行提取,优化传统GAT 中相关系数的计算方式以增强模型的特征提取能力。最后利用CRF进行解码从而实现对实体的标注。

在中文NER医疗领域,Lee等人[32]提出了ME-MGNN模型,该模型结合从部首、字符到单词级别的不同粒度的多个嵌入,以扩展字符表示,并将其输入到多个GGS-NN中,以识别命名实体并对其类型进行分类。

中文电子病历的NER 旨在识别和分类临床术语,目前大多数基于深度学习的方法存在许多薄弱环节,如特征提取不足、低资源实体识别不力、边界划分不准确等。针对边界划分不准确的问题,Zong等人[33]提出了一个新方法,该方法使用具有多向图结构的GGNN来捕获医学词典提供的特征。使用CNN来获取词之间的边界特征。这两个特征被连接成一个特征向量,并输入到Bi-Mogrifier-LSTM-Attention模块中。该模型将字典特征集成到深度神经网络中,以更好地处理罕见的临床命名实体。多头注意力模块强调当前信息与上下文信息在许多方面的相关性和依赖性,这削弱了医学和临床治疗无关的语义特征的权重。

因此为了以统一的方式利用多源知识,将词汇或知识图谱(knowledge graph,KG)概念与中文临床NER的边界很好地结合起来。Xiong等人[34]提出了一种新的基于关系图卷积神经网络,称为MKRGCN。多元知识增强中文临床NER模型。通过关系图卷积神经网络对外部词典单词和KG 概念进行整合,建立了词典单词或KG概念与其边界统一匹配的模型。

Sui 等人[28]提出的模型不区分字词的边界,因此可能会混淆字符和词之间的信息流。Zhao 等人[35]将边界划分为10 类,利用可训练的嵌入方法表示字与词之间的关系,通过词频计数和无监督的新词提取来整合数据集中的统计信息。提出了一个基于关系和统计水平的中文NER 多通道GAT(MCGAT)模型,该网络具有3个词修正GAT,用于整合词汇信息。该模型还可以进一步提高像BERT 这样的预训练模型作为下游网络的性能。

Wang等人[36]提出了一种多态GAT(PGAT)模型,旨在从多个维度捕捉字符与匹配词之间的动态相关性,以提高字符的表示能力。通过从词典中获取字符的匹配词,将字符映射到四个位置:B(开始)、M(中间)、E(结束)和S(单个词)。提出的基于GAT的语义融合单元可以动态地调节B、M、E 和S 这4 个维度中匹配词和字符的注意力,从而可以显式地捕获每个维度中字符和匹配词之间的细粒度相关性。实验结果表明,该方法具有良好的注意捕获和融合能力。

Zhang 等人[37]提出了一个在Cetoli 等人[38]研究的基础上,将GAT 应用于NER 的模型。使用GAT 对句子成分中意识范畴进行情感分析,并利用GAT 生成选择分析树中节点的表示。将GAT 应用于中文社交媒体的NER,充分利用句子的语法信息,并且使用自注意力机制来发现序列本身的特征,而不需要使用外部字典。该模型在输入方面也得到了改进,为了解决分词错误和OOV(out of vocabulary)问题,采用了字符向量和词向量的组合作为输入,并将词性信息融入其中。这样不仅可以利用分词信息,而且可以在一定程度上减少分词造成的误差。

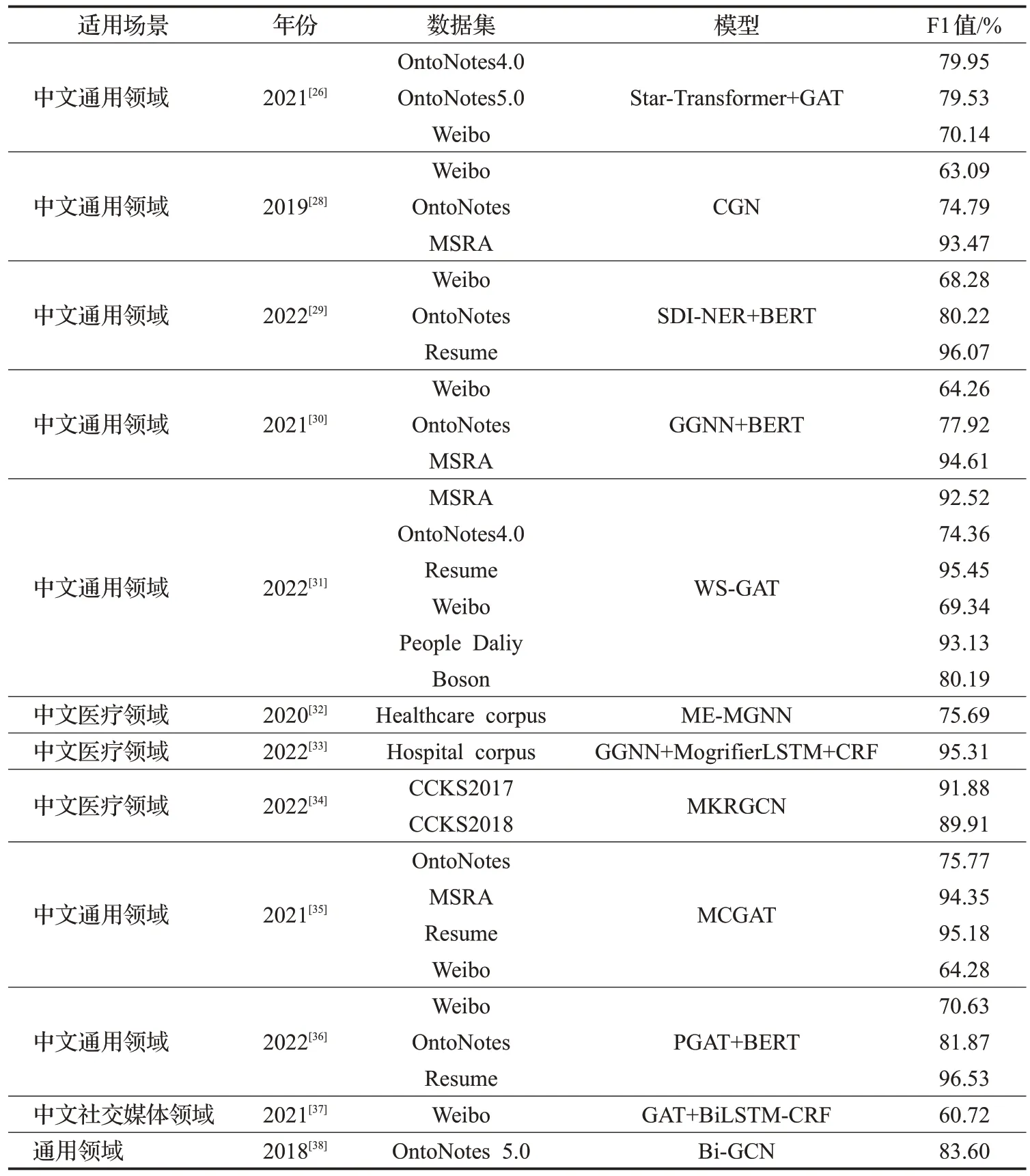

表2对比总结了实体边界检测的模型性能,据表中数据F1 的值可知,在Weibo 和OntoNotes 数据集中,加入BERT 或Transformer 与GAT 构建的模型会比单纯基于GAT的模型性能显著提升,为此在接下来关于CNER的研究中可以利用BERT+Transformer+GAT构建模型,以此获得优秀的中文边界检测的效果。

表2 实体边界检测模型性能对比Table 2 Performance comparison of entity boundary detection models

2.2 命名实体链接

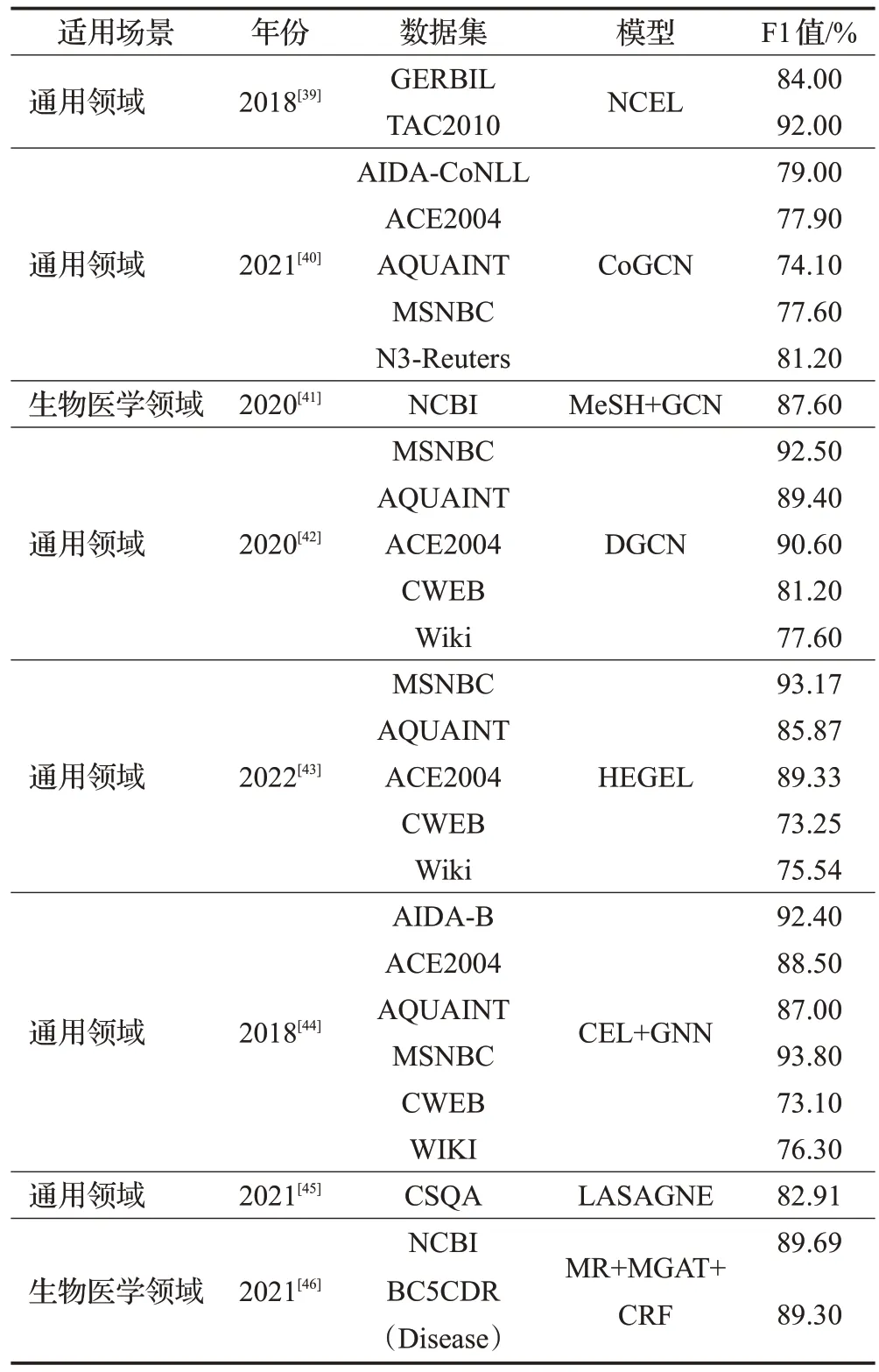

实体链接(entity link,EL)旨在将文本中的实体提及与知识库(knowledge base,KB)联系起来,神经网络模型在这方面已经取得了成功,表3展示了实体链接的相关数据集。然而,现有的方法大多依赖于局部上下文来独立地解决实体问题,由于局部信息的数据稀疏性,这种方法往往会失败。为了解决这个问题,Cao 等人[39]提出了一种新的集体实体连接神经网络模型(NCEL)。NCEL 应用GCN 集成地方上下文特征和实体连接的全局一致性信息。为了提高计算效率,Cao 等人[39]近似地对相邻实体提及的子图进行图卷积,而不是对整个文本进行图卷积。为了提高NCEL 对数据噪声的鲁棒性,该模型进一步引入了注意力机制,并在Wikipedia 超链接上对其进行训练,以避免过拟合和域偏差。在实验中,Cao 等人[39]评估了5 个公开数据集上的NCEL,以验证链接性能和泛化能力,对时间复杂度、关键模块的影响以及定性结果进行了分析,证明了模型的有效性和效率。

表3 实体链接主要数据集Table 3 Entity link primary datasets

Jia等人[40]提出了一种将共注意力机制与GCN相结合的模型,用于KG 与实体之间的联系,从上下文中自动提取提及和实体的特征。具体而言,在给出实体提及上下文及其候选实体上下文的情况下,引入共注意力机制来研究实体提及上下文与候选实体上下文之间的关系,并在考虑这种关系的基础上构建提及表征。此外,Jia 等人[40]还提出了一种基于上下文感知的实体表示GCN,该网络同时考虑了候选实体的图结构以及与实体提及上下文的关联性。

在生物医学领域中,疾病名称不仅需要确定,而且还需要标准化或与描述MeSH 等疾病的临床税收学相关联。因此,Pujary 等人[41]研究了一种疾病正常化的替代方法,通过利用MeSH 的图结构来表示疾病名称,以及使用图嵌入分类法中可用的词汇信息,结合神经NER模型和Pujary等人[41]的基于图的实体连接方法,通过多任务学习提高了在NCBⅠ语料库疾病识别效果。

通过GCN对实体相关性进行建模可以显著提高实体链接的效率。然而,现有的实体链接模型未能考虑到一组实体的结构图不仅取决于给定文件的上下文信息,还取决于模型不同聚合层的自适应变化,从而导致在捕获实体之间的结构信息方面存在不足。由此,Wu 等人[42]提出了一个动态的GCN结构,在训练过程中,研究人员对模型中的图结构进行动态计算和修改。通过动态链接节点的知识聚合,GCN 模型能够共同识别文本与KG之间的实体映射,有效地捕获整个文本中提到的各个实体之间的主题一致性。

而Chen等人[43]提出了一种新的基于异构图的全局实体连接器(HEGEL),它为每个文本建立了一个信息丰富的异构图,以收集各种链接线索。然后,HEGEL利用一种新的异构GNN 对不同类型的流形信息进行集成,并对它们之间的相互作用进行建模。

在保证提及关系和实体关系一致性的约束下,集体实体将文本中实体的提及映射连接到知识库(KB)中的相应词目。Zhang 等人[44]的目标是通过GNN 处理集体实体链接。该方法将同一文本中的提及解析为提及图,并从整个KB中提取包含其候选实体的子图。然后,在提及图和实体图上,分别用两个GAT 以迭代的方式更新节点表示和匹配得分。这样,匹配得分和节点表示可以相互不断改进,从而得到更好的映射。

对于在KG 上进行复杂会话问题回答的任务中,Kacupaj等人[45]提出了LASAGNE,该模型是第一种采用GAT 扩展的transformer 结构进行多任务神经语义分析的模型。LASAGNE 使用Transformer 模型来生成基本的逻辑表单,而GAT 则用于利用实体类型和谓词之间的相关性来生成节点表示。LASAGNE 模型还包括一个新颖的实体识别模块,可以检测、链接和排序问题上下文中的所有相关实体。

近几年,基于神经网络的生物医学实体连接得到了显著的效果。然而,现有大多数的研究没有充分利用其模型中的主题一致性。而且大多数集合模型使用基于序列的方法,这可能会传播错误。最重要的是,这些模型忽略了单个文本中提及内容之间的关系,这对于链接实体非常有用。因此,Bo等人[46]提出了一种有效的基于GAT 的模型,它可以动态捕获实体提及之间的关系,并学习连贯的表示。此外,与一般领域中的基于图的模型不同,该模型不需要大量额外的资源来学习表示。

表4 对比总结了命名实体链接的方法性能,从表中数据可以看出,在ACE2004 和AQUAⅠNT 两个数据集上,动态的GCN 模型(DGN)取得了远超其他模型的效果。

表4 实体链接模型性能对比Table 4 Performance comparison of entity link models

2.3 命名实体消歧

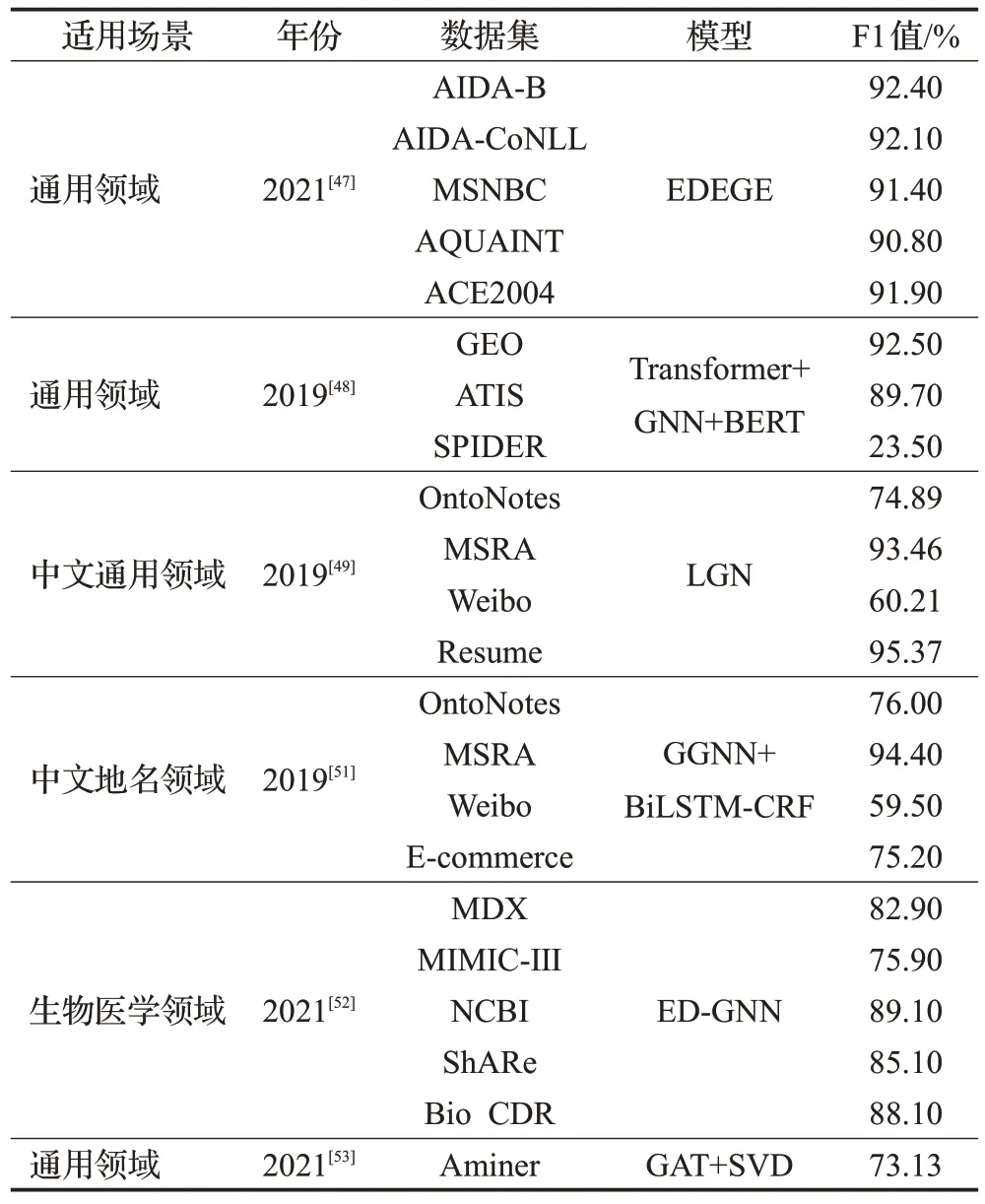

知识图谱实体消歧的目的是将模糊实体与KG 中的相应实体进行匹配,这与实体链接的目的一致,表5展示了实体消歧的相关数据集。现有的实体消歧方法通常是利用实体及其属性的上下文信息来获取实体提及嵌入向量,并与候选实体嵌入向量进行相似性比较,通过相似性进行实体匹配。这种方法的缺点是忽略了实体所在KG 的结构特征,即实体与实体之间的联系,因此无法获得实体的全局语义特征。为了改善实体消歧问题的准确率和召回率,Ma 等人[47]提出了基于实体和图嵌入的实体消歧模型(EDEGE),它利用了实体关系的语义嵌入向量和子图结构特征的嵌入向量。EDEGE 首先训练实体关系的语义向量,然后训练实体所在子图的图结构向量,并通过实体相似度函数平衡这两个向量的权重。最后,将平衡向量输入到GNN中,输出实体之间的匹配,实现实体的消歧。

表5 实体消歧主要数据集Table 5 Entity disambiguation primary datasets

Shaw等人[48]提出了一种基于扩展Transformer自注意力机制的GNN 体系结构,以利用输入元素之间的关系。Shaw等人[48]展示了这种GNN架构在语义解析中的应用,以给定自然语言语句和潜在相关实体的图形表示为条件。该方法能够与自然语言语句一起处理模糊和潜在冲突的实体候选者,从而在解析之前完全消除一组相关实体的歧义。这个模拟图还使我们能够在可用的情况下合并关于实体之间关系的知识。结合解码时的复制机制,该模型还提供了一种概念上简单的方法,用于生成带有接地实体的逻辑表单。

Gui等人[49]介绍了一种基于词典的图形神经网络模型(LGN),它实现了中文NER 作为一个节点的分类任务。该模型打破了神经网络的序列化处理结构,通过细致的连接,可以获得更好的字词交互效果。词典知识通过连接相关字符来捕捉局部成分。同时,设计了一个全局中继节点来捕获远程依赖和高级特征。LGN遵循邻域聚合方案,其中节点表示通过递归聚合其传入边和全局中继节点来计算。由于聚合的多次迭代,该模型可以利用全局上下文信息反复比较歧义词,以便更好地进行预测。

地名词典被证明是NER的有用资源[50],现有将地名录纳入基于机器学习的NER系统的许多方法依赖于手动定义的选择策略或手工制作的模板,这并不能得到最佳效果,尤其是在涉及多个地名录时。对于中文NER的任务尤其如此,其中单词没有自然标记,会导致歧义。为了自动学习将多个地名词典整合到NER 中,Ding等人[51]提出了一种基于GGNN的新方法,该方法具有多图结构,可捕获地名词典提供的信息。对各种数据集的实验表明,该模型能够有效地结合丰富的地名词典信息进行NER,同时解决实体歧义问题。

由于医学知识库中的实体和源文本片段之间的词语差异,现有的医疗实体消歧方法是不够的。因此,Vretinaris等人[52]介绍了基于3种典型GNN(GraphSAGE、R-GCN 和MAGNN)的ED-GNN 在医学实体消歧中的应用。该方法开发了两种优化技术来微调和改进EDGNN。首先,引入一种新的策略,将文本片段中提到的实体表示为查询图。然后,设计了一种有效的负采样策略来识别硬负样本,以提高模型的消歧能力。

随着出版物规模的迅速扩大,名称歧义问题受到了越来越多的挑战。现有的工作主要集中在利用内容信息来区分不同的名称实体。Zhang等人[53]利用联合内容信息和关系信息来消除同一实体名称的歧义。首先,基于合作者、机构和场所等出版物的元信息构建异构学术网络。然后,将网络转换成单独的齐次图。在此基础上,提出了通过优化嵌入向量来联合学习内容和关系信息的GAT。最后,提出了一种聚类算法来收集最有可能代表同一个人的作者姓名。

表6 对比总结了命名实体消歧的方法性能。表中数据可以看出,在通用领域里该任务处理的效果很好,但是在中文的特定领域中,比如在微博地名领域中消除歧义的效果就不是很出色。

表6 实体消歧模型性能对比Table 6 Performance comparison of disambiguation models

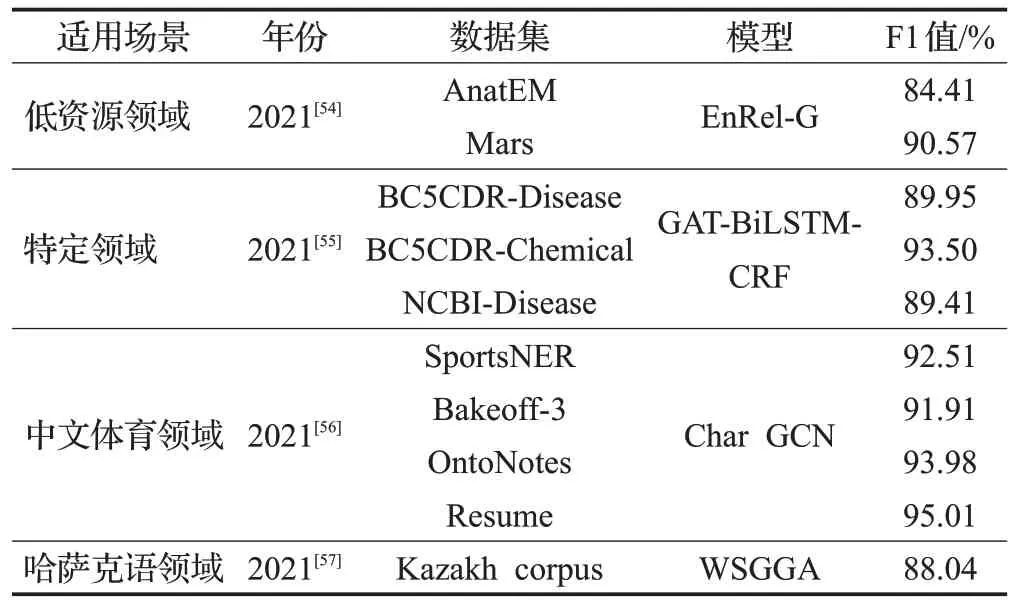

2.4 低资源领域命名实体识别

NER在一般领域得到了很好的研究,现有的系统在识别常见实体类型方面已经取得了人类水平的性能。然而,对于特定领域来说,NER性能仍然是适中的,这些领域往往具有复杂的上下文和行话实体类型,表7给出了与其相关的部分数据集。为了应对这些挑战,Chen等人[54]提出了基于全局共参照关系和局部依赖关系的明确连接实体提及,以构建更好的实体表示。在实验中,该模型利用GAT结合了实体提及关系,结果表明该方法在不同领域的两个数据集上显著地提高了NER性能。进一步实验表明,提出的轻量级系统可以有效地提高NER 性能到一个更高的水平,即使只有少量领域特定的标记数据可用。

表7 低资源NER的主要数据集Table 7 Primary datasets for low resource NER

缺乏人工注释一直是低资源领域中NER的主要障碍之一。为了解决这个问题,学者们已经做了很多工作,根据特定领域的词典自动生成银色注释。然而,领域词典的信息是有限的,并且生成的注释可能是嘈杂的,这对学习有效的模型提出了重大挑战。因此,Luo等人[55]通过引入词典引导的GAT 模型来解决这些问题。首先,利用领域特定词典,通过图匹配算法提取领域实体的候选词,从而捕获领域实体的词汇模式。此外,利用词提及交互图将实体的语义和边界信息集成到它们的上下文中。

传统的NER 对于结构简单的传统数据集是有效的,但是对于体育领域的文本来说就不那么有效了。对此,Seti 等人[56]提出了一种应用于中文体育领域的CNER 模型,该模型基于字符级图卷积神经网络(Char GCN)和自注意力机制。该方法将体育文本中的每个汉字视为一个节点。节点之间的边缘使用相似的字符位置和体育文本中命名实体的字符特征来构造。该实体的内部结构信息是使用字符映射CNN提取的。自注意力机制捕捉体育文本的等级语义信息,以加强命名实体之间的关系,并捕捉字符之间的相关性和依赖性。CRF分类函数能够准确识别中文体育文本中的命名实体。

对于在特殊语种领域的NER 任务,Haisa 等人[57]通过引入一种混合神经网络模型,利用具有多维特征和注意力机制的词语语义对哈萨克语命名实体进行识别。该任务有两个挑战:第一,哈萨克语是一种具有粘性和形态学丰富性的语言,由于数据稀少,对NER提出了挑战;第二,是哈萨克语命名实体边界不清、一词多义、嵌套现象严重。处理文本数据稀疏的一个常用策略是应用字词分割。因此,该方法从哈萨克语词法分析系统出发,将词和词干的语义结合起来。此外,该模型构造了一个实体的图结构,以词、实体和实体类别作为节点,以包含关系作为边,并使用带注意力机制的GGNN更新节点。最后,通过CRF,提取最终的结果。表8 总结了低资源领域命名实体识别的模型性能对比,由此可以看出,在小语种和特定领域的NER资源匮乏,但模型取得的效果显著,尤其是字符GCN(Char GCN)模型。

表8 低资源命名实体识别模型性能对比Table 8 Performance comparison of low resource named entity recognition models

2.5 实体关系抽取

联合NER 和关系提取是NLP 中的一项重要任务,其目的是以端到端的方式识别实体并提取相应的关系,表9 展示了关系抽取任务的相关数据集。Hong 等人[58]将联合提取分为两个子任务,首先检测实体跨度和同时识别实体关系类型。为了考虑实体和关系之间的完整交互,Hong 等人[58]提出了一种新的关系感知注意力机制来获得两个实体跨度之间的关系表示。因此,基于所有提取的实体跨度构造一个完整的图,其中节点是实体跨度,边是关系表示。

表9 关系抽取相关实体数据集Table 9 Relationship extraction of relevant entity datasets

此外,该方法改进了原始GCN,以便在编码节点特征时同时利用相邻节点特征和边缘信息。目前,与NER任务相比,关系抽取任务对复杂文本的识别效果较差。为了解决这一问题,Lai 等人[59]提出了一种新的联合模型,即通过改进的GAT(ERⅠGAT)提取实体和关系,增强了关系提取任务的能力。该模型引入了GAT,通过构造对称关系来提取图嵌入后的实体和关系。为了解决GCN过于平滑的问题,受到矩阵分解的启发,Lai等人[59]通过设计一种新的多头注意力机制和共享注意力参数来改进GAT。

Fu等人[60]提出了一种基于GCN的端到端关系抽取模型(GraphRel),该模型利用GCN 联合学习命名实体和关系。与以往的Baseline模型相比,该方法考虑了命名实体和关系之间的相互作用,通过关系加权的GCN,以更好地提取关系。该方法利用线性结构和依赖结构提取文本的连续特征和区域特征,进一步利用完全词图提取文本中所有词对之间的隐含特征。

使用行政文件交流和业务信息记录需要能够以稳健有效的方式自动从此类文件中提取和理解内容。此外,这些报告的半结构化性质特别适合使用基于图形的表示,这些表示足够灵活,可以适应来自不同文档模板的变体。此外,GNN 提供了适当的方法来学习这些文档中数据元素之间的关系。在这项工作中,Carbonell等人[61]研究了利用GNN解决半结构化文本中的实体识别和关系抽取问题。

从电子病历中挖掘大规模医学实体和实体关系,对于构建医学KG、医学智能辅助诊断等应用具有重要意义。现有的方法大多将医学实体识别和实体关系分类作为独立的子任务,采用流水线模型来解决这两个子任务之间存在的错误传播和不能实现子任务之间交互的问题。Pang等人[62]提出了一种利用GCN进行中文医学实体及其关系提取的联合模型。

Kambar 等人[63]对生物医学文本关系提取(RⅠFRE)的GNN模型(Bio-RⅠFRE)进行了改进,提出了一种从生物医学文本中联合提取化学基因命名实体及其相互作用的RⅠFRE模型。该模型利用异构图GNN模型强化生物医学文本的表示和关系抽取。结果表明,Bio-RⅠFRE在CHEMPROT 数据集上比其他联合实体关系提取模型的F1 得分提高了3%。此外,在实体重叠情况下,当句子中的关系数增加时,该模型具有较强的鲁棒性,能够获得较好的F1值。

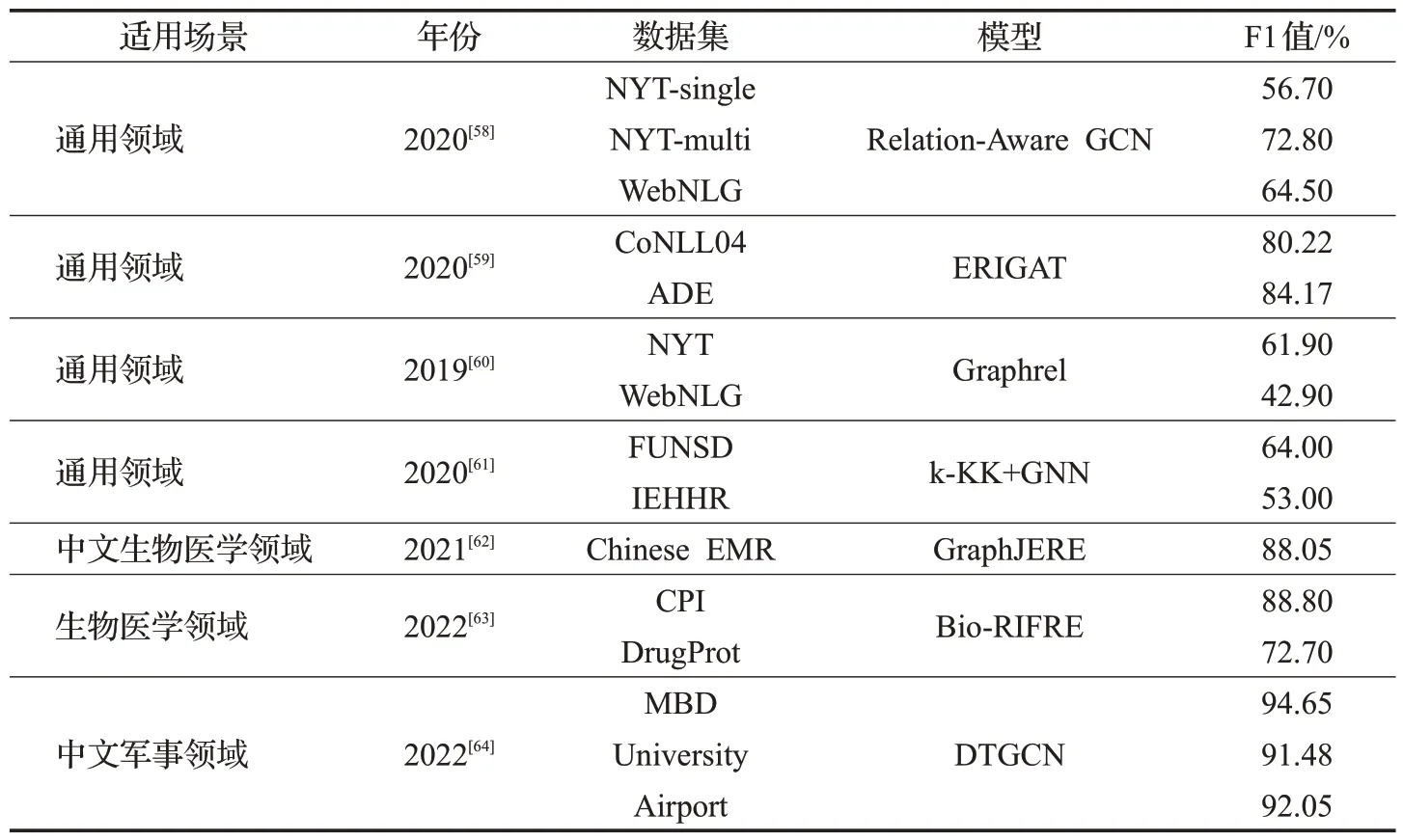

军事实体与描述性实体之间关系的提取是军事KG自动化构建的关键任务。这类文本非结构化存在诸如实体长度不固定、实体之间的间隔可能过长,以及代词过多等问题。传统的单一神经网络模型缺乏提取长区间实体关系信息的能力,无法很好地解决上述问题。为了解决这些问题,Li等人[64]提出了一种新的命名实体关系提取模型DTGCN,结合了依赖树和GCN。由表10中的数据可知,GCN 对实体关系抽取任务的作用很突出。未来的研究可以多进行些利用GCN处理实体关系抽取工作。

表10 实体关系模型性能对比Table 10 Performance comparison of entity-relationship models

2.6 嵌套命名实体识别

嵌套NER旨在识别复杂层次句子中命名实体的边界和类别。针对嵌套NER问题,Luo等人[65]提出了一种新的二部平面图网络(BiFlaG),该模型包含两个子图模块:最外层实体的flat-NER模块和内层所有实体的图模块。采用BiLSTM和GCN联合学习平面实体及其内部依赖关系。以往的模型只考虑信息从最内层到外层(或从外到内)的单向传递,但是,该模型却有效地捕获了信息之间的双向交互。该方法首先是利用平面NER模块所识别的实体构造一个实体图,并将实体图提供给下一个实体图模块。从图模块中学到的更丰富的表示包含了内部实体的依赖性,可以用来改进最外层实体的预测。

KG中的嵌套NER旨在获取所有有意义的实体,包括长文本区域中句子的嵌套实体。对此,Zhou等人[66]提出了一个POS 感知的嵌套NER 模型(PANNER),以解决上述问题。具体来说,该方法首先通过引入词性信息来构造一个异构图;其次,设计了一个基于语法路径的扩张随机游走(DRW)算法,为每个节点抽取固定大小的邻居节点;然后,通过注意力机制聚合来自不同类型邻居节点的信息;最后,使用双向译码模块对所有基于节点分层嵌入的平面实体和嵌套实体进行识别和分类。

有些嵌套NER 是使用基于字符级、词级或词典级的模型完成的。然而,这些研究忽视了补充注释的作用。Sui 等人[67]提出了一种基于触发器的GNN 模型(Trigger-GNN)来处理嵌套NER。它通过实体触发编码和语义匹配获得补充的注释嵌入,并利用一种高效的图信息传递体系结构——聚合-更新模式来处理嵌套实体。Sui等人[67]假设使用实体触发器作为外部标注可以在整个句子上添加互补的监督信号。它有助于模型更有效地学习和推广,并具有成本效益。

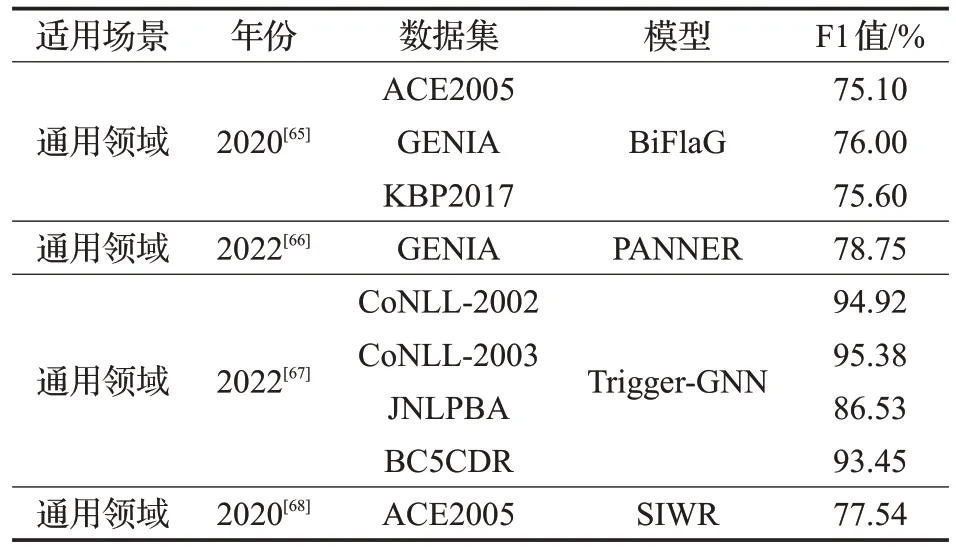

Tran等人[68]引入了一种句法信息词表示法(SⅠWR),它可以在不改变其结构的情况下将句法信息整合到神经模型中。该模型由依赖树上的两层GCN层以及自身和顺序信息组成。GCN用于将句法信息包含到基本单词表示中,SⅠWR联合预测POS和句法依赖。由表11中可以看出,在ACE2005 和GENⅠA 数据集中PANNER 模型的性能显著,但是该模型在精度上没有得到最好的结果,这是值得思考和解决的问题。

表11 嵌套命名实体识别模型性能对比Table 11 Performance comparison of nested named entity recognition models

2.7 其他任务

在2.1节实体边界检测任务中提到过,Cetoli等人[38]利用一组GCN研究了依赖树在命名实体识别器中的作用。通过对不同的NER 结构进行比较,他们发现句子的语法对结果有积极的影响。在OntoNotes5.0 数据集上进行的实验表明,其性能得到了改进,而不需要大量的特征工程或者额外的语言特定知识。

Jin 等人[69]讨论了从KB 中推断实体细粒度类型的问题。他们将该问题转化为基于图的半监督分类任务,提出了分层多图卷积神经网络(HMGCN)。该方法构造了三种连通矩阵来捕获实体之间不同类型的语义关联,并提出了一种递归正则化方法来建模给定类型层次结构中类型之间的sub-class-of关系。

由于直接叠加GCN和LSTM在建立依赖树和上下文信息之间的交互模型方面存在困难。Xu等人[70]提出了synergiized-LSTM(Syn-LSTM)模型,这是一种新的RNN 体系结构,它使用额外的图编码表示更新内存和隐藏状态,每个单词的图编码表示可以通过GCN 获得。Syn-LSTM允许cell接收来自图编码表示的结构化信息,并利用门控机制,使该模型能够分别对从词表示和图编码表示中检索到的信息量进行独立的评估。这种机制能够更好地收集上下文信息和结构化信息。

如何在复杂句子中使用远距离词语交流和保证命名实体的完整性仍然是一个未解决的问题,因此Sun等人[71]提出利用语法和语义依赖特征进行NER。该模型基于BiLSTM-CRF 和GCN,通过处理语法和语义依赖来获得句子中单词的远距离交流。

Zaratiana 等人[72]提出了GNNer 框架(GCN 和GAT)模型,该框架使用GNN 来丰富跨度表示,以减少NER预测过程中重叠跨度的数量。与Baseline方法相比,该方法减少了重叠跨度的数量,同时保证了较强的性能。

3 结束语

综上所述,本文总结了众多利用GNN 进行NER 任务的研究,从各个角度分析了NER 任务的解决策略。就现阶段本文提到研究工作中取得的成果和存在的问题而言,未来重要的研究可能还有如下多个方向。

(1)低资源特定领域的NER:由于在低资源和特定领域对NER 的研究颇少,所以该方向是一个值得研究的方向。但该领域的数据极不规范且复杂,如交通、军事、体育和一些小众语种等领域,在提取命名实体时经常识别不出名词实体,因此需要结合特定领域专业知识来提高NER的性能,同时可以利用GNN 进一步提高实体识别的准确性。

(2)多模态融合NER:随着深度学习在语音、文本和图像上单模态的深度研究,逐渐地将多个领域信息联合起来形成新的网络,称为多模态融合技术。同样地,通过将文本信息和视觉信息联合进行多模态NER,可以依赖上下文语境和实体关联图像并利用GNN 关联图像,消除多义词表达时的歧义,能够更有效地提取文本中的命名实体。额外的图像信息可以引导更多的文本内容,指正歧义实体。因此,将GNN结合多模态融合成新的网络模型进行NER研究也可以是未来的一个探索方向。

(3)NER与交叉应用领域:将NER应用在更多的学科领域,例如智能家具、智慧城市、智能交通等建筑领域是一个值得探索的研究方向。通过GNN 进行NER 是众多NLP任务的上游任务,为此,可以利用NER的结果以及结合KG进行更深层的研究,文献[40]和文献[49]的实验证实该方法的可行性,未来可以利用此方法在城市交通的安全风险识别分析上进行研究与突破,这也是今后的研究方向,希望能够利用该方法实现在更多领域的扩展。