融合深层语义与空间精确度的低照度图像增强方法*

杨 微 陈孝如 张志威 陈立军

(1.广州软件学院软件工程系 广州 510990)(2.华南理工大学计算机科学与工程学院 广州 510641)

1 引言

在暗夜、室内、背光及恶劣天气等不理想光照环境采集的图像存在亮度低、噪声伪影、细节丢失、颜色失真等退化问题,不利于人类视觉感知,也会对计算机视觉高层任务产生效能退化的影响。低照度图增强可表示为Ih=fE(Il),Il代表采集的低照度图像,fE为图像增强,Ih表示图像增强结果,是基于软件方法提高不理想光照条件环境的成像质量,恢复图像隐含信息内容的表达,使图像更加符合人类视觉感官或计算机视觉高层任务需求。由于现实光照的不确定性及存在的噪声干扰Ih不唯一,fE为NP 问题,属于计算机视觉中重要且具有挑战的问题。

对此,早期研究者提出不同的增强方法[1~5],但基于深度学习的方法是低照度图像增强主流方法。文献[6]最早将深度学习用于低照度图像增强去噪任务中;文献[7]受传统Retinex 理论的多尺度加权高斯环绕处理启发,基于带残差结构CNN 网络设计等价的“高斯差分”结构“MSR-net”,完成低照度图像增强;文献[8]设计全局照明感知和细节恢复网络GLADNet,在大分辨率尺寸下完成低照度图像细节重建;文献[9]设计LightenNet 基于CNN网络学习获得低照度图像光照图并通过gamma 矫正,后基于Retinex 理论获得反射图作为增强结果;RetinexNet[10]结合Retinex 理论和深度卷积神经网络,构建三阶段增强网络进行端到端训练完成低照度图像增强;文献[11~12]结合Retinex 理论及深度CNN,采用分解网络、恢复增强网络分阶段由粗到细地完成低照度增强;EnlightenGAN[13]基于GAN网络设计带注意力引导的U-Net 网络作为生成器及双判别器结构对全局及局部信息进行引导,在没有低/正常光图像对的情况下无监督完成低照度图像增强;KinD++[14]基于CNN 网络设计了侧重于光照图像的交互调整和反射图像细节增强的网络结构来重建图像;Zero-DCE++[15]构建了无监督的训练网络估计输入图像的亮度曲线,采用迭代递进的方式进行低照度图像增强,克服了配对数据的依赖;MBLLEN[16]基于CNN设计由多尺度特征提取模块、编码解码结构的增强模块、图像融合模块构建的低照度增强网络完成图像增强;文献[17~19]针对单幅低照度图像增强效果不佳,采用相同场景的多帧图像进行图像增强,渐进式完成图像增强任务。

分析发现,由于低照度图像增强为位置敏感的视觉任务,基于深度学习低照度图像增强主流为基于CNN的U型架构,如编码-解码结构[6,20~22]、U-Net[23]结构及其融合残差连接的变体结构。U 型网络结构高分辨率到低分辨率的下采样阶段能获得上下文语义聚合的特征表示,低分辨率到高分辨率的上采样恢复阶段能获得空间位置精确的特征表示,但下采样和上采样阶段会导致用于图像重建的特征丢失了空间纹理细节的精确度,影响低照度图像恢复的准确性,出现模糊、对比度细节不足问题。对此,研究者提出U 型多尺度结构、高分辨率单尺度结构及二者混合结构获取并融合丰富的上下文语义信息特征表示和较准确的空间信息特征表示[24~25]。受此启发,论文设计“融合全局深层上下文语义及空间精确度特征的低照度图像增强网络”,简称CCSNet,论文主要贡献包括:

1)论文基于上下文深层语义信息编码结构及U 型结构设计了融合深层上下文语义及空间准确度特征的一种端到端的低光照图像增强网络CCSNet,不同深度的双编码结构并行,分别获得丰富的全局上下文深层语义特征及空间纹理细节信息保留的特征;2)引入多层次特征融合机制完成U型网络不同阶段、深层上下文语义特征和较准确的空间准确度特征进行融合,得到聚合丰富语义信息及空间准确度的特征表达,提高低照度图像恢复的准确性;3)引入注意力机制对不同语义尺度信息特征的聚合和筛选,提升网络特征提取选择和表达的能力;4)针对设计的网络结构及解决的问题设计了有效的损失函数。

2 相关研究

2.1 基于端到端深度CNN网络低照度图像增强

低照度图像增强任务中获取并全面利用保留图像空间细节的特征信息及深层压缩的图像全局上下文语义信息非常关键,文献[16]设计包含特征提取模块及多个同构并行U 型增强子网的多分支增强网络MBLLEN来获取不同层次丰富特征;文献[26]设计一种结构纹理感知网络STANet,基于全分辨率网络分支和带残差U 型编码解码结构分别提取纹理特征和全局局部特征,融合全局局部及纹理特性特征进行图像增强;文献[27~30]设计由全分辨率卷积网络分支、U 型编码解码网络分支、注意力机制及信息交换融合模块构成的网络结构,获得不同尺度语义信息特征后进行融合,完成进行图像恢复任务;文献[31]设计一个低照度增强的混合网络结构,在编码解码结构中增加学习边缘特征分支,并对内容特征进行融合获得增强的结果;文献[32]改良计算机视觉Transformer 结构提出一种编码器-解码器U 型转换器Restormer,用于在高分辨率图像上进行多尺度局部-全局表示学习,并精心设计多头转移注意力(MDTA)模块聚合局部和非局部像素交互;文献[33]设计一个保持分辨率不变及多分辨率融合的高分辨率表征网络HRNet,避免丢失高分辨率空间准确性表征。受文献[15,27~34]启发,论文设计了一种融合深层上下文语义及空间准确度特征的端到端低光照图像增强网络CCSNet,不同于现有的工作,网络由两个不同深度双编码结构及一个单解码结构组成,不同深度双编码结构并行编码分别建模深层压缩上下文语义特征及较精确的空间信息特征,并进行特征融合用于单解码结构完成低照度图像重建,缓解低照度图像增强网络高分辨率到低分辨率再恢复高分辨率过程中全局深层上下文语义压缩和空间精确度特征保留间的矛盾。

2.2 信息特征融合

特征融合包括基于残差跳跃连接结构实现信息融合[23,26,32]、融合不同输入源的图像信息[16~19]、融合增强网络不同分辨率尺度的特征信息[27~30,32~33,36]、融合增强网络不同阶段的特征信息[15,35]、融合增强网络不同分支提取的特征信息[26,31]等,能够弥补低照度图像增强任务中单一特征语义的欠缺、丰富特征语义层次、缓解有效信息在学习过程的退化,帮助获得更准确的像素到像素恢复质量。论文采用跳跃连接将基础U 型编码结构中的不同分辨率的信息融合到对应分辨率的解码结构中,补充减少空间精确信息丢失;采用特征通道拼接及特征融合对不同深度双编码结构的信息进行融合,融合全局深层上下文丰富的语义信息特征和保留较高分辨率的的空间精确度特征,提高低分辨率到高分辨率图像恢复的准确性。

2.3 注意力机制

计算机视觉中注意力机制被证明能够学习发现图像中有用的信息并关注,而抑制无用的信息[37],文献[38~40]提出通道注意力机制对生成特征通道mask,实现对重要的通道特征赋予更大的权重;文献[41]设计空间注意力机制生成位置空间mask,实现对空间重要的像素位置赋予更大的权重;文献[41~43]融合通道及空间注意力形成空间通道双重注意力机制,同时编码通道及空间的重要性;文献[44]通过编解码网络获得全局光照预测,在低照度图像增强工作中形成图像全局光照注意力机制。文献[45~46]通过Transformer注意力机制建立图像特征全局、长程依赖关系,取得非常优秀的任务性能。CCSNet 同样引入注意力机制关注重要特征信息,提升网络学习效率及能力。

3 论文网络模型

3.1 网络结构

如图2,CCSNet 整体架构由基础U 型编码模块EMu、U 型解码模块DMu、深层上下文语义编码模块EMc、跨尺度特征融合模块FFM、注意力机制模块AM 构成。其中EMu和EMc构成不同深度双编码结构,并行对输入低照度图像提取不同层次语义信息SF、CF,见式(1)、式(2)所示,SF为保留较精确空间信息的特征,CF为压缩的全局深层上下文语义特征,完整图像增强过程见式(3)。

1)特征提取结构。如图1 中上半部分基础U-Net 结构,EMu为了保留更多高分辨率空间信息,降低了网络深度,首先输入低照度图像由2*(3*3)空洞卷积提取32 通道的输入特征,保证更大感受野的同时不损失空间信息;接着经过Maxpooling 下采样操作得到原始输入图像1/2 分辨率的特征图;在输入图像的1/2分辨率空间层,特征图经过2*(3*3Conv+BN+Relu)常规卷积进行特征转换后通道翻倍并Maxpooling 下采样操作得到原始输入图像1/4分辨率的特征图;在输入图像1/4分辨率空间层特征图经过和1/2分辨率层相同的操作得到1/8 空间分辨率的空间特征SF。习建模低照度输入图像深层压缩聚合的上下文语义信息,为了缓解由于网络深度加深发生的梯度分散和网络退化问题,采用预训练的分类网络Resnet101[47]为骨干网络构建。如图1 下半部分,EMc分别获取Resnet101 网络Stage3 及Stage4 两个不同尺度的语义信息输出,分别通过通道注意力AM[38]进行特征选择;Resnet101 网络输出层对Stage4 施加通道注意力的输出结果再执行乘运算的特征再选择;后两不同尺度语义信息再分别执行线性插值上采样到SF相同的分辨率,在通道层拼接后得到聚合了低照度图像丰富的深层上下文语义信息的特征CF。AM 结构参考文献[38],对重要的特征通道更大的权重,优化特征的选择能力,帮助建模输入图像的长程依赖、全局关联的深层上下文语义特征。(SF,CF)在特征通道层Concatenate 后得到空间精确度特征及丰富深层上下文语义特征的拼接特征。

图1 MEF测试集采样低光照图像增强视觉效果示例(颜色框表示局部放大对比区域)

图2 CCSNet网络结构图

2)信息融合结构。为了减少基础U 型网络下采样过程中存在的信息遗忘及网络空间精确度信息丢失,CCSNet 增加残差跳跃连接,建立基础U 型网络编码过程和解码过程相同分辨率之间信息的传递的连接;为了有效利用提取丰富特征语义信息,对不同深度双编码结构EMu、EMc获得的深层上下文语义信息特征表示CF和较准确的空间信息特征SF进行通道层拼接融合。如图3 所示,(SF,CF)特征在通道层拼接后进行融合,首先经过“3*3Conv+BN+Relu”操作,后基于通道注意力机制对通道选择后再进行残差加操作,得到融合丰富的语义信息特征表示和较准确的空间信息特征表示,输出特征经过U 型解码模块DMu完成低照度图像重建。FFM 模块能够平衡语义压缩和空间位置信息丢失的矛盾,能够得到丰富的图像恢复的特征表示。

图3 FFM网络结构图

3.2 网络损失函数

论文针对提出的CCSNet端到端低照度增强网络结构及低照度图像增强的目标,提出由主要损失函数和辅助损失构建的复合损失函数,从不同层面约束引导网络得到综合较优的增强结果。其中,主要损失函数为图像重建损失引导图像进行重建;辅助损失包括对比度损失、感知损失、颜色损失,提升低照度图像的对比度、颜色等综合质量。具体如下:

1)图像重建损失约束。用于评估增强图像Ih和真实参照图像IN之间内容的差别,表示为Lrec。考虑到Charbonnier[48]具有更好的鲁棒性及SSIM[49]损失具有对局部结构变化的感知敏感,Lrec由Charbonnier损失LChar和SSIM 损失Lssim构成,见式(4),α及β为平衡系数,分别设置为1和0.1。

2)感知损失。为使增强图像Ih更具有真实性,引入感知损失Lper[50],见式(5),Ih为网络增强结果,IN为参考图像,Φj表示VGG16网络第j次卷积得到的特征映射,Cj、Wj和Hj表示特征图通道、宽度及高度。

3)图像对比度损失约束。为了约束增强图像Ih和真实参照图像IN之间具有一致的对比度,引入对比度损失Lspa[15],见式(6),K表示图像划分区域的数量,Ω( )i表示以像素点为中心的区域,设置为4。

4)颜色一致性损失约束。为使增强图像Ih和真实参照图像IN应该具有较好颜色一致性,引入颜色一致性损失约束Lc,由监督颜色损失函数Lc1[51]及无监督颜色损失函数Lc2[15]。见式(7)及式(8),其中G表示高斯模糊操作,Jp、Jq分别表示增强图像Ih的p和q通道的平均强度值,p和q表示图像的通道。

5)总损函数。如下式所示,依据实验论文设置λ1=0.1,λ2=0.1,λ3=0.1。

4 实验结果及分析

为了验证论文提出方法的有效性,从MEF、low、DICM、Fusion、NPE 等公共测试数据集和LOL数据集[10]中选择了不同光照退化质量的测试图像,与有监督[6,16,52]、无监督算法[15]、基于物理模型算法[9,10,14]、基于GAN 算法[13]等主流增强算法进行定性及定量分析实验对比,证明了论文提出方法的有效性,获得有较对比算法更强泛化能力且亮度提升自然、噪声伪影不明显、颜色丰富真实的增强结果。

4.1 实验环境及数据集

论文在搭载GeForce GTX 1660Ti 6G GPU、Intel(R)Core(TM)i7-9750H CPU、Windows11 操作系统的PC 机上,基于PyTorch 框架构建CCSNet 网络。网络使用的训练数据集为BrighteningTrain[53],该数据集包含1000 张低照度和正常曝光数据对,图片为384*384*3,其中985数据对用于训练,15对用于评估,训练中图像随机切片的patch size 为256*256*3,输入图像被归一化到[0,1]区间。网络训练优化器使用Adam 优化器,学习率设置为lr=le-5,β1=0.9,β1=0.999,ε=10-8,当训练任务完成2/3 时,学习率衰减10%,网络共训练1400个epoch。

4.2 实验结果定性分析

如图1,CCSNet 增强结果全局亮度提升较好、颜色自然主观感知较好,细节恢复、对比度提升及噪声预制水平较好,见蓝色放大区域的树木建筑层次及红色放大区域的凉亭的岩石和屋檐区域。观察图中蓝色框及红色框放大区域:文献[6]细节模糊,颜色失真;文献[10]放大区域噪声伪影严重;文献[13~16]亮度提升不足且在不同程度的颜色失真、模糊、噪声。

如图4,第一列为存在不同程度的曝光不足、噪声、对比度低、细节被覆盖、颜色失真等退化问题的测试图像;中间列为对比算法增强结果;最后一列为论文方法CCSNet 增强结果。首先整体观察,CCSNet 网络在各不同低光照场景中增强质量更稳定,能够适应不同低光照条件,具有更好的泛化性能。其次自上向下依次横向分析对比,图4(a)为CCSNet 增强结果能自适应增强图像全局亮度,重建极暗中书柜区域的部分轮廓(文献[6,15,14]黑色框增强几乎失效,文献[10]重建书柜区域轮廓较丰富但出现伪影),恢复窗外房屋、围墙、树木、草地的颜色层次(对比算法均存在不同程度的颜色失真,特别文献[14]窗户及窗外的树木颜色失真严重),保留较完成的场景细节纹理(文献[16,6]图像存在过渡平滑丢失纹理细节),视觉感知自然,没有出现严重的伪影噪声(文献[10]存在较多噪声伪影)。图4(b)中CCSNet 较对比算法增强结果更自然(文献[16,6,14]存在模糊、伪影、颜色失真,场景不自然),全局光照均匀且保留较好的场景深度信息(文献[13,14]画面较深的区域增强失败),色彩真实(文献[16,6,15]整体色调重建失败,文献[10]水面、天空、河道右边的灯光区域出现不同程度的彩色光晕现象),结果建筑物对比度及细节感较好(文献[16,6,14]河流两旁建筑存在模糊、细节丢失、黑影),但是由于输入图像光照退化严重,天空区域出现伪影(对比文献同样存在不同程度的伪影)。图4(c)为反射光成像,文献[16]增强结果整体偏暗,黑色框中树丛亮度增强不足,远山丢失了岩石的纹理细节;文献[6]过渡平滑出现模糊及对比度细节丢失;文献[13]红色框标注区域及文献[10]出现彩色伪影;文献[15,14]屋顶瓦块边缘曝光不足出现黑晕及不自然情况;CCSNet 整体增强光照较均匀,没有明显的黑影、伪影和颜色不自然。图4(d)为非均匀光照成像,文献[16,6]地面、房子墙体的纹理细节等由于平滑丢失;文献[14]增强结果存在严重颜色失真、黑色伪影,整体视觉感官不自然;文献[10,15]的整体亮度增强较好,但存不同程度的阴影;CCSNet 整体亮度增强较文献[10,15]不足,但亮度提升对比度自然,能够抑制噪声伪影、矫正失真颜色。图4(e)为夜晚非均匀光照成像,文献[16]建筑及地面由于过于平滑出现细节纹理丢失;文献[6,15,14]整体存在不同程度颜色失真、虚化、细节丢失;文献[13]中整体颜色和亮度重建较好,但红框区域出现彩色伪影;文献[10]中对于室内亮灯的窗户区域出现严重的污染,且整体重建结果不真实,伪影严重;而CCSNet增强结果亮度均匀,没有明显的噪声,色彩较自然地凸现了黑暗中的房屋结构。图4(f)为背光成像,文献[13,15,16]前景亮度增强不足且背景黑色伪影抑制失败,特别文献[16]动物眼睛、胡须边缘细节纹理丢失;文献[6]黑色框区域丢失细节,动物耳朵和后颈脖子存在不自然黑晕;文献[10]前景增强对比度较好,但结果颜色不真实;文献[7,14]整体增强亮度、细节、对比度较好,相比文献[14],CCSNet 增强结果抑制了背景中黑晕把天空色彩重建的较自然完美,前景中动物的颜色也更丰富自然。图4(g)中文献[16]存在过度平滑,重建图像丢失部分纹理细节;文献[2,10]中红色区域的色彩伪影导致模糊和细节丢失;文献[14]红色框区域相对其他增强结果模糊及噪声更明显;文献[13,15]及CCSNet增强结果整体亮度、对比度和颜色综合较优。

如图5,第一列为输入,第二列为真实的参考图,中间为对比算法,最后一列为论文CCSNet增强结果;黑色框区域为增强失败特别注意区域;图像下面为信噪比PSNR 及结构相似度SSIM 两个图像质量评价指标,红色代表最佳指标。图5(a)中CCSNet 增强结果获得最佳的SSIM 指标,整体主观视觉上色彩丰富自然,亮度提升均匀,没有出现局部过暗、伪影模糊(文献[16]色彩偏灰白,黑色框区域由于过渡模糊丢失纹理场景信息;文献[6,13,15,14]布偶头部区域存在黑色伪影,尤其文献[13]整体图像存在模糊伪影和细节纹理丢失;文献[10]存在噪声及水杯颜色错误的增强)。图5(b)中CCSNet 增强结果获得最佳的PSNR 指标,在黑色框处存在较浅的绿色伪影,但整体亮度提升较好,没有局部黑影(文献[6,13,10,14]增强结果中时钟及其周边存在黑边或是没有恢复的黑色区域);图像细节对比度较自然没有过渡平滑及大量的噪声现象(文献[6]增强结果整体存在过渡平滑细节丢失的情况,尤其注意黑色框中的窗户区域;文献[10]存在不自然的伪影现象;文献[16,15]增强结果的窗户区域存在大量噪声);水道数字旁的色带、窗外的远山及全局整体的色彩得到了重建恢复(文献[6,14]中窗外的远山颜色重建失效,文献[1]整体色彩偏暗不自然)。

图5 LOL数据集增强结果可视化对比(放大视觉效果更直观)

图5(c)中CCSNet 增强较对比算法获得最佳SSIM 指标,视觉上整体实现了全局自然和谐的增强没有过曝光及模糊伪影(文献[6,13]的黑框区域存在模糊及伪影,尤其文献[6]由于模糊丢失细节信息),色彩层次丰富真实(文献[16]增强结果颜色鲜亮但丢失了纹理细节,且右起第三件黑灰色衣服领子的红色边颜色恢复失败,文献[10,14]黑色衣服颜色恢复失败且不真实)。图5(d)中CCSNet 增强较对比算法获得最佳SSIM 指标,增强结果全局亮度提升均匀、对比度细节较好,没有明显的伪影及噪声,唯一真实恢复重建图像中装订机的颜色(文献[6,16]增强结果模糊伪影较严重,文献[10,13,15]黑色框区域噪声明显且存在伪影,文献[14]存在多处有颜色的伪影,书本书页处颜色亮度不足,存在较多黑晕现象)。

通过图1、4、5综合分析对比,CCSNet在不同测试数据上较主流算法具有更好的鲁棒性及泛化性,能够适应不同程度的光照退化场景,包括恶劣条件下的图像增强,具有全局及局部自适应的亮度增强;提升图像细节对比度,抑制噪声减少伪影现象,获得色彩层次丰富真实的视觉感官。

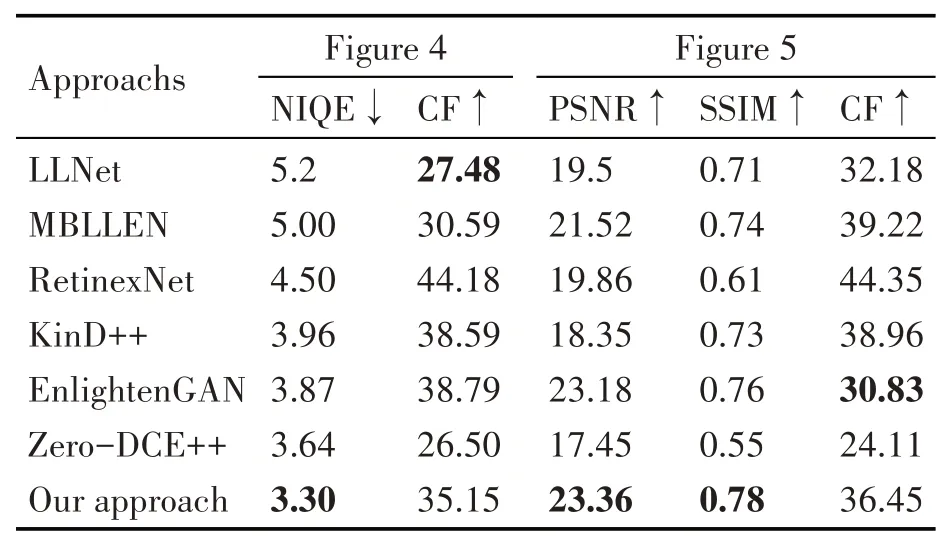

4.3 实验结果定量分析

在定量分析实验中,论文图像质量评价指标选择信噪比PSNR、结构相似度SSIM[49]、均方根误差RMSE、自然保持度NIQE[54]、图像颜色度量指标Colorfulness[55],其中Colorfulness基于对手颜色空间(rg、yb),检验实验指标和研究参与者分配给图像的色彩之间的相关性值,值越大表明低照度图像增强结果色彩保持及性能越好,见式(10)~(11)所示,μ、σ分别为像素强度均值和方差。

论文在测试数据集上对比主流的低照度增强方法,统计了PSNR、SSIM、RMSE 三个指标平均值,如表1所示,CCSNet网络增强结果在三个图像质量评价指标中均获得最佳的性能,较次有算法PSNR、SSIM、RMSE 分别提升比例为0.259、0.132、0.446,优于对比算法。如表2 所示,论文公共测试数据集及LOL 数据集分别进行了对比性能定量分析,其中,在公共测试数据集中CCSNet 网络增强结果取得了更优秀的NIQE 指标,较次优算法提升了0.083;在LOL 测试数据中PSNR、SSIM 均取得更优秀的性能;Colorfulness色彩度量指标在对比算法中处于中间位置,综合表明网络增强结果具有对比优势的颜色矫正能力,在LOL测试数据上的表现也证明了这一点。综合对表1、表2 数据分析,CCSNet网络在定量实验对比分析中取得了综合较对比的主流基于深度学习的低照度增强算法更优的性能。

表1 图像质量评价指标PSNR、SSIM、RMSE的比较

表2 不同数据集图像质量评价比较

5 结语

论文针对主流深度学习低照度图像增强网络架构中深层上下文语义特征获取与保留空间精确度特征间的矛盾,设计了一种融合全局深层上下文语义及空间准确度特征的端到端低光照图像增强方法,不同深度双编码结构并行获取并融合利用深层上下文语义的特征及保留空间精确度的特征完成低照度图像重建的任务。与不同类型主流算法对比进行定性及定量分析实验对比,结果表明论文方法取得了更好的图像质量评价指标及更强泛化能力、亮度提升更自然、噪声伪影不明显、颜色丰富真实的综合增强质量。低照度图像增强依旧是计算机视觉研究中的底层关键且具有挑战的研究方向,未来将深入挖掘不同低光照场景图像光照内在本质规律,建立起低光照图像增强与高层视觉任务的关联,提升计算机视觉高层任务效能。