基于事件相机的连续光流估计

付婧祎 余 磊 杨 文 卢 昕

光流(Optical flow,OF)估计一直是图像处理与计算机视觉领域中一个核心的研究课题.近年来,随着计算机软硬件水平的提高,各类光流估计算法层出不穷,光流技术在跟踪[1-2]、运动分割[3-4]、导航[5-6]和图像配准[7-8]等应用领域凸显出了越来越重要的作用.特别是在高速运动场景中,由于空间物体运动位置的快速变化,对运动数据的获取和光流的计算提出了更高要求,连续且高精度的光流估计算法[9]更是被国内外学者广泛研究,其获得的光流估计结果也能为后续各类视觉任务打下良好基础.

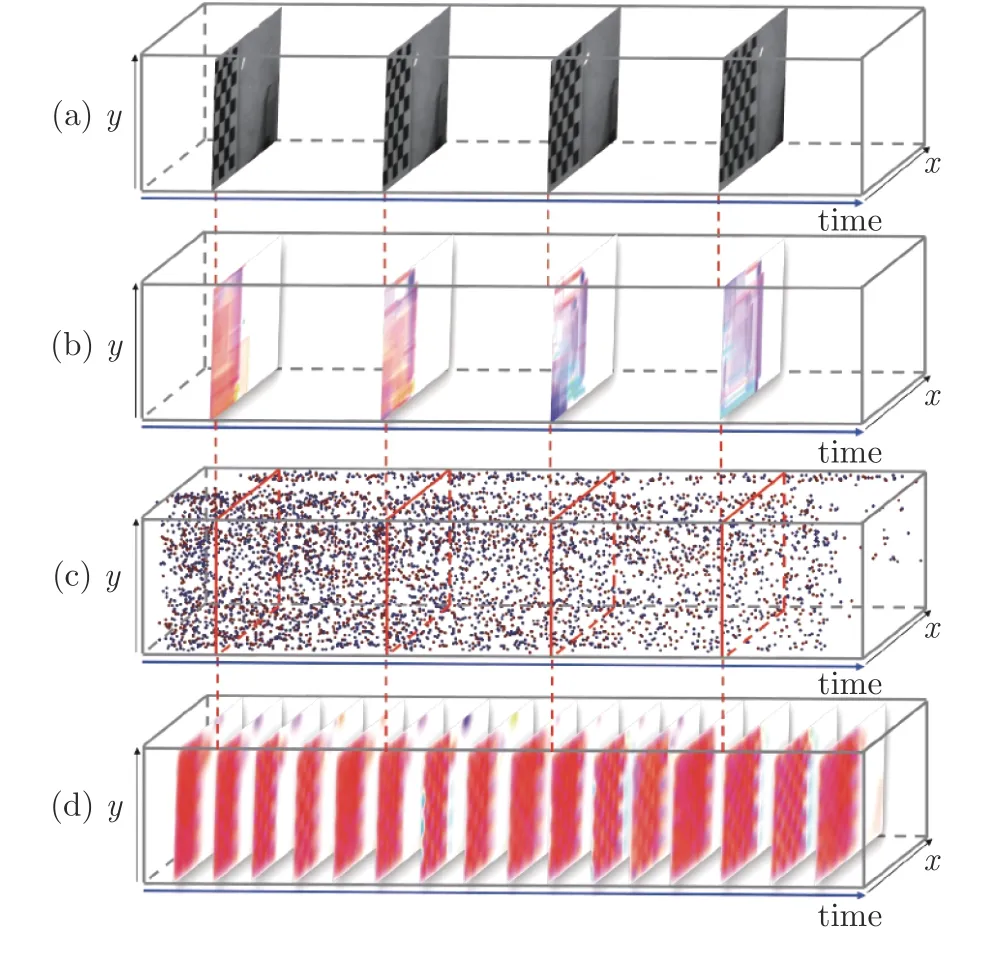

然而,由于相机自身较低的时间分辨率,传统光学相机在高速运动场景下,难以连续捕捉到物体在成像平面中位置的快速变化,导致输出图像帧存在运动模糊,因此低帧率的数据使得基于传统相机的光流估计算法无法有效地进行连续的光流估计.如图1(a)所示,向右做高速运动的棋盘格由传统光学相机成像,由于传统相机曝光时间较长,棋盘格在亮度图像帧中出现了运动模糊.通过传统Horn-Schunck 算法[10]获得的光流结果如图1(b)所示,随着棋盘格运动速度加快,受到亮度图像运动模糊的影响,传统算法所估计的光流精度逐渐降低,甚至输出与实际运动反向的光流结果.

图1 基于传统相机和基于事件相机的光流估计效果对比((a)传统相机输出图像帧序列;(b)传统Horn-Schunck算法的光流估计结果;(c)事件相机输出事件流;(d)本文EDI-CLG 算法光流估计结果)Fig.1 Comparison of traditional camera and event camera based optical flow ((a)The samples of images acquired by traditional camera;(b)The results using Horn-Schunck algorithm;(c)The event data generated by event camera;(d)The results using the proposed EDI-CLG algorithm)

近年来,针对基于传统光学相机的光流估计算法易受运动模糊影响的问题,基于事件相机[11-12]的光流估计算法受到了广泛关注.事件相机是一种新型的仿生传感器,不同于传统相机通过固定时间间隔采样获取图像帧,该相机具有独立的像素,这些像素只在场景的亮度变化超过一定阈值时异步地进行成像.此外,事件相机具有高时间分辨率的特性,受运动模糊问题影响较少[13],因此能够对空间物体的运动进行连续捕捉,获取瞬时的运动数据有利于进行连续的光流估计.图1(c)展示了棋盘格高速运动生成的事件点,红色表示亮度增强,蓝色表示亮度减弱.可以看出,事件相机捕捉到的运动信息在时间上具有连续性,基于此估计出的如图1(d)所示的光流结果,不仅在时间上具有连续性特征,而且更加精确.

目前,基于事件相机的光流估计算法主要分为单纯基于事件流算法和联合事件流与亮度图像算法两种.由于事件流数据不能如图像帧一样完整地反映场景的纹理信息,因此单纯基于事件流的光流估计算法[14-16]仅能反映事件点触发位置的光流信息,无法得到完整的场景运动信息.此外,由于事件数据存在大量噪声[17],也降低了光流估计的准确性.动态和主动像素视觉传感器(Dynamic and activepixel vision sensor,DAVIS)相机由Berner 等[18]开发.该传感器结合了动态视觉传感器(Dynamic vision sensor,DVS)[19-20]和传统的主动像素传感器(Active pixel sensor,APS),不仅输出异步事件流,还可以输出固定帧率的亮度图像.基于此,Almatrafi 等[21]提出了联合DVS 和APS 数据的光流估计方法,提高了事件相机光流估计的准确性和鲁棒性.然而,由于APS传感器输出的亮度图像依然不可避免地受到运动模糊影响且该算法由于依赖亮度图像获取空间梯度,只能估计出建帧时刻的非连续光流,因此并不能保证高速运动场景下光流的精度和连续性.

针对上述问题,本文基于亮度恒定假设和事件产生模型利用事件相机输出事件流的低延时性质,融合存在运动模糊的亮度图像帧,提出基于事件相机的连续光流估计算法.通过研究模糊图像帧与曝光时间内生成事件点之间的关系,可以重建出连续的清晰亮度图像,从而使算法受运动模糊的影响较少.最后在计算光流时,添加平滑约束获得更具鲁棒性的稠密光流,最终实现高速运动场景下受运动模糊影响较小的连续光流估计.

本文的主要贡献如下:

1)针对基于传统光学相机的光流估计算法易受运动模糊影响问题,本文通过研究模糊图像帧与曝光时间内生成事件点之间的关系,理论上推导了联合事件和图像的连续光流模型,建立了任意时刻光流、图像和事件之间的关系.

2)基于联合事件和图像的连续光流模型,提出HS (Horn-Schunck)和结合局部与全局(Combining local and global,CLG)平滑约束的光流估计方法,提升了重建光流的精度和平滑性.

3)通过实验表明,本文方法不仅能够较大提升基于事件相机光流估计的精度,同时还能解决目标高速运动条件下如何进行连续且稳定的光流估计问题.因此,对于高速运动的极端场景,本文方法具有一定优势.

1 相关算法概述

1.1 基于传统相机的光流估计

在基于传统相机的光流估计方法中,光流可以通过连续图像帧间的相关性以及图像上特定像素在空间和时间上的变化得到.一般地,坐标 (x,y)上的像素在t时刻的亮度值可以表示为I(x,y,t),为简便起见,有时将I的坐标变量默认省略.在环境不变时,用同一相机拍摄的图像序列之间有很强关联性,因此可以引入光流的“亮度恒定”假设[10,22]即随着时间的变化,在图像平面移动的像素点亮度值不变.对于t时刻在坐标 (x,y)上的像素点,经过∆t时间,移动到 (x+∆x,y+∆y),则:

基于这一假设,将式(1)按一阶泰勒展开后,再忽略高阶项,可以得到光流约束方程:

但仅有光流约束方程不足以估计出二维运动场.因此,Horn 等[10]通过正则化方式提高全局空间的一致性,提出速度平滑假设,将问题转化为可求解的凸函数,也就是HS 光流法.Lucas 等[22]提出基于光流场局部空间一致性的Lucas-Kanade 光流,提高算法的准确性和鲁棒性.随后,Black 等[23]提出分段平滑的假设来改进全局平滑,黄波等[24]通过引入二维标号场改进了HS 光流.Fortun 等[25]则通过最小化光流的大小来引入额外的约束,进一步提升了算法的精度.

然而,由于传统相机的时间分辨率较低,在某些高速运动的极端场景下,容易出现运动模糊,导致光流估计算法的性能急剧下降.因此基于传统相机的光流估计算法无法有效地保证高速运动场景下光流估计的准确性和稳定性.针对运动模糊问题,现有方法大多数基于线性运动的假设,在此基础上,通过求解模糊问题得到相应的光流估计[26-27].但是,由于场景运动较为复杂,无法满足线性运动假设,从而影响光流估计的精度[28].

1.2 事件相机成像原理

事件相机是受生物视觉系统启发的一类新型视觉传感器,与传统相机存在一定区别.传统相机基于帧进行成像,输出同步图像帧,像素点代表场景的绝对亮度;事件相机基于像素点独立成像,输出包含大量事件点的异步事件流,事件流表示场景在对数域的亮度变化.事件点数据包含了亮度变化事件的像素坐标、触发时间和极性三类信息.在像素平面上,若像素u=(x,y)T在t时刻上的对数光强值与上一时刻的对数光强值之差超过一定的阈值C,则激发事件e:=〈u,t,p〉:

式中,V:=lgI表示图像对数域的亮度值;阈值C >0;∆t是距离该像素上一次激发事件经过的时间;p∈{1,-1} 表示事件的极性,p为正表示光强增强,为负表示光强减弱.

与逐帧成像的传统相机相比,逐像素点独立成像的事件相机延时极低,能够及时响应像素的亮度变化并输出事件流,从而记录任意时刻的亮度变化情况.事件相机的低延时性质,使其特别适用于高速和高动态范围场景的视觉任务,例如自动驾驶[29]、高速同时定位与地图构建[30]、光流估计等.

1.3 基于事件相机的光流估计

针对基于事件相机的光流估计问题,目前常见方法是将恢复图像像素强度作为预处理步骤,以适应传统算法.如Benosman 等[14]利用短时间内事件的逐像素直方图来代替像素值,Bodo 等[31]使用中心差分来改善空间梯度的质量,Tobias 等[32]则利用空间梯度和时间梯度之间的耦合来提高鲁棒性.但由于从事件到强度转换过程中信息的丢失,这些算法与基于帧的光流估计算法相比,精度较差.

另一种常见方法是利用事件相机的特性来估计光流.Gallego 等[15]通过图像对比度最大化,以产生运动补偿的图像来同时估计光流和深度.Lagorce等[16]开发算法来拟合时空流形以估计平滑的边缘运动.Liu 等[33]提出一种基于事件的块匹配算法来估计光流的方向,并在文献[34]中融合了速度的计算.Barranco 等[35]提出一种基于相位的方法来计算高频纹理区域的光流,并尝试重建强度信号,以避免纹理边缘处可能存在的问题.Bardow 等[36]通过建立窗口,将亮度恒定和平滑先验组合为代价函数,并通过变分法进行优化,实现光流和亮度的估计.这些算法在一定程度上提高了光流估计的精度,但由于事件流数据不能如图像帧一样完整地反映场景的纹理信息,因此基于事件相机的光流估计算法仅能反映事件点触发位置的光流信息,无法得到完整的场景运动信息.

近年来,联合事件生成模型和“亮度恒定”假设进行光流估计的方法[37]得到了广泛关注.其中,部分方法基于事件的二重积分(Event-based dou-ble integral,EDI)模型[38],如Pan 等[39]利用该模型提出了联合光流估计和亮度图像去模糊算法,实验结果表明,利用EDI 模型可以降低运动模糊的影响,有利于提升光流估计的精度.因此,本文算法同样基于EDI 模型,并通过结合事件流和亮度图像各自的优势,提出基于事件相机的连续光流估计算法,以解决现有的传统光流估计算法易受运动模糊的影响,以及单纯基于事件流的光流估计算法空间信息不足的问题.

2 基于事件相机的连续光流估计

本节研究基于事件相机的连续光流估计方法,结构安排如下: 第2.1 节简要介绍EDI 模型,第2.2 节推导联合EDI 模型和“亮度恒定”假设的连续稀疏光流估计方法,第2.3 节分别添加两种平滑约束,最终求得对噪声具有鲁棒性的连续稠密光流场.

2.1 EDI 模型

EDI 模型[38]利用事件点的高时间分辨率优势,可以重建出受运动模糊影响较少的连续清晰亮度图像.相机APS 模块具有曝光时间,因此其输出的亮度图像在相机或场景内运动目标做高速运动的情况下,会产生运动模糊.假定第i帧亮度图像为Y[i]∈RM×N,曝光时间为T,曝光起始时刻用ti表示,则图像生成模型可以表示为:

式中,I(t)表示在t∈R时刻的瞬时清晰亮度图像,这个生成模型可以解释为由于亮度图像I(t)在T时间内的快速变化,导致输出图像Y[i] 模糊.为了更直观地表示事件,用连续时间信号来定义离散事件序列,对于像素平面上的每一个像素 (x,y),定义exy(t)为连续时间t的函数:

式中,δ(·)表示狄拉克函数,te表示事件被激发的时刻.定义I(f)是f时刻的瞬时清晰亮度图像,结合式(4)和式(6),可得:

将式(7)代入亮度图像生成模型式(5),可以得到曝光时间内的模糊图像与事件点,以及时刻f的瞬时清晰亮度图像之间的关系:

然后,可以定义:

最终,可将式(8)写为:

式中,Ei(f)表示第i帧亮度图像曝光时间内生成事件点的二重积分,I(f)表示任意时刻f的瞬时清晰亮度图像,两者均在时间上具有连续性特征.式(10)将模糊图像、瞬时清晰亮度图像和事件点之间建立了联系.而模糊图像和事件点是已知的,就可以通过式(10)计算出任意时刻的瞬时清晰亮度图像.

2.2 基于EDI 模型的连续光流估计

EDI 模型仅仅考虑了模糊图像的去模糊问题,本节进一步结合光流约束方程研究基于EDI 模型的连续光流估计问题.

若将EDI 模型重建出的瞬时清晰亮度图像看作式(3)中的亮度图像I,即:

则亮度图像I对时间f求导得:

可以结合式(3)和式(10),推导出联合事件流和亮度图像的连续光流估计方法:

则式(12)可更新为:

最终,将式(14)代入式(13),求得基于连续清晰亮度图像重建的光流计算公式:

上式给出了任意时刻f的连续光流v(f)与模糊图像Y[i] 和事件流数据Ei(f)之间的关系.第2.3节中,将利用这个关系并结合平滑约束,进一步得到优化的光流估计.

2.3 平滑约束的连续光流估计

2.3.1 HS 平滑约束的连续光流估计

HS 光流法是一种基于全局的方法[40],它除了需要满足Lucas-Kanade 光流法的亮度恒定、时间连续和运动位移小的假设外,还需要满足图像光流场全局平滑的假设.使用I简化表示I(f),令光流矢量v=(v1,v2),定义一个能量函数:

式中,Ix、Iy和If分别表示图像I在x、y方向上的导数和对时间的导数,∇表示求梯度,该能量函数的 (Ixv1+Iyv2+If)2是灰度变化因子,α(|∇v1|2+|∇v2|2)是平滑因子,α为正则化参数,调节光流场的平滑程度,理想的光流场应该使得灰度变化因子和平滑因子之和最小,即亮度恒定且运动平滑.为了便于推导,令:

将L对v1和v2分别进行求导,得:

式中,∆ 是拉普拉斯算子操作,可表示为:

本文用以下公式代替:

式中,(x,y)为m(x,y)的拉普拉斯估计值:

进行拉普拉斯操作替换后,将式(19)更新为:

使用Gauss-Seidel 迭代方法[40],利用估计的空间梯度、时间导数和上一次迭代的速度估计结果来计算一组新的速度估计值,得到迭代式:

本文实验中选取λθ=1×10-6.具体算法见算法1.其中,时间间隔 ∆f将每一帧亮度图像的曝光时间T进行T/∆f等分,决定了T时间内的连续光流估计次数.

2.3.2 CLG 平滑约束的连续光流估计

通常情况下,基于局部的光流估计方法对噪声更具鲁棒性,而基于全局的光流估计方法则产生更加精确的稠密光流场.CLG 光流法[41]结合了局部方法和全局方法各自的优势,产生对噪声具有鲁棒性的稠密光流场,其最小化能量函数可以表示为:

式(26)中各个参数的定义如下:

式中,Kρ是高斯核,ρ表示高斯核的邻域窗口大小,“∗”表示卷积操作,参数α调节平滑程度.使用类似第2.3.1 节中HS 平滑约束迭代公式的推导过程,可得CLG 平滑约束的光流迭代公式:

将式(11)和(15)代入迭代式(31),计算v1和v2在第k步迭代的估计值.迭代收敛条件与第2.3.1节相同,经过多次迭代,最终得到连续稠密光流的估计结果.与Pan 等[39]方法不同的是,本文方法利用EDI 模型重建连续清晰亮度图像的优势,推导出同样在时间上具有连续性的光流估计方法,因此在高速运动的极端场景下具有一定的优势,而文献[39]则基于曝光时间内光流恒定的假设,对亮度图像进行去模糊操作.

算法1.基于事件相机的连续光流估计算法

3 实验结果及分析

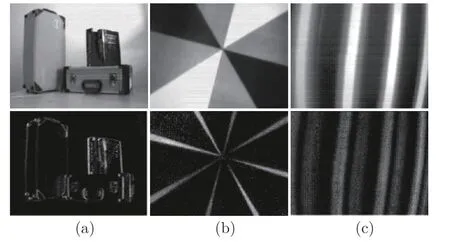

本文使用两组数据集对算法进行测试.第1 组来自Bodo 等[31]提供的数据集,由DAVIS240 相机[18]录制且带有光流真实值.该数据集场景简单,所有事件点均由相机低速运动生成.图2 展示了该数据集中TranslBoxes、RotDisk 和TranslSin 三个数据的亮度图像和对应事件帧,对应结果如图3、图4 所示.第2 组是运动模糊数据集,图5(a)展示了该数据集中三个数据的亮度图像,前两行数据来自Pan等[38]提供的真实模糊事件数据集,第3 行数据为使用DAVIS346 相机录制的真实模糊事件数据.第2组数据集包含高速运动导致亮度图像模糊的更具挑战性的情况,可以用于验证本文算法在极端场景下的鲁棒性,但不带有光流真实值.在实验中,将本文提出的引入HS 约束和CLG 约束的连续光流估计模型分别命名为EDI-HS 和EDI-CLG.

图2 DAVIS240 数据集的亮度图像和对应事件帧((a)TranslBoxes 数据;(b)RotDisk 数据;(c)TranslSin 数据)Fig.2 Brightness image and corresponding event frame of DAVIS240 datasets ((a)TranslBoxes dataset;(b)RotDisk dataset;(c)TranslSin dataset)

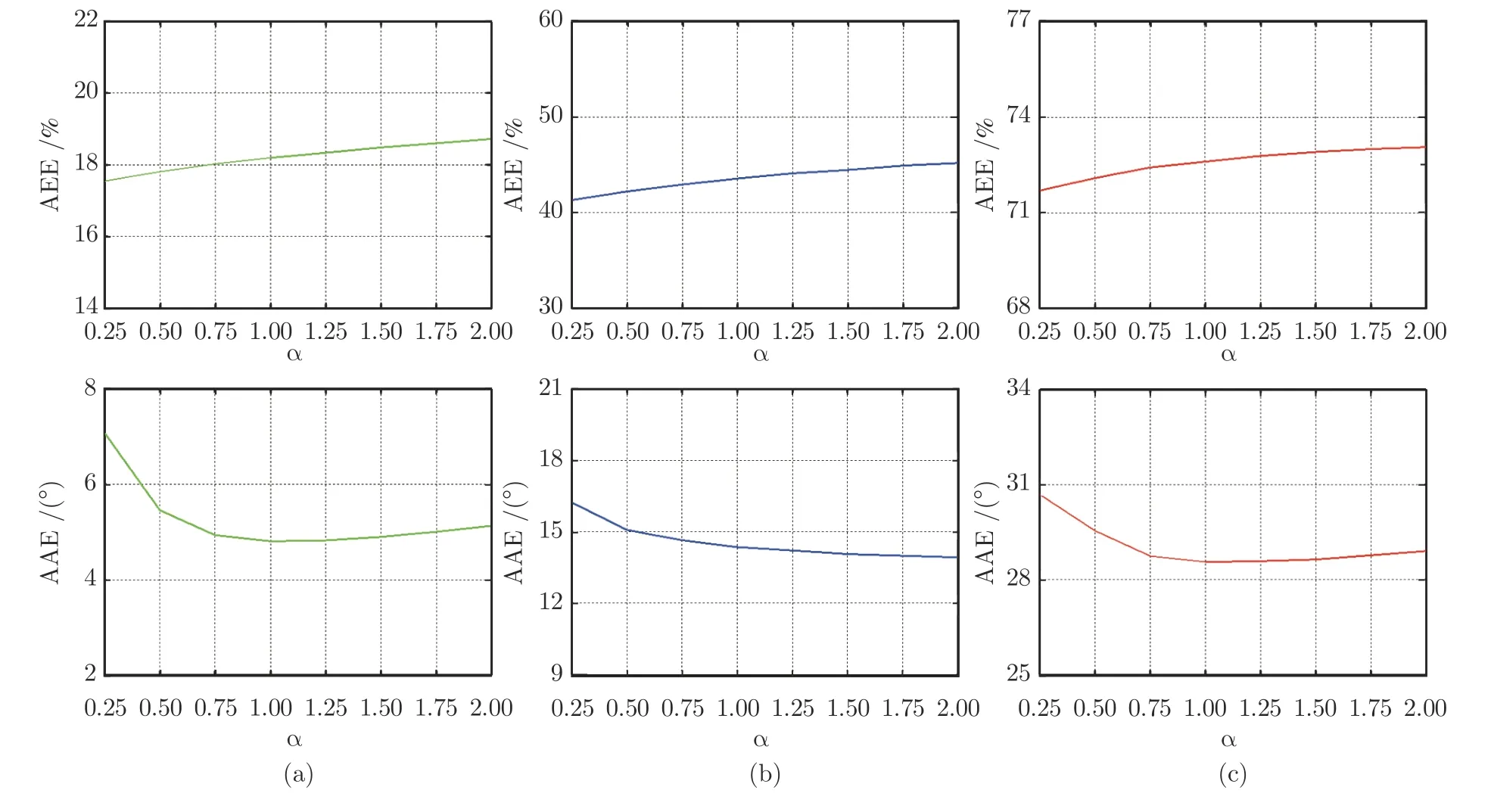

图3 正则化参数 α 与光流误差的关系曲线 ((a)TranslBoxes 数据;(b)RotDisk 数据;(c)TranslSin 数据)Fig.3 Relationship between optical flow error and regularization parameter α ((a)TranslBoxes dataset;(b)RotDisk dataset;(c)TranslSin dataset)

3.1 参数选取

算法1 中待设定的参数为平滑约束的正则化参数α.本文主要通过实验方式对该参数进行设置,选择带有标准偏差的平均端点误差(Average end point error,AEE)和平均角度误差(Average angular error,AAE)以及均方误差(Mean square error,MSE)来作为光流精度的衡量指标.AEE 表示光流大小与真实值的误差,单位为%:

AAE 表示光流方向与真实值的误差,单位为(°):

MSE 可用如下公式表示:

式中,vi=(vx,vy)i表示第i个光流测量值,ui=(ux,uy)i表示相应的光流真实值.

采用第1 组DAVIS240 数据集进行实验,通过观察不同的正则化参数对所计算光流的平均端点误差和平均角度误差的影响,对参数进行选取.在α取值为[0,3000]范围内进行了大量实验,通过实验发现,在各数据集上,当α>2 时,两种误差都随α的增大而升高,光流质量变差.因此,图3 展示了α取值在区间[0,2]上对所得光流的平均端点误差和平均角度误差的影响曲线.可以发现,相较于平均角度误差,平均端点误差受参数α的影响更小且平均端点误差随α的增大而缓慢升高,平均角度误差随α的增大呈现先降低后升高趋势.当α=0.75 左右时,可以同时保证两种误差均为较低,因此在后续实验中设置α=0.75.

3.2 连续光流估计结果

为验证本文算法的精度,将它们与现有的基于事件相机的光流估计算法进行比较,分别为Almatrafi 等[21]提出的联合DVS 和APS 数据的光流估计方法、图像对比度最大化光流估计法[15]和局部平面拟合光流估计法[16].将它们分别命名为DAVIS-OF、DVS-CM 和DVS-LP.其中,DAVIS-OF 光流估计算法在添加CLG 平滑约束时取得了最好的效果,因此本文在进行对比实验时,也对其添加了CLG平滑约束.

首先,使用第1 组DAVIS240 数据集对算法进行实验测试.表1 展示了各个算法在这3 个数据上的光流估计结果与真实值之间的误差,精度排名第1 和第2 的算法分别使用加粗和下划线标注.总体上,EDI-CLG 的结果最好,在3 个数据上的误差都比较小,EDI-HS 在TranslBoxes 和TranslSin 两个数据上的结果比另外3 种现有算法更优,且EDICLG 光流结果的标准差在3 个数据上都较小,说明EDI-CLG 的光流结果较为稳定,很少有异常值,具有良好的抗噪性能.实验结果表明,在DAVIS-240 数据集上,本文算法相比于其他3 种对比算法,在精度和稳定性上具有一定优势.

表1 DAVIS240 数据集光流误差表Table 1 Optical flow error on DAVIS240 datasets

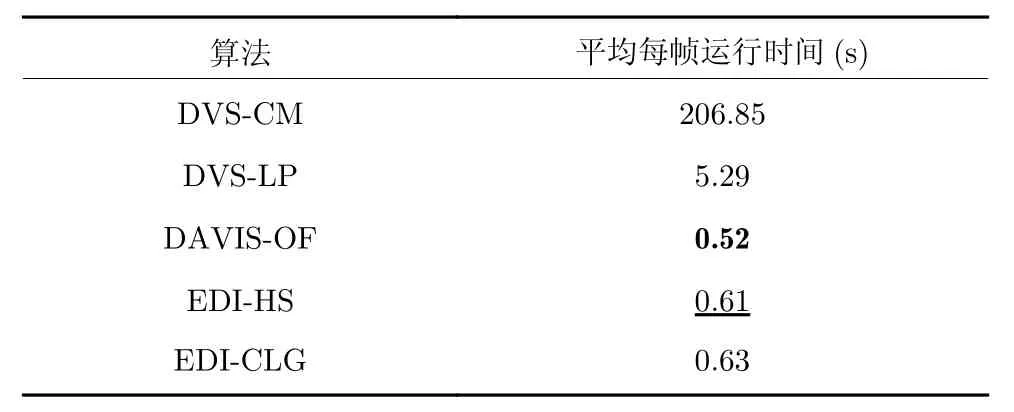

表2 展示了各个算法在3 个数据上的运行时间对比,其中运行速度排名第1 和第2 的算法分别使用加粗和下划线标注.使用Matlab2014a 进行光流估计的平均每帧运行时间作为衡量指标,其中,DAVIS-OF 的运行时间最短,EDI-HS 的运行时间也相对较短,而EDI-CLG 的迭代过程相比于EDIHS 较为复杂,因此运行时间略长,DVS-CM 则由于逐像素迭代计算光流,平均每帧运行时间为最长.实验结果表明,在DAVIS240 数据集上,本文算法的运行时间相比于现有算法具有一定的优势.

表2 运行时间对比Table 2 Comparison of running time

图4 为利用第1 组数据集中TranslBoxes、Rot-Disk 和TranslSin 三个数据对本文的连续光流估计方法与其他3 种光流估计算法进行测试的结果对比图.为便于可视化,对光流场进行了下采样.图4 包括光流真实值图像以及5 种算法的光流结果图.其中,绿色的直线箭头表示光流,所有光流估计结果都在事件帧图像上显示.

在TranslBoxes 数据中,箱子在图像上表现为向右移动,事件帧图像中噪声较少且边缘明确.其中,EDI-CLG 的光流结果较好,大小和方向都最接近真实值;DAVIS-OF 的光流方向总体较好,但光流大小缺乏一致性.而DVS-CM 和DVS-LP 个别事件点的光流发生了明显错误,特别是DVS-LP 有些光流值幅度很小,增加了AEE 误差,结果见表1.在RotDisk 数据中,分隔成不同颜色区域的圆盘顺时针转动,从真实值上可以看出,光流方向基本都垂直于区域边缘且光流大小与圆盘半径成正比.其中,EDI-CLG 的光流比较稳定,并且光流大小基本符合与圆盘半径的正比关系,这有效减少了光流误差.而EDI-HS 的光流方向较好,但是某些边缘上的光流大小比例不正确.DAVIS-OF 的光流大小最符合与圆盘半径的正比关系,但有些地方输出的光流方向不够准确.DVS-CM 由于只对局部区域做对比度最大化,光流方向并不都垂直于边缘;DVSLP 则有许多错误的光流方向,有些甚至与运动反向.在TranslSin 数据中,图像表现为黑白正弦曲线向左移动,由于黑白边界并不清晰,事件帧图像上边缘不明确且有许多噪点.其中,EDI-HS 和 EDICLG 估计的光流方向较为一致,但有个别光流幅值较大.而对比算法DAVIS-OF、DVS-CM 和DVSLP 输出的光流方向不稳定,且大小也比较杂乱.

为了验证本文算法在更具挑战性的场景下进行光流估计的准确性和稳定性,下面使用第2 组运动模糊数据集进行测试.第2 组数据集提供了高速运动导致亮度图像模糊的情况,可以用于验证本文算法在极端场景下的鲁棒性.

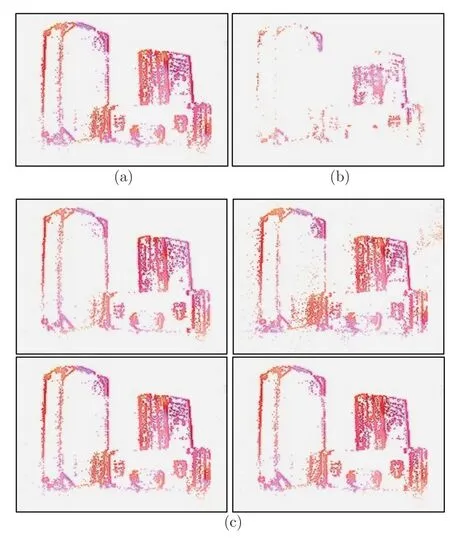

图5 展示了各种算法在第2 组数据集上的测试结果,包括数据集中的模糊亮度图像、使用EDI 方法重建的清晰亮度图像和各个算法的光流结果图.第1 行展示的数据是人手臂挥动黑白格图像,第2行数据是人在室内起跳后落下,第3 行数据是高速移动的相机拍摄的棋盘格.由图5 可以看出,在目标高速运动且亮度图像存在运动模糊的情况下,本文提出的两种连续光流估计算法都能稳定估计光流,光流方向都较为准确且变化较为平滑,其中EDI-CLG 估计的光流视觉效果最好,DVS-CM 和DVS-LP 的光流则存在异常值,方向准确度也不高.

3.3 连续光流的精度稳定性测试实验

通过与基于传统相机的光流估计算法对比可知,本文算法可以在一帧亮度图像的曝光时间内进行多次光流的计算(见图1),说明本文算法在时间上具有连续性.然而,当光流连续输出时,仍需进一步测试其精度是否稳定.因此,将本文提出的EDICLG 算法与 DAVIS-OF 方法进行连续光流的稳定性对比实验.

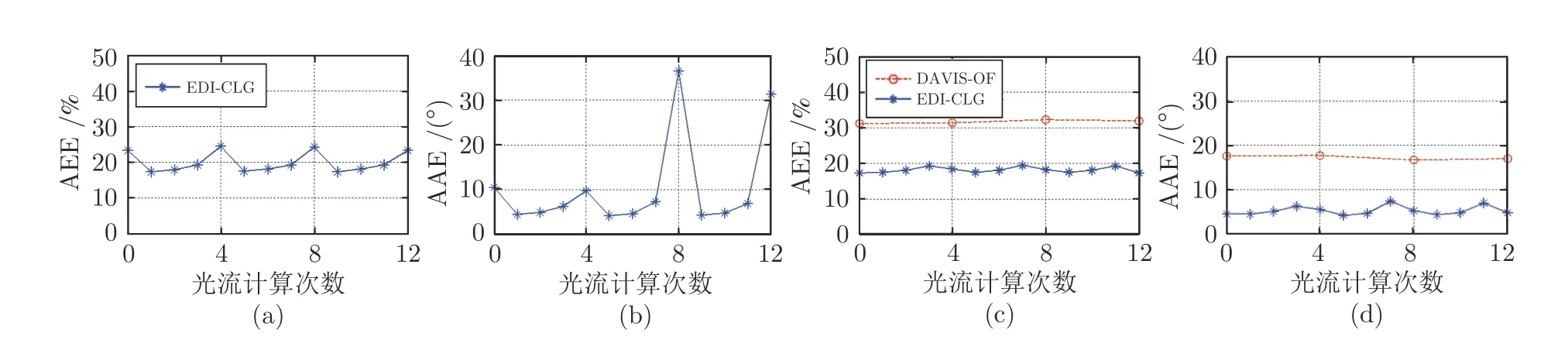

利用第1 组数据集中TranslBoxes 数据进行测试.最初使用算法1 得到的连续光流误差表明,本文算法在每一帧图像的曝光边界时刻,光流质量会比曝光中间时刻明显变差(见图6(a)、图6(b)).这是由于在亮度图像的曝光边界时刻,EDI 模型对模糊图像的补偿效果比在曝光中间时刻差[38],从而影响曝光边界时刻重建图像的质量,进而影响到光流估计的精度.因此,采用Niklaus 等[42]提出的亮度图像插帧算法,将前面使用EDI 模型进行重建的连续清晰亮度图像序列中每帧曝光边界时刻生成的图像,通过前后两张图像的插帧,替换为更高质量的重建图像,使连续光流估计的精度得到了进一步提升.

图6 连续光流误差对比折线图 ((a)EDI-CLG 算法改进前的平均端点误差;(b)EDI-CLG 算法改进前的平均角度误差;(c)EDI-CLG 算法改进后与DAVIS-OF 算法的平均端点误差对比;(d)EDI-CLG 算法改进后与DAVIS-OF 算法的平均角度误差对比)Fig.6 Continuous optical flow error comparison ((a)The average endpoint error of EDI-CLG before improvement;(b)The average angular error of EDI-CLG before improvement;(c)Comparison of the average endpoint error between the improved EDI-CLG and DAVIS-OF;(d)Comparison of the average angular error between the improved EDI-CLG and DAVIS-OF)

图6(c)、图6(d)展示了2 种算法的光流估计结果与真实值之间的平均端点误差和平均角度误差对比折线图,选择数据集中连续3 帧图像进行实验,对本文方法进行每帧图像曝光时间内连续4 次光流计算.由对比两组光流的平均端点误差和平均角度误差结果可以看出,本文算法估计出的连续光流误差更小且在多帧曝光时间内,可以保持精度的稳定性.

图7 展示了单帧亮度图像曝光时间内进行连续光流的精度稳定性测试的结果对比图.其中,DAVISOF 算法只能估计建帧时刻的非连续光流,因此输出单张光流结果(见图7(b)).而本文提出的EDICLG 算法可以在单帧亮度图像的曝光时间内多次计算光流(本文实验计算4 次),如图7(c)所示.可以看出,与对比算法相比,本文算法获得的光流与真实值更加接近,而对比算法输出的光流精度较低且有些事件点处没有输出光流.

图7 EDI-CLG 算法和DAVIS-OF 算法连续光流结果对比图 ((a)光流真实值;(b)DAVIS-OF 方法;(c)本文EDI-CLG 方法在单帧图像曝光时间内连续4 次进行光流计算的结果)Fig.7 Comparison of continuous optical flow results between EDI-CLG algorithm and DAVIS-OF algorithm((a)Ground truth;(b)The DAVIS-OF method;(c)The results of four continuous optical flow calculations within the exposure time of a frame using the proposed EDI-CLG method)

4 结束语

在相机或目标高速运动的极端场景下,由于相机自身较低的时间分辨率等局限性,基于传统光学相机的光流估计方法难以估计出连续的光流结果.针对这一问题,本文提出基于事件相机的连续光流估计算法,该算法联合了事件相机输出的DVS 数据和APS 数据各自优势,不仅能够重建出任意时刻的清晰亮度图像,而且可以保证光流估计的连续性和稳定性,解决了相机APS 数据易受运动模糊影响的问题.在计算光流时,本文通过引入两种平滑约束来计算稠密光流,进一步提升了算法的鲁棒性和准确性.实验结果表明,本文算法相较于现有的光流估计算法,在平均端点误差、平均角度误差和均方误差指标上,性能均有较大提升.在目标高速运动的极端场景下,也依然能够有效且鲁棒地估计连续光流.