基于机器视觉的巡检机器人目标检测研究

王 平,徐世晟,吴凤娟,张斌武

(国网武威供电公司,甘肃 武威 733000)

基于机器视觉的巡检机器人广泛应用于各个行业,尤其是在变电站智能巡检中,已成为主要的巡检手段。为更好地实现变电站巡检,提高巡检机器人的控制精度,姚楚阳等[1]设计了一种可升降式变电站室内巡检机器人控制系统,将改进Floyd全局路径规划算法用于搜索最优路径,从而提高巡检效率;王宏伟等[2]提出一种基于空间关系的巡检机器人巡检点自动生成方法,实现了巡检机器人对不同巡检场景的巡检点自动标定;董翔宇等[3]提出一种基于局部监督深度混合识别网络,从而对变电站巡检机器人道路场景进行识别,实现了实际变电站场景识别。通过上述研究可知,巡检机器人在变电站巡检中得到了广泛应用,且在巡检精度、路径规划以及目标识别方面均取得了良好的应用效果。但郑昌庭等[4]认为,巡检机器人虽然已经被广泛用于变电站目标检测识别,但其检测准确率和检测速度仍有待进一步提高。因此,本文结合YOLOv3网络检测精度高和计算速度快的特点,提出一种改进YOLOv3网络,并将其应用于基于机器视觉的巡检机器人目标识别。

1 基本算法

1.1 YOLOv3网络简介

YOLOv3网络是典型的目标检测识别网络,具有检测精度高和计算速度快的特点,其基本结构如图1所示,包括骨干网络Darknet53和检测网络FPN两部分。其中,骨干网络负责特征提取,由53个卷积层和23个残差层组成;检测网络负责对目标进行检测,通过引入FPN(feature pyramid networks,特征金字塔网络)思想对3个不同尺度的特征进行检测,可实现不同尺度目标的检测[5]。

图1 YOLOv3网络结构

YOLOv3网络通过对输入图像进行卷积操作,可划分为S×S个网格,每个网格通过3个锚框对目标进行预测,得到包括C个类别概率和预测框中心坐标与高度、置信度的输出结果S×S×3×(4+1+C)。最后采用非极大值抑制确定类别的预测值[6]。

YOLOv3网络的损失函数loss包括坐标位置损失(lcoorderr)、Jaccard相似系数损失(liouerr)和分类损失(lclasserr),具体计算方法如式(1)所示:

(1)

1.2 YOLOv3网络改进

1)路径改进。

YOLOv3网络通过FPN横向连接获取同层下采样位置信息,容易导致路径冗余,进而使信息在传递过程中丢失严重[7]。因此,为避免该问题,本文利用具有自下而上路径增强结构的路径聚合网络(path aggregation network,PANet)来缩短路径,同时对底层特征传播进行增强,提高信息的利用率。

2)自适应特征池化结构改进。

考虑到YOLOv3网络采用的FPN自适应特征池化是根据候选区域大小将特征划分到对应特征层上,容易导致相似特征可能对应不同特征层的问题,进而影响网络的精度[8],因此,本文利用PANet首先将候选区域映射到不同特征层,然后进行特征对齐,取消特征池化的两次量化操作,确定最终池化单元区域,实现对不同级别特征的融合,进而使网络更适配新特征。

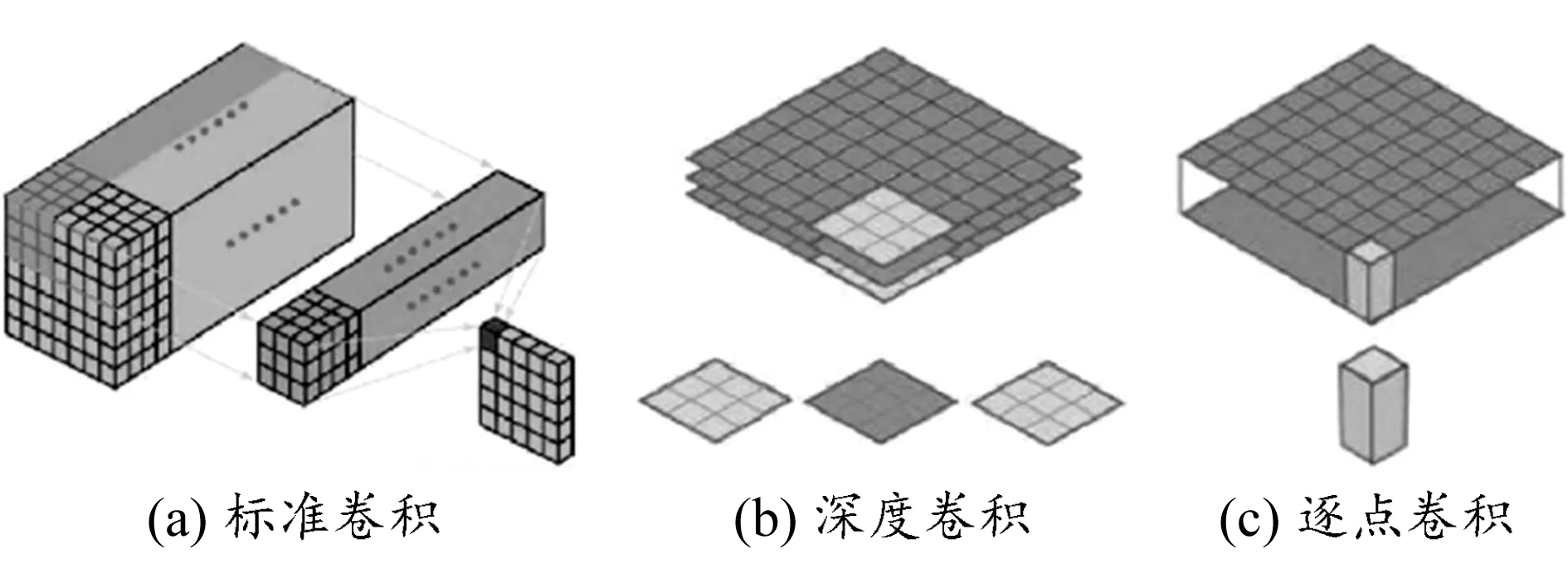

3)卷积结构改进。

标准YOLOv3网络的卷积核用于所有输入通道的卷积,存在计算量大的问题。为解决该问题,本文采用计算量小的深度可分离卷积结构替代原始标准卷积结构。深度可分离卷积包括深度卷积和逐点卷积两部分[9]。其中,深度卷积的卷积核与输入通道一一对应;逐点卷积为1×1×M的卷积结构,可通过加权生成新的特征图。标准卷积、深度卷积和逐点卷积三者的结构如图2所示。

图2 不同卷积对比

假设原始特征图和输出特征图尺寸分别为DF×DF×M和DF×DF×N,其中DF为特征图的宽和高,M、N为通道深度,则YOLOv3原始的标准卷积DK×DK计算量可表示为C1=DK×DK×M×N×DF×DF,深度可分离卷积的计算量可表示为C2=c1+c2=DK×DK×M×DF×DF+M×N×DF×DF,其中c1、c2分别为深度卷积和逐点卷积。由此可计算深度可分离卷积和标准卷积的计算参数比k:

(2)

由于N取值较大,因此1/N可忽略不计[10],从而减少了参数的计算量。

通过上述改进,有效提高了YOLOv3网络的信息利用率,减少了计算量,提高了检测识别精度。

2 基于机器视觉的巡检机器人目标识别方法

本文采用改进YOLOv3网络作为目标识别网络,具体识别流程如图3所示。

3 仿真实验

3.1 实验环境搭建

本次实验采用Pytorch开源框架搭建改进的YOLOv3网络,并在Windows10操作系统中运行。系统配置Inter Xeon E5-1603 v4中央处理器,GeForce GTX1660 8 GB GPU,内存条为DDR4。

3.2 数据来源及预处理

选用基于机器视觉的变电站巡检机器人现场采集的变电站可见光图像和红外光图像作为数据集,具体包括变压器等设备油位表读数、断路器等设备状态、变电站设备外观的可见光图像5 800张,以及变电站一次设备本体和接头的温度分布红外光图像1 150张。

为使样本图像满足网络输入条件,对采集的图像进行图像增强和噪声去除等预处理,最终获得可见光图像11类3 800张,红外光图像6类700张,并按9∶1比例划分为训练集和测试集。

3.3 评价指标

实验选用均值平均精度PmA、每秒帧率FPS作为网络检测精度与检测速度的性能评估指标,其计算公式如下[11-12]:

(3)

(4)

式中:M为YOLOv3网络预测的图像类别;PA,c为c类目标的平均精度,可通过式(5)计算;t1、t2分别为算法处理图像的开始和结束时间,单位为s;N为被处理图像的数量。PmA值越大,表示网络的预测准确率越高。当FPS>25帧/s,说明网络具有实时检测性能[13]。

(5)

式中:p为精确度,r为召回率。

3.4 参数设置

改进YOLOv3网络的学习率为0.001,批处理大小为16,迭代次数为50,Jaccard相似系数阈值为0.5,使用ADAM优化器进行优化[14-15]。

3.5 结果与分析

3.5.1网络验证

图4为改进前后YOLOv3网络在训练数据集上的训练损失函数值。由图可知,相较于改进前的YOLOv3网络,改进后的YOLOv3网络的训练损失更小,且可更快收敛。

图4 YOLOv3网络改进前后训练损失函数值

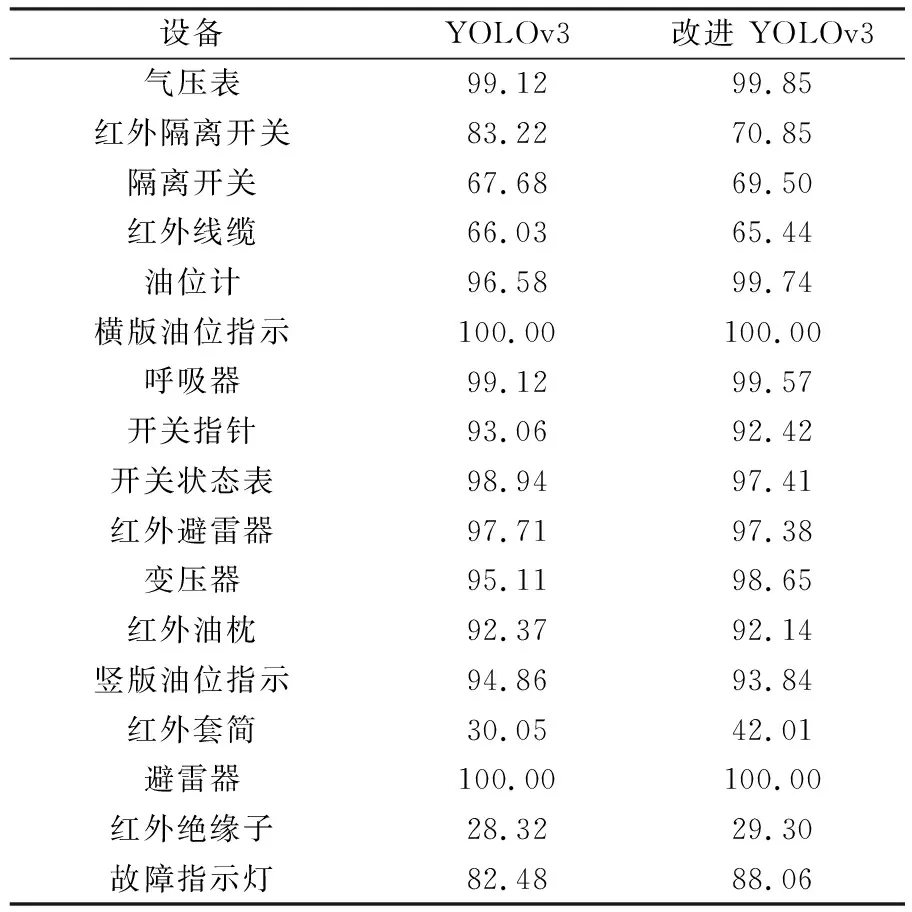

表1为YOLOv3网络改进前后在测试集上的识别均值平均精度对比。由表可知,不同变电站设备图像,标准YOLOv3网络和改进后的YOLOv3网络的识别准确率不同;标准YOLOv3网络对变电站红外避雷器和横版油位指示可见光图像的识别准确率最高,PmA值达到100%,对红外绝缘子、红外套筒的识别准确率较低,PmA值分别为28.32%和30.05%;改进YOLOv3网络对横版油位指示、气压表、油位计、避雷器的识别准确率较高,PmA值均达到99%以上,对红外绝缘子和红外套筒的识别准确率较低,PmA值分别为29.30%和42.01%。整体来看,改进YOLOv3网络对变电站设备可见光图像和红外光图像的识别准确率更高,对可见光图像识别的PmA值为94.27%,对红外光图像识别的PmA值为68.06%,相较于改进前的YOLOv3网络PmA值分别提高了4.12%和7.56%。由此说明,改进的YOLOv3网络可对大部分变电设备图像进行识别。

表1 YOLOv3网络改进前后在测试集上的PmA值对比 %

表2为改进前后YOLOv3网络大小和检测识别速度的对比。由表可知,改进后的YOLOv3网络相较于改进前的YOLOv3网络,网络大小缩小至原来的四分之一,为54 MB,检测速度提高了近一倍,FPS达到30帧/s,具有实时检测性能。

表2 改进前后YOLOv3网络大小与检测速度对比

为进一步验证改进后的YOLOv3网络,与YOLOv3-tiny网络的性能进行了对比,结果见表3。由表可知,相较于YOLOv3-tiny网络,改进YOLOv3网络的大小和检测速度具有明显优势。

表3 改进前后YOLOv3网络大小与检测速度对比

3.5.2不同网络性能对比

为进一步验证改进YOLOv3网络的有效性和优越性,通过实验对比了改进YOLOv3网络与常用目标检测识别网络——SSD网络和DenseBox网络以及Faster RCNN网络的识别性能及网络大小,结果见表4。由表可知,相较于常规目标检测识别网络,改进YOLOv3网络的文件最小为54.0 MB,说明改进网络在网络大小方面相较于常规目标检测识别网络具有一定的优势;在准确率方面,改进YOLOv3网络仅次于DenseBox网络,PmA值为84.44%,但检测速度更快,FPS为30帧/s;在检测速度方面,改进YOLOv3网络略低于SSD网络和Faster RCNN网络,但检测识别准确率明显高于SSD网络和Faster RCNN网络。因此,综合来看,改进YOLOv3网络具有一定的有效性和优越性,可用于巡检机器人采集的变电站设备图像识别中。

表4 不同网络在测试集上的识别性能对比

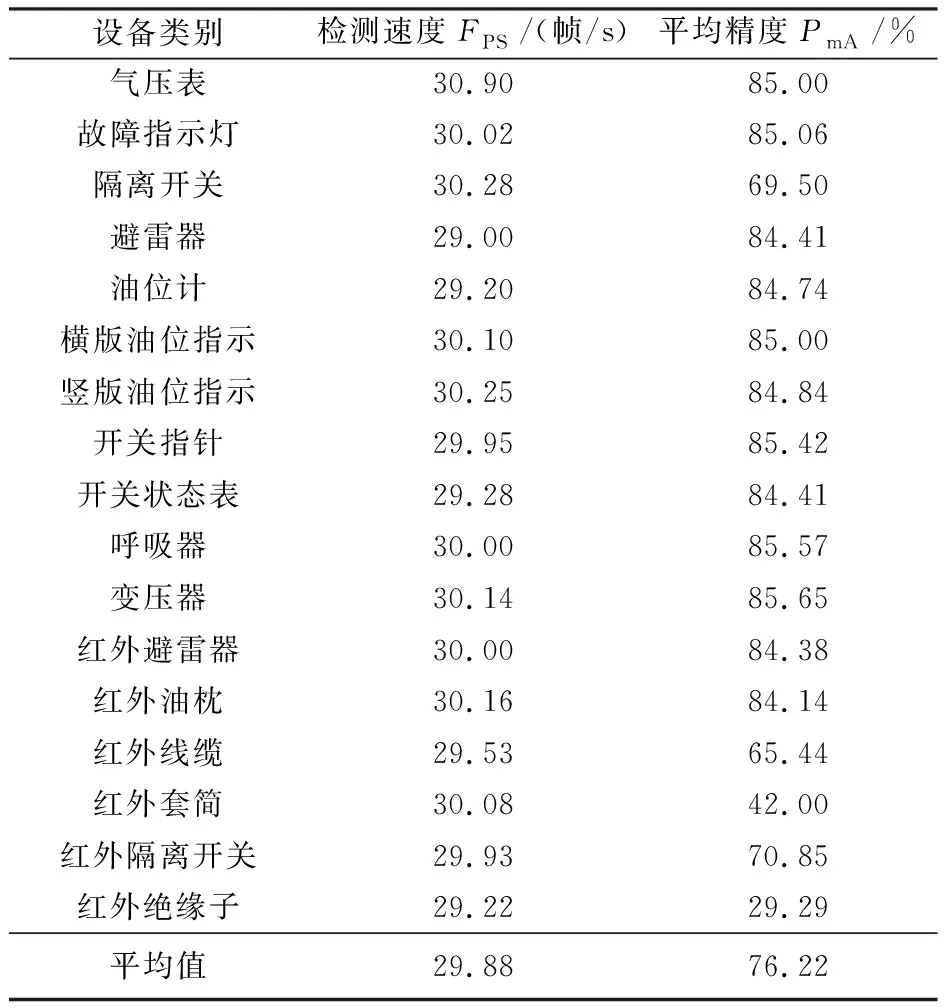

3.5.3实际应用效果

为检验本文所提改进YOLOv3网络的实际应用效果,利用网络收集整理了巡检机器人采集的17类变电站设备图像,每类图像各50张,对改进YOLOv3网络的实际检测识别效果进行了检验,并统计了网络的识别准确率和检测速度,结果见表5。由表可知,改进YOLOv3网络能较准确地识别出变电站设备图像,平均识别准确率为76.22%,检测速度基本维持在30帧/s左右。由此说明,改进YOLOv3网络对于巡检机器人采集的变电站设备图像具有良好的检测识别性能,且能保证较高的实时性。图5为改进YOLOv3网络对收集整理的网络巡检机器人采集的变电站设备图像的识别结果示例。

表5 改进YOLOv3网络的实际检测性能

图5 改进YOLOv3网络对变电站设备图像检测识别结果实例

4 结束语

综上所述,本文所提的基于机器视觉的巡检机器人目标识别方法,采用PANet和深度可分离卷积改进的YOLOv3网络作为目标识别网络,实现了对基于机器视觉的巡检机器人目标的高精度、快速检测与识别,具有一定的有效性和优越性。本文虽取得一定成果,但目前变电站巡检机器人采集的图像样本量还较少,可能影响检测精度,因此下一步将扩充样本数据。