全自主机器人视觉信息采集与导航控制方法

祝毅鸣,刘 鑫

(1.郑州西亚斯学院,河南新郑 451150;2.中南大学商学院,湖南长沙 410083)

1 引言

目前全自主机器人[1]多使用多视觉传感器,以此加强机器人的智能性。视觉是全自主机器人获取和感知周围环境的方式之一,全自主机器人的核心由内部传感器和外部传感器构成,内部传感器[2]可直接获取机器人自身的数据,外部传感器可获取周围环境以及研究对象的相关信息。自主机器人的重要研究目的是控制机器人的导航系统,在传感器的帮助下,获取相关数据,实现由出发点到终点的自主运动[3]。

文献[4]首先建立全自主机器人的运动模型,并利用卡尔曼滤波算法以及GPS技术定位出全自主机器人的位置,通过开放软件设置机器人行驶路径,根据机器人的偏航角等控制全自动机器人的导航,实现全自主机器人导航控制。

文献[5]首先通过单目视觉获取机器人相关数据特征,并对特征实施分割,其次在深度卷积神经网络的帮助下细化特征,得到机器人全局姿态优化,实现全自主机器人导航控制。

文献[6]利用深度视觉完成机器人导航数据的特征提取与匹配,其次在八叉树的帮助下规划导航地图,最后构建最近点模型,以此预测出机器人最优位姿,实现全自主机器人导航控制。以上三种方法在控制机器人导航过程未对目标对象定位,无法获取目标路径,导致机器人只能随机寻找路径到达目标地点,延长了导航控制时间,存在导航控制效果差和目标对象跟踪精度低的问题。为了解决上述问题,提出全自主机器人视觉信息采集与导航控制方法。该方法通过采集机器人信息,并且利用定位方法明确目标位置,结合Q算法和Boltzmann探索方案,实现机器人的导航控制,以期促进机器人的智能化发展。

2 机器人的目标定位

全自主机器人全局定位功能是机器人的核心功能,该功能是保证机器人可自主前进的前提,避免出现盲目运动的情况,在定位前需要采集机器人的相关信息作为定位和导航的基础。

2.1 基于视觉的信息采集

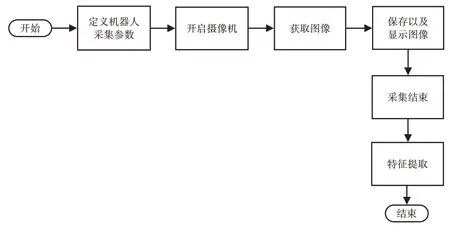

通过分析全自主机器人整体性能,得出基于视觉的信息采集流程,如图1所示。

图1 信息采集流程图Fig.1 Information Collection Flow Chart

视觉的信息采集流程主要由六步构成,依次是定义机器人采集参数、开启摄像机、获取图像、保存以及显示图像、采集结束、特征提取。基于全自主机器人自身设备可知,机器人采集图像信息仅依靠视觉技术[7]即可获取所需信息,视觉技术可分为主动视觉以及被动视觉。

(1)被动视觉

被动视觉方法就是利用机器人自身的摄像机随机获取一个视点,以此获取图像后完成三维重建。

(2)主动视觉

主动视觉是通过摄像机获取外界环境的几何信息,并对其开展特征提取处理,以此实现基于视觉的信息采集。

2.1.1 参数确定

根据流程图可知,在采集信息时,需要确定采集参数,实质上在采集图像时,目标对象和摄像机之间处于相对运动状态,导致获取的图像不清晰,需要及时调整摄像机的高度以及倾斜角等,确保图像的清晰度,以此获取完整的信息。

摄像角度和高度直接影响图像的质量,在保证图像质量的同时,最大程度地降低计算量,可以不断根据对象的实际距离确定。

拍摄对象在正常景深范围时,图像才能保证自身的清晰度,一旦超出该范围,无论是图像的对比度耗时,还是分辨率均会发生一定程度的下降,其中景深变化最重要的因素就是光圈大小,光圈越大,景深越小,但光圈的可调范围是不变的范围,因此,在获取信息时需要提前确定出最大光圈值,以此保证高度不同物体的清晰度。

2.1.2 信息特征提取

无论是被动视觉还是主动视觉,其核心均是提取信息的特征,以此完成信息采集。

选取BRIEF 特征提取方法完成信息特征提取,该方法由两部分组成,分别是特征点检测以及特征点表示,在特征点检测过程中,首先利用检测器检测出目标物的极值点,并运用滤波完成多尺度图像的极值点检测,继而将其视为兴趣点,同时实时响应阈值的判断以及非极大值的约束,最终针对特征点,在函数差值的帮助下,得出特征点的位置以及尺度,其中响应阈值判断是断定每种兴趣点的响应值,进而排除不在此范围内的兴趣点。

特征点的描述以特征点为中心,在设定好的范围内计算二进制表示特征点,以此确保尺度的不变性。范围的选取要求是保证特征点的尺度全部成正比,全自主机器人在实际导航过程中以地面目标为核心引导目标,这是因为该目标发生旋转的概率小,因此,不需要添加特征点方向的变化能力,进而最大程度地降低计算难度,二进制是利用多个像素点的比较值形成,进而得到的计算公式为:

式中:nd—图像像素对的数量;γ—横纵坐标像素的灰度比值。

根据以上对特征点的检测和描述,求解出Hamming 距离即可完成特征点的匹配。

2.2 目标定位

特征点匹配[8]的数量以及稳定性是实现机器人目标定位的关键点,通过候选对象以及标准目标点之间匹配的数量以及稳定性,表示两点之间的相似度,但因为各个目标中的特征点可能存在差异,通过相似度度量仅能得到目标的粗略位置,因此,需要加强精度,分别对目标物实施粗定位以及精定位。

2.2.1 粗定位

假设t时的目标图像区域集合为lt,则此时目标搜索区域集合为:

每个目标图像区域都需要计算其运动速度,并提取最大相似度的目标图像区域,将其视为粗定位跟踪结果。

则候选图像目标与标准图像之间的相似度计算公式为:

根据跟踪目标在区域中出现次数越多代表特征点越稳定的原理得出特征稳定性度量公式为:

式中:H—时间滑动部位的大小;

D—特征点在目标区域中匹配特征点的数量。

2.2.2 精定位

因为邻近图像的变化带有连续性,得出邻近图像间的变化关系,其表达式为:

根据式(5)即可随时求解相互邻近图像中心位置的位移向量以及目标区域的缩放向量。

为了最大程度地降低目标定位误差,在最小二乘法的帮助下计算目标变化参数以此得到目标的精确定位,假设样本点变量为,则目标函数表达式为:

则目标图像缩放向量以及中心坐标的表达式为:

式中:ox—图像缩放向量;

—中心坐标;

e—样本集。

对目标定位均是先对图像开展粗定位再开展精定位,随机选取样本集e作为输入添加到式(7)中,计算缩放向量以及位移,并输入到式(5)中,生成回归的线性方程,其次浏览所有匹配特征点对,进而计算出每个样本点到线性方程中的直线长度,在结果小于固定阈值,则样本和最小二乘法的结果完全相同,并反复执行上述两步直到完成系统要求的次数,提取出和最小二乘法次数完成相同次数最多的样本,即得出最优结果,则最优结果是目标图像的中心位移向量͂以及目标区域内在x轴上的缩放向量的分量,同理可知在y轴的位移向量以及缩放向量。

假设t−1时刻的目标图像为,则t时间的目标精确定位为

综合粗定位和精定位[9]的结果,即可实时定位目标对象的位置,从而控制机器人导航。

3 全自主机器人的导航控制

在Q学习算法[10]的基础上对处于动态环境中的全自主机器人导航开展控制可获取高效的控制结果,该算法的实质是在不知道机器人状态转移概率以及惩戒值时,计算出最优控制策略的一种算法,通过该算法可顺利实现移动机器的导航控制,同时尽可能的避免出现运动状态空间的维数灾难情况,完成计算后对其实施离散化处理即可。

当机器人准备实施下一个动作时,需要在数据库中随机抽取一个动作,在Boltzmann探索方案的帮助下得出目前机器人状态可执行动作的概率,概率计算表达式为:

式中:t—温度参数;m—训练次数;t0、α—调节参数;bi—执行动作;c—目前状态。

根据式(8)在所有动作集中选取机器人下一步所要完成的动作。

在状态转移的帮助下设置瞬间奖惩值,假设机器人的某一状态时的奖惩值表达式为:

式中:d—常数项;λ1—发生冲突的模糊隶属度;λ2—发生危险的模糊隶属度;λ3—发生威胁的模糊隶属度;λ4—安全的模糊隶属度;λ5—左侧的模糊隶属度;λ6—中间的模糊隶属度;λ7—右侧的模糊隶属度。

根据机器人的实际状态计算机器人的速度,并定义各个时刻下机器人与周围障碍物的距离,根据实际距离的变化得到奖惩值中常数值,进而获取Q学习算法的瞬间奖惩值。

根据设定的学习率和折扣率整理出Q学习规则,以此不断更新Q值,得到最优的机器人导航策略,并在人机交互技术下,实现全自主机器人的导航控制,每隔一段时间,采集一次机器人的状态信息,并发送导航信号,完成导航控制。

4 实验结果与分析

4.1 实验环境及参数

为了验证全自主机器人视觉信息采集与导航控制方法的整体有效性,实验对象全自主机器人,如图2所示。

图2 实验设备Fig.2 Laboratory Equipment

图2 的研究对象底部装置了移动滚轮,可以自由移动,采集数据的摄像机安装在全自动机器人的最顶部,安装位置如图所示,摄像机为索尼生产的SSC−G918P宽动态摄像机,实验主要技术参数包含像素、机械臂尺寸等,如表1所示。

表1 技术参数表Tab.1 Technical Parameter Table

以上述对象进行对比分析实验,对所提方法、文献[4]方法和文献[5]方法开展导航控制效果和目标对象跟踪精度的测试,以轮转角控制精度、航向角控制角度、横向位移偏差和目标跟踪精度为实验性能指标。在实验时,使用的场地为某市的中心广场,南北长400m,东西宽120m,在无人的情况下,在场地内设置障碍物,目标位置为(23,94),起点位置为(156,15),设置5个障碍物,分别在(145,15)、(133,34)、(92,43)、(85,66)、(42,66)位置。

4.2 实验性能分析

针对全自主机器人的导航控制实质上就是对其轮转角、位移以及航向角的控制,因为这三种因素的控制精度直接影响最终的控制效果。

4.2.1 轮转角控制精度分析

为了得出三种导航控制方法的优劣,随机选取一环境对三种方法开展控制效果的实验,在实验过程中保证三种方法的各种外界条件均相同,比较三种方法在不同时刻下的轮转角控制精度,以此得出三种导航控制方法的实际效果,如表2所示。

表2 三种方法的轮转角控制精度Tab.2 The Precision of Wheel Rotation Control by Three Methods

通过分析表2的三种方法的轮转角控制结果发现,轮转角每时每刻都发生变化,所提方法与理想结果一致,文献[4]方法的控制角仅在40s和100s时接近理想值,其他时间均与理想值偏差大,最低偏差2,文献[5]方法的控制角在40s时,控制较仅为9,与理想值相差11,此时偏差最大,其他时间偏差较小,接近理想结果,但整体偏离理想值,三种方法与理想控制角度最接近的是所提方法,该方法基本无误差,因此,所提方法提高了转轮角的控制精度和性能。

4.2.2 航向角控制角度分析

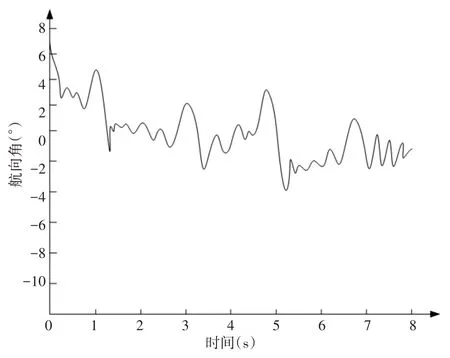

对机器人的角度控制不仅有轮转角,航向角也是导航控制好坏的关键,在同样的实验环境下,分析实验方法的航向角与机器人理想航向角的误差,如图3、图4所示。

图3 理想航向角控制角度Fig.3 Ideal Heading Angle Control Angle

图4 不同方法的航向角控制角度Fig.4 Heading Angle Control Angle of Different Methods

根据图3、图4可知,与理想航向角最接近的是所提方法和文献[4]方法,文献[5]方法与理想航向角偏差较大,仔细分析可知,所提方法基本与理想航向角重合,其角误差最小,因此,所提方法有效提高了航向角的控制精度。

4.2.3 横向位移偏差分析

为了进一步验证所提方法是最优控制方法的可信度,分析在不同时间下所提方法的位移偏差,如表3所示。根据表3可知,所提方法对位移量的控制未出现偏差,偏差值均未0m,即生成最高精度的位移量,文献[4]方法的横向位移平均偏差为0.38m,文献[5]方法的横向位移平均偏差为0.59m,文献方法的偏差均高于所提方法,最低高出0.38m,因此,所提方法在横向移动方面具备最优导航控制方法,有效降低了横向位移偏差。

表3 不同方法的机器人横向位移偏差(m)Tab.3 The lateral Displacement Deviation of the Robot by Different Methods(m)

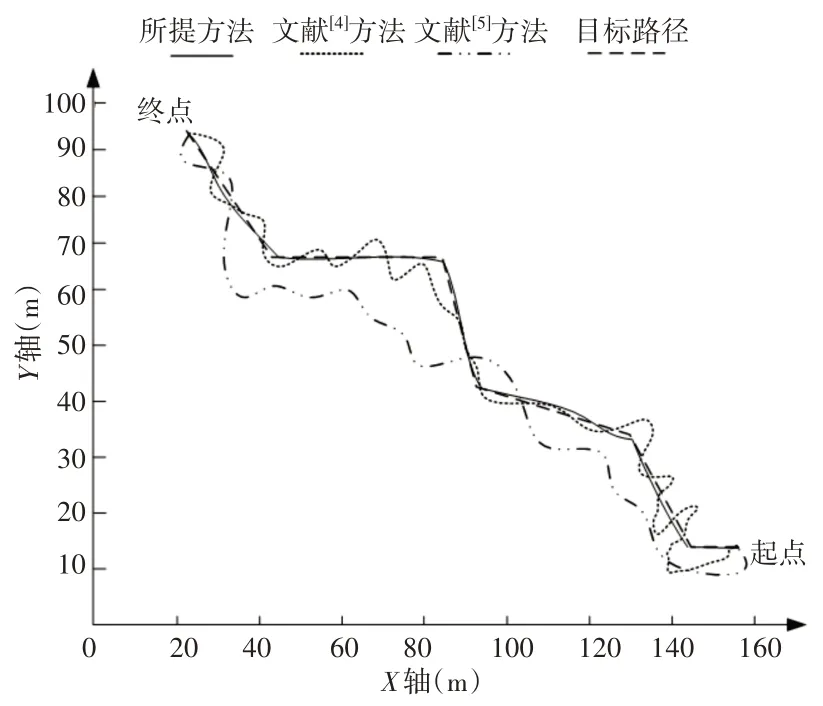

4.2.4 跟踪精度分析

机器人的导航控制是根据目标对象的位置和可行驶路径完成导航,因此,在控制过程中对目标对象的跟踪精度是否精准决定导航控制效果,为验证所提方法该方面的性能,在相同环境下,已知机器人的目标路径和目标对象,将三种方法得出的导航控制与目标路径进行分析,判断三种方法的跟踪精度,以此判定三种控制方法的优劣,如图5所示。根据图5可知,所提方法的路径是最相似目标路径的路径,在图5中可以看出,其路径基本与目标路径一致,且跟踪路径与目标路径十分接近,其在坐标(117,38)位置,Y轴出现最大误差,误差值为0.5m,文献[4]方法的路径在坐标(140,10)位置,Y轴出现最大误差,误差值为达到12m,文献[5]方法的路径在坐标(80,46)位置,Y轴出现最大误差,误差值为19m,对比分析三种方法的误差值,其中,所提方法的Y轴误差最小,并且低于1m,文献方法的Y轴误差均高于10m,因此,所提方法的跟踪精度最高,其是最优导航控制方法,这是因为所提方法在对机器人导航控制过程中对目标开展了精确的定位处理,提前确定目标位置的精确位置,以此获取最优形式路径,完美实现导航控制。

图5 三种方法的目标跟踪精度Fig.5 Target Tracking Accuracy of Three Methods

5 结束语

为进一步加强机器人的核心能力,提出全自主机器人视觉信息采集与导航控制方法,该方法采集相关导航数据以及对目标定位,计算奖惩值获取导航信号并完美避障,实现全自主机器人的导航控制,解决了导航控制效果差和目标对象跟踪精度低的问题,有效避免机器人因避障问题带来的影响,加强机器人使用寿命。在后续的研究中,针对方法的运算耗时进行研究,以期降低耗时,进一步提高信息采集和导航控制的效率。