基于迁移学习的小麦籽粒品种识别研究

李平 马玉琨 李艳翠 冯继克 赵明富

摘要:不同角度下小麥籽粒具有不同特征信息,造成分类结果存在差异。采用同一小麦籽粒多角度图片,使用小麦籽粒腹沟向上、腹沟向下和腹沟朝前三个角度图片构建小麦籽粒品种数据集。选取黄淮麦区种植面积较大的6个小麦品种作为试验材料,对比不同模型在小麦籽粒识别上的准确度。采用VGG-16、ResNet-50、Inception-V3卷积神经网络,通过迁移学习的方式建立小麦籽粒品种识别分类模型,验证集识别准确率最高为99.35%,高于不迁移学习的识别方法和传统机器学习的识别方法。在相同的试验条件下,三种模型在使用迁移学习的情况下对小麦籽粒识别的测试集准确率分别达到99.55%、99.77%、99.22%,优于单面特征建模识别。基于3种模型中分别选择最优试验,对其3种角度分别识别。结果表明:腹沟向下的识别率在3种模型中最好,腹沟朝前次之,腹沟向上较差。通过试验发现,采用同一小麦籽粒多角度图片可以更准确地提取小麦籽粒特征,并且有助于分类模型提升品种识别准确率。

关键词:小麦籽粒;品种识别;卷积神经网络;迁移学习

中图分类号:S126: S512: TP391

文献标识码:A

文章编号:20955553 (2023) 070220

10

Study on wheat seed variety identification based on transfer learning

Li Ping1, Ma Yukun2, Li Yancui3, Feng Jike1, Zhao Mingfu1

(1. College of Information Engineering, Henan Institute of Science and Technology, Xinxiang, 453003, China;

2. School of Artificial Intelligence, Henan Institute of Science and Technology, Xinxiang, 453003, China;

3. College of Computer and Information Engineering, Henan Normal University, Xinxiang, 453007, China)

Abstract: Wheat grains under different angles have different feature information, resulting in differences in classification results. In this paper, we adopt the same wheat grain multi-angle pictures, and use the three angle pictures of wheat grain groove upward, groove downward and groove forward to construct the wheat grain variety dataset. Six wheat varieties with large planting area in Huanghuai wheat area were selected as test materials to compare the accuracy of different models in wheat grain recognition. VGG-16, ResNet-50, and Inception-V3 convolutional neural networks are used to build a classification model for wheat seed variety recognition by transfer learning, and the highest recognition accuracy of the validation set is 99.35%, which is higher than that of the recognition method without transfer learning and the traditional machine learning recognition method. Under the same test conditions, the test set accuracies of the three models for wheat seed grain recognition using migration learning reached 99.55%, 99.77%, and 99.22%, respectively, which were better than single-sided feature modeling recognition. Based on the selection of the optimal test among each of the three models, their three angles were recognized separately. The results showed that the recognition rate of ventral groove downward was the best among the three models, ventral groove toward the front was the second best, and ventral groove upward was poor. It was found that the use of multi-angle pictures of the same wheat grain can extract wheat grain features more accurately and help the classification model to improve the accuracy of variety identification.

Keywords: wheat seeds; variety identification; convolutional neural network; migration learning

0 引言

小麦是世界上最重要的农产品之一,种植面积广泛分布在全球各地。同时,小麦也是中国粮食生产的主要作物之一,生产面积和总产量占比较高,而小麦的稳定发展对我国的粮食安全储备起到重要的作用[12]。目前小麦识别主要依靠人工的方法对不同小麦籽粒品种进行识别,该方法成本比较低,但需要工作人员具有丰富的实践经验,存在效率低、主观性强、准确率低等弊端。因此,该方法在生产实践中没能得到广泛的应用。传统的机器学习方法需要人工总结规律并提取特征,需要耗费大量时间、精力进行在图片预处理和特征有效性评估工作。攀超等[3]通过机器学习的方法对小麦品种提取6个颜色特征、5个形态特征、5个纹理特征进行分析识别,结果表明当采用3种特征的时候效果最好,识别准确率达到93.13%。何红霞[4]对小麦品种进行提取6个颜色特征、5个形态特征、5个纹理特征进行分析识别,通过三种算法对比,使用粒子群算法PNN神經网络的优化效果最为显著,准确率达到96.32%。因此需要一种效率高、准确率高的小麦品种识别方法。

近年来,以卷积神经网络代表的迁移学习技术迅速发展,在农作物种类的研究上得到广泛的应用[510]。谢为俊等[11]提出一种基于卷积神经网络的油茶籽完整性识别算法,从网络结果简化和超参数进行优化,使优化后的网络对油茶籽完整性识别准确率达到98.05%。刘嘉政[12]提出一种基于Inception-V3的迁移学习模型对花卉进行识别,在对各个参数进行微调的情况下,平均识别率达到93.73%。王东方等[13]基于迁移学习提出了一种TL-SE-RseNeXt-101,用于不指定农作物种类病虫害检测分类,与4种卷积模型进行对比,该模型在对不同作物种类的不同病害分类准确率达到98%。可以看出通过迁移学习方式的卷积神经网络在图像识别有较好的表现。

传统的小麦分类研究中,所拍摄的小麦品种图像都是按照腹沟向上的形态进行拍摄[1417],所采集的图像方式单一,采集小麦籽粒单面的图像往往不能更好的体现小麦籽粒的特征,本文所拍摄小麦品种图像是采用单粒多图多角度进行拍摄,分别为腹沟向上、腹沟朝前45°、腹沟向下,以便于能更好地提取特征。本文以选取种植面积较大6种小麦种子籽粒分类为例,采用多幅同一小麦籽粒图片分角度小麦籽粒分类数据库有助于分类模型更准确地提取小麦籽粒特征,避免了已有数据集中采集角度不统一造成的特征干扰问题,以较少数据量获得较高识别率,提高了品种识别的兼容性和准确性。采用迁移学习的方式对VGG-16[18]、ResNet-50[19]、Inception-V3[2021]这三种成熟的卷积神经网络对小麦籽粒进行品种的分类,并与不迁移的方法和传统的机器学习方法进行对比。

1 数据库构建

1.1 传统图像采集

樊超等[3]在对小麦品种进行分类研究中,采用的是BENQ_5000E 型扫描仪进行4个不同品种和6个不同品种图像采集,拍摄时采用的方法是按照腹沟向上的形态进行扫描。孟惜等[16]在对小麦品种识别中,采用的是BENQ_5000E型扫描仪进行6个不同品种图像采集,拍摄时采用的方法是按照腹沟向上的形态进行扫描。陈文根等[17]在对小麦品种识别中,采用索尼IMX258进行9个不同品种图像采集,拍摄时采用的方法是籽粒背面图片。所采集的图像方式太过单一,都是采集的小麦籽粒的单面不能很好地体现小麦籽粒的特征性,采集图像较少也不利于在深度学习模型中训练。

1.2 本文图像采集

河南科技学院生命科技学院实验室有小麦品种300多个,筛选出黄淮麦区种植面积较大的6个小麦品种,本文进行图像采集。表1为选择拍摄的小麦品种编号、品种名称以及本文对品种设置的标签。表1中品种编号为实验室原始编号,品种标签为本文处理并报告结果所用标签。图1为小麦品种实例。

本文对选取的品种进行单粒多图多角度来构建小麦籽粒图片,分为三种角度进行拍摄,分别为腹沟向上、腹沟朝前、腹沟向下,为了更好地提高品种识别的兼容性和准确性。针对表1中选出的6个小麦品种,采用体视镜进行籽粒拍摄,拍摄时每个品种挑选出颗粒饱满的种子1 000粒。拍摄在室内自然光照和灯光条件下进行,同时,保持拍摄板的干净整洁,避免杂质影响后续的图像处理结果。拍摄时以黑色吸光绒布为背景,体视显微镜参数设置为:放大倍数1倍,分辨率2 688像素×1 520像素,自动白平衡(AWB)关闭,宽动态平衡(WDR)关闭,LED补光灯设为中等。通过调整体视显微镜右侧焦螺旋对小麦种子聚焦,每粒小麦分别拍摄腹沟向上、腹沟朝前、腹沟向下和空白4张图片。小麦籽粒图像采集过程中,为避免籽粒之间出现漏拍、多拍、错拍等现象,同时为方便后期筛选处理,使用空白照片将不同颗粒之间的小麦进行分隔,图2所示为采集的小麦籽粒原始图像,三个方向图片,拍摄时图像名是日期加自动编号。拍摄根据品种籽粒类别逐类拍摄,每类品种保存至一个文件夹中,最终得6个品种的19 800张照片(包含空白照片)。

1.3 图像命名

本文拍摄的原始图像命名格式是时间加自动编号,没有体现小麦的品种类别和拍摄角度信息。如图3所示,命名结合表1的品种标签,其中0代表农大3416-18,内乐288命名标签为1等;标签中第2位数字代表每个品种拍摄的小麦颗粒数,0_1代表农大3416-18的第一粒小麦,0_2代表农大3416-18的第二粒小麦,以此类推;第三个数字表示每粒小麦分不同角度拍摄的3张图像,1代表小麦腹沟向下,2代表小麦腹沟朝前45°,3代表小麦腹沟向上。综上,3_1_1代表百农4199第一粒小麦,拍摄的第一个角度的图像,3_2_1 代表百农4199第二粒小麦,拍摄的第一个角度的图像,1_2_3代表内乐288第二粒小麦,拍摄的第三个角度的图像。使用程序对6个小麦品种统一命名,删除空白照片,统一命名后得到18 000张图像。

1.4 图像预处理

由于在拍摄中部分图片会存在问题,比如主体不够突出,辨识度低,图片拍摄时没有按照角度进行命名,为方便后續试验本文对图片先进行了预处理。预处理有图片降噪处理。

原始小麦图像分辨为2 688像素×1 520像素,且原始数据中小麦两边有部分黑边。原始图片带有影响图片的因素,因此要先对数据进行降噪处理,去除掉照片中的干扰因素,方便后续试验。为使数据更加适合训练模型和降低图像黑边对训练的影响,本文将2 688像素×1 520像素的图像切割为1 520像素×1 520像素。如不对图像进行压缩,则易造成内存溢出和训练时间较长的情况,内存溢出将导致模型无法完成训练,因此还需要对图像进行压缩处理,为满足卷积神经网络的输入图像的尺寸,本文将其按比例压缩像素。小麦数据集选择9 000张图片,按照8∶1∶1的比例划分为训练集、验证集和测试集,分别包括7 200张训练图像、900张验证集图像、900张测试集图像。为了满足不同模型输入的要求,对训练集图像进行随机裁剪和归一化处理,对验证集和测试集只进行归一化处理。如图4所示为裁剪后的小麦籽粒图像。

2 试验方法

2.1 卷积神经网络

卷积神经网络是一种带有卷积结构的深度神经网络,卷积结构可以减少深层网络占用的内存量,其三个关键的操作,第一是局部感受野,第二是权值共享,第三是池化(pooling)层,有效地减少了网络的参数个数,缓解了模型的过拟合问题。卷积神经网络的低隐层是由卷积层和最大池采样层交替组成,高层是全连接层对应传统多层感知器的隐含层和逻辑回归分类器。第一个全连接层的输入是由卷积层和子采样层进行特征提取得到的特征图像。最后一层输出层是一个分类器,可以采用逻辑回归,Softmax回归对输入图像进行分类。如图5所示,该网络是经典的卷积神经网络结构。

本文采用3种典型的卷积神经网络,分别为VGG-16[18]、ResNet-50[19]、Inception-V3[2021]。

VGG网络是在2014年由牛津大学著名研究组提出,其特点在于使用堆叠多个3×3的卷积核叠加代替了大的卷积核同时增加了网络层深度,整个网络都是用了同样大小的卷积核和最大池化尺寸,而且对于数据集具有很好的泛化能力。

ResNet是在2015年由微软实验室提出,其特点是参考VGG网络,在其基础上进行修改,在吸取了VGG网络的基础上加入了残差网络,目的为了克服由于网络深度加深而产生学习效率低和准确率无法提升的问题。

Inception-V1又名GoogLeNet,其中深度:层数更深避免梯度消失的问题;宽度:增加了多种核。Inception-V3通过改进Inception-V1网络,加入了分解成小卷积的思想,将较大的二维卷积拆解成两个较小的一维卷积,节约了大量参数,加速运算并减轻了过拟合。

2.2 迁移学习及微调模型

迁移学习也称为归纳迁移,其目标是将某个领域或任务上学习到的知识或模式应用到不同的但相关的领域或问题中。针对图像领域存在的训练成本高,可以用迁移学习来解决。基于卷积神经网络的迁移学习就是将已训练好的模型及参数在新的识别任务上再次进行训练,本文改进后的模型结构为:在原网络基础上增加一层ReLU激活函数,一层Dropout层,一层6维全连接层以及一层Softmax层。

本文采用不冻结任何网络层,将模型所有层设置为迁移学习方式,即为直接训练模型所有参数,并与冻结预训练模型的全部卷积特征提取层、仅对新分类器参数训练的迁移学习并和不迁移模型、传统的KNN、SVM进行对比。对于上述模型中训练及优化方案,3种模型结构共进行26组模型训练。迁移学习主要是训练好的模型具有较强的特征提取能力,通过利用在Image大型数据集上三种预训练模型,采用迁移学习的方法对预训练模型卷积模块参数,迁移到小麦籽粒识别任务中,作为网络的初始化参数,并且将预训练网络最后一层的全连接层替换为本文小麦籽粒数据集的类别数,即为类别数6,通过全局训练和局部训练完成识别模型,通过测试集得到小麦籽粒分类准确率。本文的小麦籽粒迁移学习框架如图6所示。

2.3 模型参数及优化

此处采用在ImageNet大规模视觉识别挑战赛上取得较好成绩的卷积神经网络VGG-16、ResNet-50以及Inception-V3的卷积。针对3种卷积神经网络,在原网络基础上添加ReLU激活函数,Dropout层,以及Softmax函数,加入Dropout是为了缓解模型训练导致过拟合,在训练过程中修改网络结构。

激活函数的引入是为了增加神经网络模型的非线性,没有激活函数的每层就相当于矩阵相乘。使用ReLU激活函数,给神经元引入非线性因素,可以解决线性能力不足的问题,这样神经网络就可以应用到众多的非线性模型中。

f(x)=max(0,x)

(1)

式中:

x——输入的数据;

f(x)——输出的结果。

最后一层是Softmax函数,本算法主要用于多分类问题,目的是将多分类的结果以概率的形式展现出来。

Softmax(x)=exi∑nj=1exj

(2)

式中:

xi——第i个神经节点的输出值;

j——

输出神经节点个数,即分类的类别个数。

本文选用适用于大规模数据的随机梯度下降法(Adaptive moment estimation, Adam)作为优化算法,Adam将随机梯度下降算法中的自适应梯度算法(Adaptive gradient algorithm, AdaGrad)和均方根传播(Root mean square propagation, RMSProp)的优势结合在一起,适合解决大规模数据和参数优化的问题。选择0.0001、0.001、0.01和0.1共4种初始学习率进行学习。

在模型训练过程中,本文引入早停技术(Early Stopping)来对模型训练后的验证集验证的结果进行监控,耐心值设置的为12,表示连续12次验证集的損失值不下降,立即停止对模型的训练,所以每次的迭代次数不是固定的。同时在训练过程中保存当前最优参数,后续如果有更优的结果则进行替换。此方法限制模型取得最小损失函数值的迭代次数,迭代次数过多,算法容易过拟合,迭代次数太少,则容易欠拟合。

2.4 模型评价标准

评价分类问题的评价指标:准确率(Accuracy)、精确率(Precision)、召回率(Recall)、F1值,混淆矩阵则是用来说明分类任务的。TP(True Positive)表示将正类预测为正类;FP(False Positive)表示将负类预测为正类;TN(True Negative)表示将负类预测为负类;FN(False Negative)表示将正类预测为负类。

准确率定义:对于给定的数据,分类正确的样本数占总样本数的比例。

Accuracy=TP+TNTP+FP+FN+TN

(3)

2.5 试验环境

试验采用PyTorch深度学习框架开发环境,PyTorch是Torch的Python版本,是由FaceBook开源的神经网络框架,主要用于GPU加速过的运算替代与NumPy类似的运算和构建深度神经网络。根据相关学者研究结果,PyTorch的速度表现胜过TensorFlow和Kersa等框架,使用同样的模型,PyTorch实现更有可能快过其他框架。与TensorFlow的静态计算图不同,PyTorch的计算图是动态的,可以根据计算需要实时改变计算图。使用RTX3060 12G显卡和CPU AMD锐龙5800X完成训练及验证结果。

3 试验结果与分析

3.1 基于深度学习的籽粒识别

基于深度学习的分类识别与传统机器学习识别方法对比如表2所示。传统模型通过提取的28个特征进行识别,结果显示KNN的验证集识别准确率最高为93.33%,KNN和SVM训练速度普遍高于卷积神经网络,但卷积神经网络的准确率大多高于KNN和SVM的准确率。在同等条件下,Inception-V3的验证集要比VGG-16和ResNet-50分别高1.33个百分点和1.25个百分点。使用深度学习建立的识别方法要比传统的机器学习识别方法验证集准确率较高,实用性高于机器学习。

3.2 基于迁移学习的籽粒识别

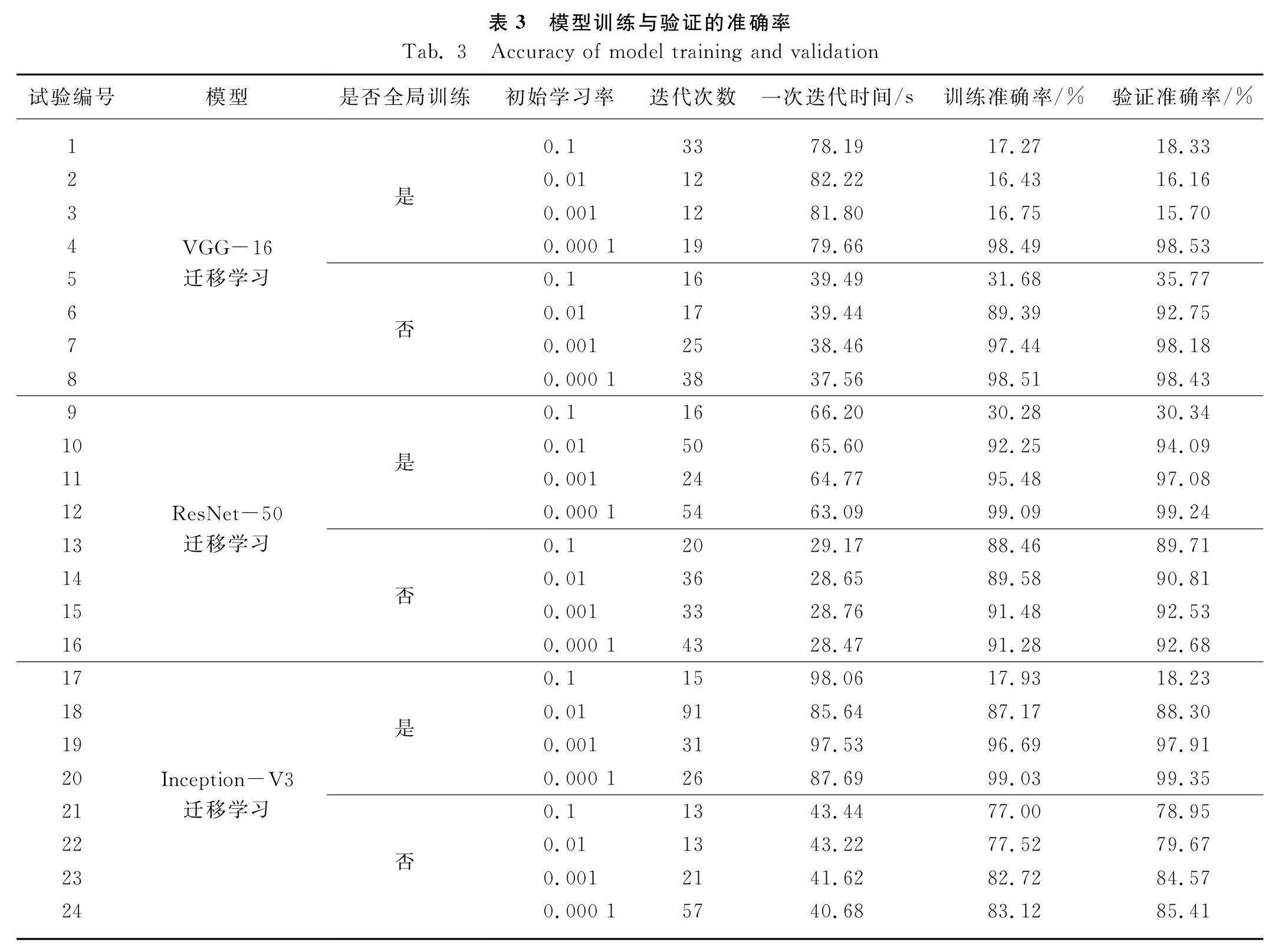

与不迁移学习的模型相比,迁移学习能够明显提升模型的收敛速度以及准确率。各组训练和验证的结果如表3所示,其中迭代次数的不同是指验证集早停技术对结果进行监控,当损失值连续12次不下降时所产生的迭代次数,一次迭代时间指的是通过总时间除以迭代次数所产生的时间。进行全局训练的是指不冻结卷积特征提取层,并和新的分类器参数进行所有参数训练方式,局部训练是指冻结卷积特征提取层,仅对新的分类器进行参数训练方式。试验选择初始学习率为0.1、0.01、0.001、0.000 1进行模型训练。

3.2.1 迁移学习方式对模型准确率的影响

表3为模型训练与验证的准确率,可以看出在相同的参数下,直接训练所有参数的迁移学习方式要明显优于仅训练分类器参数的方式。局部训练参数的迁移学习方式下,试验8的验证集识别准确率最高,为98.43%。全局训练参数的迁移学习方式下,试验20的验证集识别准确率最高,为99.35%。在相同参数下,对比不迁移的模型,VGG-16迁移学习比不迁移学习高1.54个百分点,ResNet-50迁移学习比不迁移学习高2.17个百分点,Inception-V3迁移学习比不迁移学习高1.03个百分点。与不迁移学习的模型相比,迁移学习能够明显提升模型的收敛速度以及准确率。

从验证集的准确率看,进行全局训练的参数模型所得到的验证集准确率明显优局部训练的参数模型,最高的分别为进行全局训练的VGG-16模型初始学习率为0.000 1时,验证集准确率为98.53%;进行全局训练的ResNet-50模型初始学习率为0.000 1时,验证集准确率为99.24%;进行全局训练的Inception-V3模型初始学习率为0.000 1时,验证集准确率为99.35%,Inception-V3模型分别比VGG-16模型和ResNet-50模型高0.82个百分点和0.11个百分点。全局训练所迭代的时间虽然比较多,但准确率是最高的,局部训练的三种模型来看,所训练的时间相对于全局训练要节省相对应的一半,但其准确率相对于全局训练相对较小一点。

3.2.2 初始学习率对模型准确率的影响

从初始学习率看,学习率作为深度学习中重要的超参数,其决定着目标函数是否能收敛到局部最小值或者最优值,设置太大会使结果超过最优值,太小会使损失速度下降过慢,合适的学习率能够使目标在合适的数据内收敛到局部最小值或者最优值。随着初始学习率的下降,训练集和验证集的准确率也随之提升。

在局部训练中ResNet-50的学习率为0.001的时,验证集的准确率为92.53%,学习率为0.000 1时,验证集的准确率为92.68%,说明当学习率为0.001时,已经收敛到接近最优值,再降低学习率也不会明显增加准确率。而初始学习率为0.000 1的时候试验4、试验12、试验20是三种模型中准确率最高的,但时候验证集识别率呈现出一定的波动,尤其是VGG-16中的试验4波动较大,模型不稳定。以上结果表明,采用0.000 1的初始学习率时三种模型泛化能力最强,效果也最优。这是因为选用的微调迁移学习,模型在原始数据上已经收敛,所以设置较小的学习率在新数据上有更好的效果。

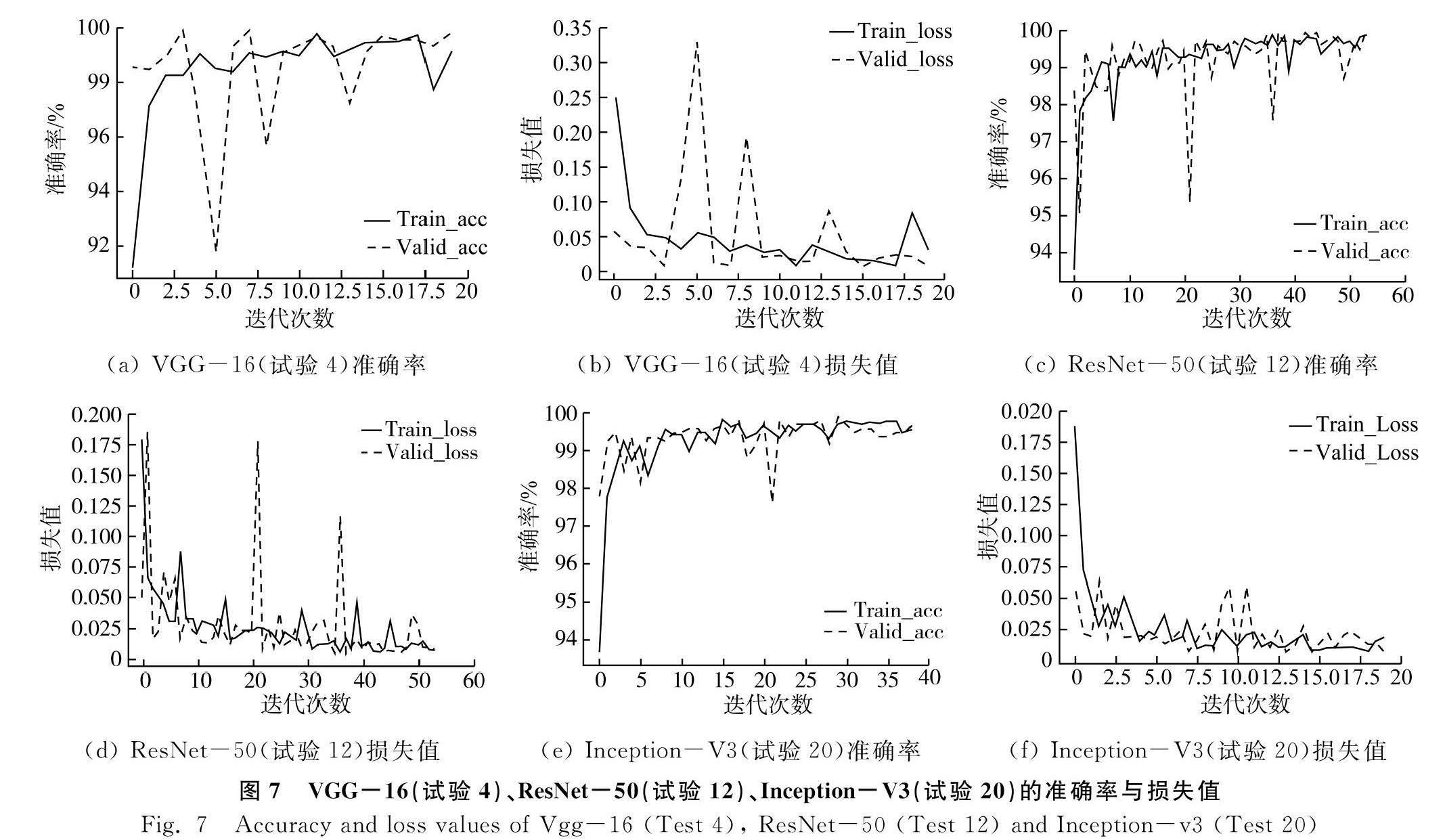

3.2.3 准确率与损失值曲线的分析

从图7来看,三种模型中,VGG-16中验证集的损失值和准确率相对不稳定,验证集损失值在第五次迭代过程中出现了极大的提升,在前15次迭代中有较大的波动,在15次后进入相对稳定状态。ResNet-50中训练集和验证集的损失值和准确率在21次迭代以后相对是平稳的,在40多次的迭代次数中,第21次迭代和第36次迭代中验证集的精度有相对较大的波动,在之后训练中相对稳定状态。Inception-V3中训练集和验证集的损失值和准确率都是趋于相对稳定的状态,相对也是三种模型在全局训练并且学习率在0.000 1的条件下验证集效果最高的。三种模型均在达到稳定状态并且识别准确率明显提高,表明使用迁移学习的网络可以保证准确率和速度的情况下对小麦籽粒进行识别的可行性,在识别前期不用做机器学习对图像进行过多的处理,大大降低了人工操作的成本。

3.2.4 测试集准确率的分析

表4为3种模型VGG16、ResNet-50、Inception-V3在全局训练中学习率为0.000 1时测试集的结果。

可以看出ResNet-50的测试结果最高,高于VGG-16准确率0.22个百分点,高于VGG-16 F1值0.19个百分点;高于Inception-V3准确率0.55个百分点,高于Inception-V3 F1值0.53个百分点,迭代时间是最短的。在VGG-16中,虽然识别率相对于ResNet-50较低一些,训练所需的迭代时间比ResNet-50高一些。在Inception-V3中,验证集虽然是最高的但是在测试集的识别率相对于另外两种模型要低一些,训练所需的迭代时间要比ResNet-50高一些,相较于VGG-16的迭代时间相差不多。综上所述ResNet-50模型全局训练模型运算时间最短且分类效果在测试集上的准确率最高。

3.3 基于迁移学习的三种角度识别结果分析

1) 角度统一的影响。

在以往的试验中,采用的是单粒单图单角度的图片,从结果来看无法达到预期效果,在本试验中,单粒多图多角度的图片识别效果要比单粒单图单角度识别效果更优。通过迁移微调后的网络与现有的小麦识别进行对比,对比试验选择文献[14]和文献[1718]的拍摄方式和试验方法。在三种模型中,通过测试集验证ResNet-50的平均识别率最高为99.77%,结果如表5所示。

2) 三种角度的影响。

为了更好地验证多幅同一小麦籽粒图片的必要性,分别对三种角度在模型中的识别性能进行分析。

试验结果如图8和表6所示,在VGG-16(试验4)中测试集对应的混淆矩阵中品种标签2中有4张图像被误认为了标签1,出现错误上的在腹沟朝前方向1张,腹沟向上方向3张,在三种角度中,腹沟向下的识别率最好。在ResNet-50(试验12)中测试集对应的混淆矩阵中品种标签2中有1张图像被误认为标签1,标签4中有1张图像被误认为标签5,出现错误的在腹沟向上的方向2张,在三种角度中,腹沟向下的识别率最好。

在Inception-V3(试验20)测试集对应的混淆矩阵中品种标签0中有1张圖像被误认为标签3,标签1中有2张图像误认为标签2,标签2中有1张图像被误认为标签0和2张图像被误认为标签1,标签4有1张图像被误认为5,其中腹沟朝前的有4张图像,腹沟向上的有3张图像,在三种角度中,腹沟向下的识别率最好。通过图9可以看出,在ResNet-50(试验12)中三种角度的混淆矩阵中,出现识别错误的都在腹沟向上。综上所述,可以看出从三种角度来讲,腹沟向下识别率最好。进一步验证了单粒多图多角度籽粒图片的必要性。

4 结论

本文试验使用迁移学习的方法,通过改进原模型的结构,将VGG-16,ResNet-50,Inception-V3这三个网络模型对小麦籽粒分类,证明了迁移学习对比深度学习和机器学习更有有效性。

1) 针对小麦籽粒识别分类的问题,采集了6个推广面积比较广的小麦籽粒图像,每个品种分别采集1 000 粒小麦,针对每粒小麦分别采集腹沟向上、腹沟朝前、腹沟向下三种角度的图像,每个品种采集3 000张图像。选择9 000张图片,通过迁移学习的方法将3种典型的卷积神经网络应用到小麦籽粒识别的问题上进行比较,结果表明验证集准确率最高可达99.35%。根据网络的复杂度,网络的训练时间显著差异,全局训练的时间相对于不进行全局训练的时间将近多一倍左右,其中VGG-16网络局部训练时学习率为0.000 1时所训练的时间最短,且验证集准确率比全局训练的准确率低0.1个百分点,为98.43%。尽管使用迁移学习在训练的时间要远大于传统的机器学习,但显著提高了小麦籽粒识别分类的准确率,在小麦籽粒识别方面效果更好。

2) 对比深度学习、机器学习、迁移学习中,迁移学习明显在准确率上高于深度学习和机器学习,通过迁移学习识别的结果可以看出使用迁移学习能够更好地达到识别效果。从三种模型中各选择识别最好的试验,分别为试验4、试验12、试验20,进行其性能比较,结果表明,试验12中ResNet-50的识别速度最快,识别率是最高的,对其三种角度分别测试结果发现腹沟向下跟腹沟朝前的效果最好。试验6和试验22虽然识别率不是最高,但是其识别准确率也不差。从三种模型中分别去看三种角度平均识别率的试验中,腹沟向下的效果在三种模型中效果最好,腹沟朝前的要比腹沟向上的效果要好一点。验证了单粒多图多角度小麦籽粒图片的必要性。

3) 本文6类小麦籽粒采用三种模型进行籽粒识别,通过测试选择出了最优的模型,但是其所迭代时间过长,速度过慢。下一步重点将选择轻量级网络和增加小麦籽粒类别,在不影响识别效率的情况下提高运行速度,从而选择出更适合的模型。

参 考 文 献

[1] 王宁, 程威. 2000—2019年河南省小麦播种面积与产量变化趋势分析[J]. 农业科技通讯, 2021(6): 234-235, 322.

[2] 马斯霜, 白海波, 惠建, 等. 小麦主要品质性状研究进展[J]. 中国农学通报, 2021, 37(24): 1-5.

Ma Sishuang, Bai Haibo, Hui Jian, et al. Main quality characters of wheat: A review [J]. Chinese Agricultural Science Bulletin, 2021, 37(24): 1-5.

[3] 樊超, 夏旭, 石小凤, 等. 基于图像处理的小麦品种分类研究[J]. 河南工业大学学报(自然科学版), 2011, 32(5): 74-78.

Fan Chao, Xia Xu, Shi Xiaofeng, et al. Wheat variety classification based on image processing [J]. Journal of Henan University of Technology (Natural Science Edition), 2011, 32(5): 74-78.

[4] 何红霞. 基于机器视觉的小麦种子品种分类模型研究[D]. 合肥: 安徽农业大学, 2018.

He Hongxia. Study on classification model of wheat seed varieties based on machine vision [D]. Hefei: Anhui Agricultural University, 2018.

[5] 程帅, 李艳玲, 司海平, 等. 基于卷积神经网络的农作物种类自动识别算法研究[J]. 河南科学, 2020, 38(12): 1908-1914.

Cheng Shuai, Li Yanling, Si Haiping, et al. Automatic recognition algorithm of crop species based on convolutional neural network [J]. Henan Science, 2020, 38(12): 1908-1914.

[6] 徐岩, 刘林, 李中远, 等. 基于卷积神经网络的玉米品种识别[J]. 江苏农业学报, 2020, 36(1): 18-23.

Xu Yan, Liu Lin, Li Zhongyuan, et al. Recognition of maize varieties based on convolutional neural network [J]. Jiangsu Journal of Agricultural Sciences, 2020, 36(1): 18-23.

[7] 刘小刚, 范诚, 李加念, 等. 基于卷积神经网络的草莓识别方法[J]. 农业机械学报, 2020, 51(2): 237-244.

Liu Xiaogang, Fan Cheng, Li Jianian, et al. Identification method of strawberry based on convolutional neural network [J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51(2): 237-244.

[8] 张忠志, 薛欢庆, 范广玲. 基于改进卷积神经网络的红枣缺陷识别[J]. 食品与机械, 2021, 37(8): 158-162, 192.

Zhang Zhongzhi, Xue Huanqing, Fan Guangling. Research on jujube defect recognition method based on improved convolution neural network [J]. Food and Machinery, 2021, 37(8): 158-162, 192.

[9] 石晨宇, 周春, 靳鸿, 等. 基于卷积神经网络的农作物病害识别研究[J]. 国外电子测量技术, 2021, 40(9): 93-99.

Shi Chenyu, Zhou Chun, Jin Hong, et al. Research on crop disease recognition based on convolutional neural network [J]. Foreign Electronic Measurement Technology, 2021, 40(9): 93-99.

[10] 邱津怡, 罗俊, 李秀, 等. 基于卷积神经网络的多尺度葡萄图像识别方法[J]. 计算机应用, 2019, 39(10): 2930-2936.

Qiu Jinyi, Luo Jun, Li Xiu, et al. Multi-scale grape image recognition method based on convolutional neural network [J]. Journal of Computer Applications, 2019, 39(10): 2930-2936.

[11] 謝为俊, 丁冶春, 王凤贺, 等. 基于卷积神经网络的油茶籽完整性识别方法[J]. 农业机械学报, 2020, 51(7): 13-21.

Xie Weijun, Ding Yechun, Wang Fenghe, et al. Integrity recognition of camellia oleifera seeds based on convolutional neural network [J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51(7): 13-21.

[12] 刘嘉政. 基于深度迁移学习模型的花卉种类识别[J]. 江苏农业科学, 2019, 47(20): 231-236.

Liu Jiazheng. Flower species identification based on deep transfer learning model [J]. Jiangsu Agricultural Sciences, 2019, 47(20): 231-236.

[13] 王東方, 汪军. 基于迁移学习和残差网络的农作物病害分类[J]. 农业工程学报, 2021, 37(4): 199-207.

Wang Dongfang, Wang Jun. Crop disease classification with transfer learning and residual networks [J]. Transactions of the Chinese Society of Agricultural Engineering, 2021, 37(4): 199-207.

[14] 何胜美, 李仲来, 何中虎. 基于图像识别的小麦品种分类研究[J]. 中国农业科学, 2005(9): 1869-1875.

He Shengmei, Li Zhonglai, He Zhonghu. Classification of wheat cultivar by digital image analysis [J]. Scientia Agricultura Sinica, 2005(9): 1869-1875.

[15] Punn M, Bhalla N. Classification of wheat grains using machine algorithms [J]. International Journal of Science and Research (IJSR), 2013, 2(8): 363-366.

[16] 孟惜, 王克俭, 韩宪忠. 基于改进BP网络的小麦品种识别[J]. 贵州农业科学, 2017, 45(10): 156-160.

Meng Xi, Wang Kejian, Han Xianzhong. Classification of wheat varieties by improved BP neural network [J]. Guizhou Agricultural Science, 2017, 45(10): 156-160.

[17] 陈文根, 李秀娟, 吴兰. 基于深度卷积网络的小麦品种识别研究[J]. 粮食储藏, 2018, 47(2): 1-4, 13.

Chen Wengen, Li Xiujuan, Wu Lan. Research on wheat variety identification based on deep convolution network [J]. Grain Storage, 2018, 47(2): 1-4, 13.

[18] Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition [J]. arXiv preprint arXiv: 1409.1556, 2014.

[19] He K, Zhang X, Ren S, et al. Deep residual learning for image recognition [C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 770-778.

[20] Szegedy C, Liu W, Jia Y, et al. Going deeper with convolutions [C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2015: 1-9.

[21] Szegedy C, Vanhoucke V, Ioffe S, et al. Rethinking the inception architecture for computer vision [C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 2818-2826.