基于YOLOv5模型的飞蓬属入侵植物目标检测

李宗南 蒋怡 王思 李源洪 黄平 魏鹏

摘要:为应用深度学习模型实现机器快速准确识别农田恶性杂草,以田间常见的2种飞蓬属入侵植物为对象,采集样本图像并标注杂草目标,基于网络结构深度、宽度可调的一阶段目标检测模型YOLOv5搭建训练平台和嵌入式测试平台,训练14组具有不同网络层和卷积核的模型权重,验证模型精度及检测帧率。结果表明:不同网络结构深度、宽度设置的YOLOv5模型识别飞蓬属入侵植物的平均精度为91.8%~95.1%,有8组权重的平均精度优于YOLOv3的,合理增加网络层和卷积核能提高模型精度;YOLOv5在训练平台的帧率为28~109fps之间,在测试平台的帧率为12~58fps之间,有12组权重的帧率比YOLOv3的有显著提高,帧率受平台算力限制并随网络层和卷积核增加而下降,在算力较低的嵌入式系统中实现实时检测需平衡模型网络结构的设置。该研究结果可为搭建农田杂草智能感知系统提供参考。

关键词:深度学习;目标检测;卷积神经网络;入侵植物;杂草;智慧农业

中图分类号:S24

文献标识码:A

文章编号:20955553 (2023) 070200

07

Object detection of invasive Erigeron L. plants base on YOLOv5

Li Zongnan, Jiang Yi, Wang Si, Li Yuanhong, Huang Ping, Wei Peng

(Institute of Remote Sensing and Digital Agriculture, Sichuan Academy of Agricultural Sciences,

Chengdu, 610066, China)

Abstract: In order to achieve fast and accurate identification of malignant weeds in agricultural fields using deep learning models, this study took two common invasive plants of Erigeron L. in the fields, collected sample images and labeled weed targets, and built a training platform and an embedded test platform based on YOLOv5 with adjustable depth and width of network structure. Fourteen groups of model weights with different network layers and convolution kernels were trained, and the accuracy and detection frame rate were evaluated. The results showed that the average precision of YOLOv5 with different network structure depth and width settings for identifying invasive plants ranged from 91.8% to 95.1%. Eight groups of weights achieved higher average precision than YOLOv3, indicating that the increase of network layers and convolution kernels can improve the model accuracy. The results also showed that frame rates of YOLOv5 were between 28 to 109 fps on the training platform and between 12 to 58 fps on the test platform. Twelve sets of weights exhibited significantly improved frame rates compared to YOLOv3. The frame rate is limited by the computing capability of the platform and decreases with the increase of network layers and convolution kernels. To realize real-time detection in the embedded system with low compute capability, a balanced network structure setting is needed. The results of this study can provide a reference for building an intelligent weed sensing system in agricultural fields.

Keywords: deep learning; object detection; CNN; invasive plants; weeds; smart agriculture

0 引言

外來入侵植物对中国自然生态系统、农业生产系统有严重危害[12]。自2003年以来,中国已发布4批共计70种危害性大的外来入侵物种,其中入侵植物40种涉及14科。入侵植物中菊科比例最多,有17种,且大部分成为农业恶性杂草。在农田环境中,恶性杂草通过阳光、水分、养分等资源竞争及化感作用影响作物生长,是降低农产品产量和品质的重要因子之一[25]。杂草防治的方法包括农业防治、生物防治、物理机械防治、化学防治等[1]。农业防治包括轮作、间作、套作、耕翻整地、绿肥作物种植、田间水肥管理、综合种养、覆盖地膜等方式[3, 5]。恶性杂草在作物苗期中极易疯狂生长,在农业防治措施不能有效控制杂草的情况下,需人工进一步使用工具、机械、化学药剂等直接防治杂草[4]。随着中国农业劳动力减少、农业生产逐步向规模化、专业化方式发展,除草机械逐步被应用于农田、果园场景以提高除草效率[6]。智能除草机械集成智能感知、精准定位、精准操作、定量施用等子系统,具有降低劳动强度、提高效率、减少污染等潜力,研发适于不同环境、满足不同作物管理需求的智能除草机器成为农业杂草防控的重要发展方向[78]。

杂草的机器视觉识别作为智能除草的关键技术之一[9],通过彩色、光谱、深度等传感器获取数据,经特征分析与处理,达到区分杂草与土壤背景、作物的目的[1014]。早期目标检测方法通过颜色[10, 12]、光谱指数[13, 15]、深度图像[16]等特征建立突出杂草、作物及土壤背景的指标,使用阈值分割[12]、人工神经网络[10, 14, 17]、支持向量机[1819]等算法实现杂草目标识别,普遍没有使用滑动窗口检测目标,存在准确率低、不规则目标检测的鲁棒性较差等问题。随深度学习算法的发展[20],目标识别与检测形成以图像区域提取的两阶段目标检测模型和直接对类别和位置进行回归确定的一阶段目标检测模型二大类。前者代表算法为Faster R-CNN[21],后者代表算法有SSD[22]、YOLO[23]等。基于深度學习模型的目标检测法已成为当前杂草机器视觉识别应用的主要选择[24]。国外研究显示基于无人机影像和卷积神经网络的大豆田杂草识别精度优于98%[25];不同结构的深度卷积神经网络模型识别不同类型杂草的性能存在较大差异[26]。国内研究基于Faster R-CNN[2728]、YOLO v3[29]等深度学习目标检测模型进行棉田杂草识别训练。对比Faster R-CNN先提取目标候选框后分类的二阶段目标检测,YOLO算法将目标分类问题和目标位置确定问题通过回归方法统一求取,检测速度更快,实时性更佳,成为诸多实时目标检测场景的首选方法,并得到广泛的改进和应用。

针对当前农业恶性杂草智能感知、防治需求,该研究开展基于YOLOv5模型的杂草智能识别算法性能评测。受气候、耕作模式和种植制度等因素影响,杂草群落的空间分布和演替有区域差异,部分杂草在特定范围形成优势群落,危害农业;因此该研究选择中国西南地区常见的2种菊科飞蓬属入侵植物为识别对象,采集农田、果园、田间道路两旁等多种环境下的杂草图片建立样本数据集,训练并检验模型,为机器感知、防治恶性杂草提供技术参考。

1 数据与方法

1.1 数据采集与标注

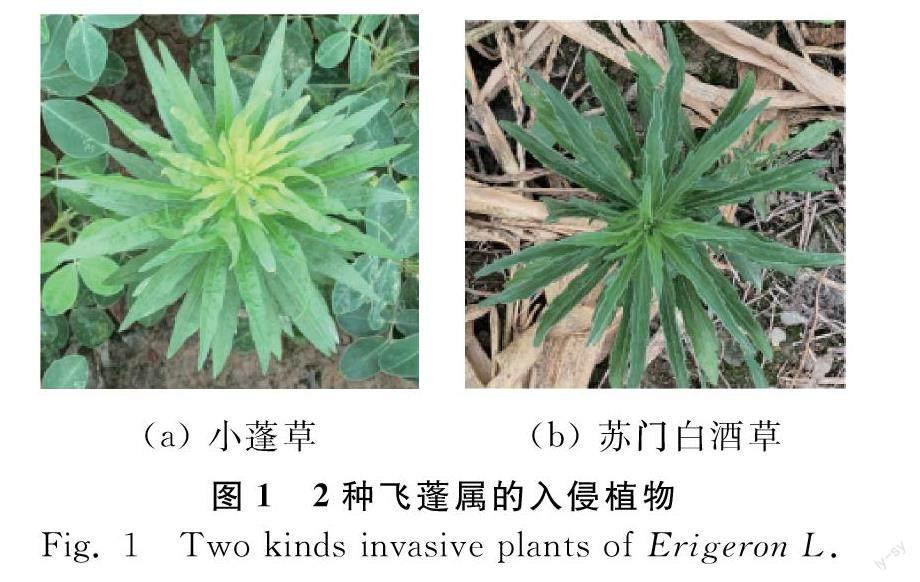

使用彩色相机以垂直地面的视场角度为主采集杂草图片。于2021年6—8月分4次在成都市周边果园、农田内共获取杂草自苗期到开花期的图片共计438幅。飞蓬属(Erigeron L.),被子植物门菊科植物,多年生、稀一年生或二年生草本,或半灌木,全属约有200种以上,主要分布于欧洲、亚洲大陆及北美洲,少数也分布于非洲和大洋洲,我国有35种,主要集中于新疆和西南部山区[30]。小蓬草(学名:Erigeron canadensis L.,异名:Conyza canadensis)、苏门白酒草(学名:Erigeron sumatrensis Retz.,异名:Conyza sumatrensis),均为菊科飞蓬属,于2014年进入中国外来入侵物种名单(第三批),如图1所示。该研究参考中国科学院植物研究所“植物志-植物物种信息系统”物种信息系统(http://www.iplant.cn/)提供的图像,对采集的图像进行识别。使用Labelme标注图像中的目标杂草,完成杂草标签共计1465个。完成标注后,转为YOLO模型运行所需文件格式。

1.2 模型与试验平台

1.2.1 YOLOv5模型

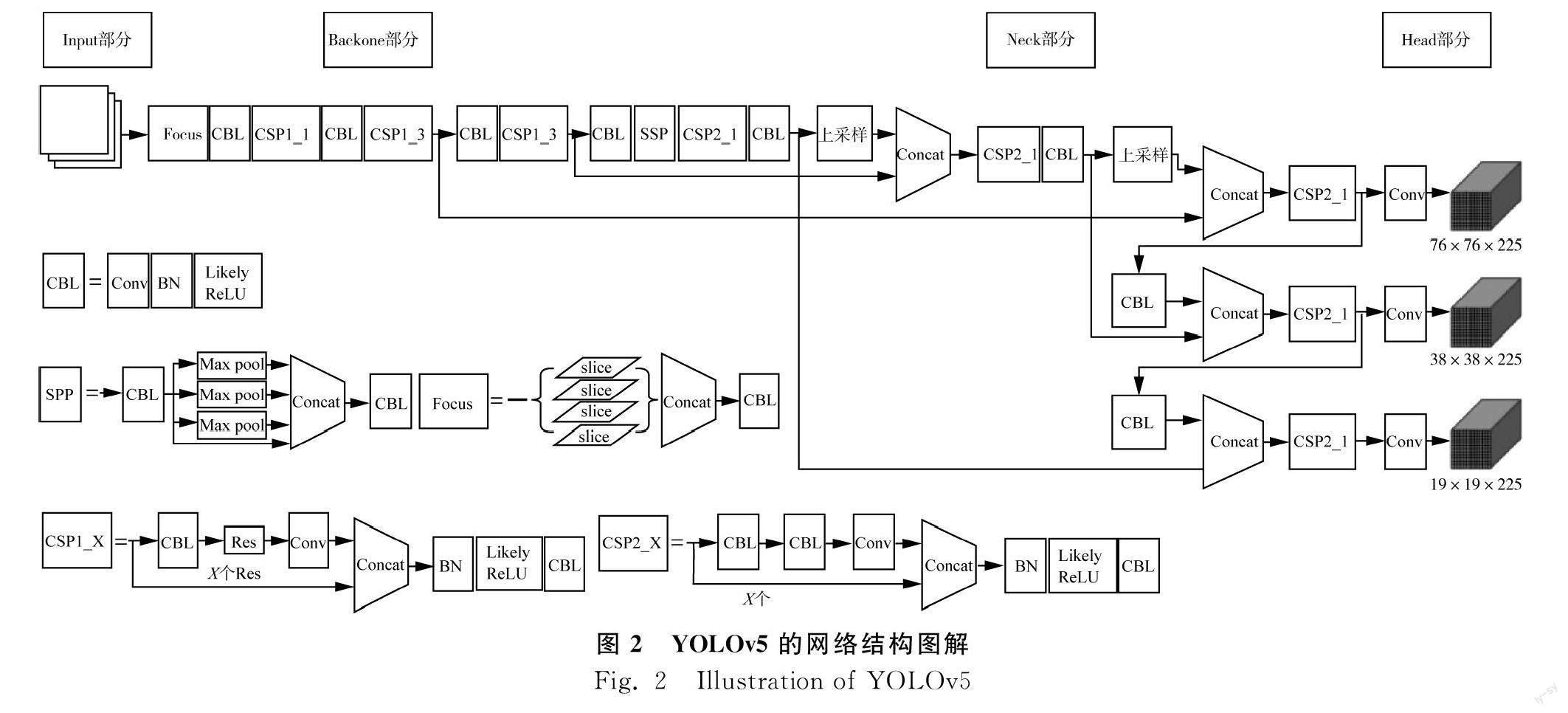

YOLO自2015年发布v1版,到2020年已发展到v5版,其发展和改进借鉴空间金字塔池化(SPP)[31]、残差网络(ResNet)[32]、跨阶段网络(CSP)[33]、特征图金字塔网络(FPN)[34]、路径聚合网络(PAN)[35]等相关深度学习研究成果。YOLOv5的网络结构分为输入(Input)、骨干(Backbone)、颈部(Neck)、头部(Heads)等四个部分。v5版目前仍持续发布更新,该研究选择v5版第五次正式释放的版本。以YOLOv5s为例,该模型网络结构示意见图2,其中,Conv为卷积操作,Concat为张量拼接操作,Res为残差网络组件。CBL为卷积、批量归一化(BN)、Likely激活三者相连的网络结构;SPP使用3个尺度的最大池化核和1个连接进行池化操作。Focus网络层的操作是对图片各通道数据每隔一个像素取一个值形成切片,然后堆叠。CSP1、CSP2为两种不同结构的跨阶段局部网络,前者用于Backbone,后者用于Neck,在CSP1网络层中使用残差网络。

Iuput部分具有Mosaic数据增强、自适应锚框计算、自适应图片缩放等功能,实现数据集丰富和训练速度提升。Backbone部分包括Focus、CBL、CSP1等网络结构,实现多视野感受、多特征提取。Neck部分包括CBL、CSP2、SPP、上采样(改进的FPN)、下采样(改进的PAN)结构,通过上采样、下采样、连接等实现多尺度特征融合。Heads部分采用CIoU_loss损失函数、DIoU-NMS非极大值抑制算法[36]实现目标类型识别和位置确定。通过设置Backbone和Neck部分不同的网络深度和宽度,可调节模型的网络层和卷积核数量。

1.2.2 训练平台

训练平台硬件配置主要包括i9-11900F中央处理器、128 GB内存、Quadro RTX 4000 GPU(显存8 GB、CUDA核2 304个)。软件配置主要包括Windows 10操作系统、CUDA11.1、cudnn8.0.5、Pytorch1.8、YOLOv5。

1.2.3 模型设置及训练

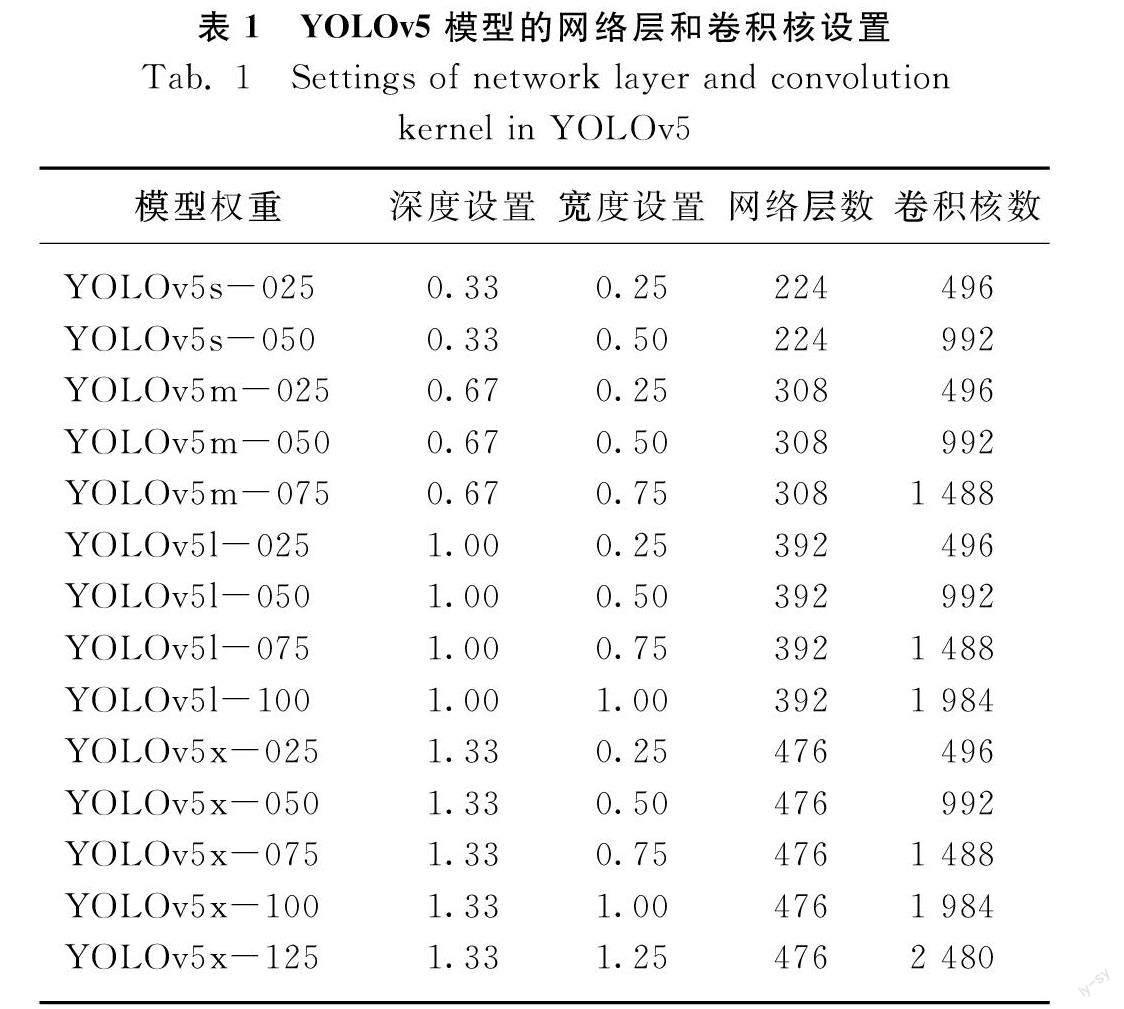

YOLOv5的第五次发行版公开了4个不同深度和宽度网络的预训练权重文件,分别为YOLOv5s.pt、YOLOv5m.pt、YOLOv5l.pt、YOLOv5x.pt。该研究以此4个权重文件,通过调整各模型的宽度设置,形成14个具有不同网络层和卷积核的模型,具体见表1。限于训练平台GPU显存,各模型权重训练的bitch size、image size均设置为4和640,训练次数Epoch设置为300。训练和测试的样本数比例为0.85∶0.15。

1.2.4 模型精度评价

为评价YOLOv5模型不同网络结构设置的性能,以YOLOv3模型为参考,使用准确率(Precision,P)、召回率(Recall,R)、平均精度(Average Precision,AP)3项指标评价模型检测杂草的精度。

P=TPTP+FP×100%

R=TPTP+FN×100%

AP=1n∑nk=1P(k)·ΔR(k)

式中:

TP——模型检测为正的正样本数;

FP——模型检测为正的负样本数;

FN——模型检测为负的正样本;

ΔR——

区间(k,k+1)的召回率变化值。

P反映模型检测的错检情況,R反映模型检测的漏检情况。AP综合反映模型的精度,由精确率和召回率变化情况决定,该研究使用交并比等于0.5的平均精度。

1.2.5 运行帧率测试

使用帧率评价模型在平台上运行时处理图像的效率。帧率是反映模型和平台数据处理效率的指标,机器进行实时检测时,检测帧率需大于图像采集帧率,以保证不漏检。一般流畅的实时监测要求图像采集帧率大于24帧。该研究在训练平台和测试平台上测试不同模型的帧率。

测试平台采用Jetson Xavier NX嵌入式计算板,该板集成6核ARM CPU、8GB内存、384个CUDA核,软件平台为Ubuntu18.04、CUDA10.2、cudnn8.0.5、Python3.6、Pytorch1.8、TensorTR,YOLOv5。测试平台上使用engine格式的权重文件。engine文件是pt文件经TensorRT转换得到,转换后模型使用INT8和FP16精度的数据计算,且部分运算合并,从而实现低算力嵌入式测试平台的运算加速。

2 结果与分析

2.1 不同网络结构深度、宽度设置的模型精度

使用14组不同设置的YOLOv5检测2种入侵植物,准确率为86.9%~94.1%,召回率为83.2%~91.9%,平均精度为91.8%~95.1%,具体各组设置的精度见表2。从表2可以看出,在固定网络层数的情况下,增加卷积核具有提高模型精度的潜力,但在网络层较少的结构中增加过多的卷积核则可能降低AP,具体表现为:YOLOv5s在宽度设置为0.50时的AP高于设置为0.25的;YOLOv5m在宽度设置为0.75时的AP高于设置为0.5的,但较之设置为0.25时的AP无提高;YOLOv5l随宽度设置由0.25逐步增加到1.00,AP表现为先增后减。在固定卷积核数的情况下,增加网络层数具有提高模型目标精度的潜力,但在卷积核较少的结构中设置过多的网络层亦可能降低AP,具体表现为:当宽度设置为0.25时,深度设置值更大的YOLOv5m较YOLOv5s的AP提高,但具有更大深度设置值的YOLOv5l与YOLOv5x的AP均低于YOLOv5m;宽度设置为0.50、0.75、1.00时,深度设置最大的YOLOv5x的AP高于其他的。综上,单一增加过多的网络层数或卷积核数可能会导致模型平均精度下降,同时合理增加网络层和卷积核有助于最大限度地提高模型识别杂草的精度。

对比YOLOv3,YOLOv5有3组设置的AP略有降低,有3组设置的AP与之相同,有8组设置的AP有提高。其中YOLOv5x-050、YOLOv5x-125较YOLOv3的分别提高1.5和2.8个百分点。三者检测飞蓬属入侵植物的效果见图3,YOLOv5x-050、YOLOv5x-125漏检数量比YOLOv3少,符合各模型的召回率表现。

2.2 不同网络结构深度、宽度设置的帧率

从表3可以看出,训练平台中,YOLOv5模型14组不同设置的检测帧率在28~109fps之间,有12组设置的帧率较YOLOv3有明显提升。嵌入式测试平台中,YOLOv5不同设置的检测帧率在12~58fps之间,低于训练平台。模型在训练平台和测试平台上运行的帧率均随深度、宽度设置值增加而逐步降低。较高算力的训练平台中,模型各组设置的检测帧率均超过视频常用的24fps;较低算力的测试平台中,有3组设置的帧率低于24fps,其中平均精度最高的YOLOv5x-125受限于网络层和卷积层多、计算量大,其帧率仅为12fps,未达到实时检测的要求。因此在算力较低的嵌入式系统中实现实时检测需平衡网络结构设置,需选择次优AP的模型深度、宽度设置,以保证数据流畅处理。该研究中,YOLOv5x-050在测试平台的帧率为33fps,AP仅次于YOLOv5x-125,满足实时高精度检测要求。

3 讨论

该研究对中国西南地区常见的小蓬草和苏门白酒草进行有监督的机器学习识别,目标识别精度受模型性能和样本影响。模型方面,YOLO系列模型持续改进,不断集成诸多网络层的优点,使之性能水平逐步提高。该研究通过设置不同的网络深度和宽度参数调整YOLOv5模型网络结构,评选满足算力要求且精度最优的入侵植物检测模型权重,结果表明调整网络结构参数能小幅度提高检测精度,合理设置YOLOv5的网络层和卷积核数量能获得比YOLOv3更优的精度和检测效率。样本方面,该研究采集的样本数据量仅能满足小飞蓬和苏门白酒草2种入侵植物的检测。国内各地的外来入侵植物种类及优势群落不同,为满足实际的杂草检测还需采集和丰富样本数据,以构建能识别多种恶性杂草的目标检测模型。为保证样本数据质量,图片采集时,拍摄角度、距离、曝光时间等影响图片效果的因素应按更为规范统一的方式进行。为构建更为精细的识别模型、获取更多植物的种类信息,目标植物的属、种及植物生长期等具体信息应标注说明。

4 结论

1) 通过采集飞蓬属小蓬草、苏门白酒草2种外来入侵植物的样本数据,搭建基于YOLOv5模型的训练平台和测试平台,训练14组具有不同网络层和卷积核的模型权重,模型经精度检验及性能测试。

2) 不同网络深度、宽度设置的YOLOv5模型识别飞蓬属入侵植物的平均精度为91.8%~95.1%,有8组网络结构设置的平均精度优于YOLOv3;YOLOv5在训练平台的帧率为28~109fps之间,在嵌入式测试平台的帧率为12~58fps之间,有12组网络结构设置的帧率比YOLOv3的有显著提高。基于YOLOv5深度学习模型能实现快速准确的外来入侵植物检测,该研究各项测试结果可为下一步搭建杂草机器检测系统、配置平台算力等工作提供参考依据。

参 考 文 献

[1] 万方浩, 侯有明, 蒋明星. 入侵生物学[M]. 北京: 科学出版社, 2015.

[2] 闫小玲, 寿海洋, 马金双. 中国外来入侵植物研究现状及存在的问题[J]. 植物分类与资源学报, 2012, 34(3): 287-313.

Yan Xiaoling, Shou Haiyang, Ma Jinshuang. The problem and status of the alien invasive plants in China [J]. Plant Diversity and Resources, 2012, 34(3): 287-313.

[3] 赵玉信, 杨惠敏. 作物格局、土壤耕作和水肥管理对农田杂草发生的影响及其调控机制[J]. 草业学报, 2015, 24(8): 199-210.

Zhao Yuxin, Yang Huimin. Effects of crop pattern, tillage practice and water and fertilizer management on weeds and their control mechanisms [J]. Acta Prataculturae Sinica, 2015, 24(8): 199-210.

[4] 李香菊. 近年我国农田杂草防控中的突出问题与治理对策[J]. 植物保护, 2018, 44(5): 77-84.

Li Xiangju. Main problems and management strategies of weeds in agricultural fields in China in recent years [J]. Plant Protection, 2018, 44(5): 77-84.

[5] 孙金秋, 任相亮, 胡红岩, 等. 农田杂草群落演替的影响因素综述[J]. 杂草学报, 2019, 37(2): 1-9.

Sun Jinqiu, Ren Xiangliang, Hu Hongyan, et al. The factors influencing weed community succession in the crop field [J]. Journal of Weed Science, 2019, 37(2): 1-9.

[6] 吕沐华, 丁珠玉. 基于机器视觉的果园喷药除草机器人视觉系统设计[J]. 中国农机化学报, 2021, 42(5): 42-48.

Lü Muhua, Ding Zhuyu. Design of visual systems for orchard spraying weeding robot based on machine vision [J]. Journal of Chinese Agricultural Mechanization, 2021, 42(5): 42-48.

[7] 傅雷扬, 李绍稳, 张乐, 等. 田间除草机器人研究进展综述[J]. 机器人, 2021, 43(6): 751-768.

Fu Leiyang, Li Shaowen, Zhang Le, et al. Research progress on field weeding robots: A review [J]. Robot, 2021, 43(6): 751-768.

[8] 兰天, 李端玲, 张忠海, 等. 智能农业除草机器人研究现状与趋势分析[J]. 计算机测量与控制, 2021, 29(5): 1-7.

Lan Tian, Li Duanling, Zhang Zhonghai, et al. Analysis on research status and trend of intelligent agricultural weeding robot [J]. Computer Measurement & Control, 2021, 29(5): 1-7.

[9] Aichen W, Wen Z, Xinhua W. A review on weed detection using ground-based machine vision and image processing techniques [J]. Computers and Electronics in Agriculture, 2019, 158: 226-240.

[10] Aitkenhead M J, Dalgetty I A, Mullins C E, et al. Weed and crop discrimination using image analysis and artificial intelligence methods [J]. Computers and Electronics in Agriculture, 2003, 39(3): 157-171.

[11] 毛文华, 曹晶晶, 姜紅花, 等. 基于多特征的田间杂草识别方法[J]. 农业工程学报, 2007, 122(11): 206-209.

Mao Wenhua, Cao Jingjing, Jiang Honghua, et al. In-field weed detection method based on multi-features [J]. Transactions of the CSAE, 2007, 23(11): 206-209.

[12] 毛罕平, 胡波, 張艳诚, 等. 杂草识别中颜色特征和阈值分割算法的优化[J]. 农业工程学报, 2007, 23(9): 154-158.

Mao Hanping, Hu Bo, Zhang Yancheng, et al. Optimization of color index and threshold segmentation in weed recognition [J]. Transactions of the CSAE, 2007, 23(9): 154-158.

[13] 赵川源, 何东健, 乔永亮. 基于多光谱图像和数据挖掘的多特征杂草识别方法[J]. 农业工程学报, 2013, 29(2): 192-198.

Zhao Chuanyuan, He Dongjian, Qiao Yongliang. Identification method of multi-feature weed based on multi-spectral images and data mining [J]. Transactions of the CSAE, 2013, 29(2): 192-198.

[14] Granitto P M, Verdes P F, Ceccatto H A. Large-scale investigation of weed seed identification by machine vision [J]. Computers and Electronics in Agriculture, 2005, 47(1): 15-24.

[15] Alchanatis V, Ridel L, Hetzroni A, et al. Weed detection in multi-spectral images of cotton fields [J]. Computers and Electronics in Agriculture, 2005, 47(3): 243-260.

[16] Piron A, Leemans V, Lebeau F, et al. Improving in-row weed detection in multispectral stereoscopic images [J]. Computers and Electronics in Agriculture, 2009, 69(1): 73-79.

[17] Torres-sospedra J, Nebot P. Two-stage procedure based on smoothed ensembles of neural networks applied to weed detection in orange groves [J]. Biosystems Engineering, 2014, 123: 40-55.

[18] Pérez-Ortiz M, Pea J M, Gutiérrez P A, et al. A semi-supervised system for weed mapping in sunflower crops using unmanned aerial vehicles and a crop row detection method [J]. Applied Soft Computing, 2015, 37: 533-544.

[19] Bakhshipour A, Jafari A. Evaluation of support vector machine and artificial neural networks in weed detection using shape features [J]. Computers and Electronics in Agriculture, 2018, 145: 153-160.

[20] Lecun Y, Bengio Y, Hinton G E. Deep learning [J]. Nature, 2015, 521(7553): 436-444.

[21] Shaoqing R, Kaiming H, Ross G, et al. Faster R-CNN: Towards real-time object detection with region proposal networks [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[22] Wei L, Dragomir A, Dumitru E, et al. SSD: Single shot multibox detector [C]. Springer International Publishing, 2016: 21-37.

[23] Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection [C]. IEEE Conference on Computer Vision and Pattern Recognition. 2016: 779-788.

[24] Hasan A S M, Sohel F, Diepeveen D, et al. A survey of deep learning techniques for weed detection from images [J]. Computers and Electronics in Agriculture, 2021, 184.

[25] Alessandro D S F, Matte Freitas D, Gercina G D S, et al. Weed detection in soybean crops using ConvNets [J]. Computers and Electronics in Agriculture, 2017, 143: 314-324.

[26] Yu J, Sharpe S M, Schumann A W, et al. Deep learning for image-based weed detection in turf grass [J]. European Journal of Agronomy, 2019, 104: 78-84.

[27] 樊湘鵬, 周建平, 许燕, 等. 基于优化Faster R-CNN的棉花苗期杂草识别与定位[J]. 农业机械学报, 2021, 52(5): 26-34.

Fan Xiangpeng, Zhou Jianping, Xu Yan, et al. Identification and localization of weeds based on optimized Faster R-CNN in cotton seedling stage under natural conditions [J]. Transactions of the Chinese Society for Agricultural Machinery, 2021, 52(5): 26-34.

[28] 李春明, 逯杉婷, 远松灵, 等. 基于Faster R-CNN的除草机器人杂草识别算法[J]. 中国农机化学报, 2019, 40(12): 171-176.

Li Chunming, Lu Shanting, Yuan Songling, et al. Weed identification algorithm of weeding robot based on Faster R-CNN [J]. Journal of Chinese Agricultural Mechanization, 2019, 40(12): 171-176.

[29] 薛金利, 戴建国, 赵庆展, 等. 基于低空无人机影像和YOLOv3实现棉田杂草检测[J]. 石河子大学学报(自然科学版), 2019, 37(1): 21-27.

Xue Jinli, Dai Jianguo, Zhao Qingzhan, et al. Cotton field weed detection based on low-altitude drone image and YOLOv3 [J]. Journal of Shihezi University(Natural Science), 2019, 37(1): 21-27.

[30] 中国植物志编辑委员会. 中国植物志[M]. 北京: 科学出版社, 1985.

[31] He Kaiming, Zhang Xiangyu, Ren Shaoqing, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1904-1916.

[32] He Kaiming, Zhang Xiangyu, Ren Shaoqing, et al. Deep residual learning for image recognition [C]. IEEE Conference on Computer Vision and Pattern Recognition, 2016: 770-778.

[33] Wang C Y, Liao H Y M, Wu Y H, et al. CSPNet: A new backbone that can enhance learning capability of CNN [C]. Proceedings of the IEEE/CVF conference on computer vision and pattern recognition workshops. 2020: 390-391.

[34] Lin T Y, Pollr P, Girshick R, et al. Feature pyramid networks for object detection [C]. IEEE Conference on Computer Vision and Pattern Recognition, 2017: 936-944.

[35] Shu L, Lu Q, Haifang Q, et al. Path aggregation network for instance segmentation [C]. IEEE Conference on Computer Vision and Pattern Recognition, 2018: 8759-8768.

[36] Zheng Z, Wang P, Liu W, et al. Distance-IoU loss: Faster and better learning for bounding box regression [C]. Proceedings of the AAAI conference on artificial intelligence. 2020, 34(7): 12993-13000.