基于孪生网络的无人机目标多模态融合检测

韩自强,岳明凯,张 骢,高 棋

基于孪生网络的无人机目标多模态融合检测

韩自强,岳明凯,张 骢,高 棋

(沈阳理工大学 装备工程学院,辽宁 沈阳 110159)

为解决小型无人机“黑飞”对公共领域的威胁问题。基于无人机目标多模态图像信息,文中提出一种轻量化多模态自适应融合孪生网络(Multimodal adaptive fusion Siamese network,MAFS)。设计一种全新的自适应融合策略,该模块通过定义两个模型训练参数赋予不同模态权重以实现自适应融合;本文在Ghost PAN基础上进行结构重建,构建一种更适合无人机目标检测的金字塔融合结构。消融实验结果表明本文算法各个模块对无人机目标检测精度均有提升,多算法对比实验结果表明本文算法鲁棒性更强,与Nanodet Plus-m相比检测时间基本不变的情况下mAP提升9%。

无人机;轻量化;孪生网络;自适应融合策略;多模态图像

0 引言

无人机因其具有造价低、安全风险系数小和机动性强等优点在军民领域有着广泛的应用[1-3]。然而无人机的“黑飞”、“滥飞”现象日益增多对社会公共安全构成严重威胁。无人机目标具有飞行高度低、速度慢等特点,这使得通过传统雷达和无线电检测方法变得困难且成本高;基于声音检测无人机受噪声干扰较大且检测不明显。除上述方法外,基于二维图像数据的数据驱动方法也逐渐应用于无人机检测中并取得了较好的效果。

基于数据驱动的目标检测方法主要以可见光图像作为输入源,但随着检测场景的复杂化和多元化仅靠单一的可见光图像作为输入无法有效获取图像中目标信息[4-5]。由于红外成像设备主要利用目标辐射或反射的能量成像,与可见光图像相比它不受光照影响,但存在图像纹理特征缺失严重、对比度与分辨率低等情况。因此需要设计一种多模态目标检测算法充分利用可见光图像提供的纹理信息和红外图像提供的热辐射信息,进而提升无人机目标检测准确度。

孪生网络是一类包含2个或多个分支的神经网络架构,各个分支共享网络参数。孪生网络通常以多个样本作为输入,利用输出结果实现多样本输入特征融合。孪生网络多用于计算机视觉领域。在目标检测领域有学者提出一种基于YOLOv2的轻量级目标检测模型[6],首先通过共享权重的特征提取网络提取多分支输入图像特征,之后利用注意力模块实现多特征融合。在目标跟踪领域中,基于孪生网络的目标跟踪算法如Siamese FC[7],只使用离线训练的模型对目标区域和模板区域进行相似度匹配,不需要在跟踪过程中对模型进行实时更新。利用孪生网络架构可以极大地提升算法推理效率,实现实时性目标检测或目标跟踪。同时利用多分支输入特征,可以提高算法在目标检测领域中的检测精度。

根据融合阶段的不同可以将检测融合算法分为3类,分别为像素级融合检测、特征级融合检测和决策级融合检测[8]。像素级融合检测就是先将红外与可见光图像进行融合,再对融合后的图像进行检测。这种方法好处是检测与融合完全分开可以使用已有的融合算法处理图像,但往往也会产生大量的数据冗余增加了检测时间和后续检测的难度。白玉、宁大海等[9-11]使用决策级融合检测,首先采用卷积神经网络对可见光与红外图像分别进行目标检测,再根据提出的融合策略对检测结果进行融合,但该方法只是对检测结果的融合,缺乏对目标特征信息的互补。马野、解宇敏等[12-14]将可见光与红外图像同时输入神经网络后分别进行特征提取,然后进行目标检测后输出结果。现有方法虽然在不同阶段对红外与可见光信息进行融合,但网络结构的局限性导致检测速度过慢且难以部署到检测设备。

本文利用孪生网络架构提出一种多模态自适应融合无人机目标检测算法(MAFSnet)。该算法首先通过共享卷积权重的轻量化孪生网络分别提取红外与可见光图像的特征信息,接着将提取的特征按照指定的融合策略进行自适应融合。将融合后的特征信息通过改进的Ghost PAN结构实现多尺度信息交互,最后通过简易检测头输出最终的预测结果。

1 特征融合检测算法

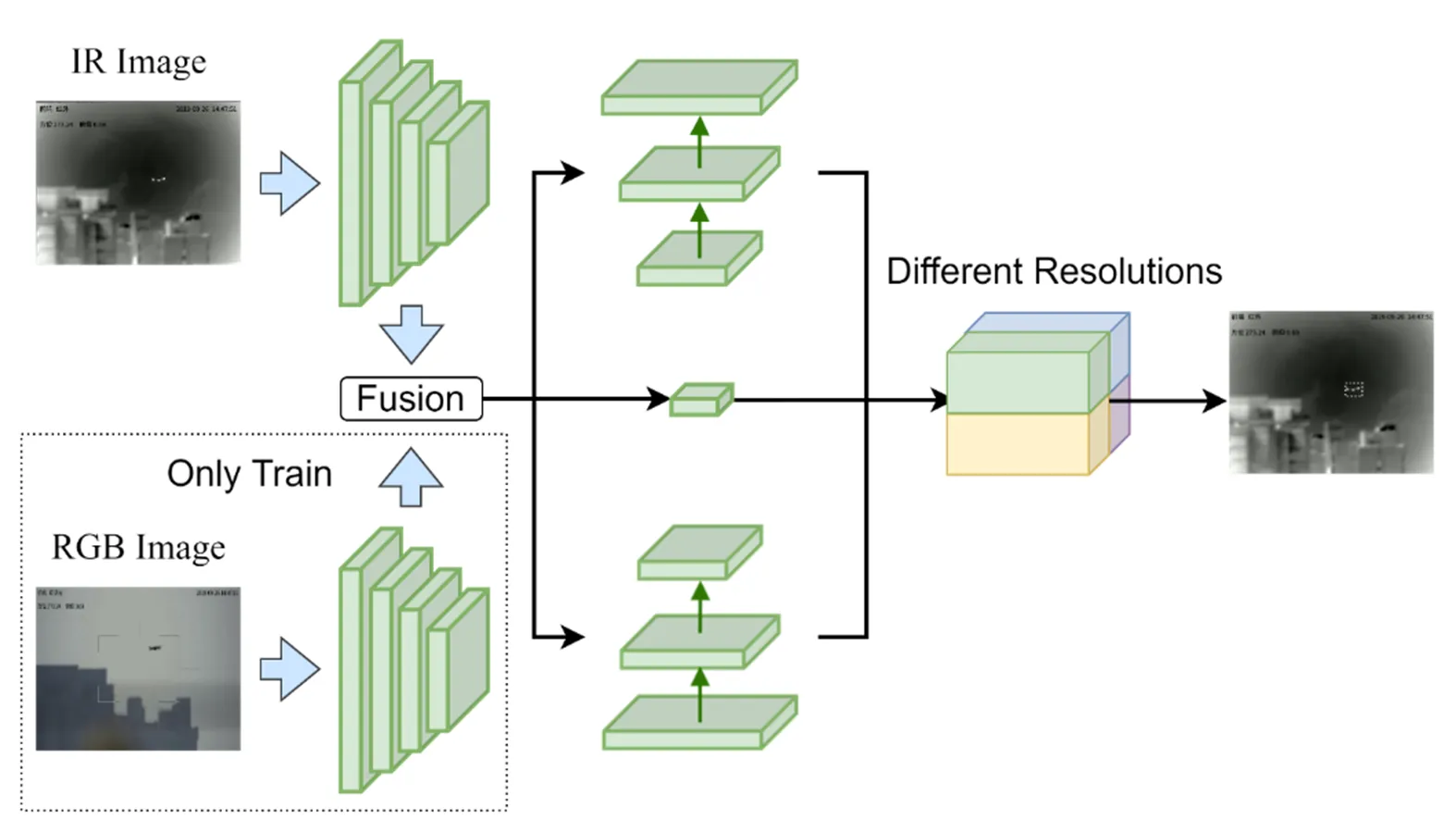

图1展示了本文所提出的孪生网络检测模型架构。首先将RGB image和IR image作为输入流输入到两个编码器中,分别用于提取彩色图像和深度图像之间的特征。其中两个编码器结构共享权重以减少算法训练参数数量,并且仅在训练阶段使用RGB Image流。接着将两种模态的多层次编码输出进行特征融合输出3种不同尺度大小的编码图。将融合输出的结果进行1×1卷积计算使通道数量减少到96。接着本文在Nanodet Plus-m[15]算法的基础上对Ghost PAN进行改进,设计适合多模态融合的金字塔式结构用于多尺度融合,将不同层次的融合结果进行维度拼接及元素求和后输出4种不同尺寸大小的显著性预测图。本文将在下文给出各个网络模块的详细信息。

图1 MAFS网络模型

1.1 编码器结构

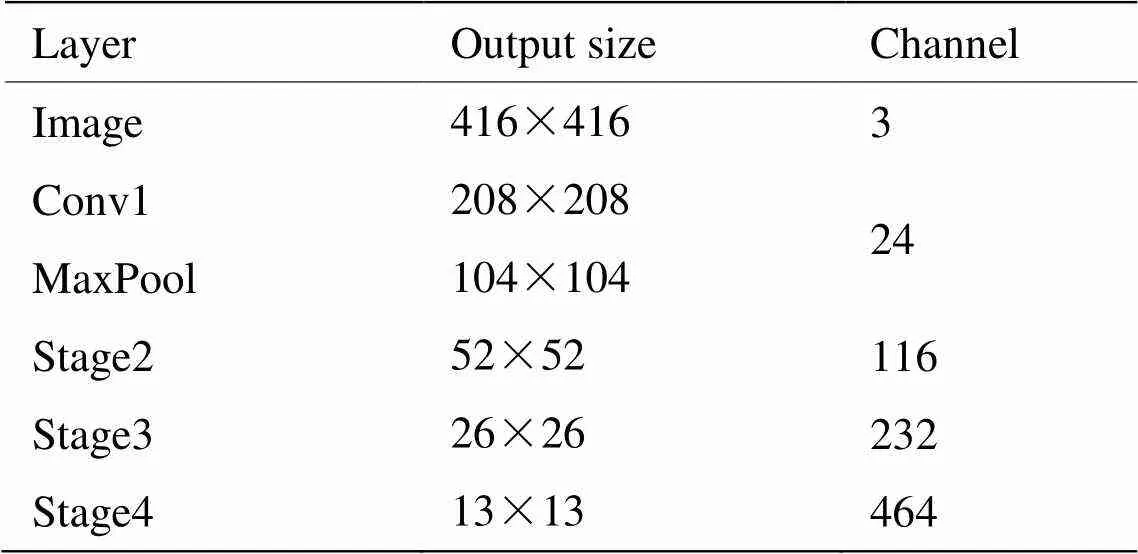

轻量化网络模型通过减小网络结构复杂度来降低训练后模型的大小,在几乎对精度不造成影响的前提下以适应更多的应用场景。本文选择Shufflenet-V2轻量化网络作为Baseline。该网络由Ma[16]等人在2018年设计并提出,其中Shufflenet-V1引入大量的分组卷积以降低模型参数量。接着在Shufflenet-V2中引入channel split和channel shuffle减少分组卷积带来的负面影响并增加不同分支之间的信息交互。本文所使用网络结构如表1所示。

表1 编码器组成结构

在表1中,该编码结构对输入多模态图像分别进行下采样,本文选择后三层下采样输出。其中Stage(=2,3,4)与Shuffenet-V2具有相同的结构。

1.2 融合模块

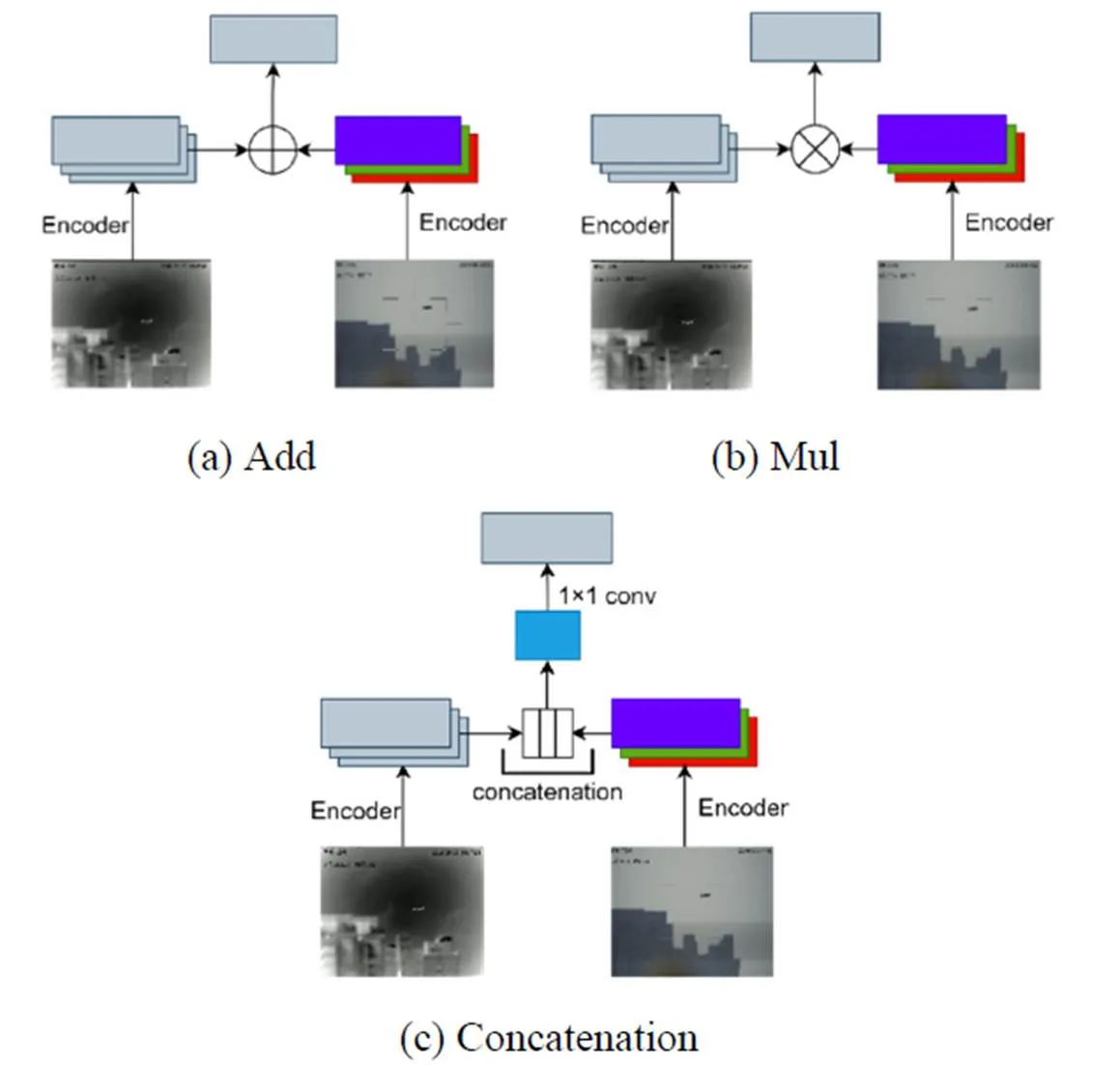

在多模态自适应融合算法中,本文对3种不同融合策略进行尝试,如图2所示。

图2 多模态融合策略

在图2(a)(b)(c)中将提取之后的特征向量分别进行元素相加运算、点积运算和通道级联操作。对于图2(a)本文考虑双模态权重可能会对最终检测结果产生影响,然后分别对两种不同模态进行加权。初始化两个值为1的可训练参数和,然后分别与编码图进行矩阵数乘运算输出结果,最后将数乘结果执行矩阵数加计算,其输出结果Fusionadd∈×W×H可以表示为:

IR=ir[,:,:]∈[0,) (1)

RGB=rgb[,:,:]∈[0,) (2)

Fusionadd=×IR+×RGB (3)

式中:和分别为红外特征图和彩色特征图权值系数,取正数;表示通道维度;IR和RGB分别表示两种不同模态的特征张量。

在图2(b)将提取之后的特征图进行点积运算,其输出结果Fusionmul∈×W×可以表示为:

Fusionmul=IR×RGB (4)

在图2(c)中首先进行通道级联后使用1×1的卷积进行降维,其输出结果Fusionconcat∈×W×可以表示为:

Fusionconcat=1×1(IR, RGB) (5)

式中:表示concatenation操作;表示1×1卷积计算。

1.3 改进多尺度融合Ghost PAN模块

在MAFSnet中添加多尺度融合结构为了提高模型的特征提取能力和检测精度。针对无人机目标较小的特点,进一步优化特征融合层以及多尺度检测层的特征尺度,使得训练出来的检测模型能够更好地适应无人机目标检测,同时提高模型的检测速度。

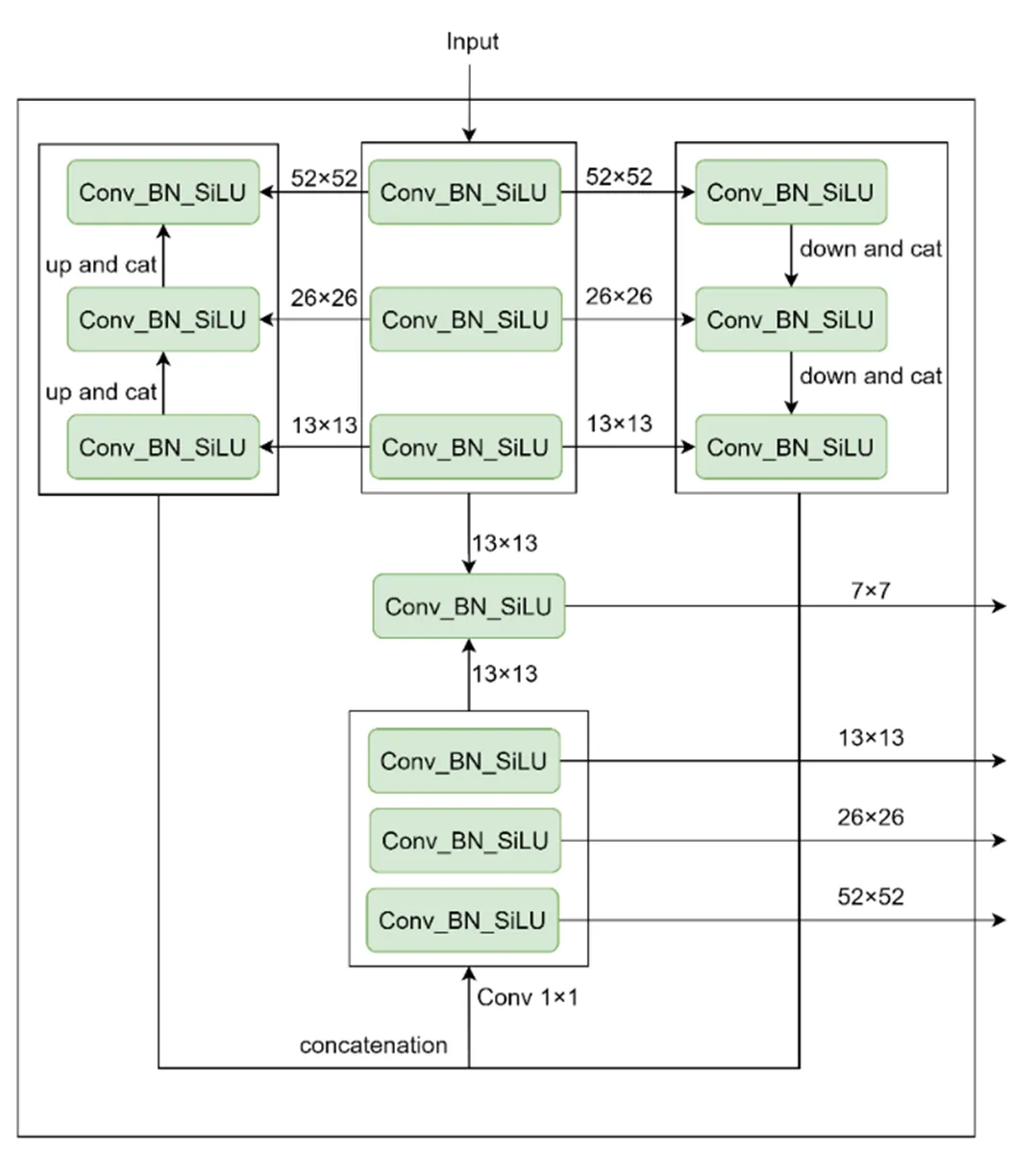

如图3所示,本文在Nanodet Plus-m算法的基础上对Ghost PAN进行改进。向多尺度融合模块输入3种不同分辨率大小和通道数的特征图。首先经过一个卷积核大小为1×1的卷积层把通道数降到96,接着将输出的结果分别进行上采样和下采样操作,并将采样输出进行拼接。最后将拼接的结果与1×1卷积层输出进行下采样后相加。使用多尺度融合方法提高不同采样输出之间的信息交互能力。

1.4 损失函数

由于无人机目标信噪比低造成训练正样本和负样本数量严重不匹配,当目标被严重遮挡时容易导致漏检情况发生,因此需要更加复杂的分布对边界框进行建模。

为解决样本不匹配问题本文使用Generalized Focal Loss和GIOU Loss[17]对网络进行损失计算,并针对不同损失函数设定不同的权重系数,整体损失计算公式如下:

Loss=FLoss+FLoss+GIOULoss (6)

式中:、和表示权重系数,在文中实验部分分别设置为1.0、0.25和2.0。

2 实验结果与分析

2.1 实验准备

本次实验使用Anti-UAV数据集的训练集[18]和Anti-UAV竞赛[19]的测试-开发数据集来训练MAFSnet模型,使用采集的无人机红外数据集进行验证。其中训练集的红外图像分辨率为640×512,RGB图像分辨率为1960×1080。由于训练数据集是视频的连续帧,相邻图片差别不大,因此需要进行一定程度地数据调整。首先对于训练集每10帧取一张图片,并去掉其中不包含无人机的图片。最后得到总共6830张用于训练的图片,其中4681是白天拍摄,2149张拍摄于夜晚。测试集采集于沈阳理工大学龙翔体育场如图4所示,针对红外视频序列每20帧抽取一张图像并使用LabelImg工具进行标注,制取测试集数目共687张。其中采集测试集与训练集的图片不存在重叠。

图3 改进的Ghost PAN

图4 部分测试集数据

2.2 训练环境及参数配置

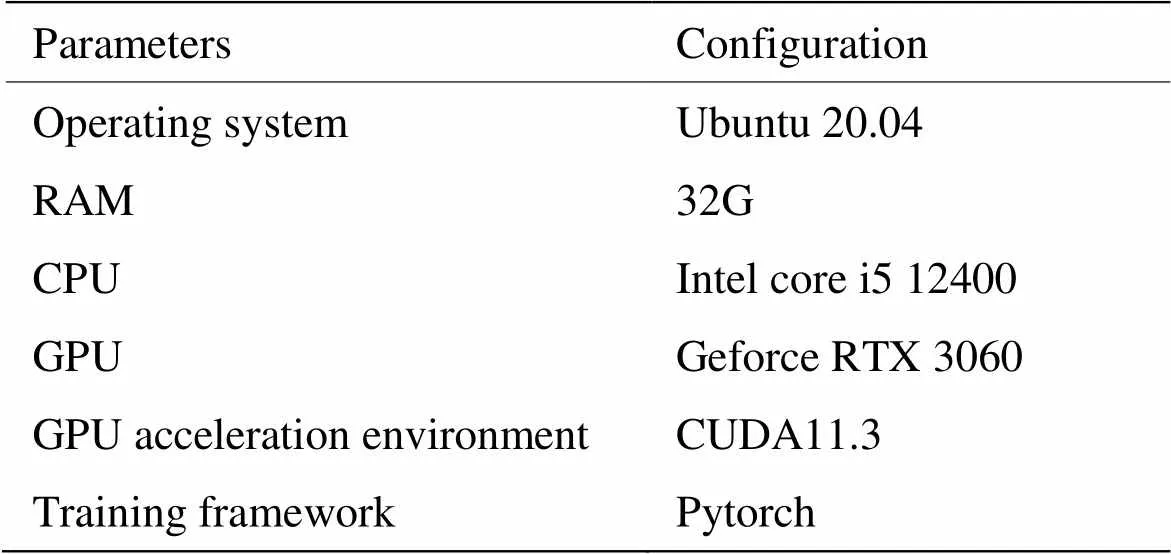

本实验使用Pytorch框架,在ubuntu20.04上运行,具体配置如表2所示。

表2 实验配置

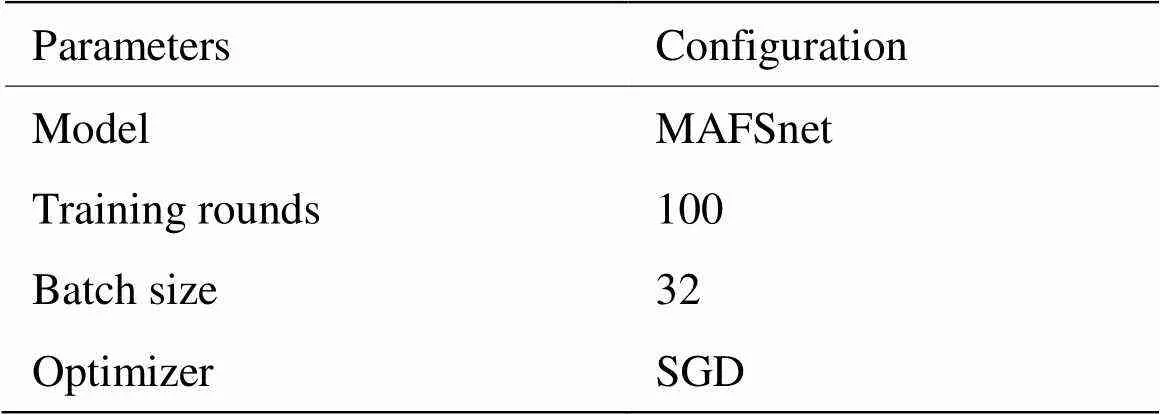

本实验采用MAFSnet模型进行训练,训练批次batch szie设置为32,训练权重采用Shufflenet-V2.pth,共迭代100轮次,具体配置如表3所示。

表3 算法实现的具体参数配置

2.3 数值评估方法

本文使用COCO评估指标来评估目标检测部分的性能。由于无人机目标的尺寸小,当存在几个像素的偏差时可能会引起较大的IoU波动。预测的边界框和ground truth标签之间的IoU为50%表示预测足够合理,因此AP50可能是一个更有用和更公平的度量边界框。另外本文还使用平均准确率(mean average precision,mAP)对MAFSnet算法进行性能评价以判别模型正确分类的能力。利用Latency、Flops和Params来检验算法的检测效率以及参数数量和模型复杂度。

2.4 消融实验

本文在该部分将逐步介绍如何从Nanodet Plus-m改进到MAFSnet。

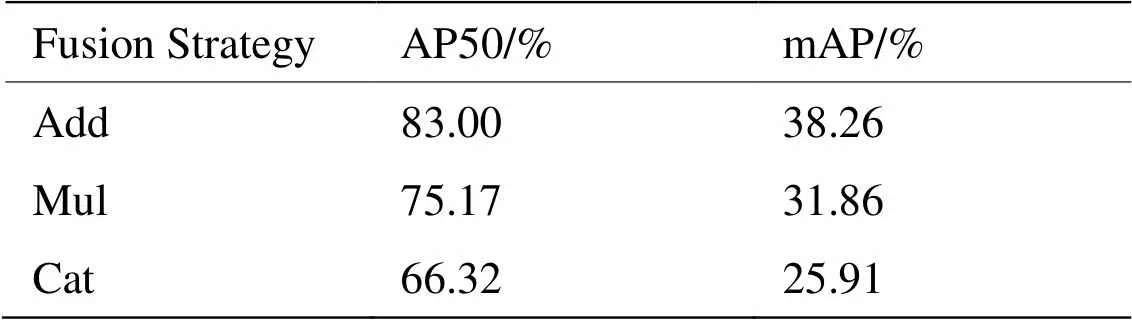

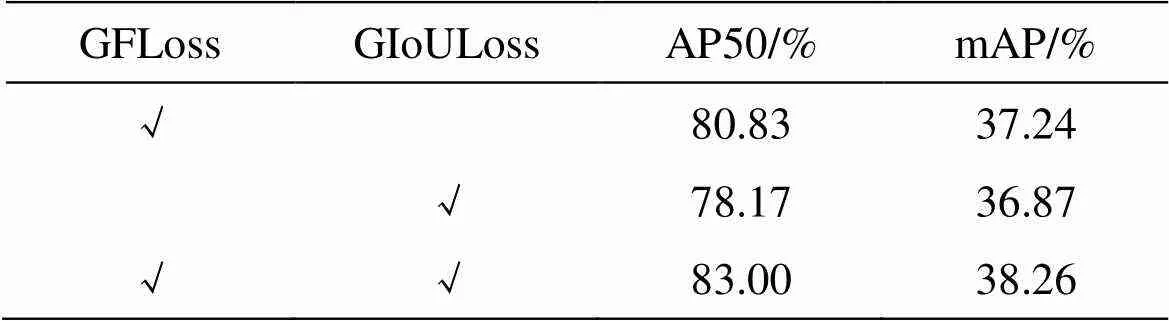

首先对1.2中不同融合策略进行实验设计,在本文中提出了3种不同的策略来融合红外图像和彩色图像的编码特征。为了比较它们的有效性和差异,文中在同一基线中执行不同的策略,并分别展示AP50和mAP的实验结果。如表4所示,求和运算策略在所有指标上都取得了更好的性能。本文认为求和操作更适合多模态特征融合,而乘积和concatenation结果较差。因此本文使用求和运算策略执行其余的消融实验和对比实验。由于本文只在训练阶段进行多模态特征融合,且不同的融合策略不会对推理阶段产生影响,因此不会影响到模型的计算量和模型参数。

表4 多模态融合策略

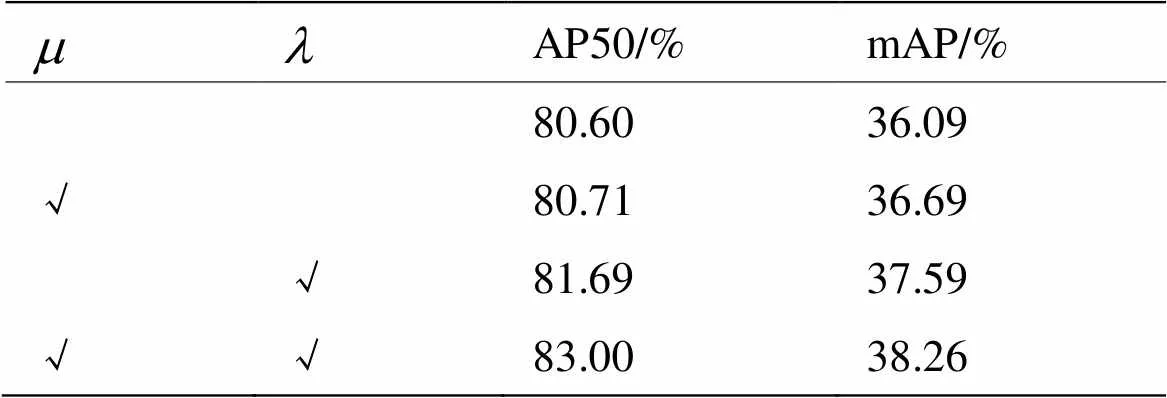

如表5显示,针对不同模态设置不同权重对mAP和AP50的影响很大。未加入权重参数时AP50为80.60%,设置不同的权重参数后AP50可以达到83.00%,提升了3.0%。其中1:1的权重比例效果最差,因此本文认为针对不同模态设置不同权重比例是很有必要的。由于在算法验证阶段采用的是红外图像,所以会导致1:的AP50(81.69%)要优于:1(80.71%),提升了1.2%。不同的权重系数会产生不同的检测结果。在实验部分,本文将和初始化为1并将它们作为可训练参数,它们是一种通过数据迭代进行自动学习的变量。利用随机梯度下降的方法(即优化器SGD)不断调整自身数值使模型的损失(预测值和真实值之间的误差)最小,从而获得更好的检测结果。以自主学习的方式加权融合红外和可见光特征,可以保证网络在引入丰富特征信息的同时,尽可能降低噪声干扰。

如表6所示,本文分别控制添加损失函数,用于评估损失函数对检测精度的影响。加入GFLoss后MAFSnet的mAP为37.24%,当替换GIoULoss后mAP下降了0.37%。本文认为GFLoss更适合小目标检测任务,当检测目标较小时会导致正负样本严重不匹配,从而预测一个不可信且质量极高的分数。而多损失函数可以提高模型性能,因此本文同时使用两种损失函数训练MAFSnet,提高算法鲁棒性。其中多损失函数的损失权重与NanoDet-Plus[15]一致。

表5 多模态融合的权重因子

表6 损失函数

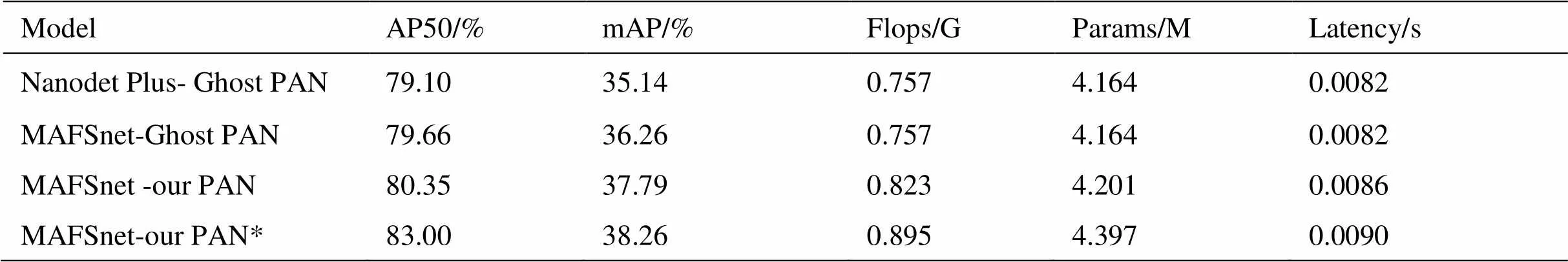

如表7所示,本文首先尝试将MAFSnet与Ghost PAN相结合,在保证模型参数和推理时间不变的情况下mAP提升了3.2%,添加前后的mAP分别为35.14%和36.26%。本文认为采用多模态融合对无人机检测精度的提升是有效的。接着本文对Ghost PAN进行改进,对于该模块本文首先进行结构重建形成新的PAN结构,在推理时间基本不变的前提下mAP提升4.2%,其中模型改进前后的mAP分别为36.26%和37.79%。如图3中conv1×1模块,本文采用共享卷积权重和非共享卷积权重两种方法进行实验,在表7中“*”代表非共享卷积权重。由表可知使用非共享卷积权重的mAP为38.26%,使用共享卷积权重的mAP为37.79%,提升了1.2%。实验数据表明在模型复杂度基本不变的前提下,本文所设计的模块实现了无人机目标检测精度的提高。

表7 改进Ghost PAN的消融实验结果

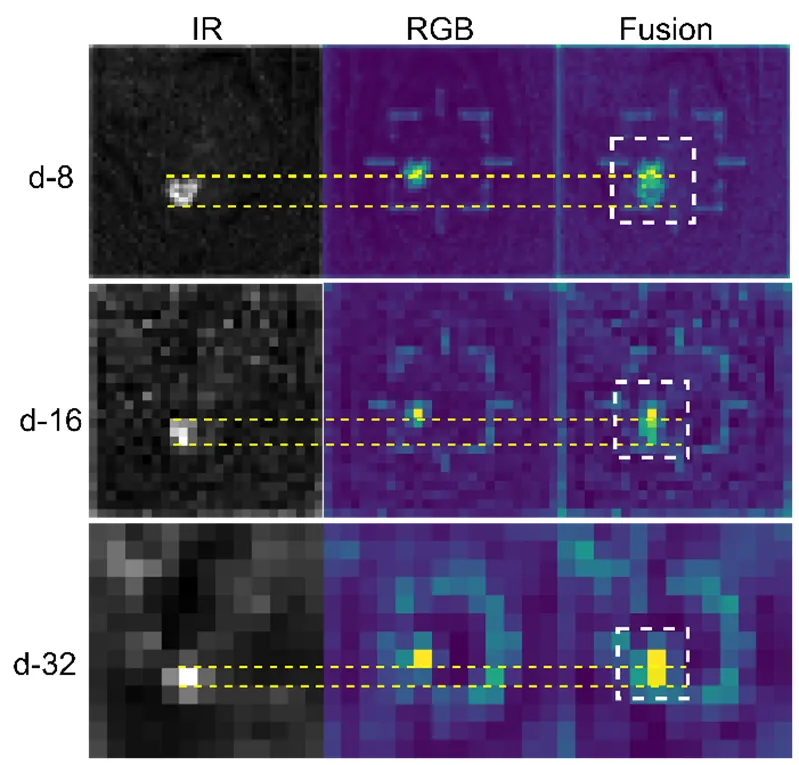

图5展示了IR和RGB image分别经过特征提取之后(下采样倍率为8、16、32)的可视化输出,其中多模态输入图像未配准对齐。本文引入平行黄色虚线表示不同模态特征之间的差异。由第二列可知,当本文以无人机目标红外图像为基准时,彩色图像目标位置会出现偏移,从而产生融合误差如白色矩形框所示。由于无人机目标在图像中像素面积占比小,使用融合的方法可以增加无人机目标更多特征,本文认为这种偏移对无人机目标检测是有利的。因此可以利用多模态融合方法增强无人机目标在卷积神经网络中的特征表示,从而增强无人机目标检测精确度。

图5 多模态特征融合偏差

2.5 多算法对比实验

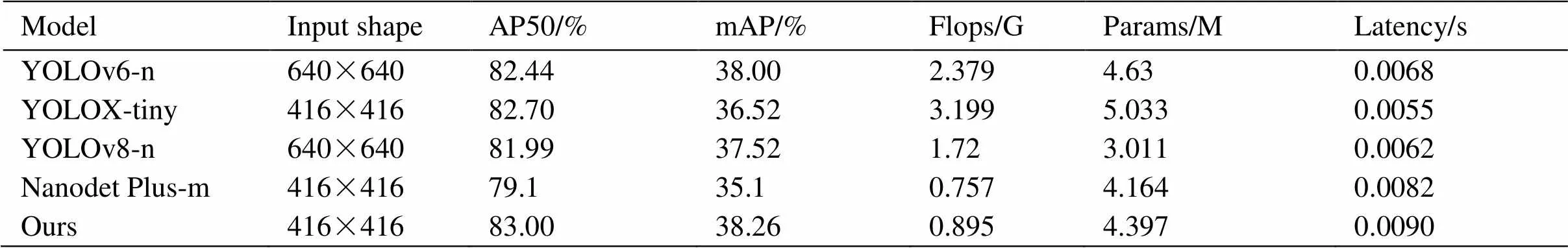

为了更正确地验证结果,本文微调YOLOv6-n[20]、YOLOX-tiny[21]、YOLOv8-n[22]和Nanodet Plus-m四种轻量化检测算法,维持模型超参数不变且训练配置如表2所示。表8表明MAFSnet获得了最佳的检测结果38.26%mAP。与刚刚发布的YOLOv8-n算法相比,在推理时间相差不大的情况下mAP提升了0.74%。MAFSnet与改进前的Nanodet Plus-m相比,在推理时间仅降低0.0008s的前提下mAP提升了9%。因此本文认为MAFSnet可以实现轻量化、实时性检测无人机目标。

本文选择4张红外图像进行可视化实验验证。首先从沈阳理工大学龙翔体育场采集的数据集中选取两张红外图像(a)和(b),它们分别包含草木和白云。接着在3rd-Anti-UAV数据集和NUDT-SIRST[23]数据集中分别选择一张包含建筑背景的红外图像(c)和(d),其中d包含两个无人机目标。如图6所示,与其他目标检测算法相比本文算法鲁棒性更强,在多种复杂背景下都能更好地实现无人机目标检测。在目标局部对比度不高(a)的情形下Nanodet Plus、YOLOv8和YOLOX皆不能很好地检测到无人机目标。在冗余信号过多的情况下(c)只有本文算法和YOLOX准确获得无人机目标的位置信息。由于本文算法存在多模态特征融合优势,更能适应复杂背景下的无人机目标检测。

表8 不同算法结果对比

图6 不同算法检测结果

3 结论

为解决无人机滥用对社会构成的威胁,本文基于无人机图像提出一种多模态自适应融合孪生网络。首先使用轻量级孪生网络ShuffleNetV2降低结构复杂度和模型参数,加快检测速度。设计一种自适应融合策略实现多模态融合,有效结合多模态输入图像优势提高图像信息利用率。将融合后的特征图通过改进的Ghost PAN增强浅层特征的使用和提取以加强对无人机目标的检测,提高模型的准确性。最后进行消融实验和多算法对比实验设计,消融实验结果表明MAFSnet可以充分利用多模态无人机目标信息来提升无人机目标检测准确度,同时本文所提出融合策略可以有效提升无人机目标检测精度。多算法对比实验结果表明本文算法在复杂环境背景下无人机目标检测精度要优于其它检测算法,具有更强的鲁棒性。同时与改进前的方法相比在检测速度基本不变的情况下获得9%的提升。

然而本文算法仍有一些问题值得进一步研究,比如如何利用更高效的上下文信息、探讨注意力模块对不同模态的影响等。在未来的工作中,将继续探索多模态融合和融合策略在无人机目标检测中的应用。

[1] 张辰, 赵红颖, 钱旭. 面向无人机影像的目标特征跟踪方法研究[J]. 红外技术, 2015, 37(3): 224-228, 239.

ZHANG Chen, ZHAO Hongying, QIAN Xu. Research on Target Feature Tracking Method for UAV Images[J]., 2015, 37(3): 224-228, 239.

[2] 王宁, 李哲, 梁晓龙, 等. 无人机单载荷目标检测及定位联合实现方法[J]. 电光与控制, 2021, 28(11): 94-100.

WANG Ning, LI Zhe, LIANG Xiaolong, et al. Joint realization method of single payload target detection and positioning of UAV[J]., 2021, 28(11): 94-100.

[3] 杨欣, 王刚, 李椋, 等. 基于深度卷积神经网络的小型民用无人机检测研究进展[J]. 红外技术, 2022, 44(11): 1119-1131.

YANG Xin, WANG Gang, LI Liang, et al. Research progress in detection of small civilian UAVs based on deep convolutional neural networks [J]., 2022, 44(11): 1119-1131.

[4] 粟宇路, 苏俊波, 范益红, 等. 红外中长波图像彩色融合方法研究[J]. 红外技术, 2019, 41(4): 335-340.

SU Yulu, SU Junbo, FAN Yihong, et al. Research on color fusion method of infrared medium and long wave images [J]., 2019, 41(4): 335-340.

[5] 陈旭, 彭冬亮, 谷雨. 基于改进YOLOv5s的无人机图像实时目标检测[J]. 光电工程, 2022, 49(3): 69-81.

CHEN Xu, PENG Dongliang, GU Yu. Real-time target detection of UAV images based on improved YOLOv5s [J]., 2022, 49(3): 69-81.

[6] Redmon J, Farhadi A. YOLO9000: Better, Faster, Stronger[C]//2017(), 2017: 6517-6525.

[7] Bertinetto L, Valmadre J, Henriques J F, et al. Fully-convolutional siamese networks for object tracking[J/OL]. C, 2016. https://arxiv.org/abs/1606.09549

[8] 闫号, 戴佳佳, 龚小溪, 等. 基于多源图像融合的光伏面板缺陷检测[J]. 红外技术, 2023, 45(5): 488-497.

YAN Hao, DAI Jiajia, GONG Xiaoxi, et al. Photovoltaic panel defect detection based on multi-source image fusion [J]., 2023, 45(5): 488-497.

[9] MA Jiayi, MA Yong, LI Chang. Infrared and visible image fusion methods and applications: A survey[J]., 2019, 45: 153-178.

[10] 白玉, 侯志强, 刘晓义, 等. 基于可见光图像和红外图像决策级融合的目标检测算法[J]. 空军工程大学学报: 自然科学版, 2020, 21(6): 53-59, 100.

BAI Yu, HOU Zhiqiang, LIU Xiaoyi, et al. Target detection algorithm based on decision-level fusion of visible light images and infrared images [J]., 2020, 21(6): 53-59, 100.

[11] 宁大海, 郑晟. 可见光和红外图像决策级融合目标检测算法[J]. 红外技术, 2023, 45(3): 282-291.

NING Dahai, ZHENG Sheng. Decision-level Fusion Object Detection Algorithm for Visible and Infrared Images[J]., 2023, 45(3): 282-291.

[12] 马野, 吴振宇, 姜徐. 基于红外图像与可见光图像特征融合的目标检测算法[J]. 导弹与航天运载技术, 2022(5): 83-87.

MA Ye, WU Zhenyu, JIANG Xu. Target detection algorithm based on feature fusion of infrared image and visible light image [J]., 2022(5): 83-87.

[13] 刘建华, 尹国富, 黄道杰. 基于特征融合的可见光与红外图像目标检测[J]. 激光与红外, 2023, 53(3): 394-401.

LIU Jianhua, YIN Guofu, HUANG Daojie. Object detection in visible and infrared images based on feature fusion [J]., 2023, 53(3): 394-401.

[14] 解宇敏, 张浪文, 余孝源, 等. 可见光-红外特征交互与融合的YOLOv5目标检测算法[J/OL]. 控制理论与应用, http://kns.cnki.net/kcms/detail/44.1240.TP.20230511.1643.024.html.

XIE Yumin, ZHANG Langwen, YU Xiaoyuan, etc. YOLOv5 target detection algorithm based on interaction and fusion of visible light-infrared features [J/OL]., http://kns.cnki.net/kcms/detail /44.1240.TP.20230511.1643.024.html.

[15] RangiLyu. NanoDet-Plus: Super fast and high accuracy lightweight anchor-free object detection model[EB/OL]. https://github.com/ RangiLyu/nanodet , 2021.

[16] MA N, ZHANG X, ZHENG H T, et al. Shufflenet v2: Practical guidelines for efficient cnn architecture design[C]//(ECCV). 2018: 116-131.

[17] LI X, WANG W, WU L, et al. Generalized focal loss: Learning qualified and distributed bounding boxes for dense object detection[J]., 2020, 33: 21002-21012.

[18] JIANG Nan,WANG Kuiran, PENG Xiaoke. Anti-UAV: A Large-Scale Benchmark for Vision-Based UAV Tracking[J]., 2023, 25: 486-500, DOI: 10.1109/TMM.2021.3128047.

[19] ZHAO J, WANG G, LI J, et al. The 2nd Anti-UAV workshop & challenge: Methods and results[J/OL]. arXiv preprint arXiv:2108.09909, 2021.

[20] LI C, LI L, JIANG H, et al. YOLOv6: A single-stage object detection framework for industrial applications[J/OL]. arXiv preprint arXiv:2209.02976, 2022.

[21] GE Z, LIU S, WANG F, et al. Yolox: Exceeding yolo series in 2021[J/OL]. arXiv preprint arXiv:2107.08430, 2021.

[22] Github. Yolov5[EB/OL]. https://github.com/ultralytics/yolov5, 2021.

[23] LI B, XIAO C, WANG L, et al. Dense nested attention network for infrared small target detection[J]., 2022, 32: 1745-1758.

Multimodal Fusion Detection of UAV Target Based on Siamese Network

HAN Ziqiang,YUE Mingkai,ZHANG Cong,GAO Qi

(Shenyang Ligong University, College of equipment Engineering, Shenyang 110159, China)

To address the threat of small drones "black flying" to the public domain. Based on the multimodal image information of an unmanned aerial vehicle (UAV) target, a lightweight multimodal adaptive fusion Siamese network is proposed in this paper. To design a new adaptive fusion strategy, this module assigns different modal weights by defining two model training parameters to achieve adaptive fusion. The structure is reconstructed on the basis of a Ghost PAN, and a pyramid fusion structure more suitable for UAV target detection is constructed. The results of ablation experiments show that each module of the algorithm in this study can improve the detection accuracy of the UAV targets. Multi-algorithm comparison experiments demonstrated the robustness of the algorithm. The mAP increased by 9% when the detection time was basically unchanged.

UAV, lightweight, Siamese network, adaptive fusion strategy, multimodal image

TN219

A

1001-8891(2023)07-0739-07

2023-06-01;

2023-06-21.

韩自强(1999-),男,硕士研究生,主要从事探测、控制与信息对抗技术。E-mail:hanzq@sylu.edu.cn。

岳明凯(1971-),男,教授,博士,研究方向:武器系统安全控制,探测、控制与毁伤技术。E-mail:13032486996@163.com。

辽宁省教育厅基本科研面上项目(LJKMZ20220605)。