可见光与红外图像分区融合的夜视抗晕光方法

梁嘉豪,郭全民,王晗蕾

可见光与红外图像分区融合的夜视抗晕光方法

梁嘉豪,郭全民,王晗蕾

(西安工业大学 电子信息工程学院,陕西 西安 710021)

针对夜视晕光图像区域特征差异大,导致融合图像视觉效果不理想的问题,提出一种可见光与红外图像分区融合的夜视抗晕光方法。先采用自适应阈值迭代法确定低频系数的晕光阈值,将低频系数划分为晕光与非晕光区域,在晕光区域采用非线性红外系数权值调节策略,依据图像晕光程度合理消除晕光;在非晕光区域采用灰度均值先验权值调节策略,提高较亮图像参与融合的权值,增强暗处区域的可见度。实验结果表明,本文方法对不同程度的夜视晕光场景均具有良好的适用性,能合理且有效地消除晕光,提高夜视融合图像的质量。

夜视抗晕光;图像融合;红外图像;Curvelet变换

0 引言

夜间行车滥用远光灯极易引发交通事故[1]。因此,研究夜视抗晕光方法用于消除晕光干扰并获得符合人眼观察的夜视图像,应用于汽车安全辅助系统,可有效保障夜间行驶安全。

目前夜视主动抗晕光方法主要有:前挡风玻璃增加偏振[2]、红外成像技术[3-5]、像素积分时间独立可控的图像传感器[6]、可见光与红外融合图像[7-10]等。其中,结合可见光图像分辨率高且色彩丰富、红外图像不受晕光干扰等优点的异源融合方法,可有效降低晕光干扰并提高图像质量,是当前解决晕光问题的研究热点。文献[11]提出了一种多尺度分解融合方法,通过对低频分量的显著图和残差图分别采用“模值取大”和“平均”规则进行融合,提高了融合图像的清晰度并凸显了红外显著信息。文献[12]采用非下采样剪切波变换(Nonsubsampled shearlet transform,NSST)对图像进行分解,通过设计的自适应稀疏表示模型对低频分量融合,有效提升了显著信息。文献[13]对NSST分解的高频分量采用自适应参数的简化脉冲耦合神经网络(Adaptive-parameter pluse-coupled neural network,AP-SPCNN)进行融合,利用其全局耦合性与脉冲同步性提高了融合图像清晰度。文献[14]采用四阶偏微分方程(Fourth-order partial differential equation,FPDE)分解红外与可见光图像,对低频分量采用期望值最大的融合策略,有效地提升了融合图像的显著信息。但因晕光也属于夜视图像中的显著信息,上述方法在增强图像细节信息的同时会放大晕光区域,不利于夜间行车安全。文献[15]在YUV色彩空间下通过Wavelet变换对低频分量加权融合,降低了晕光干扰,但晕光信息仍参与融合,在强晕光场景中存在晕光消除不足问题。文献[16]提出改进的IHS-Curvelet变换,通过设计的低频红外权值自动调节策略消除晕光较为彻底,但在晕光分布不均匀的场景,由于区域特征差异过大,易导致明暗分裂现象。

为了在不同晕光场景下均能获得视觉效果较好的夜视图像,本文提出一种可见光与红外图像分区融合的夜视抗晕光方法。通过晕光阈值将低频系数分为晕光与非晕光区域,在晕光区着重依据图像晕光程度合理消除晕光;在非晕光区重点提高暗处区域的可见度。

1 夜视抗晕光原理

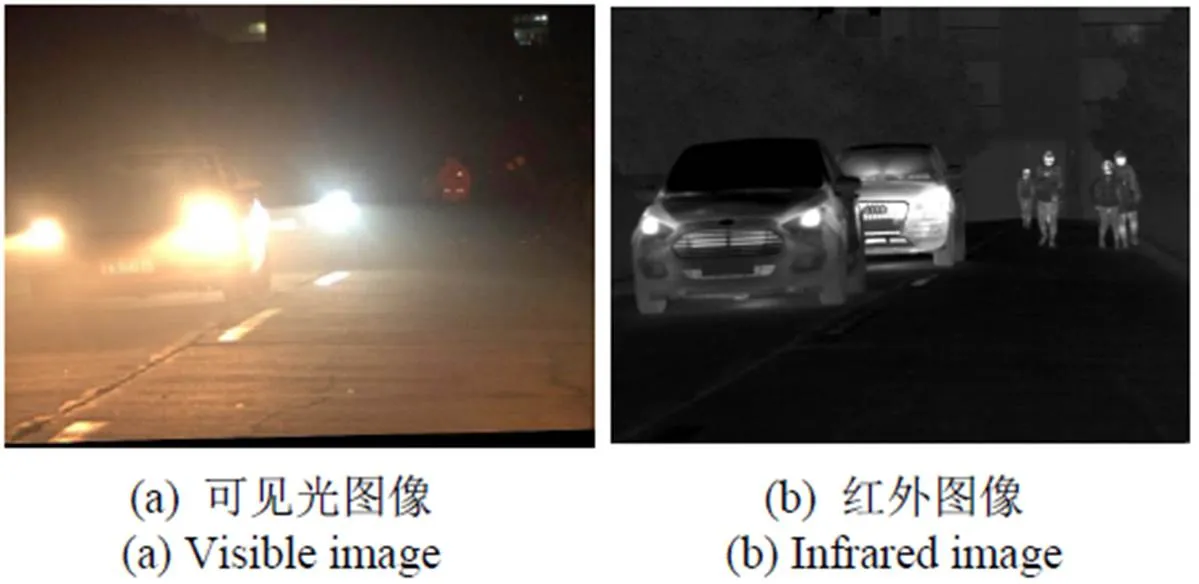

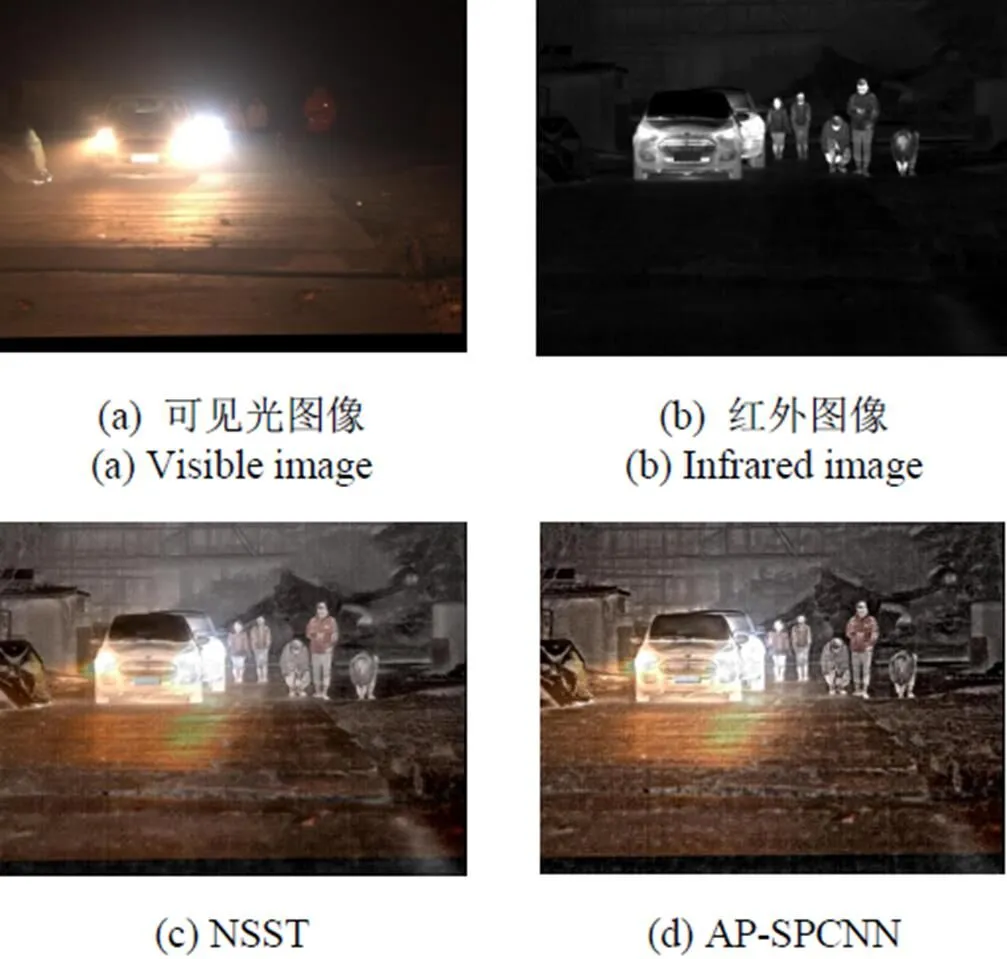

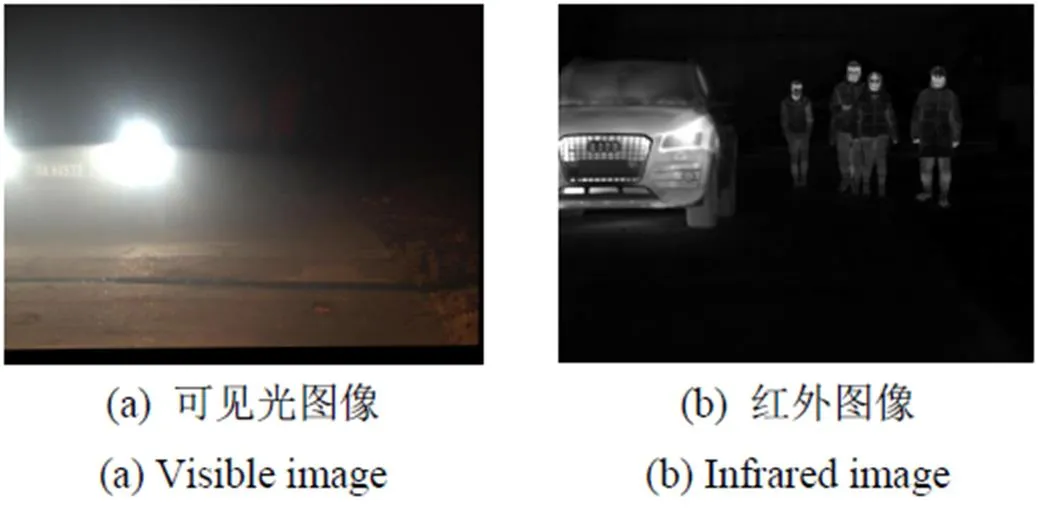

在夜视晕光场景,可见光图像中晕光十分刺眼,覆盖了车辆轮廓,导致暗处行人难以观察。在红外图像中车辆与行人轮廓清晰可见,但车牌、车道线、色彩等重要细节信息缺失,如图1所示。

图1 夜视晕光图像

可见光图像不同区域特征差异极大,故不同区域图像融合处理的着重点也应不同。在高亮度晕光区域,应合理消除晕光干扰,当晕光较强时,易使驾驶员眩目影响夜间行车安全,故要尽可能地消除晕光;当晕光较弱时,避免亮度消除过度导致图像局部过暗,故晕光消除适当即可。在低亮度非晕光区域,应有效提升图像色彩、轮廓及纹理等细节信息,增强夜视图像的视觉效果。为了在不同晕光场景中均能获得视觉效果较好的夜视图像,本文提出了一种基于分区融合的夜视抗晕光方法。

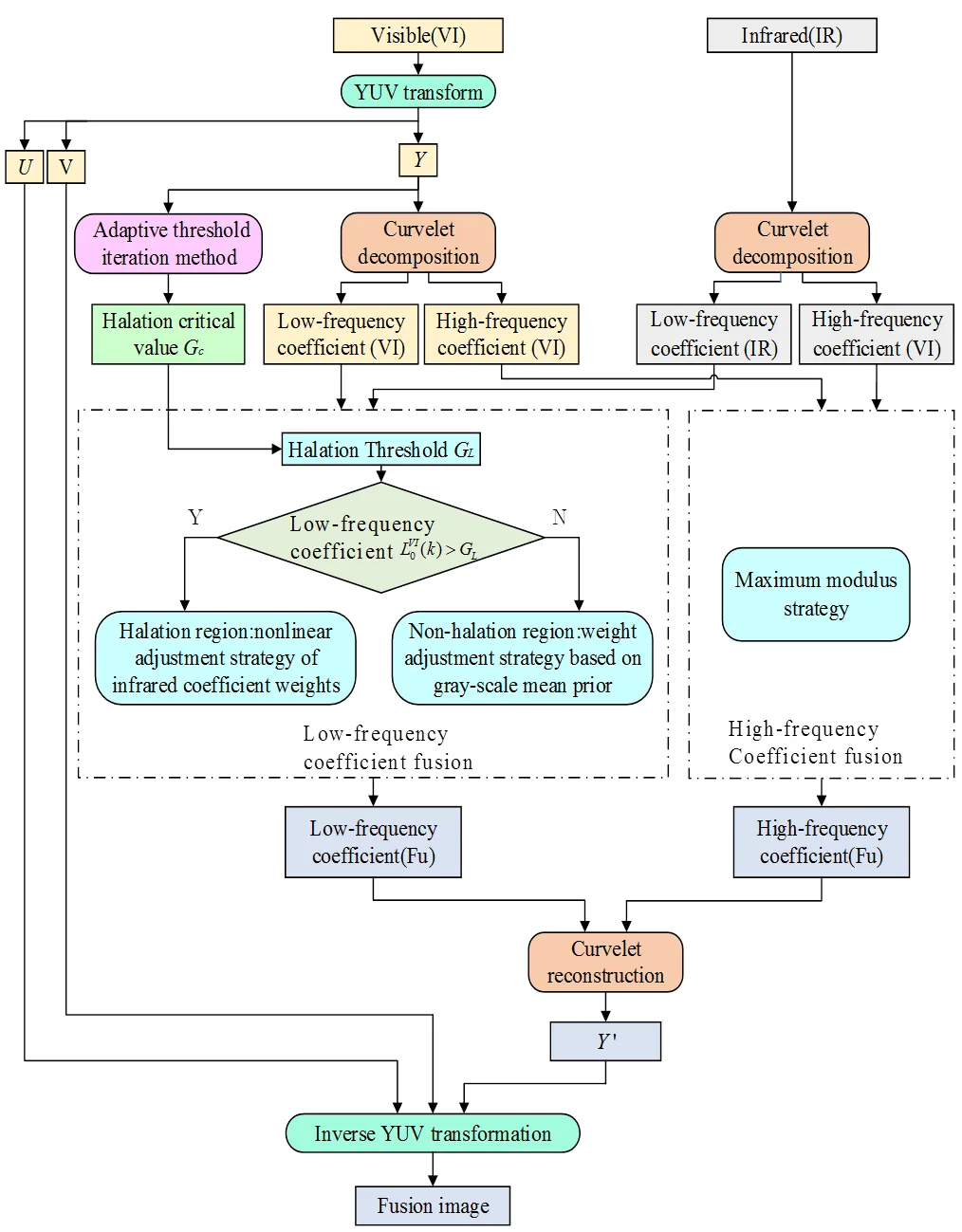

可见光图像转换到YUV空间后,因晕光信息主要分布在亮度分量中,故通过自适应阈值迭代法求解亮度分量的晕光临界值,并进一步确定低频系数的晕光阈值,将低频系数划分为晕光与非晕光区域。在晕光区通过构造非线性红外系数权值调节策略合理消除晕光;在非晕光区域采用灰度均值先验权值调节策略,提高较亮图像参与融合的权值,提高暗处区域的可见度。高频系数融合采用模值取大策略保留更多的细节信息。利用Curvelet变换具有各向异性的特性,保留边缘细节并抑制周边噪声,有效提高了图像的清晰度。同时仅对YUV变换的亮度分量进行融合,降低算法复杂度,提高处理效率,并避免色彩失真。

2 基于分区融合的夜视抗晕光方法

基于上述夜视抗晕光原理,本文方法的整体处理框图如图2所示。

图2 图像融合抗晕光过程

2.1 Curvelet分解

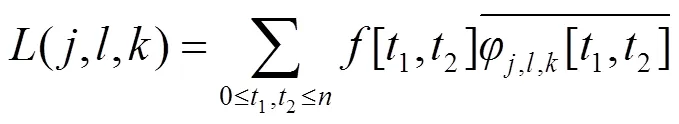

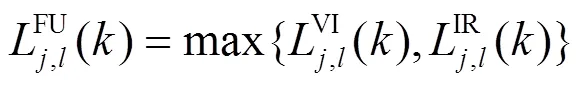

可见光图像经YUV变换[17]获得亮度分量,再对分量与红外图像分别进行Curvelet分解。二维离散Curvelet分解[18]可表示为:

式中:[1,2]表示输入图像;,l,k[1,2]表示Curvelet函数;分别表示分解的尺度、方向与位置。

分解后得到亮度分量和红外图像对应的低频系数VI0()、IR0(),高频系数VI()、IR(),其中上标VI、IR分别表示可见光、红外。

2.2 低频系数晕光阈值的确定及区域划分

首先通过自适应阈值迭代法[19]确定可见光图像亮度分量的晕光临界值c。

计算第+1次阈值T+1为:

T+1=(1+2)(2)

(3)

式中:为自适应系数;1和2分别为经阈值T分割后的两个区域的灰度均值;In()是第个像素的灰度值;为总像素数,1和2分别为两个区域的像素数,=1+2。

为了尽可能减少迭代次数,自适应系数需要根据图像的晕光程度自动调整。研究表明晕光程度与晕光区域面积正相关,与非晕光区域面积负相关,通过实际实验,自适应系数取为:

=-1.73360.0253+2.2243 (4)

式中:表示晕光与非晕光面积比。初始阈值0取亮度分量的灰度中值进行迭代计算,直到阈值不再变化时结束,最新的阈值即为晕光临界灰度值c。

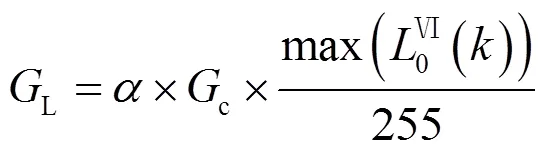

由于晕光区域高灰度值像素比较集中,进行晕光消除处理时易造成晕光临界处明暗分裂的现象,故在c的基础上扩大低频系数的晕光消除范围,低频系数的晕光阈值L取为:

式中:为缩放因子,使消除晕光后的晕光与非晕光区域衔接更自然,Î[0, 1]。通过多次计算优化,本文取=0.65。若低频系数位置的灰度值VI0()>L,则该位置属于晕光区域;反之,若VI0()≤L,则该位置属于非晕光区域。

2.3 非晕光区域低频系数权值调节策略

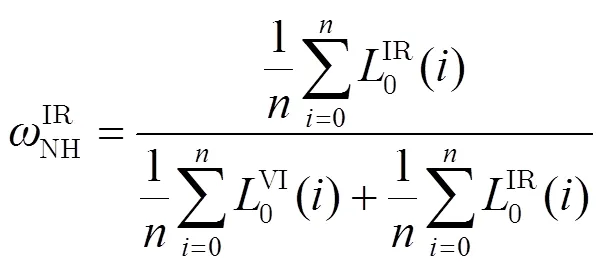

夜视图像非晕光区整体较暗,为了增强融合图像非晕光区的可见度,通过提高非晕光区整体较亮像素参与融合的权值,提升融合图像暗处视觉效果。以亮度分量与红外图像的非晕光区灰度均值作为先验信息,确定非晕光区域红外低频系数权值IRNH():

式中:为非晕光区总像素数。

2.4 晕光区域低频系数权值调节策略

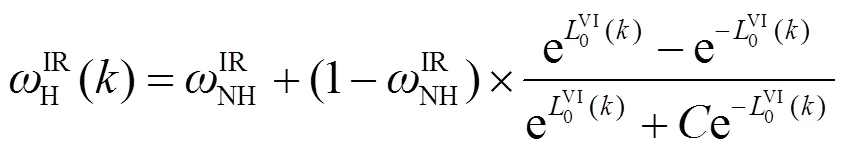

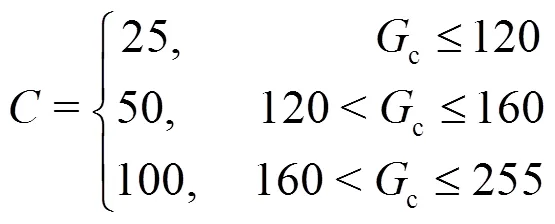

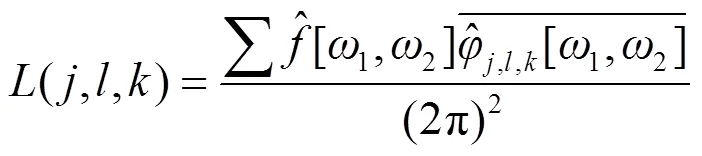

由于晕光信息主要分布于可见光图像的低频分量,Curvelet分解后的可见光低频分量在晕光区域的系数值明显大于其他区域。因此,在晕光区随着晕光程度变强,可见光低频系数值变大,应增大红外低频系数权值,降低可见光低频系数权值以更好地消除晕光;当逐渐递进到晕光中心区域时,对应的红外低频系数权值应取大值,以彻底地消除晕光;在晕光临界处,为了使晕光与非晕光区域明暗衔接自然,且防止晕光消除过度,应合理设置缓冲区,以非晕光区的红外低频系数作为晕光区域红外低频系数权值的基准,且要变化缓慢。根据上述思想构造晕光区域红外低频系数权值IRH()的非线性表达式:

式中:为约束因子,用于调节晕光消除程度。当取不同值时,红外低频系数权值IRH()随可见光低频系数VI0()的变化趋势如图3所示。

图3 晕光区域红外低频系数权值曲线

Fig.3 Weight curves of infrared low frequency coefficient in halo region

由图3可以看出,取值不同的函数曲线变化趋势,均为HIR()随0VI()的增大而增大,且变化率开始缓慢后变大,接近1时再变小。另外,对应同一0VI()不变时,越小该点的HIR()越大,因此与晕光消除程度成反比关系。根据晕光程度调整的取值,再利用式(6)调整红外与可见光低频系数权值,达到合理消除晕光的目的。由于晕光程度与晕光临界值成正比关系,经过多次计算优化,将晕光临界值c划分为3个区间,不同区间的取值为:

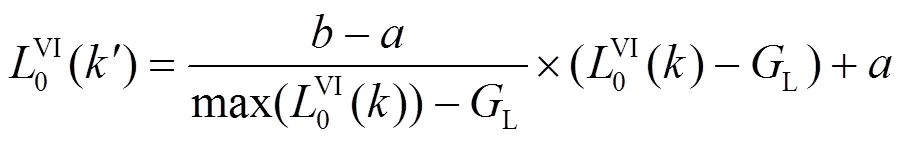

为了将晕光区域的红外低频系数权值均匀分布在范围[0,1],首先对VI0()进行区间投射:

式中:VI0()表示点VI0()投射到[,]区间的低频系数值。本文选择[0, 4]区间投射,以VI0()为作为式(7)的输入,得到红外低频系数权值矩阵IRH()。

2.5 Curvelet重构

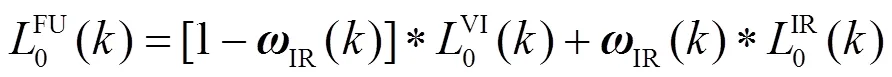

融合后的低频系数FU0()为:

式中:IR()为红外低频系数权值矩阵,可表示为:

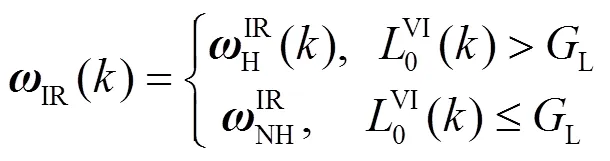

高频系数融合采用模值取大策略,可获得更多的纹理细节信息[20]。融合后的高频分量FU()为:

频域的离散Curvelet变换表式为:

利用式(13)将FU0()与FU()进行Curvelet重构,得到新亮度分量¢,再将其与、分量进行YUV逆变换得到最终的融合图像。

3 实验及分析

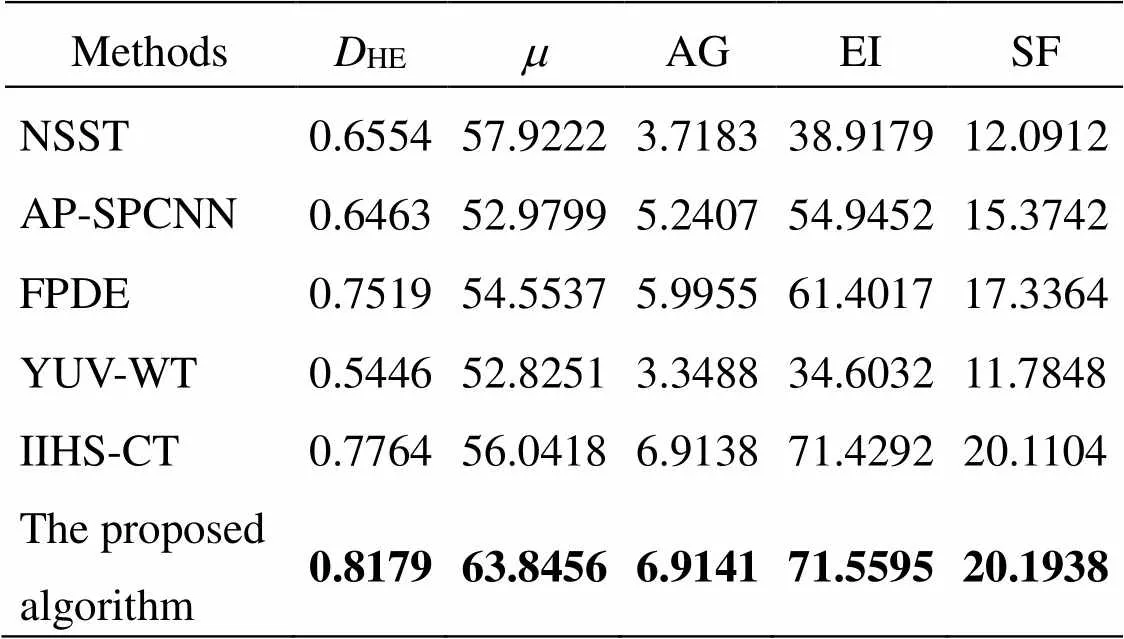

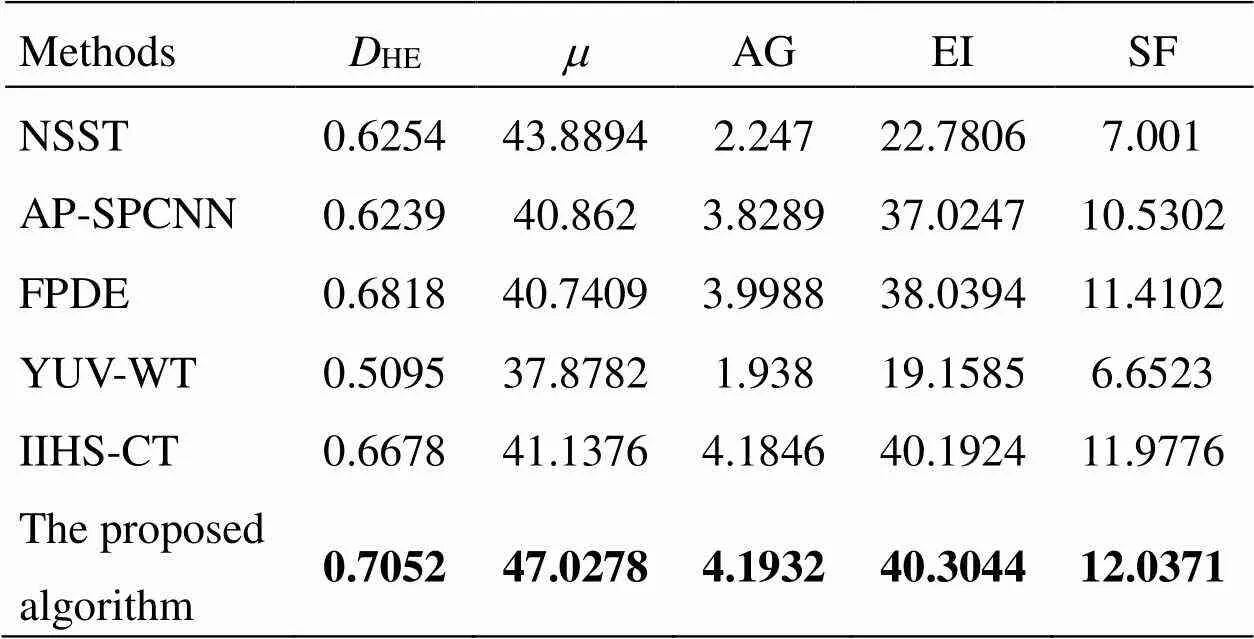

为验证本文方法的有效性,本文在两种不同道路晕光场景采集了对向车辆由远及近的可见光与红外图像,分别采用NSST[12]、AP-SPCNN[13]、FPDE[14]、YUV-WT[15]、IIHS-CT[16]等5种融合方法与本文方法进行实验对比。为了避免高亮度晕光信息干扰融合图像的评价结果,本文采用文献[19]提出的自适应分区质量评价方法对融合结果进行客观评价。采用晕光消除度HE指标对晕光区域的晕光消除效果进行评价,值越大表明晕光消除越彻底。采用均值、平均梯度(AG)、边缘强度(EI)、空间频率(SF)等指标对非晕光区域进行评价,越大表明非晕光区域亮度越高,AG越大表明图像细节反差的变化速率越大;EI越大表明图像的边缘细节越明显;SF越大表明图像空间域变化越强。

3.1 对向车辆距离较远的晕光场景

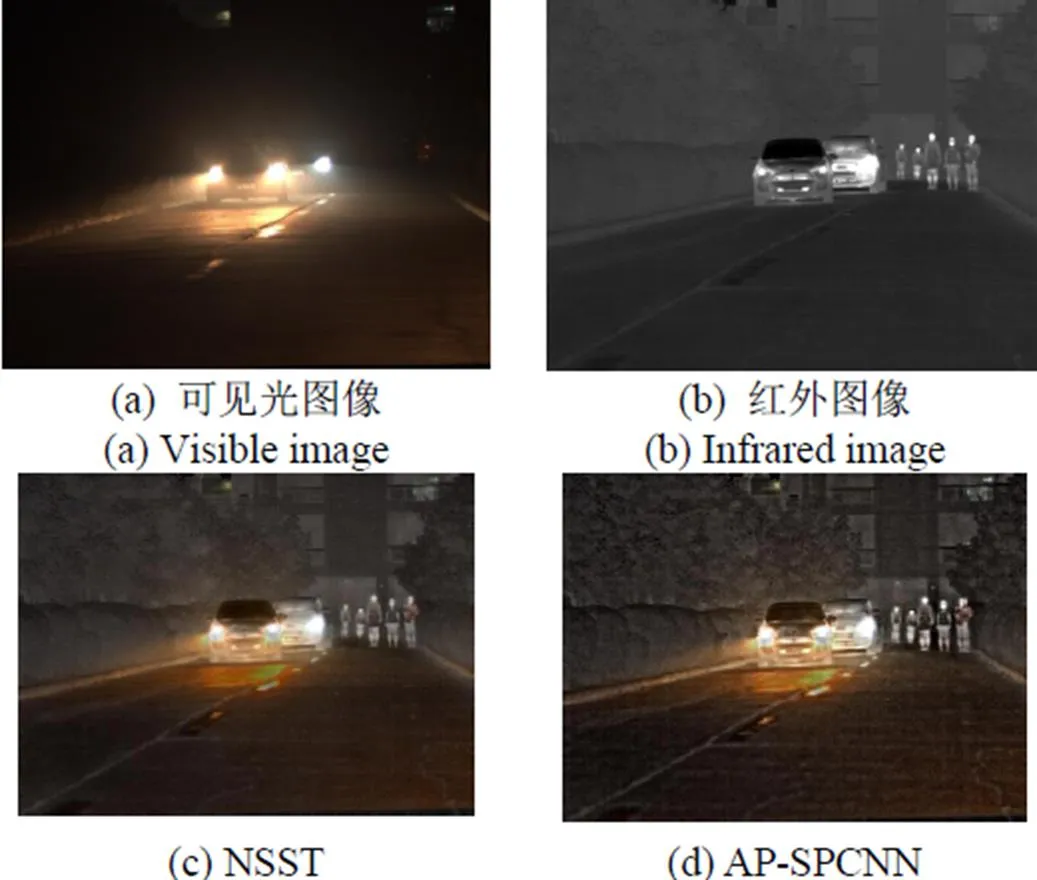

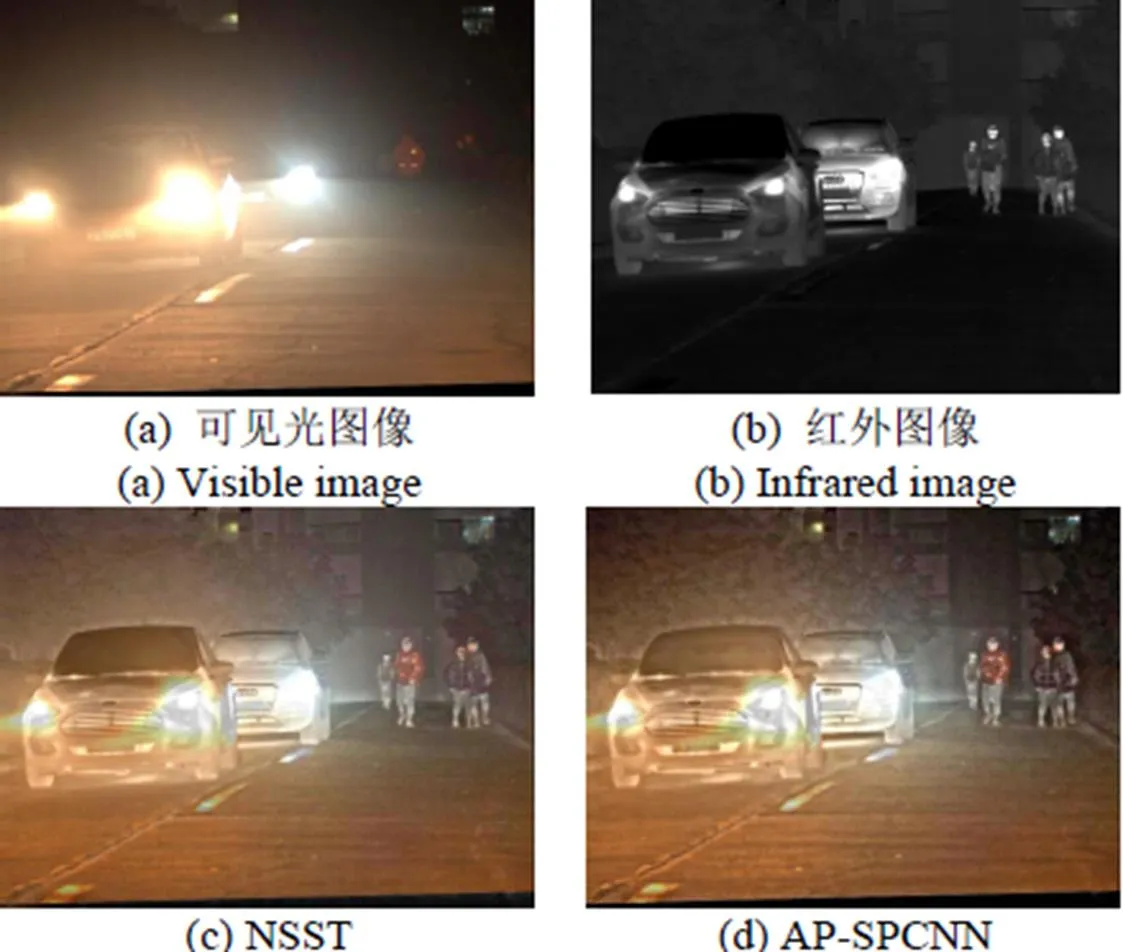

夜间对向车辆较远时,图像整体偏暗。可见光图像中晕光较弱,路况等信息受益于晕光变得更加明显,但晕光部位侧方和后方区域缺乏光源,车辆轮廓、行人难以观察;红外图像中车辆轮廓与行人清晰可见,但路面状况、色彩等信息缺失。图4与图5分别为场景1与场景2的原始图像及不同算法的融合图像。

从图4与图5可以看出,在整体清晰度方面,YUV-WT与NSST相较于其他5种算法融合图像的清晰度欠佳。在晕光消除方面,NSST、AP-SPCNN、FPDE以及YUV-WT在车灯附近仍有光斑残余,晕光消除程度明显不如IIHS-CT与本文算法。在行人、车辆等信息的显著程度与图像整体亮度方面,本文算法的行人与车辆轮廓相较于其它5种算法更显著,且图像整体亮度更好。场景1与场景2各算法融合图像的客观评价结果如表1与表2所示。

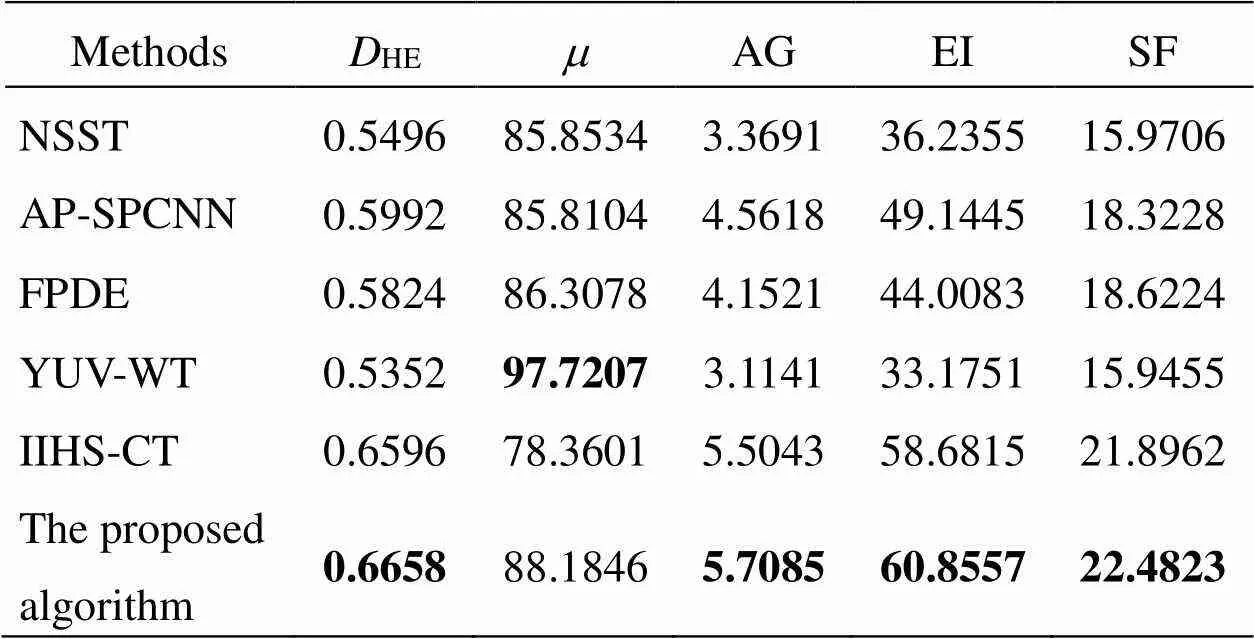

Table 1 场景1融合图像的客观评价指标

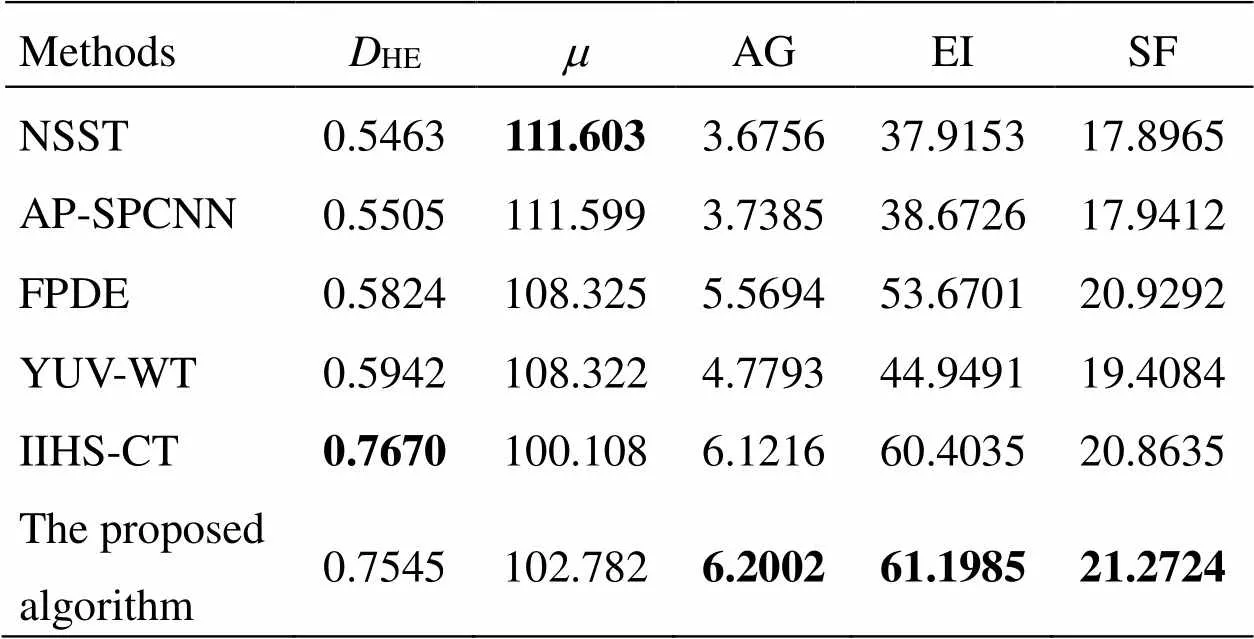

由表1与表2知,IIHS-CT与本文算法都设计了晕光消除的低频融合规则,所以HE明显高于其他4种算法,其中本文算法HE最高,在场景1中相较于其他5种抗晕光算法分别提升了24.7%、26.5%、8.7%、50.1%、5.3%,在场景2中相较于其他5种抗晕光算法分别提升了12.7%、13%、3.4%、38.4%、5.6%。在非晕光区域,本文算法设计了灰度均值先验权值调节策略,通过提高较亮图像参与融合的权值有效提升融合图像的亮度,指标在场景1中相较于其他5种算法分别提升了10.2%、20.5%、17%、20.8%、13.9%,在场景2中相较于其他5种算法分别提升了7.1%、15%、15.4%、24.1%、14.3%。由于Curvelet变换的各向异性,对边缘信息更敏感,所以本文算法与IIHS-CT融合图像的AG、EI与SF指标相较于其它4种算法明显提高,但IIHS-CT晕光消除范围过大,导致图像非晕光区域整体较暗,变化率与细节反差小,故相较于本文方法的AG、EI与SF指标较低。在两种场景下,本文算法的各项指标均高于其它5种方法,验证了本文方法在对向车辆距离较远的晕光场景的有效性。

Table 2 场景2融合图像的客观评价指标

3.2 对向车辆距离较近的晕光场景

当对向车辆较近时,多个车灯形成的晕光部位连成一个较大区域,十分炫目极易造成交通隐患。可见光图像的高亮度晕光覆盖了车辆轮廓,路面受益晕光变得明显,但也导致暗处区域更加难以观察;红外图像无晕光且目标轮廓清晰,但会丢失车道线等重要信息且细节模糊,无色彩。图6与图7分别为场景3与场景4的原始图像及不同算法的融合图像。

由图6与图7可看出,NSST与YUV-WT算法融合的图像在两种场景中较为模糊,边缘细节的清晰度较差,行人显著度不足。除了IIHS-CT与本文算法,其他4种算法处理融合图像在场景4中的晕光消除不足,在车灯附近晕光仍比较严重。IIHS-CT在两种场景中均晕光消除过度,导致晕光临界处两侧明暗差异较大,整体视觉效果较差。本文算法相较于其他5种算法,晕光消除较好,车辆轮廓更清晰,整体亮度更符合人眼视觉。场景3与场景4融合图像的客观评价结果如表3与表4所示。

Table 3 场景3融合图像的客观评价指标

Table 4 场景4融合图像的客观评价指标

由表3与表4可知,本文算法与IIHS-CT变换都针对低频部分的晕光信息设计了晕光消除策略,因此两种场景中HE指标明显高于其它4种方法。在场景4中,虽然IIHS-CT的HE最高,但晕光临界处明暗分裂明显,影响图像整体视觉效果,而本文算法晕光消除范围控制较好,获得图像的视觉效果更好。YUW-WT与NSST分别在场景3与场景4中最高,但行人显著度较差。AP-SPCNN与FPDE能较好保留图像显著信息,但晕光本身也属显著信息,导致上述算法在晕光较强场景中的融合图像较高而HE较低,晕光信息依然存在,导致车辆轮廓比较模糊。本文算法与IIHS-CT利用了Curvelet变化对边缘信息更敏感的特性,相较于其他4种算法边缘信息保留的更多,图像更清晰,故AG、EI与SF较高。另一方面,由于IIHS-CT不能有效地控制晕光消除范围,导致部分非晕光区域亮度较低,灰度变化率变小,所以AG、EI与SF相较于本文算法较低,验证了本文算法在对向车辆距离较近的晕光场景的有效性。

3.3 结果讨论

通过以上的分析可知,NSST、AP-SPCNN、FPDE、YUV-WT算法在强晕光场景中存在晕光消除不足。IIHS-CT方法晕光消除彻底,但存在因晕光消除过度造成严重的明暗分裂现象,适用性较差。本文算法针对不同区域特征采取不同权值调节策略,在不同晕光场景中均能有效消除晕光,提升融合图像质量,普适性较好。

4 结论

本文提出的基于可见光与红外图像分区融合的夜视抗晕光方法,较好地解决了现有夜视抗晕光融合图像视觉效果不理想的问题。该方法能较好地控制晕光消除,并有效提高暗处色彩、细节的可见度,获得的融合图像更适合人眼观察。不同晕光程度场景下的实验结果表明,本文方法相较于对比的5种图像融合方法普适性更好,对提高夜间行车安全具有重要意义,也可为交通感知、安全监控等领域中的低照度逆光图像采集提供一种解决方案。

[1] 安轩. 滥用远光灯致事故发生要担责[J]. 道路交通管理, 2021(1):75.

AN Xuan. Taking responsibility for accidents caused by misuse of high beams [J]., 2021(1): 75.

[2] Marsell E, Bostrom E, Harth A. Spatial control of multiphoton electron excitations in InAs nanowires by varying crystal phase and light polarization[J]., 2018, 18(2): 907-915.

[3] Ashiba H I, Ashiba M I. Super-efficient enhancement algorithm for infrared night vision imaging system[J].., 2021, 80: 9721-9747. DOI: 10.1007/s11042-020-09928-w.

[4] YUAN Yubin, SHEN Yu, PENG Jing, et al. Defogging technology based on dual-channel sensor information fusion of near-infrared and visible light[J]., 2020, DOI:10.1155/2020/8818650.

[5] Ashiba H I. Dark infrared night vision imaging proposed work for pedestrian detection and tracking[J]., 2021, 80: 25823–25849. DOI: 10.1007/s11042-021-10864-6.

[6] 王健, 高勇, 雷志勇, 等. 基于双CCD图像传感器的汽车抗晕光方法研究[J]. 传感技术学报, 2007(5): 1053-1056.

WANG Jian, GAO Yong, LEI Zhiyong, et al. Research of auto anti-blooming method based on double CCD image sensor[J]., 2007(5): 1053 -1056.

[7] QIAO Tianzhu, CHEN Lulu, PANG Yusong. Integrative multi-spectral sensor device for far-infrared and visible light fusion[J]., 2018, 8(2): 134-145. Doi:10.1007/s13320-018-0401-4.

[8] HU Haimiao, WU Jiawei, LI Bo. An adaptive fusion algorithm for visible and infrared videos based on entropy and the cumulative distribution of gray levels[J]., 2017, 19(12): 2706-2719. Doi: 10.1109/TMM.2017. 2711422.

[9] 裴佩佩, 杨艳春, 党建武, 等. 基于滚动引导滤波器和卷积稀疏表示的红外与可见光图像融合方法[J]. 激光与光电子学进展, 2022, 59(12): 56-63.

PEI Peipei, YANG Yanchun, DANG Jianwu, et al. Infrared and visible image fusion method based on rolling guidance filter and convolution sparse representation[J]., 2022, 59(12): 56-63.

[10] 蒋一纯, 刘云清, 詹伟达, 等. 基于图像退化模型的红外与可见光图像融合方法[J]. 电子与信息学报, 2022, 44(12): 4405-4415. DOI: 10.11999/JEIT211112.

JIANG Yichun LIU Yunqing ZHAN Weida, et al. Infrared and visible image fusion method based on rolling guidance filter and convolution sparse representation [J].2022, 44(12): 4405-4415. DOI: 10.11999/JEIT211112.

[11] CHEN J, WU K, LUO L. Multiscale infrared and visible image fusion based on phase congruency and saliency[C]//2020, 2020: 224-227. DOI: 10.1109/IGARSS39084.2020.9324363.

[12] 王昭, 杜庆治, 董安勇, 等. 基于非下采样剪切波变换的红外与可见光图像融合[J]. 光电子·激光, 2020, 31(10): 1062-1073.

WANG Zhao, DU Qingzhi, DONG Anyong, et al. Infrared and visible image fusion based on nonsubsampled shearlet transform[J]., 2020, 31(10): 1062-1073.

[13] ZHANG L, ZENG G, WEI J, et al. Multi-modality image fusion in adaptive-parameters SPCNN based on inherent characteristics of image [J]., 2022, 20(20): 11820-11827. DOI: 10.1109/JSEN.2019. 2948783.

[14] 高雪琴, 刘刚, 肖刚, 等. 基于FPDE的红外与可见光图像融合算法[J].自动化学报, 2020, 46(4): 796-804.

GAO Xueqin, LIU Gang, XIAO Gang, et al. Fusion algorithm of infrared and visible images based on FPDE[J]., 2020, 46(4): 796-804.

[15] 郭全民, 董亮, 李代娣. 红外与可见光图像融合的汽车抗晕光系统[J].红外与激光工程, 2017, 46(8): 171-176.

GUO Quanmin, DONG Liang, LI Daidi. Vehicles anti-halation system based on infrared and visible images fusion[J]., 2017, 46(8): 171-176.

[16] 郭全民, 王言, 李翰山. 改进IHS-Curvelet变换融合可见光与红外图像抗晕光方法[J]. 红外与激光工程, 2018, 47(11): 440-448.

GUO Quanmin, WANG Yan, LI Hanshan. Anti-halation method of visible and infrared image fusion based on improved IHS-Curvelet transform [J]., 2018, 47(11): 440-448.

[17] 何惜琴, 陈冬冬. 基于YUV颜色模型与导向滤波的图像去雾算法[J].液晶与显示, 2021, 36(8): 1166-1173.

HE Xiqin, CHEN Dongdong. Image defogging algorithm based on YUV color model and guided filtering[J]., 2021, 36(8): 1166-1173.

[18] 王丽, 苗凤娟, 陶佰睿. 结合Curvelet变换和LSWT的多聚焦图像融合算法[J]. 计算机工程与科学, 2015, 37(6): 1203-1207.

WANG Li, MIAO Fengjuan, TAO Bairui. A multi-focus image fusion algorithm based on Curvelet transform and LSWT[J].,2015, 37(6): 1203-1207.

[19] 郭全民, 柴改霞, 李翰山. 夜视抗晕光融合图像自适应分区质量评价[J]. 电子与信息学报, 2020, 42(7): 1750-1757.

GUO Quanmin, CHAI Gaixia, LI Hanshan. Quality evaluation of night vision anti-halation fusion image based on adaptive partition[J]., 2020, 42(7): 1750-1757.

[20] LI W, LI Z, LI S. Infrared and visible image fusion via multi-scale edge-preserving filtering and pulse-couple neural network[C]//2021 7th, 2021: 742-746. DOI: 10.1109/ICCC54389.2021.9674474.

Night Vision Anti-halation Method Based on Partition Fusion of Visible and Infrared Images

LIANG Jiahao,GUO Quanmin,WANG Hanlei

(,,710021,)

The imperfect visual effects in fused images are caused by the large difference between the regional features of night-vision halation images. To address this problem, a partition fusion method for visible and infrared images is proposed. First, the halation threshold of the low-frequency coefficient, determined by the adaptive threshold iteration method, divided the low-frequency coefficient into halation and nonhalation regions. In the halation region, the proposed nonlinear adjustment method for the infrared coefficient weights eliminated halation according to the degree of halation in the image. In the nonhalation region, the weight adjustment method based on the prior grayscale mean was applied to improve the weight of brighter images participating in the fusion to enhance the visibility of dark areas. The experimental results show that the proposed method can be applied to night-vision halation scenes of different degrees to eliminate halation and improve the quality of night-vision image fusion.

night vision anti-halation, image fusion, infrared Image, Curvelet transformation

TP391.4

A

1001-8891(2023)07-0714-07

2022-09-11;

2022-11-23.

梁嘉豪(1997-),男,硕士研究生,主要研究方向:图像处理与机器视觉。E-mail:kouhaoshi58300@163.com.

郭全民(1974-),男,教授,博士,主要从事智能感知与信息处理、图像处理及机器视觉方面的研究。E-mail:guoqm@163.com。

国家自然科学基金(62073256),陕西省重点研发计划项目(2019GY-094,2022GY-112)