一种基于层叠指针网络的实体关系抽取

李世龙 张浩军 李大岭 王家慧 齐晨阳

摘 要:通过对知网上252篇有关新工科的典型教育研究文献进行实体关系人工标注,建立了高等教育领域新工科视角下实验数据集NEDS(New Engineering Data Set),设计了一种层叠指针网络模型。实验结果表明,在高等教育领域NEDS上该模型表现突出,其精确率、召回率和F1值分别达到了83.56、76.25和79.74,很好地解决了关系重叠问题。

关键词:新工科;实体关系抽取;层叠指针;关系重叠

中图分类号:TP391 文献标识码:A 文章编号:2096-4706(2023)07-0011-05

Abstract: By artificially labeling the entity relationship of 252 typical educational research literatures on new engineering on CNKI, the experimental dataset NEDS (New Engineering Data Set) from the perspective of new engineering in the field of higher education is established, and a cascading pointer network model is designed. The experimental results show that the model performs well in NEDS in the field of higher education, and its accuracy, recall and F1 values reach 83.56, 76.25 and 79.74 respectively, and solve the problem of relationship overlap.

Keywords: new engineering; entity relationship extraction; cascading pointer; relationship overlap

0 引 言

近年來,新工科等教育改革人才培养模式被提出,大量教育学者在该领域进行探索研究。本文聚焦新工科教育改革领域,建立了高等教育领域新工科视角下实验数据集NEDS,通过引入实体关系抽取技术,实现人工智能辅助,来提高高等教育研究者的研究效率。

信息抽取是知识图谱构建的重要环节,将非结构化或半结构化文本转换为结构化的数据。命名实体识别和关系抽取是信息抽取的两个重要子任务。命名实体识别是从文本中识别出具有特别意义的实体信息,而关系抽取是从本文中实体的语义关系,得到(主体,关系,客体)三元组信息。

1 相关工作

实体关系抽取,主要包含流水线式和联合式两种方法。

1.1 流水线式方法

流水线式方法分为两步,先进行命名实体识别再关系抽取,最后整合成三元组信息。

1.1.1 命名实体识别

命名实体识别是指识别文本中有意义、有价值的实体并将其归入到指定类别的任务,是理解文本意义的基础,是构建知识图谱的核心技术。早期命名实体识别主要以统计模型作为主流方法,常用的统计方法有隐马尔科夫模型(HMM)和条件随机场(CRF)[1]等,它们的准确率在很大程度上依赖于自然语言处理(NLP)工具和人工标注特征。随着深度学习在不同领域的普及,越来越多的深度学习模型被提出解决实体识别问题。Collcbert等人[2]采用卷积神经网络(CNN)和条件随机场(CRF)叠加在单词嵌入中来处理NLP任务。然后,循环神经网络(RNN)在命名实体识别任务中表现出比其他神经网络更好的性能。Chiu和Nichols[3]使用混合双向LSTM和CNN架构来学习单词和字符级特征,减少了特征工程的需要。Shen等人[4]采用深度学习与主动学习相结合来进行命名实体识别,取得了较好的表现。Huang等人[5]提出将BI-LSTM和CRF联合模型作为NLP序列标注工作。

1.1.2 关系抽取

实体关系描述了存在实物之间的关联关系,它被定义为两个或两个以上实体之间的某种联系,是知识图谱构建的基础。关系抽取就是从文本中自动检测和识别出实体之间的某种语义关系。闫雄[6]等人采用自注意力机制和CNN相融合计算序列中词之间的相互关系,提升了关系抽取的效果。Gan等人[7]提出了了子序列实体注意LSTM网络(EA-LSTM)用于关系抽取,具有较好的效果。流水线方式存在误差传播问题,忽略命名实体识别和关系抽取两个任务之间的相关性。

1.2 联合式抽取方法

联合式抽取方法的出现,改善了误差传播问题并且能够有效地利用两个任务之间的相关性。Miwa和Bansal[8]提出了基于端对端的神经网络模型来进行实体关系联合抽取,他们通过在双向序列LSTM-RNNs上叠加双向树状LSTM-RNNs来捕获词序列和依赖树子结构信息,但忽略了实体标签之间的远距离依赖。Zheng[9]等人提出了一种混合神经网络模型来提取实体及其关系,而不需要任何手工特征,该混合神经网络包含用于实体提取的双向编码器-解码器LSTM模块(BiLSTM-ED)和用于关系分类的CNN模块,BiLSTM-ED得到的实体上下文信息再传递给CNN模块,以改进关系分类。Li等人[10]将混合神经网络应用在生物医学文本中进行实体关系联合抽取。Zheng[11]等人提出了一种新的标记方案,该标记策略将涉及序列标注任务和分类任务的关系抽取转化为序列标注任务,并且采用端到端的神经网络模型直接抽取实体-关系-实体三元组信息。Eberts等人[12]采用的共同联合范式为特征,该范式共享相同的编码器并为所有任务提及表示,同时为实体识别和关系抽取保留独立的解码器,以多任务方式联合训练,但该方法并未解决关系重叠问题。

关系重叠是指一个实体与另一个实体之间存在多种关系,或者一个实体与多个不同的实体间存在多种关系。针对这种情况,Wei[13]等人提出了一种新的标记框架CASREL,该框架通过一种级联二进制表示将关系看作为主体和客体所映射出的函数,来处理关系重叠问题。

2 一种基于层叠指针网络实体关系抽取模型

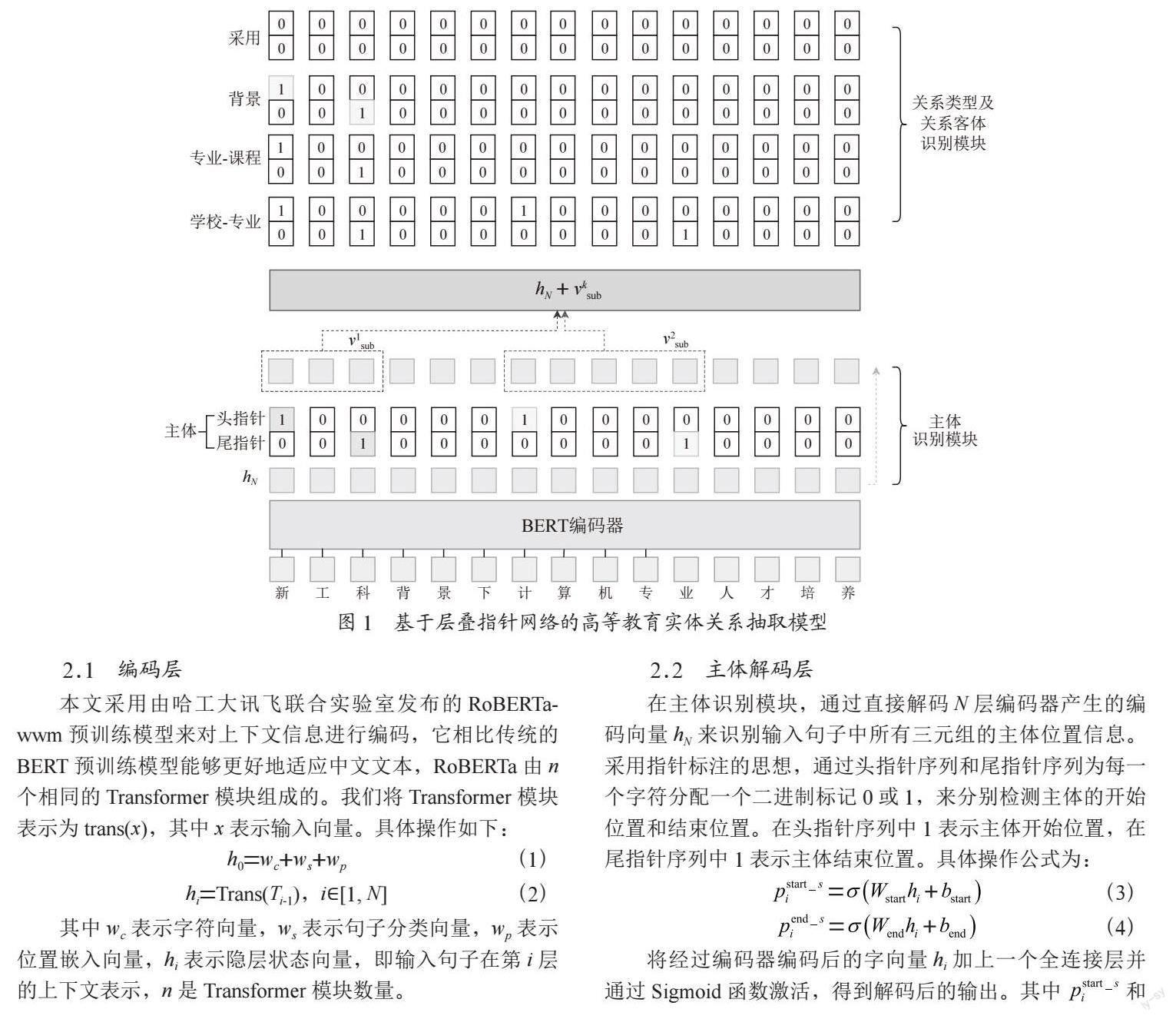

Liu等人[14]提出的RoBERTa模型,该模型在BERT的基础上提高了模型规模、算力和数据量。Wei[13]等人提出的级联指针二进制标记框架将关系看作为主体和客体所映射出的函数。综合上述方法设计一种层叠指针网络的高等教育領域实体关系抽取模型,该模型包含三个模块,我们通过梯度下降以参数共享的方式共同训练。首先,基于BERT的编码器将句子嵌入到潜在空间中;其次,主体识别模块来预测主体的头和尾的位置序列,通过BERT词向量加上一个全连接层去预测一个二分类的问题;最后,关系及客体识别模块随机拿一个主体来预测关系和客体的关系位置矩阵,如图1所示。

2.1 编码层

本文采用由哈工大讯飞联合实验室发布的RoBERTa-wwm预训练模型来对上下文信息进行编码,它相比传统的BERT预训练模型能够更好地适应中文文本,RoBERTa由n个相同的Transformer模块组成的。我们将Transformer模块表示为trans(x),其中x表示输入向量。具体操作如下:

其中wc表示字符向量,ws表示句子分类向量,wp表示位置嵌入向量,hi表示隐层状态向量,即输入句子在第i层的上下文表示,n是Transformer模块数量。

2.2 主体解码层

在主体识别模块,通过直接解码N层编码器产生的编码向量hN来识别输入句子中所有三元组的主体位置信息。采用指针标注的思想,通过头指针序列和尾指针序列为每一个字符分配一个二进制标记0或1,来分别检测主体的开始位置和结束位置。在头指针序列中1表示主体开始位置,在尾指针序列中1表示主体结束位置。具体操作公式为:

将经过编码器编码后的字向量hi加上一个全连接层并通过Sigmoid函数激活,得到解码后的输出。其中 和 分别表示将输入序列中的第i个标识为主体的开始和结束位置的概率。如果概率超过某个阈值,则被标记为1,否则将被标记为0。hi表示输入序列中第i个位置的编码表示,即:hi=hN[i],其中W表示可训练权重,b是偏置σ表示Sigmoid激活函数。

2.3 关系及客体解码层

该模块同时识别关系以及相对应的客体。其结构和主体识别模块类似,将主体编码器的头、尾指针向量序列变换为关系和客体位置矩阵。解码方式与主体识别模块直接对编码向量hN进行解码不同,关系及客体解码器还考虑了主体特征。具体操作公式为:

其中 和 分别表示为在当前关系下,输入序列中的第i个标识为客体的开始和结束位置的概率, 表示在主体识别模块中检测到的第k个主体的编码向量。实体通常由多个汉字组成,为了保证主体的向量维度一致性,将构成主体的每个汉字编码向量的平均值来作为主体的特征表示。

2.4 损失函数

在主体识别模块中,目标函数的定义如下:

其中Pθ (s|x)是主体识别模块中输入文本序列为x,参数θ={Wstart, bstart, Wend, bend}预测主体s的目标函数;L是输入句子长度; 是文本x中第i个标记的主体开始或结束位置的二进制标记。

在关系客体识别模块中,目标函数的定义如下:

其中Pr (o|s, x)表示当关系类别为r,并且在输入文本x和所选主体为s的条件下预测客体o的目标函数;L是输入句子长度, 是文本x中第i个标记的主体开始或结束位置的二进制标记。

结合两个目标函数,模型的最终损失函数为:

其中N是输入样本的数量。综合上述公式可知,0≤P≤1使得q接近于0,当标签y=1时,则放大了损失的权重;当标签y=0时,所对应的 就更小,使得初始状态符合目标分布,最终实现加速收敛。

3 实验分析

3.1 数据集

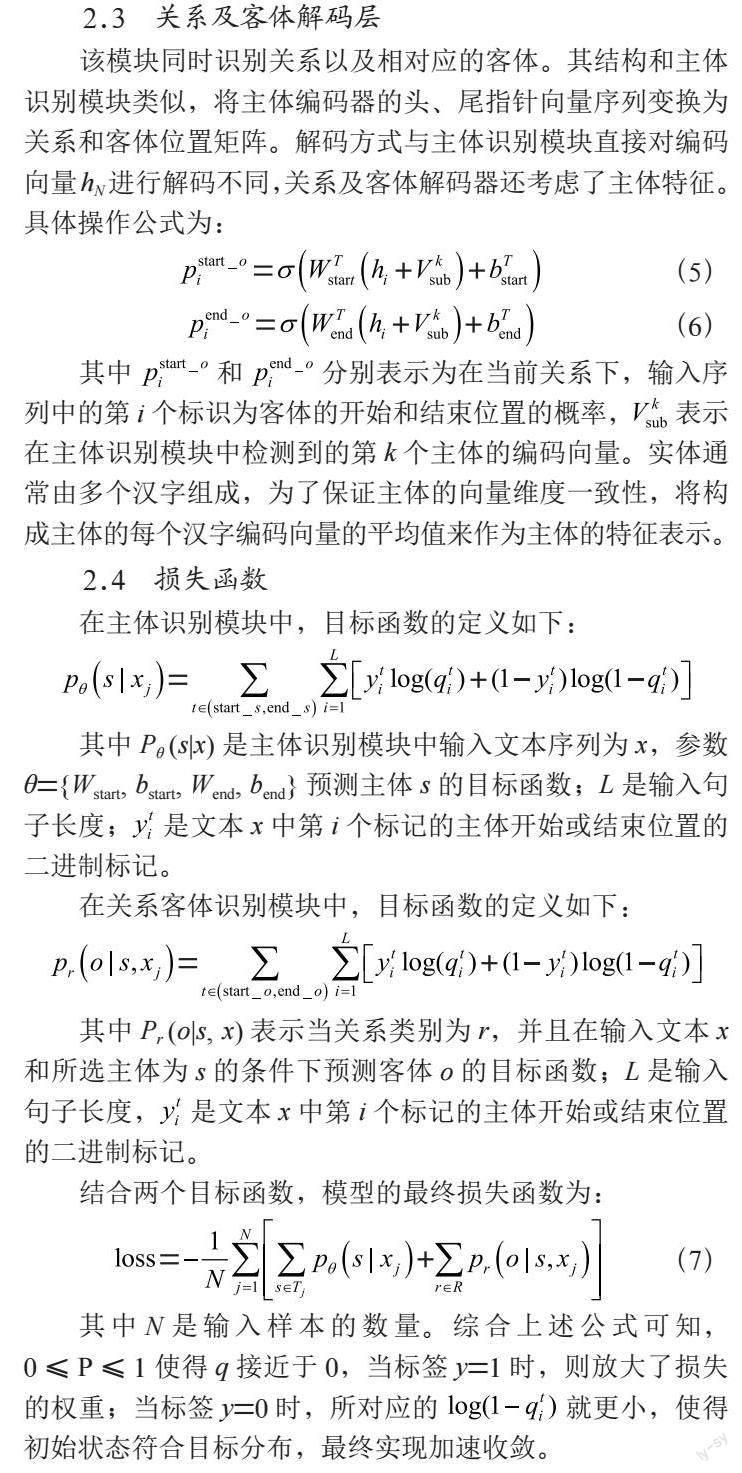

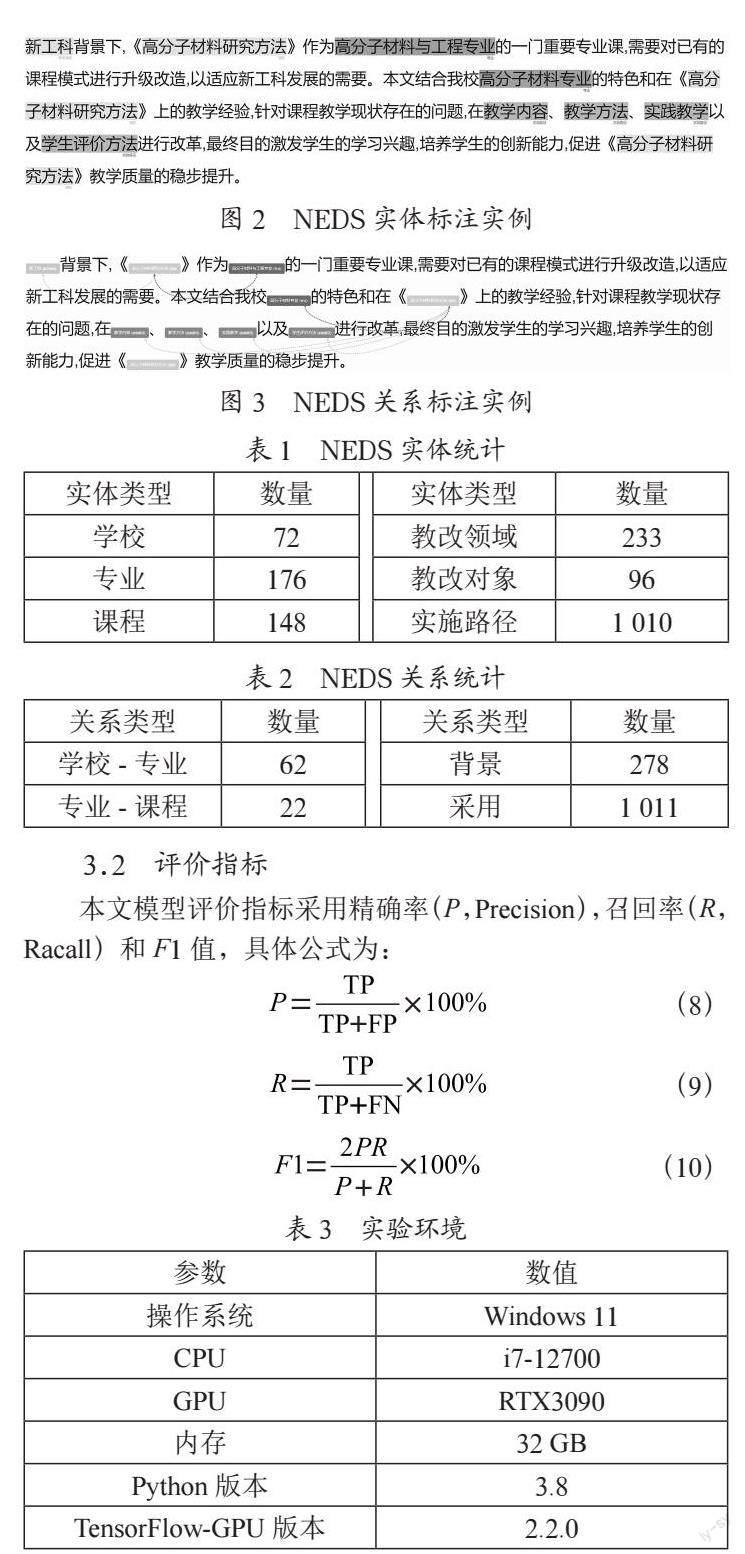

实验原始数据来自中国知网,选自高等教育领域新工科视角下的北大核心文献,共计252篇构成新工科数据集NEDS对其摘要部分进行人工标注,将其划分为训练集162篇,测试集45篇,验证集45篇。由小组讨论定义实体与关系类型,通过标注工具进行人工标注,如图2、图3所示。NEDS数据集包含六个实体类型、四个关系类型,统计情况如表1和表2所示。

3.2 评价指标

本文模型评价指标采用精确率(P,Precision),召回率(R,Racall)和F1值,具体公式为:

其中,TP为模型预测出的三元组信息与文本数据中正确的三元组信息相同的个数,FP为模型预测出的三元组信息不属于文本数据中正确的三元组信息的个数,FN为模型未能预测出正确三元组的个数。

3.3 实验环境

本文实验环境如表3所示。

3.4 参数设计

本文模型参数设计:BERT预训练模型Chinese_Roberta_wwm_ext_L-12_H-768_A-12,学习率为0.000 01,批量大小为8,句子最大长度为512,模型优化器选择Adam,Sigmoid函数阈值0.5,字嵌入维度768。

3.5 实验结果与分析

为验证本文模型的有效性,在自建数据集NEDS上与其他三种方法进行了实验对比。可分为两类:流水线式抽取方法和联合式抽取方法。

对于流水线式的抽取方法,先命名实体识别然后进行关系抽取,本文模型与以下两种流水线式的方法进行对比:

1)BERT+LSTM:使用BERT-CRF进行命名实体识别,然后使用LSTM进行关系抽取。

2)BERT+BiLSTM:使用BERT-CRF进行命名实体识别,然后使用BiLSTM进行关系抽取。

对于联合式的抽取方法,本文模型与Casrel进行了实验对比。

3)Casrel:Wei[13]等人提出的新的级联二进制标记框架的联合抽取模型,它将关系建模为映射到句子中对象的函数,很好的解决了关系重叠问题。

从表4可以看出本文模型与流水线式抽取方法BERT+LSTM和BERT+BiLSTM相比在NEDS数据集上表现更为优秀,F1值分别提高了23.37%和14.17%,这是因为本文模型没有误差传播问题,加强了命名实体识别和关系抽取两个子任务之间的依赖性,并且本文模型所使用的指针网络相比序列标注能够更好地解决关系重叠问题。Casrel模型和本文模型对关系重叠问题都有着不错的表现,本文模型与Casrel模型在精确值、召回率和F1值分别有2.03%、0.82%和1.39%的提升。主要原因是在编码层上本文模型使用了RoBerta对输入句子进行编码,与BERT模型相比,能够更好地适应中文语料并且在模型规模、算力和数据量上都有所提高;在解码层上本文采用层叠指针标注策略,提高了对关系重叠问题的识别率。

为了更形象的表示本文模型性能,将上述模型的实验迭代过程进行对比,如图4所示,本文模型相比其他模型在更短的训练周期达到稳定,并且能够在最短的训练周期达到最高的F1值,进一步体现了本文模型的有效性。

4 结 论

本文在高等教育领域新工科视角下定义了6种实体类型和4种关系类型并构建了NEDS数据集。设计了一种基于指针网络的实体关系抽取方法,通过实验,本文模型在自建数据集NEDS上的精确率、召回率和F1值分别达到了83.56、76.25、79.74,为后续构建教育改革类知识图谱提供了数据支持。

参考文献:

[1] LAMPLE G,BALLESTEROS M,SUBRAMANIAN S,et al. Neural Architectures for Named Entity Recognition [J/OL].arXiv:1603.01360 [cs.CL].[2022-10-06].https://arxiv.org/abs/1603.01360v1.

[2] COLLOBERT R,WESTON J,BOTTOU L,et al. Natural Language Processing (almost) from Scratch [J].The Journal of Machine Learning Research,2011,12:2493-2537.

[3] CHIU J P C,NICHOLS E. Named Entity Recognition with Bidirectional LSTM-CNNs [J].Computer Science,2016,4:357-370.

[4] SHEN Y Y,YUN H,LIPTON Z C,et al. Deep Active Learning for Named Entity Recognition [J/OL].arXiv:1707.05928 [cs.CL].[2022-10-06].https://arxiv.org/abs/1603.01360v1.

[5] HUANG Z H,WEI X,KAI Y. Bidirectional LSTM-CRF Models for Sequence Tagging [J/OL].arXiv:1508.01991 [cs.CL].[2022-10-06].https://arxiv.org/abs/1508.01991.

[6] 閆雄、段跃兴、张泽华.采用自注意力机制和CNN融合的实体关系抽取 [J].计算机工程与科学,2020,42(11):2059-2066.

[7] GAN T,GAN Y Q,HE Y M. Subsequence-Level Entity Attention LSTM for Relation Extraction [C]//2019 16th International Computer Conference on Wavelet Active Media Technology and Information Processing.Chengdu:IEEE,2019:262-265.

[8] MIWA M,BANSAL M. End-to-End Relation Extraction using LSTMs on Sequences and Tree Structures [J/OL].arXiv:1601.00770 [cs.CL].[2022-10-06].https://arxiv.org/abs/1601.00770v2.

[9] ZHENG S C,HAO Y X,LU D Y,et al. Joint Entity and Relation Extraction Based on A Hybrid Neural Network [J].Neurocomputing,2017,257:59-66.

[10] LI F, ZHANG M S,FU G H,et al. A neural joint model for entity and relation extraction from biomedical text [J/OL].BMC Bioinformatics,2017,18:1-11[2022-10-06].https://link.springer.com/content/pdf/10.1186/s12859-017-1609-9.pdf.

[11] ZHENG S C,WANG F,BAO H Y,et al. Joint Extraction of Entities and Relations Based on a Novel Tagging Scheme [J/OL].arXiv:1706.05075 [cs.CL].[2022-10-09].https://arxiv.org/abs/1706.05075v1.

[12] EBERTS M,ULGES A. An End-to-end Model for Entity-level Relation Extraction using Multi-instance Learning [J/OL].arXiv:2102.05980 [cs.CL].[2022-10-09].https://arxiv.org/abs/2102.05980v2.

[13] WEI Z P,SU J L,WANG Y,et al. A Novel Cascade Binary Tagging Framework for Relational Triple Extraction [C]//Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics.[S.I.]:Association for Computational Linguistics,2020:1476-1488.

[14] LIU Y H,OTT M,GOYAL N,et al. RoBERTa: A Robustly Optimized BERT Pretraining Approach [J/OL].arXiv:1907.11692 [cs.CL].[2022-10-09].https://arxiv.org/abs/1907.11692.

作者簡介:李世龙(1997—),男,回族,河南平顶山人,硕士研究生在读,研究方向:自然语言处理;张浩军(1969—),男,汉族,浙江杭州人,博士,教授,硕士生导师,研究方向:人工智能;李大岭(1997—),男,汉族,河南濮阳人,硕士研究生在读,研究方向:自然语言处理;王家慧(1997—),女,汉族,河南开封人,硕士研究生在读,研究方向:光网络故障定位;齐晨阳(1998—),男,汉族,河南周口人,硕士研究生在读,研究方向:数据挖掘。