基于级联注意力与密集特征融合的图像修复算法

臧升睿 陈敏 艾振华 于腾 迟洁茹 杨国为

摘要:针对图像修复算法存在的语义不连贯、纹理不清晰等问题,提出一种基于生成对抗网络的新型级联密集生成网络CDGAN(Cascade Densely Generative Adversarial Network),采用encoder-decoder作为生成器主干,利用下采样提取图像特征;为使网络关注修复图像的高频纹理和颜色保真度等有效信息,引入级联的注意力模块,并加入密集特征融合模块扩大网络的整体感受野,充分学习图像特征,提高编码器提取特征的利用率,最后将处理后的图像特征进行上采样重建。在Celeb A和Places2数据集的测试结果表明,CDGAN在语义连贯性、纹理清晰度等方面都有所提升。

关键词:生成对抗网络;图像修复;注意力机制

中图分类号:TP391.41

文献标志码:A

文章编号:1006-1037(2023)02-0030-06

doi:10.3969/j.issn.1006-1037.2023.02.06

基金项目:

国家自然科学基金(批准号:62172229)资助。

通信作者:

于腾,男,博士,副教授,主要研究方向为人工智能与计算机视觉,图像增强,去雾去噪,目标检测等。

图像修复技术最早是Bertalmio等[1]受文物修复的启发在SIGGRAPH国际学术会议上提出的概念,现已成为计算机视觉领域的重要研究课题之一,主要利用缺失区域周边或者外部的辅助数据对受损图像区域推理和修复。现有的修复方法主要分为传统修复方法和基于深度学习的修复方法。传统图像修复方法主要有基于像素插值、扩散和补丁匹配等方法,但如果给定的图像是唯一的或非重复的,如人脸和景观等,这些方法大多会产生伪影、结构缺失等问题。近来,基于深度学习的图像修复方法取得了重大发展,以出色的图像生成能力而闻名的生成对抗网络(Generative Adversarial Networks,GAN)[2]被广泛应用于图像处理领域。上下文编码器采用深度生成模型,使用重建和对抗性损失根据缺失区域周围信息预测场景的缺失区域,第一次将生成对抗网络思想应用到图像修复上[2]。基于GAN的图像修复算法使用多鉴别器修复图像[3];基于全卷积网络改进的U-Net结构使用跳跃连接融合不同尺度的图像特征[4];Shift-Net将U-Net结构[5]中的全连接层替换为Shift Connection层,将图像缺失区域周围的信息特征进行转移[6];语义注意力模块(Contextual Attention Module, CAM)可以实现对图像语义特征信息的生成重建[7];TransFill通过引用与目标图像共享场景内容的另一个源图像来填充缺失区域[8];MISF将图像修复视为过滤任务,以此实现高保真修复[9]。然而,这些方法修复的图像依旧存在模糊伪影,因为专注于生成视觉上结构一致,而忽略了修复结果的纹理和稳定性。针对目前图像修复中存在语义不连贯、纹理不清晰的现象,CBAM(Convolutional Block Attention Module)[10]可以序列化地在特征图通道和空间两个维度产生注意力信息,极大地提升了网络整体的鲁棒性。膨胀卷积[11]可以增大网络的整体感受野,增加修复图像局部细节。本文构建了一个以encoder-decoder为基础的级联密集生成对抗模型CDGAN(Cascade Densely Generative Adversarial Network),加入跳跃连接层,并添加了改进的通道注意力与像素注意力相级联的级联注意力模块和由不同膨胀率的膨胀卷积层组成的密集特征融合模块,获得了具有高级语义和清晰纹理的修复图像。

1 方法

1.1 整体网络框架

整体网络采用encoder-decoder作为框架,编码器通过下采样的卷积层和池化层提取图像特征,解码器将提取的图像特征进行解码重建,生成新的特征图。为保留图像的细节特征,模型下采样前的卷积层和相应的反卷积层之间添加跳跃连接,避免计算成本的快速增加[12]。模型下采样与上采样之间加入级联注意力以及密集融合模块,下采样后的特征图需更精细的处理。整体的网络结构图如图1所示。

1.2 级联注意力模块

基于卷积神经网络的图像修复算法大多对图像的通道和像素特征处理方式相同,但由于受损图像的不同通道以及不同像素上的關键信息分布不均匀,图像中与缺失区域相关的信息和无关信息的权重有显著差异。一些像素在至少一种颜色(RGB)通道中具有非常低的强度,说明不同的通道特征具有完全不同的加权信息[13]。如果平等地处理这些信息,网络将缺乏覆盖所有像素和通道的能力,而且将极大地限制网络的表征能力。

通道注意力机制可以自适应的预测通道中潜在的关键特征,计算出输入图像各个通道的权重,使网络模型将关注力更多放在信息量最大的通道特征上,阻抑信息量小的通道特征。级联注意力模块将通道注意力和像素注意力在通道级和像素级特征上结合,获得自适应学习权重并与输入特征相乘得到关键特征,使网络更多地关注高频纹理和颜色保真度等有效信息。

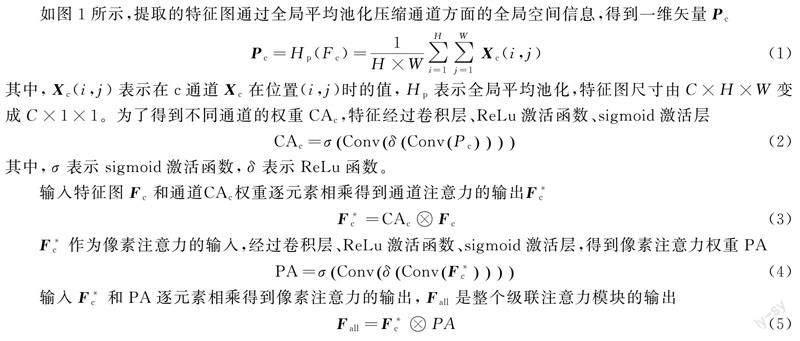

如图1所示,提取的特征图通过全局平均池化压缩通道方面的全局空间信息,得到一维矢量Pc

其中,Xc(i,j)表示在c通道Xc在位置(i,j)时的值,Hp表示全局平均池化,特征图尺寸由C×H×W变成C×1×1。为了得到不同通道的权重CAc,特征经过卷积层、ReLu激活函数、sigmoid激活层

其中,σ表示sigmoid激活函数,δ表示ReLu函数。

输入特征图Fc和通道CAc权重逐元素相乘得到通道注意力的输出F*c

F*c作为像素注意力的输入,经过卷积层、ReLu激活函数、sigmoid激活层,得到像素注意力权重PA

输入F*c和PA逐元素相乘得到像素注意力的输出,Fall是整个级联注意力模块的输出

1.3 密集特征融合模块

特征融合在神经网络设计中应用广泛,利用不同层的特征来提高性能。图像修复时,尽可能大的感受野有利于修复破损区域。膨胀卷积通常被用来实现扩大感受野,既增加了可作为输入的区域,又不增加可学习权重的数量。然而,膨胀卷积的卷积核是稀疏的,应用在计算过程中跳过了许多像素。虽然应用大卷积核可以解决这一问题,但是引入了大量的模型参数,加大计算成本。为了扩大感受野的同时确保密集的卷积核,本文采用密集特征融合模块,如图3所示。

密集特征融合模块首先使用卷积核为3的卷积层将输入特征的通道数从256个减少到64个,以减少网络中冗余的参数;这些加工过的特征被送到4个带有不同膨胀率的膨胀卷积分支以提取多尺度特征,分别表示为fi(i=1,2,3,4)。除f1外,其余fi都有一个对应的卷积核为3的卷积层,用Qi()表示。通过累积相加法,可以从各种稀疏多尺度特征的组合中得到密集的多尺度特征。Fi表示Qi()的输出

文中使用1×1卷积融合各尺度特征。实验证明,密集特征融合模块扩大了一般扩张卷积的感受野,并没有增加网络的参数量。

1.4 损失函数

为了更好地恢复缺失图像中的语义和真实细节,将像素重建损失、对抗损失、感知损失、风格损失相结合共同训练CDGAN模型。像素重建损失表示为

其中,E(*)为分布函数的期望值,D和G分别为判别器和生成器,G(z)为输入为z时生成器G生成的虚假样本,pdata(x)是真实图像的分布,z~pz(z)是破损图像的分布。

为提高修复结果的整体一致性,本文添加风格损失

其中,Gi(X)是根据σ的激活而构造的大小为Ci×Ci的Gram矩阵,Ci为通道数,X′表示预测图像。

总的损失函数为

其中,ω1,ω2,ω3分别表示平衡不同损失项贡献的超参数,分别设置为1,0.1,250。

2 实验结果与分析

2.1 数据集及环境配置

验证实验在Celeb A[14]人脸数据集和Places2[15]场景数据集上开展。实验设备的显卡NVIDIA GeForce RTX 2080Ti GPU,操作系统Ubuntu 18.04,运行环境为Pytorch框架,搭配Python的多个库。模型训练选择Adam优化器进行参数优化,初始学习率设置为2×10-4。输入任意尺寸的图像,通过预处理将图像尺寸裁剪为256×256大小。

2.2 评价指标

为验证CDGAN模型的性能,采用峰值信噪比(Peak Signal to Noise Ratio,PSNR)和结构相似性指数(Structural Similarity, SSIM)[16]这两个标准指标对其定量评估。PSNR和SSIM可以反映模型重构原始图像内容的能力

其中,h、w和p分别代表生成图像的高度、宽度和颜色通道,μX、μX′、σXX′分别是X、X′的局部均值、标准差和互协方差。C1、C2是正则化常数,为了避免在局部均值或标准差接近零时出现不稳定的情况,C1、C2 通常取值为0.012,0.032。

2.3 對比实验与消融实验

为了直观的展示本文模型CDGAN的有效性,将其与 MEDFE[17]、RFR[18]、PIC[19]、GMCNN[20]、DSI[21]算法的修复结果做了比较。图4为CDGAN与以上方法在CelebA-HQ数据集上对中心规则掩码修复的结果对比图,输入的图像如图4(a)所示,图4(g)表示真实图像。MEDFE的结果中包含扭曲的结构和不和谐的面孔,RFR和PIC对图像纹理的修复效果不理想而且存在明显的伪影,GMCNN的修复结果对人脸进行美颜磨皮,使图像纹理失去真实性。CDGAN得到了更合理、自然和逼真的图像。

表1为在CelebA-HQ人脸数据集和Places2场景数据集上,利用评价指标对中心掩码的图像修复结果进行定量分析,可以看出,CDGAN要优于其他算法模型。

2.4 消融实验

为了验证密集特征融合模块的表征能力,将不同膨胀率的4个膨胀卷积(4个膨胀卷积和组合操作)统一替换为膨胀率为2的3×3膨胀卷积(见表2和图5)。可知,带有普通的膨胀卷积的网络模型对破损区域结构的色彩修复存在较多伪影,带有密集特征融合模块的模型预测得更合理,伪影更少,表明大而致密的感受野有利于完成大孔洞的图像修复。

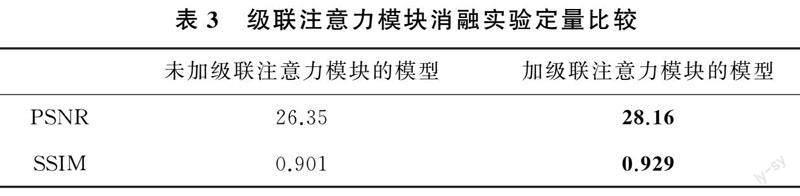

为证明级联注意力模块在CDGAN中的影响,比较了有/没有级联注意力模块的结果,如图6和表3所示。未加级联注意力模块的网络模型得到的结果,对于眉毛的修复杂乱无章,眼睛也修复得无神,加有级联注意力模块的确实可以使网络修复到更多关于缺失区域的纹理细节。

3 结论

本文提出的对破损图像进行纹理精细修复的CDGAN模型,以生成对抗网络作为基础框架,生成器采用encoder-decoder,加入改进的级联注意力模块,调整通道特征,重定特征权重;添加密集特征融合模块,借助于密集扩张卷积增大网络感受野,同时未增加网络参数,提升了网络的整体性能;并在网络的整体损失函数优化上增加了风格损失函数,加强破损图像的已知区域与破损区域之间的约束关系。CDGAN模型在不同场景图像的修复中,能够生成纹理清晰, 语义连贯的图像,且在定性指标PSNR、SSIM上表现良好。

参考文献

[1]BERTALMIO M, SAPIRO G, CASELLES V, et al. Image inpainting[C]// 27th Annual Conference on Computer Graphics and Interactive Techniques. New York, 2000: 417-424.

[2]GOODFELLOW I, P0UGET-ABADIE J, MIRZA M, et al. Generative adversarial networks[J]. Communications of the ACM, 2020, 63(11): 139-144.

[3]PATHAK D, KRHENBHL P, DONAHUE J, et al. Context encoders: feature learning by inpainting[C]// 2016 IEEE Conference on Computer Vision and Pattern Recognition(CVPR). Seattle, 2016: 2536-2544.

[4]IIZUKA S, SIMO-SERRA E, ISHIKAWA H. Globally and locally consistent image completion[J]. ACM Transactions on Graphics, 2017, 36(4):107.

[5]RONNEBERGER O, PHILIPP F, THOMAS B. U-net: Convolutional networks for biomedical image segmentation[C]// 18th International Conference on Medical Image Computing and Computer-assisted Intervention. Springer, 2015: 234-241.

[6]YAN Z Y, LI X M, LI M, et al. Shift-net: Image inpainting via deep feature rearrangement[C]// 15th European Conference on Computer vision(ECCV). Munich, 2018: 1-17.

[7]YU J H, LIN Z, YANG J M, et al. Generative image inpainting with contextual attention[C]// 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, 2018: 5505-5514.

[8]ZHOU Y Q, BARNES C, SHECHTMAN E, et al. TransFill: Reference-guided image inpainting by merging multiple color and spatial transformations[C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition.Electr Network, 2021: 2266-2276.

[9]LI X G, GUO Q, LIN D, et al. MISF: Multi-level interactive siamese filtering for high-fidelity image inpainting[C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition.New Orleans, 2022: 1859-1868.

[10] WOO S H, PARK J, LEE J Y, et al. Cbam: Convolutional block attention module[C]// 15th European Conference on Computer Vision.Munich, 2018: 3-19.

[11] YU F, KOLTUN V. Multi-scale context aggregation by dilated convolutions[C]// International Conference on Learning Representations (ICLR).PuertoRico, 2016: 28-36.

[12] 王豫峰. 基于殘差网络的图像缺失修复研究[J]. 现代计算机, 2022, 28(12):69-74.

[13] HE K M, SUN J, TANG X O. Single image haze removal using dark channel prior[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33(12): 2341-2353.

[14] HE K M, ZHANG X Y, REN S Q, et al. Deep residual learning for image recognition[C]// 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Seattle, 2016: 770-778.

[15] ZHOU B, KHOSLA A, LAPEDRIZA G, et al. Places: An image database for deep scene understanding[J]. Journal of Vision, 2017, 17(10): 296-296.

[16] HORE A, ZIOU D. Image quality metrics: PSNR vs. SSIM[C]//2010 20th International conference on pattern recognition. Istanbul, 2010:23-26.

[17] LIU H Y, JIANG B, SONG Y B, et al. Rethinking image inpainting via a mutual encoder-decoder with feature equalizations[C]// 16th European Conference on Computer Vision. Glasgow, 2020: 23-28.

[18] LI J, WANG N, ZHANG L, et al. Recurrent feature reasoning for image inpainting[C]// IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Seattle, 2020: 7757-7765.

[19] ZHENG C X, CHAM T J, CAI J F. Pluralistic image completion[C]// 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach, 2019: 1438-1447.

[20] WANG Y, TAO X, QI X J, et al. Image inpainting via generative multi-column convolutional neural networks[C]// 32nd International Conference on Neural Information Processing Systems. Vancouver, 2018: 329-338.

[21] PENG J L, LIU D, XU S C, et al. Generating diverse structure for image inpainting with hierarchical VQ-VAE[C]// 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2021: 10770-10779.