基于生成对抗网络的乳腺MRI图像生成

王红玉,朱天薏,冯 筠,丁松涛,王苹苹,陈宝莹

(1.西安邮电大学 计算机学院,陕西 西安 710121;2.西安邮电大学 陕西省网络数据分析与智能处理重点实验室,陕西 西安 710121;3.西安市大数据与智能计算重点实验室,陕西 西安 710121;4.西北大学 信息科学与技术学院,陕西 西安 710127;5.西安国际医学中心 医院影像诊疗中心,陕西 西安 710110)

医学影像在各种疾病的诊断和治疗中起着至关重要的作用。通常不止一种成像模式涉及临床决策,因为不同的模式会提供互补的见解[1]。例如计算机X线摄影(computed radiography,CR)、计算机断层扫描(computed tomography,CT)、磁共振成像(nuclear magnetic resonance imaging,MRI)等多种成像方式[2]。其中,MRI对软组织有很好的对比,MRI按扫描方式可以分为常规扫描和功能扫描,常规扫描包括T1加权、T2加权成像等;功能成像包括弥散加权成像(diffusion weighted imaging,DWI)、灌注加权成像(perfusion weighted imaging,PWI)等,这些成像序列可以从不同方面反映人体组织的不同信息,构成多序列MRI。与CT相比,MRI也更安全,不涉及任何辐射,但它最大的缺点是原始数据是在包含空间频率信息的k空间中连续采集的,采集时间长[3]。这种缓慢的成像速度会引起患者的不适[3],容易造成多序列MRI数据缺失的情况,使得严格依赖多序列MRI输入的诊断无法进行。研究表明,融合多序列特征对于乳腺癌诊断至关重要[4],但由于设备、医院、病人自身等原因,采集到的乳腺MRI数据有时会存在序列数据缺失的情况。

随着人工智能的发展,传统机器学习方法已无法满足日益复杂的医学应用场景,因此,深度学习技术逐渐被引入。利用深度学习进行缺失数据生成,可以缓解由数据缺失所引起的联合诊断精度不高的问题,准确的生成结果可以为医生对病情的定量分析提供精确测量数据,进一步提高医生的工作效率。在医学图像处理方面,由于设备损坏、不正确使用、病人对造影剂过敏等情况,导致部分采集的多序列图像存在缺失、伪影等问题,使得严格依赖于多序列的诊断工作无法顺利进行,因此,需要引入生成模型进行医学数据扩充或增强等数据预处理操作,进而开展下一步工作。目前,医学图像常用的深度学习生成模型主要是以生成对抗网络(generative adversarial networks,GAN)为基础的变体,GAN主要分为两个模块:生成器和判别器,两个模块通过互相博弈学习产生结果。生成器输入一般为随机噪声,噪声进入生成器得到一个输出,判别器输入为原始数据和生成数据,用来判断输入的样本是原始数据还是生成数据,通过损失来不断调节整个网络训练,直到判别器无法判断,即无论对于生成数据还是真实数据,判别器输出结果概率都是0.5。其中,Pix2Pix[5]和Cycle-consistency[6]是医学图像相互转换生成的两种主要模式。然而这两种模式在处理多序列MRI的生成中都不是理想的。Pix2Pix虽然具有优异的性能,但对训练数据要求较严,需要成对的和像素对齐的图像,这不一定总能实现。而Cycle-consistency虽然对训练数据要求不像Pix2Pix那么严格,它可以接受源域和目标域有未配准的误差,但没有对这种误差进行处理,导致生成效果也没有达到最优,并且训练也非常不稳定。

针对以上问题,本研究以RegGAN[7]作为基础网络,根据医学图像具有目标区域局部化这一特性,在生成器部分引入通道注意力和空间注意力机制,利用全局最大池化和平均池化使网络更加关注图像中感兴趣区域(region of interest,ROI),以获得较大的感受野和空间信息,使生成图片包含尽量完备且丰富的信息,进而改善生成性能。针对生成对抗网络训练不稳定出现模式崩溃的情况,从而影响肿瘤生成效果的问题,本文在判别器中加入梯度正则化模块,提高网络训练的稳定性,进一步提高生成性能。通过实验验证本文方法与目前主流的医学图像生成方法相比性能有效提升。

1 相关工作

医学图像生成从最初基于传统学习的方法到近年来基于深度学习的方法,都进行了许多实验并取得了相应进展。传统算法的关键是提取有效的特征构建映射关系[8],但与自然图像相比,不同模态的医学图像信息特征要复杂得多。近年来,机器学习在计算机视觉领域取得了重大进展,并逐渐成为医学影像的一个重要研究领域。机器学习极大拓展了医学影像领域的研究方向和各种临床应用,促进了放疗和放射医学影像学的发展[8]。在医学影像生成领域,基于机器学习的模型也提高了不同医学模态图像之间的相互转换生成能力。这里所指的医学模态转换生成既包括不同医学成像技术的图像转换生成,如MR-CT、PET-CT图像转换生成,也包括相同成像技术但不同扫描参数的医学图像的相互转换,如MR的T1加权图像和MR的T2加权图像之间的相互转换生成等。由此可预见,医学模式转换生成技术的进步可能会日益扩大临床应用[9]。

基于深度学习的方法比传统的医学图像生成方法更灵活。通用的网络结构可以以最小的成本迅速适应其他任务,例如,通过调整参数,从而增加了在临床所需的不同成像模式之间生成快速扩展的可能性[8]。另一方面,基于深度学习的方法性能主要取决于训练数据集的质量和数量。虽然事先需要花费很多精力来收集和处理训练数据,但一旦模型训练完成,图像预测在较短的时间即可完成。在临床环境中可以获得大量回溯性的各种模态的图像数据,这一点很适合数据驱动型的深度学习方法。

深度学习在逆问题上的巨大成功促使其在医学成像领域迅速得到应用[10-11]。该领域的早期研究提出了基于斑块级处理的局部网络[12-14],虽然局部网络比传统方法更有优势,但它们对整个图像中更广泛的背景表现出有限的敏感性[15]。后来的研究采用了深度CNN进行图像级的处理,随着大型成像数据库的可用性不断增加,基于CNN的生成已经在各种应用中得到成功证明,包括跨MR扫描仪的生成[16-17]、多对比度MR生成[18-20]和CT生成[2,21-22]。尽管它们能带来重大的改进,但用像素级损失训练的CNN往往会遭受不理想的细节结构的损失[23]。

为了改善对结构细节的捕捉,研究人员提出GANs来学习以源模态为条件的目标模态分布[24]。对抗性损失使GANs能够为恢复高空间分辨率的信息捕获更好的先验[23]。近年来,基于GANs的方法被证明在许多生成任务中具有最先进的性能,包括数据增强以及多模态生成[25-26]。GANs模型的重要应用包括CT转PET[27]、MR转CT[2]、无配对的跨模式[28]、3T转7T[29]和多对比度MRI生成[23,30]等。Liu等人提出将密集块整合到周期生成对抗网络中,有效捕获CT和MRI之间的关系以进行CT生成[2]。Modanwal等人在训练过程中引入相互信息损失,并提出了一种改进的判别器架构,利用更小的视野来确保乳房组织中更精细的细节的保存[31]。Fernandez等人提出了brainSPADE模型,该模型结合了基于生成扩散的标签生成器和语义图像生成器,将生成数据用来训练分割模型,并通过实验证明其性能与用真实数据训练的模型相当[32]。

总体来说,使用深度学习的方法在一定程度上可以实现不同模态医学影像转换生成,目前GANs已经应用于大量图像到图像的转换生成任务中[33]。GANs成功的关键是对抗损失[33]的思想,它使生成的图像在原则上与真实图像难以区分。虽然GANs模型已经成为医学影像生成一种主流方法,但上述研究并非没有局限性,比如,目前大量的研究都是将对齐数据进行转换生成,或是忽略医生更关注局部信息这一特性,直接对全局进行生成。除此之外,许多研究人员在利用GANs模型对医学影像进行生成时,忽略了GANs本身训练不稳定这一情况。因此,针对这些问题,本文提出一种基于特征增强的双注意力配准生成对抗网络(feature-enhanced dual-attentive registration-based generative adversarial networks,DA-RegGAN),分别对生成器和判别器部分进行改进,以此来提高网络的生成质量。

2 乳腺MRI图像生成网络

2.1 算法整体框架

本文提出的基于特征增强的双注意力配准生成对抗网络DA-RegGAN结构如图1所示。网络输入原始的乳腺DCE图像,进入生成器得到生成的DWI图像,生成器引入卷积注意力机制(convolutional block attention module,CBAM),用于获得更大的感受野,以获得更全面的病灶信息。对于配准网络R,假设输入x是A病人的DCE图像,经过生成器G得到A病人的DWI图像G(x)。y是B病人真实的DWI,G(x)和y进入到配准网络R中进行配准,得到配准图像R(G(x),y),即让网络认为A病人生成的DWI图像G(x)是B病人得到的,属于同一病人的数据。判别器D用于判断生成图像真假,为了网络获得更稳定的一个训练,在判别器之后结合梯度正则化进一步提高网络的生成质量,通过校正损失和对抗损失不断调节网络训练。引入的卷积注意力和梯度正则化这两个模块既改善了医学图像生成过程中由于存在病灶过小而生成效果不够精确的问题,又改善了由于GANs网络本身训练不稳定而引起的结果不准确的问题,使得生成数据和真实数据相比具有更高的相似性。

图1 DA-RegGAN结构Fig.1 DA-RegGAN structure

2.2 基于卷积注意力的生成配准模块

由于乳腺肿瘤图像数据量少且肿瘤病变形态、大小差异大,以致对乳腺肿瘤良恶性进行诊断具有一定的难度,而生成更清晰的病灶并对缺失数据进行补充生成有助于提高乳腺肿瘤良恶性诊断的准确性。因此,设计一个既能关注病灶区域的生成,又能使生成结果更接近原始图像的生成网络至关重要。针对上述问题,本文首先对生成器进行设计,引入CBAM模块。生成器结构如图2所示。将原始DCE图像输入生成器中,生成器先对图片边界进行填充,经过4个特征提取层,每个特征提取层包含1个卷积层以及对应的归一化层、ReLU层。然后,经过以残差结构为基础的下采样,提取深层特征。在残差的基础上引入CBAM模块,最后,对提取到的特征进行上采样,输出层使用Tanh激活函数,得到最终的DWI生成结果。CBAM结合通道注意力和空间注意力的生成器结构用于获得更大的感受野,输入的特征图分别通过全局最大池化和全局平均池化使网络更关注感兴趣区域,通过这两个模块分别对输入特征图在通道和空间进行自适应特征选择和增强,突出主要特征,抑制无关特征,使网络更加关注需要生成目标的内容信息和位置信息,以提高网络的生成精度。生成器生成的DWI输入如图1所示的配准网络R,以此减少未严格对齐的数据引起的生成误差。

图2 DA-RegGAN生成器结构Fig.2 DA-RegGAN generator structure

2.3 基于梯度正则化的判别器模块

(1)

而这样可能存在除0错误,所以将|D(x)|也加到了分母中,以此保证函数的有界性,如式(2),

(2)

2.4 损失函数

本文模型主要通过对抗损失和校正损失不断调节网络训练。在对抗训练的过程中,GAN的生成器和判别器交替训练以最小化它们的损失,定义如式(3),

Ex[log(1-D(G(x)))]

(3)

对抗损失计算在判别器D输出处产生,训练一般是先固定生成器G,训练判别器D,D训练的目标是能够将真实的乳腺DWI样本准确识别,所以期望D(y)越趋近1,也就是越大越好,因此,有maxD。然后保持D不变,训练G,生成器希望尽可能生成接近真实样本,即第2项越小越好,这就是minG。通过判别器产生的误差不断更新生成器,提高网络的生成质量。对于校正损失,主要是将未严格配对的乳腺图像看成有噪声的标签,而这个噪声主要是由于空间位置的不配对带来的,因此,以生成器G之后的配准网络R作为标签噪声模型来校正结果。

3 实验

3.1 实验设置

本文使用来自某医院采集的98位病人乳腺MRI数据作为研究数据,其包含医学专家对每个病灶图像病变区域的划分。如表1所示,图像包含从良性病变到恶性病变的组织学分级,训练集图像包括647幅良性和1 050幅恶性,共1 697幅。测试集图像包括210幅良性和338幅恶性,共548幅。在测试集中,良性病变和恶性病变样例比例为105:169,比例较为均衡。

乳腺肿瘤良恶性病变样例如图3所示。可以观察到,在T1序列、DCE序列以及DWI序列中,良性病变内皮细胞较为完整,肿瘤中心和周边无明显差异,而周边间质血管的分布明显高于肿瘤中心。对于恶性病变,肿瘤的生长需要大量的血液供应,所以肿瘤间质中微血管数目增多,内皮间隔较大,没有外膜。DWI通过捕捉水分子的运动状态来获得成像,观察图3可得,良性病变的DWI图像肿瘤区域与周围细胞对比明显,肿瘤边缘明显,对于恶性病变,信号强度高于良性病变。图3中T1为未注射造影剂前5~10 min内扫描的图像,DCE-1为注射造影剂后2 min内拍摄的图像,DCE-2为增强高峰图像,MASK为医生标注的病灶区域。不同序列的病灶区域部分分别用红色框和绿色框框出。

本实验使用PyTorch1.10库、python3.6平台进行代码编写,在12 GiB NVIDIA GTX 3060 Ti GPU的服务上进行实验。网络模型训练时,参数按随机梯度下降进行优化,学习率设置为0.000 1,优化器为Adam,训练迭代次数为80。

表1 乳腺MRI数据集的组成Tab.1 Composition of the breast MRI dataset

图3 乳腺数据集良恶性样例Fig.3 Sample of benign and malignant breast dataset

3.2 DA-RegGAN消融实验

为了验证引入的卷积注意力机制和梯度正则化对提高乳腺DCE在局部病灶及全局生成DWI图像精度的效果,进行了消融实验,结果如表2所示。本文使用标准平均绝对误差(normalized mean absolute error,NMAE)、峰值信噪比(peak signal to noise ratio,PSNR)、结构相似性(structural similarity,SSIM)这3类评价指标对生成结果进行评估。基础网络使用的是加入配准模块的图像转换生成对抗网络,CBAM表示卷积注意力机制,GN表示梯度正则化。CBAM和GN两者之间的关系包括:①在整体框架中的位置不同,CBAM在生成器部分,GN在判别器部分;②作用方式不同,CBAM在生成器中加强有用的特征生成并抑制无用的特征,GN在判别器训练之后添加Lipschitz约束,这两个模块同时都可以提高模型的性能,只是作用的角度不同;③解决问题方向不同,CBAM主要用于增强网络感知力,使网络更关注并学习感兴趣区域,能够自适应地分配通道和空间级别的注意力以提高模型的性能,GN主要用于解决GAN训练过程中模式容易崩溃或消失等一系列不稳定问题,通过添加约束来提高模型训练速度和准确性。从表2中可以看到,在不使用注意力模块,而只使用GN对网络进行训练时,GN对于图像全局生成质量有所提升,表明GN模块可以提高网络的生成性能。而仅加入CBAM模块,对于图像生成质量也有所提升,且对于病灶生成的PSNR指标相对最好,说明本文实验使用的CBAM模块有助于网络模型对于乳腺肿瘤病灶生成学习,提高乳腺肿瘤病灶区域图像生成质量。

可以看到,本文结合CBAM和GN模块的DA-RegGAN模型在NMAE、PSNR、SSIM指标上均有提升,说明本文方法有助于提升乳腺肿瘤图像转换生成学习,提高了乳腺肿瘤图像生成的相似度,生成效果如图4所示,红色框位置为病灶区域。图4从上往下第(1)、(2)、(3)行分别为3张不同的乳腺DWI图像及其不同模块的生成效果。

表2 乳腺肿瘤图像转换生成消融实验结果Tab.2 Results of breast tumour image conversion to generate ablation experiments

图4 消融实验结果可视化Fig.4 Visualisation of the results of the ablation experiment

观察表2数据可得,加入CBAM模块后全局生成效果的平均NMAE、SSIM指标虽较基础网络有降低,但在病灶生成部分有效提高,主要是因为通过CBAM学习到的特征是大感受野,具有更丰富的通道和空间特征,提高了模型对于不同形态乳腺肿瘤图像的学习生成能力,改善了乳腺肿瘤图像生成时病灶区域的生成质量。在CBAM的基础上进一步结合GN模块,保证病灶生成的效果,进一步提高全局图像生成效果。这说明GN模块在一定程度上可以进一步提升网络训练质量的情况,提高网络全局生成效果。

3.3 图像生成算法对比

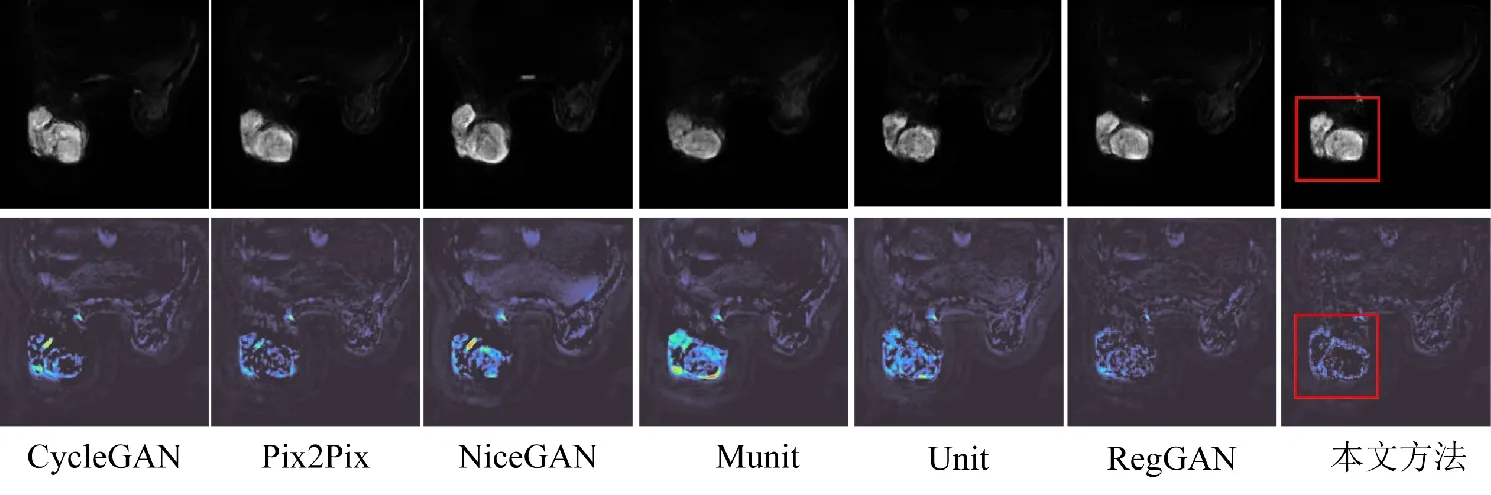

为了进一步验证本文方法的有效性和先进性,将本文方法分别与多个图像转换主流方法进行对比,包括CycleGAN[6]及其变体Munit[34]、Unit[35]、NiceGAN[36]、Pix2Pix[5]以及RegGAN[7]等6种算法模型,进行全局生成和局部生成的比较,局部生成结果如表3所示,全局生成结果如表4所示。从表3可以看出,在乳腺数据集上,本文方法得到局部生成的NMAE值、PSNR值、SSIM值结果均优于其他算法。从表4可以看出,在乳腺数据集上,本文方法得到全局生成的NMAE值、PSNR值、SSIM值结果也均优于其他算法。综合表3和表4可以看出,不论是局部生成的结果还是全局生成的结果,评价指标均有所提升,这表明本文的方法对乳腺肿瘤图像转换的学习能力较好,在一定程度上提高了乳腺肿瘤生成的精度。为了使生成结果可视化效果更明显,将原始图与生成图相减,以热力图的形式可视化。以图4中数据(1)为例,进行可视化展示,如图5所示,第1行为不同方法的生成结果,第2行为生成结果与原始图像作差的结果,为了使作差可视化更明显,进行了色彩空间转换显示。由图5可以看出,将本文方法生成图片与原始图片相减,图片差值较小,这表明提出的DA-RegGAN对于乳腺肿瘤全局和局部学习效果都较好。

对于全局生成,DA-RegGAN可以学习乳腺图像中的其他组织信息,并且对图像的边缘信息也可以学到相对不错的一个效果。对于局部生成,由于加入了CBAM模块,使模型更关注局部病灶信息的生成,因此,可以观察到图5中病灶区域部分差值更小。通过表3和表4及可视化结果可以观察到,Munit模型效果与其他算法相比结果最差,这可能是由于Munit的解不是唯一的且忽略了数据未配准误差。与本文方法相当的是RegGAN,而本文DA-RegGAN则是在RegGAN解决未配准误差基础上引入注意力机制和梯度正则化,以实现更精确的生成效果,病灶区域较其他方法学到更多的细节,使生成图片整体更接近真实的DWI图像。

表3 局部生成结果对比Tab.3 Comparison of local generation results

表4 全局生成结果对比Tab.4 Comparison of global generation results

图5 乳腺肿瘤生成对比算法可视化展示Fig.5 Visualisation of the comparative algorithm for breast tumour generation section

3.4 肿瘤良恶性诊断

为了进一步验证本文方法的有效性,将生成的图片用于分类网络中进行肿瘤良恶性分类。在保证网络计算量相同的前提下,本文方法在ResNet34、AlexNet、GoogLeNet分类网络上进行了实验,结果如表5所示。其中,良性图为210张,恶性图338张。分类网络训练数据有6组,100%+0表示数据组成全为原始数据。50%+50%表示数据组一半为原始数据一半为生成数据。100%+10%表示数据组成在原始的所有数据上加入了10%的生成数据,即良性图为210张原始数据加上21张生成数据,总共231张良性图,恶性图为338张原始数据加上34张生成数据,总共372张恶性图。其余3组的数据划分方法也是类似。

从表5可以看出,在ResnNet34网络中,保持数据量相同的情况下,在50%的原始数据加入50%生成数据提升效果相对较好,F1值为0.860。对于数据扩充,在100%原始数据加入50%的生成数据结果最好,F1值为0.951,而在100%原始数据加入100%的生成数据与原始数据100%加入50%的生成数据相差不大甚至有所下降,这可能是由于存在重复的生成数据和一些生成效果不太好的数据,从而影响分类结果,但相比于原始100%的数据还是有所提升。在AlexNet、GoogLeNet分类网络上也进行了相同的实验中,除了GoogLeNet在数据组成为100%+100%仍有轻微提升,其余情况同ResNet类似,这是因为同前两个网络相比,GoogLeNet网络层数更少,更轻量化,鲁棒性更强。综合实验结果表明,本文方法均可以提升网络诊断的性能,进一步说明本文方法的有效性。

表5 良恶性肿瘤分类结果Tab.5 Classification results for benign and malignant tumours

4 结语

本文针对乳腺肿瘤图像转换算法忽略局部病灶信息生成及由于训练不稳定导致生成效果不佳的问题,在生成对抗网络模型的基础上,引入注意力机制和梯度正则化模块,使网络更关注局部病灶信息的生成,并且网络训练更稳定。加入的注意力机制模块包含通道注意力和空间注意力,通过这两个注意力,网络可以获得更丰富的通道信息和空间信息,有效提高了生成网络对于局部病灶的学习能力。通过与当前主流的图像转换生成算法进行实验比较,结果表明本文算法取得了比当前主流算法更好的生成性能。然而,本文算法也存在不足,对于肿瘤边缘细节生成仍存在不够清晰的问题,这一方面还有待进一步的提升和改进。