基于改进ShuffleNet v1的服装图像分类算法

曾华福 杨杰 李林红

摘要:针对服装图像分类模型体积较大,缺少细分类的问题,提出基于改进ShuffleNet v1的服装图像分类算法。该算法以ShuffleNet v1为基础,通过优化模块的堆叠次数和网络层通道数来降低模型的计算量,满足算法的实时性要求;嵌入通道和空间注意力模块,使得模型关注重要的特征信息,抑制无用的特征信息;设计非对称多尺度特征融合模块,加强模型的特征提取能力。结果表明:所提算法在自建的衬衫服装数据集中准确率为88.31%,分别高于ShuffleNet v1、ShuffleNet v2、MobileNet v2和ResNet50模型2.77%、3.69%、1.98%、0.62%;所提算法在DeepFashion的部分数据集中也取得了不错的效果,验证了所提算法的有效性与通用性;与基础模型相比,所提模型的参数量仅为0.73M,模型参数量减少了约60%,实现了模型准确率和推理速度的提升。

关键词:服装图像分类;ShuffleNet v1;深度学习;注意力机制;非对称多尺度特征融合

中图分类号:TP399

文献标志码:A

文章编号:1009-265X(2023)02-0023-13

随着电子商务的发展,网上购物已成为人们主要的购物方式之一。服装作为人们日常生活的必需品,在电子商务中占据着重要地位。据产业信息网《2021—2027年中国服装纺织电子商务行业市场发展模式及未来前景展望报告》数据显示,服装行业的电子商务交易额逐年增长,2020年较2011年交易额增长420.7%,网购服装已经成为消费者购买服装的主流方式[1]。检索服装是网购服装的重要一步,电商平台检索服装的主要方式是文字搜索。这种搜索方式的前提是商家拍照后进行服装分类同时配上相应的文字再上传至平台,在搜索时根据文字匹配相应的服装图像。服装图像分类作为检索的重要组成部分,可以帮助用户快速地找到心仪的服装。目前,电商平台进行服装图像分类的方式主要是传统的人工分类。人工分类仍存在以下缺点:a)服装图像数量大,人工分类消耗大量的人力财力;b)服装款式更新迭代迅速,商家要花费大量的时间才有可能全面地熟悉和掌握,难以快速准确地进行更新和细致分类;c)人工分类存在个人主观性,不可避免地存在分类误差。另一方面,用户希望能够基于自己的喜好和风格来检索出更加精准的结果。因此,商家对服装的分类需要做到细致和准确。所以,为了解决现有的电商服装分类难题,满足商家对服装分类的高效准确的需求,研究一种高效的服装细分类方法具有重要意义。

近年来,随着深度学习的迅速发展,基于CNN(Convolutional neural network)的图像分类算法已经取得了显著进展。CNN能够自动学习图像的有效特征,准确率较传统方法有了极大的提升,为服装图像分类提供了理论和技术支持。由于CNN的显著优势,大量学者基于CNN来设计服装图像分类模型。任永亮等[2]提出了一种利用网络剪枝方法和网络稀疏约束的方法,减少卷积神经网络Xception中从卷积层到全连接层的冗余参数,在DeepFashion数据集上的准确率为79.88%。Zhou等[3]提出了一种基于并行卷积神经网络(PCNN)与优化随机向量函数链(RVFL)相结合的服装分类方法,利用泄漏整流线性单元激活函数和最大池化层来提高特征提取的性能,Fashion-Mnist数据集上的准确率达到92.93%。高樱萍等[4]针对传统的服装图像分类方法效率低、准确度不高等缺点,提出了一种基于VGG16和迁移学习的服装图像分类方法,从DeepFashion数据集中另外选取400张图片组成测试集,达到了92.25%的准确率。赵宏伟等[5]提出了一种基于关键点注意力和通道注意力的分类模型,在DeepFashion数据集上的top-3准确率为91.24%。Yu等[6]提出了一种VCG网络,使用VGG16作为特征提取网络,并在第二个卷积块中加入卷积块注意模块(CBAM), 在DeepFashion数据集上的平均准确率为80.77%。Gao等[7]基于ResNet模型提出服装分类算法,采用随机擦除数据增强方式,强化模型的泛化能力,分类精度提高了2.43%。上述研究对服装图像分类问题从不同的方面进行了改进,例如改善卷积方式和引入注意力机制,有效地提升了模型的分类精度,为本研究提供了良好的借鉴思路。然而,上述研究仍然存在以下不足:a)在提升精度的同时忽略了模型复杂度的上升,导致模型体积较大,在设备中的推理耗时较高;b)研究对象相对集中于服装大类别分类,对某一类别的细分类存在不足。因此,研究一种轻量级的服装图像细分类模型具有重要的实用价值。

2012年,Krizhevsky等[8]提了AlexNet模型,该模型采用卷积神经模型自动提取图像特征,其在ImageNet数据集中的识别精度远超传统的特征提取方法,引起了深度学习的热潮。再到2014年的GoogleNet[9]、VGG[10]系列模型,2015年的ResNet[11]系列模型,卷积神经模型在图像处理领域优势越来越突出,同时模型的参数量也越来越大。然而,大型模型对硬件算力的要求高,使得模型难以直接在边缘设备上运行,限制了模型的产业化,促使研究往轻量级模型发展。2017年SqueezeNet[12]的提出,标志着模型轻量化的开始。后续出现了Xception[13]、MobileNet[14]和ShuffleNet[15]等系列的轻量级模型,使得模型在保证精度的同时,模型计算量和参数量更小,推理速度更快。其中,ShuffleNet具有网络结构优雅、參数量低和识别精度高等优点。因此,本文选取ShuffleNet v1作为本研究的基础网络,对其进行优化改进,实现衬衫服装图像分类。

针对服装图像分类模型模型较大,缺少细分类问题,本文在前人研究的基础上,探索设计一种轻量级的服装图片细分类模型。基于轻量级ShuffleNet v1模型,从以下几个方面设计高效的服装图像细分类模型:a)选取轻量高效的ShuffleNet v1作为本研究的基础模型;b)通过改进模块的堆叠次数和调整基本单元的通道数来优化模型结构,使得准确率的下降在可接受范围内,减少模型的参数量和计算量;c)嵌入通道和空间注意力模块,使得模型关注重要特征,减弱次要特征;d)设计非对称多尺度特征融合模块,提高模型的特征提取能力和模型的鲁棒性能。

1相关工作

1.1ShuffleNet v1

ShuffleNet v1是由旷视科技于2018年提出的一种高效的轻量级神经网络模型,可直接在移动端部署使用,模型在保持轻量性的同时,具有不错的识别精度。该模型的主要创新点如下:a)该网络在基本单元中使用了分组逐点卷积,而不是传统卷积,该方式能够有效降低模型的计算量和参数量,提升卷积的运算效率;b)提出通道重洗技术,解决了分组卷积带来的组与组之间的特征信息无共享交流的问题,实现通道信息交流,加强了模型的特征表达能力。

ShuffleNet v1的基本单元模块主要有两种,如图1所示。基本单元模块借鉴了残差单元[11]的设计思路,提升梯度的传播效率;如图1(a)所示,卷积操作中使用深度卷积替换标准的3×3卷积,降低卷积操作的复杂度,减少模型参数;将首尾两个逐点卷积换成分组逐点卷积,进一步降低模型的参数量;在首端的分组逐点卷积和深度卷积之间加入通道重洗,实现组与组之间特征信息的交流。将输入直接与卷积操作后的输出相加融合,构成步长为1的基本单元模块,如图1(b)所示;将输入进行平均池化后与卷积操作后的输出拼接融合,构成步长为2的基本单元模块,如图1(c)所示。

1.2分组逐点卷积与通道重洗

分组逐点卷积是将1×1的标准卷积进行分组卷积操作。在卷积的过程中,将输入的特征层分组,每个卷积核也相应地分组,每组中的卷积核只与同组的输入特征进行卷积操作。如图2所示,输入特征尺寸为H×W×Cin,输出特征尺寸为H×W×Cout,假设分为g组,此时每组的特征尺寸为H×W×Cin/g;每个卷积核也分为g组,每组卷积核的个数为Cout/g,最后将每个组的输出拼接在一起输出。分组逐点卷积的参数量比逐点卷积的参数量小,是逐点卷积的1/g,具体对比如式(1):

P1P2=1×1×Cin×Coutg1×1×Cin×Cout=1g(1)

式中:P1是分组逐点卷积的参数量,P2是逐点卷积的参数量。

通道重洗可以实现组与组之间的特征信息共享交流。在如图3(a)所示,输入特征分为绿、蓝、黄三组,进行分组逐点卷积后,输出仅与组内的特征有关,与其他组的特征无关,信息没有共享交叉,提取的特征有一定的局限性。通道重洗正好可以解决这个问题,在完成分组逐点卷积后,进行通道重洗操作。如图3(b)所示,使得组与组之间特征信息相互

融合,提高了模型特征提取能力。

分组逐点卷积和通道重洗是ShuffleNet v1的核心技术点。分组逐点卷积可以减少模型参数量,提高模型运算效率;还可以降低过拟合的风险,具有正则化的效果[18]。通道重洗将不同组的通道信息重新分组,克服了各组之间的信息孤立的约束,在不增加计算量的前提下,使得组与组之间实现信息共享,提高了模型对特征信息的学习能力。鉴于分组逐点卷积和通道重洗的优势,本文沿用这两个核心技术点,在设计基本单元时,使用分组逐点卷积进行通道调整;采用通道重洗技术对特征进行通道洗牌。具体如图2、图3所示。

1.3注意力机制

CBAM[16]模块包含空间和通道注意力模块,可以嵌入到CNN模型中,与CNN一起进行端到端的训练。其过程如式(2):

Fc=Mc(F)F

Fs=Ms(Fc)Fc(2)

式中:F表示输入的特征图,Ms表示通道权重系数,Mc表示通道权重系数,Fc表示通道注意力特征,Fs表示空间注意力特征,表示逐像素乘法运算。

CBAM的通道注意力机制如图4(a)所示,将输入的特征层进行空间维度的平均池化和最大池化,得到两个特征描述,将两个特征描述经过一个多层感知机(MLP, Multilayer perceptron),然后将神经模型输出的特征进行相加操作,再经过Sigmoid激活函

数激活,得到通道的权重系数Mc,最后将此权重系数与输入的特征相乘得到新的特征层,过程如式(3):

Mc=σ(fM(fAvg(F)+fMax(F)))(3)

式中:σ表示非線性激活函数,fM表示多层感知机(MLP)操作,fAvg表示空间维度上的平均池化函数,fMax表示空间维度上的最大池化函数。

CBAM的空间注意力机制如图4(b)所示,对输入的特征层进行通道维度的平均池化和最大池化得到两个特征描述,按通道维度将这两个特征描述拼接在一起,再经过一个卷积计算,将卷积计算得到的特征通过Sigmoid激活函数激活,得到空间的权重系数Ms,最后将此权重系数与输入特征相乘得到新的特征层。具体计算如式(4):

Ms=σ( fc([fAvg(F), fMax(F)]))(4)

式中:σ表示非线性激活函数,fc表示卷积计算,fAvg表示通道维度上的平均池化函数,fMax表示通道维度上的最大池化函数。

1.4非对称卷积

ACNet(Asymmetric convolution net)是Ding等[17]于2019年提出的一种非对称卷积模型。核心思想是:a)训练阶段在标准的k×k卷积中并行k×1、1×k卷积,将3个卷积后的特征相加融合输出,如

图5(a)所示;b)推理阶段如图5(b)所示,将学习好的3个卷积核如图所示方式进行相加融合,删除训练阶段并行的k×1、1×k卷积。训练阶段并行的非对称卷积核,可以强化特征提取能力,提高模型的鲁棒性。推理阶段将并行的3个卷积核融合,同时只保留标准的k×k卷积,在不增加计算量的前提下,提升了模型的性能。这种特征融合的方式为多尺度特征融合提供了新的设计思路。

2算法设计

针对于服装图像分类问题,本文基于ShuffleNet v1模型进行改进,设计轻量高效的服装图像分类算法。本文提出改正后的模型整体框图如图6所示,其中

Conv代表普通卷积层,GC Conv代表分组卷积,Stage代表模型内部的大模块,由多个基本单元BottleNeck组成。其中基本单元包括带有注意力机制的基本单元BottleNeck_C和具有非对称多尺度特征融合模块的基本单元BottleNeck_A。

本文模型的具体的设计思路如下:首先,与基础模型相比,针对于模型的Stage块的数量设计,本文模型增加了Stage块的数量,由原来的3个增加至6个,该方式能够加深网络深度,有利于提取到图像的深层特征;其次,本文对基本单元进行通道数优化,构建先升维再降维的通道变化规律,允许基本单元有更小通道的输入和输出,降低模型的整体计算量;再次,本文对ShuffleNet v1的基本单元进行了改进,在步长为1的基本单元中嵌入注意力机制,构建了带注意力机制基本单元;本文也提出了一种非对称多尺度特征融合单元,应用于步长为2情况下的基本单元,提升模型的特征提取能力。

2.1模型结构设计

MobileNet v2[14]提出一种倒残差结构,它与普通的残差结构不同,如图7所示。普通的残差结构是先降维后升维,即对输入特征的维度先降维进行特征的提取,然后进行升维。倒残差正好相反,先升维后降维,即对输入特征的维度先升维进行特征的提取,然后进行降维。倒残差结构的这种先升后降可以允许输入更低的维度,减少模型的参数量和计算量,且不影响模型的特征提取性能。

本文模型借鉴MobileNet v2的倒残差结构设计,通过优化模块的堆叠次数和网络层通道数来降低模型的计算量方式设计新的模型结构,降低模型的参数量,提高了模型运算效率。

2.2注意力机制单元

CBAM注意力机制能够自适应地获取通道和空间相应的权重参数。利用相应的权重参数可以从冗杂的特征信息中选择出对当前类别的关键特征信息,从而强化关键特征信息,有效地提升了模型的特征提取能力和抗噪性能。

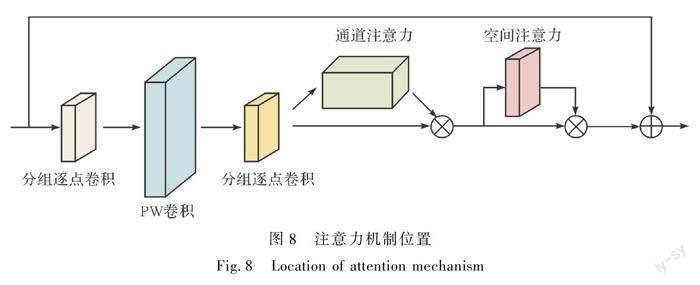

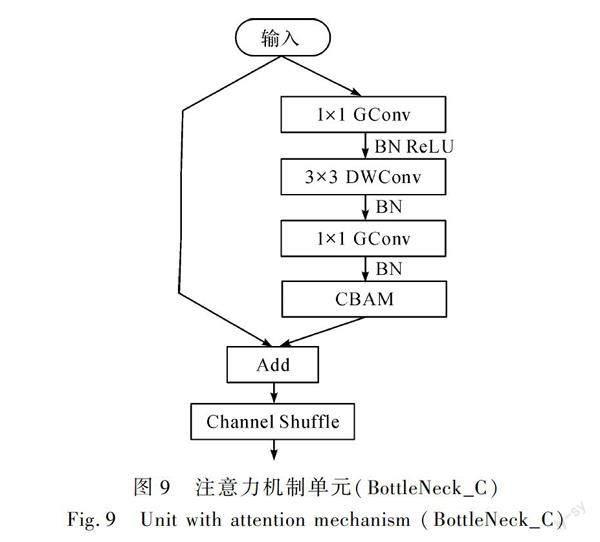

本文将CBAM注意力机制嵌入到ShuffleNet v1步长为1的基本单元模块中,使得模型在通道和空间维度上都能强化关键特征信息,抑制无用特征信息,提高模型的特征提取能力。CBAM注意力机制在基本单元模块中的位置如图8所示,在第2个分组逐点卷积之后依次串联通道注意力机制和空间注意力机制。同时将通道重洗在残差融合后进行[19]。改进后的基本单元模块如图9所示,将其作为本文模型中步长为1的基本单元模块,模块命名为BottleNeck_C。

2.3非对称多尺度特征融合单元

标准卷积是利用单一尺度的卷积核进行卷积操作。单一尺度的卷积核的感受野有限,提取的特征信息比较单一,在一定程度上限制了模型的性能。为进一步提升模型的性能,本文提出了一种非对称多尺度特征融合模块。非对称多尺度特征融合模块借鉴ACNet训练阶段的思想,如图10所示,在标准的k×k卷积基础上并行k×1、1×k的卷积,相加融合得到特征的输出,称之为k×k非对称多尺度特征融合模块。利用多个不同尺度的卷积核进行特征提取,可以增加模型对尺度的适应性和加宽模型,提取的特征在空间尺度上更为丰富,强化特征的提取能力。同时并行非对称的卷积可以提高模型对图像翻转、旋转的鲁棒性[17]。

本文通过非对称多尺度特征融合模块来设计模型的基本单元,命名为BottleNeck_A,该单元如图11所示。首先,在非对称多尺度特征融合后连接一组逐点卷积,进行通道的调整;其次,在另一条分支上进行最大池化和分组逐点卷积操作;然后,将两条分支的输出特征经过BN层后执行相加操作;最终,采用通道重洗技术对特征进行通道洗牌。考虑到并行卷积会导致模型参数量大幅增加,因此,本文只将非对称多尺度特征融合单元应用于步长为2时的基本单元。

3实验与结果

3.1数据集介绍

实验一共使用了两个数据集,分别是自建的衬衫数据集和DeepFashion[19]的部分数据集,DeepFashion的部分数据集用于验证提出算法的有效性和通用性。由于目前尚未有公开的衬衫圖像分类数据集,本文通过模型搜索和人工拍摄的方式收集衬衫图像,并按照图像分类任务的文件格式建立数据集。自建数据集根据衬衫上图案的不同,将衬衫分为具象图案和抽象图案两大类,具象图案有豹纹、斑马纹和刺绣,抽象类图案包括条纹、格子、斑点、纯色、印花,共计8类衬衫8143张图片,具体数量见表1。

DeepFashion是一个公开的大型服装数据集,包含80万张不同场所、角度和不同类别的图片。本次研究选取Blazer类别中经典男友款短上衣、经典牛仔款短上衣、经典一扣短上衣等8类经典的短上衣和Dress类别中的V形印花连衣裙、豹纹印花连衣裙等6类连衣裙,共计14类。由于数据量较小,使用剪裁、仿射变化等数据增强的方式生成图片,扩充数据量,避免训练的过程中由于数据量小而出现过拟合问题,增强后的具体数量如表2所示。在训练的过程中,将数据集按8∶2划分为训练集和验证集。

3.2实验设置及环境

首先,为了证明本研究提出的各项改进点对基础模型的性能提升都有贡献,设置消融实验。然后,为了验证本文所提模型的有效性和通用性,选取经典的分类模型VGG16、ResNet50及最新的EfficientNet v2[20]和轻量级分类模型ShuffleNet v2[21]、MobileNet v2在DeepFashion的部分数据集上进行不同模型的对比实验,比较本文所提模型和其他分类模型的分类性能。

本文搭建的实验平台配置如下:电脑为Intel Core I5-8500(3GHz)的CPU,搭载2张Tesla P100显卡,Ubuntu 14.04的操作系统,python 版本为3.6.9,深度学习框架及版本为Pytorch1.6.0。

模型的训练使用Tesla P100进行加速,减少训练的时间。选择Adam作为模型参数优化器;训练周期设置为200次;每批次训练的16张衬衫图片;学习率设置为0.0001;损失函数采用交叉熵损失。为提高模型的泛化能力,在训练时对数据集执行:a)将衬衫图片随机剪裁224×224;b)随机水平翻转;c)归一化处理。验证时对数据集执行:a)将衬衫图片大小调整为256×256;b)中心裁剪為224×224;c)归一化处理。

采用准确率Acc(Accuracy)、F1(F-score)作为衬衫分类结果的衡量指标,采用参数量P(Params)衡量模型的大小,Occ(Occupancy)衡量模型训练时GPU的占用内存,模型的推理速度采用平均时间(Tavg)衡量。各衡量指标具体的计算如式(5)、式(6):

Acc=TP+TNTP+TN+FP+FN(5)

F1=2TP2TP+FP+FN(6)

式中:TP表示正类预测准确的数量,TN表示负类预测准确的数量,FP表示负类预测错误的数量,FN表示正类预测错误的数量。

P=∑(H×W×Cin1+1)×Cout1+∑(Cin2+1)×Cout2(7)

式中:H表示卷积核高度,W表示卷积核宽度,Cin1表示输入通道数,Cout1表示输出通道数,Cin2表示全连接层输入节点数,Cout2表示全连接层输出节点数,P表示所有卷积层参数与所有全连接层参数的和。

Tavg=∑Ni=1tiN(8)

式中:N表示测试图片的数量,ti表示第i张图片推理的耗时,Tavg表示单张图片的平均耗时。

3.3消融实验

为了证明本研究提出的各项改进点对基础模型的性能提升都有贡献,设置消融实验。首先,为了验证所提改进结构的有效性,按新的网络结构表搭建出所提结构;其次,为了证明引入通道和空间注意力机制对模型性能的提升效果,使用注意力机制单元BottleNeck_C替换ShuffleNet v1步长为1情况下的基本单元;再次,为了验证所提出的非对称多尺度特征融合单元对网络的贡献,使用非对称多尺度特征融合单元BottleNeck_A替换ShuffleNet v1步长为2情况下的基本单元;最后,将所有改进点进行结合,对最终的模型进行性能测试。

消融实验结果如表3所示。可以看出,通过改进模型的结构,模型在仅牺牲1.17%的准确率情况下,参数量减少至约为基础模型的1/8;通过引入CBAM模块,使得模型在通道和空间维度上都能关注重要特征信息,提升了模型的识别准确率;非对称多尺度特征融合模块并行了两个1×3、3×1卷积强化模型对特征的学习能力,提高模型对图像翻转、旋转的鲁棒性,模型的准确率提高了1.66%。

为了验证通道注意力和空间注意力分别对衬衫服装分类的有效性,设计6组对比实验,分类结果如表4所示。实验结果表明:a)嵌入注意力机制后,模型的预测准确率都得到了提升,其中,识别精度最好的连接方式是依次串联通道注意力和空间注意力;b)CBAM注意力机制中主要是通道注意力带来参数量。为直观体现通道、空间注意力对模型的效果,将模型卷积结果利用CAM[22]采用热力图的形式进行可视化展示。如图12所示,温度越高的地方表示模型越关注。在图12(b)中是没有加入注意力机制的原始模型,可以发现模型关注点比较分散,包含了无关的背景信息;在图12(c)―(f)中加入了注意力机制后,模型可以将注意力集中在分类的目标上,有效地区分周围的背景干扰信息,其中串联通道注意力后串联空间注意力对分类目标的关注度最好。

为了确保模型推理速度,本文优化了模块的堆叠次数和网络层的通道数,在保证模型精度的情况下,极大地减少了参数量;在注意力机制的实验中,证明了采用通道与空间注意力机制依次串联的方式对网络的性能提升效果最明显;本文提出的非对称多尺度特征融合单元能够提升模型的特征提取能力,进一步提升模型的分类准确率。与基础的ShuffleNet v1相比,所提模型准确率提高了2.77%,模型的参数量减少了约60%,单张图片推理的平均时间减少了4.18 ms,实现了模型准确率和推理速度的提升。因此,消融实验证明了本文所提改进点的有效性,所提模型是一种低消耗、高精度的服装图像分类模型。

3.4算法对比

为了体现本文所提出算法的有效性,与当前主流分类模型VGG16、ResNet50、EfficientNet v2、ShuffleNet v2、MobileNet v2等进行实验对比。在自建的衬衫服装分类数据集中训练,训练的过程中保证每一个模型的超参数相同,同时每完成一个训练周期,记录模型在验证集上的准确率。

如图13所示为不同模型在自建的衬衫数据集中的训练曲线,E为训练的迭代次数,A为模型测试的准确率,L为模型测试的损失值。从图13中可以看出,改进后的模型有明显的提升,收敛速度更快,在验证数据集中的损失值最小。各模型在自建数据中具体实验结果如表5所示,表中Ts表示单张图片推理时间(CPU),Occ表示模型训练是GPU的占用率。可以看出,本文算法基于ShuffleNet v1模型改进,准确率最高,且耗时最短,GPU占用内存也是最小;具体改进后模型的准确率比VGG16、EfficientNet v2分别略低0.24%、0.61%,但参数量分别减少了99.46%、99.38%;比ShuffleNet v1、ShuffleNet v2、MobileNet v2、ResNet50模型分别高2.77%、3.69%、1.88%、0.62%,同时模型参数量约减少分别为65.40%、42.06%、67.26%、96.81%。原因如下:a)ShuffleNet v1本身对衬衫服装分类性能的优越性,对特征的提取能力超越了ShuffleNet v2;b)重新设计了模型结构减少模型的参数量,实验证明,准确率下降在可接受的范围内,改进后的模型结构可以大幅度地减少模型的参数量;c)本文算法引入CBAM注意力机制模块,能够模拟人的视觉专注重要信息,而忽略非必要信息;d)本文算法设计的非对称多尺度特征融合模块,将步长为2的结构单元换成非对称多尺度特征融合单元,强化模型的特征提取性能同时提升了模型的鲁棒性。

如表6所示为各模型在自建衬衫数据集中的F1值,结果显示:a)本文算法对条纹、斑点、纯色、斑马纹4类衬衫的F1值均高于其他模型的F1值;b)本文算法的平均F1值为0.875,分别高于ResNet50的0.874、MobileNet v2的0.857、ShuffleNet v2的0.842、ShuffleNet v1的0.847,仅次于VGG16的0.876和EfficientNet v2的0.879。通過分析可知,本文模型参数量仅为0.73M,仅约为EfficientNet v2的0.6%,VGG的0.54%。本文模型在以极低的计算消耗的情况下取得了不错的识别精度,更适合在实际场景中的部署使用。因此,所提模型是一种高精度、低消耗的服装图像分类模型。

为进一步分析本文所提出算法的有效性和通用性,在DeepFashion的部分数据集上进行实验对比,实验结果如表7所示。可以看出,本文算法在DeepFashion的部分数据中的准确率为93.22%,超越了ShuffleNet v1、ShuffleNet v2、MobileNet v2、VGG16和ResNet50模型,仅次于EfficientNet v2。本文算法的准确率低于EfficientNet v2的原因是EfficientNet v2模型结构深,模型复杂,具有较好的学习能力,但是EfficientNet v2的模型参数量大,对设备的要求较高。因此,本文算法同样具有有效性和通用性。

4结语

本文基于ShuffleNet v1进行改进,提出衬衫服装分类算法。在自建的衬衫分类数据集中表明,本文算法准确率超过了许多经典的轻量级分类模型;改进模型结构大幅度地减少了模型参数量;嵌入CBAM注意力机制模块可以提高模型对分类目标的关注度,有效地区分周围背景干扰信息;引入非对称多尺度特征融合模块使得模型提取到的特征在空间尺度上更为丰富,提高了分类的准确率。在公共数据集DeepFashion的部分数据中表明本文算法的有效性和通用性。实现了高精度、耗时小的衬衫服装分类,对帮助商户前期的服装细分类具有实际的应用价值。同时,对类似的细分类问题和轻量化问题的研究具有较好的学术意义和参考价值。

本文算法是应用于服装图像的细分类。由于数据集的原因,目前仅支持条纹、格子、斑点等衬衫的少数类别。现实生活中,某一类服装有不同的形式和更多的类别。如何收集有效数据或利用对抗性学习来扩展数据集是一个值得探索的方向。

参考文献:

[1]产业信息网. 2021—2027年中国服装纺织电子商务行业市场发展模式及未来前景展望报告[R/OL]. [2022-07-20]. https://www.chyxx.com/research/202011/906001.html.

Industry Information Network. Report on the market development mode and future prospects of China apparel and textile E-commerce industry in 2021-2027[R/OL]. [2022-07-20]. https://www.chyxx.com/research/202011/906001.html.

[2]任永亮,宋田,毋涛.基于Xception改进的卷积神经网络服装分类算法[J].计算机系统应用,2022,31(6):381-387.

REN Yongliang, SONG Tian, WU Tao. Improved clothing classification algorithm based on Xception in convolutional

Neural Network[J]. Computer Systems & Applications, 2022,31(6): 381-387.

[3]ZHOU Z Y, DENG W X, WANG Y M, et al. Classification of clothing images based on a parallel convolutional neural network and random vector functional link optimized by the grasshopper optimization algorithm[J]. Textile Research Journal. 2022, 92(9/10): 1415-1428..

[4]高樱萍,宋丹,陈玉婷.基于卷积神经网络和迁移学习的服装图像分类[J].纺织科技进展,2021(11):48-52.

GAO Yingping, SONG Dan, CHEN Yuting. Clothing image classification based on VGG16 and transfer learning[J]. Progress in Textile Science & Technology, 2021(11): 48-52.

[5]赵宏伟,刘晓涵,张媛,等.基于关键点注意力和通道注意力的服装分类算法[J].吉林大学学报(工学版),2020,50(5):1765-1770.

ZHAO Hongwei, LIU Xiaohan, ZHANG Yuan, et al. Clothing classification algorithm based on landmark attention and channel attention[J]. Journal of Jilin University(Engineering and Technology Edition), 2020, 50(5): 1765-1770.

[6]YU S, JIN S Z, PENG J, et al. Application of a new deep learning method with CBAM in clothing image classification[C]// IEEE International Conference on Emergency Science and Information Technology. Chongqing, China. IEEE, 2022:364-368.

[7]GAO Z Y, HAN L X. Clothing image classification based on random erasing and residual network[J]. Journal of Physics: Conference Series, 2020, 1634(1): 012136.

[8]KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[C]//International Conference on Neural Infor-mation Processing Systems. Lake Tahoe, Nevada. New York: ACM, 2012: 1097-1105.

[9]SZEGEDY C, LIU W, JIA Y Q, et al. Going deeper with convolutions[C]//IEEE Conference on Computer Vision and Pattern Recognition. Boston, MA. IEEE, 2015: 1-9.

[10]SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition [EB/OL]. [2018-07-22]. http://arxiv.org/abs/1409.1556.

[11]HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]//Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA. IEEE, 2016: 770-778.

[12]IANDOLA F N, HAN S, MOSKEWICZ M W, et al. SqueezeNet: AlexNet-level accuracy with 50x fewer parameters and <0.5 MB model size[EB/OL]. [2018-11-13]. https://arxiv.org/pdf/ 1602. 07360.pdf.

[13]CHOLLET F. Xception: Deep learning with depthwise separable convolutions[C]//IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI, USA. IEEE, 2017: 1800-1807.

[14]SANDLER M, HOWARD A, ZHU M L, et al. MobileNetV2: Inverted residuals and linear bottlenecks[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT, USA: IEEE, 2018: 4510-4520.

[15]ZHANG X Y, ZHOU X Y, LIN M X, et al. Shufflenet: An extremely efficient convolutional neural network for mobile devices[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT, USA. IEEE, 2018: 6848-6856.

[16]WOO S, PARK J, LEE J Y, et al. CBAM: Convolutional Block Attention Module[M]. Computer Vision-ECCV 2018. Cham: Springer International Publishing, 2018: 3-19.

[17]DING X H, GUO Y C, DING G G, et al. ACNet: Strengthening the kernel skeletons for powerful cnn via asymmetric convolution blocks[C]//IEEE/CVF Inter-national Conference on Computer Vision(ICCV). seoul, Korea(South). IEEE, 2019: 1911-1920.

[18]ZHOU B L, KHOSLA A, LAPEDRIZA A, et al. Learning deep features for discriminative localization[C]//Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA. IEEE, 2016: 2921-2929.

[19]LIU Z W, LUO P, QIU S, et al. DeepFashion: Powering robust clothes recognition and retrieval with rich annotations[C]//IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA. IEEE, 2016: 1096-1104.

[20]MA N N, ZHANG X Y, ZHENG H T, et al. ShuffleNet V2: Practical Guidelines for Efficient CNN Architecture Design[M]. Computer Vision-ECCV 2018. Cham: Springer International Publishing, 2018: 122-138.

[21]KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[J]. Communications of the ACM, 2017, 60(6): 84-90.

Clothing image classification algorithm based on improved ShuffleNet v1

ZENG Huafua,b, YANG Jiea,b, LI Linhonga,b

(a.School of Electrical Engineering and Automation; b.Jiangxi Provincial Key Laboratory of Maglev Technology, Jiangxi University of Science and Technology, Ganzhou 341000, China)

Abstract:

In recent years, with the development of the Internet economy, compared with offline sales of clothing, online shopping has broken the time and geographical restrictions, and has gradually become one of the mainstream consumption methods with distinctive features such as various categories and affordable prices. According to the China E-Commerce Report 2021 released by the Ministry of Commerce of the People's Republic of China, in 2021, the national online retail witnessed rapid growth, with the online retail volume reaching 13.09 trillion yuan, of which footwear and clothing products account for the largest proportion, reaching 22.94%. With the increasing demand for clothing, consumers' requirements for clothing retrieval methods are also increasing. Consumers hope to retrieve more accurate results based on their own needs and styles. Therefore, the classification of clothing needs to be meticulous and accurate.

To promote the accurate integration of clothing retrieval results of e-commerce platforms and consumer demand, it is necessary to further enrich the clothing retrieval methods of e-commerce platforms. Aiming at the problem of large volume and lack of fine classification of garment image classification models, a garment image classification algorithm based on improved ShuffleNet v1 is proposed. Based on ShuffleNet v1, the algorithm reduces the computational load of the model by optimizing the number of module stacks and network layer channels to meet the real-time requirements of the algorithm. Furthermore, the channel and spatial attention module is embedded to make the model focus on important feature information and suppress useless feature information. Finally, the asymmetric multi-scale feature fusion module is designed to enhance the feature extraction ability of the model. The results show that the accuracy of the proposed algorithm in the self-built shirt and clothing dataset is 88.31%, which is 2.77%, 3.69%, 1.98% and 0.62% higher than that of ShuffleNet v1, ShuffleNet v2, MobileNet v2 and ResNet50 models respectively. The proposed algorithm has also achieved good results in some datasets of DeepFashion, verifying the effectiveness and universality of the proposed algorithm. Compared with the basic model, the parameters of the proposed model are only 0.73M, and the parameters of the model are reduced by about 60%, which improves the accuracy and reasoning speed of the model.

This paper proposes an algorithm to achieve high-precision and less time-consuming shirt clothing classification, which has practical application value for helping merchants to subdivide clothing in the early stage. At the same time, it has good academic significance and reference value for the research of similar fine classification and lightweight problems. However, due to the limitation of the dataset, only a few categories of shirts such as stripes, lattices and spots are supported. In real life, a certain type of clothing has different forms and more categories. How to collect effective data or expand datasets is a direction worth exploring in the future.

Keywords:

clothing image classification; ShuffleNet v1; deep learning; attention mechanism; asymmetric multi-scale feature fusion

收稿日期:20220801

網络出版日期:20221207

基金项目:江西省03专项及5G项目(20204ABC03A15)

作者简介:曾华福(1996—),男,江西赣州人,硕士研究生,主要从事计算机视觉方面的研究。

通信作者:杨杰,E-mail:yangjie@jxust.edu.cn